还在为强化学习(RL)框架的扩展性瓶颈和效率低下而烦恼吗?当模型和集群规模达到上千块 GPU 时,传统的中心化控制器架构难免会遇到性能瓶颈、内存溢出甚至系统崩溃。

事实上,当前最顶尖的基础模型,从 DeepSeek-R1,到 o3-pro, Gemini 2.5-pro 和 Claude-4,其卓越的推理能力都离不开大规模强化学习的加持。这充分表明,RL Scaling 已经成为大模型领域迈向更高智能的 “军备竞赛” 核心,是大势所趋。而 xAI 最近发布的 Grok 4,更是将这一趋势推向了新的高度,他们直接在其拥有的 200,000 块 GPU 大集群上,以前所未有的 “后训练规模” 来运行强化学习,旨在精进模型的推理能力。

Grok 4 和其他顶尖推理模型的成功共同揭示了一个明确的事实:解决强化学习的扩展性瓶颈,已不再仅仅是一个工程挑战,而是解锁下一代 AI 高级推理能力、实现更强通用智能的关键所在。因此,对 RL Scaling 的投入和研究,是未来 AI 发展的重要方向和核心战略。

现在,来自上海创智学院的研究团队正式推出 siiRL,一个支持大规模高效强化学习训练的 RL 框架!

siiRL 的核心在于其创新的 多控制器 范式和 全分布式 架构,它将数据加载、计算和数据流转等任务均匀地分散到所有工作节点,从根本上解决了传统 RL 框架中由单一控制器引发的性能瓶颈。

传统 RL 框架为何遭遇瓶颈?

解构单控制器之痛

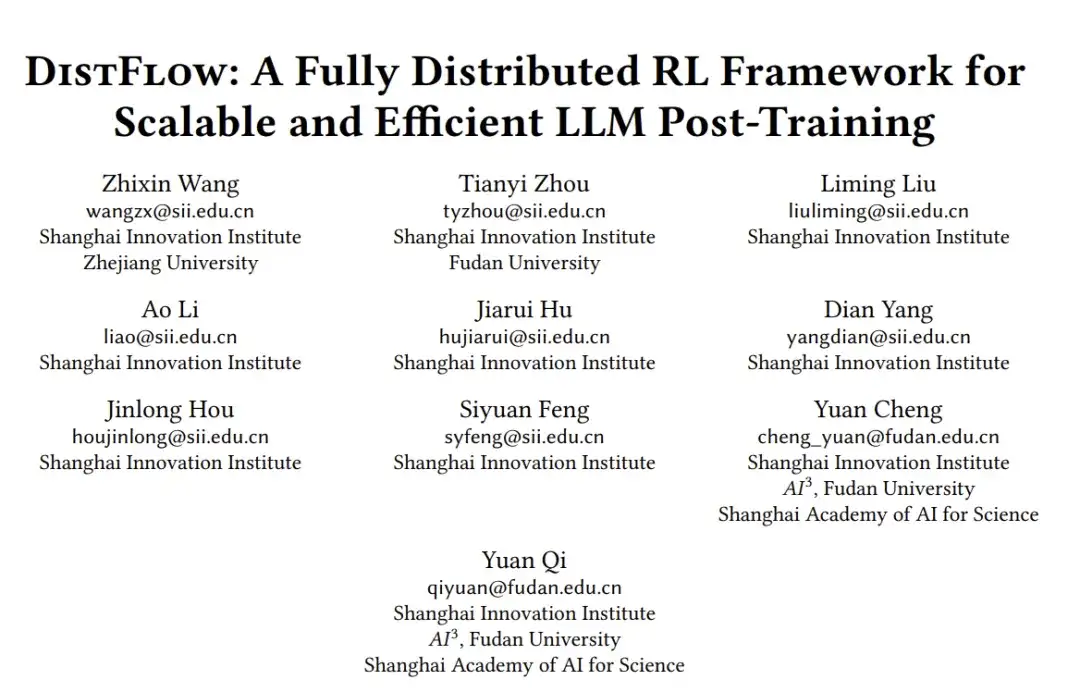

图 1:传统单控制器架构瓶颈。所有数据操作(初始加载、中间数据流转)都需经过中心控制器,导致严重的通信开销和扩展限制 。

在主流的强化学习框架中,系统通常采用一种混合或单一控制器架构,即由一个中心化的控制器节点来调度整个执行逻辑和管理数据流 。无论是初始的数据集加载,还是各计算阶段间海量中间数据的收集与分发,所有数据都必须流经这个中心节点 。

这种设计在小规模下尚可运行,但一旦扩展到数百乃至上千 GPU,该中心节点就会因巨大的 I/O 和通信开销而成为系统的性能瓶颈 。更糟糕的是,海量数据很容易压垮中心节点的内存,导致系统崩溃(OOM),从根本上限制了系统的可扩展性和稳定性 。此外,固化的算法流程也大大增加了研究者进行算法创新的难度 。

siiRL 的高效秘诀:全分布式架构

为了彻底解决上述痛点, siiRL 创新性地采用了 全分布式架构 和 多控制器范式,移除了中心节点,将数据与计算的调度权下放到每一个工作单元 。

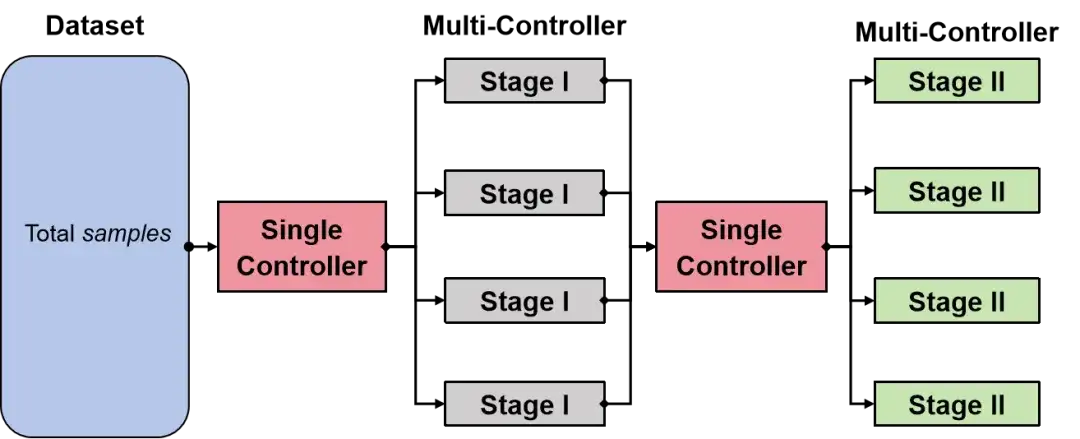

图 2:siiRL 架构概览

siiRL 的整体设计包含三大核心组件:

a. DAG Planner (DAG 规划器):用户可以通过配置文件灵活定义一个代表完整 RL 工作流的 有向无环图(DAG) 。DAG Planner 负责接收这个逻辑图,并将其自动解析、分解为一系列线性的执行任务,分发给每个 Worker 。这种设计将算法逻辑与物理执行完全解耦,赋予了研究者极大的灵活性 。

b. DAG Worker (DAG 工作单元):作为框架的基本执行单位,每个 DAG Worker 绑定到一个 GPU,并独立执行由 DAG Planner 分配的任务链 。它通过动态函数分发机制,将 DAG 节点定义(如角色、类型)与具体的计算函数实现解耦,使得框架极易扩展 。

c. Data Coordinator (数据协调器):它负责管理整个数据生命周期,确保数据在全分布式系统中的高效、正确流动 。

i. Distributed Dataloader:在初始加载阶段,每个 Worker 只加载自己所需的数据分片,通过并行加载的方式从源头避免了单点瓶颈 。

ii. Distributed Databuffer:在阶段转换时,当并行策略(如数据并行度)发生变化,Databuffer 会自动完成跨节点的数据重组与分发,确保数据流无缝衔接 。

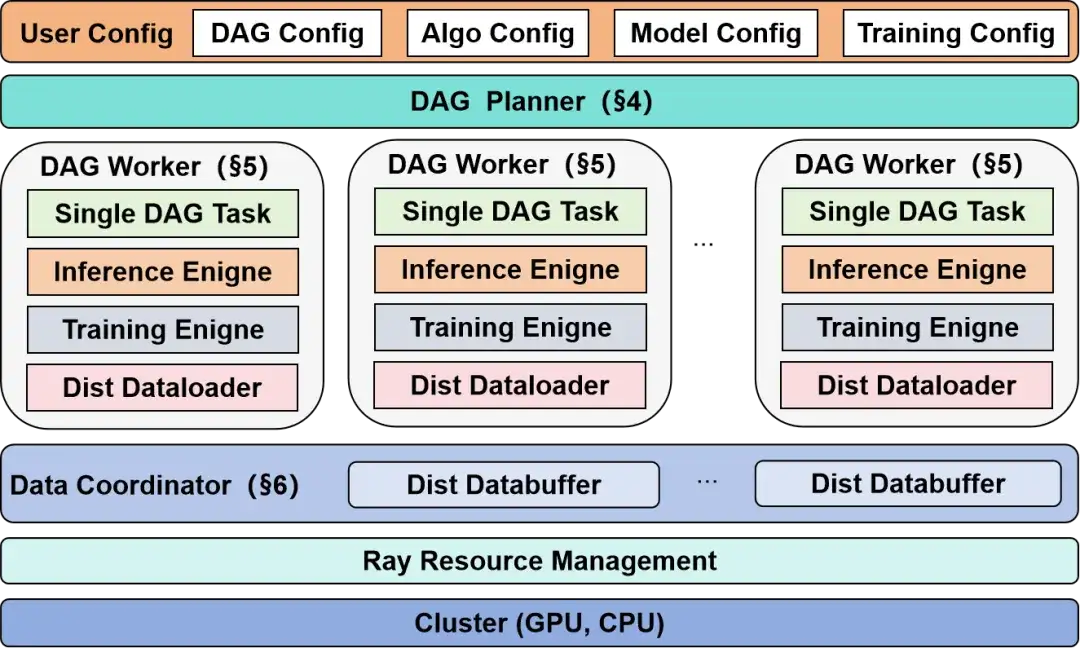

图 3:Distributed Databuffer 示意图。当数据并行从 2(生成阶段)变为 4(训练阶段)时,Databuffer 自动将数据重新切分并分发给正确的 Worker 。

效果验证:速度与扩展性双丰收,

性能依旧强劲!

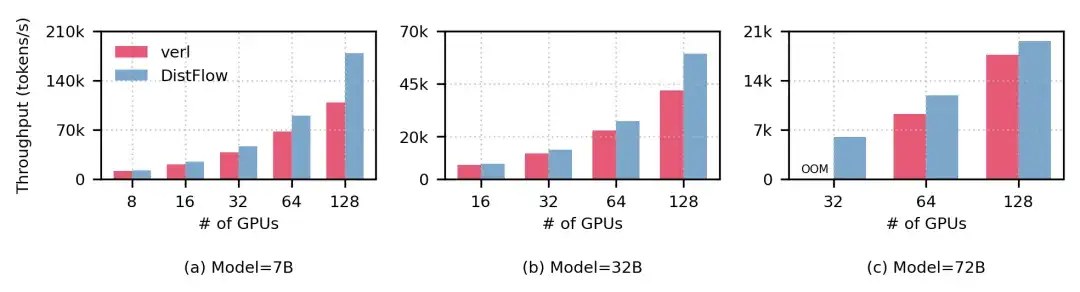

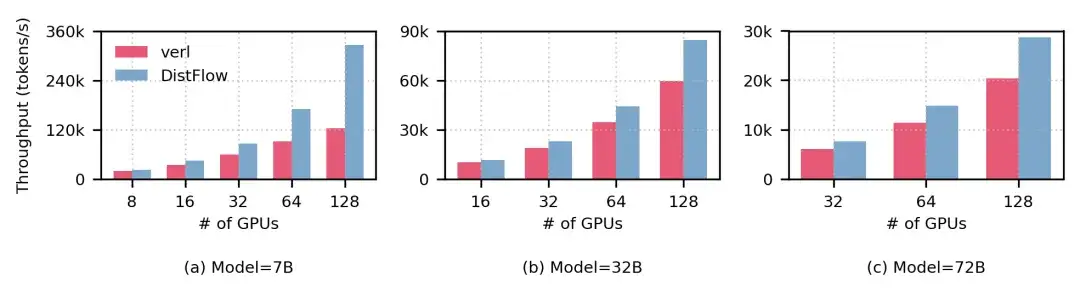

我们在涵盖 7B 到 72B 的多种模型尺寸和算法上,将 siiRL 与当前最主流的开源框架 verl 进行了全面对比。实验结果证明了 siiRL 架构的巨大优势。

在 PPO 和 GRPO 算法的端到端训练中,siiRL 的性能全面超越基线。尤其是在数据交互量更大的 GRPO 算法下,siiRL 实现了高达 2.62 倍 的吞吐提升 。值得注意的是,在训练 72B 模型时,基线框架在 32 卡配置下便遭遇了 OOM 错误,而 siiRL 则能轻松完成任务。

图 4:使用 PPO (上) 和 GRPO (下) 算法的端到端吞吐对比。siiRL(蓝色)在所有模型尺寸和 GPU 规模上均大幅领先基线框架 verl(红色) 。

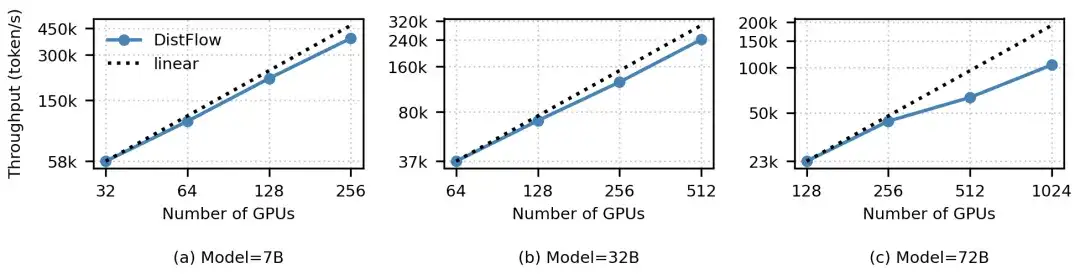

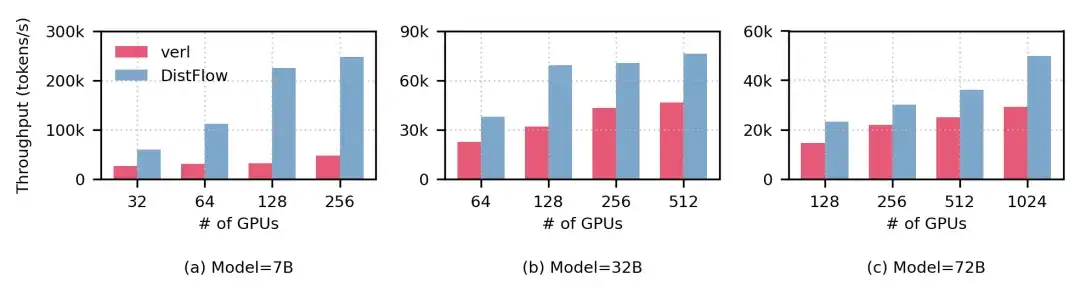

扩展性评估:千卡规模下的近线性扩展

得益于全分布式设计,siiRL 在扩展至 1024 个 GPU 时仍表现出近乎完美的线性扩展能力 。如下图所示,在训练 32B 模型时,从 64 卡扩展至 512 卡,系统依然保持了 80.5% 的线性扩展效率 。由于基线框架在同等规模下无法运行,我们转而测试其所能支持的最大训练批次大小,在此条件下,siiRL 在 VLM 设定下实现了惊人的 7 倍 速度提升。

图 5:siiRL 在 VLM 任务上的扩展性评估,展示了从 32 到 1024 GPU 规模下的近线性扩展能力 。

图 6: siiRL 和基线框架在基线框架支持最大训练批次下对比实验,7B 模型训练吞吐提升最高达到 7 倍。

数据密集型场景:优势愈发明显

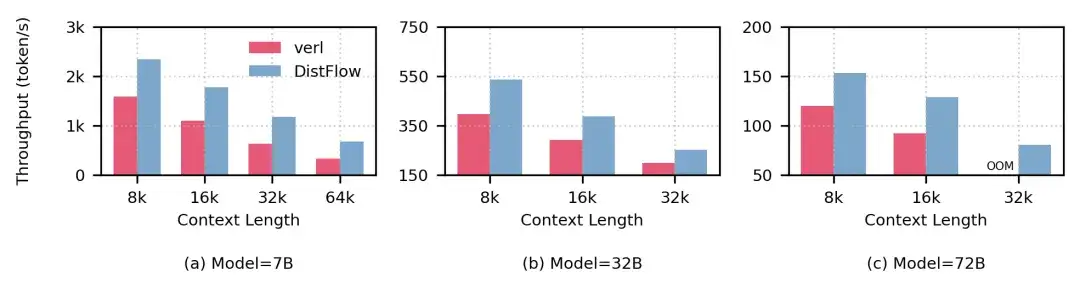

在长上下文这类数据密集型任务中,siiRL 的优势愈发凸显 。随着上下文长度从 8k 增加到 64k,siiRL 相对于基线的领先优势从 1.48 倍扩大到 2.03 倍 。这充分证明,数据通信量越大,siiRL 的全分布式数据流设计的效率提升就越高 。

图 7:长上下文性能评估。随着上下文长度增加,siiRL(蓝色)的性能优势愈发显著 。

收敛性验证:性能提升,精度无损

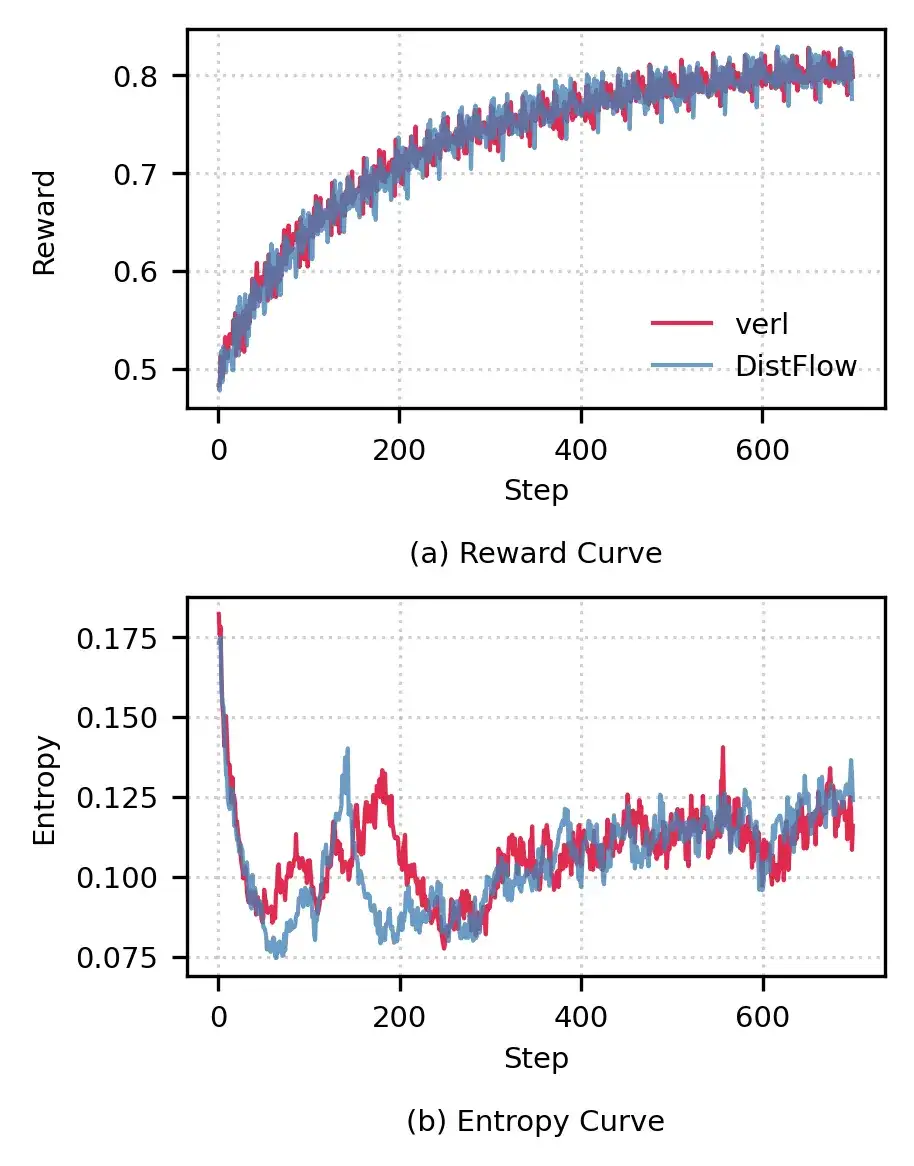

为了确保性能提升不以牺牲模型精度为代价,我们进行了收敛性对比实验 。结果表明,在完全相同的超参数下,siiRL 和基线框架的奖励值与熵值曲线几乎完全重合 。这意味着,siiRL 在将训练总耗时大幅减少的同时,保证了与基线完全一致的训练效果 。

图 8:收敛性对比。siiRL 与基线框架的训练曲线趋势一致,证明其优化不影响模型最终精度 。

未来计划:

我们基于 DAG 的灵活设计,为构建复杂的 “多智能体系统” 奠定了天然且坚实的基础。展望未来,我们计划将多智能体支持作为系统的核心特性进行重点拓展,这包括支持更复杂的智能体交互工作流,扩展对多智能体强化学习(MARL)算法的兼容性,并实现更丰富的智能体与环境的交互机制,从而将我们的框架打造为一个功能全面的多智能体研发平台。

总结:

开启大规模强化学习新纪元

本文介绍了 siiRL,一个为解决大规模 RL 训练中的扩展性和灵活性挑战而设计的全新框架 。通过创新的全分布式架构 和用户自定义的 DAG 驱动流程,siiRL 不仅彻底解决了传统单控制器设计的瓶颈问题,实现了千卡规模的近线性扩展和高达 7 倍的吞吐提升,还极大地增强了框架的灵活性,加速了算法的创新迭代周期 。

我们相信这项工作为大规模强化学习研究铺平了道路,提供了一个更高效、更灵活、真正可扩展的解决方案 。欢迎大家试用 siiRL,共同迈向大规模 AI 的未来!

上海创智学院 AI Infra 团队介绍

siiRL 诞生于上海创智学院产学研一体化人才培养模式。

文章来自公众号“机器之心”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md