要说今年“科技春晚”CES上最吸引眼球的是什么,智能车当属其一。

毕竟大模型一上车,智能座舱都卷成酱婶了:

让车上的数字助手帮忙记录约饭日程,Ta能直接帮你把餐厅也给预定了。

规划路线这种事儿也变得充满巧思,数字助手会根据你的习惯,主动问你:“路上买杯咖啡不?”

智能车上下游厂商纷纷秀出肌肉,也难怪不少前线参展的胖友们感叹:CES能当车展逛了。

事实上,随着大模型落地应用的重点从云侧走向端侧,不仅是手机厂商纷纷卷起端侧大模型,大模型上车也已成为关注焦点之一:

智能车是现今最重要的智能移动终端之一,而大模型被认为是AI规模化应用的关键。

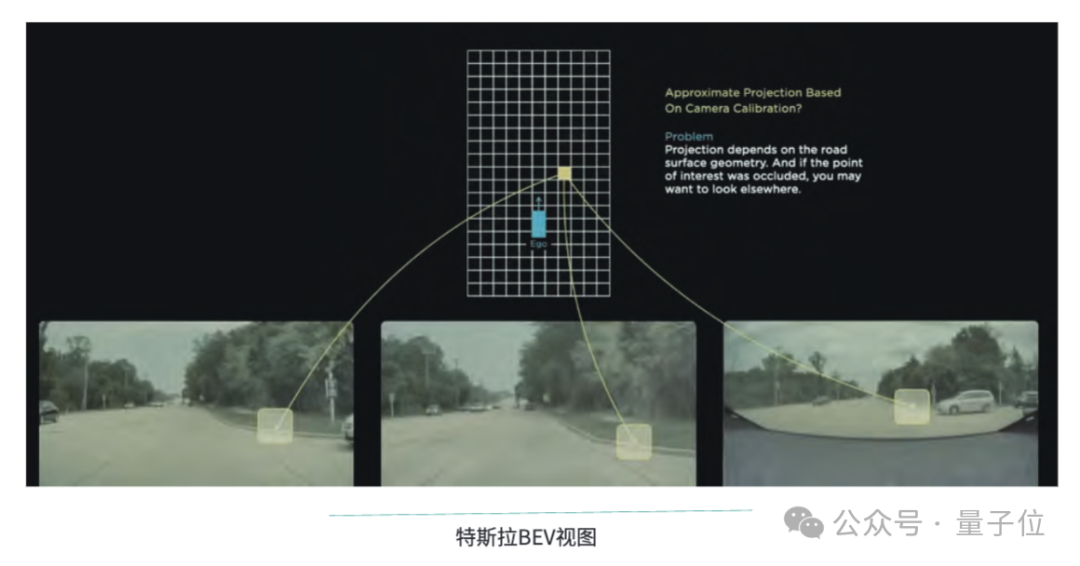

不止是基于大模型、生成式AI能力构建智能座舱,由特斯拉而引起热议的端到端自动驾驶方案,背后也正代表着通过大模型串联感知、预测、规划所有模块的全新技术趋势。

也就是说,在大模型重构一切掀起的“模力时代”中,从智能座舱到自动驾驶,“汽车机器人”的真正实现,正在全方位围绕大模型展开。

那么,问题来了——

前文已经说到,大模型上车的两种最受关注的趋势,其一围绕自动驾驶,其二聚焦智能座舱。

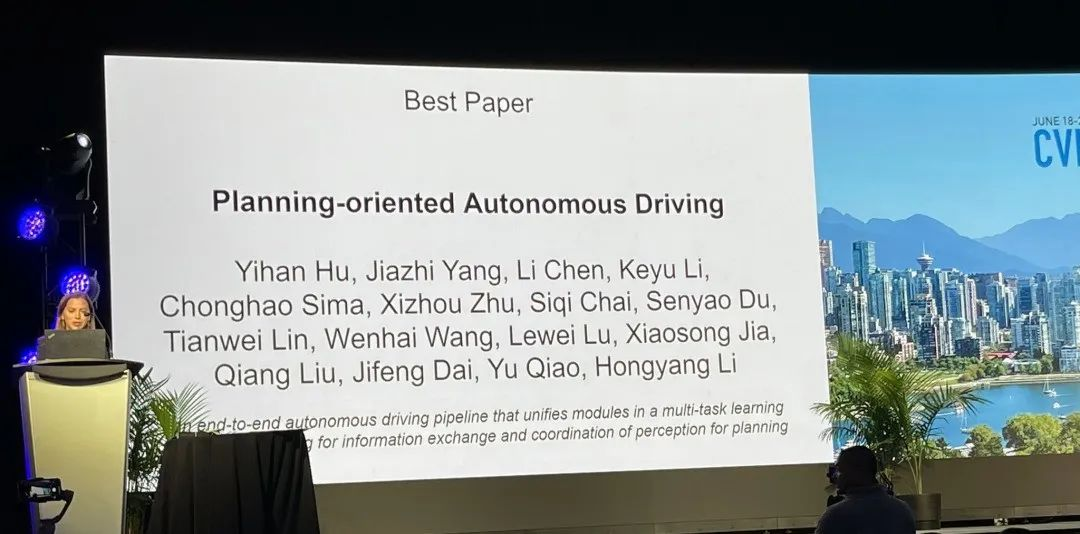

自动驾驶方面,随着CVPR 2023最佳论文颁给自动驾驶大模型,一种行业共识浮出水面:

端到端自动驾驶是行业的未来,而新的突破将以大模型技术为基础。

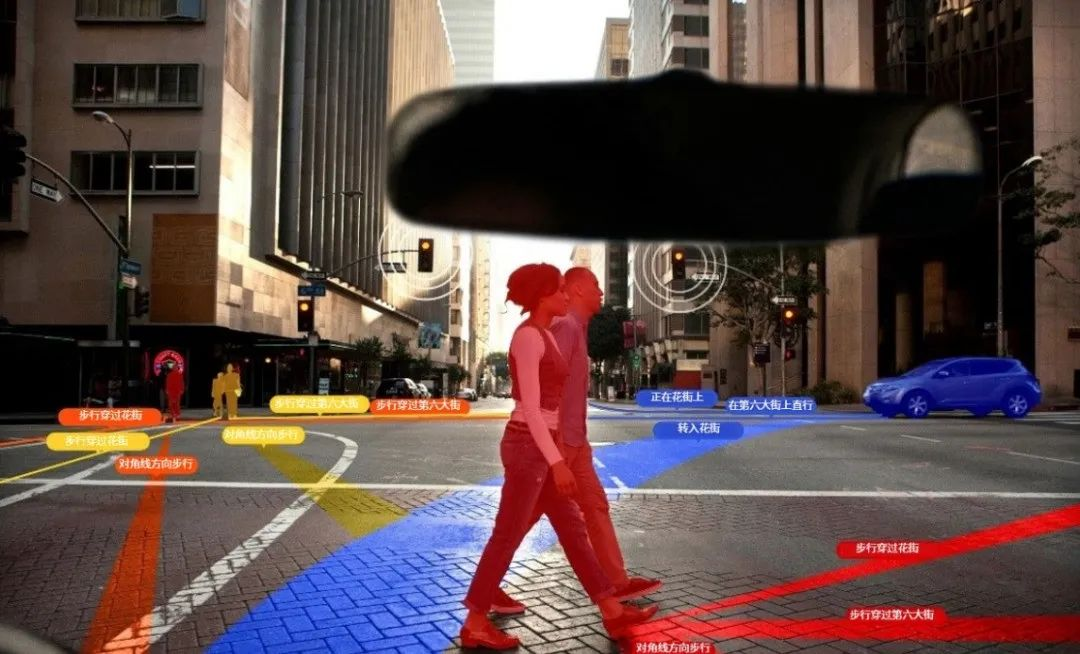

有别于传统上更多基于规则的自动驾驶算法,端到端模型能够直接基于传感器输入(如摄像头数据),学习如何控制输出,无需人为设计复杂的中间表示。

举个例子,在端到端自动驾驶方案中,想要让模型学会不闯红灯,无需设计规则,只要多用高质量的交通信号灯视频训练它就行。

这也就意味着,端到端模型能够更好地处理复杂的交通场景:相比于对手写规则的依赖,此类模型可以针对实际场景进行推理,更能够解决corner case带来的应用落地问题。

量子位智库在《2023年度十大前沿科技趋势报告》中指出,端到端自动驾驶技术以全部模块神经网络化为特征,对规则的依赖度低,具备智能涌现能力和跨场景应用潜力。

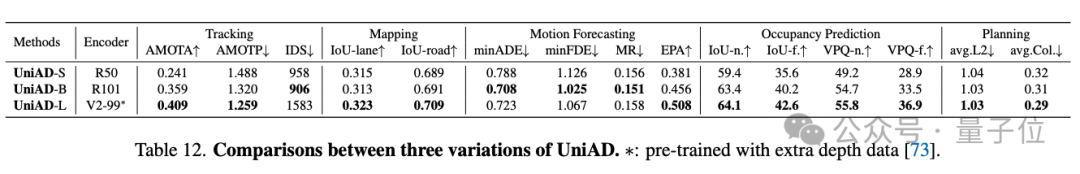

而在CVPR 2023最佳论文《Planning-oriented Autonomous Driving》中,研究人员通过实验证明,骨干网络的增大能够带来感知分数的提升,这可能进一步改善模型的预测和规划性能。

也就是说,更大的模型能够提供更丰富的特征表示和更复杂的任务处理能力,能够更好地支持自动驾驶场景中复杂的数据处理和决策制定。

如果说大模型驱动的自动驾驶还是探索进行时,生成式AI与智能座舱的结合,则已经更快一步有了具体落地案例。

在今年的CES上就可见一斑。

比如吉利银河E8,就已大模型上车,实现了车上的影音娱乐和AI交互的个性化:基于文生图大模型,秒级生成私人定制款专属壁纸、精准推荐音乐还能基于音乐意境生成风格化壁纸、AI数字精灵具备“人设”更加拟人……

高通的骁龙数字底盘概念车,更直观展现出了边缘侧生成式AI的高效用例。

比如仪表盘上出现了一个警示灯,不必研究用户手册,直接向数字助手提问就能立刻得到答案。AI甚至还能帮助你当场预约维修。

关键是,部署在车端的大模型,即终端侧AI的模式,在结合本地数据提供更加个性化的座舱服务的同时,能够保护用户数据“足不出车”。这既保障了用户的隐私安全,也缓解了云端处理带来的时延问题。

另外,对端侧算力的充分利用也能大大缓解用户规模化增长给云端算力带来的成本压力。

不难看出,对于自动驾驶领域而言,大模型的技术浪潮,带来了突破当前技术瓶颈的新路径。因此也不乏业内人士给出这样的判断:真正要在通用场景下实现L4、L5级自动驾驶,大模型不可或缺。

值得关注的是,尽管云侧基础大模型及其应用一年来进展飞速,但大模型上车,仍然存在不小的挑战。

其一,是数据问题。相比于互联网的海量数据,自动驾驶领域本身数据量要小得多,并且对于训练端到端模型而言,来自优秀人类驾驶员的高质量数据更为关键。

其二,是算力问题。无论是智能驾驶中的路况实时推理,还是智能座舱中的用户意图理解和功能调度,都对端侧算力有着更高的需求。

其三,还有安全性问题。这一方面涉及到端到端自动驾驶模型的可解释性,另一方面,是端云结合过程中,如何确保用户隐私数据不泄露的问题。

而从硬件的视角来看,这些问题,实际上都对车载芯片提出了更高的要求。

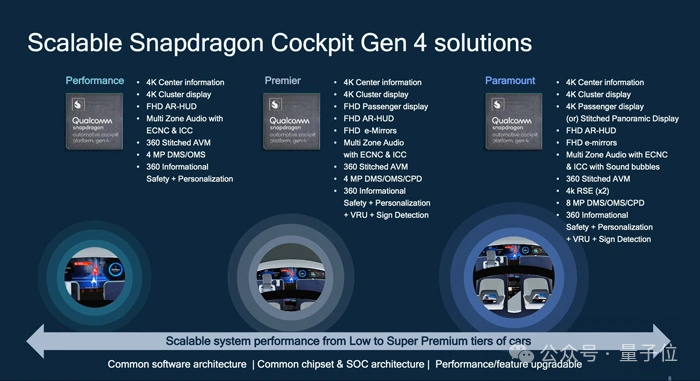

如果说骁龙8155(第三代旗舰级骁龙座舱平台)在过去几年中已经成为座舱是否智能的事实衡量标准之一,那么,在CES“车展”上频频出现的另一个关键词,已经透露出“模力时代”智能车新的竞逐方向——

骁龙8295(第四代至尊级骁龙座舱平台)。

从国产造车新势力,到奔驰宝马,CES上亮相的最新量产车上,骁龙8295已经成为新的标配。

在大模型上车的最新趋势里,车芯最新的进化方向是什么样的,不妨就以骁龙8295为例,具体拆解来看。

骁龙8295采用5nm工艺制程打造。算力方面,其CPU算力达到230K DMIPS,是骁龙8155的8倍;GPU则可实现每秒2.9万亿次单精度浮点运算(2.9TFLOPS)或每秒5.8万次半精度浮点运算(5.8TFLOPS),相较于8155,整体性能提升2倍,3D渲染性能提升3倍,能同时带动车内11块屏幕,远超市面上其他车机芯片。

更关键的是,骁龙8295搭载双核NPU,AI算力从8155的4TOPS直接跃升至30TOPS。

这样的参数性能,放在车规级芯片上,可以说是一骑绝尘。而反映到功能上,大模型、多模态交互、离线语音,甚至是舱泊一体、驾舱一体,都有了实现的基础。

以搭载了骁龙8295的极越01为例,云端的语音识别算法模型直接放在车端,实时响应时间能从1.5秒缩短到700毫秒。

除了常规自主泊车,还能在车外语音控制车辆实现自主泊车。

车内,在骁龙8295的支持下,极越01能实现对不同说话人的识别,也就是支持多人同时语音功能。配合离线语音库,即使没有网络连接,也能实现全功能语音识别。

并且车内的智能交互,现在也不仅仅停留在语音层面,配合眼神、动作的多模态交互,现在也可以在车上实现。比如,想要打开车上的某一扇窗户,不用详细说明,只要一句“打开窗户”再配合视线,车上AI就能秒懂车主心意。

值得一提的是,骁龙8295作为可扩展自动驾驶SoC平台,拥有广泛的软件生态系统,包括视觉感知、泊车和驾驶员检测软件栈等等。

对于车企而言,这意味着在骁龙座舱平台的基础上整“花活”更加方便快捷。

而站在消费者的角度,座舱内智能化体验的升级,以上所述也仅仅是个开始。

大模型带来的变革,核心是人机交互方式的变革。

而智能车作为被给予厚望的“智能空间”,自然而然成为这场重构一切的技术变革风暴中不容忽视的一环。

智能车的“ChatGPT时刻”具体何时会到来,还没有人能够准确地预判。但至少在软硬件准备上,以高通为代表的玩家,已经率先一步做好了迎接爆发的准备。

事实上,这种逐渐聚焦到终端的对新“ChatGPT时刻”的期待,在2024年开端的这场CES上,可以说是无处不在。智能车备受瞩目,但远非全部。

从爆火的AI掌机Rabbit R1,到AI PC,再到AR/VR和具身智能机器人,AI与终端的结合,几乎已经蔓延到CES会场的每一个角落。

“模力时代”新一阶段的变革走向,也在其中越发显现:大模型/生成式AI技术落地到端侧,是新一轮AI机遇爆发的关键。

对此,高通公司总裁兼CEO安蒙在CES主题演讲中谈到:

生成式AI的发展,正在从第一阶段走向第二阶段。当前,整个行业已经将生成式AI在处理器中落地,下一步将是使用场景和应用的开发。

归结原因,核心其实是,数据在哪里,AI推理就应该在哪里进行。

一方面,云计算推理成本正随着大模型应用用户数量的增加和模型参数规模的增大而急剧增加,需要充分利用端侧算力来平衡成本。另一方面,只有当终端就能运行AI大模型用例时,个人数据才能在受到保护的前提下被充分运用,实现真正个性化的大模型应用。

总而言之,2024年一开年,“模力时代”终端变革的一角,已经进一步向大众揭开。

可以预见的是,变革的风暴不会就此停滞,更多的智能变化,或许就将在这一年中,通过智能终端,离你我的生活更进一步。