视频生成还可以这么玩?

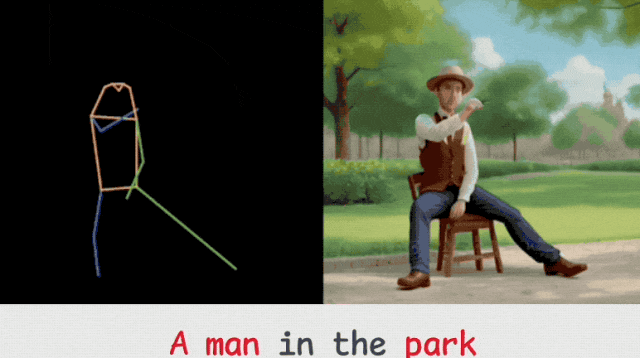

来一个“火柴人”做做动作示范,再加文本描述,即可让各种形象惟妙惟肖地跟着动起来。

比如男人在公园椅子上做远眺姿势:

钢铁侠街边起舞:

蝙蝠侠也不闲着,水上打拳:

形象数量可以随意添加:

风格也能任意切换(上:新海诚,下:梵高):

如此看下来,让任意一个八杆子打不着的形象跳个科目三,也是简简单单了。

如上成果便是不久前入选了AAAI 2024的姿态全可控视频生成框架:Follow-Your-Pose。

出自清华大学、香港科技大学、腾讯AI Lab以及中科院。

相关代码已在GitHub揽获800颗标星。

有网友惊叹,有了它:

TikTok/抖音的舞蹈将永远花样百出。

那么以下,为作者投稿内容,一起来看看它具体是如何做到的吧。

现如今,生成文本可编辑和姿势可控的角色视频在创建各种数字人方面具有迫切的需求。

然而,由于缺乏一个全面的、具有成对的视频-姿态-文本的生成数据集,从而使这项任务受到了限制。

在这项工作中,研究团队设计了一种新颖的两阶段训练方案,该方案可以利用易于获得的数据集(即图像姿势对和无姿势视频)和预训练的文本到图像(T2I)模型来获得姿势可控的角色视频。

具体来说,在第一阶段,只有姿态图像对仅用于可控的文本到图像生成。

团队学习了一个零初始化的卷积编码器来对姿态信息进行编码。

在第二阶段通过添加可学习的时间自注意力和改革后的跨帧自注意力块,用无姿势视频数据集对上述网络的运动进行微调。

在团队新设计的支持下,该方法成功地生成了连续的姿势可控的角色视频,同时保留了预训练的T2I模型的概念生成和合成能力。

具体来说,该两阶段训练策略,可有效地从研究团队提出的LAION-Pose数据集中学习图像姿势对齐,并从没有姿势注释的自然视频中学习时间相干性。

在第一阶段训练中,只有姿态编码器Ep可以训练来学习姿态控制。

在第二阶段训练中,只有时间模块是可训练的,包括时间自注意力(SA)和跨帧自注意力。

在推理过程中,通过提供描述目标角色和相应外观的文本以及表示运动的姿势序列来生成时间连贯的视频。

预训练稳定扩散的大多数参数都被冻结,包括伪 3D 卷积层以及交叉注意力(CA)和前馈网络(FFN)模块。具体框架结构如下。

为了进一步保持时间一致性,研究团队利用帧间自注意力(SA)来进行交叉帧处理。

不同的是,他们通过简单地在DDIM的上一次采样过程中重复使用每个时间步长的噪声,来生成更长的视频序列。

具体而言,假设每次采样T帧,将最后T帧的噪声添加到下一个2个循环中,作为先验知识。

需要注意的是,在整个去噪过程中,为了确保生成的长视频的时间一致性,会将每个时间步长的噪声添加到先验知识中。

如框架图所示,所提出的方法仅调整了用于视频生成的帧间自注意力和时间自注意力。

通过以上两阶段的训练,结合为每个阶段精心设计的可调节模块,研究团队所提出的方法可以从轻松获得的数据集(例如人体和姿势的图像对以及随机视频)中生成连续的姿势可控视频。

这篇工作主要解决了生成文本可编辑且姿势可控制的角色视频的问题。

为实现这一目标,作者重新设计和调整了预训练的文本到图像模型,因为它具有强大的语义编辑和组合能力。

并设计了一个新的两阶段训练方案,可以利用大规模的图像姿势对和多样化的无姿势数据集。

具体而言,在第一训练阶段,使用姿势编码器将姿势信息注入网络结构,并从图像-姿势对中学习,以实现姿势可控的文本到图像生成。

在第二训练阶段,研将图像模型扩展为3D网络,从无姿势视频中学习时间上的连贯性。

通过研究团队的几项新设计,所得框架可以生成具有新颖创意和时间上连贯的视频,同时保留原始T2I模型的概念组合能力。

论文:

https://arxiv.org/abs/2304.01186

代码:

https://github.com/mayuelala/FollowYourPose

更多效果:

https://follow-your-pose.github.io/

文章来自于微信公众号“量子位”(ID: QbitAI),作者 “THUSIFSICLAB”

【开源免费】Fay开源数字人框架是一个AI数字人项目,该项目可以帮你实现“线上线下的数字人销售员”,

“一个人机交互的数字人助理”或者是一个一个可以自主决策、主动联系管理员的智能体数字人。

项目地址:https://github.com/xszyou/Fay

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales