随着多模态大模型的不断演进,指令引导的图像编辑(Instruction-guided Image Editing)技术取得了显著进展。然而,现有模型在遵循复杂、精细的文本指令方面仍面临巨大挑战,往往需要用户进行多次尝试和手动筛选,难以实现稳定、高质量的「一步到位」式编辑。

强化学习(RL)为模型实现自我演进、提升指令遵循能力提供了一条极具潜力的路径。但其在图像编辑领域的应用,长期以来受限于一个核心瓶颈:缺乏一个能够精确评估编辑质量并提供高保真度反馈的奖励模型(Reward Model)。没有可靠的「奖励信号」,模型便无法有效判断自身生成结果的优劣,从而难以实现高效的自我优化。

为攻克这一难题,北京智源人工智能研究院 VectorSpace Lab 团队近日发布了全新的高保真奖励模型系列——EditScore。该工作直面上述挑战,旨在为指令引导的图像编辑任务提供精确、可靠的奖励信号,从而为强化学习在 AIGC 领域的深入应用铺平道路,真正解锁其强大潜力。

EditScore 是智源在成功推出统一图像生成模型 OmniGen 系列之后,对更通用、更可控的生成式 AI 的又一重要探索。为了促进未来在奖励建模、策略优化和⼈⼯智能驱动的模型改进等领域的研究,EditScore 模型系列和 EditReward-Bench 数据集现已全⾯开源。同时,经过强化学习微调的 OmniGen2-EditScore7B 模型也已同步开放。

团队表示,后续将陆续发布应⽤于 OmniGen2 的强化学习训练代码,以及针对 OmniGen2、Flux-dev-Kontext 和 Qwen-Image-Edit 的 Best-of-N 推理脚本,欢迎社区持续关注。

为了克服图像编辑领域缺乏高质量奖励信号的障碍,EditScore 团队提出了一套系统的两步解决方案。

第⼀步:建⽴严谨的评估标准

⼯欲善其事,必先利其器。为了能够直接、可靠地评估图像编辑奖励模型的质量,团队⾸先构建并开源了 EditReward-Bench,这是业界⾸个专⻔为评估图像编辑奖励模型⽽设计的公开基准,涵盖了 13 个不同的⼦任务和 11 个当前最先进的编辑模型(包括闭源模型),并包含了专家级的⼈⼯标注,为衡量奖励信号的质量建⽴了⻩⾦标准。

第⼆步:开发强⼤的多功能⼯具

在 EditReward-Bench 的指引下,团队精⼼策划数据并进⾏训练,最终成功开发出 EditScore 系列模型(分为 7B、32B、72B 三个尺⼨)。这⼀系列模型是专为指令图像编辑任务设计的⾼保真奖励模型,旨在提供⽐通⽤视觉语⾔模型(VLM)更精确的反馈信号。

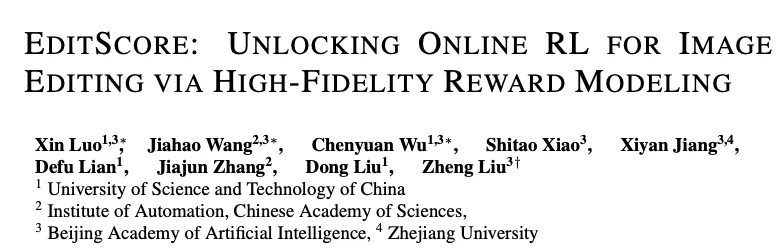

EditReward-Bench 上的基准测试结果,显示了 EditScore 相较于其他模型的优越性

核心亮点:

EditScore 的实⽤价值在两个关键应⽤中得到了充分验证:

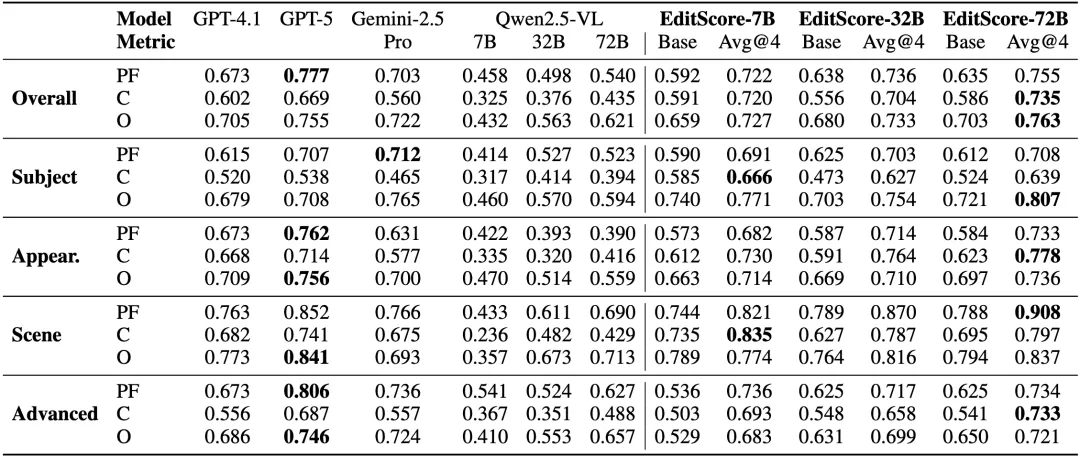

a.作为最先进的重排序器:通过「优中选优」(Best-of-N)的⽅式,EditScore 能够即时提升多种主流编辑模型的输出质量。

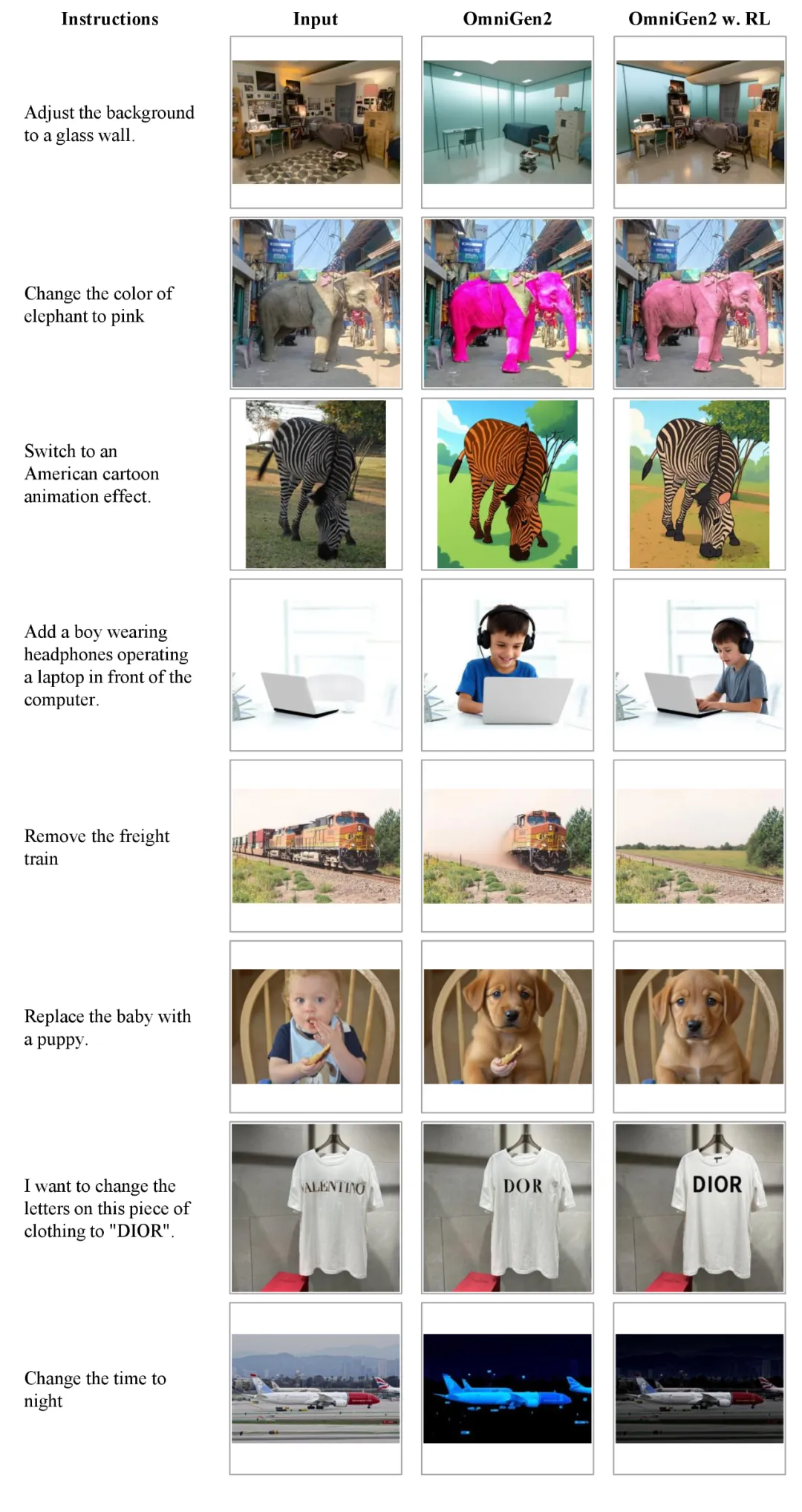

b.作为强化学习的⾼保真奖励:当通⽤视觉语⾔模型在强化学习训练中束⼿⽆策时,EditScore 能够提供稳定且⾼质量的奖励信号,成功解锁了在线强化学习在图像编辑领域的应⽤,并带来了显著的性能提升。 团队的实验表明,将 EditScore-7B 应⽤于 OmniGen2 模型的 Flow-GRPO 微调后,OmniGen2 在 GEdit 基准上的得分从 6.28 提升⾄ 6.83。

EditScore 作为图像编辑的卓越奖励信号,能够精确区分编辑质量的好坏。

将 EditScore 作为强化学习奖励模型应用于 OmniGen2 的视觉结果对比

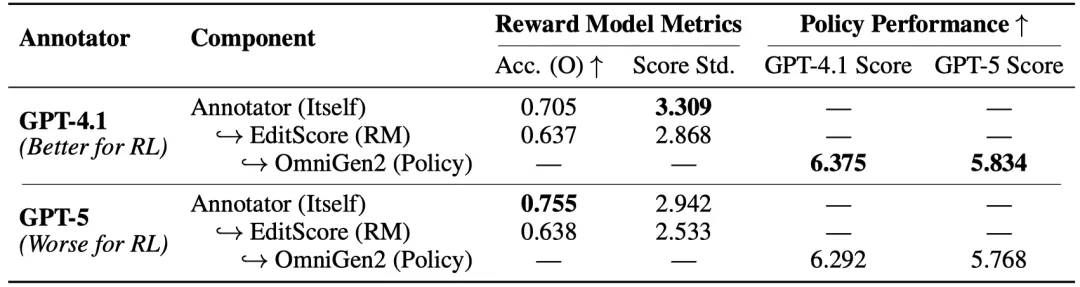

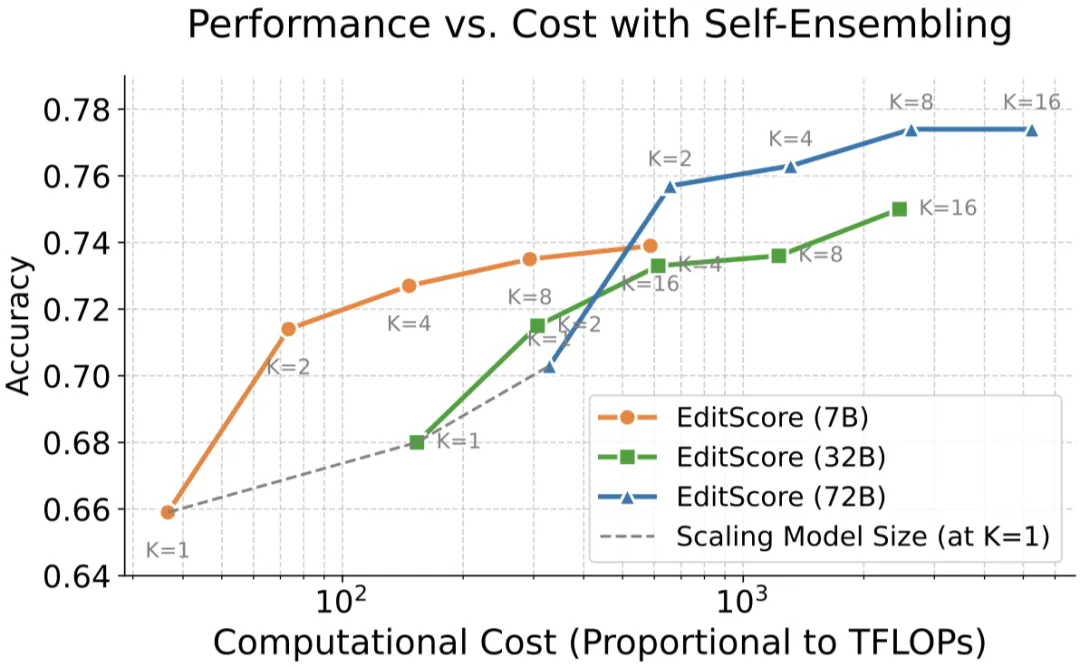

在研究过程中,团队还获得了⼀些有趣的洞⻅:

GPT-4.1 系列奖励模型凭借更优的输出分布特性,能够更有效地指导强化学习优化

EditScore 持续的从参数拓展和测试时计算拓展(Self-ensemble)中获得性能增益

智能的成长离不开自我评估与持续进化。EditScore 让模型具备了「自我审视」与「自我进化」的能力,为提升 AIGC 的可控性与可靠性打开了新的可能。

智源研究团队表示,将持续深入奖励建模研究,「我们很高兴将 EditScore、EditReward-Bench 、OmniGen2-EditScore7B 以及所有的研究发现开源,希望能为业界带来新的启发,期待与社区共同探索,让 AIGC 模型变得更智能、更可控、更可靠,在更多领域释放创造的力量」。

文章来自于“机器之心”,作者“机器之心”。

【部分开源免费】FLUX是由Black Forest Labs开发的一个文生图和图生图的AI绘图项目,该团队为前SD成员构成。该项目是目前效果最好的文生图开源项目,效果堪比midjourney。

项目地址:https://github.com/black-forest-labs/flux

在线使用:https://fluximg.com/zh

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner