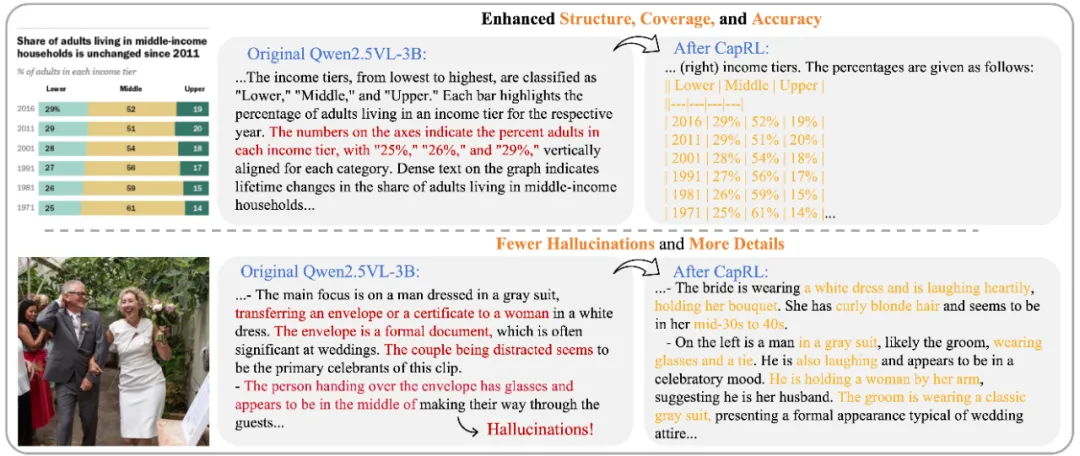

今天推荐一个 Dense Image Captioning 的最新技术 —— CapRL (Captioning Reinforcement Learning)。CapRL 首次成功将 DeepSeek-R1 的强化学习方法应用到 image captioning 这种开放视觉任务,创新的以实用性重新定义 image captioning 的 reward。训练得到的 CapRL-3B 模型,可以成功达到与 Qwen2.5-VL-72B 相当的 captioning 水平!这是 image captioning 领域的一大进展,更是为 GRPO 策略应用于开放任务提供了重要思路!

目前 Huggingface model&dataset 总下载量已经突破 6k,并且正在迭代更强的基座模型以及升级 training recipe,欢迎使用!

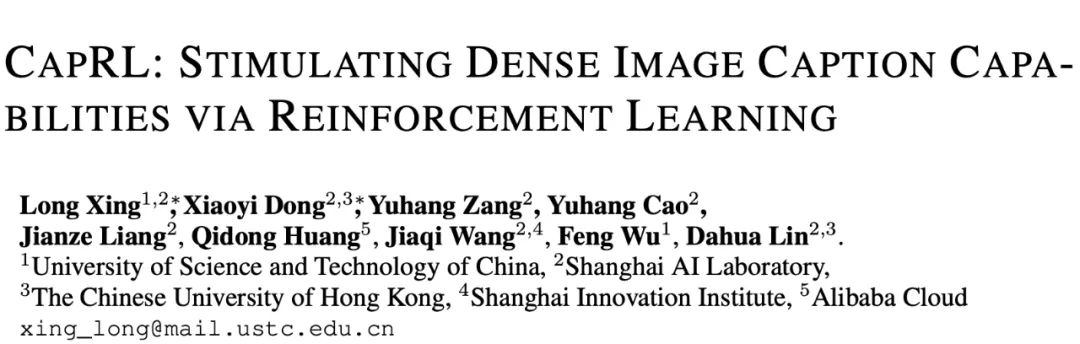

图 1. CapRL 解决了为 image captioning 这种主观任务设计 reward 的重大挑战,巧妙的以实用性定义了客观 verifiable reward,避免了使用 LVLM-as-a-Judge 带来的 reward hacking,显著提升了描述的质量

Image Captioning 旨在为给定图像生成自然语言描述,弥合视觉与语言世界之间的鸿沟,是目前 ViT 训练以及 LVLM 预训练重要的训练语料。目前大多数 Image Captioning 模型都是基于 LVLMs 并采用监督微调(SFT)方法进行训练,但是这种训练方式有两大问题,数据方面依赖大量由人工或闭源模型标注的数据集,成本高昂且难以扩展,效果方面因为死记硬背的训练方式导致泛化与多样性不足。

SFT 的局限性促使研究者转向一种新的范式 —— 基于可验证奖励的强化学习(RLVR)。RLVR 这种训练范式在 visual grounding,detection 这种包含标准答案的视觉任务上已经得到广泛应用,然而,将 RLVR 应用于 Image Captioning 等开放性任务仍然非常具有挑战性,其关键在于如何设计一个客观可靠的 reward 函数。“什么是一个好的图片描述?”,这个问题带有很强的主观性,大家往往看法不一,同一张图片可能会存在多种不同的合理描述,这就给 verifiable reward 设计带来很大的困难。

现有的一些方法尝试使用奖励模型(reward models)或 LVLM-as-a-judge 来提供 reward,如图 1(a)所示,但是这种方法非常容易受到奖励欺骗(reward hacking)的影响。模型可能学会利用奖励模型的漏洞(偏好冗长或简短的输出形式)来获得更高分数,而非真正生成高质量的描述,这种不可靠的奖励信号很容易导致在 GRPO 训练过程中出现异常,图 1(c)中展示了训练过程中出现了 caption 过长以及过短的情况,最终导致模型的表现不及预期甚至出现训练崩溃。

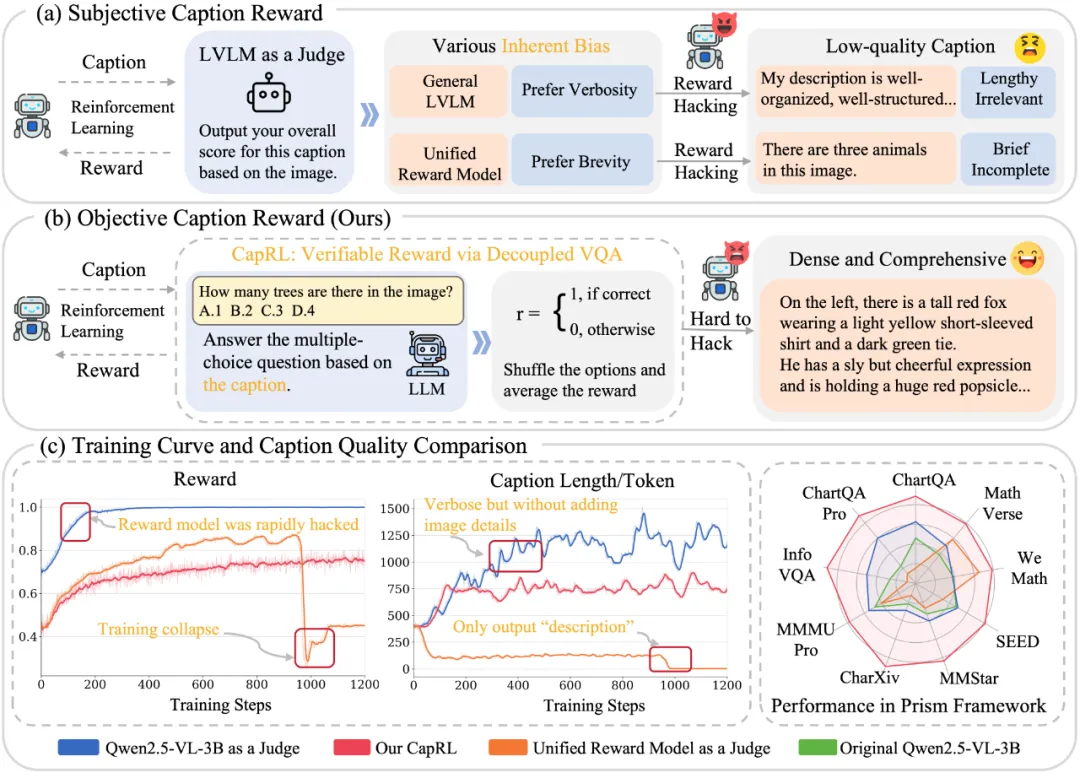

图 2. CapRL 框架。 我们的 CapRL 采用了解耦的两阶段流程,首先 LVLM 生成图像描述,然后让一个 LLM 基于该图像描述回答视觉多选题,而 LLM 的回答准确率则作为 LVLM 的客观奖励信号

为了解决主观图像描述任务中 RLVR 奖励函数缺乏客观性的难题,我们提出了一种全新的视角:caption quality 与其实用性成正比。当图像描述足够详细且准确时,即使一个纯语言模型无法直接 “看到” 图像,也能回答与图像相关的视觉问答。例如图二中,对于问题 “图片里面谁在大笑?”,当描述中包含 “兔子警官 Judy 正在开怀大笑”,LLM 即可正确回答 “Judy”。

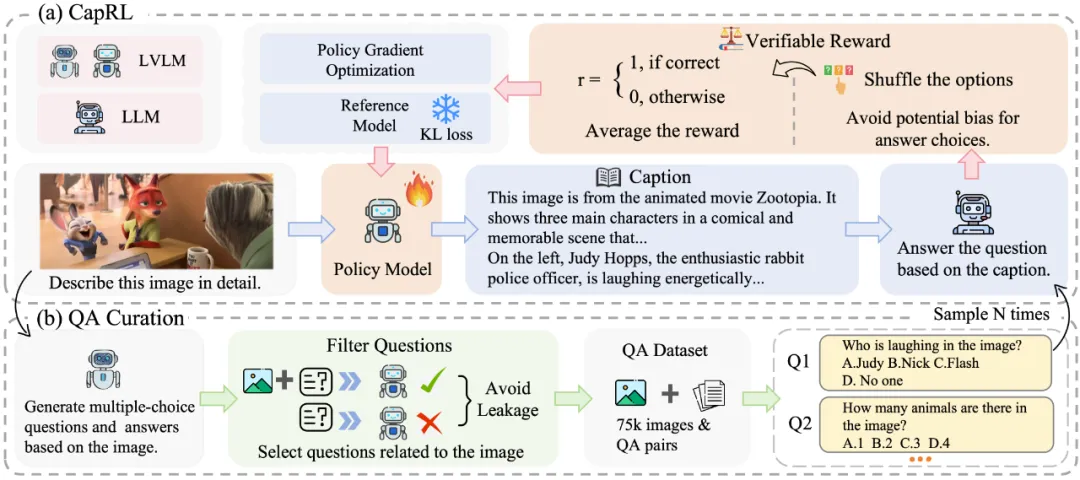

基于这一动机,我们提出了一个高效的两阶段解耦式训练框架,称为 CapRL(Captioning Reinforcement Learning)。在 CapRL 框架中,我们让一个纯语言模型根据 caption 去回答与原图像相关的多项选择题,LLM 的回答准确率即作为 RLVR 训练的客观奖励信号。基于 CapRL 训练之后,输出的描述如图 3 所示,会在准确率,细节覆盖等方面大幅度提升

图 3. CapRL 效果展示。Qwen2.5-VL-3B 经过 CapRL 训练之后描述的准确性更高,图片信息覆盖更全,含有更少幻觉。

我们对 CapRL 框架带来的优势进行了全面评估。

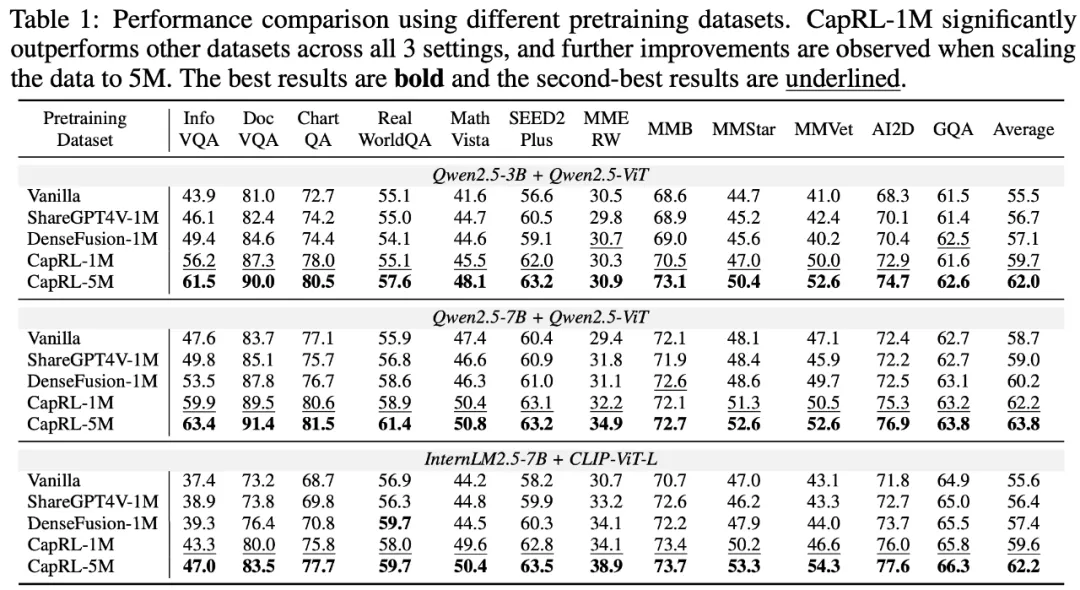

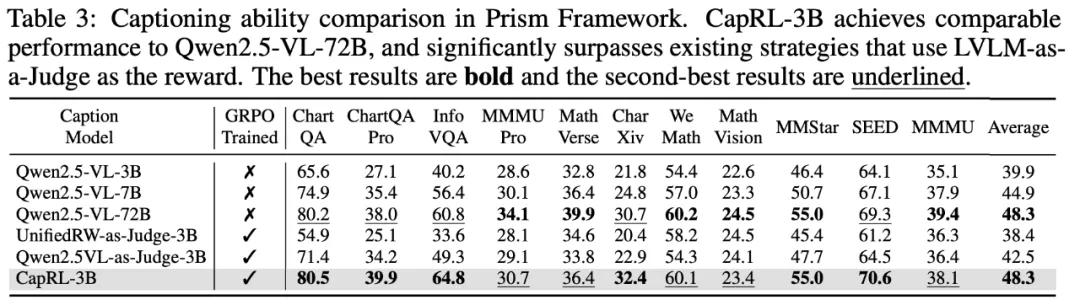

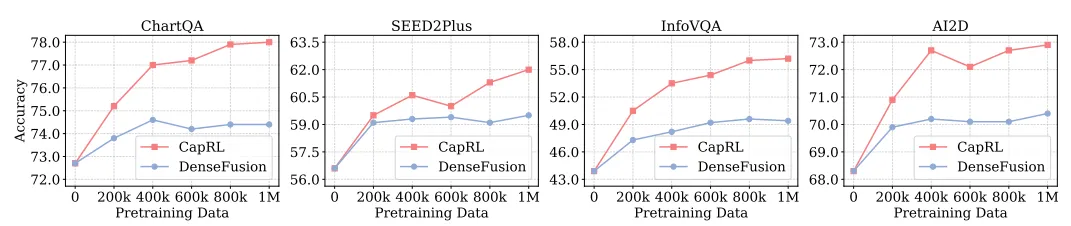

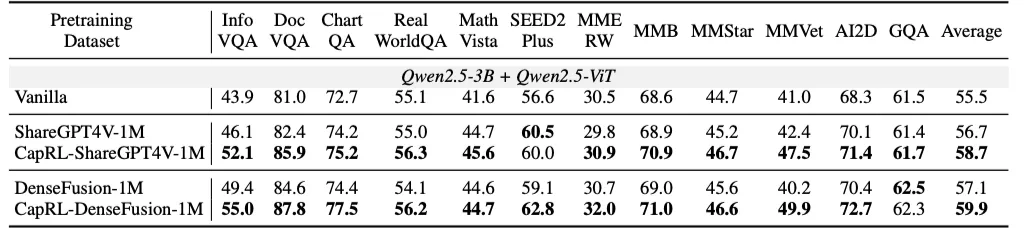

(i)我们使用 CapRL-3B 标注图片产生了 CapRL-5M 数据集,并在该数据集上对 LVLM 进行预训练,在全部 12 项基准测试中均取得了显著性能提升,与以往的 ShareGPT4V,DenseFusion dataset 的对比中展示出了巨大优势,效果如图 4 所示;(ii)此外,借助 Prism Framework 对描述质量进行直接的评估,我们观察到 CapRL-3B 的性能与 72B 模型相当,并在平均水平上超越基线模型 8.4%。

图 4. 使用不同预训练数据集的性能比较结果显示:CapRL-1M 在全部三个设置中均显著优于其他数据集,并且当数据规模扩展至 5M 时,模型性能进一步得到提升。

图 5. 在 Prism 框架下的图像描述能力对比中,CapRL-3B 的表现可与 Qwen2.5-VL-72B 相媲美,并且显著优于以 LVLM-as-a-Judge 作为奖励信号的现有方法。

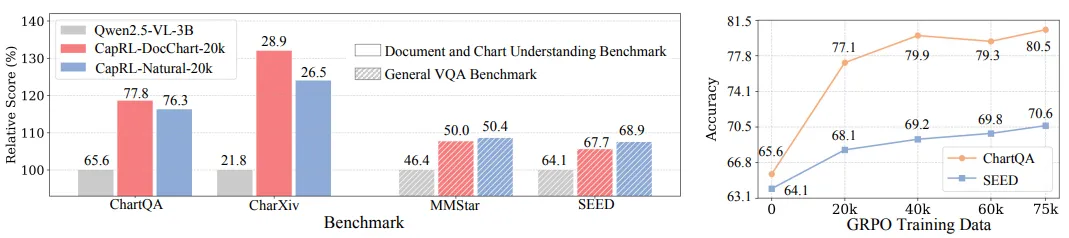

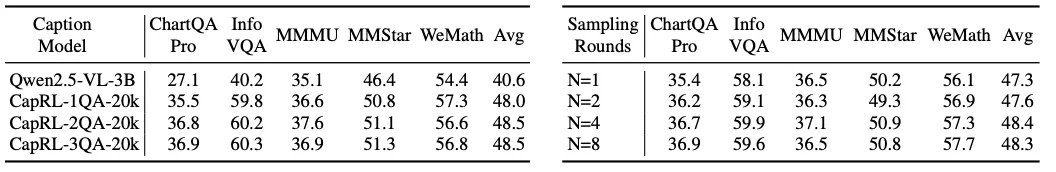

图 6. 我们针对 CapRL 进行了丰富的探究实验,具体实验设置可查看原论文

我们目前已经开源了论文中的模型,数据集和 QA 构造的代码,我们还在持续迭代中,欢迎使用!

文章来自于“机器之心”,作者“邢龙和董潇逸”。