阿里大模型,再次开源大放送——

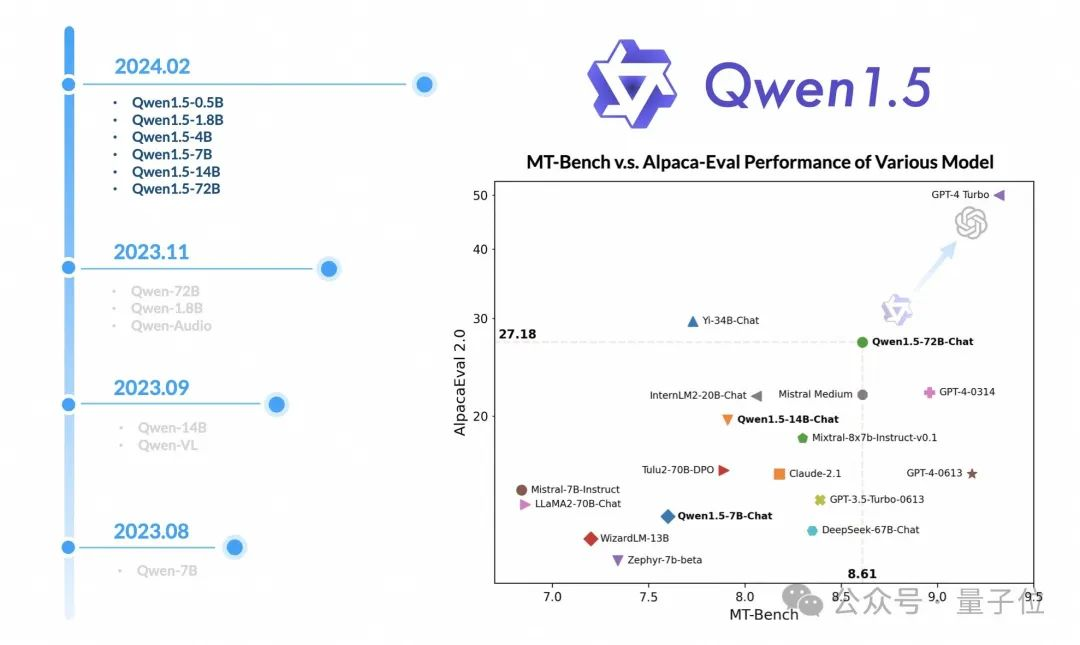

发布Qwen1.5版本,直接放出六种尺寸。

最大的Qwen1.5-72B-Chat模型,在MT-Bench和Alpaca-Eval v2上,超越Claude-2.1、GPT-3.5-Turbo-0613。

甚至在部分任务中,得分已经超过前几个版本的GPT-4。

各地的开发者前来祝贺,其中0.5B的迷你版让不少人都迫不及待想试试。

并且还顺便问问,那个多模态大模型Qwen-VL-Max有可能开源吗?

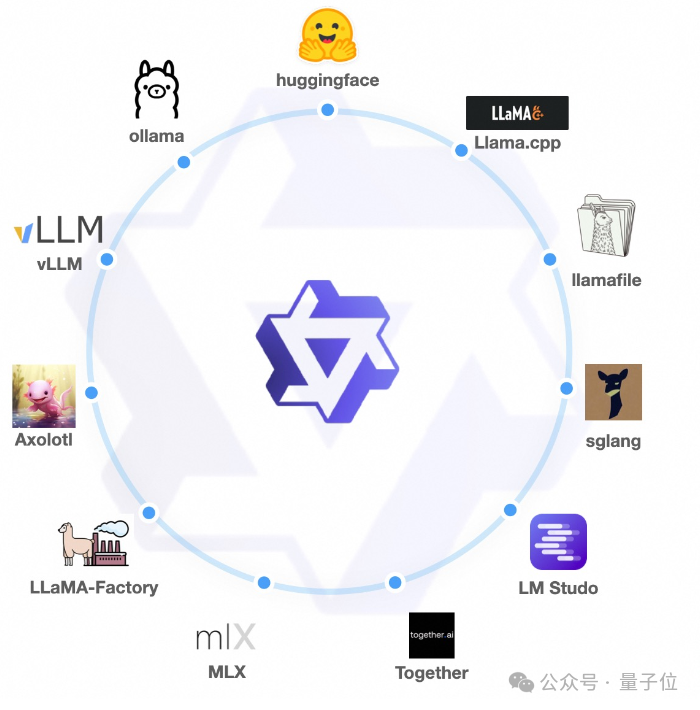

除此之外,还集成到了Hugging face transformers,以及同主流的十余个框架合作,从微调、部署、量化到本地推理一步到位。

此次开源发布,主要有四个方面值得关注。

首先,模型系列很多,直接开源了6种尺寸(0.5B、1.8B、4B、7B、14B、72B)的基础模型(base)、聊天模型(chat)以及量化模型(包括Int4 和 Int8 GPTQ 模型,以及 AWQ 和 GGUF 量化模型)。

其次,更多的生态融入。

目前,Qwen1.5的代码合并到Hugging Face transformers,使其transformers>=4.37.0而无需trust_remote_code。

此外,还同主流的第三方框架,比如vLLM、用于部署的SGLang 、用于量化的AutoAWQ、AutoGPTQ 、用于微调的Axolotl、LLaMA-Factory以及用于本地 LLM 推理的llama.cpp等进行了合作。

Qwen1.5系列可在Ollama、LMStudio等平台上使用。此外,API 服务不仅在 DashScope 上提供,而且在Together.ai上也提供,具有全球可访问性。

再者,性能更强。

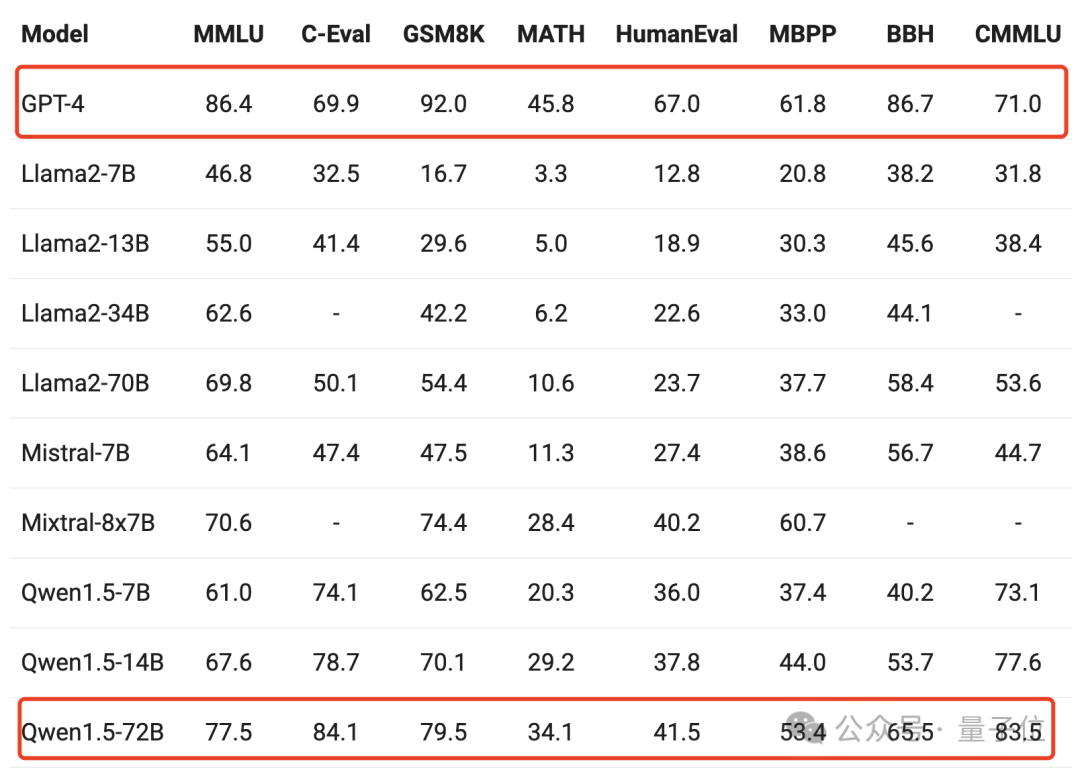

比如在基本能力的评估上,包括MMLU(5-shot)、C-Eval、Humaneval、GS8K、BBH等基准测试中可以看到,Qwen1.5-72B一些分数上已经超过了GPT-4。

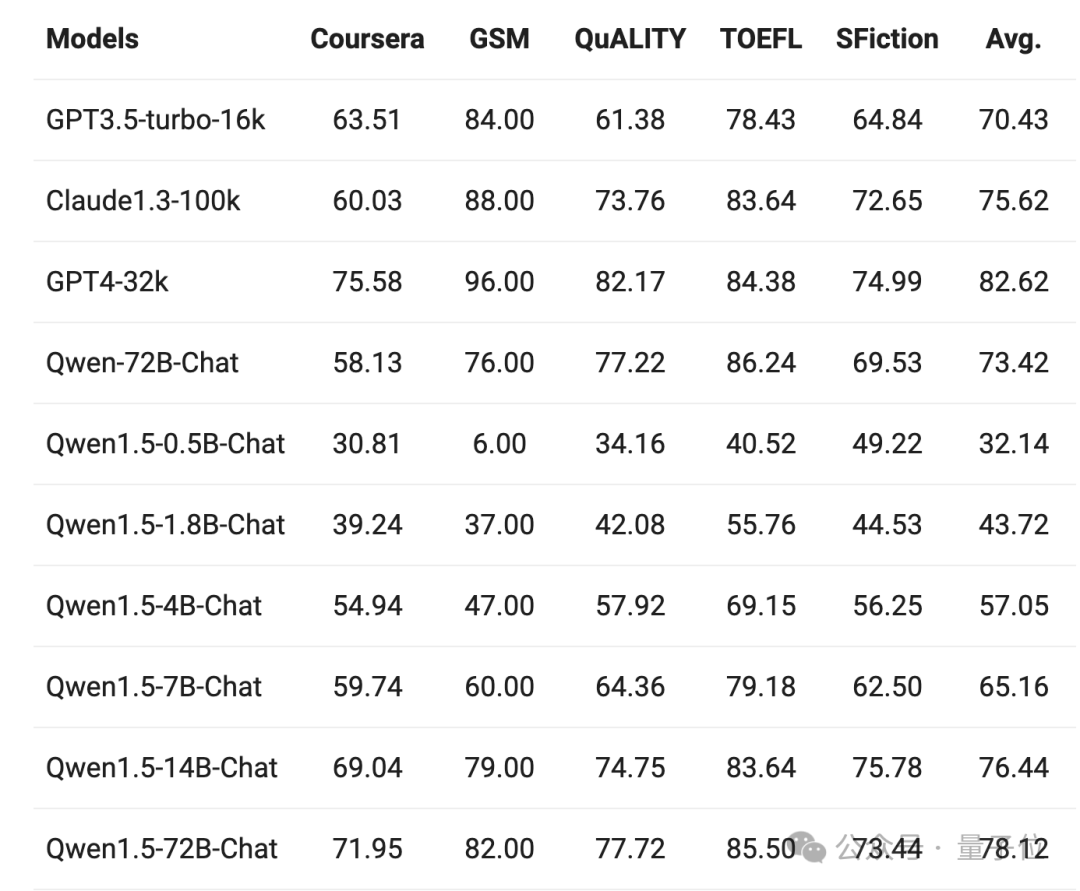

在长上下文支持上,全系列模型的能力都有一定的拓展。尤其Chat模型,像Qwen1.5-7B-Chat这样的小模型,在5个任务中有4个表现与GPT-3.5相当。

而Qwen1.5-72B-Chat的性能,则明显优于 GPT3.5-turbo-16k,略微落后于 GPT4-32k。

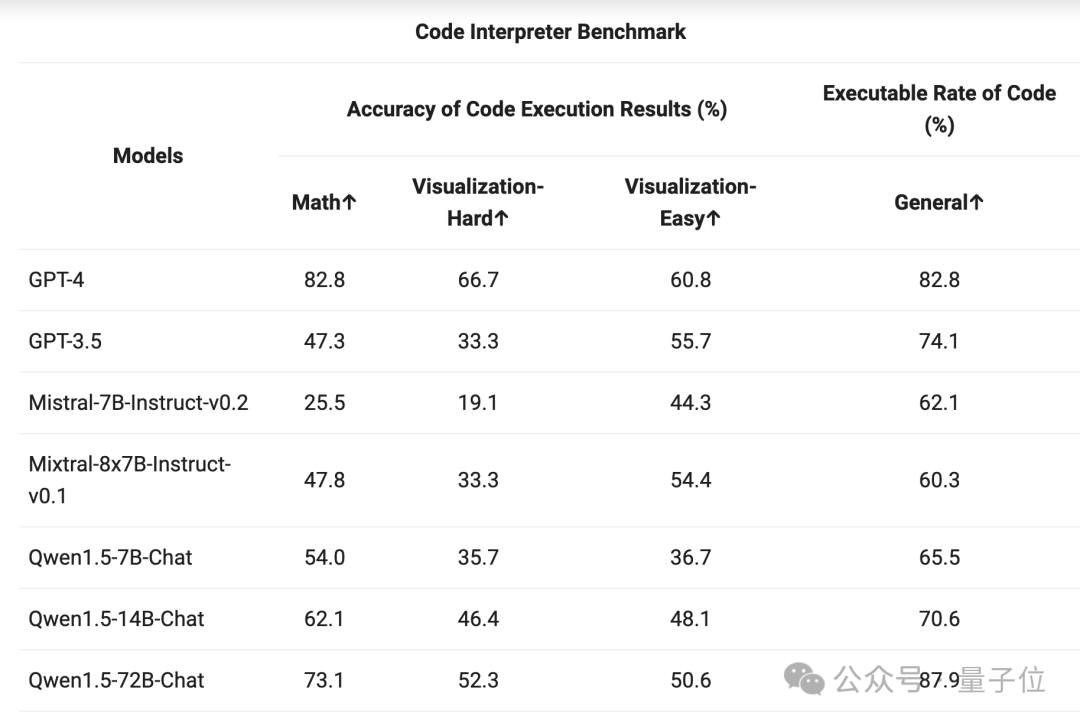

在代码执行上,72B聊天模型在数学以及可视化方面离GPT-4还有一定的差距,但代码可执行率超过GPT-4。不过他们表示,会在在未来的版本中得到增强。

除此之外,此次功能也得到了升级和统一。

这两天,与阿里大模型的进展还不少。

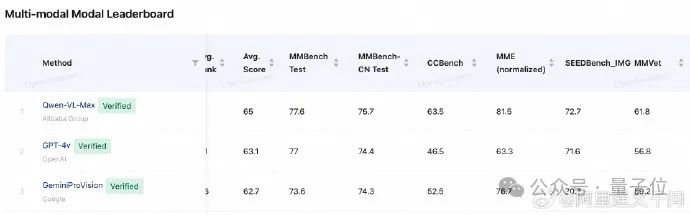

比如前几天,其多模态大模型Qwen-VL-Max登顶OpenCompass榜首。

以及在通义千问APP上,上线了不少春节免费新应用,比如全家福、拜新年、万物成龙等图像生成的功能。

此外,还有网友反馈说,通义千问2.0版本升级之后,能力提升得很明显。

你有感受到吗?

项目链接:

https://huggingface.co/collections/Qwen/qwen15-65c0a2f577b1ecb76d786524

https://qwenlm.github.io/zh/blog/qwen1.5/

参考链接:

[1]https://twitter.com/JustinLin610/status/1754538215959335100

[2]https://twitter.com/huybery/status/1754537742892232972

[3]https://twitter.com/_akhaliq/status/1754545091434139732

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0