7B开源模型,数学能力超过了千亿规模的GPT-4!

它的表现可谓是突破了开源模型的极限,连阿里通义的研究员也感叹缩放定律是不是失效了。

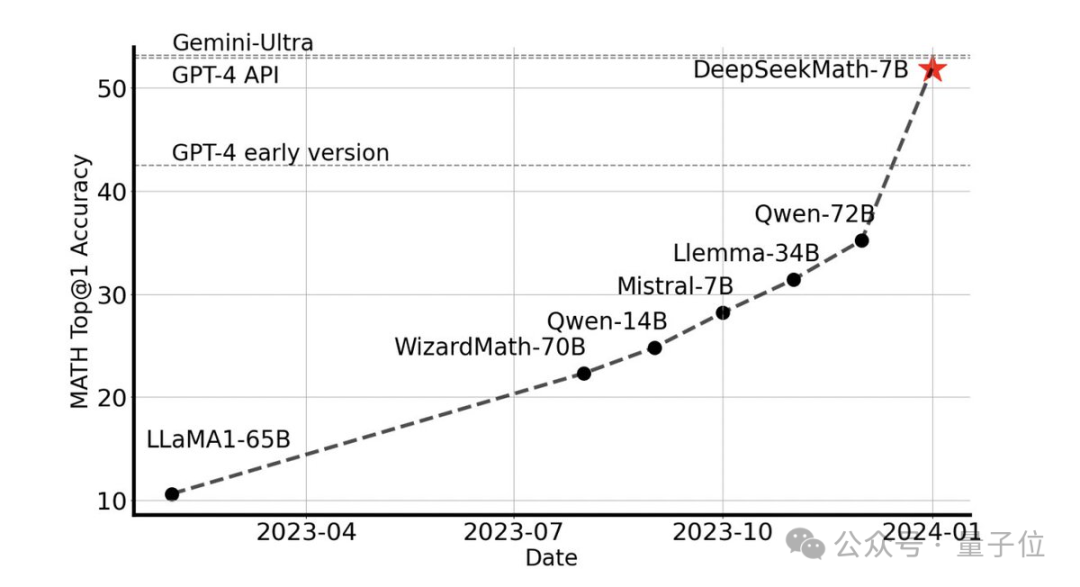

无需借助任何外部工具,它就能在竞赛水平的MATH数据集上达到51.7%的准确率。

在开源模型中,它第一个在该数据集上达到一半的准确率,甚至超过了早期和API版本的GPT-4。

这一表现让整个开源社区为之震撼,Stability AI的创始人Emad Mostaque也表示研发团队属实让人印象深刻,而且潜力被低估了。

它,就是深度求索团队最新开源的7B数学大模型DeepSeekMath。

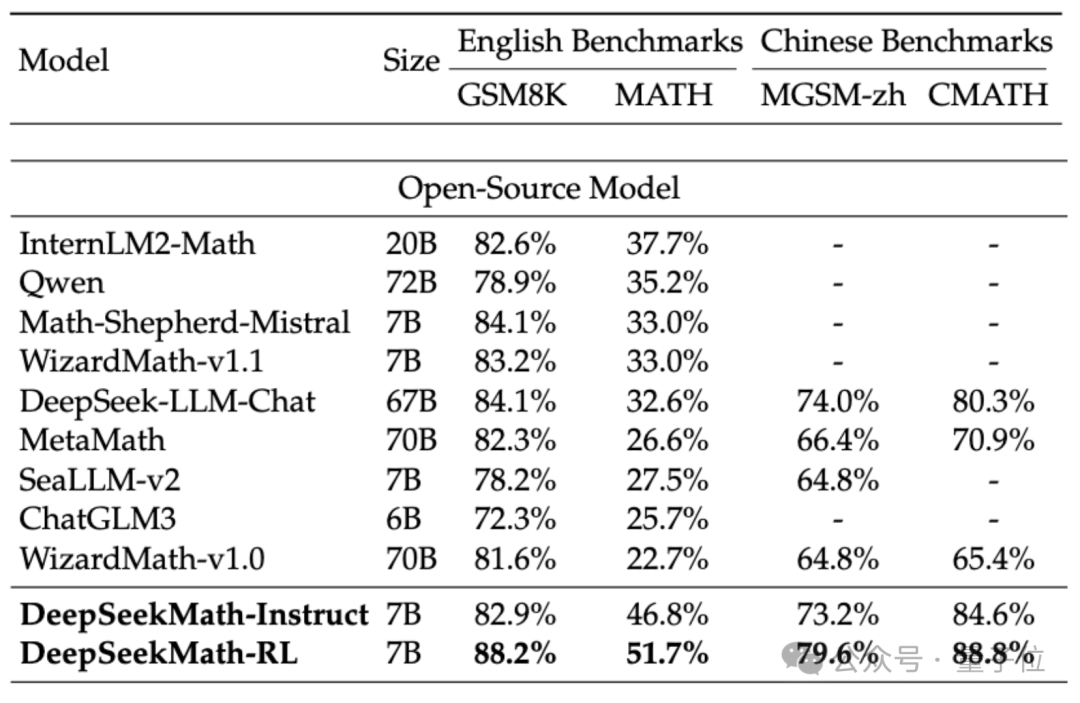

为了评估DeepSeekMath的数学能力,研究团队使用了中(MGSM-zh、CMATH)英(GSM8K、MATH)双语的数据集进行了测试。

在未使用辅助工具、仅靠思维链(CoT)提示的情况下,DeepSeekMath的表现均超越了其他开源模型,其中包括70B的数学大模型MetaMATH。

和自家推出的67B通用大模型相比,DeepSeekMath的成绩也有大幅提升。

如果考虑闭源模型,DeepSeekMath也是在几个数据集上都超越了Gemini Pro和GPT-3.5,在中文的CMATH上超越了GPT-4,MATH上的表现也与之接近。

但要注意的是,GPT-4按泄露规格是一个千亿参数的庞然大物,而DeepSeekMath参数量只有7B。

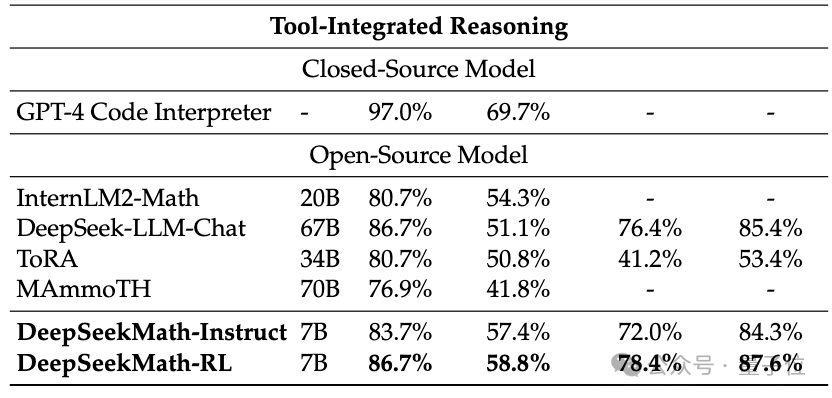

如果允许使用工具(Python)进行辅助,DeepSeekMath在竞赛难度(MATH)数据集上的表现还能再提高7个百分点。

那么,DeepSeekMath优异表现的背后,都应用了哪些技术呢?

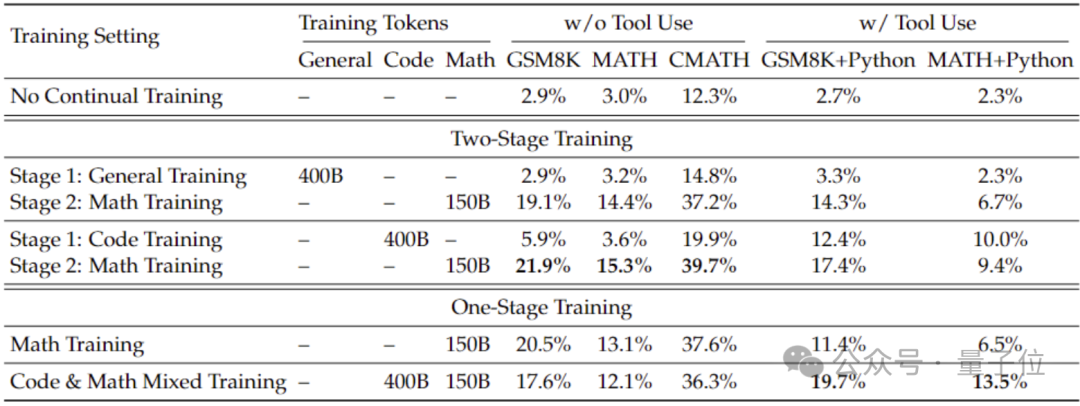

为了获得比从通用模型更好的数学能力,研究团队使用了代码模型DeepSeek-Coder-v1.5对其进行初始化。

因为团队发现,无论是在两阶段训练还是一阶段训练设置下,代码训练相比于通用数据训练都可以提升模型的数学能力。

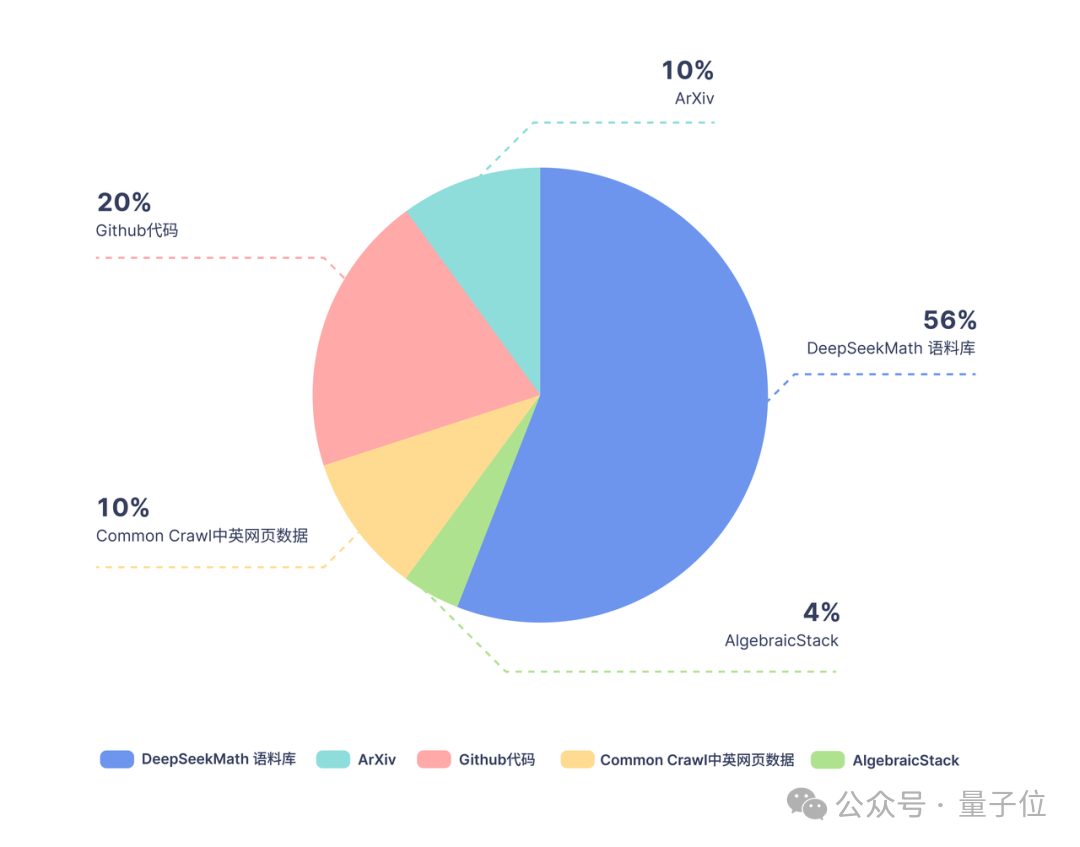

在Coder的基础上,研究团队继续训练了5000亿token,数据分布如下图:

训练数据方面,DeepSeekMath使用的是从Common Crawl提取的120B高质量数学网页数据,得到了DeepSeekMath Corpus,总数据量是开源数据集OpenWebMath的9倍。

数据采集过程是迭代式进行的,经过四次迭代,研究团队收集了3500多万个数学网页,Token数量达到了1200亿。

为了确保训练数据中不包含测试集的内容(因为GSM8K、MATH中的内容在互联网上大量存在),研究团队还专门进行了过滤。

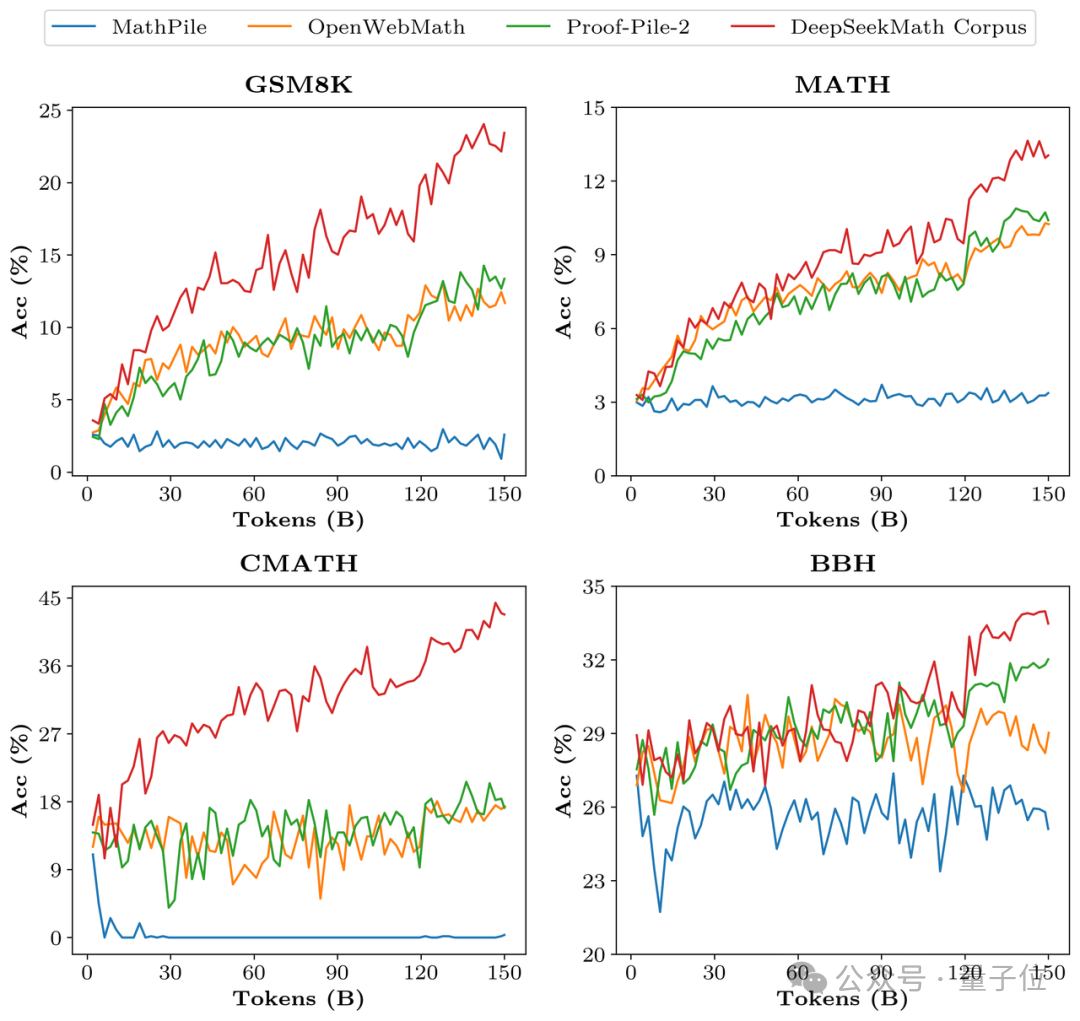

为了验证DeepSeekMath Corpus的数据质量,研究团队分别用MathPile等多个数据集训练了1500亿token,结果Corpus在多个数学基准上效果明显领先。

对齐阶段,研究团队首先构建了一个776K样本的中英文数学指导监督微调(SFT)数据集,其中包括CoT、PoT和工具集成推理等三种格式。

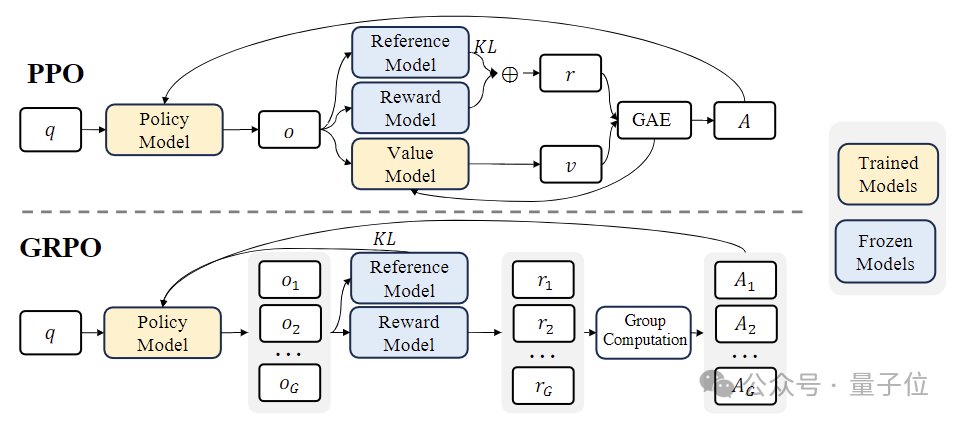

而在强化学习(RL)阶段,研究团队使用了一种名为“基于组的相对策略优化”(Group Relative Policy Optimization ,GRPO)的高效算法。

GRPO是近端策略优化(PPO)的一种变体,过程中传统的价值函数被替换为一个基于组的相对奖励估计,可以减少训练过程中的计算和内存需求。

同时,GRPO通过迭代过程进行训练,奖励模型会根据策略模型的输出不断更新,以确保策略的持续改进。

推出DeepSeekMath的深度求索团队,是国内开源模型领域的一名“头部选手”。

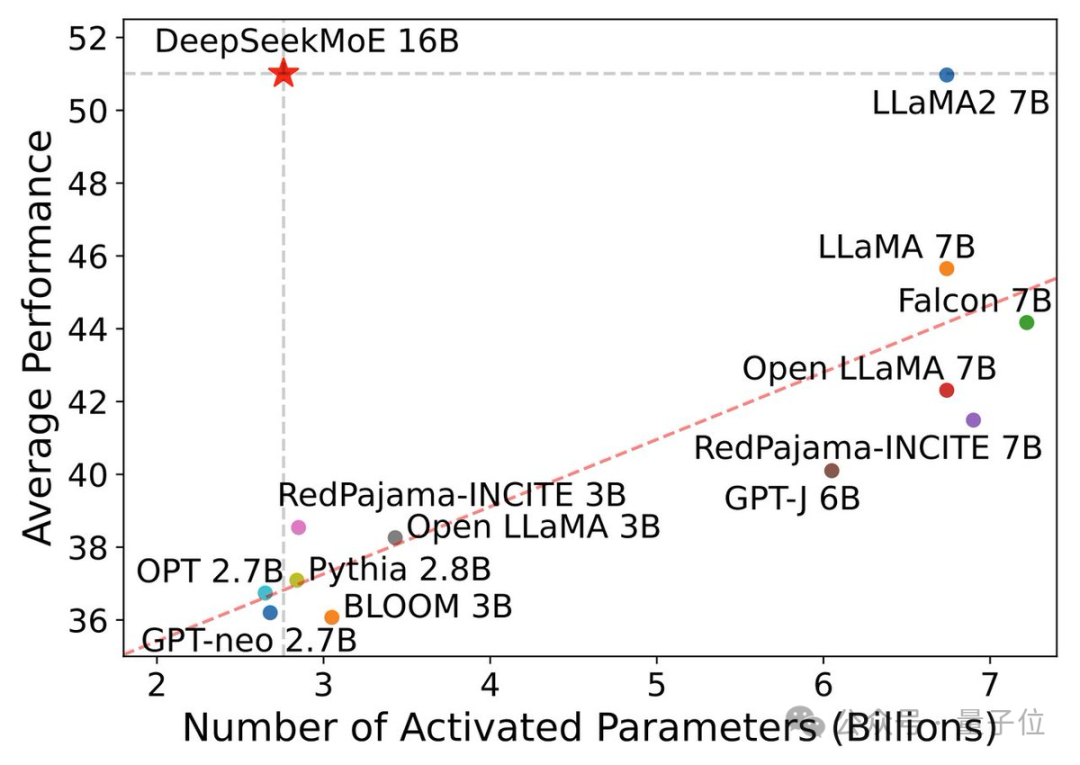

此前,该团队就曾推出过首个国产开源MoE模型DeepSeek MoE,它的7B版本以40%的计算量击败了相同规模的密集模型Llama 2。

作为通用模型,DeepSeek MoE在代码和数学任务上的表现就已十分亮眼,而且资源消耗非常低。

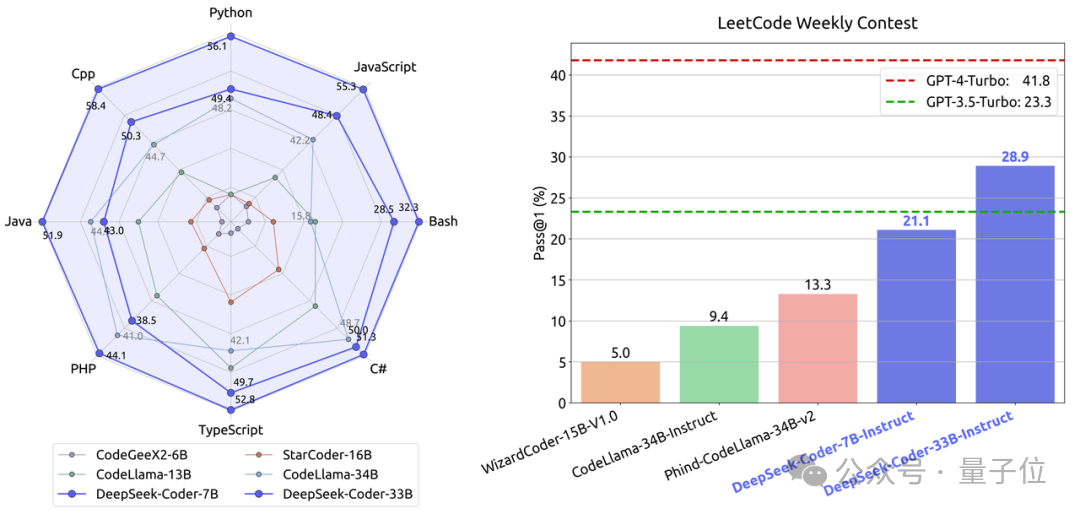

代码方面,该团队推出的DeepSeek-Coder的编程能力在代码生成、跨文件代码补全、以及程序解数学题等多个任务上均超过了同等规模的开源标杆CodeLllama。

同时,它也击败了GPT-3.5-Turbo,成为最接近GPT-4-Turbo的开源代码模型。

如前文所说,此次推出的DeepSeekMath,也正是在Coder的基础之上打造的。

而在X上,已经有人开始在期待Coder和Math的MoE版本了。

论文地址:

https://arxiv.org/abs/2402.03300

参考链接:

[1]https://twitter.com/deepseek_ai/status/1754701472363958581

[2]https://mp.weixin.qq.com/s/CPyKHnBNzJuCn-wZ1wpPoA

文章来自微信公众号 “ 量子位 ”,作者 克雷西

【开源免费】kimi-free-api是一个提供长文本大模型逆向API的开渔免费技术。它支持高速流式输出、智能体对话、联网搜索、长文档解读、图像OCR、多轮对话,零配置部署,多路token支持,自动清理会话痕迹等原大模型支持的相关功能。

项目地址:https://github.com/LLM-Red-Team/kimi-free-api?tab=readme-ov-file

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner