Gemini 3力压全场,OpenAI坐不住了。

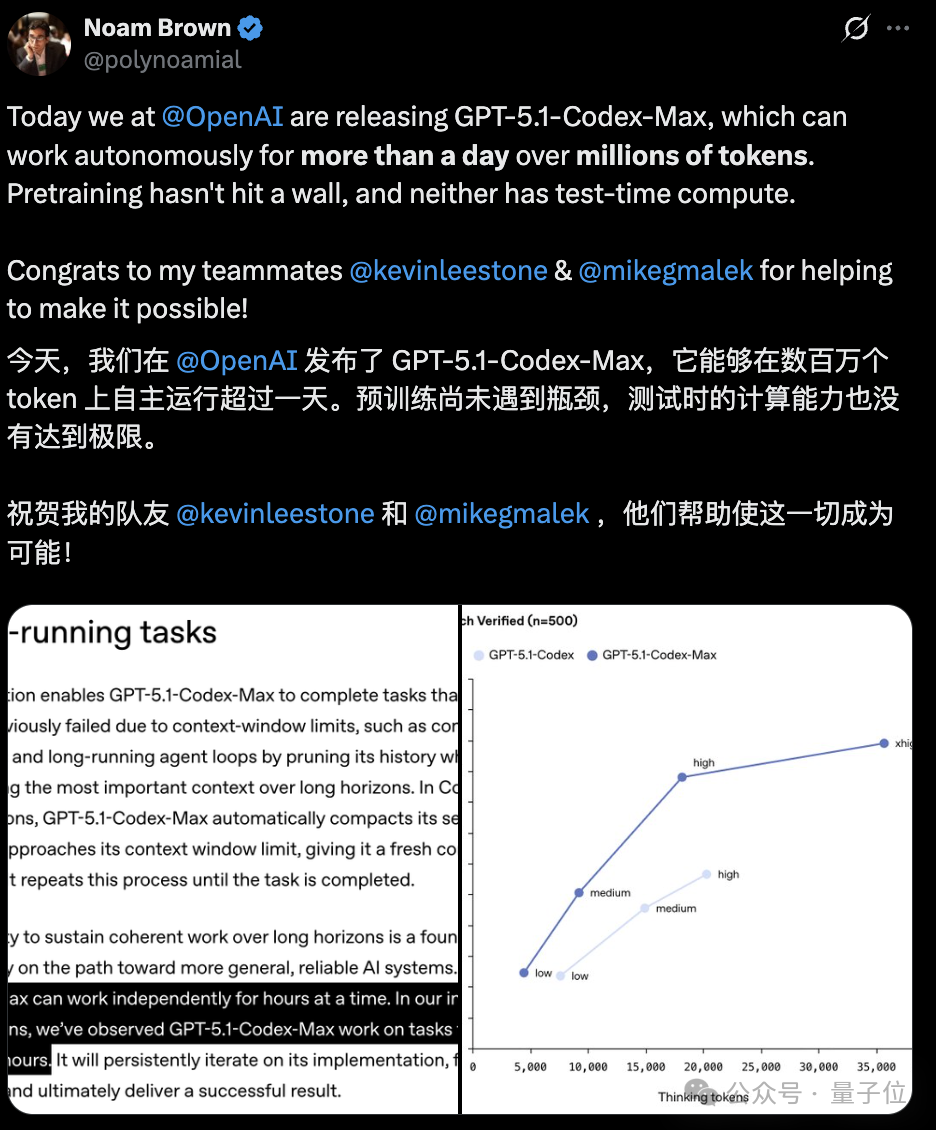

发布Codex新版本——GPT-5.1-Codex-Max,突破上下文窗口限制,实现跨越数百万token的长时间连续工作,最长超过24小时的那种。

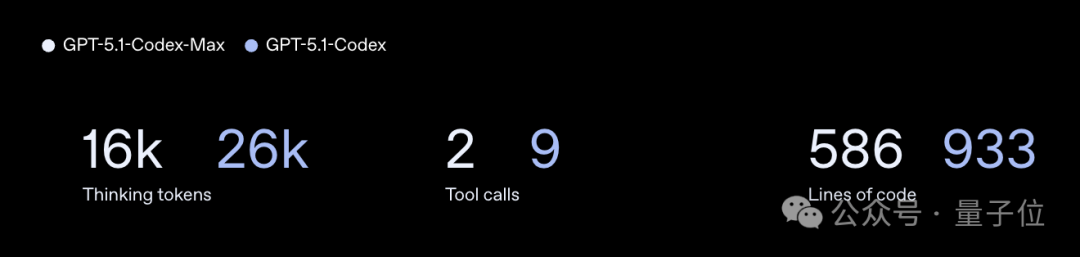

新模型任务效率也更高。它做的太阳系引力沙盒和上一代GPT-5.1-Codex的对比是这样的(多加了几个“太阳”看引力效果):

△上:GPT-5.1-Codex-Max 下:GPT-5.1-Codex

资源消耗是这样的:

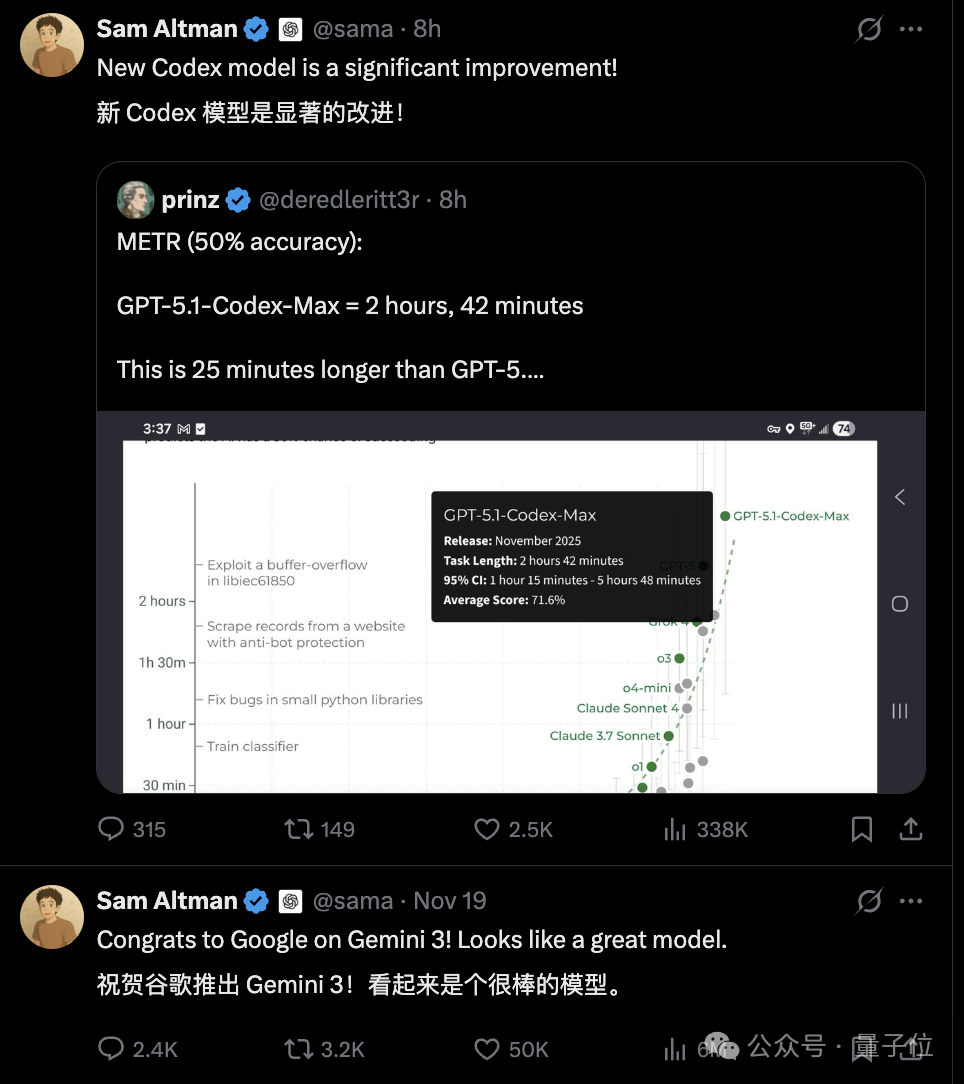

于是,奥特曼昨天刚夸完Gemini 3,今天又赶来给自家GPT-5.1-Codex-Max站台,咱说这也太忙了(doge)。

新版本在METR达到新SOTA。这个指标衡量的是,用人类做任务的时间当参照,看AI有一半概率能搞定同款任务的能力。

其实就是先看人类做某类软件工程任务得花X小时,然后看AI模型能不能有50%的概率,把这项任务给完成了。

上面数据说明,在这种情况下,GPT-5-Codex-Max有50%的概率能够成功完成一项原本需要人类2小时42分钟完成的软件工程任务。

这比GPT-5对标的时间还多了25分钟。

AI编程现在这么火,各家也都在奋力加码自家模型。

在这个前沿赛道,模型处理复杂任务的推理能力、持久力与稳定性,始终是衡量效能的关键指标。

而GPT-5.1-Codex-Max这次也是做了大升级。

首先,它在PR创建、代码审查等实际软件工程任务中训练,推理变得更快更有效。也是OpenAI首个能在Windows环境中的模型。

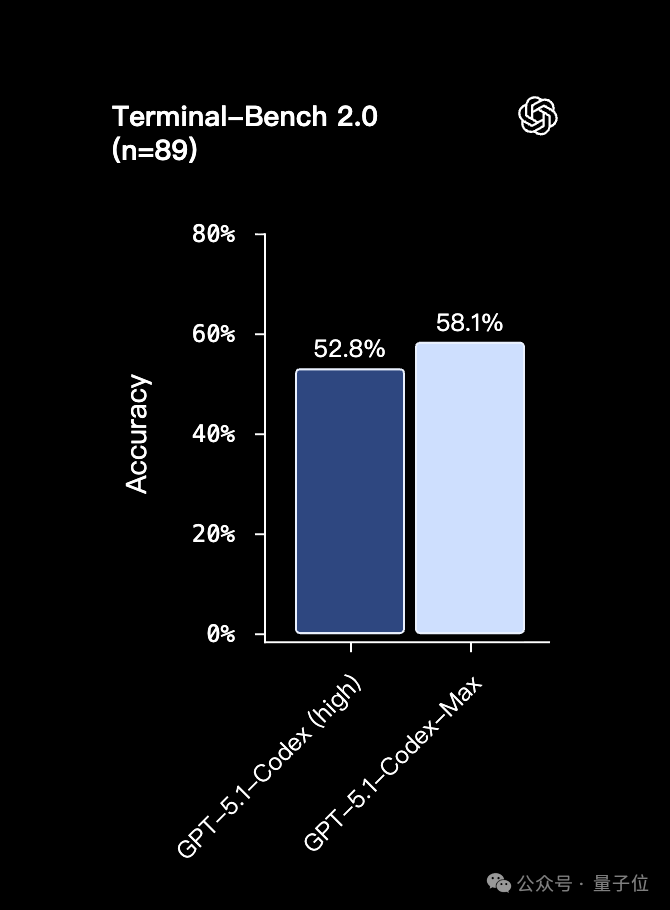

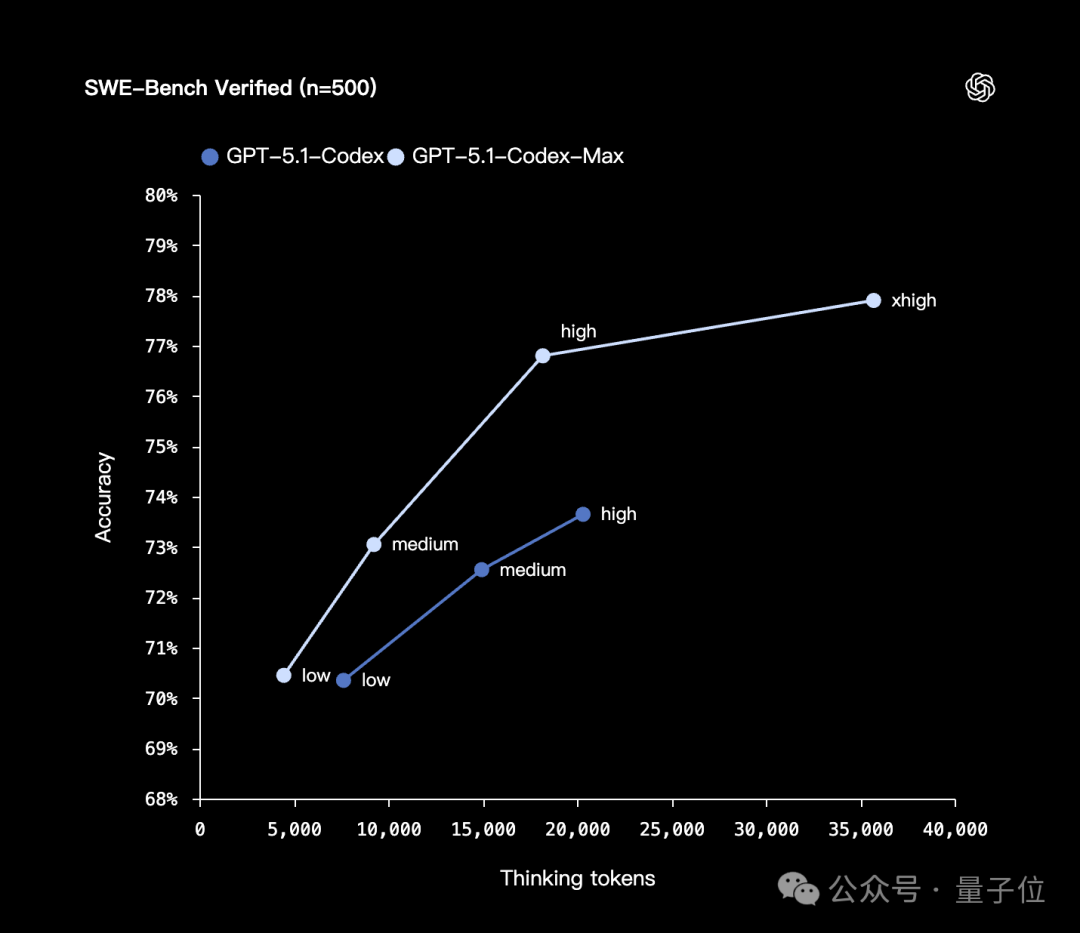

在SWE-bench Verified测试中,同样medium推理力度下,它比之前的GPT‑5.1-Codex性能更好,且思考token使用减少了30%。

而且针对非延迟敏感任务还推出了xhigh推理力度选项,思考时间更长答案更好。

说到思考时间长,这次的新版本对于长时间运行任务的处理也比较出色,能够实现“超长待机”,跨多个上下文窗口连贯工作。

这是因为GPT-5.1-Codex-Max原生支持压缩,突破了上下文窗口限制。

具体来说,在接近上下文窗口限制时,模型会自动压缩对话,获得新上下文窗口然后继续任务,直到完成。

在内部评估中,它能一次独立运行超过24小时,连贯处理数百万个token。

看样子,新模型在处理长运行、高强度的任务上比较有优势。

比如,它在应对书籍、长文档分析等超长篇幅任务时,就无需拆分内容,避免信息割裂产生的理解偏差。

也能支撑高负载、长周期的持续工作。

OpenAI研究员Noam Brown对此表示:(虽然现在表现就很不错但)尚未遇到瓶颈,还没达到极限。

目前,GPT-5.1-Codex-Max已在Codex中支持与CLI、IDE扩展、云端和代码审查工具结合使用,API接口很快也会上线。

当然了,新的编程模型一出,Claude是肯定会被拉出来遛一下的。

相比之下,Claude Code速度更快。

新版Codex的token消耗量更友好。

或许,Claude和Codex的组合拳更能打。

一天时间,Gemini 3、Grok 4.1 Fast、GPT-5.1-Codex-Max都来了,好一个硅谷345组团上新(doge)。

这位网友你真相了说得有道理。

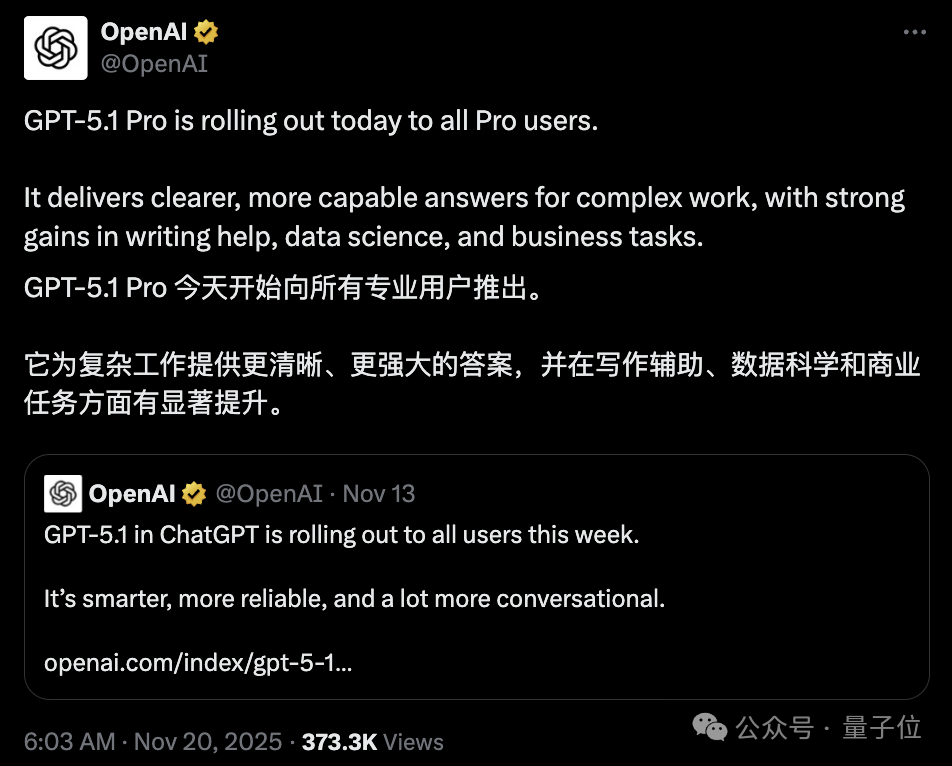

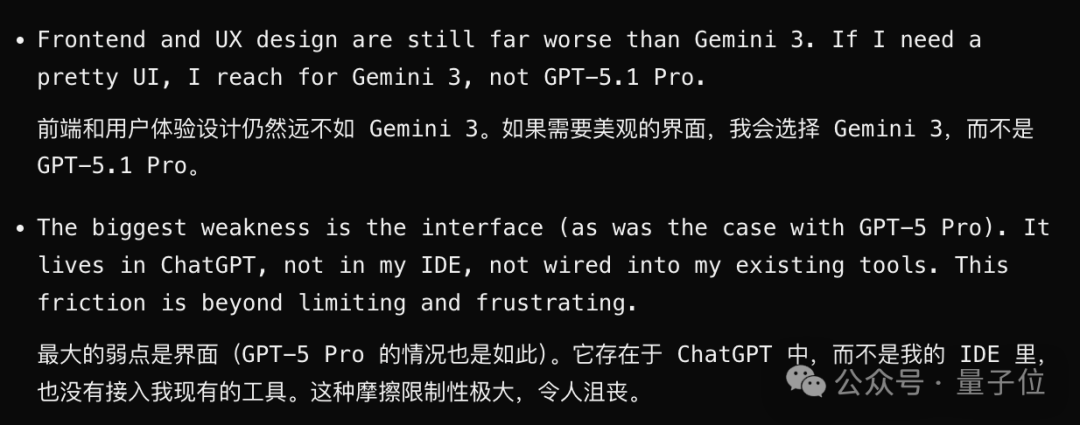

实际上,OpenAI这次还悄悄发布了GPT-5.1 Pro。

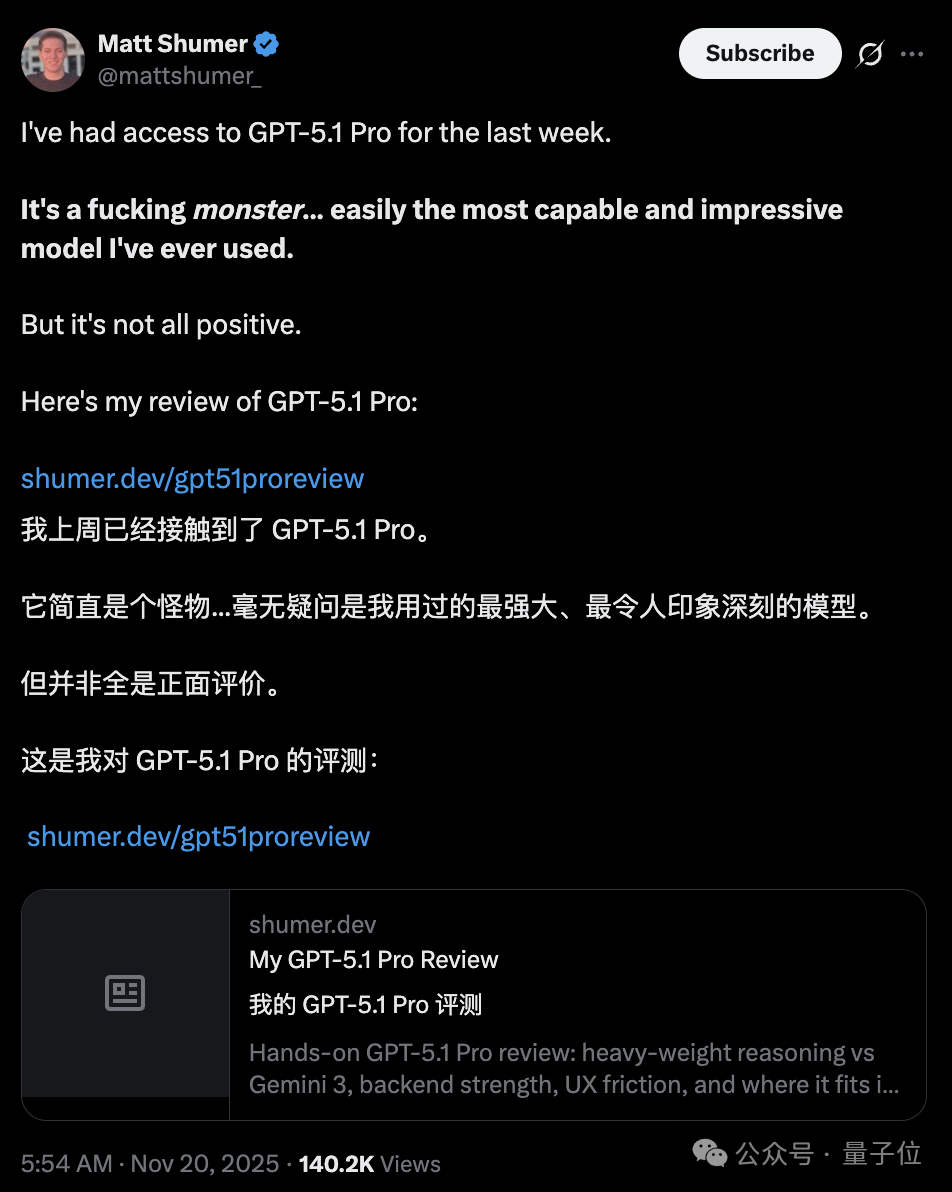

虽然官方介绍仅有寥寥几笔,但通过第三方测评来看,这个Pro版本看上去还是有点东西的。

尤其是在指令遵循方面做得更好。

虽然在一定程度上和Gemini 3有差距,但如果能接入IDE,将发挥出更大的潜力。

参考链接:

[1]https://x.com/polynoamial

[2]https://openai.com/index/gpt-5-1-codex-max/

[3]https://x.com/sama/status/1991258606168338444

[4]https://x.com/OpenAI/status/1991266192905179613

[5]https://news.ycombinator.com/item?id=45982649

[6]https://x.com/mattshumer_/status/1991263717820948651

文章来自于微信公众号 “量子位”,作者 “量子位”