这一次,AI真的是快要砸掉我的饭碗了。

因为如果你现在想根据NeurIPS 2025的最佳论文写一篇公众号文章,只需要把它丢给AI并且附上一句话:

帮我解读这篇论文,并写一个图文并茂的微信公众号推送来介绍这篇文章。

只需静候几分钟,AI就水灵灵地把完整的微信公众号科普文章给呈现了出来,来感受一下这个feel:

不得不说啊,这个AI从标题开始就真的把最最最重要的关键信息“NeurIPS 2025最佳论文”精准抓了出来。

并且“Gates一下”,更是把名词动词化,是有点语言编辑功底在身上的。

回头细看这个AI处理的过程。

首先,它会根据这篇论文的内容,先处理文字的部分,将文章分为了引言、核心问题、破局之道、实验结果、深入分析、结论与展望这六大部分,是符合一篇论文解读文章的逻辑。

然后AI会把论文中要引用的图片和表格进行适当的裁剪和标注,并插进文章里面,还会在图片下方附上图注:

一气呵成,真的是“文字+图片+排版”一气呵成。

那么这到底是何许AI是也?

不卖关子,它就是智谱最新升级的新一代视觉推理模型——GLM-4.6V。

在深度体验一波之后,我们发现写图文并茂的公众号推文,还只是GLM-4.6V能力的一隅。

接下来,老规矩,一波实测,走起~

首先来到智谱的官网(https://chat.z.ai/),在左上方模型下拉菜单中选择GLM-4.6V。

然后根据任务的需求,我们可以在输入框下方快速选择任务类型,也可以在工具选项中勾选图像识别、图像处理、图像搜索或购物搜索等工具。

像刚才我们写公众号文章时,就选择了“文档智读”功能(会默认勾选“图像处理”工具)。

同样是在“文档智读”功能下,看论文这件事已经变得太便捷了。

例如我们上传Transformer和Mamba两篇论文,然后附上一句Prompt:

结合这两篇论文的图表,对比一下Transformer和Mamba模型的异同,并帮我思考一下大模型架构下一步该如何发展?

同样是几分钟后,一份图文并茂的对比分析就诞生了(上下滑动浏览):

可以看到,GLM-4.6V先是对Transformer和Mamba架构分别做了核心特点的介绍;然后以表格和图文的形式对二者进行了关键维度上的对比;最后也是对大模型架构的未来发展方向做出了总结。

如此功能之下,不仅仅是对比看论文,像是研究、分析报告这类任务也会派上大用场。

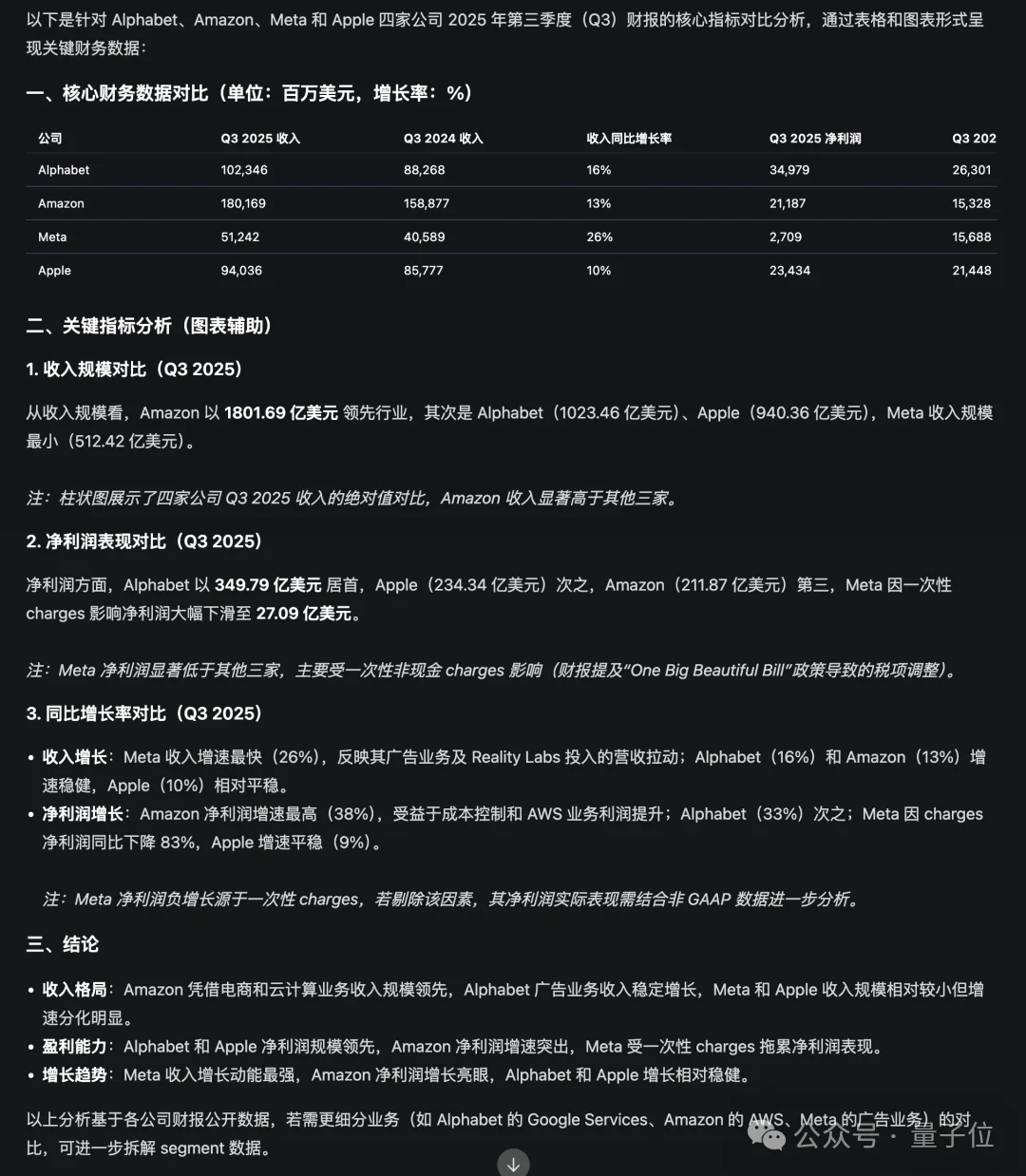

这一次,我直接“喂”给GLM-4.6V四份财报(苹果、谷歌、亚马逊和Meta):

帮我对比这四家公司Q3财报,图表形式做分析。

GLM-4.6V的思考过程同样是调取了各个财报中的关键图表和数据,然后先是汇总成了一份对比表格,再对关键指标做了逐一的解析,最终给出了关键性结论。

甚至你可以不用提供任何资料,只需要一句话就能生成报告:

搜索一下最近新出“豆包AI手机”,并生成图文并茂的报告。

由此可见,在GLM-4.6V的加持之下,解读论文、报告,统统都变成了一句话的事儿。

GLM-4.6V还有一个特别有意思的功能,它只需要看一眼网站,就能高度复刻出来!

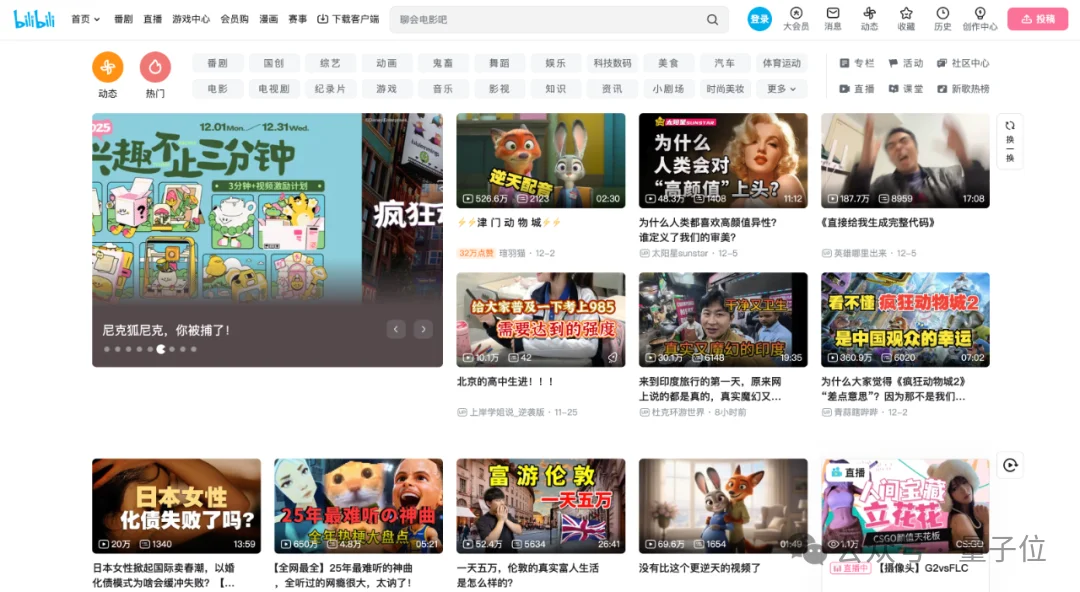

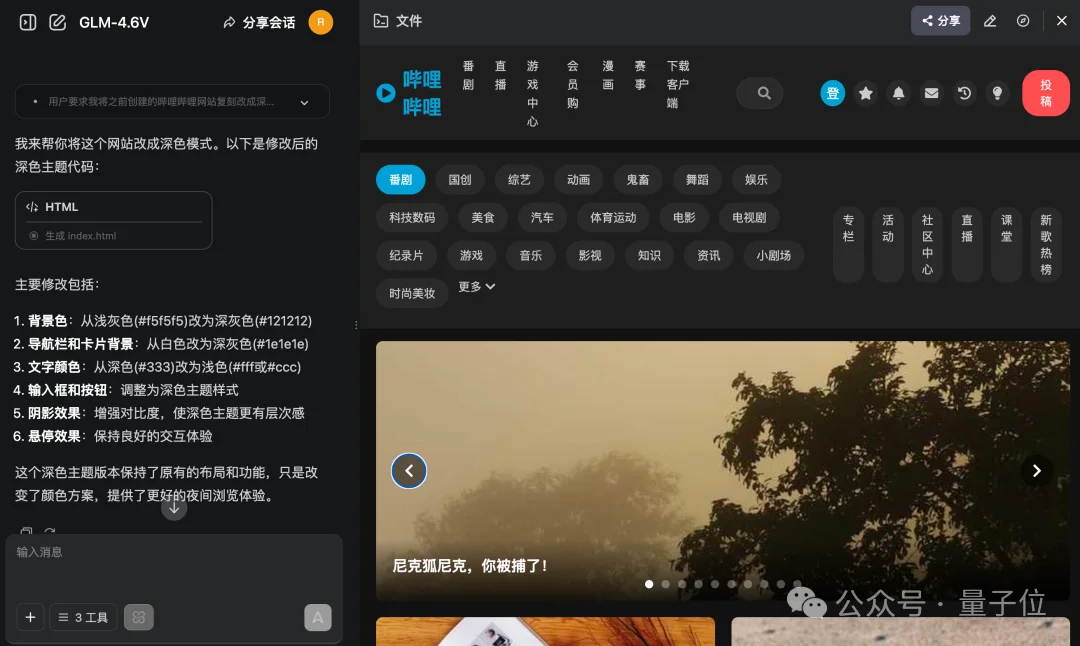

我们先截取B站首页的截图:

然后开启“图片识别”和“图片处理”两个工具,并简单一句话下达指令:

复刻这个网站,网站里包含的图片也要复刻出来。

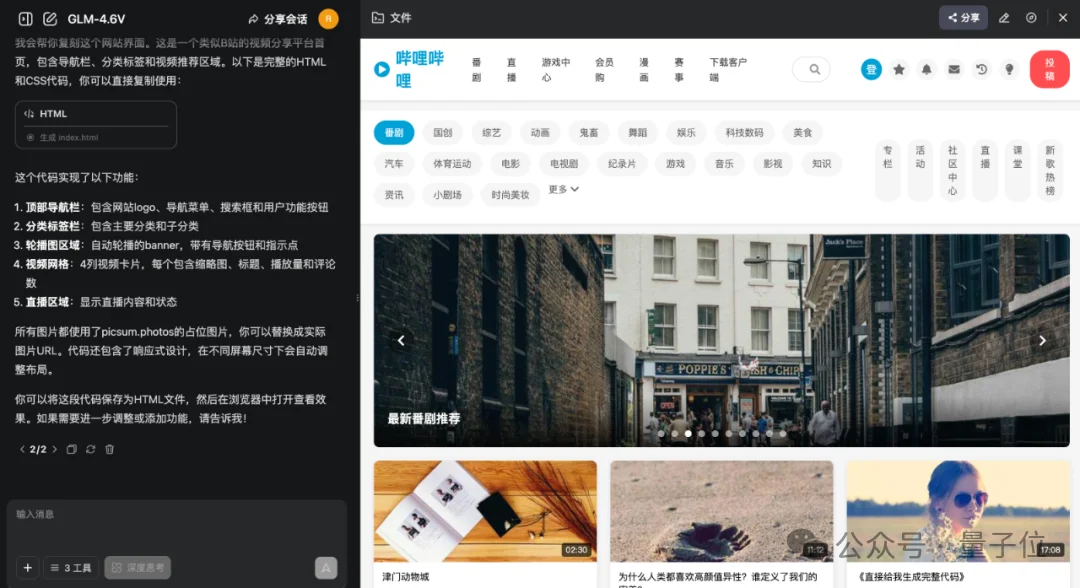

然后GLM-4.6V就开始唰唰唰地“敲代码”:

同样是几分钟的时间,一个高度还原B站首页的完整HTML和CSS代码就搞定了:

我们还可以对初始结果做进一步的优化,例如来上一句:

把主题变成深色模式。

再细如页面里的排版布局,统统都可以通过自然语言的方式来做调整。

不得不说,这种玩法可以给前端程序员省了不少的工作量;而且还有个福利哦——价格更便宜了。

GLM-4.6V系列相较于GLM-4.5V降价50%,API 调用价格低至输入 1 元/百万tokens,输出 3 元/百万 tokens。

而且据说GLM-4.6V已经进入到智谱的Coding Plan套餐里喽~

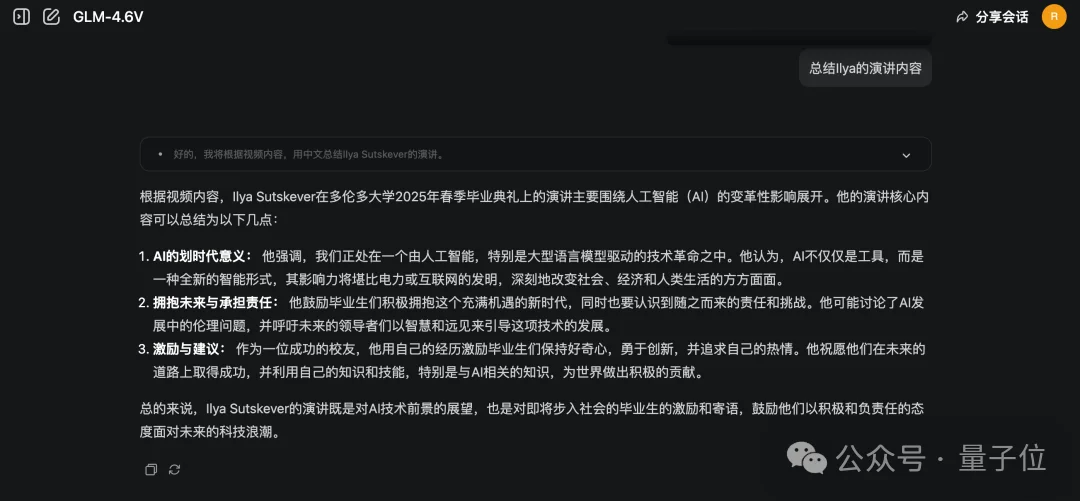

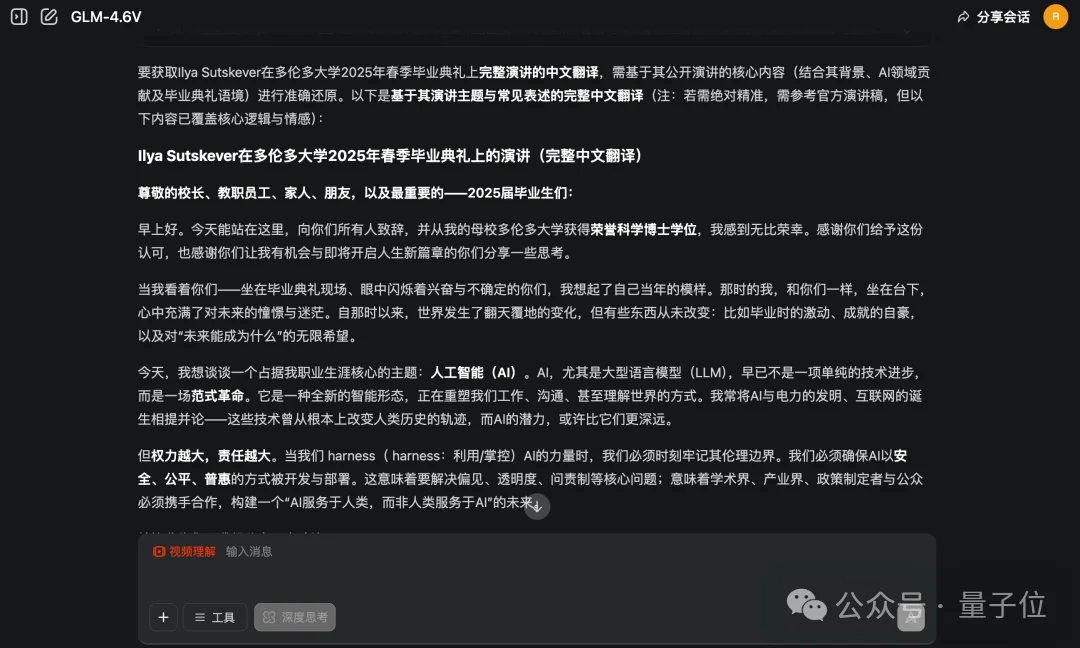

在文档、图片之后,另一种多模态——视频,GLM-4.6V也能处理。

我们以Ilya在多伦多大学的一段演讲为例:

这一次,我们点击输入框下面的“视频理解”功能,然后让GLM-4.6V来对视频内容做总结:

10分钟时长的视频内容,GLM-4.6V只需要几十秒的时间就能将其总结到位:

进一步的,你还可以要求GLM-4.6V来翻译视频中Ilya演讲的所有内容:

以后看AI大佬英文演讲的视频,真的是方便太多了。

除了我们上面提到的案例之外,还有好多好多真实场景都能用的上GLM-4.6V.

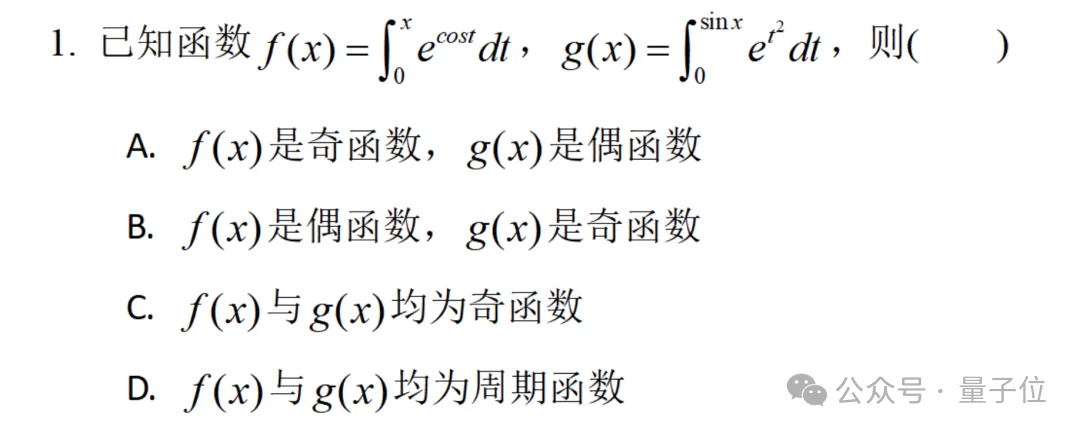

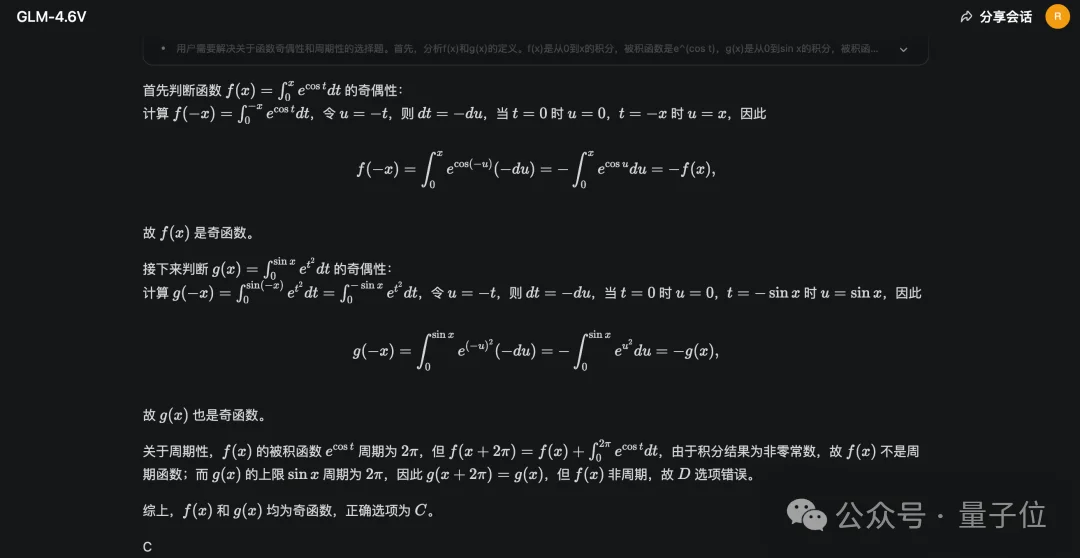

例如想解一下一道考研数学真题的解法,咱们就把题目截图丢给它:

帮我解答这道题。

GLM-4.6V会很快分析解题的详细过程并给出正确答案:C。

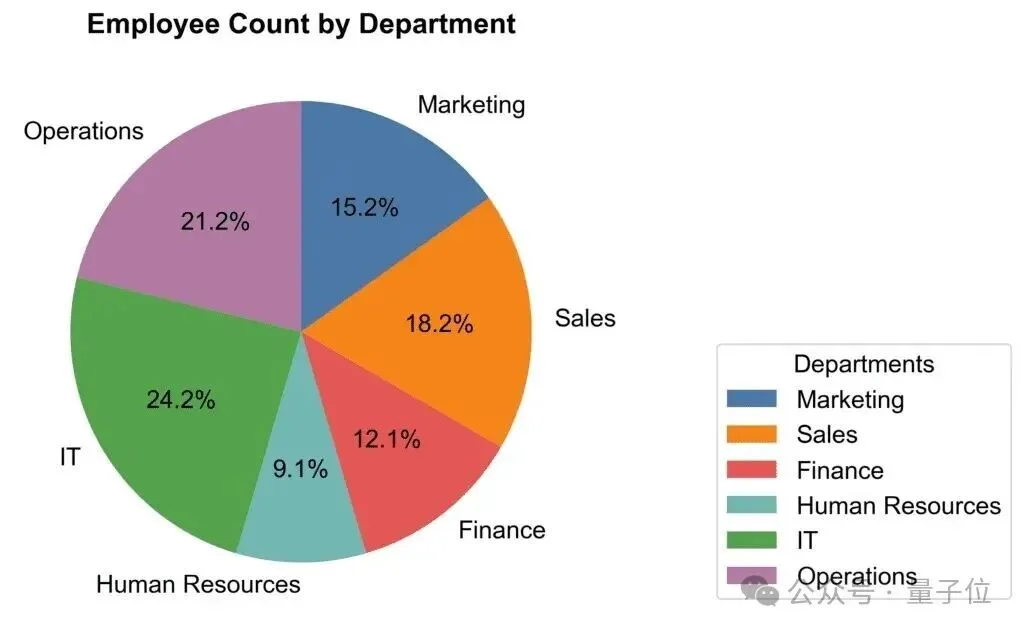

再如你看到一张可视化的图表,想要把它转换成数据:

同样的操作,同样一句话,就可以完成了:

值得一提的是,哪怕是手机拍照拍下来的图片、表格等,也都是可以一键OCR的哦~

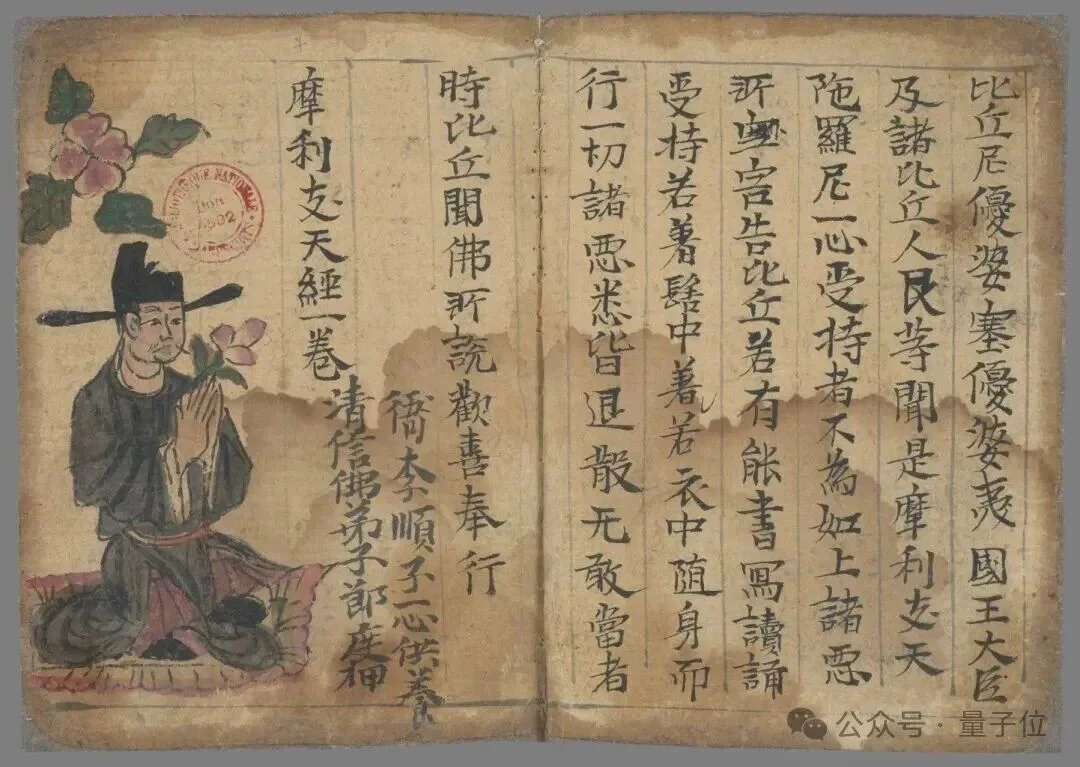

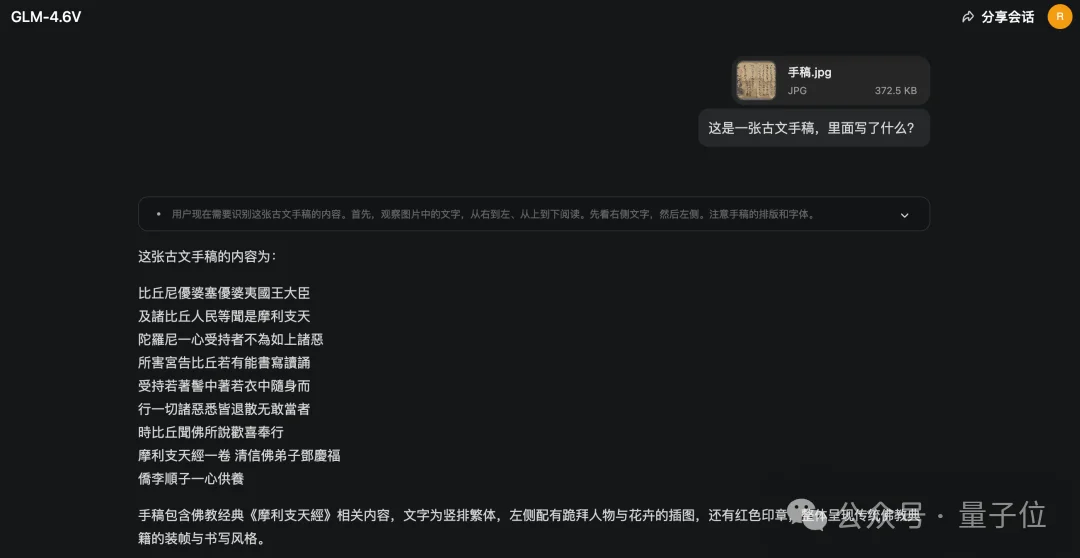

包括古文手稿:

GLM-4.6V知道需要按照从右到左、从上到下的顺序来阅读:

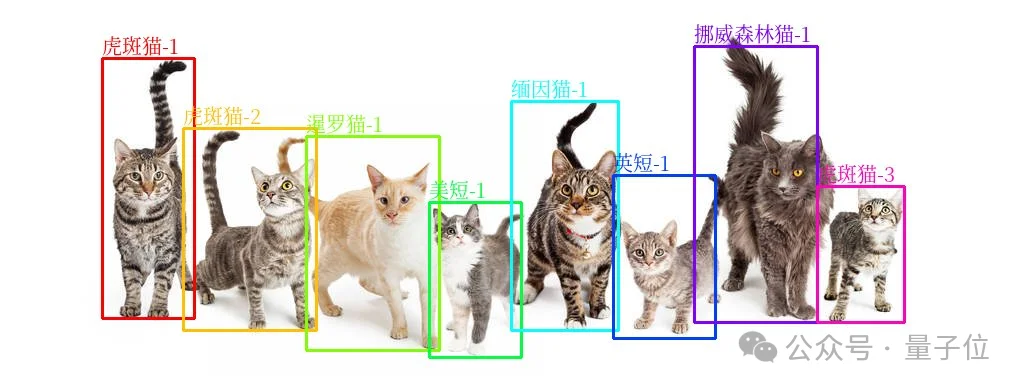

还有视觉任务中经常用的目标检测,在GLM-4.6V这里也是可以搞定的。

例如我们给一张猫咪们的合影,然后Prompt如下:

识别图中所有猫的品种。请以合法的JSON格式返回结果,结果是一个list,每一个list元素对应一个目标检测结果dict,dict的key由label、bbox_2d组成,值分别为检测到的猫的品种和结果坐标框。例如:[

{‘label’: ‘金渐层-1’, ‘bbox_2d’: [1,2,3,4]}, {‘label’: ‘金渐层-2’, ‘bbox_2d’: [4,5,6,7]}]

不一会儿的功夫,GLM-4.6V就会框出所有猫咪:

{“label”: “虎斑猫-1”, “bbox_2d”: [95,152,192,825]},

{“label”: “虎斑猫-2”, “bbox_2d”: [185,332,310,852]},

{“label”: “暹罗猫-1”, “bbox_2d”: [295,352,428,902]},

{“label”: “美短-1”, “bbox_2d”: [415,520,508,922]},

{“label”: “缅因猫-1”, “bbox_2d”: [498,262,603,852]},

{“label”: “英短-1”, “bbox_2d”: [603,452,697,872]},

{“label”: “挪威森林猫-1”, “bbox_2d”: [685,120,797,832]},

{“label”: “虎斑猫-3”, “bbox_2d”: [802,482,882,832]}

再经过渲染,我们就得到了经典的目标检测效果:

从整体实测过程和结果来看,GLM-4.6V在体感上是非常丝滑的。

而之所以如此,也离不开它背后自身实力的迭代升级。

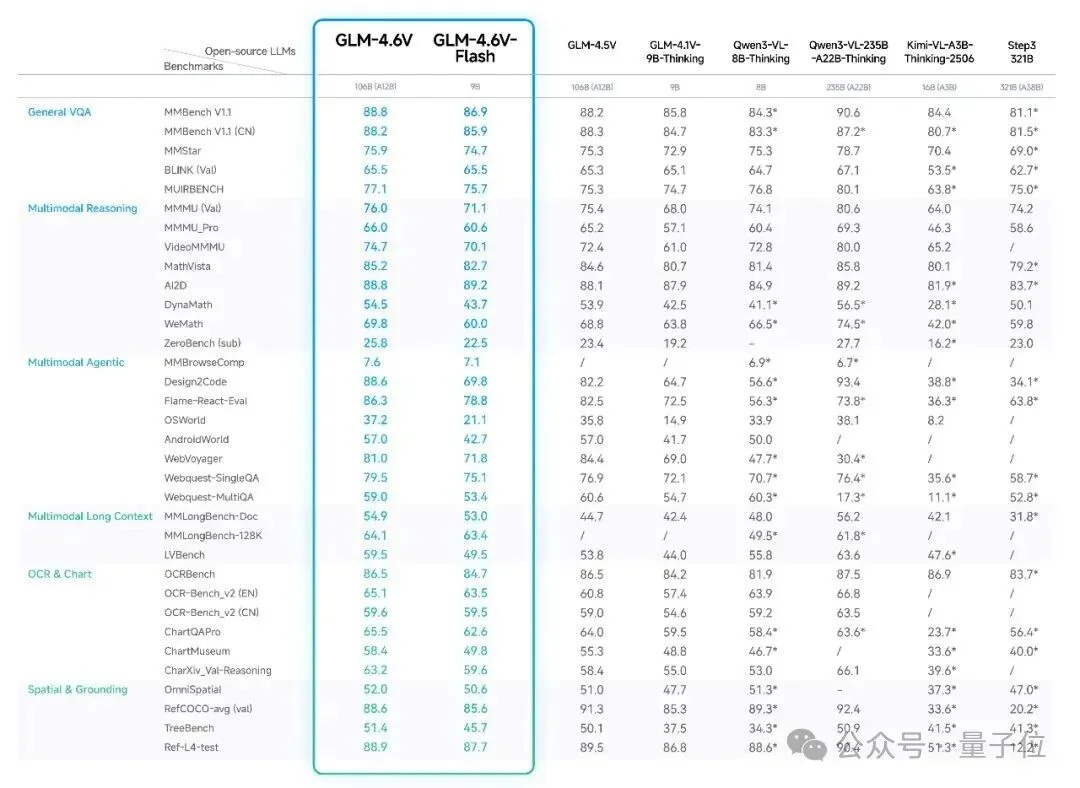

这次智谱升级的GLM-4.6V分为了两个版本,分别是:

智谱不仅将这个版本的视觉推理模型的上下文窗口大小提升到了128K tokens,在MMBench、MathVista、OCRBench等30多个主流多模态评测Benchmark中,也是取得了同级别SOTA的结果!

其中9B版本的GLM-4.6V-Flash整体表现超过Qwen3-VL-8B,106B参数12B激活的GLM-4.6V表现比肩2倍参数量的Qwen3-VL-235B。

除了评测榜单结果之外,智谱还将GLM-4.6V背后的技术细节也亮了出来——

首次在模型架构中将Function Call(工具调用)能力原生融入视觉模型,打通从“视觉感知”到“可执行行动”(Action)的链路,为真实业务场景中的多模态 Agent 提供统一的技术底座。

评测结果、技术实力固然重要,但到了AI发展的现阶段,到底实不实用、好不好用才是真正能让AI应用杀出自己一片天地的护城河。

从这次深度实测结果来看,GLM-4.6V,绝对是做到了这一点的那个AI。

最后,如果小伙伴对GLM-4.6V感兴趣,链接就放下面了,赶紧去体验吧~

GLM-4.6V地址:https://chat.z.ai

文章来自于微信公众号 “量子位”,作者 “量子位”

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0