Agent能力位列全球开源模型Top 2。

智东西12月17日报道,今天,小米发布并开源了最新MoE大模型MiMo-V2-Flash,总参数309B,激活参数15B。今日上午,小米2025小米人车家全生态合作伙伴大会上,Xiaomi MiMO大模型负责人罗福莉将首秀并发布主题演讲。

该模型专为推理、编码和Agent场景构建,支持混合思维模式,允许用户切换模型是“思考”还是即时回答。它能一键生成功能齐全的HTML网页,并与Claude Code、Cursor和Cline等氛围编码框架协同。该模型提供256k上下文窗口,能够完成数百轮Agent交互和工具调用的任务。

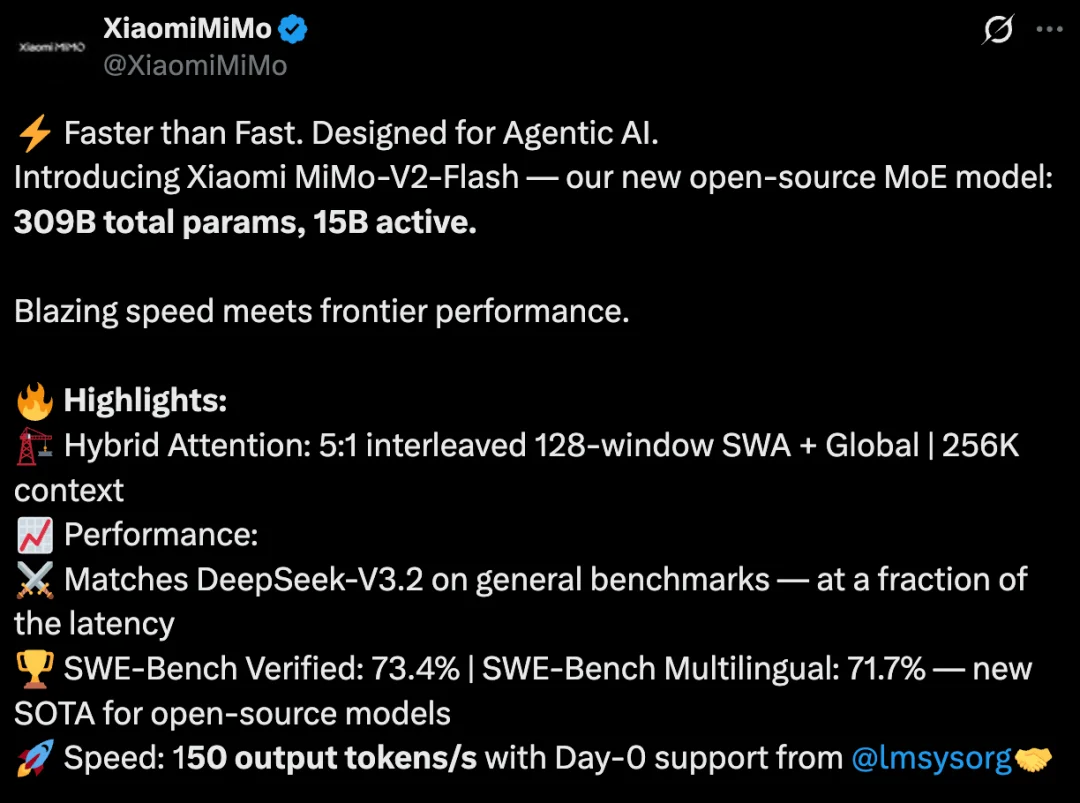

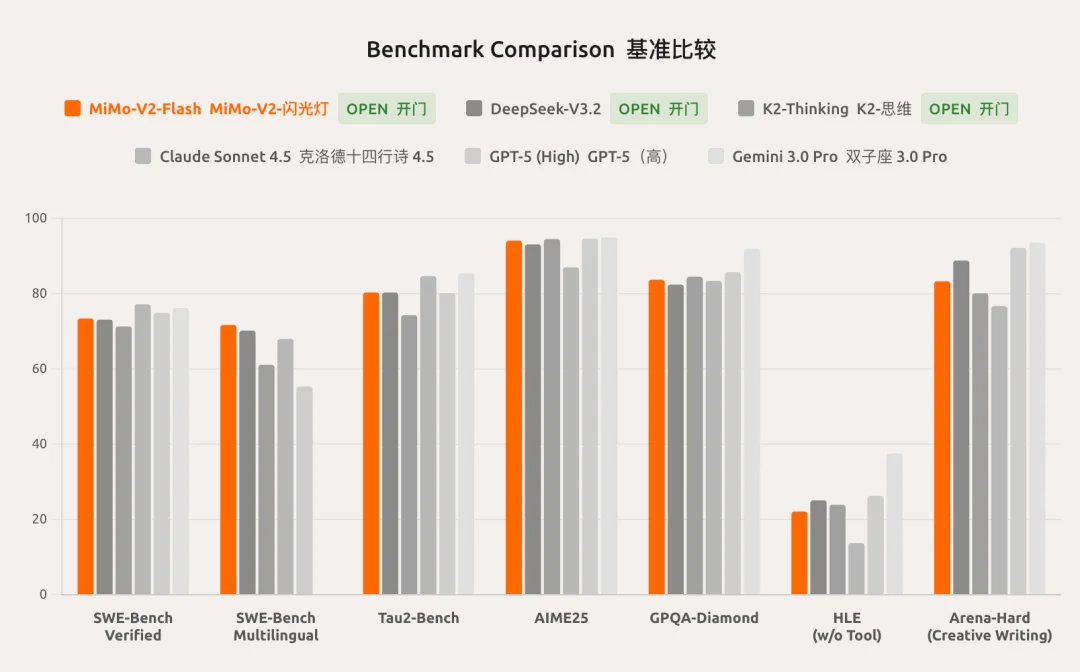

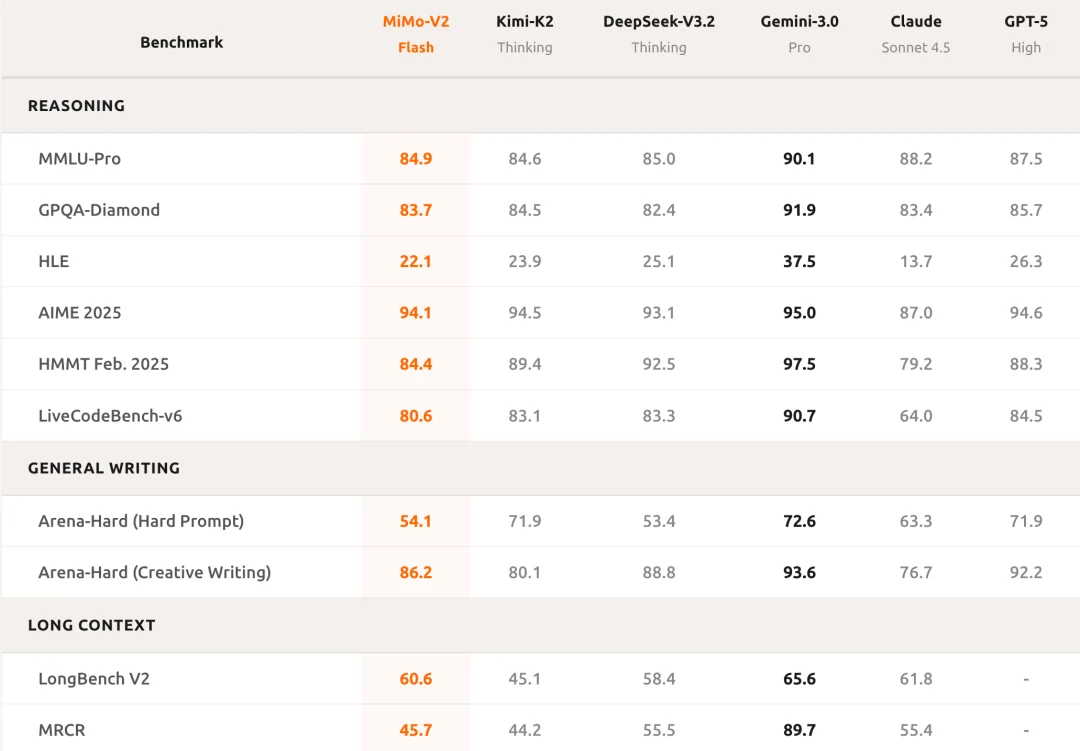

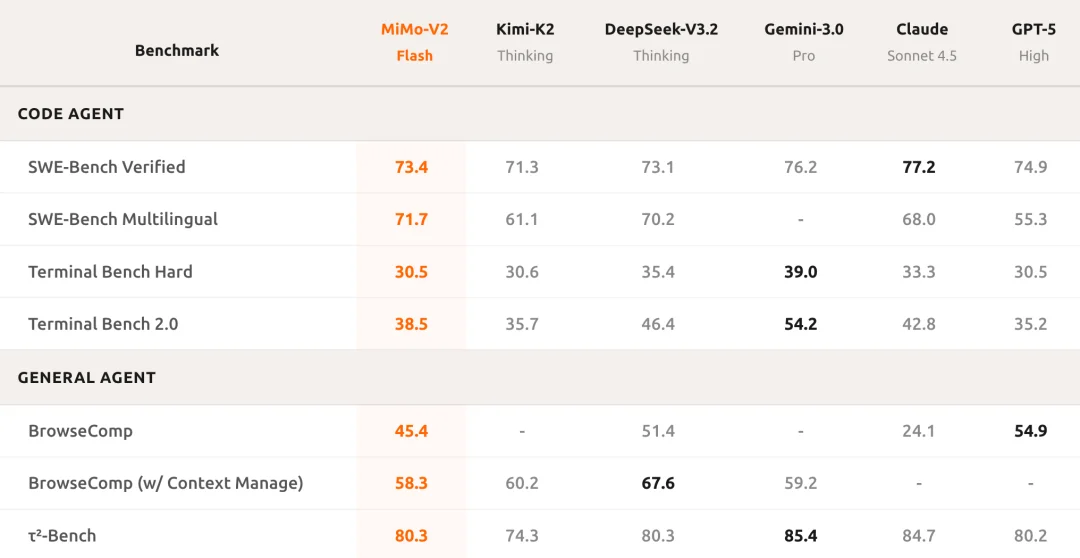

基准测试结果显示,MiMo-V2-Flash的性能基本与DeepSeek-V3.2相当,仅在不使用任何工具辅助的“人类最后一场考试”和创意文本生成评估ARENA-HARD中略逊色于DeepSeek-V3.2,但时延更小。

在多个Agent测评基准上,MiMo-V2-Flash位列全球开源模型Top 2;代码能力测评超过所有开源模型,比肩标杆闭源模型Claude 4.5 Sonnet,但推理价格仅为其2.5%且生成速度提升至2倍。

MiMo-V2-Flash能以每秒150个token的速度实现快速推理,价格方面,其每百万输入token 0.7元、每百万输出token 2.1元。

小米已经开源了MiMo-V2-Flash所有内容,并向开发者社区SGLang贡献了所有推理代码,API限时免费。目前,用户可以在网页端免费体验MiMo-V2-Flash。

开源地址:

https://t.co/4Etm0yZKTL

体验地址:

https://aistudio.xiaomimimo.com

技术报告:

https://github.com/XiaomiMiMo/MiMo-V2-Flash/blob/main/paper.pdf

能写长文、做精美网页

但实测尚不稳定

智东西先实测了下MiMo的网页开发能力。

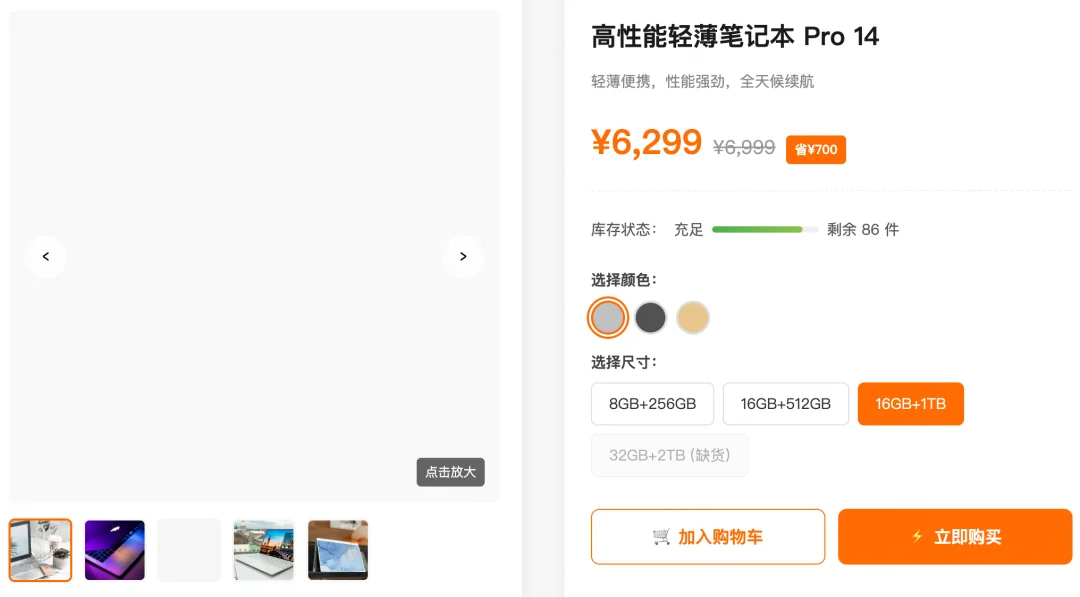

首先,智东西让其生成了一个电商页面,需要包含商品主图轮播、规格选择、价格、库存等要素。代码生成后,MiMo会在右侧显示预览界面,除查看商品大图功能需要在完整版使用,其他元素几乎和真实的线上购物没有差别。

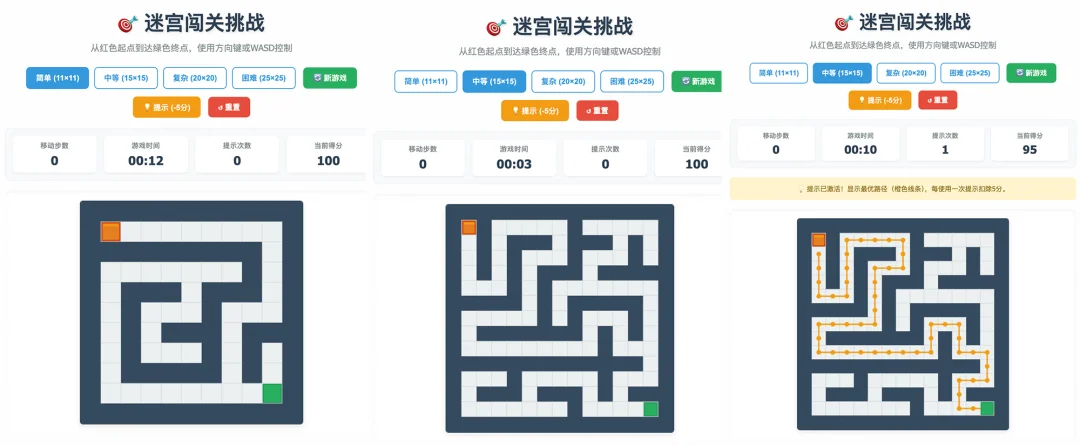

然后加大难度,智东西让其生成了一个网页版迷宫闯关小游戏,需要包含四个难度,能通过鼠标和键盘控制。在生成的网页里,MiMo还增加了提示、积分、计时等功能,整个交互体验更加完整。

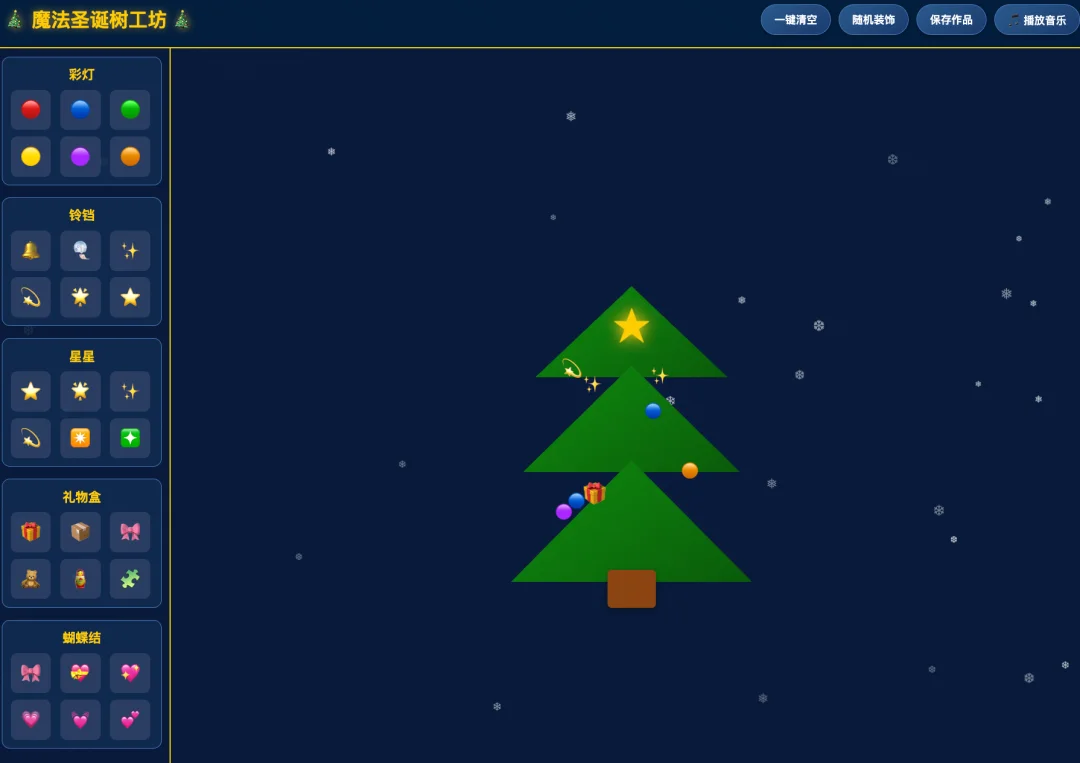

智东西还让其生成了“圣诞树装饰”交互网页。网页左侧有彩灯、铃铛、星星、礼物盒、蝴蝶结,可以拖动这些物品装饰到右侧的圣诞树上,也可以一键清空或者直接生成随机装饰。整个画面会不断飘落雪花,还可以播放背景音乐。

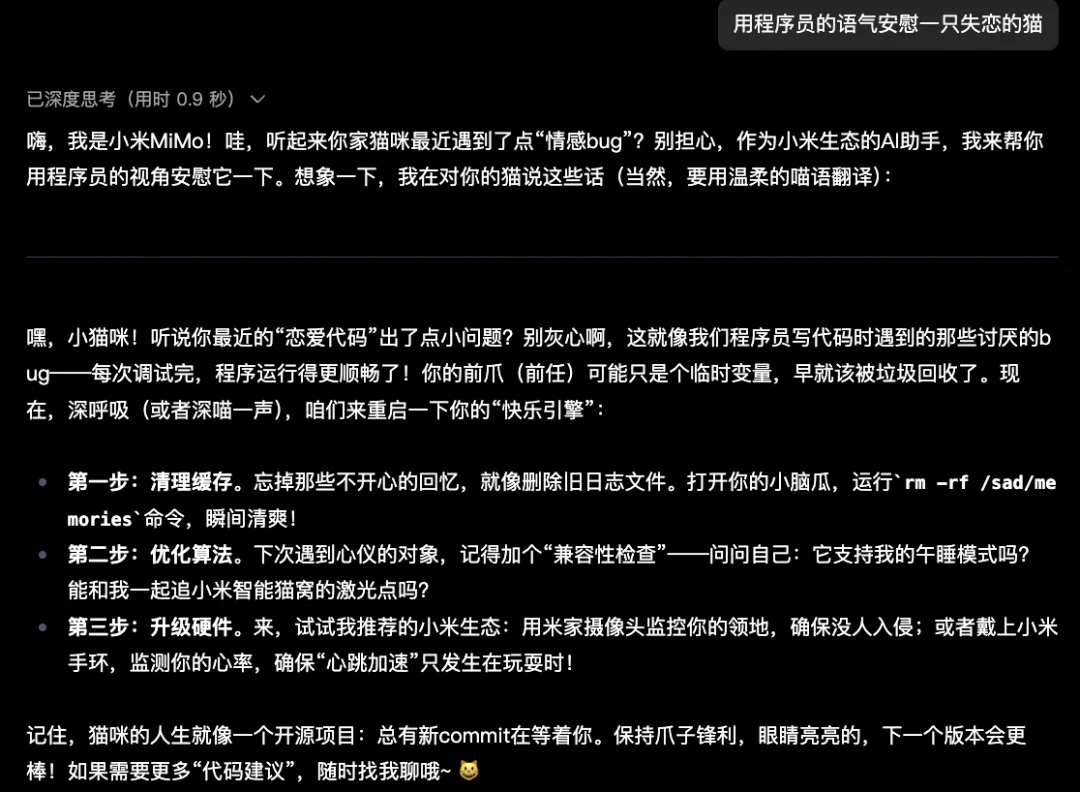

对于聊天能力,智东西先让MiMo“用程序员的语气安慰一只失恋的猫”,MiMo会让小猫“清理缓存”忘掉不开心的事,还让小猫“升级硬件”,顺便帮小米打了波广告。

最后智东西让MiMo生成了一部科幻悬疑题材的AI短剧剧本。一上来,MiMo就给出了深潜记忆提取头盔、真理之环AI伦理防火墙两个关键要素,通过检索发现,MiMo在后续剧情中将这两大物体融入进去,直接作为推动剧情发展的关键。

此外,小米在官方博客也放出了不少案例。

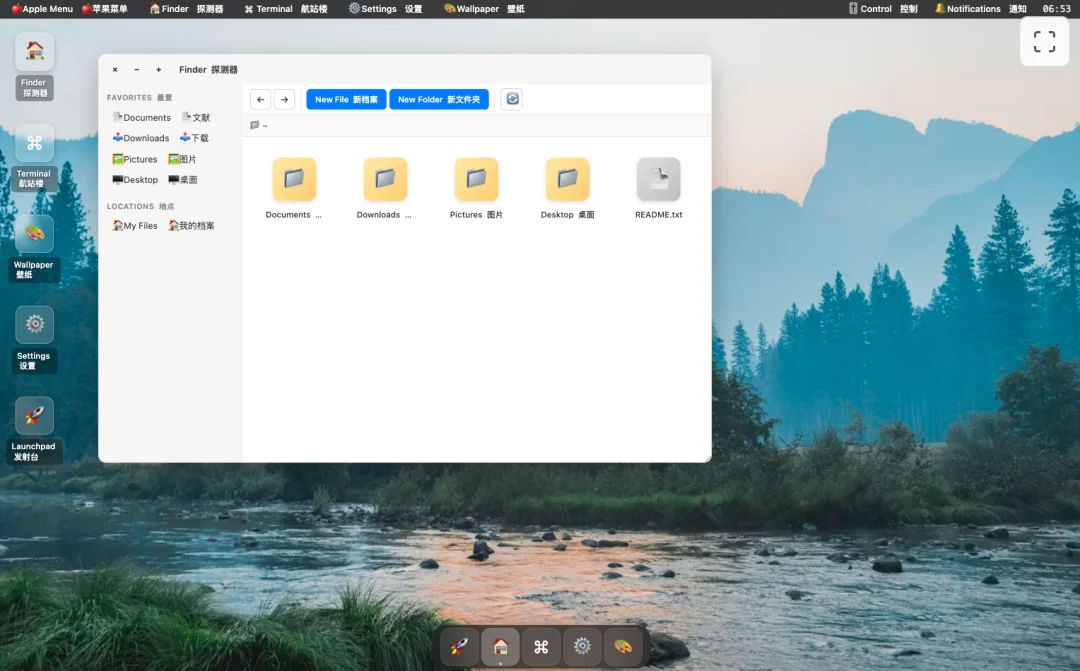

首先是网页生成能力上,其第一个官方案例是“用HTML生成一个漂亮、可用的macOS模拟操作系统”。在最终的生成界面中,包含了基本的macOS风格桌面图标,还可以切换背景、打开Finder。

其次是,打造“豪华互动圣诞树”高保真3D网页应用,并要求视觉效果奢华,MiMo的生成结果能切换圣诞树和混沌状态,支持手势交互等。

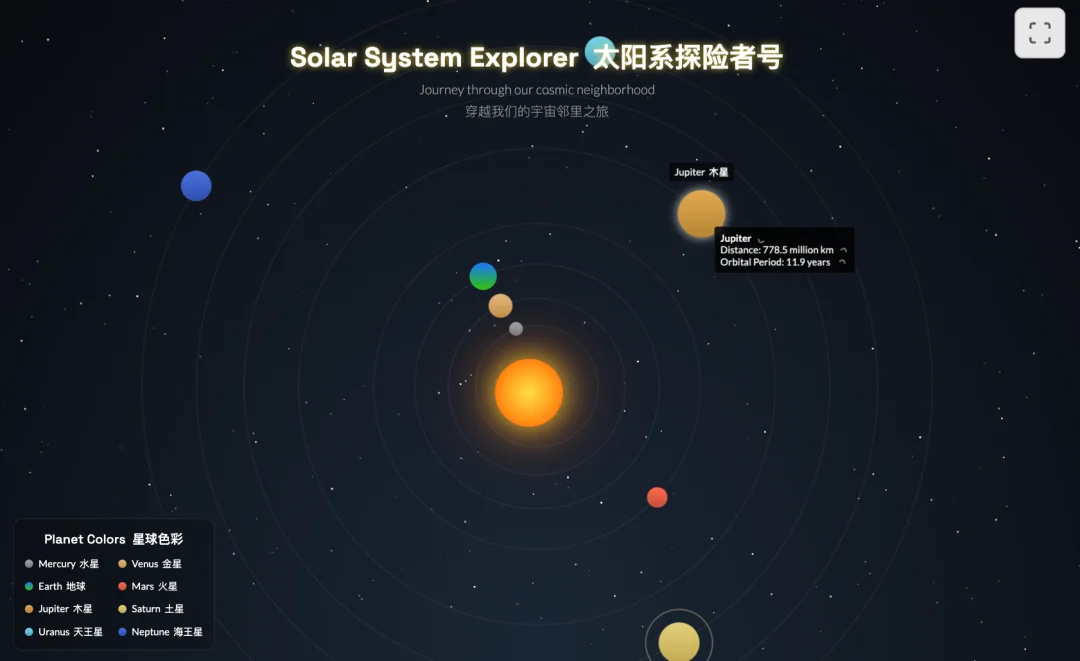

第三个演示是用HTML创建交互式太阳系探测器。当用户点击每个球体就会出现行星的简介。

智东西也让MiMo“用HTML创建一个教育性的交互式太阳系探索器”,不过最后的结果并不如官方演示。其第一次生成时行星无法选择,重新生成后可选择行星下面的选项直接不见了。

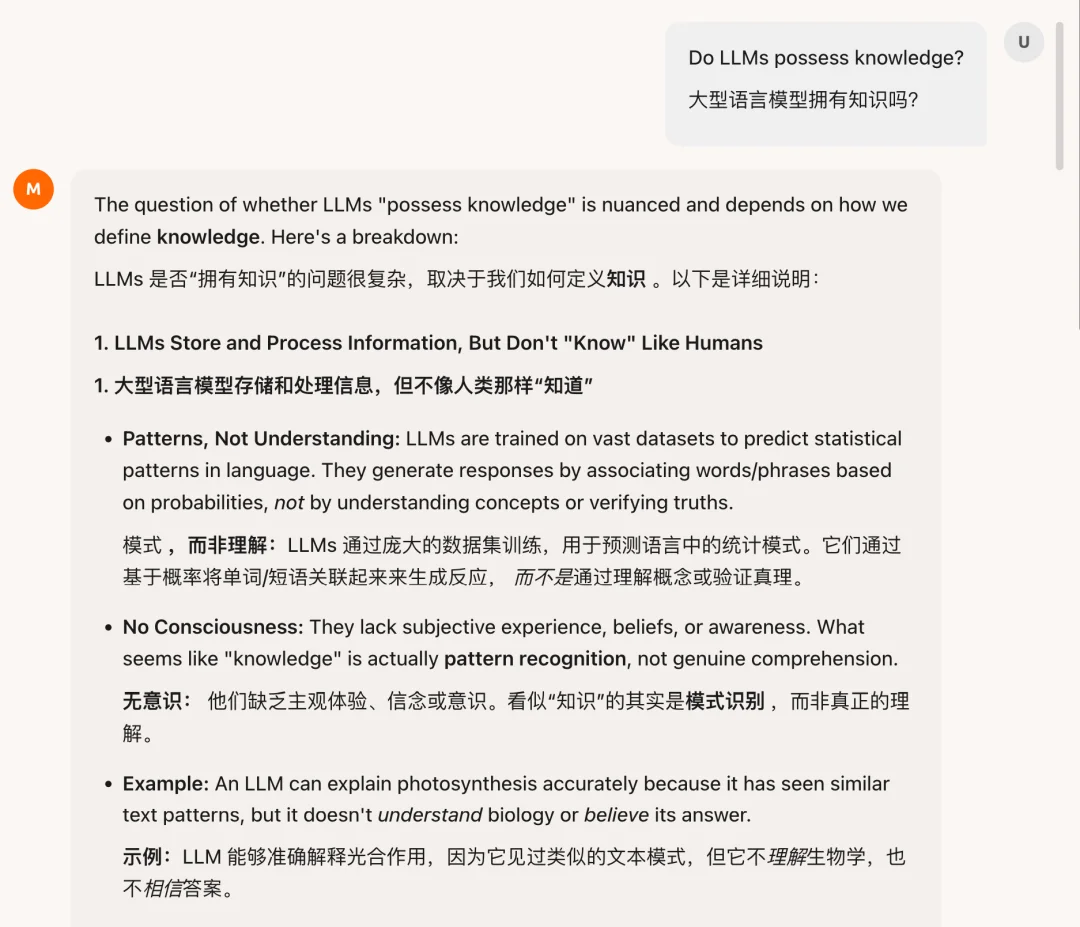

聊天能力方面,MiMo既能回答“大语言模型拥有知识吗”这类硬核科普类知识。

MiMo还可以回答“要不要吃长生不老药丸”,还会站在人类视角分析要不要吃、可能有哪些条件。

此外,该模型还具备长文本撰写能力,其可以“写一个关于误送信件的忧郁爱情故事”。

MiMo还能写深刻的非虚构作品,如以一位独居老人为中心,以他一周内收到的邮件为主,探讨现代社会中的孤独。

专为推理、编码和Agent构建

与K2 Thinking和DeepSeek V3.2 Thinking相当

在数学竞赛AIME 2025和科学知识基准GPQA-Diamond中,MiMo-V2-Flash的表现是开源模型中前二。在软件工程能力的SWE验证与多语言基准测试中,MiMo-V2-Flash在所有开源模型中位列第一,与全球顶尖闭源模型齐名。

从总的基准测试结果来看,MiMo-V2-Flash在大多数推理基准测试中的性能可与K2 Thinking和DeepSeek V3.2 Thinking相当,同时保持高质量开放式回答的竞争力。

在长上下文评估中,MiMo的模型超过了K2 Thinking。

在搜索Agent评估方面,MiMo-V2-Flash在BrowseComp上得分为45.4,配合上下文管理进一步提升至58.3。

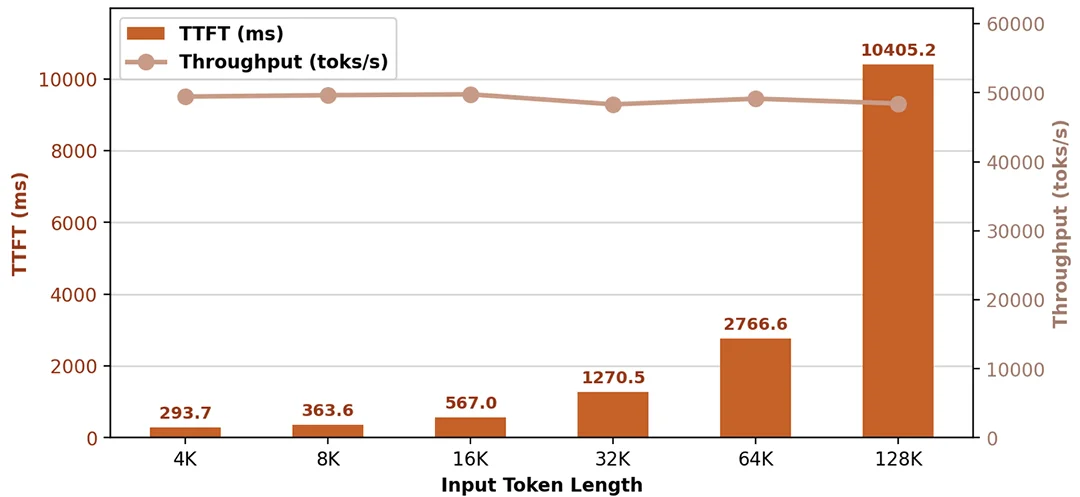

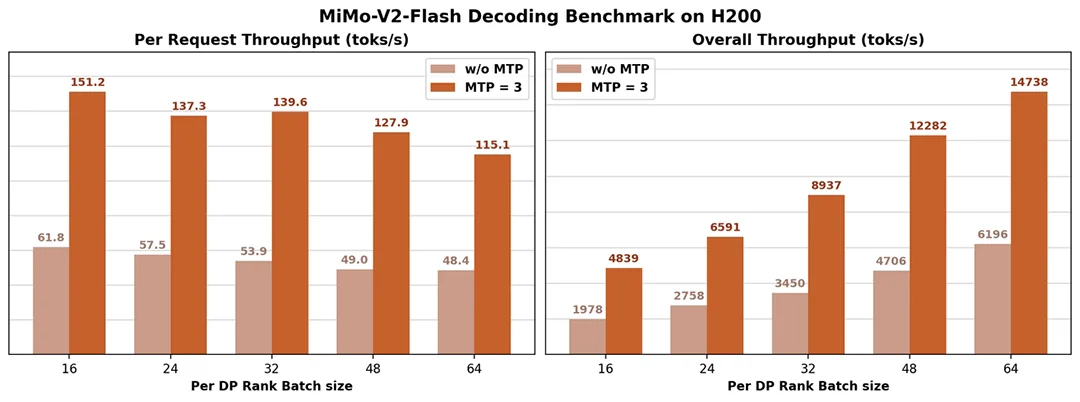

小米已经共享所有推理代码至SGLang并开源,社区实测单机结果如下:

在Prefill单机吞吐约50000 toks/s的条件下,不同Context Length都取得了优越的TTFT性能。

得益于3层MTP,在16K的Context Length情况下,Decode可以做到单机吞吐5000 ~ 15000 toks/s的同时达到151~115 toks/s的单请求吞吐。

引入MTP训练

后训练阶段提出MOPD

MiMo-V2-Flash的效率提升是因为其为高通量推理设计了创新架构进步。

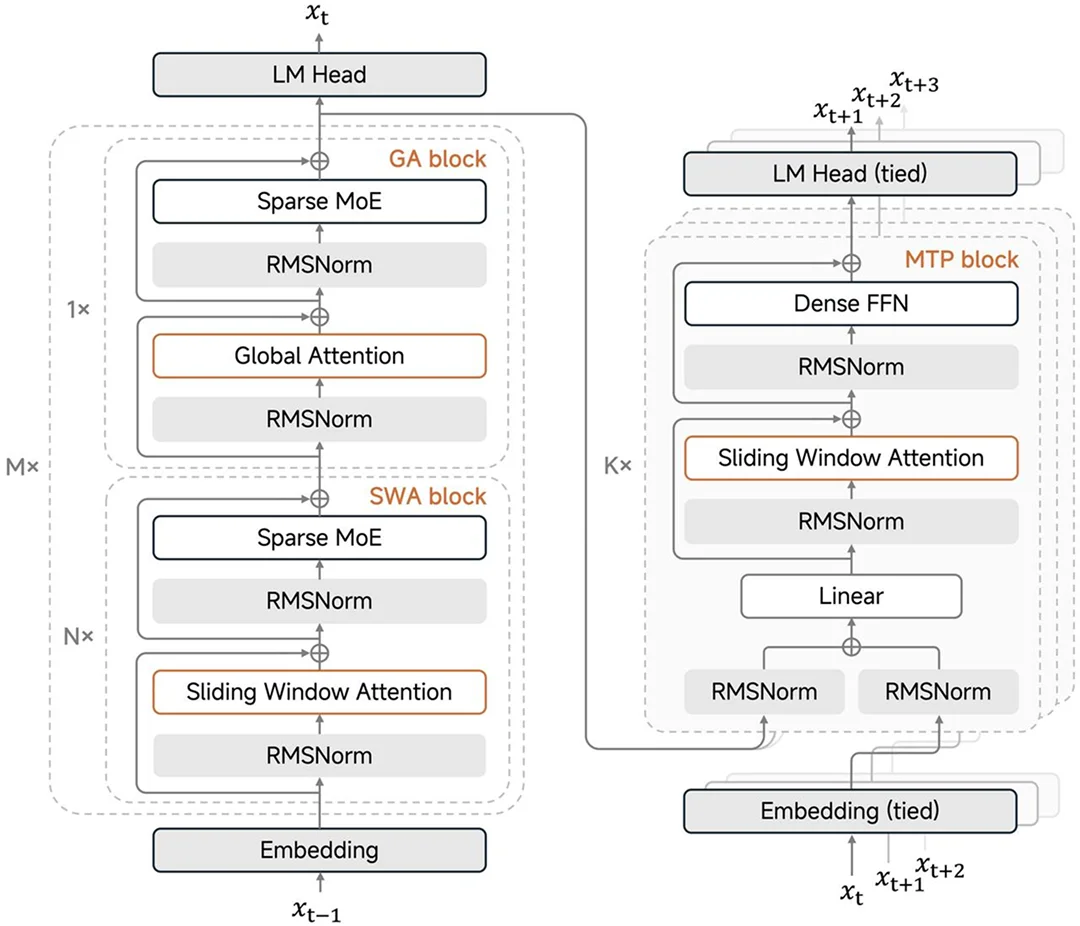

该模型全局注意力(GA)和滑动窗口注意力(SWA)的1:5混合结构。小米MiMo研究团队大量的实证结果表明,SWA简单、高效且易于使用,在通用任务、长上下文负载和推理方面整体表现优于线性注意力。

它还提供固定大小的KV缓存,便于与现有的训练和推理基础设施集成。

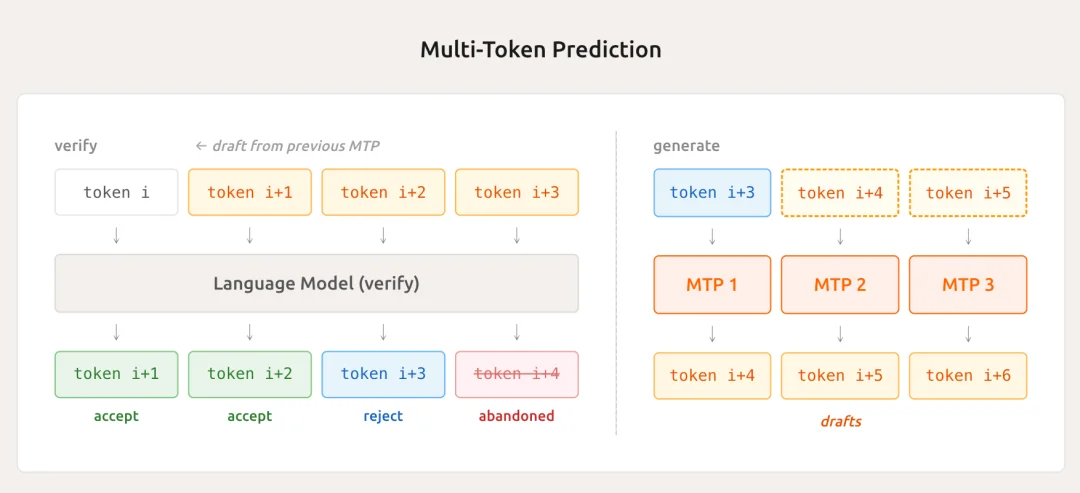

研究人员重新定义了并行解码,以实现极高的输出token吞吐量:通过引入多词元预测(MTP)训练,提升了基础模型的能力,并在推理过程中并行验证了MTP。

MiMo-V2-Flash利用MTP作为原生草稿模型进行自我推测解码,实现了实际部署加速。

大语言模型的解码过程本质上受限于内存,这是由其低运算密度特性决定的。业界通常采用批量级并行技术提升前馈网络(FFN)的运算密度,但该方法对注意力计算环节并无增益,原因在于每个推理请求都需维护独立的KV cache。

相比之下,MTP技术通过一次性生成多个草稿token,同步提升了前馈网络(FFN)与注意力机制的运算密度,后续主模型可对这些草稿token进行并行验证。这种方案能够实现token级并行计算,且不会增加KV cache的输入输出开销。

在MiMo-V2-Flash模型中,MTP模块采用稠密前馈网络来控制参数量,同时使用滑动窗口注意力机制,从而降低KV cache与注意力计算的成本。

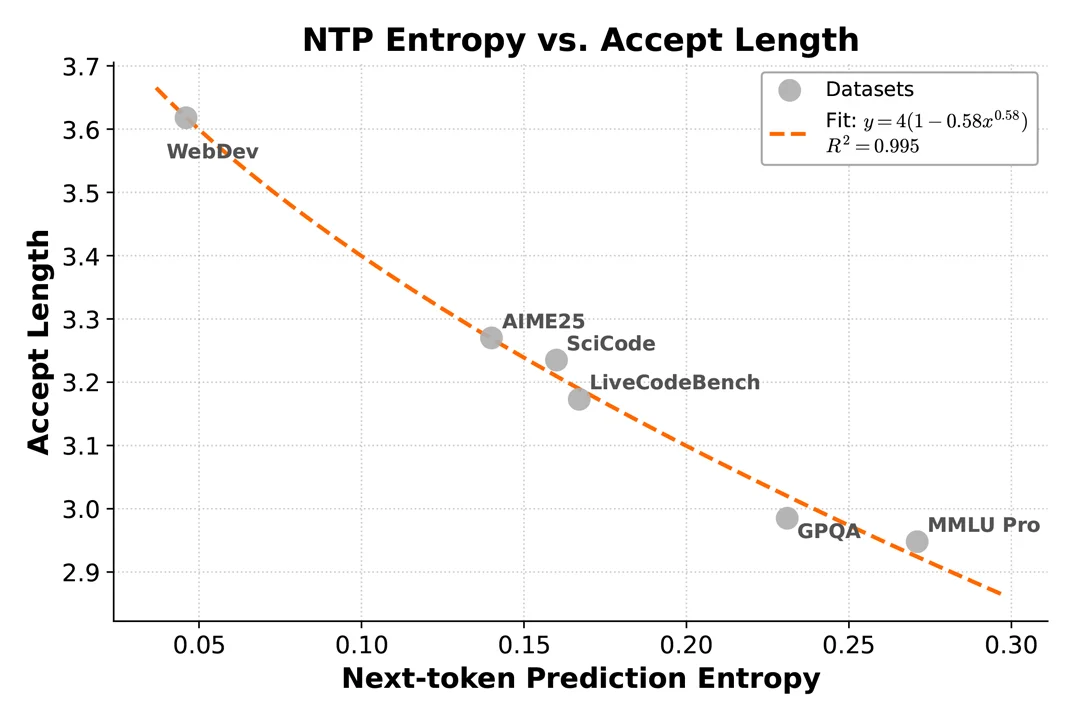

实测数据显示,3层结构的MTP模块可达到2.8-3.6个token的有效接受长度,并实现2.0-2.6倍的推理速度提升。

MiMo-V2-Flash预训练使用FP8混合精度和原生32k序列长度,使用27T token进行训练。

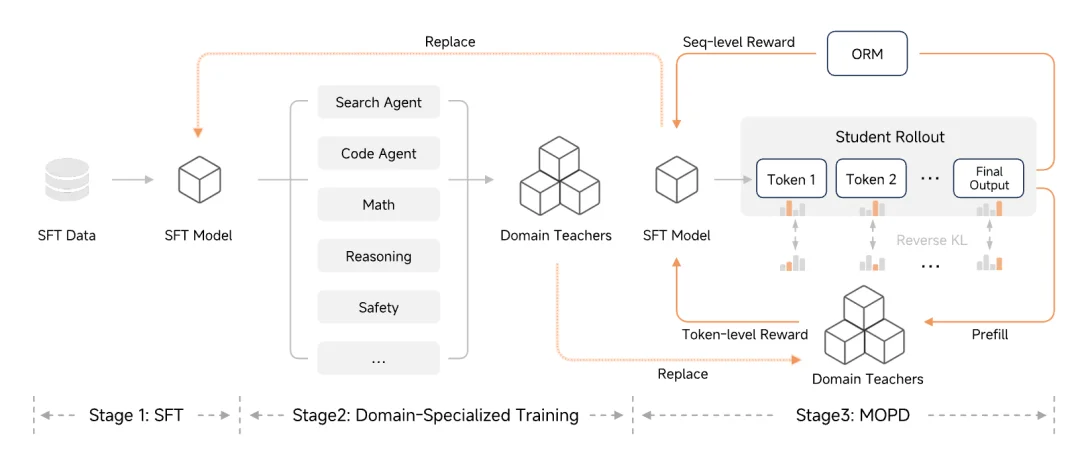

在后训练阶段,为高效拓展强化学习的计算规模,同时增强模型的推理能力与智能体自主决策能力,研究人员提出了多教师在线策略蒸馏(MOPD)。

该范式先通过监督微调(SFT)或强化学习(RL)技术得到各领域的专家教师模型,再让学生模型基于自身的策略分布进行采样,并利用多个教师模型提供的稠密型token级奖励信号完成优化。

MOPD训练只需不到传统SFT+RL流程的1/50计算资源,即可匹配教师模型的峰值表现。

此外,MOPD采用解耦设计,支持新教师与ORM(教学与学习)的灵活整合,自然实现“教学与学习”闭环迭代,精炼学生模式可演变为更强的教师,实现持续自我提升的能力。

结语:小米大模型研发踩下油门

小米凭借混合注意力机制与MOPD等技术创新,大幅优化大模型的研发成本与运行效率;同时开源全部相关成果,有效降低行业研发门槛。此外,近几个月以来,Xiaomi MiMo大模型团队踩下油门,发布数篇论文并开源多个模型。

12月5日,小米集团合伙人、总裁卢伟冰透露,公司AI大模型业务过去四个季度投入环比增速超50%,目前进展“已超出董事会预期”,并宣布将AI与“现实世界深度结合”列为未来十年核心战略。同时,小米正式启动全球人才招募计划,单岗位薪酬上限开至千万元级别,目标“在最短时间内补齐大模型尖端人才缺口”。

文章来自于微信公众号 “智东西”,作者 “智东西”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner