作者来自 Nanyang Technological University(MMLab) 与 SenseTime Research,提出 Prism Hypothesis(棱镜假说) 与 Unified Autoencoding(UAE),尝试用 “频率谱” 的统一视角,把语义编码器与像素编码器的表示冲突真正 “合并解决”。

在视觉基础模型里,我们经常同时依赖两类能力:

但现实问题是:很多系统被迫把两套表示 “拼在一起用”:语义一套、像素一套,训练效率下降、表示互相干扰、而且很难得到一个既 “语义强” 又 “细节强” 的统一潜空间。

论文把这种矛盾归结为一个更本质的问题:世界的信息到底如何被表示,才能既共享语义,又保留各自模态的细粒度。

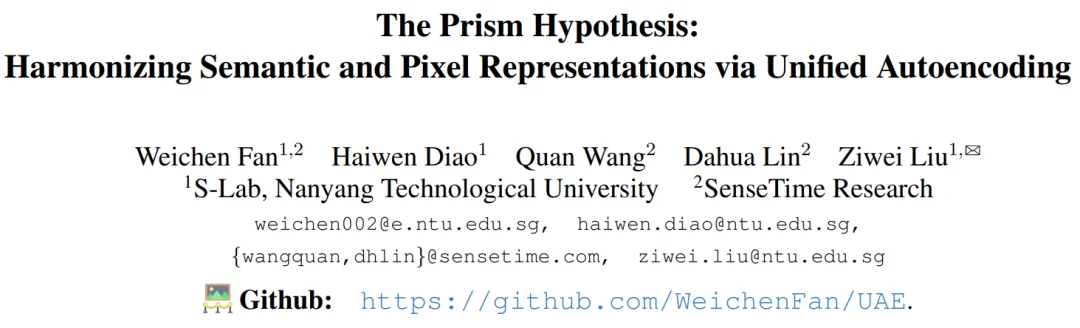

论文给出了一个非常直观的统一解释:

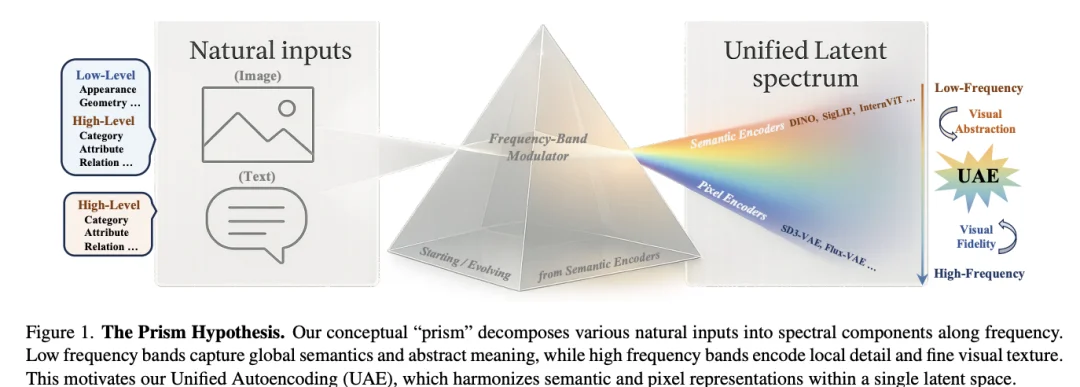

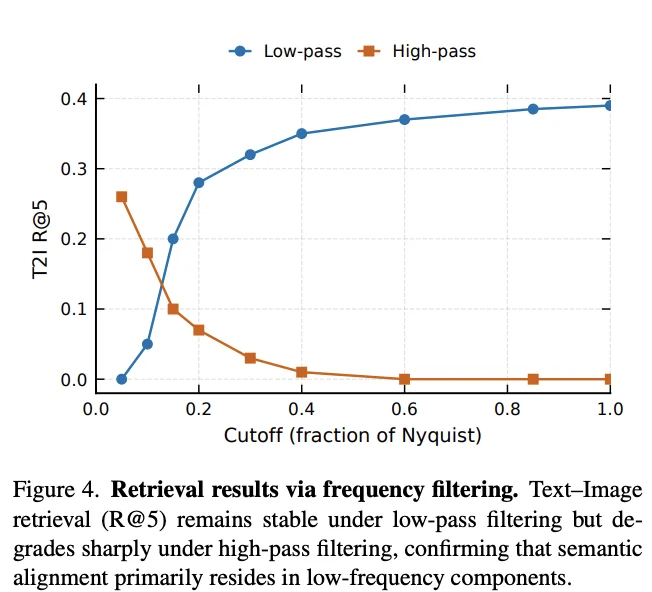

为了验证,作者做了两类证据:

1. 能量谱分析:语义编码器(如 DINOv2、CLIP)能量更集中在低频,而像素型编码器(如 SD-VAE)保留更多中高频细节。

2. 频率过滤下的检索鲁棒性:文本 - 图像检索的 R@5 在低通情况下较稳定,但在高通 / 去掉低频基座后会明显崩塌、趋近随机,说明跨模态语义对齐主要来自共享低频基座。

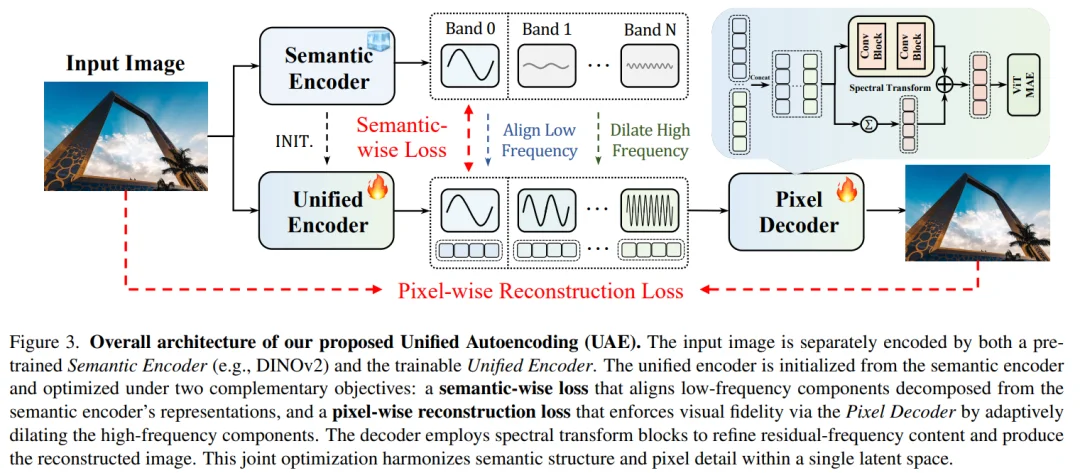

围绕 “低频语义基座 + 高频细节残差” 的思路,UAE 的核心是把一个统一编码器学成多频段潜变量,并把 “语义该管什么、细节该放哪里” 结构化地拆开。

1) Unified Encoder:从语义编码器初始化,走向统一潜空间

以 DINOv2 为例,UAE 的统一编码器从预训练语义模型初始化,进入后续频域处理。

2) Residual Split Flow:在频域做 “可控的分带分解”

UAE 用 FFT 做频段投影(平滑径向 mask),并采用迭代残差拆分,把潜变量拆成多个频带:

同时强调分解的可逆性与空间一致性。

3) Frequency Band Modulator:只 “扰动细节”,再做频带融合给解码器

训练时对高频带进行噪声扰动以增强鲁棒性;然后把各频带在通道维拼接,融合后作为解码器唯一输入。

4) Semantic-wise Loss:语义只约束低频,细节放开学像素

为了既继承语义先验、又扩展到高频细节,UAE 的语义对齐损失只施加在最低频的前 K 个 band 上:

论文也明确把 UAE 定位为 tokenizer,并强调其 “能与现有 diffusion transformers 无缝对齐”。

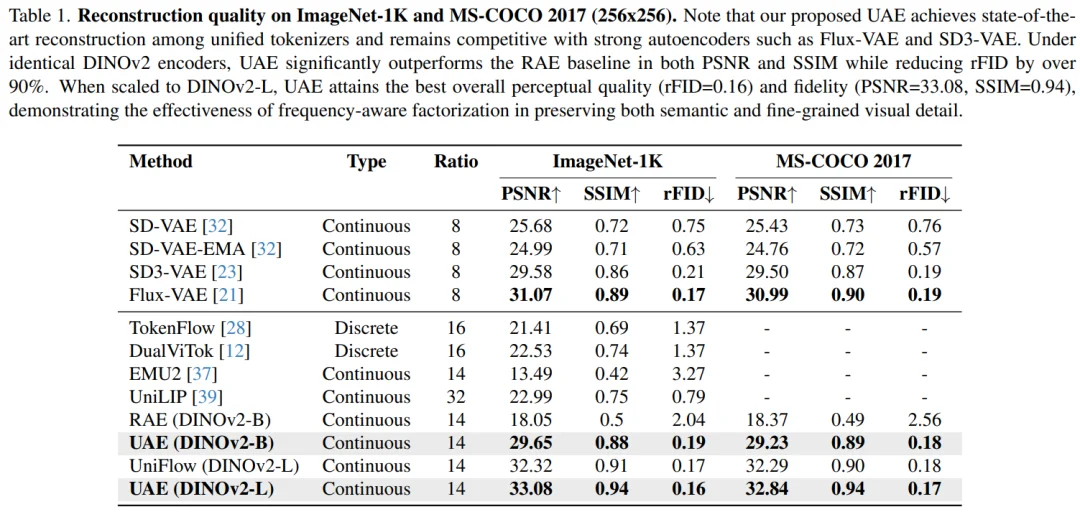

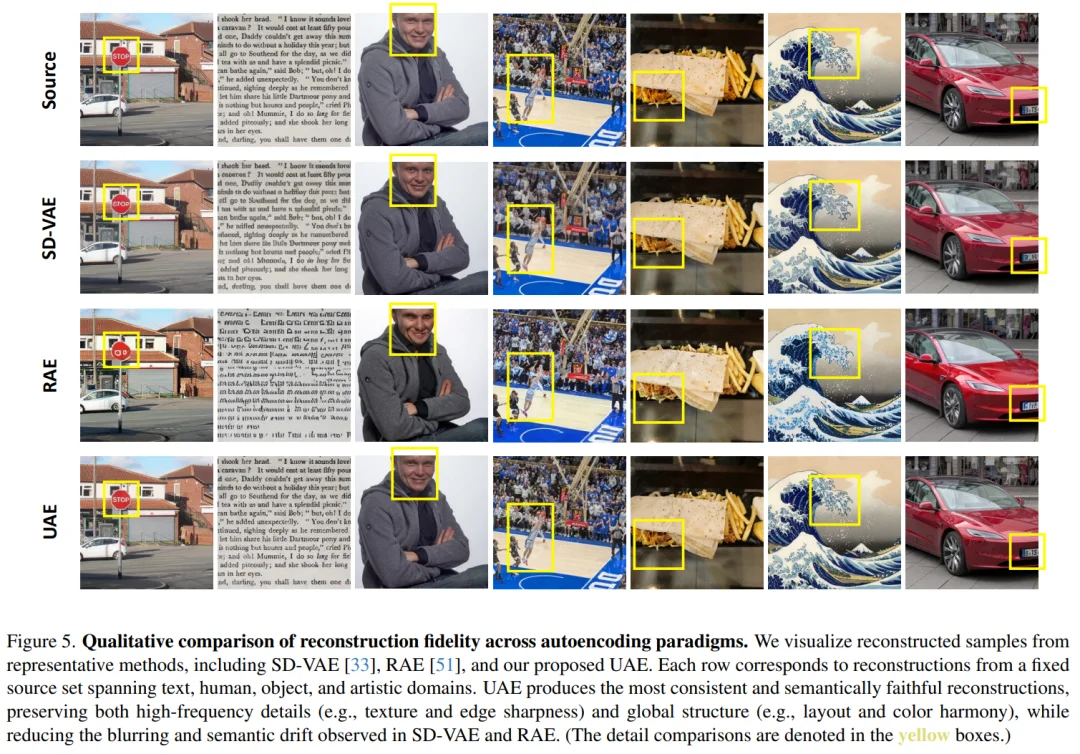

重建质量(ImageNet / MS-COCO)

在 256×256 重建任务上,UAE(DINOv2-L)在 ImageNet 上达到 PSNR=33.08、SSIM=0.94、rFID=0.16,在 MS-COCO 上达到 PSNR=32.84、SSIM=0.94、rFID=0.17。

同时,论文指出在相同 DINOv2 编码器设置下,UAE 相比 RAE 基线在 PSNR/SSIM 更高,并且 rFID 下降超过 90%。

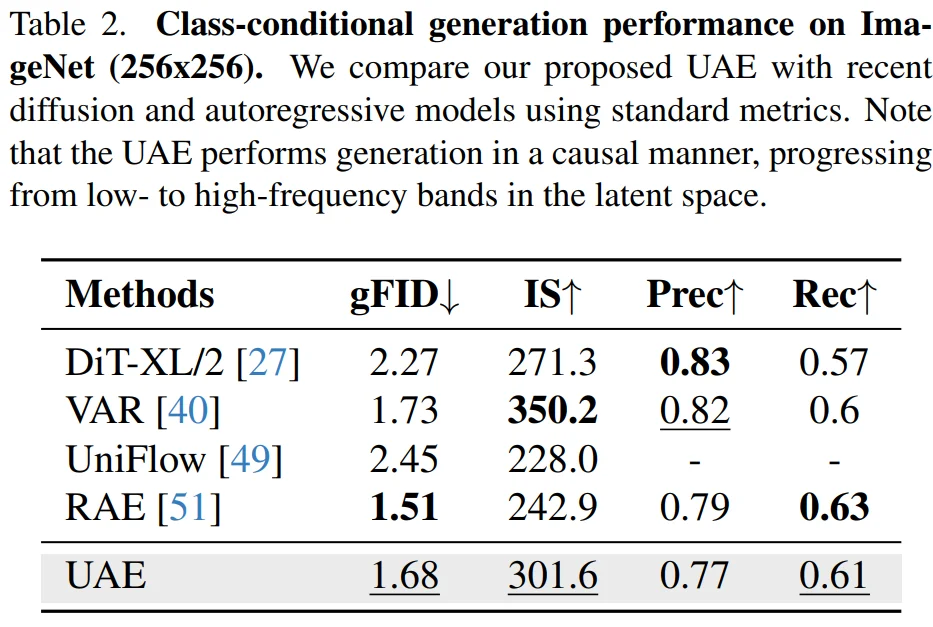

生成能力(ImageNet 类条件生成)

在 ImageNet 256×256 类条件生成上,UAE 达到 gFID=1.68、IS=301.6。

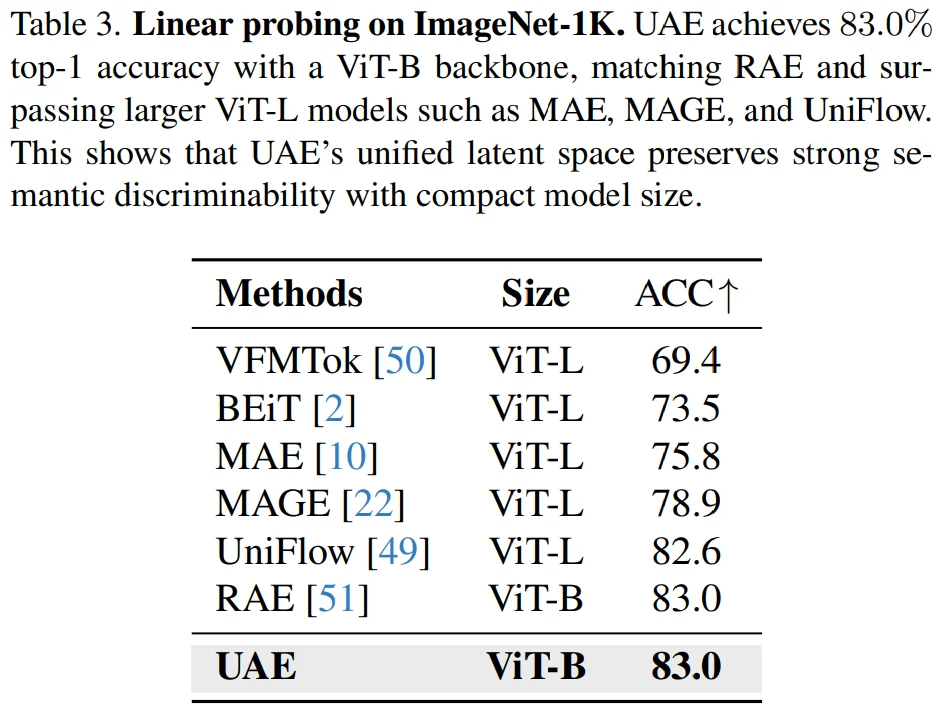

语义理解(Linear Probing)

在 ImageNet-1K 上,UAE 在 ViT-B 骨干下达到 Top-1=83.0%,与 RAE 持平。

文章来自于“机器之心”,作者 “机器之心”。