我们对 Coding Agent 的评测,可能搞错了方向。

一个反复出现,但常常被忽略的现象是:用户对 Agent 的不满,往往不是因为它「做不到」,而是因为它「做得不好」。

「做得不好」集中表现在:Agent 不遵循明确给出的指令和潜在的工程规范。比如,系统提示里明确要求「不要使用 emoji」,Agent 却在代码注释里加上笑脸;用户要求「先备份再修改」,Agent 上手就是一键 [rm -rf] 删除文件。

这些问题的共同特征是:任务最终可能完成了,但过程违反了规范。用户要的不只是「能跑的代码」,还有「符合团队协作规范的代码」。

这也暴露了当前主流评测体系的盲区。学术榜单,不管是 SWE-bench verified,还是各种基于 terminal 环境的测试,核心理念几乎都是结果导向指标。只问两个问题:测试通过了吗?Bug 修复了吗?

这种评估方式,不看模型在沙盒里的输出过程,也不看真实场景的交互体验。最后的结果是:评估和真实使用场景,完全错位。

为此,MiniMax 开源了一个新评测集:OctoCodingBench。用来评测 Coding Agent 在完成任务的过程中,有没有遵守规矩。

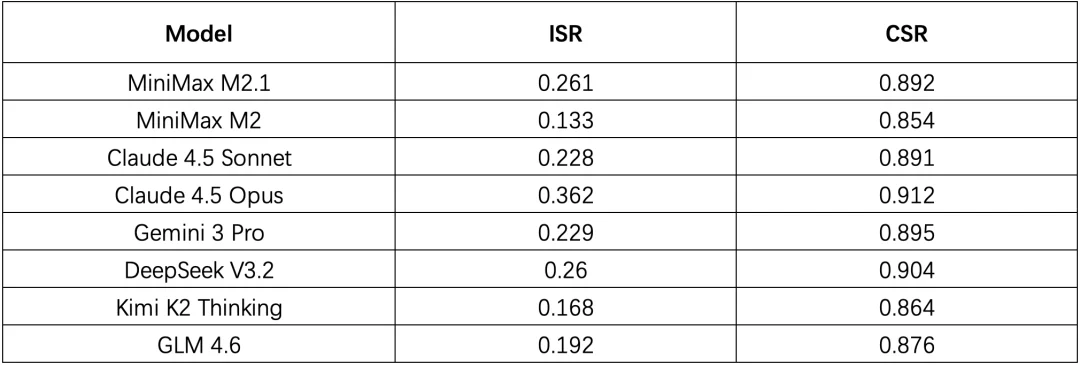

测评结果很有意思:即便是最强的模型,在 2/3 的任务中,代码可能是对的,但过程是错的。

Hugging Face 链接:

huggingface.co/datasets/MiniMaxAI/OctoCodingBench

如果遵循过程规范的 Coding Agent,才能被放心地引入真实的软件工程流程中。那目前主流 Code Agent 的评估体系就出现了明显的盲区。随着 Claude Code、Codex、Cursor、Windsurf 等 Agent 产品的普及,社区正在形成一套面向 Agent 的仓库协议体系。项目不再只是一堆代码,同时也包含了多层次协作模式的说明:

这些机制的出现,本质上是在构建一个多层级的指令系统。举个例子,当用户说「帮我重构这个模块」时,Agent 需要同时满足多个层级的约束:系统层面的安全规则(不能直接删代码)、当前用户的即时指令(重构到什么程度)、仓库中明确写下的工程规范,以及历史记忆中已经做出的决策(延续还是推翻)。更复杂的情况是,这些指令源之间可能冲突。用户临时说「这次就先不写测试了」,但 [AGENTS.md] 里明确要求「每次提交必须有测试覆盖」——Agent 该听谁的?

然而一个尴尬的问题是,当前的学术榜单,无论是 SWE-bench verified,还是各类基于 terminal 环境的测试,其核心理念几乎都是 Outcome-based Metrics (结果导向指标):测试是否通过? Bug 是否修复?这种结果导向的评估方式,根本无法刻画模型在沙盒环境下的输出过程,更不用说复杂现实场景的真实交互体验,最终导致了评估和真实使用场景的错位。

要解决这个问题,评估范式本身需要发生根本性转变——需要关注输出过程本身。

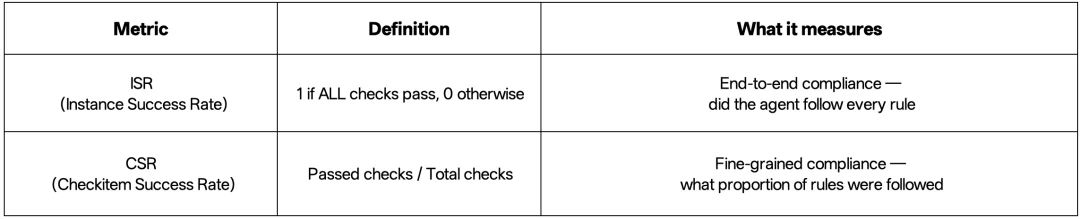

基于这一动机,MiniMax 引入了 OctoCodingBench,从 Check-level 准确率 (CSR)、 Instance-level 成功率 (ISR)两个维度来进行评估,旨在充分观测模型的完成任务时出现的过程指令不遵循问题,以尽可能接近真实用户体验。

其中,CSR 用来衡量 Coding Agent 遵循了多大比例的规则,ISR 则用来衡量 Coding Agent 是否遵循了每条规则。

一个合格的 Coding Agent,需要在完成任务的同时遵循:

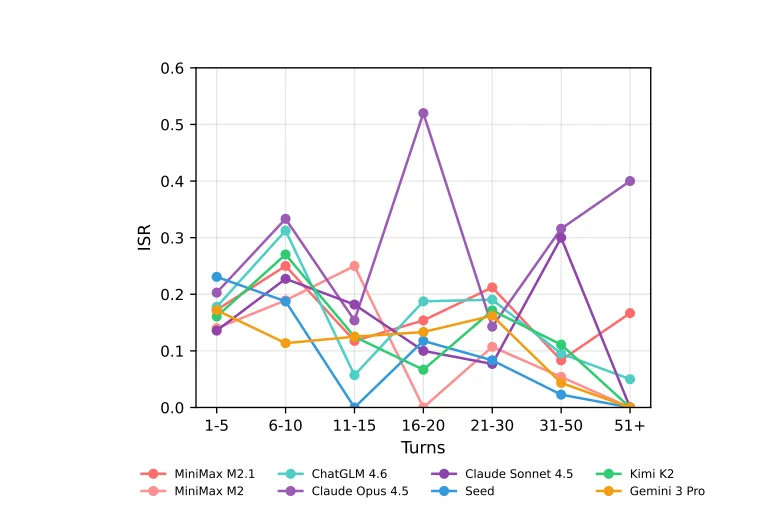

基于该评测集,MiniMax 针对现有的开源闭源模型进行了广泛的评估,发现了一些很有启发性的实验结果:

不同交互轮次下 ISR 的变化

MiniMax 认为,下一代 Coding Agent 的训练,需要引入 Process Supervision(过程监督) :

Coding Agent 的能力边界,正在从「能否写出能跑的代码」,转向「能否在复杂约束下协作式地完成任务」。这也映射出产品哲学的深层转变:Agent 不是要替代人类开发者,而是要成为懂规矩、守纪律的团队成员。

因此,过程规范(Process Specification)才是 Coding Agent 进化的核心命题。

当我们开始关注过程而非仅仅结果,当我们让评估体系能够捕捉「违规但成功」的危险模式,Coding Agent 才能真正从 Demo 走向生产环境。

文章来自于微信公众号 “Founder Park”,作者 “Founder Park”

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0