马斯克的 xAI 非常神秘。

回忆了下,过去一年,我从没见过任何 xAI 员工的公开访谈。这家公司除了例行发布会,只有马斯克这一个信息出口。

不像 OpenAI 的员工经常到处演讲,不像 Anthropic 的研究员经常会接受访谈,xAI 的工程师们像隐形人一样。

所以昨天下午,当我刷到 xAI 核心骨干 Sulaiman Ghori 的一期播客时,我非常惊喜。

这哥们聊了很多内部细节,从公司文化到具体项目,信息量巨大。

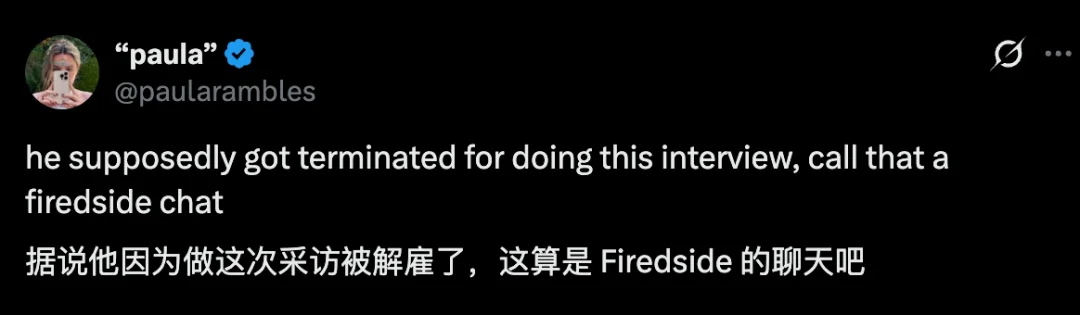

但没想到,今天早上醒来,X 上有人爆料说,Sulaiman Ghori 可能已经被公司开除了。原因是他在播客中泄露了公司机密。

震惊。

大家也可以去看看: https://www.youtube.com/watch?v=8jN60eJr4Ps

这期播客,我最感兴趣的话题是 MacroHard。相当于 xAI 的通用 Agent。这也是 Sulaiman Ghori 小哥当前正在参与的核心项目。

MacroHard 相当于是数字世界的 Optimus。

特斯拉的 Optimus 是让机器人做任何人类能做的物理任务,MacroHard 是让 AI 做任何人类能做的数字任务。

怎么做到的?直接模拟人类的操作方式。

看屏幕,敲键盘,点鼠标。Sulaiman 的原话是:任何软件都不需要适配,我们可以部署到任何人类目前能工作的场景。

OpenAI 有 Operator,Anthropic 有 Computer Use,大家都在做类似的事情。但 xAI 在一个关键问题上,选了一条不同的路。

xAI 内部很早就做了一个决定:MacroHard 的模型必须比人类快至少 1.5 倍。注意,不是更聪明,是更快。

为什么?他打了个比方:没有人愿意等电脑花 10 分钟做一件我 5 分钟就能做完的事。但如果它能在 10 秒内完成,我愿意为此付任何价钱。

这个逻辑其实来自特斯拉 FSD 的经验。自动驾驶如果反应比人慢,没人敢用。

同样的道理,一个帮你操作电脑的 AI,如果慢吞吞地思考、一步一步地点击,你早就手痒自己动手了。

所以当其他实验室在堆参数、加推理的时候,xAI 在砍延迟、压模型。别人往左,他们往右。

目前的结果是:最新测试显示,MacroHard 的速度可能达到人类的 8 倍,甚至更多。

这就带来一个问题:快,会不会意味着笨?

要快,就得用小模型。这是基本的物理约束。

其他实验室做通用 Agent 的思路是加推理、堆参数、把模型做大。xAI 的这个决定,让他们走上了一条完全相反的路。

但这里有一个直觉上的担忧:小模型会不会意味着弱模型?参数少了,能力就差了。这是过去几年 Scaling Law 灌输给我们的观念。

xAI 的实践给出了一个不同的答案。

他们在测试 MacroHard 时,经常会遇到惊喜。有些任务,模型根本没有专门训练过,但它做得完美无缺。这种泛化能力超出了团队的预期。

他把这个现象和特斯拉的 FSD 做了类比。FSD 用的也是相对小的模型,但它能处理训练数据里从未出现过的场景。原因是什么?权重效率。

大模型有很多冗余。就像一个人用 100 句话解释一件事,另一个人只用 10 句话,信息量可能是一样的。

小模型被迫压缩,反而可能提炼出更本质的模式。这不是什么神秘的事情,而是约束带来的副产品。

而且小模型还有一个隐藏优势:迭代速度。

Sulaiman 说,因为模型小,他们的训练周期从原来的四周缩短到了一周,有时候甚至是一天之内多次迭代。

这意味着什么?他们可以同时跑 20 个实验,别人只能跑 2 个。在 AI 这个领域,实验次数几乎等于进步速度。

所以这不是一个简单的大 vs 小的问题。

这是一个系统性的选择:你要一个跑得慢但单次更强的模型,还是一个跑得快、迭代更快、最终可能更好的模型?

xAI 选了后者。

还有一个更劲爆的信息:xAI 计划把 MacroHard 部署在特斯拉汽车上。

我当时看到非常惊讶。马斯克是真的敢想,他们在认真考虑用北美 400 多万辆特斯拉车里的计算芯片来部署 MacroHard。

特斯拉的车载电脑是为自动驾驶设计的,算力不弱。更重要的是,这些车大部分时间都停着,可能在充电,可能在车库里。电脑是闲置的。

与此同时,它们已经具备了联网能力、散热系统、供电系统。

换句话说,这是 400 万台现成的边缘计算节点,不需要额外建数据中心,不需要额外布线,不需要额外装空调。

xAI 的想法是:付钱给车主,租用他们汽车的闲置算力。

车主赚点外快,可能把车贷都覆盖了。xAI 得到了一个分布式的、成本极低的算力网络。 这是一个纯软件方案,不需要任何硬件建设。

当然,这个方案能不能落地还有很多变数。但它揭示了 xAI 的一种思维方式:不是问有什么资源可以用,而是问有什么资源被低估了。

特斯拉车载电脑的资本效率,比在 AWS 上租 VM 高得多。这个事实一直存在,只是没人想过这么用。

Sulaiman 还透露了一个细节,关于虚拟员工部署时遇到的坑。

他们在给客户部署虚拟员工时,会先采访人类员工,让他们描述自己的工作流程。然后发现虚拟员工老在某些地方出错。

他们去观察人类员工实际操作,结果发现人类漏掉了 20 个步骤没说。

因为那些步骤已经变成了肌肉记忆,人类自己都意识不到。就像你开车的时候,不会想着踩油门、松离合、打方向盘。你只是开。

这是一个很深刻的洞察:

人类对自己做的事情,其实没那么了解。我们以为自己在做 A,实际上我们在做 A+B+C+D,只是 BCD 已经自动化到意识之外了。

所以 MacroHard 团队现在的流程是:先采访,再观察,最后对比差异。那些差异,往往就是虚拟员工出错的地方。

还有一个更有意思的事。

xAI 已经开始在公司内部测试虚拟员工了,有时候甚至不告诉其他同事。

结果经常有人在 Slack 上问:嘿,这个同事今天不在吗?我去他工位找他,发现是空的。

因为那个工位上的员工,从一开始就是 AI。

文章来自于“AI产品阿颖”,作者 “阿颖”。

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md