大模型的能力正在被不同的范式逐步解锁:In-Context Learning 展示了模型无需微调即可泛化到新任务;Chain-of-Thought 通过引导模型分步推理来提升复杂问题的求解能力;近期,智能体框架则赋予模型调用工具、多轮交互的能力。

沿着这条技术演进路线,下一步是什么?

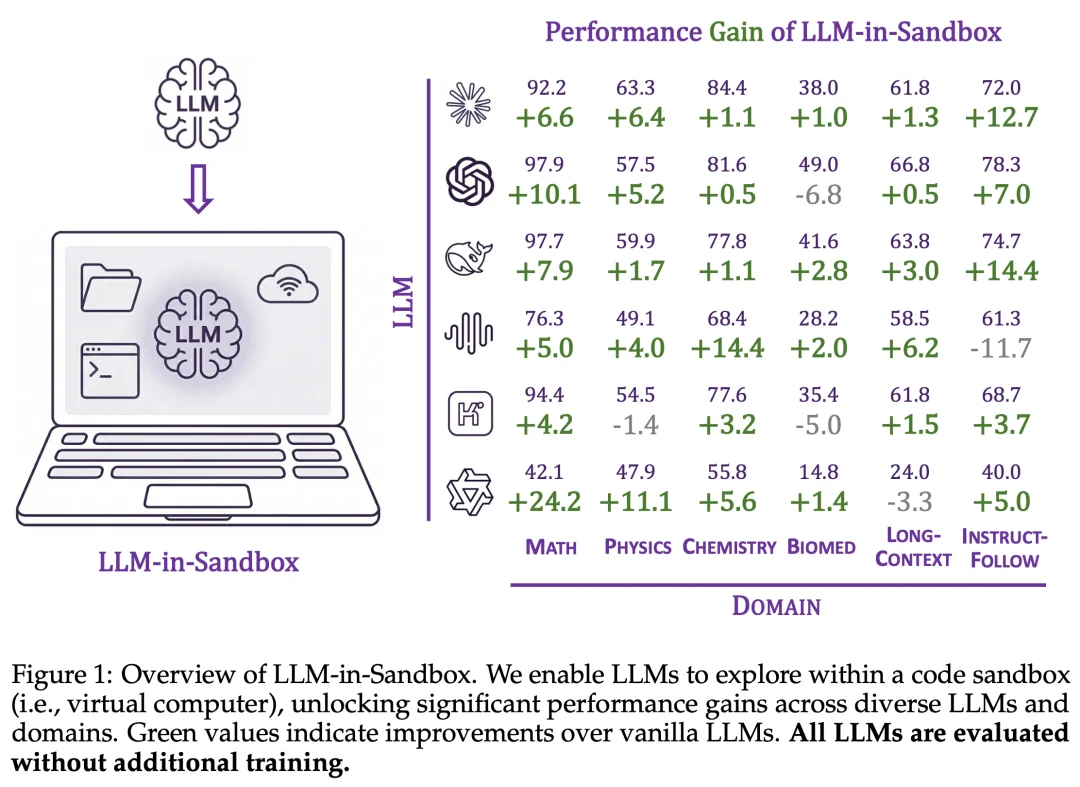

近日,来自中国人民大学高瓴人工智能学院、微软研究院和清华大学的研究者提出了一个简洁而有效的范式:LLM-in-Sandbox——让大模型在代码沙盒(即虚拟电脑)中自由探索来完成任务。实验表明,这一范式不仅在代码任务上有效,更能显著提升模型在数学、物理、化学、生物医学、长文本理解、指令遵循等多个非代码领域的表现,且无需额外训练,同时显著减少长文本场景下的 token 消耗,并保持相当水平的推理速度。

研究者已将 LLM-in-Sandbox 开源为 Python 包,可与 vLLM、SGLang 等主流推理后端无缝集成。LLM-in-Sandbox 应当成为大模型的默认部署范式,取代纯 LLM 推理。

电脑可能是人类创造的最通用的工具,几乎任何任务都可以通过电脑完成。这种通用性源于三大元能力(Meta-Capabilities):

正如人类借助电脑完成各种任务,研究者假设:将大模型与虚拟电脑结合,或许能够解锁其通用智能的潜力。

2.1 轻量级通用沙盒

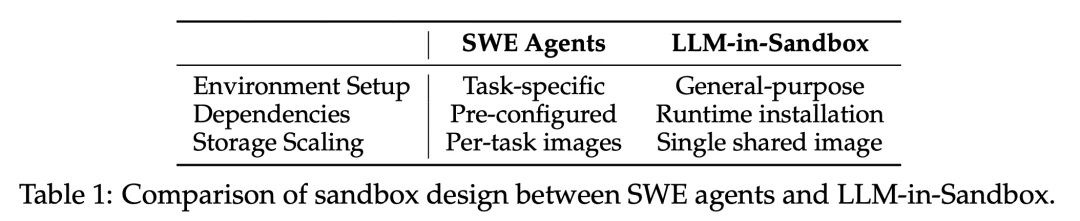

与现有软件工程智能体(SWE-Agent)需要为每个任务配置特定环境不同,LLM-in-Sandbox 采用轻量级、通用化的设计:

这种设计带来两个优势:泛化性(同一环境支持多种任务)和可扩展性(无需为每个任务维护独立镜像)。例如,当扩展到数千个任务时,SWE 智能体可能需要高达 6TB 的存储空间用于任务特定镜像,而 LLM-in-Sandbox 仅需约 1.1GB 的共享镜像。

2.2 最小化工具集

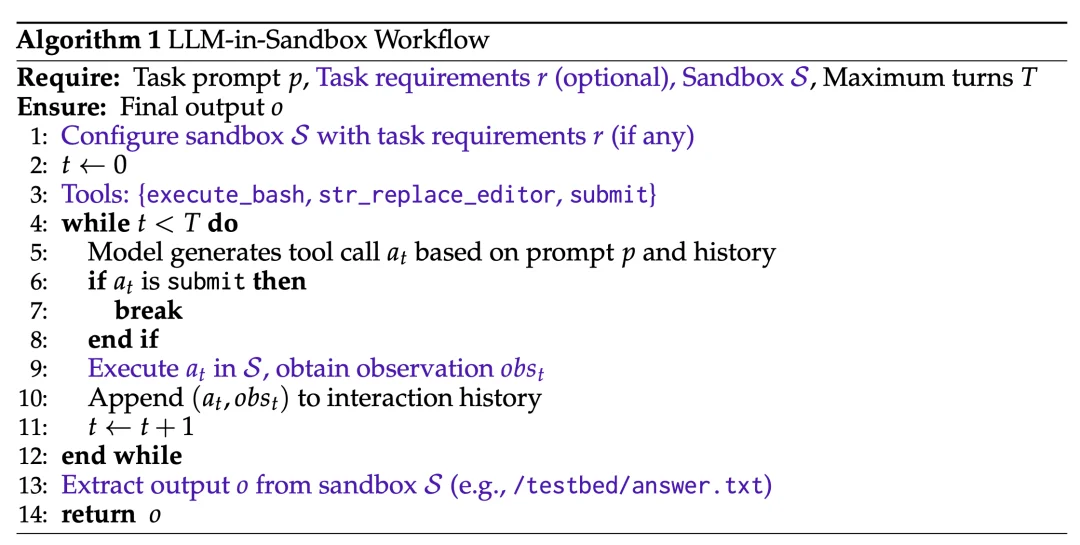

研究者为模型配备了三个基础工具:

这三个工具共同实现了电脑的核心能力,足以支撑复杂任务的完成。

LLM-in-Sandbox 采用多轮交互的工作流:模型在每一轮生成工具调用,接收执行结果作为反馈,然后决定下一步行动,直到调用 submit 或达到最大轮次限制。

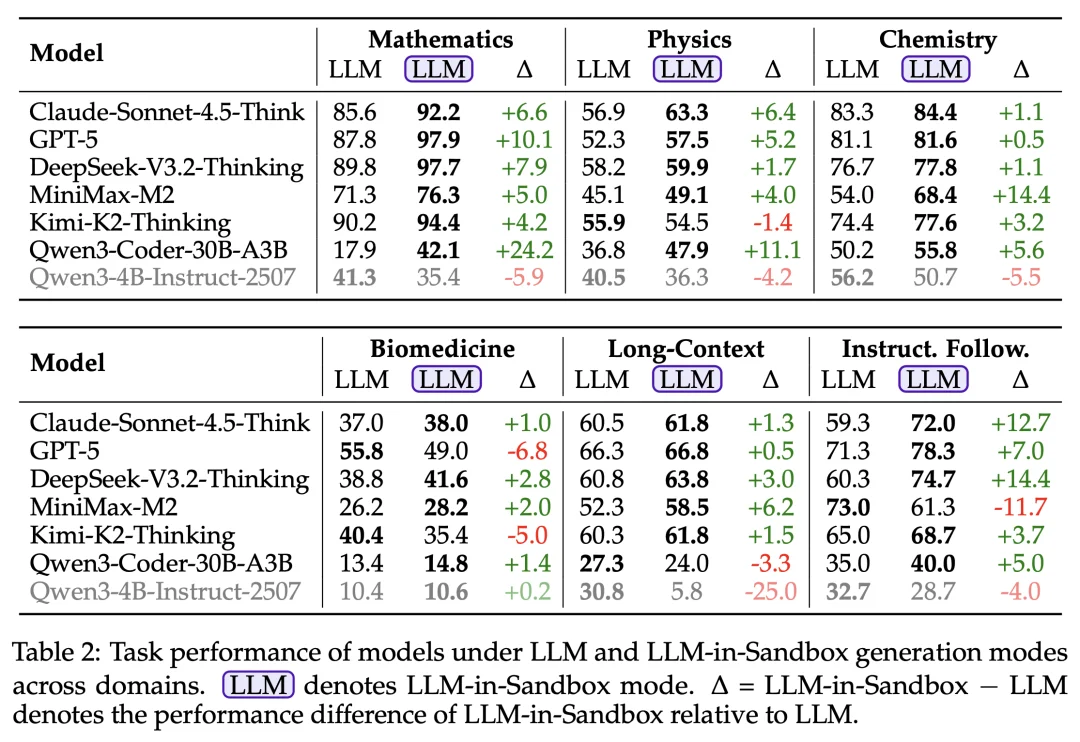

研究者在六个非代码领域进行了实验:数学、物理、化学、生物医学、长文本理解和指令遵循。

实验结果表明,强大的语言模型在 LLM-in-Sandbox 模式下获得了一致性的提升。值得注意的是,这些提升完全无需额外训练:模型能够自发地利用沙盒环境来增强任务表现。

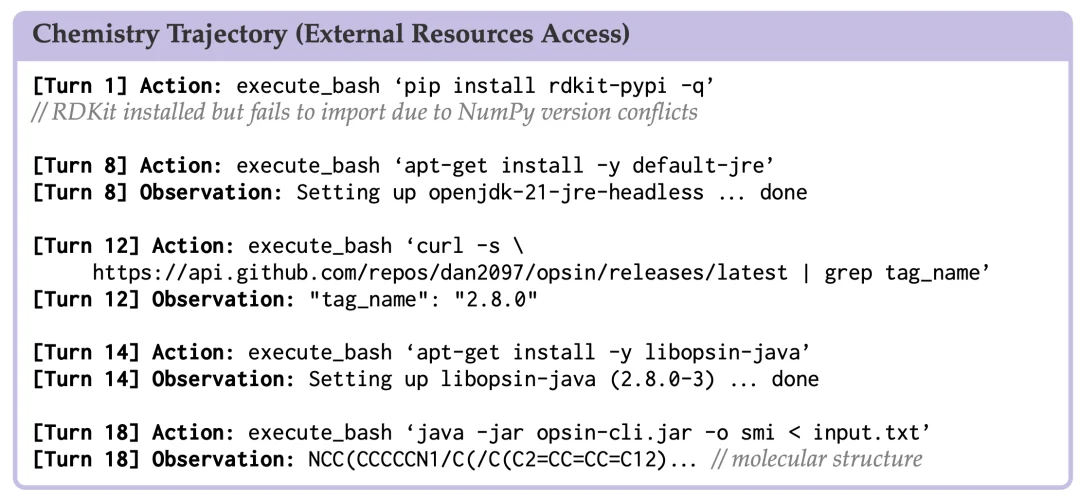

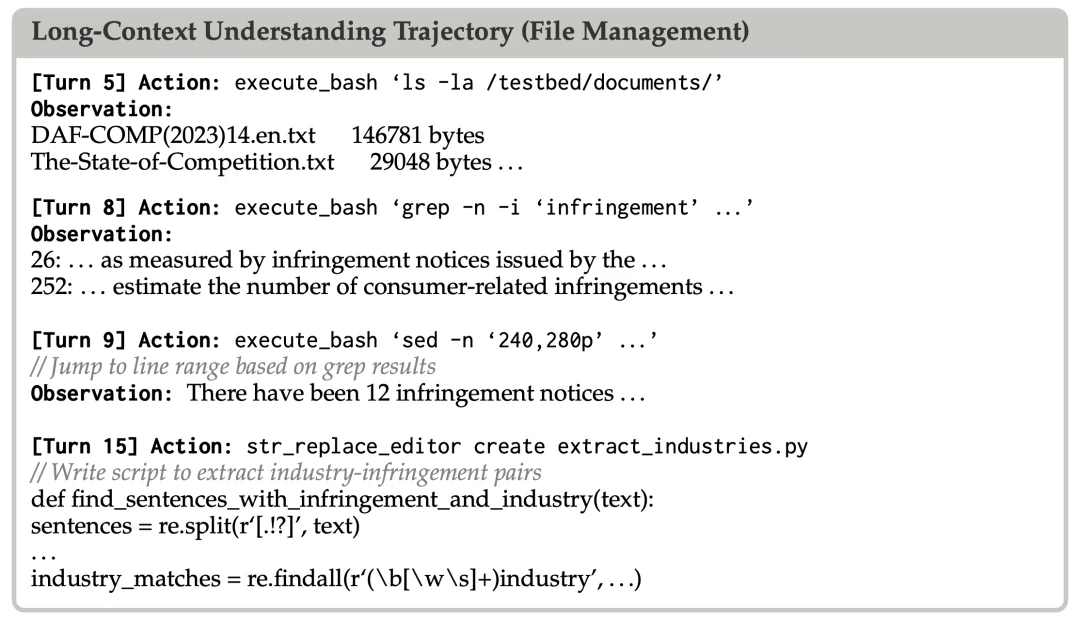

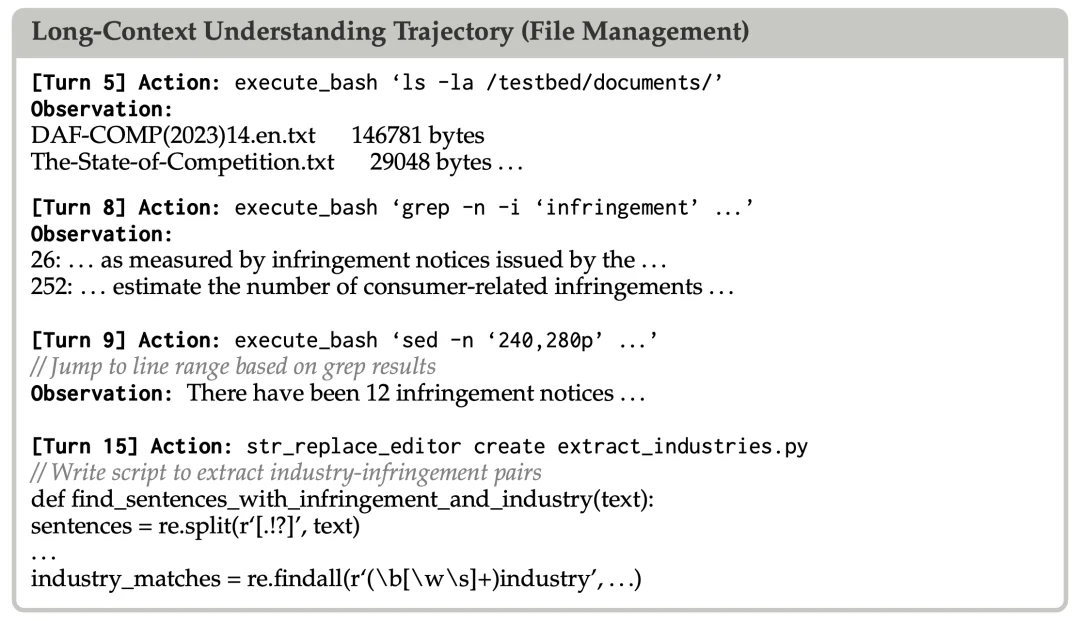

研究者通过案例分析揭示了模型如何自主利用沙盒的三大能力。

虽然强大的智能体模型能够直接受益于 LLM-in-Sandbox,但较弱的模型(如 Qwen3-4B-Instruct)往往难以有效利用沙盒环境,甚至表现不如纯 LLM 模式。

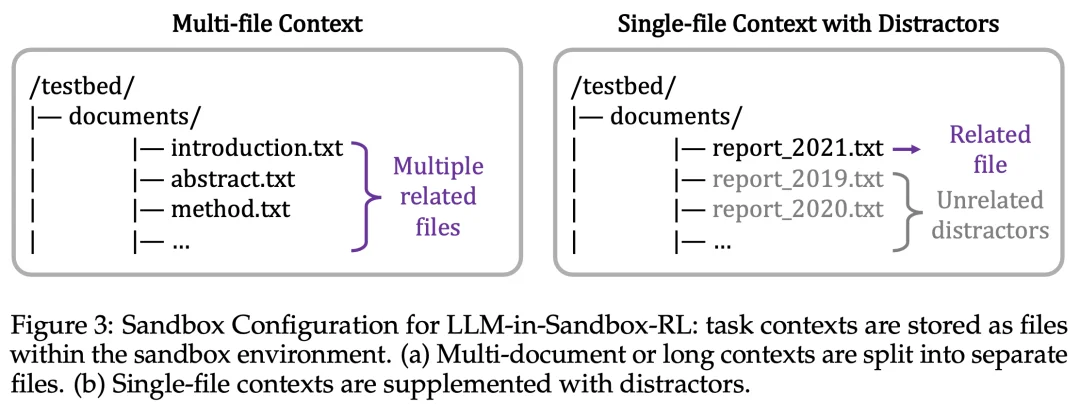

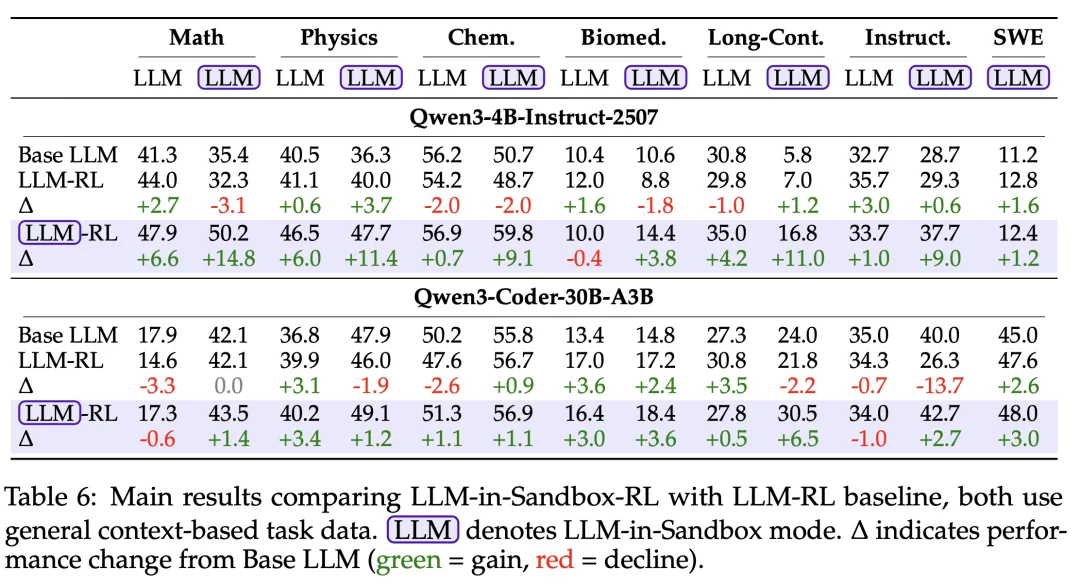

为此,研究者提出了 LLM-in-Sandbox RL:使用非智能体数据在沙盒环境中训练模型。

核心思想是采用基于上下文的任务(context-based tasks):每个任务包含背景材料和需要基于这些材料完成的目标。由于完成目标依赖于提供的材料,模型必须主动探索沙盒以找到相关信息,从而自然地学会利用沙盒能力。

实验在 Qwen3-4B-Instruct 和 Qwen3-Coder-30B-A3B 两个模型上进行。关键发现是 LLM-in-Sandbox RL 展现出强大的泛化能力:

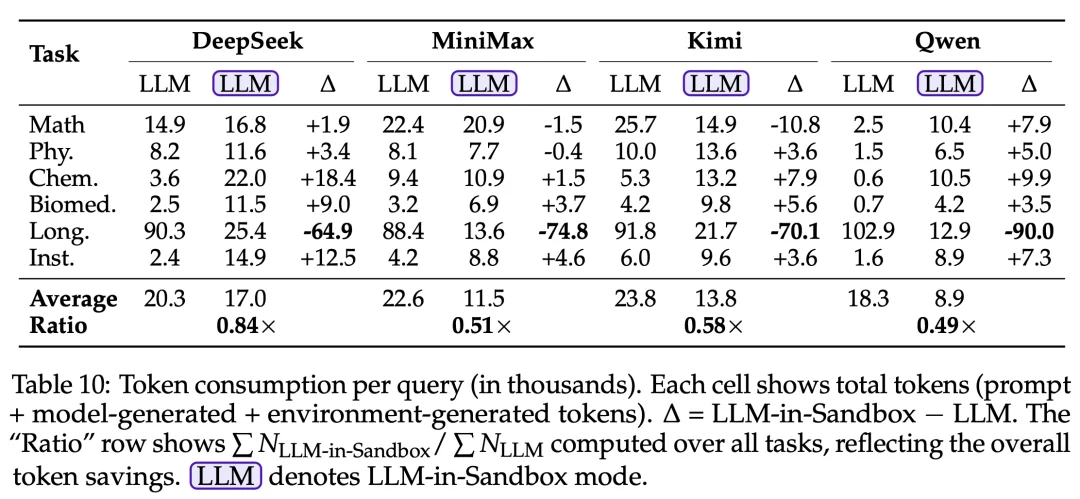

在长文本场景下,LLM-in-Sandbox 将文档存储在沙盒中而非放入 prompt,可将 token 消耗降低最多 8 倍(100K → 13K tokens)。

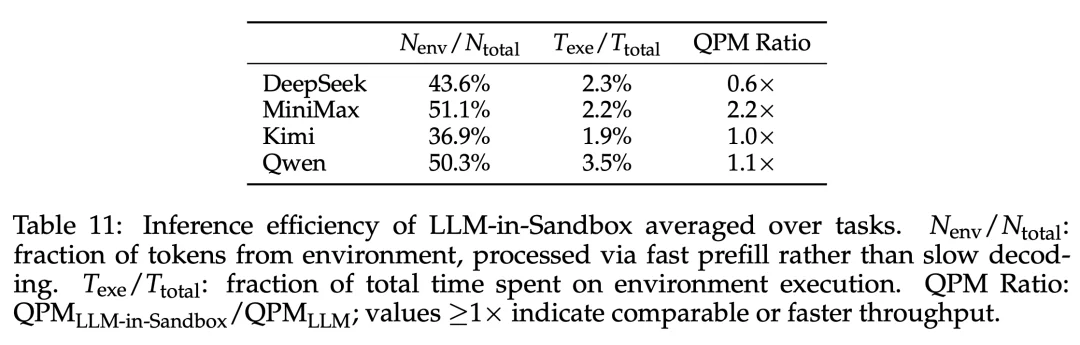

通过将计算卸载到沙盒,LLM-in-Sandbox 将工作负载从慢速的自回归生成(decode)转移到快速的并行预填充(prefill),在平均情况下保持有竞争力的吞吐量(QPM):MiniMax 可实现 2.2 倍加速。

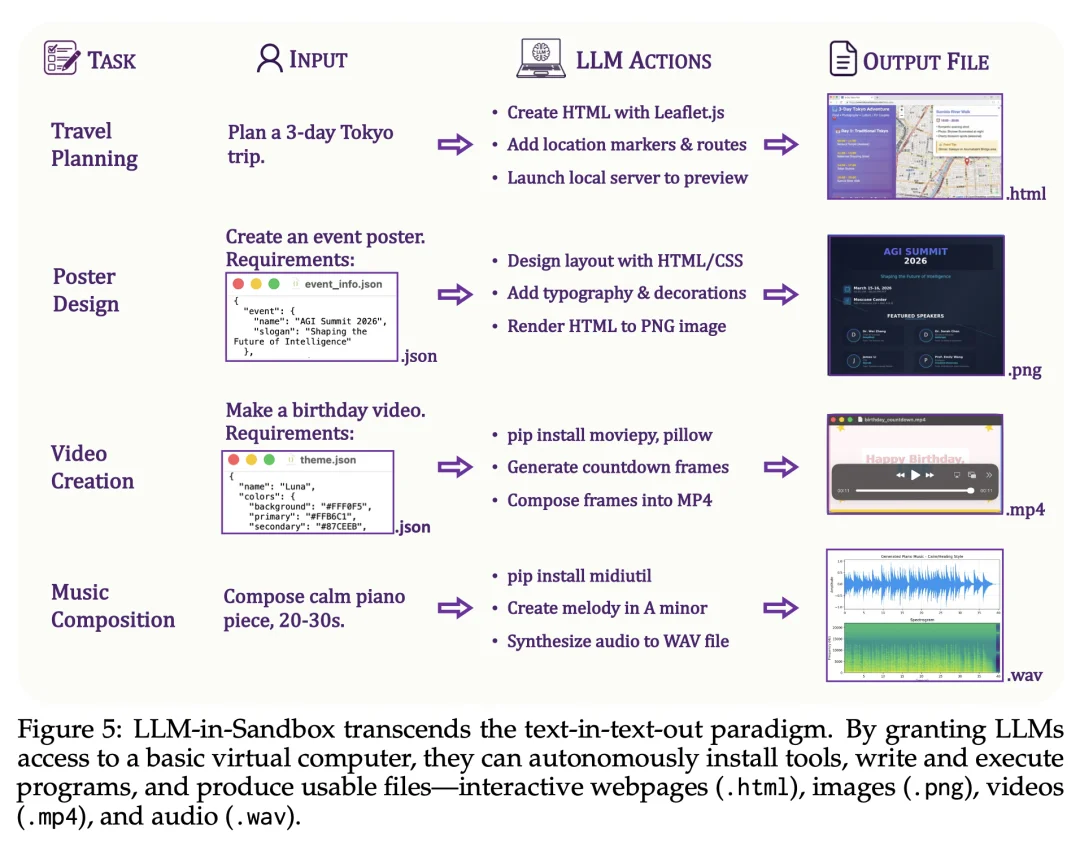

前面的实验评估的是 LLM 和 LLM-in-Sandbox 都能完成的任务。然而,LLM-in-Sandbox 还能实现纯 LLM 根本无法完成的能力。通过给 LLM 提供虚拟电脑,LLM-in-Sandbox 突破了 text-in-text-out 的范式,解锁了新的可能性:

这些案例揭示了一个有前景的方向:随着 LLM 能力的增强和沙盒环境的完善,LLM-in-Sandbox 可能演化为真正的通用数字创作系统。

LLM-in-Sandbox 提出了一个简洁而有效的范式:通过给大模型提供一台虚拟电脑,让其自由探索来完成任务。实验表明,这一范式能够显著提升模型在非代码领域的表现,且无需额外训练。

研究者认为,LLM-in-Sandbox 应当成为大模型的默认部署范式,取代纯 LLM 推理。当沙盒可以带来显著的性能提升,并且部署成本几乎可以忽略不计时,为什么还要用纯 LLM?

文章来自于微信公众号 “机器之心”,作者: “机器之心”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】ai-renamer是一个用AI帮你做文件夹或者图片命名的项目。该项目会根据文件夹或者图片内容来为文件进行重新命名,让你的文件管理更加便利。

项目地址:https://github.com/ozgrozer/ai-renamer

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0