在大模型驱动的 Agentic Search 日益常态化的背景下,真实环境中智能体 “如何发查询、如何改写、是否真正用上检索信息” 一直缺乏系统刻画与分析。

CMU 团队基于可重复检索平台 DeepResearchGym,从统一后端的半年真实流量中整理出 1400 万余条搜索请求、约 400 万个会话,在严格匿名化与清洗后,构建并于 Hugging Face 开源了首个 Agentic Search 行为日志数据集。

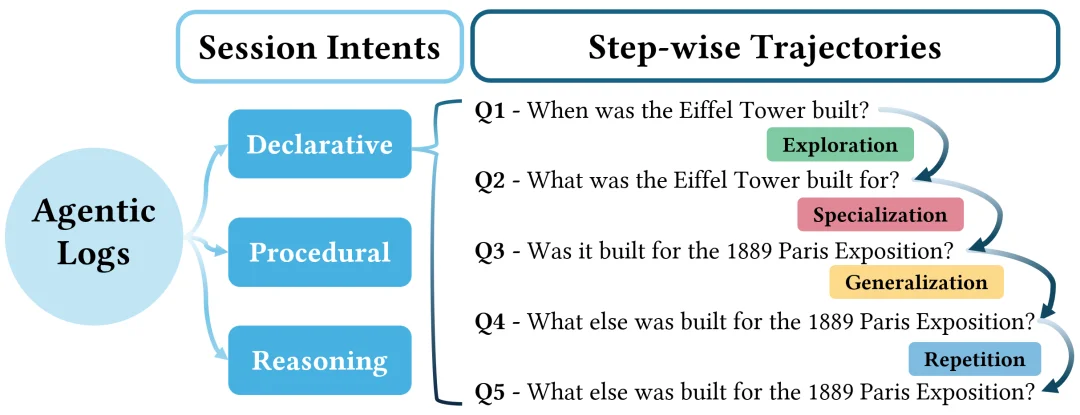

在此基础上,工作提出 “会话意图(Declarative / Procedural / Reasoning)→轨迹动作(专化 / 泛化 / 探索 / 重复)→检索信息采纳率(CTAR)” 三层分析框架,利用 LLM 进行会话切分与标签推断,刻画出智能体搜索中普遍存在的下钻偏好、事实型任务中的重试循环,以及不同改写模式对历史检索信息依赖程度的显著差异。

总体而言,该研究既为观察与评估 Agentic Search 行为提供了首个大规模开源日志,也为后续在智能体训练与系统设计中显式建模 “会不会搜” 提供了可复现的数据基础与可量化的行为信号。

近年来,大型语言模型驱动的 Agentic Search 与 Deep Research 逐渐成为信息获取的重要形态,即系统不再只返回一页文件结果,而是通过智能体自动发起多轮检索、阅读文档、改写问题,再生成综合回答。

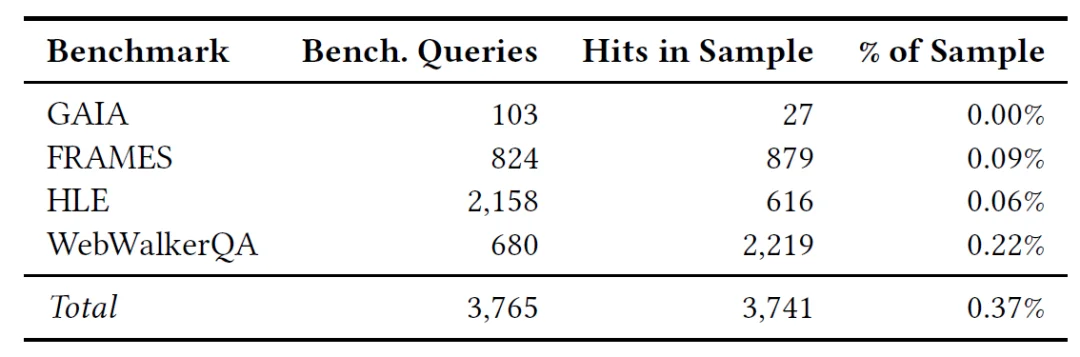

与之相对应,已有研究提出了多种基准任务和评测框架,用于衡量系统在问答、推理、工具调用等方面的性能。然而,这些评测大多基于构造好的题目和离散样本,缺乏对真实环境中智能体检索行为的系统观察与结构化分析:

这篇 Agentic Search in the Wild: Intents and Trajectory Dynamics from 14M+ Real Search Requests 论文针对上述缺口,基于 DeepResearchGym(DRGym)平台提出了两方面贡献:

1. 从半年真实流量中整理出 超过 1400 万条 Agentic Search 请求、约 400 万个搜索会话,在严格匿名化与清洗之后,发布为 首个开源的 Agentic Search 行为日志数据集。

2. 在此基础上,从 任务意图(intent) 与检索轨迹(trajectory)两个维度,系统分析智能体的搜索过程,并提出一个衡量 “是否利用检索到信息” 的指标 CTAR(Context-driven Term Adoption Rate)。

DRGym 是该团队搭建的一个面向研究用途的可重复检索平台(https://www.deepresearchgym.ai/),对外提供统一的 /search API,后端基于密集检索,挂载在固定的 Web 语料快照上,例如 ClueWeb22、FineWeb 等。不同智能体可以以任意策略调用该接口,但所有请求都运行在统一的检索基础设施之上。

日志中的每条记录包含如下信息:

论文选取约半年时间窗口,得到来自横跨 25 个国家,近 600 个 IP 地址,超过 1400 万条请求日志,约 400 万个会话(session)。

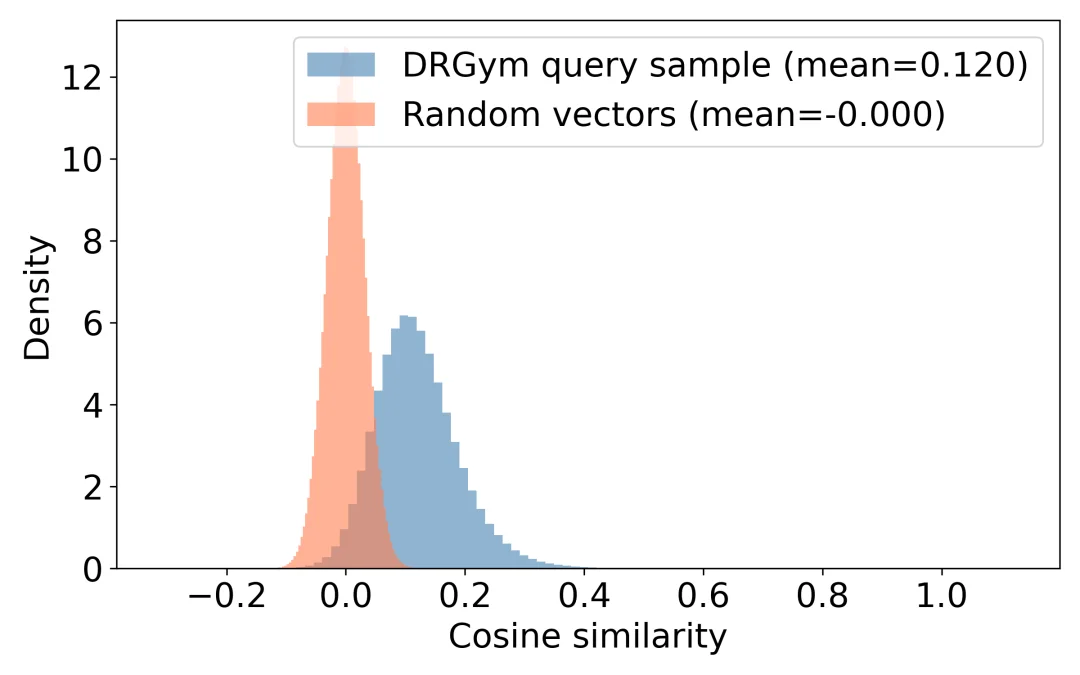

这为验证日志是否具有广泛多元使用的多样性,而非某些基准题目的重复回放训练,作者从两方面进行了检查:

隐私方面,日志经过了字段裁剪与匿名化处理:去除直接可识别信息,对自由文本进行 PII 清理,并重新生成会话级别的匿名 ID,最终在 Hugging Face 上公开。

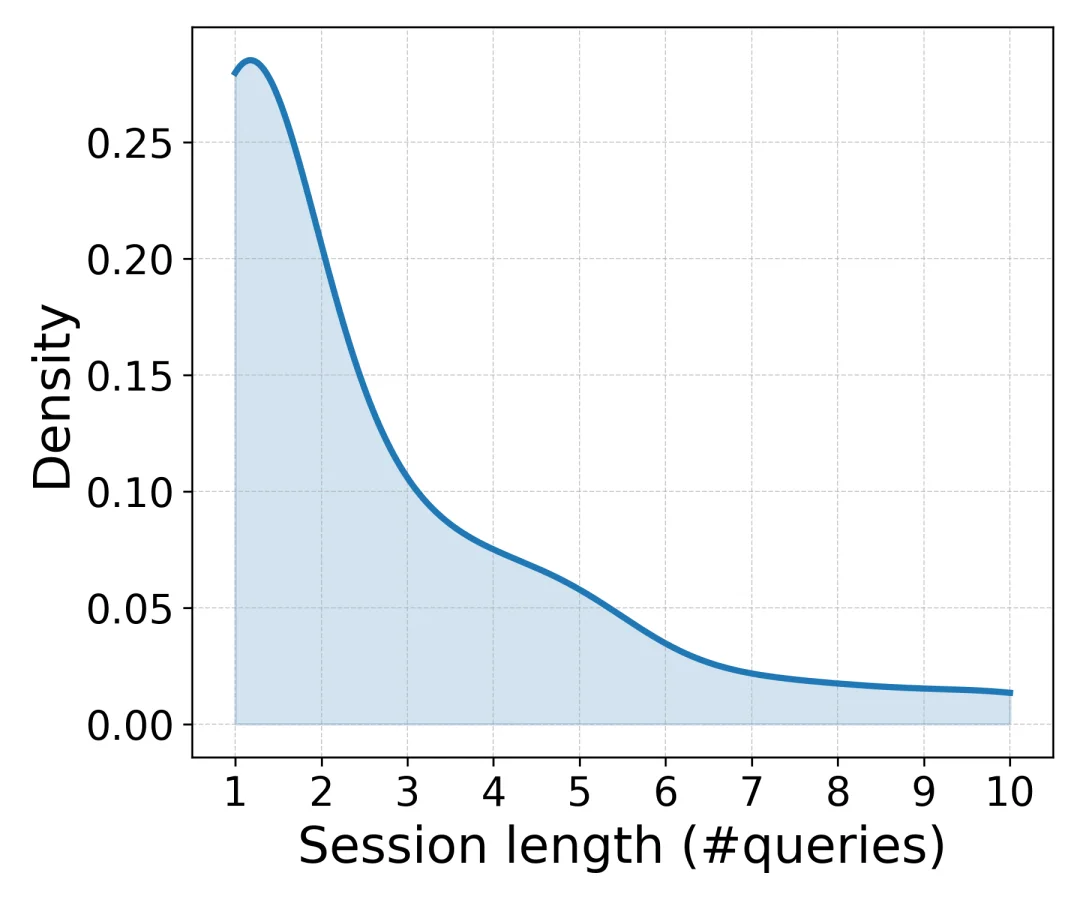

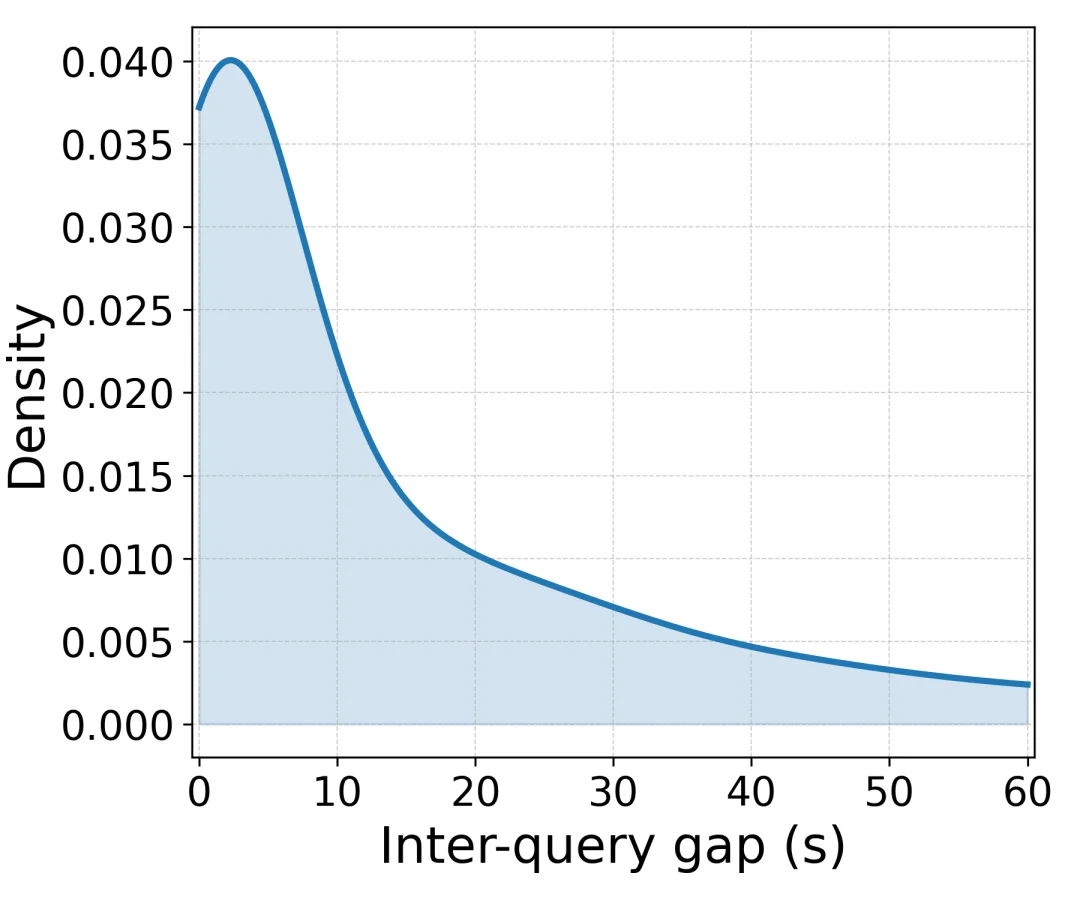

原始日志是时间顺序的请求流,要分析行为模式,需要先划分搜索会话。与传统人类 Web 日志不同,智能体请求往往高频且可并发,仅依赖固定时间阈值(例如 “间隔超过 30 分钟”)容易误分。

该工作采用了 语义 + 时间联合的 Sessionization 策略:

1. 首先,基于一批相邻请求样本,通过 LLM 标注 “是否属于同一会话”,构建连续性标签;

2. 其次,使用查询的向量表示训练一个连续性判别模型,预测两条查询之间是否应归为同一 session;

3. 在线划分时,对同一匿名 IP 下的新查询,与当前所有活跃会话的末尾查询计算连续性分数,在分数与时间差均满足条件时并入对应会话,否则开启新会话。

这一策略最终得到约 400 万个 session。整体分布上:

在会话划分的基础上,论文从两层视角刻画 agentic search 过程:

4.1 三类 Session Intent

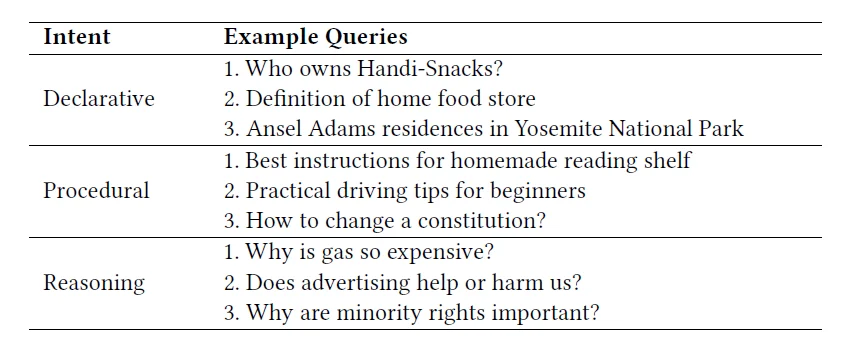

作者沿用经典的 Web Search 目标分类,对多轮会话进行三类划分:

1. Declarative:陈述型 / 事实与知识检索

2. Procedural:过程型 / 操作与步骤检索

3. Reasoning:推理型 / 分析与比较检索

标注方式为,将一个 session 内全部查询串联,交由 LLM 进行意图分类,并在样本上用另一模型交叉验证,标签可靠性较高。

统计结果表明,日志中以陈述型任务为主,其次是推理型任务,过程型任务比例相对较小。不同意图下,会话长度与检索配置表现出明显差异,例如过程型任务更倾向一次性拉取更多文档,而推理型任务的查询文本往往更长、前后变化幅度更大。

不通过目标分类下的Query 样例

4.2 四类 Trajectory Move

在单个会话内部,相邻两条查询之间的变化被划分为四种改写动作:

1. Specialization(专化):增加约束,下钻到更具体的条件或子范围;

2. Generalization(泛化):去除约束,将查询放宽到更一般的描述;

3. Exploration(探索):在同一主题下转向新的侧面或子问题,例如从 “定位” 转向 “属性信息”;

4. Repetition(重复):语义基本不变的轻微改写或直接重试,例如改写语序、替换同义表达。

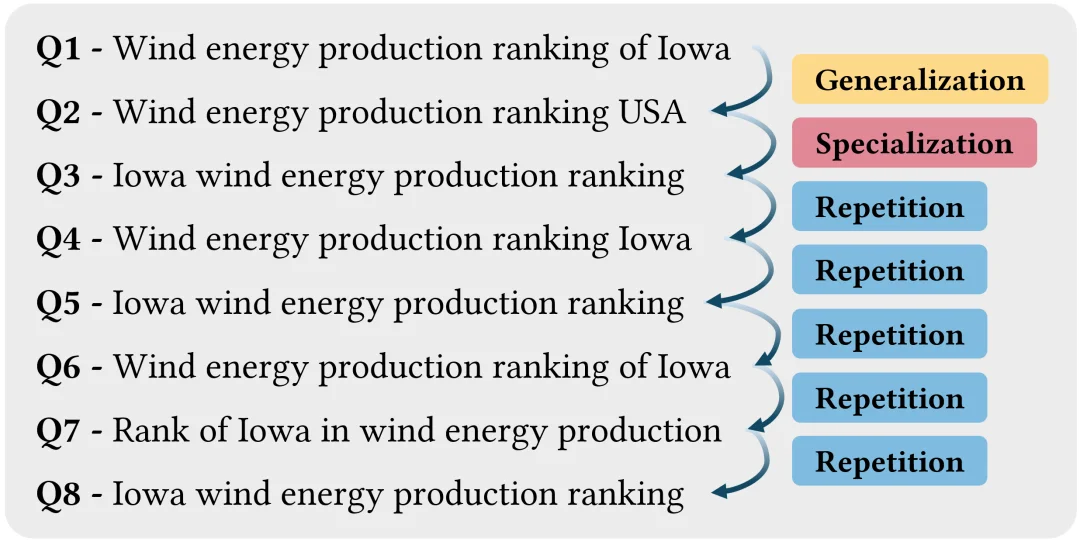

类似的这些标签基于 LLM 对查询对的判别结果获得,并结合向量相似度和检索结果重叠进行验证。整体来看,智能体呈现出明显的 “下钻偏好”(Drill-down Bias):专化与探索使用频率较高,泛化相对稀少,而在许多事实型会话的后期,重复动作显著增多,形成 “重试循环”。

案例1:事实型会话的后期形成“重试循环”

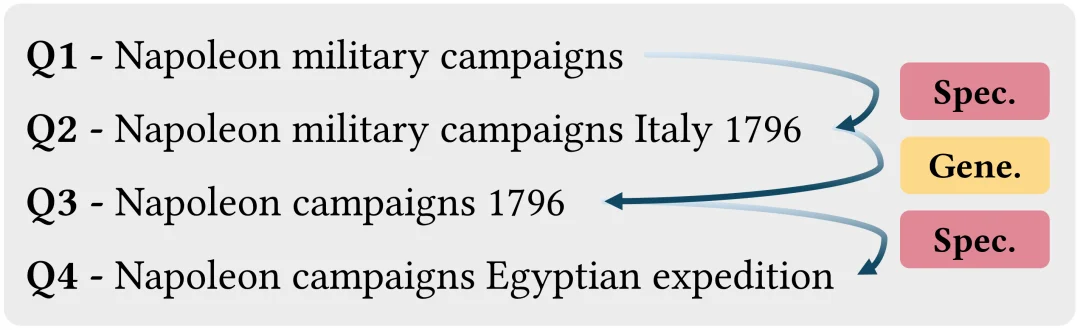

另一方面,智能体也表现出一定的 “重置 - 再细化”(Reset-then-Refine)模式,如下图可见,智能体先在一个宽泛主题上做专化(例如从 “拿破仑战役” 收窄到 “1796 年意大利战役”),随后通过去掉这些约束做一次泛化(得到更短、更宽泛的查询),再沿着另一个侧面重新专化(切换到 “埃及远征” 等新的细化方向)。

从查询长度的变化也能看出这一点,即专化通常会拉长查询,而泛化则会缩短查询。整体上,泛化在这里更像是一种轻量级回溯,用来在不同细化分支之间切换,而不是持续性地将查询维持在宽泛层级。

案例2:“重置-再细化”的步骤循环

在多轮检索中,关键问题之一是:新的查询在多大程度上受到了既有检索信息的影响。由于日志中没有点击、停留时间等显性交互信号,论文提出了一个简单的间接度量:CTAR(Context-driven Term Adoption Rate)。

计算方法概括如下:

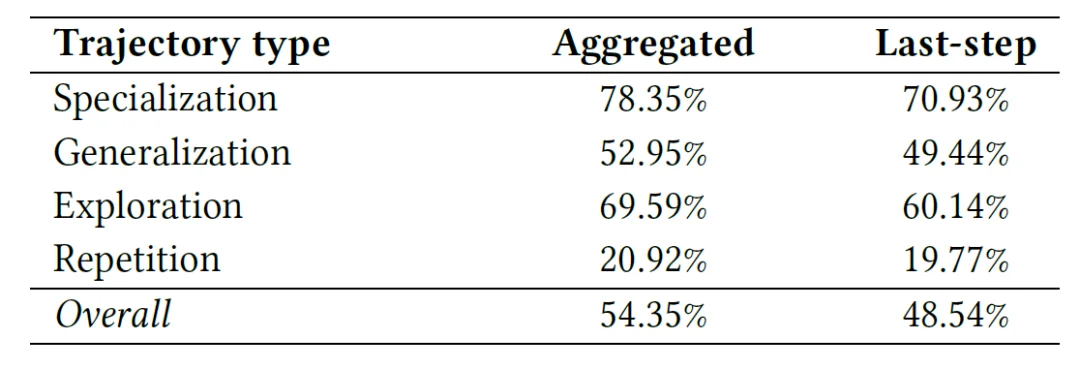

这个指标带来的核心发现包括:

1. 整体 CTAR 超过一半

大约一半以上的新词可以在之前检索到的文档中找到。这表明,在相当多的步骤中,智能体并非完全凭空提出新的条件,而是从已有获取信息中采纳术语和约束。

2. 不同 Trajectory Move 的 CTAR 存在显著差异

专化和探索动作的 CTAR 明显高于平均水平,说明这两类改写更依赖已有文档信息;重复动作的 CTAR 则较低,通常对应表述上的微调或重试,而非基于新信息的策略调整。

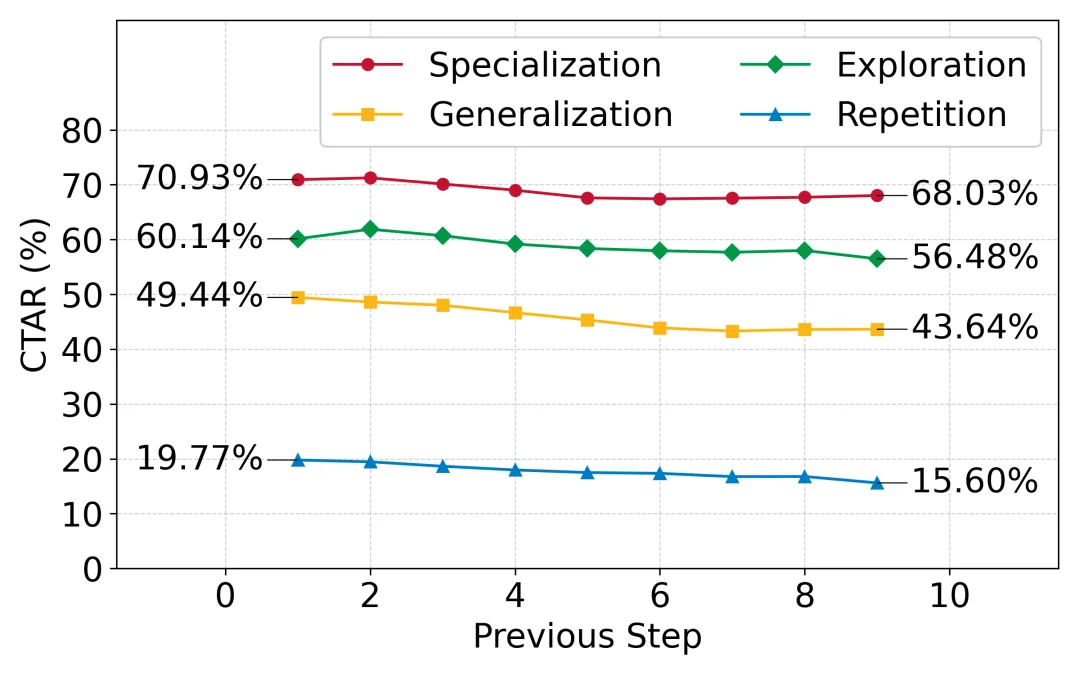

3. 历史上下文具有额外贡献

只看上一轮检索结果时,CTAR 较低;将更早步骤的文档一并纳入后,CTAR 稳定提升,说明部分新词来源于更早的检索信息,智能体在一定程度上会 “回溯” 历史上下文。

需要强调的是,CTAR 仅刻画 “新词在检索信息中的可追溯性”,并不直接等价于因果利用;但由于定义简单且易于解释,适合作为衡量 “是否参考检索上下文” 的粗粒度指标。

基于上述行为分析与 CTAR 指标,论文在结尾讨论了若干与系统设计直接相关的启示:

1. 重复动作可视为潜在 “停滞信号”

在大量陈述型会话中,随着 Agent 步骤推进,重复改写的占比明显提高,其检索结果高度重叠且 CTAR 较低。这种模式可以视为系统进入 “原地重试” 的信号。在工程上,可以基于重复率、结果重叠度和 CTAR 等联合特征,检测并中断重试循环,强制触发泛化或探索策略,或切换到更高配置的工具链。

2. 检索预算应随任务意图与轨迹自适应调整

日志表明,现有许多智能体将检索深度 K 写死为有限几个固定值,在同一会话内几乎不做调整。然而,不同意图和轨迹状态对检索策略的需求显然不同,即过程型任务更依赖一次性较宽的文档覆盖,推理型任务则往往更需要多轮细化与验证。因此,更合理的设计是,先对会话意图进行识别,再结合当前轨迹(如是否处于探索阶段、是否陷入重试)动态调整 top-K、上下文长度与工具组合,而非采用全局统一配置。

3. 将 CTAR 等 “信息采纳率” 指标纳入系统监控

CTAR 在不同改写类型之间具有明显区分度,在专化和探索步骤中,CTAR 高时往往对应基于检索信息的实质推进,而重复步骤中 CTAR 较低则更可能反映策略停滞。

因此,可以将 CTAR 一类指标纳入系统的观测与调度逻辑:当长时间观测到 CTAR 偏低或在特定模式下急剧下降时,触发算法层或工作流层面的干预与重规划。

整体来看,这篇工作完成了三件具有基础设施意义的事情:

1. 提供首个开源的 Agentic Search 行为日志数据集

基于 DRGym 平台采集并清洗的 1400 万 + 请求、约 400 万会话,在经过匿名化处理后,在 Hugging Face 平台公开,为后续研究提供了可复现的行为数据基础。

2. 提出面向 Agentic Search 的 “意图–轨迹–信息利用” 分析框架

通过三类 Session Intent、四类 Trajectory Move 以及 CTAR 指标,从结构和内容两个维度刻画智能体搜索过程,为后续的行为建模、策略比较和训练目标设计提供了分析工具。

3. 将若干经验性观察固化为可量化的设计建议

具体包括,将重复改写视作停滞信号、依据任务意图与轨迹模式自适应检索预算,以及通过检索信息采纳率监控智能体是否真正 “读取并利用” 检索结果。

对于从事信息检索与智能体系统研究的读者,这份数据与框架为理解和改进 agentic search 提供了新的切入点;对于工程实践者,则可以据此审视现有系统的行为模式,并据实引入新的监控和控制机制。

作者简介:

本论文第一作者为卡内基梅隆大学计算机学院语言技术研究所硕士研究生 Jingjie Ning,研究方向聚焦信息检索、DeepResearch、Query 理解与强化、推荐系统 Benchmark 等工作。Jingjie Ning 师从 Jamie Callan 教授及 Chenyan Xiong 教授。在卡内基梅隆大学前,Jingjie 曾在腾讯任职 Senior Data Scientist。个人主页:https://ethanning.github.io

文章来自于“机器之心”,作者 “机器之心”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner