OpenAI大模型加持的机器人Figure 01,昨天火爆了全网。

而今天,真正「开源版」的擎天柱/Figure 01诞生了,而且背后团队还将成本打了下来。

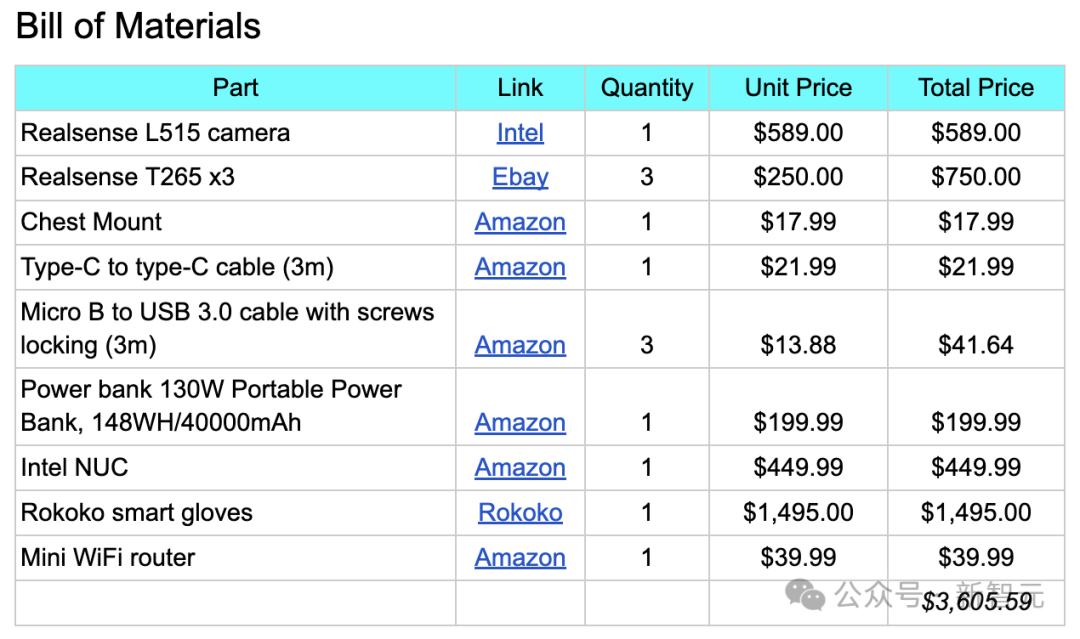

成本只要3605.59美元!

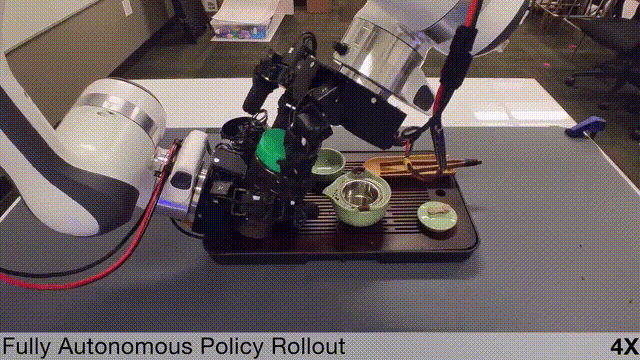

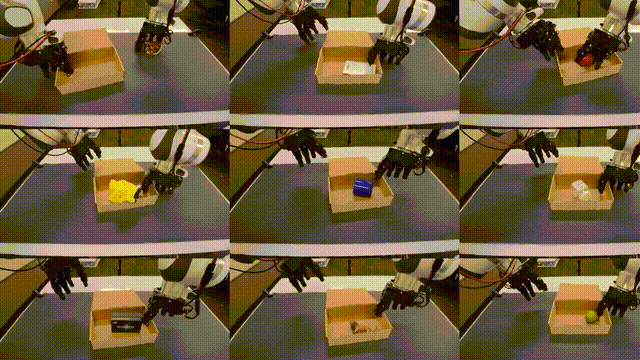

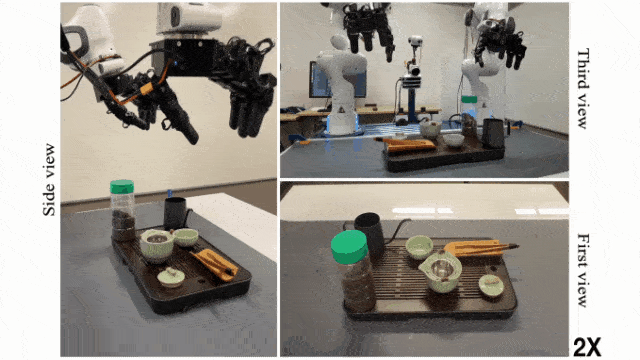

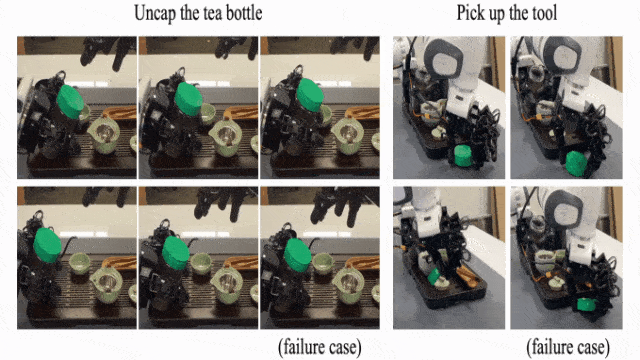

它拥有一双灵巧手,就比如泡茶,先是拧开瓶盖,再拿茶镊将茶叶挑进杯中,并放回原位。

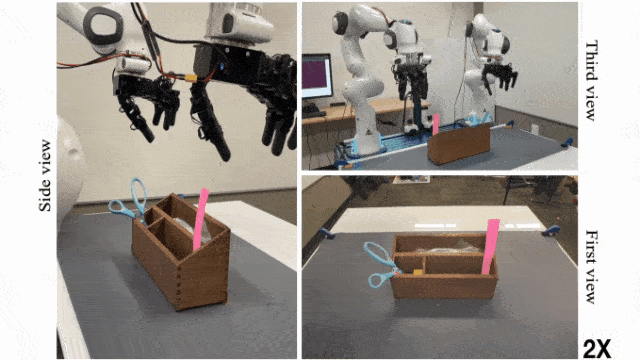

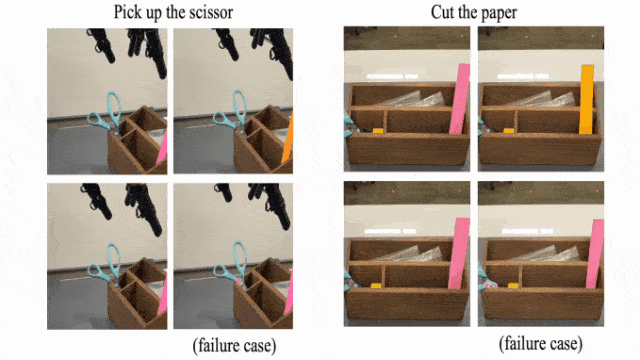

快看,它能一手拿着剪刀,一手拿着便利签纸,执行人类剪纸这一动作。(不过剪断的这个过程好难)

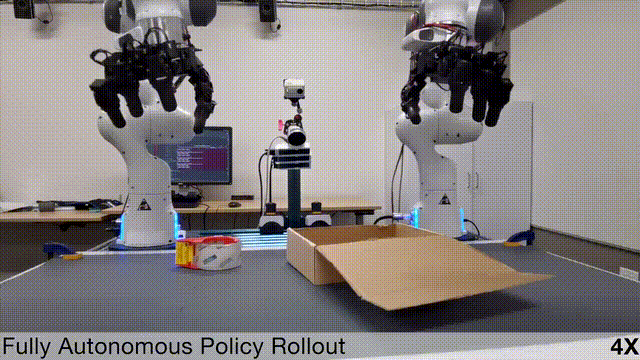

它还可以将胶带纸,放到收纳的纸盒中,一手拿胶带摆放,一手将盒子推近。

而且不管这个物体是什么,它都能照样完成。

与前段时间爆火的炒虾机器人不同的是,「灵巧手」并非通过远程操控完成任务。

是因为,凭借一副特制的手套,它可以通过各种传感器捕捉到手部精确的运动数据。

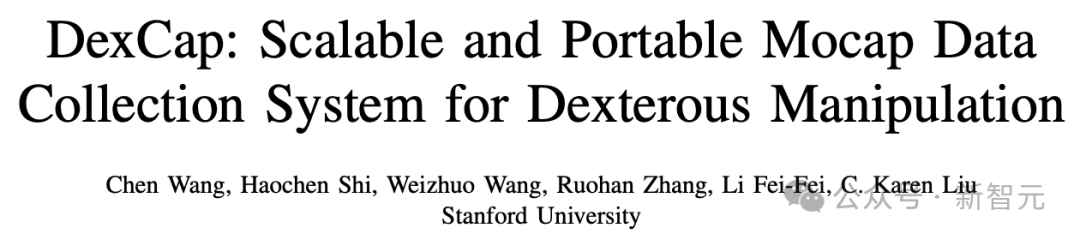

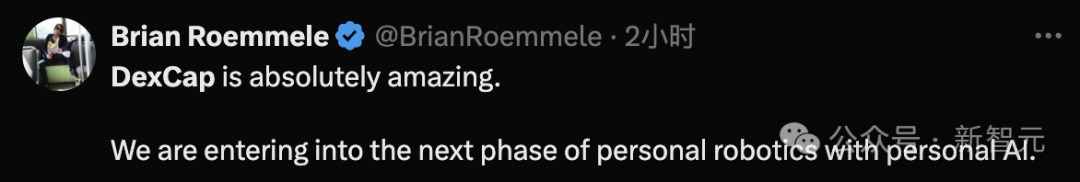

这正是由Chen Wang、李飞飞和Karen Liu等人提出的「便携式手部动作捕捉系统」——DexCap。

论文地址:https://arxiv.org/abs/2403.07788

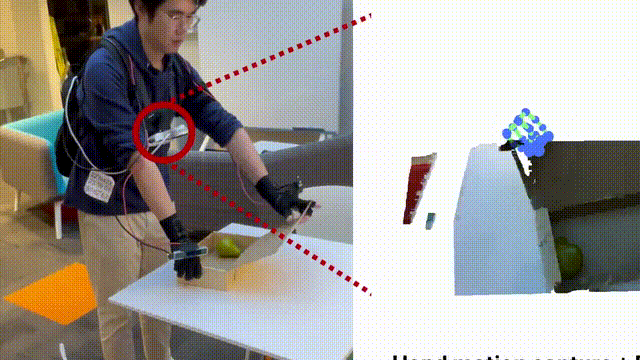

DexCap是一套基于SLAM、电磁场,以及对环境的3D观察,便能实时追踪手腕和手指运动的系统。

与传统基于视觉动捕技术不同,它不会因为视线遮挡,而无法收集数据。

与此同时,他们还设计了全新的模仿算法DEXIL,才用了逆运动学和基于点云的模仿学习。

当手部动作数据收集完成,DexCap就会利用背包中的迷你PC,通过RGB-D相机重建3D场景。

然后将运动数据与之对齐,这样,就可以得到非常精确的手部动作模型,可用于进一步的机器人训练。

值得一提的是,在对具体6项操作任务评估中,DexCap展现出卓越的完成能力。

而且,它还可以从野外动捕数据中有效学习,为未来灵巧操作的数据收集方法提供了方法。

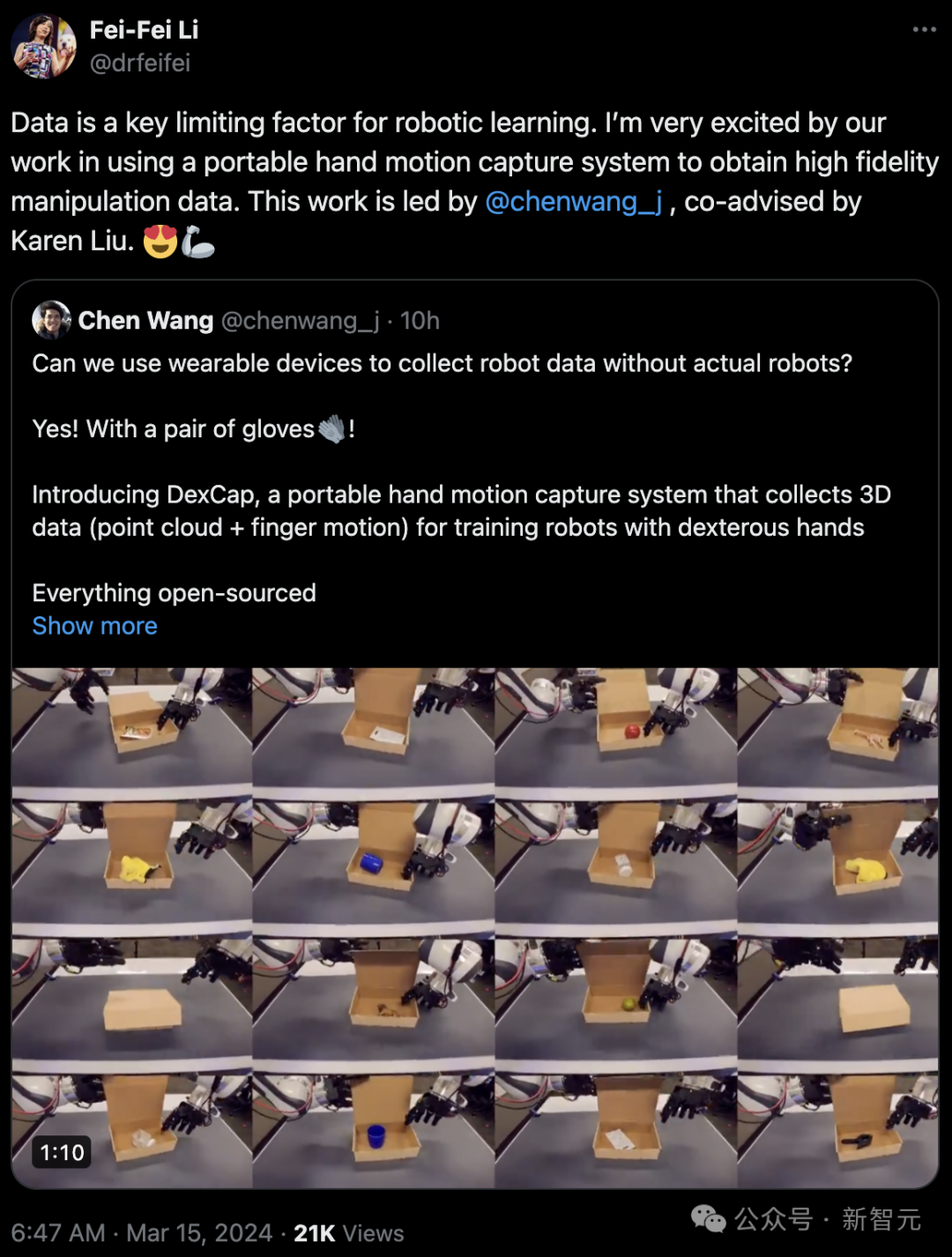

Jim Fan认为DexCap是「低配版的Optimus」,关键只要3600美元,一般人也能买得起。

另外,他还特意强调,数据收集和机器人的执行是分离的。

还有网友称,「DexCap绝对震撼,我们正在进入个人机器人与个人AI的下一阶段」。

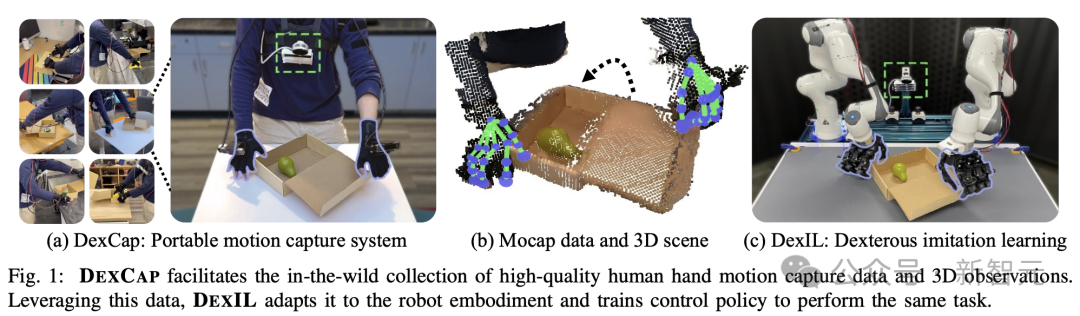

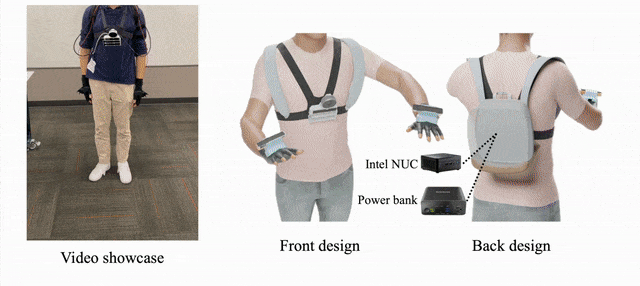

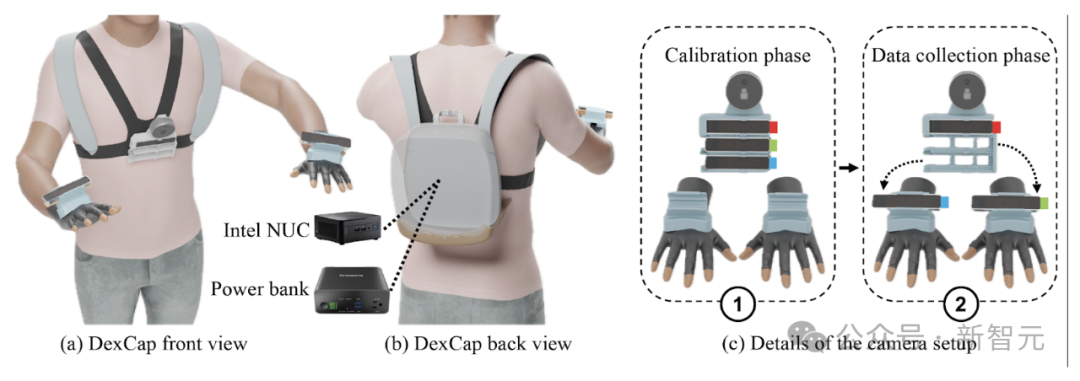

DexCap系统核心设计,就在于前向后向设备的组合。

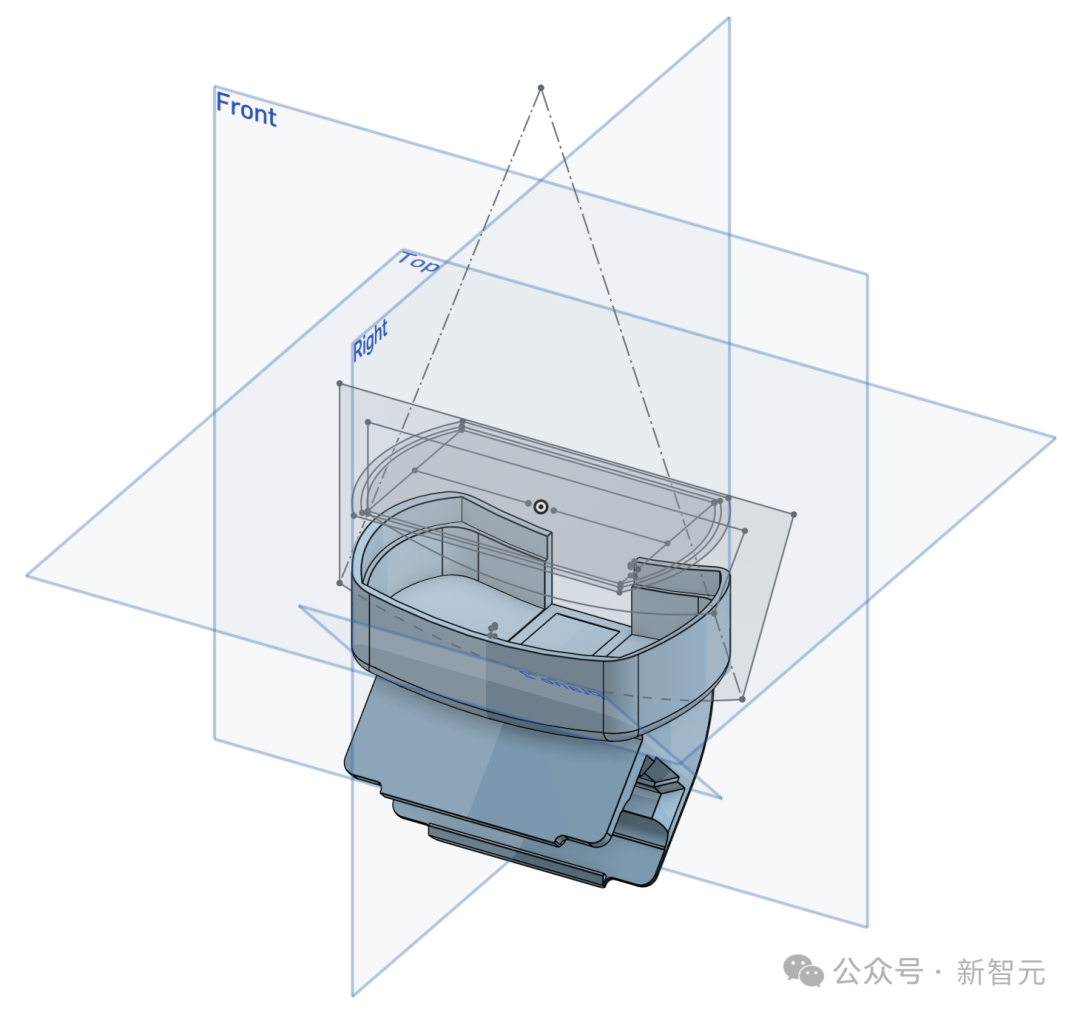

具体来说,正面设计的胸部相机架上,配备了一个RGB-D激光雷达摄像头和三个SLAM追踪摄像头。

背面的背包中,有一个迷你PC,以及电源为系统供电。大约可进行40分钟的数据收集。

此外,还需要一个动捕手套,以便进行手部动作的捕捉。

追踪摄像头最初放置在胸前机架上,进行校准。

然后在具体数据收集过程中,将摄像头从校准架上取下,安装到特制的手部支架上。

这样,系统就可以持续追踪手部的位置。

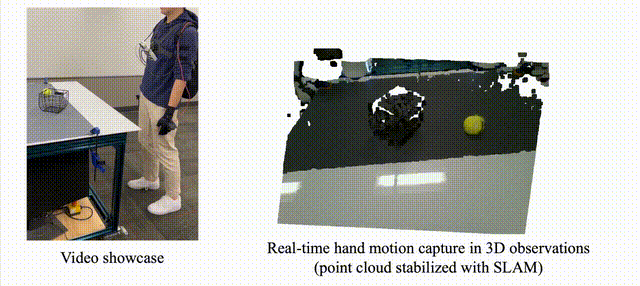

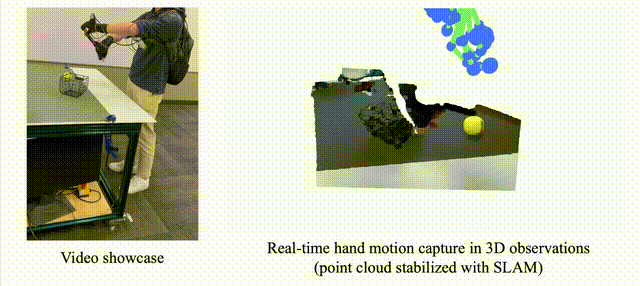

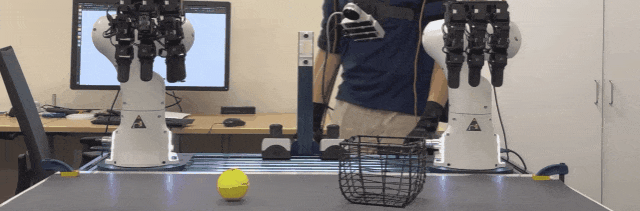

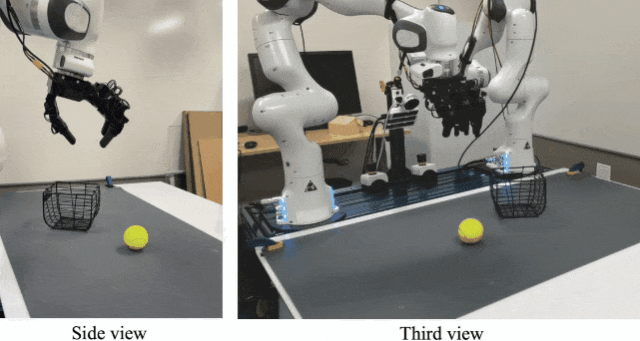

可以看到,网球被放进框里,再倒出来,整个动作都清晰可见。

机器人更多的训练数据,这不就来了么。

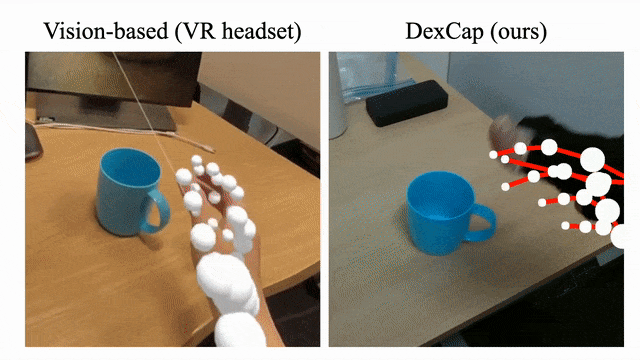

数据可视化:点云观测中的3D手部运捕数据

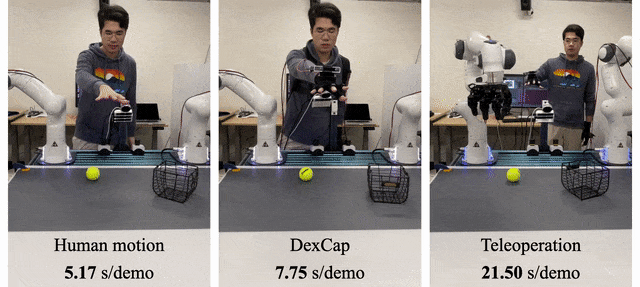

再来看数据采集吞吐量,DexCap可以实现与人类自然运动同水平的效果,而且是远程操作的3倍。

再看如下用固定的手势握住杯子手柄的动作。

VR头显使用了基于视觉的手部追踪方法,却因严重遮挡而无法准确追踪手部动作。

显然,DexCap无障碍收集了手与物体交互的数据。

研究人员的目标是利用DC记录的人手动作捕捉数据,来训练灵巧机器人策略,这个过程中会面临3个问题:

(1)如何将人手的运动重新定位到机器人手?

(2)什么算法可以学习灵巧的策略,而且要适应双手动作的高维空间?

(3)研究直接从人类动捕数据中学习的失败案例以及潜在的解决方案。

为了应对这些挑战,研究人员引入了DexIL,一个使用人手动作捕捉数据训练灵巧机器人的三步框架。

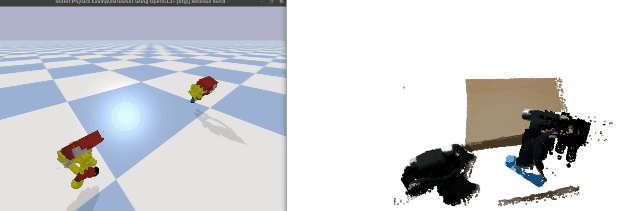

第一步,将DEXCAP数据重新定位到机器人实施例的动作和观察空间。

第二步,使用重新定位的数据训练基于点云的扩散策略。

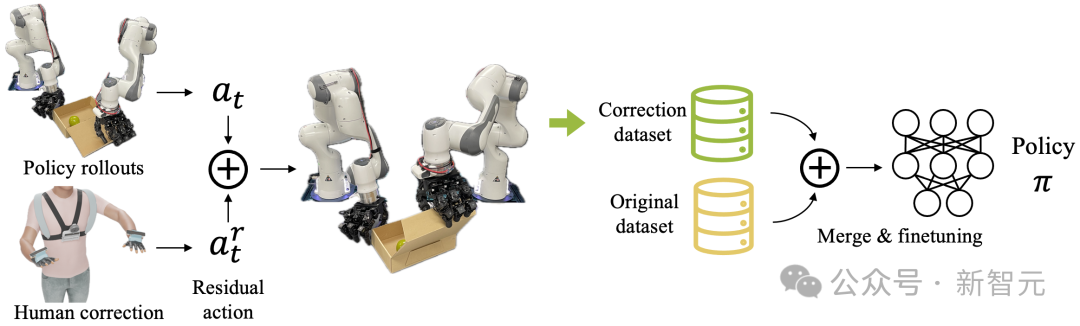

最后一步,可以采用人机交互来进行校正,旨在解决策略执行期间出现的意外行为。

动作重定向:

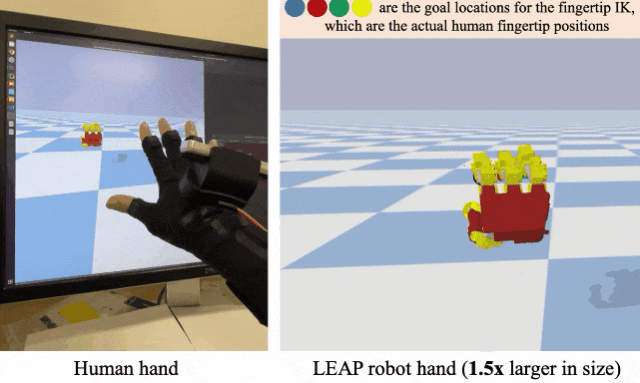

LEAP手比人手大了约50%,这种尺寸差异使得很难将手指运动直接转移到机器人硬件上。

为了解决这个问题,研究人员使用指尖逆向运动学(IK)来计算16维关节位置,并使用动捕手套跟踪人体手指的运动,手套根据电磁场(EMF)测量手指相对于手掌的3D位置。

视觉差距:

观察和状态表示选择对于训练机器人策略至关重要。为了进一步弥合人手和机器人手之间的视觉差距,研究人员使用正向运动学生成机器人手的点云网格,并将其添加到点云观察中。

使用相机参数将DCdata中LiDAR相机捕获的RGB-D图像转换为点云。这种额外的转换提供了两个显著的好处。

首先,由于DEXCAP允许人体躯干在数据采集过程中自然移动,因此直接使用RGB-D输入需要考虑移动的相机帧。

而通过将点云观测转换为一致的世界坐标系,可以隔离并消除躯干运动,从而实现稳定的机器人观察。

其次,点云提供了与机器人操作空间对齐的灵活性。由于在野外捕获的一些运动可能超出了机器人的运动范围,所以需要调整点云观测和运动轨迹的位置来确保操作范围的可行性。

观察重定向:

为了简化在人和机器人之间切换相机系统的过程,相机机架的背面集成了一个快速释放带扣,可以在不到20秒的时间内快速更换相机。

通过这种方式,保证机器人可以使用人类收集数据时的同一台相机。

通过上述设计,DexIL可以直接从DCdata学习复杂的灵巧操作技能(比如拾取、放置、双手协调等),而无需机器人数据。

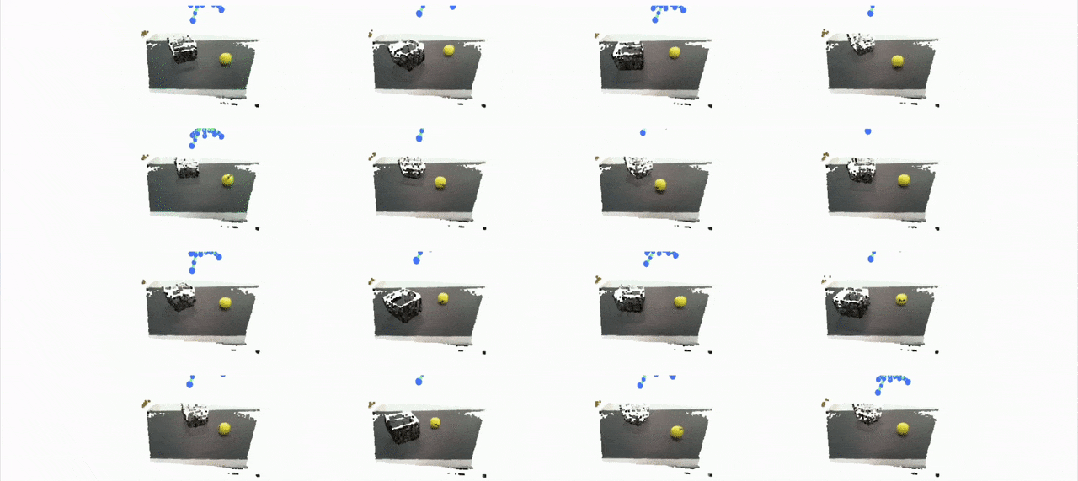

根据上面的分析,首先通过RGB-D观测构建3D点云,并转换到机器人的操作空间,将DexCap数据重定位到机器人实例中。

同时,手部动作捕捉数据也要重定位到带有指尖IK的机械臂。

基于这些数据,学习扩散策略,将点云作为输入,并输出一系列未来目标位置作为机器人动作。

上图展示了DC以3D形式捕捉详细手部运动的能力,将人类动作与所有视图中的对象点云对齐。

黄色列表示重定位后的机器人手部动作,我们可以看到它们与蓝色列在同一3D空间中精确对齐。

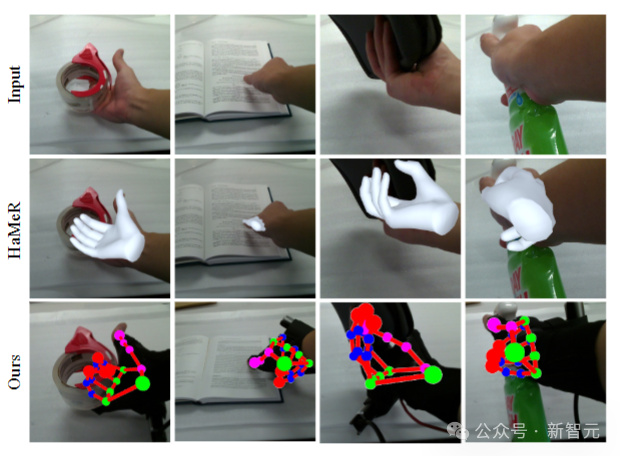

上图中,将DC与最先进的基于视觉的手部姿态估计方法HaMeR进行了比较,从相似的角度观察它们的性能。

HaMeR在严重遮挡的情况下表现不佳,要么无法检测到手,要么无法准确估计指尖位置。相比之下,DC在这些条件下表现出良好的鲁棒性。

结果演示:

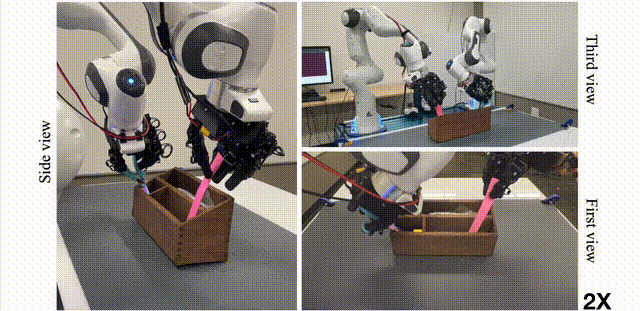

下图的捡球任务,只使用30分钟的人类动作捕捉数据来学习策略,无需任何远程操作。

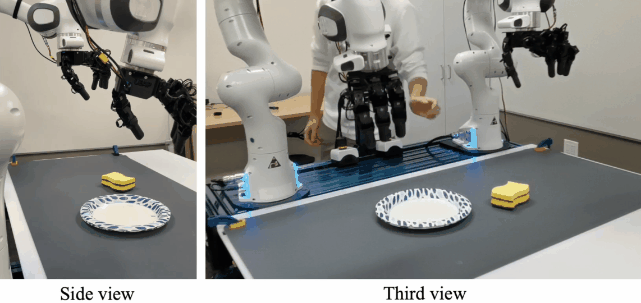

双手操作任务:

先收集双手的人体动捕数据,然后进行完全自主的策略部署。

DexCap系统在执行任务时提供了两种便捷的人在回路纠正,让用户能够根据需要灵活调整机器人的动作:

1. 残差纠正模式:

系统会实时捕捉用户手腕的微小位移变化,并将这些变化作为额外的动作指令加入到机器人的动作中,从而实现精细控制。这种模式可以实现最小的运动,但需要用户进行更精确地控制。

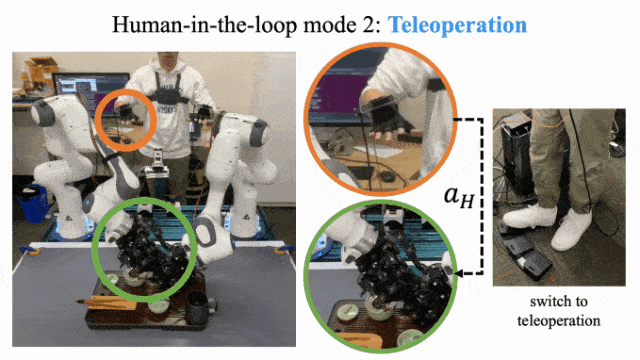

2. 遥控操作模式:

通过逆向运动学算法,用户的手部动作会被转化为机器人末端执行器的相应动作,适用于需要全面控制机器人的场景,但相对而言需要用户付出更多的努力。用户可以通过简单地踩下脚踏板来在这两种模式之间自由切换。

最后,这些纠正动作会被记录并保存在一个新的数据集中,并与原始训练数据一起进行均匀采样,从而更好地调整机器人的行为策略。

微调后:泡茶

通过分析1小时人类动捕数据并进行30次人在回路纠正后学到的策略:

通过分析1小时人类动捕数据并进行30次人在回路纠正后学到的策略:

硬件教程

地址:https://docs.google.com/document/d/1ANxSA_PctkqFf3xqAkyktgBgDWEbrFK7b1OnJe54ltw/edit#heading=h.t3oe3oo3ujny

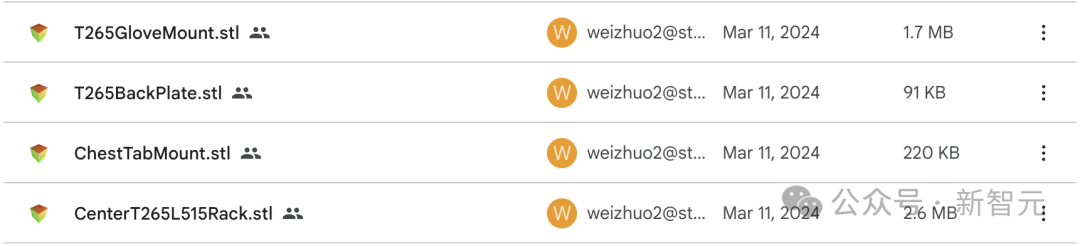

CAD 模型清单 打印项目包括:

- 中心相机架和连接板

- 两个手套相机支架(分别为左手和右手设计的镜像版本)

- 两个T265相机的后装板(同样需要左右镜像)

相关的STL文件如下:

地址:https://drive.google.com/drive/folders/1pfUISMJTJU68g6HkjKkiJAOBtRBKKByx?usp=sharing

为了确保打印出的零件能够顺畅运作,建议将滑槽部分的打印角度保持在与Z轴的倾斜角度在45度以内。

Chen Wang

论文一作Chen Wang是斯坦福大学CS的一名博士生,导师是李飞飞教授和C. Karen Liu。

在加入斯坦福大学之前,他曾在Machine Vision and Intelligence Group工作,导师是Cewu Lu教授。

参考资料:

https://dex-cap.github.io/

文章来自于微信公众号 “新智元”,作者 “新智元”

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner