“下一个短缺的将是电力。”

不久前,围绕人工智能(AI)发展,特斯拉首席执行官马斯克发出这样的预警。

他表示,人工智能计算的约束条件是可预测的,“我在一年多前就预测过芯片短缺,下一个短缺的将是电力。我认为明年将没有足够的电力来运行所有的芯片。”

此外,OpenAI首席执行官山姆·奥特曼也表示,人工智能将消耗比人们预期更多的电力,未来的发展需要能源突破。

在人工智能飞速发展的背后,能源消耗问题也日益凸显,成为业内关注的焦点。甚至有人提出,“AI的尽头是算力,而算力的尽头是电力”。

01

当下人工智能大模型的竞争,颇像一场“算力军备竞赛”。在规模效应(Scaling Law)的驱动下,各公司通过不断增加模型参数和数据量,期待实现“大力出奇迹”,相应地,算力需求也成倍增加。

所谓算力,简单来理解,就是对数据或信息的处理能力。

算力是抽象的,它的载体却实在可见,就是以数据中心、智算中心为代表的算力基础设施。算力的背后,是电力在支撑。

你可以在脑海中想象这样一幅画面——在数据中心或智算中心,成千上万台服务器和芯片整齐列阵、昼夜不停地运转。

△资料图

当下训练AI大模型使用的主流算力芯片英伟达H100芯片,一张最大功耗为700瓦,这意味着运行一小时就要耗电0.7度。而此前有消息称,OpenAI训练GPT-5,需要数万张H100芯片。

通过昼夜不息的数据中心,大家会对AI耗电有一个感性认识,而数据则更加直观。

以GPT-3的训练为例,GPT-3有1750亿个参数,据估计,训练过程使用了大约1287兆瓦时(也就是128.7万度)的电力。

该如何理解这个耗电量?这相当于美国约121个家庭一整年的用电量。也曾有专家打了这么一个比方,大概相当于3000辆特斯拉电动汽车共同开跑,每辆车跑20万英里。

GPT-3是在2020年发布的,很多人也许会问,更新的模型能耗如何呢?因为近年来不少AI科技公司不再公布训练细节,比如用了什么硬件、耗时多久,这使得能耗计算变得困难。

但GPT-3的能耗可以作为一个参考,GPT-3模型参数为1750亿,而GPT-4曾被曝包含1.8万亿参数,随着参数的翻倍,能耗也会大幅增加。

而以上的能耗还只限于训练阶段,完成训练后,AI将迎来新的耗电阶段——推理,也即人们使用AI输出结果的过程。

AI的训练是一次性事件,而使用却是长期过程,随着应用的普及、使用人数的增加,耗电量将不断叠加。

国际能源署(IEA)在今年1月的一份报告中曾表示,ChatGPT响应一个请求平均耗电2.9瓦时——相当于将一个60瓦的灯泡点亮略少于三分钟。

另外,据美媒报道,ChatGPT每天响应约2亿个需求,消耗超过50万度电力,相当于1.7万个美国家庭平均一天的用电量。

让我们做一道简单的数学题,GPT-3训练耗电约128万度,ChatGPT每天为响应需求耗电50万度,GPT-3在训练阶段消耗的电量,甚至无法支撑ChatGPT运行3天。

天长日久,耗电量可谓相当可观。

02

AI“缺电”了吗?

各种数据似乎都在说明,AI是一只“耗电巨兽”,那么下一个问题就是,它的胃口还能被满足吗?AI发展“缺电”了吗?

来让数据说话。

根据公开资料,2023年,美国全口径净发电量为41781.71亿千瓦时(1千瓦时=1度),以ChatGPT每天耗电50万度计算,按一年365天,耗电量约为18250万度,这也只占全美发电量的约0.0044%。

△资料图

AI当然不只ChatGPT,但它的耗能数据可以作为一个切口。可以看出,尽管随着AI算力的迅猛增长,电力需求也持续增长,但目前其在整体电力消耗中所占比例较小。

既然如此,科技大佬们频频呼吁关注AI能耗问题,是在“贩卖焦虑”吗?其实不然。

波士顿咨询集团曾发布报告称,到2030年底,仅美国数据中心的用电量预计就将是2022年的三倍,而这一增幅主要来自AI模型训练和更高频的AI查询。

“AI发展‘缺电’并不是现在已经出现的问题,而是未来可能面临的问题。”

中国现代国际关系研究院国际安全所所长刘冲作出这样的判断。

他表示,目前AI发展的路线是不断增加模型参数、叠加芯片,如果继续按照这个路线发展,将来消耗的电力将更多,从这个角度来讲,未来AI的能耗问题可能会越来越突出,尤其是对于电力供应本身比较紧张的国家。但就目前而言,能源还没有成为限制AI发展的因素。

工信部信息通信经济专家委员会委员刘兴亮也表示,科技大佬预言AI“缺电”,可能是想让大家重视起这个问题,这只说明,AI确实耗电,电力成本也确实很高,但是目前能源问题还没有到影响AI 发展的程度。

刘兴亮同意未来可能面临的隐忧,如果继续无节制地扩大参数规模,并且伴随着用户越来越多,而能耗技术没有进步,耗电将很快成为一个问题。但与此同时,他也作出了比较乐观的展望,认为可以通过技术进步降低能耗。

可以说,AI缺电是一个未来可能面临的问题,而在这个问题真正到来前,一系列解决思路就已经在路上。

在需求方面,AI模型的优化,芯片效率和算法效率的提升,数据中心软硬件技术的进步,都有望减少AI的能耗。

回望过去或许可以帮助我们思考未来。

一项发表于《科学》期刊的研究指出,在2010年至2018年间,全球数据中心的运算量增长了550%,存储空间增长了2400%,但耗电量仅增长6%。

而在供应方面,电力问题涉及能源、基建、政策、技术等多个方面,难以通过简单的“有”或“没有”、“充足”或“不充足”来一言以蔽之。更多样化的能源组合、电力技术革新、国家调控等都将有助于应对这个问题。

比如,国际能源署(IEA)对清洁能源能起到的作用就相当乐观,其在一份报告中指出,预计到2026年底,包括可再生能源和核能在内的低碳能源将占全球发电量的46%,并可满足所有额外需求增长,其中就包括用电需求将翻番的人工智能。

总而言之,尽管短期内还不会出现AI缺电的问题,但相关的讨论确实给大力发展AI的世界提了个醒——随着AI大模型规模和数量的高速增长,未来可能面临的能源需求激增不容忽视。

03

AI耗电的中国解法之一

目前,我国算力总规模已经位居全球第二。

据我国权威机构测算,目前,全国数据中心总耗电量占全社会的2%,电力成本占数据中心总运营成本的50%。

中国信息通信研究院数据显示,预计到2030年,数据中心能耗总量将达3800亿千瓦时左右。

AI耗电,也是我国需要应对的问题。

我国在电力方面具有优势,已建成全球规模最大的电力供应系统和清洁发电体系,其中,水电、风电、光伏、生物质发电和在建核电规模多年位居世界第一。

值得一提的是,在提升具体的AI和电力相关技术外,我国在宏观层面的一个“解题思路”,也值得关注。

让我们从最近举行的一场青海推介会说起,推介会的主题是绿色算力产业发展。

我们知道,青海有着丰富的绿色电力资源,包括光电、风电、水电等。

截至2023年底,青海省清洁能源装机超过5100万千瓦,占比92.8%,发电量占比超84.5%。

△青海省海南州千万千瓦级生态光伏发电园区

但丰富的绿电面临“用不完又送不出”的问题——绿电的不稳定性导致很多无法送出,只能在本地消耗,但本地又用不完。

AI算力需要消耗大量电力,青海的绿电又用不完,如果把数据中心搬到青海,将“绿电”变为“绿算”,将绿色“瓦特”变为绿色“比特”,岂不是双向奔赴?

在中国电信(国家)数字青海绿色大数据中心,通过风光水等清洁能源的互补,已经实现了数据中心的100%清洁能源供应。

而且,数据中心建到青海,不仅能解决电力问题,还能大大降低散热能耗。青海气候干燥、冷凉,数据中心可实现全年314天自然冷却,制冷用电比全国平均水平低40%左右。

这样得天独厚的条件,青海当然要自信推介。

在这方面,还有一位先行者,就是同样具有电力和气候优势的贵州。

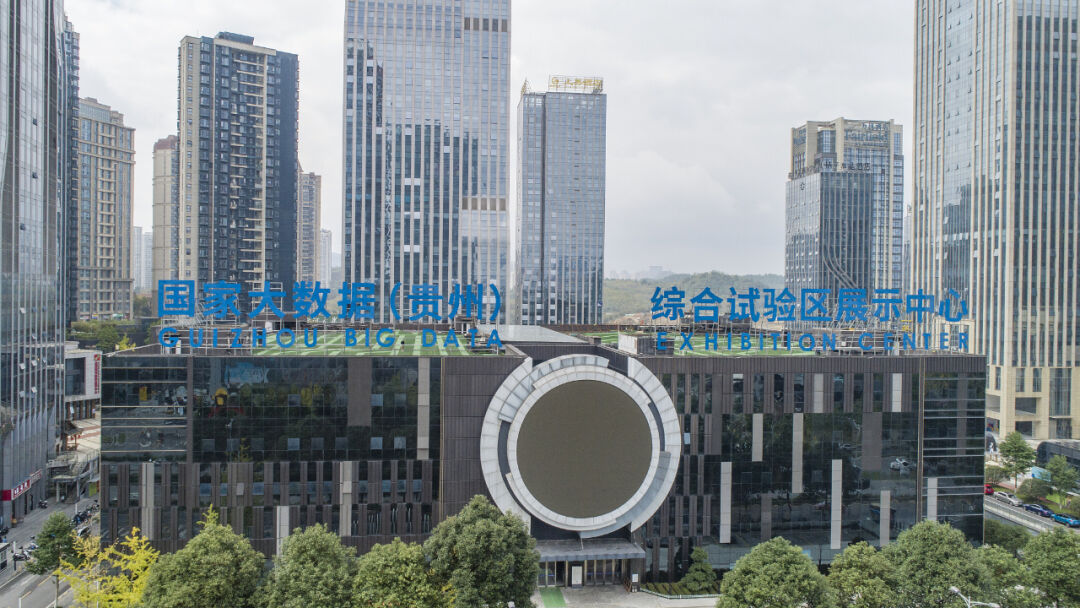

作为全球超大型数据中心集聚最多的地区之一,贵州正在人工智能的赛道上迈开步伐奔跑。

国家级人工智能训练场落户贵州贵阳;贵州省与深圳市签订算力协同发展战略合作协议;华为云计算与贵安新区合作打造全球领先的智算中心;华为云盘古、讯飞星火两个基础大模型启动在贵州产业化项目;贵州与浙江联合打造文旅宣传虚拟数字人“杭小忆”……

去年,贵州部署智算芯片达8万张,总算力规模增长28.8倍。贵州的目标是,面向东部模型训练,提供低成本、高品质、易使用的算力服务。

在贵州和青海绿色算力产业蓬勃发展的背后,是一个更为浩大的工程——“东数西算”工程。

“东数西算”工程的基本逻辑是——

受土地、水电、运维等要素影响,东部地区数据中心的运营成本较高。

而在广大西部地区,可再生能源、清洁能源、土地资源相对丰富,优越的气候条件还能降低数据中心运行能耗、减少碳排放。

因此,引导数据中心向西部资源丰富地区聚集,既能推动西部地区数据中心低碳、绿色、可持续发展,又能满足东部地区的算力需求。

早在2021年5月,相关部门就明确提出实施“东数西算”工程。

2022年2月,国家发展改革委等部门联合印发通知,同意在内蒙古、贵州、甘肃、宁夏等8地启动建设国家算力枢纽节点,并规划了10个国家数据中心集群。“东数西算”工程正式全面启动。

2023年12月,《深入实施“东数西算”工程 加快构建全国一体化算力网的实施意见》发布,首次提出“算力电力协同”。

什么是“算力电力协同”?

一方面,数据中心的高效运转离不开大量电力支撑;另一方面,电力系统的平稳高效运行也离不开算力支撑。统筹算力电力协同布局,有助于促进风光绿电消纳和数据中心零碳发展。

我们当然要看到,客观上,由于网络时延等限制存在,并非所有算力服务场景都适用“东数西算”。比如自动驾驶、证券交易等低时延业务场景就需要就近计算。

然而,人工智能模型训练推理这样高时延业务场景,正好是“东数西算”的“舒适区”,“东数西训”成为“东数西算”的典型应用场景。

近年来,人工智能带来的能耗问题引发广泛讨论,而我国早在2021年就开始布局“东数西算”,这无疑极具前瞻性,也大大助力了我国在此轮算力竞赛中占得优势。

眼下,各地人工智能方面的“东数西算”项目都在提速中。

北京首都在线与甘肃省庆阳市签订人工智能产业合作框架协议;百度智能云与成都高新区签订战略合作签约仪式,打造大模型产业……

今年以来,还涌现出了新事物——“算力券”和“算力卡”。

北京、贵州、甘肃庆阳等多地纷纷面向企业、高校、科研机构等发放“算力券”,降低使用算力的成本,来支持人工智能产业发展。

此外,有运营商已经面向普通消费者推出了“算力卡”。相关业务负责人表示,未来,算力服务也会成为像流量、宽带一样的大众化产品。

可以想见,未来,人工智能将深度融入我们的生活,能耗问题值得关注,但大可不必杞人忧天。相比于担心能源问题如何限制技术发展,思考如何用技术发展应对能源问题,是更为积极的态度。

文章来自微信公众号“新闻联播”,作者:新闻联播

【开源免费】Fay开源数字人框架是一个AI数字人项目,该项目可以帮你实现“线上线下的数字人销售员”,

“一个人机交互的数字人助理”或者是一个一个可以自主决策、主动联系管理员的智能体数字人。

项目地址:https://github.com/xszyou/Fay

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales