马斯克的第一代多模态模型Grok-1.5V,终于来了!

Grok 1.5V,号称是能连接数字世界和物理世界。

除了文本功能,它还能处理文档、图标、屏幕截图和照片之类的各种视觉信息。

很快,所有早期测试者和所有Grok用户就能用上Grok 1.5V了。

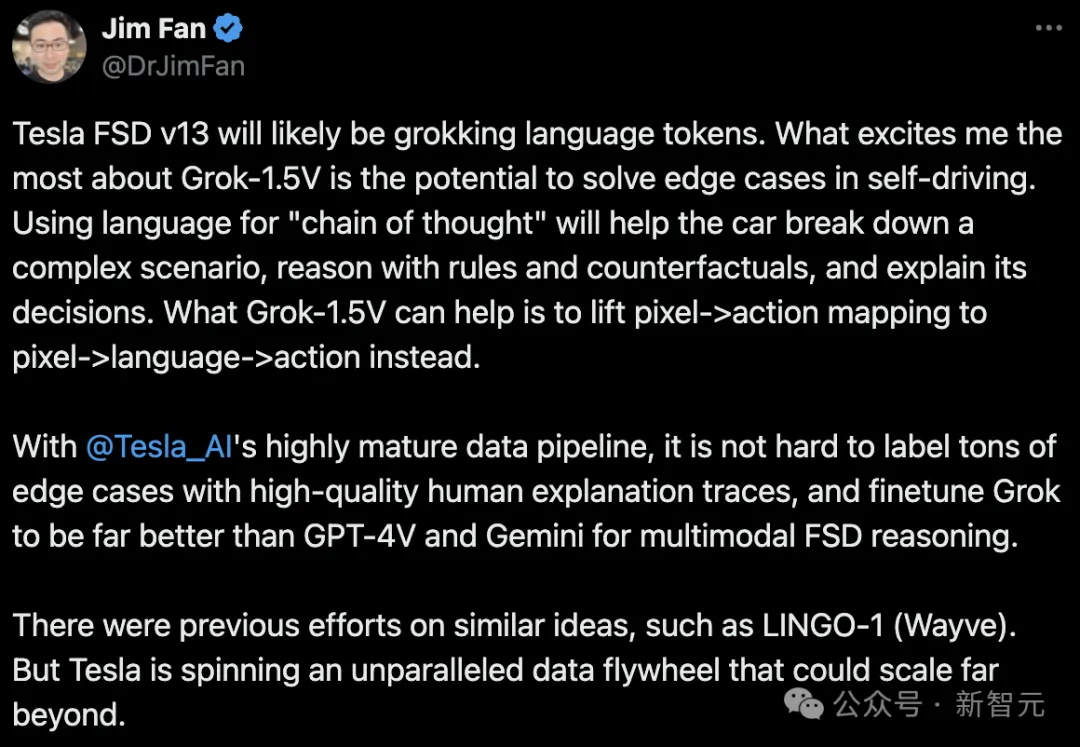

英伟达高级科学家Jim Fan发现了Grok-1.5V的「最大亮点」:在他看来,Grok-1.5V最令人感兴趣的,就是解决自动驾驶边缘案例的潜力。

如果使用语言进行「思维链」,帮助汽车分解复杂场景,用规则和反事实进行推理,解释其决策,Grok-1.5V就能将像素->动作映射提升为像素->语言->动作。

由此,特斯拉FSD V13就很有可能会理解语言Token!

特斯拉的优势是,具有高度成熟的数据管线,因此,就不难用高质量的人类解释痕迹来标记大量边缘案例,在多模态FSD推理上,微调Grok的表现就很有可能会远胜于GPT-4V和Gemini。

你可能会说,以前Wayve的LINGO-1不是也有类似的想法么?但别忘了,特斯拉正在旋转的,是一个无与伦比的数据飞轮,规模远超以前。

马斯克也适时地出现在了留言区,进一步解释道——

有两种数据源可以无限扩展,合成数据和真实世界视频。前者存在一个真伪的问题,而后者则不存在。

有网友表示,好家伙,这听起来是通往AGI最可行的路径了!具有显式语言推理的多模态模型,始终如一地推断世界模型。

在xAI的官网上,对于Grok-1.5V是这样介绍的。

它可以和GPT-4V、Claude 3 Sonnet、Claude 3 Opus等这些最顶尖的多模态模型对打。

无论是多学科推理,还是文档理解、科学图表、表格、截图和照片等多个领域,Grok-1.5V都和它们有的一拼。

尤其令人惊喜的,是它在理解物理世界时表现出的卓越能力。

在RealWorldQA基准测试中,没有思维链提示、零样本设置的情况下,用以下数据集对Grok进行评估,可以看到Grok的表现比同类模型更好。

下面7个具有代表性的例子,更说明了Grok 1.5V在不同场景中的良好表现。

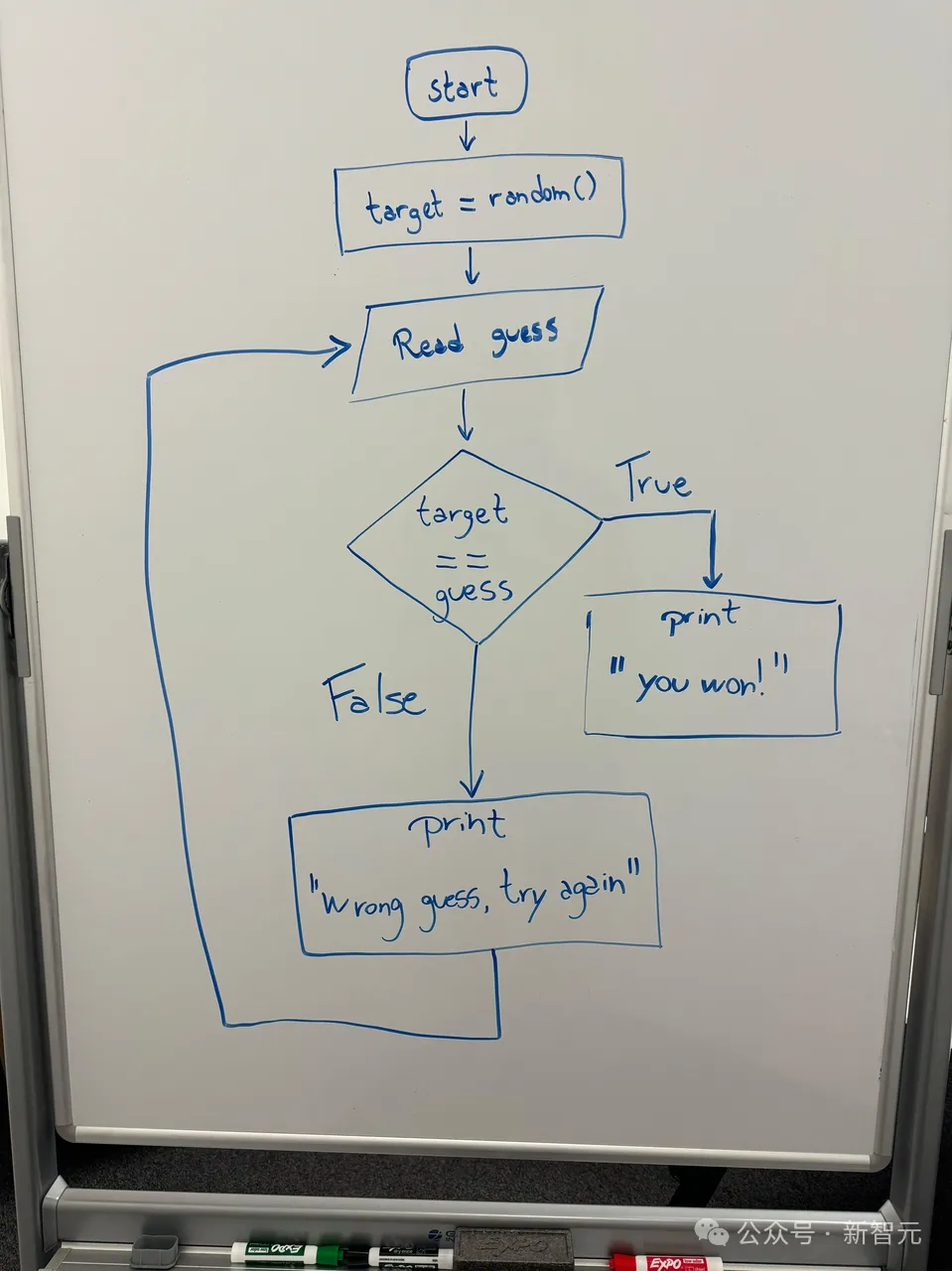

下图给出了一个简单的猜谜游戏的流程图,Grok可以根据流程图具体内容,使用python代码实现该流程。

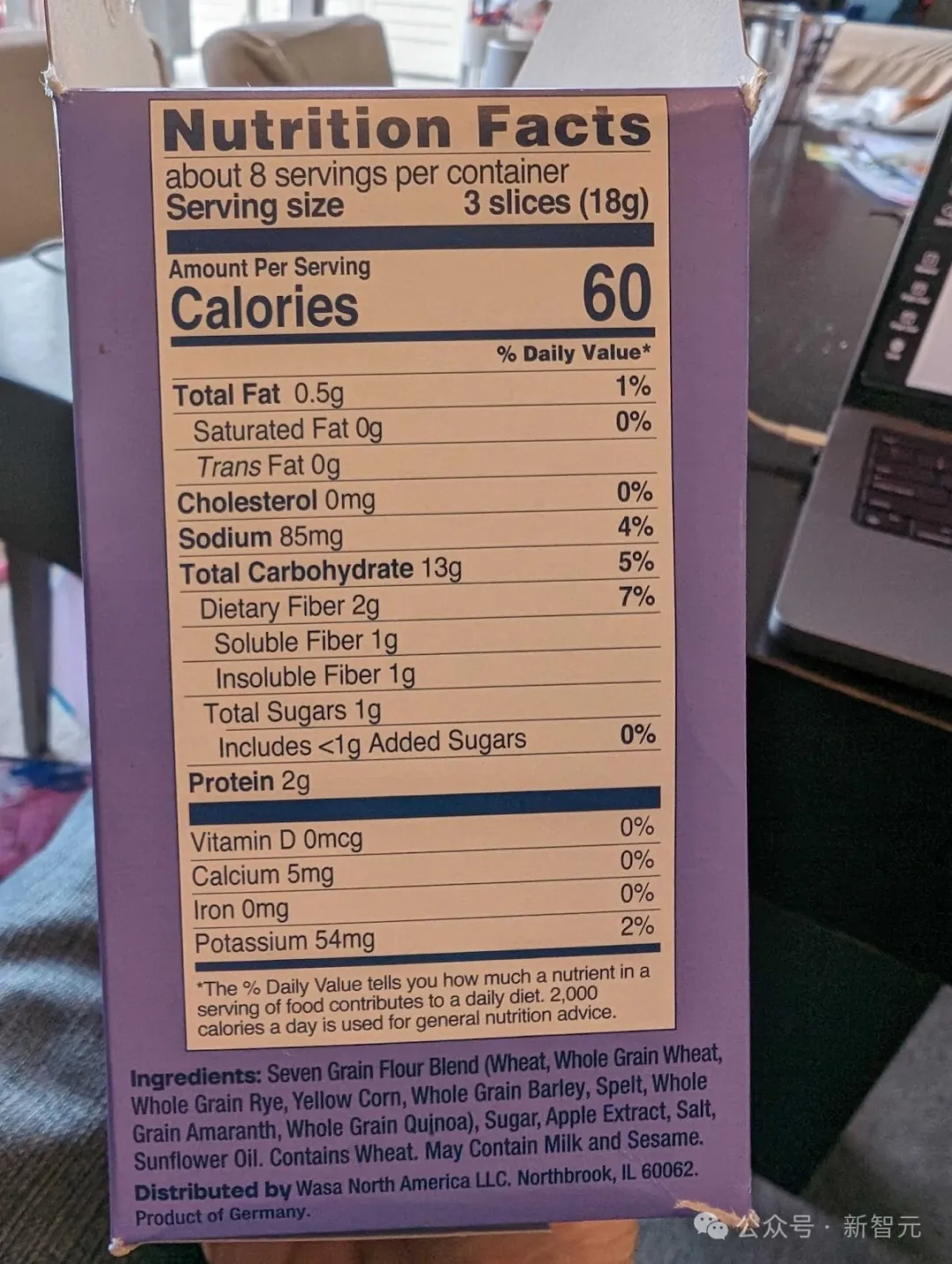

根据食品的营养配料表,Grok可以知道该食品一份份量是3片、含有60卡路里的热量,由此计算出,用户给出5片该食品的卡路里总数是100。

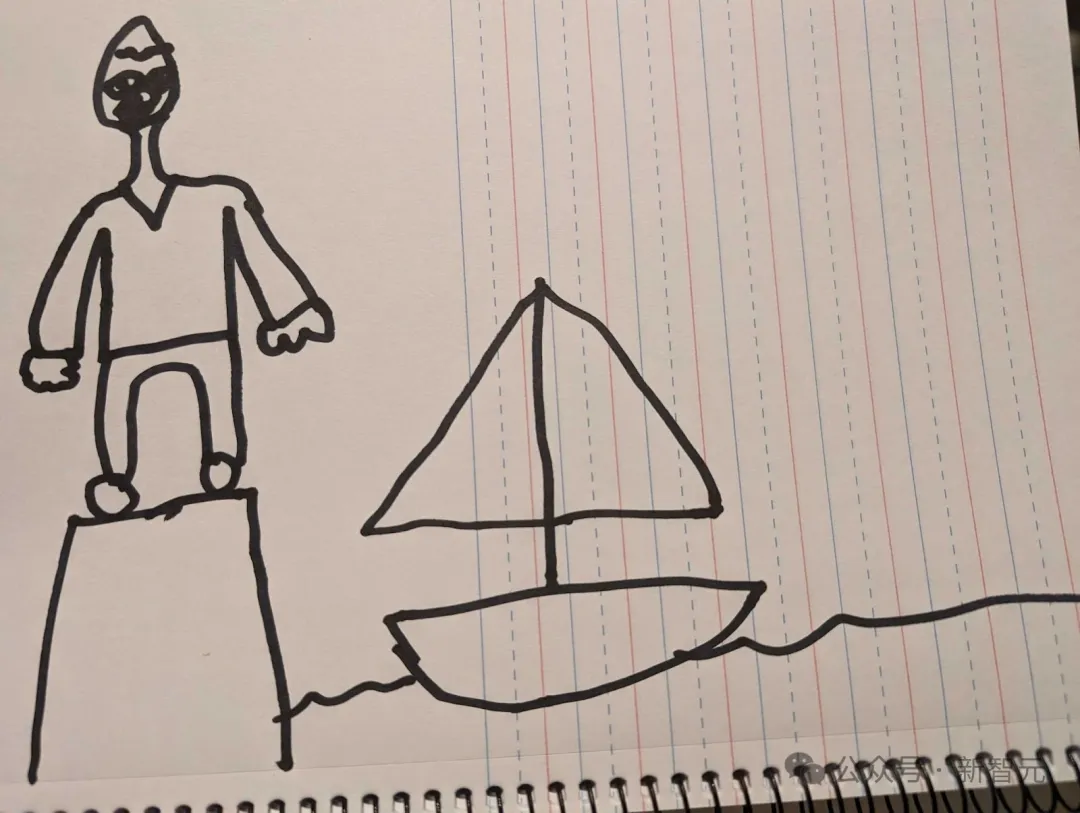

Grok可以根据画作的内容,讲述一个简短的睡前故事。

比如下面这个随笔涂鸦:

下面这张梗图,左边是初创公司,右边是大公司,讲的是什么意思呢?

小编第一眼是没看懂。看完Grok的解释,才恍然大悟。

Grok可以将表格内容转换成CSV格式。

地板上的木材腐烂了怎么办?

照片拍给Grok,它可以帮我们判断腐烂情况,还能给出合理的处理建议。

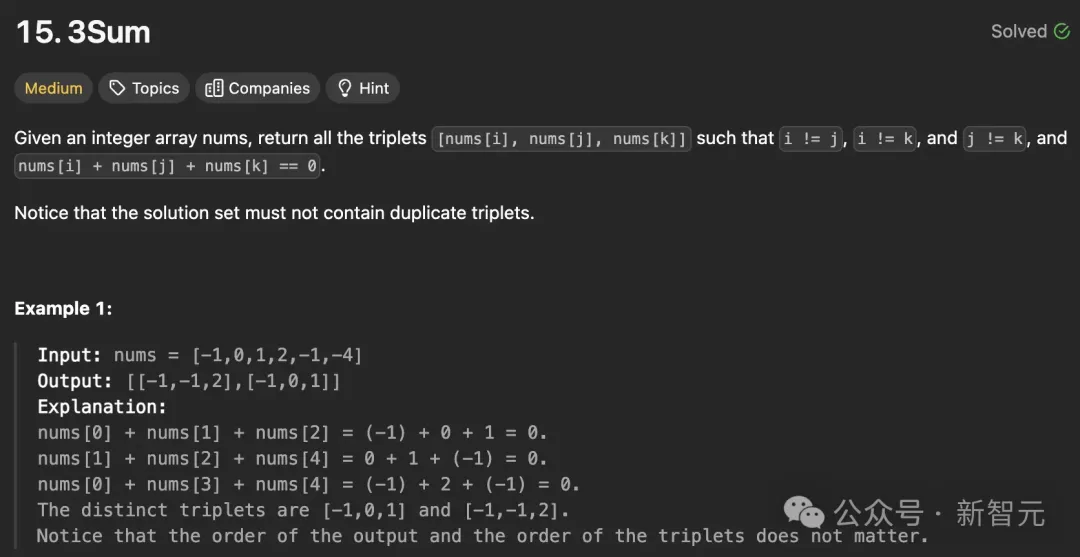

编码问题,Grok-1.5V也是不在话下。

开发有用的现实世界AI助手,提高模型对物理世界的理解是至关重要的。

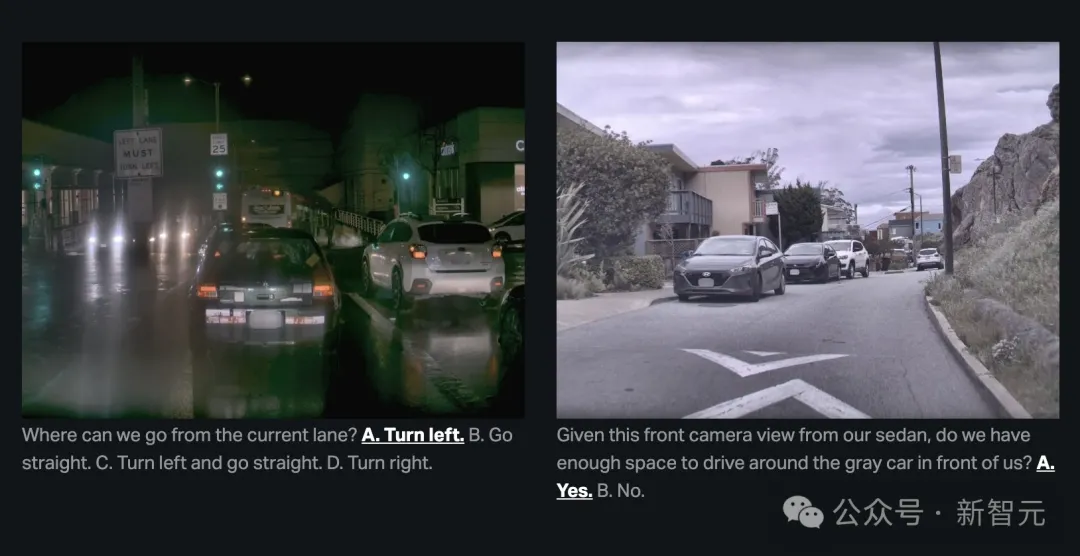

为了实现这一目标,研究团队还推出了一个新的基准——RealWorldQA。

该基准可以用于评估多模态模型对于基本现实世界空间的理解能力。

虽然当前基准中的许多示例对人类来说理解比较容易,但对于前沿模型来说还是具有一定的挑战性。

最初发布的RealWorldQA包含700多张图片,每张图片都有一个问题和易于验证的答案。

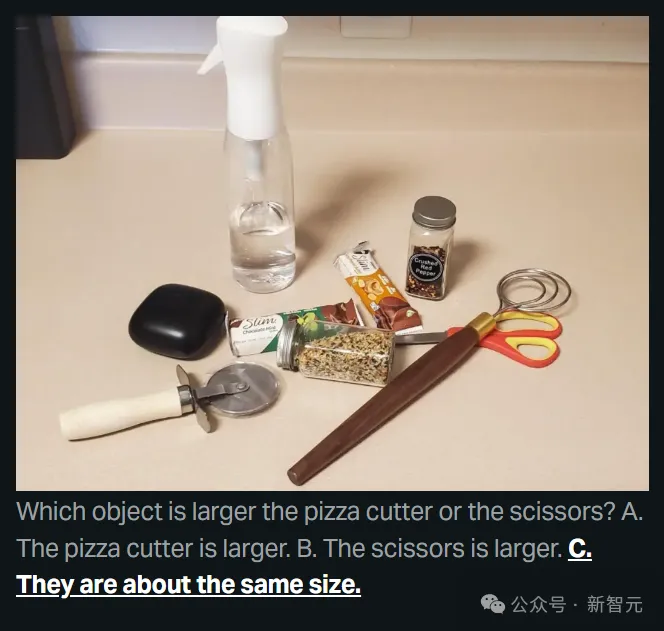

例如,如果我们问它:图片中的披萨刀和剪刀哪个物体更大?

Grok给出的答案是:它们的大小差不多。

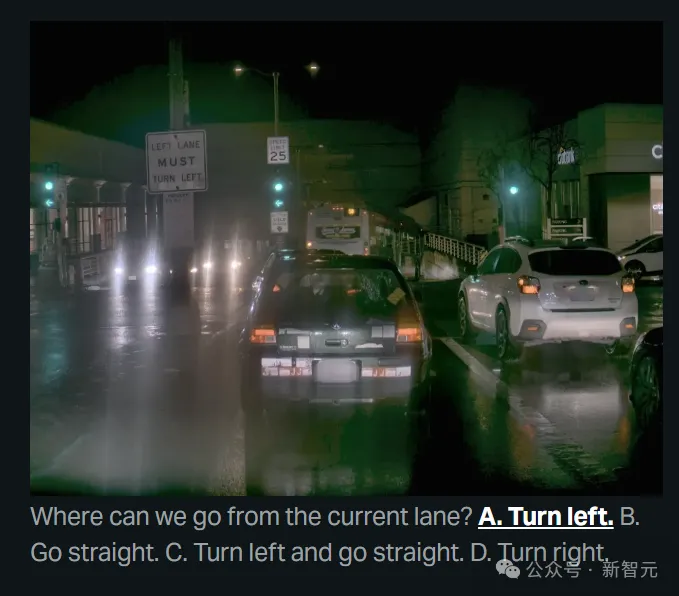

从当前车道可以去哪里?A.左转 B.直走 C.左转直行 D.右转

Grok会选A。

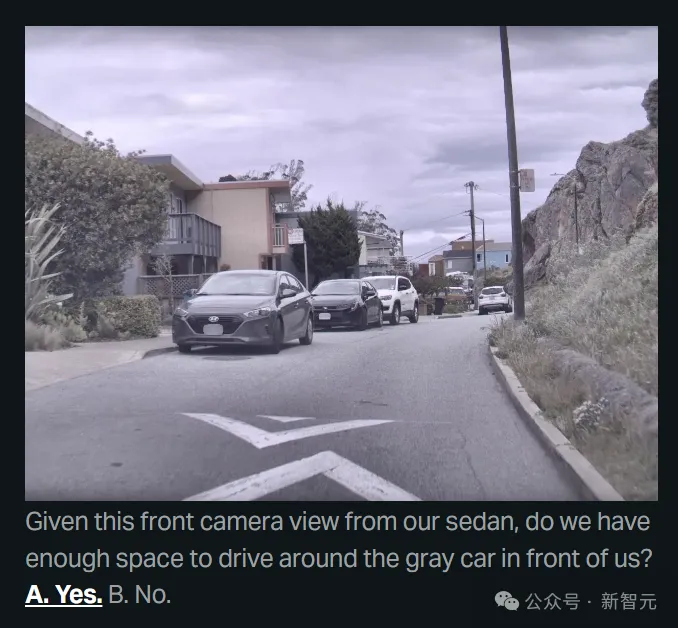

从轿车前方的摄像头来看,是否有足够的空间绕过前面的灰色轿车?

Grok给出的答案是:是。

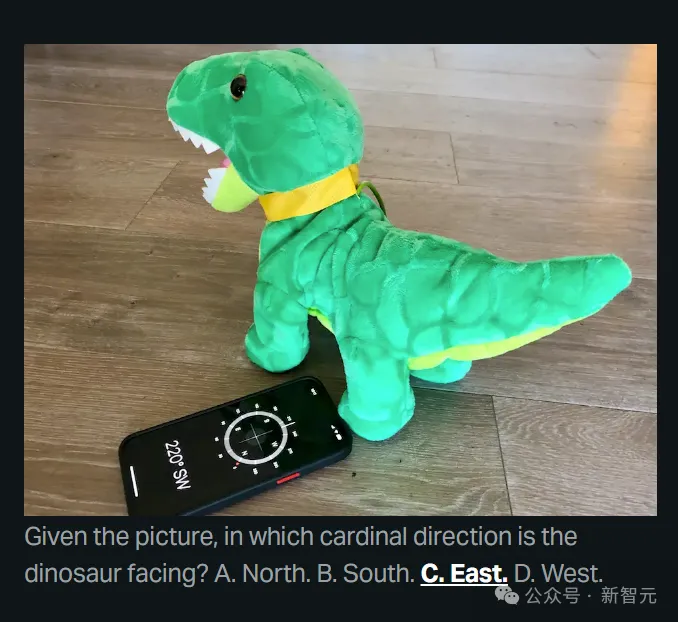

从这个图片来看,恐龙是朝向哪个方向?

Grok回答:东。

除了其他真实世界的图像外,该数据集还包括从车辆上拍摄的匿名图像。

研究团队将该数据集进行了开源,并希望随着多模态模型的改进而不断扩展该数据集。

最后,xAI官网总结道,凭着提高多模态理解和生成能力,它们将逐渐逼近构建能够理解宇宙的有益AGI。

而接下来几个月里,估计我们还会看见图像、音频、视频等多模态上,这两项能力的重大改进。

本文来自微信公众号“新智元”