最近,一则数据点出了AI领域算力需求的惊人增长——

根据业内专家的预估,OpenAI推出的Sora在训练环节大约需要在4200-10500张NVIDIA H100上训练1个月,并且当模型生成到推理环节以后,计算成本还将迅速超过训练环节。

照这个趋势发展下去,GPU的供给或许很难满足大模型持续的需求。

不过,最近海外有一个新动向,可能会给即将到来的“算力荒”提供新的解决思路——去中心化AI。

三周前,3月23日,Stability AI突然发布一项公告,宣布公司CEO Emad Mostaque辞职。Emad Mostaque自己透露了接下来动向,要去追求“去中心化AI的梦想”。

但由于去中心化网络的不确定性、不稳定性等技术上的痛难点没法解决,上一波去中心化AI很难在大模型时代真正落地。

直到最近,量子位发现,一个在海外创业的清华团队聚焦去中心化AI,创立了NetMind.AI。2023年,NetMind发布了一份白皮书,详细介绍了去中心化算力共享平台NetMind Power。这个平台要解决的,正是去中心化AI在大模型时代落地的痛点。

2021年9月,NetMind.AI启动了一项名为NetMind Power的去中心化计算平台项目。

全球有大量的闲置算力:传统数据中心的闲置算力,中小型企业拥有的没有充分使用的算力以及个人拥有的零散GPU。这些算力要么被闲置,要么被用来做游戏、视频渲染。同时,AI算力又越发紧缺,AI研究人员、中小型企业尤其是AI创业公司、参与AI项目的传统公司都受困于AI算力的高成本和高门槛。

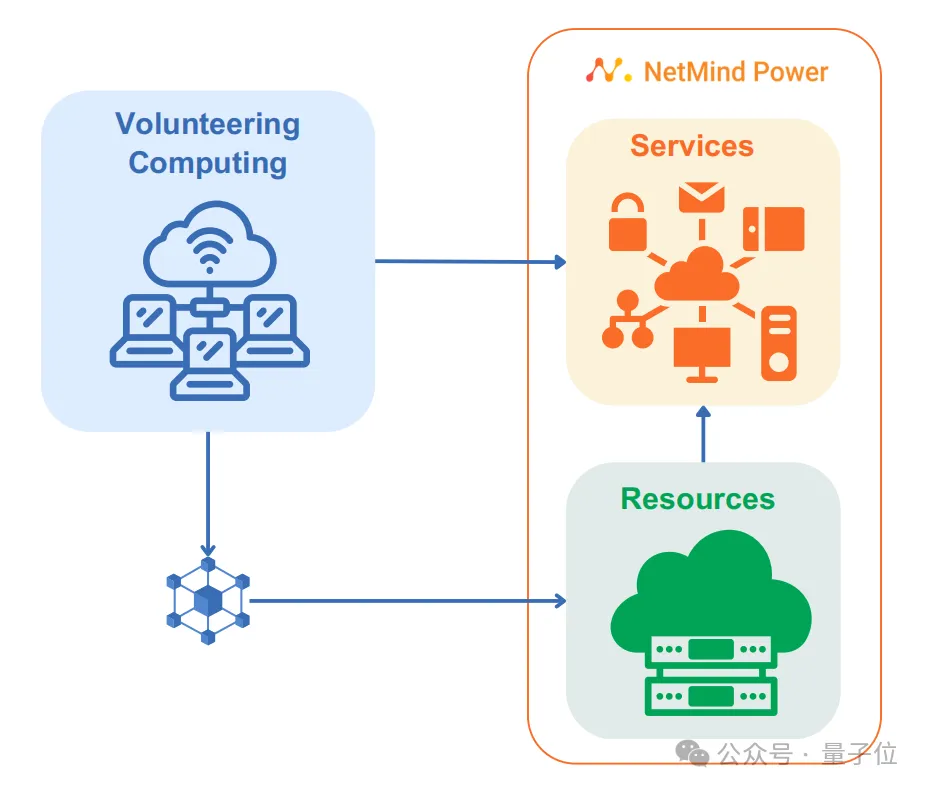

于是,NetMind Power创建了一个去中心化的计算网络,利用NetMInd研发的核心技术,撬动全球算力资源,为AI产业提供好用又用得起的AI算力服务。

目前,NetMind Power已经收集了数千张显卡,包括H100,A100,4090,3090。

该平台的四大亮点:

1. 去中心化动态集群——在极度不确定的算力上打造可靠高效的AI应用

Power平台利用基于P2P的动态分布式集群技术,结合其独特的路由、聚类算法及神经网络,将成千上万个计算节点编织成强大的网络集群架构,专门服务于AI应用等高层需求。

当用户在Power平台上进行AI相关操作,如模型训练、微调或推理时,Power的去中心化网络能够在极短时间内,在全球各地的计算节点中,通过最优化算法快速调配最合适的计算资源,为用户提供服务。

同时,Power为B端用户提供动态集群策略,可以在几秒内智能进行节点重组和配置,提供可定制,高扩展和高冗余的专属集群。

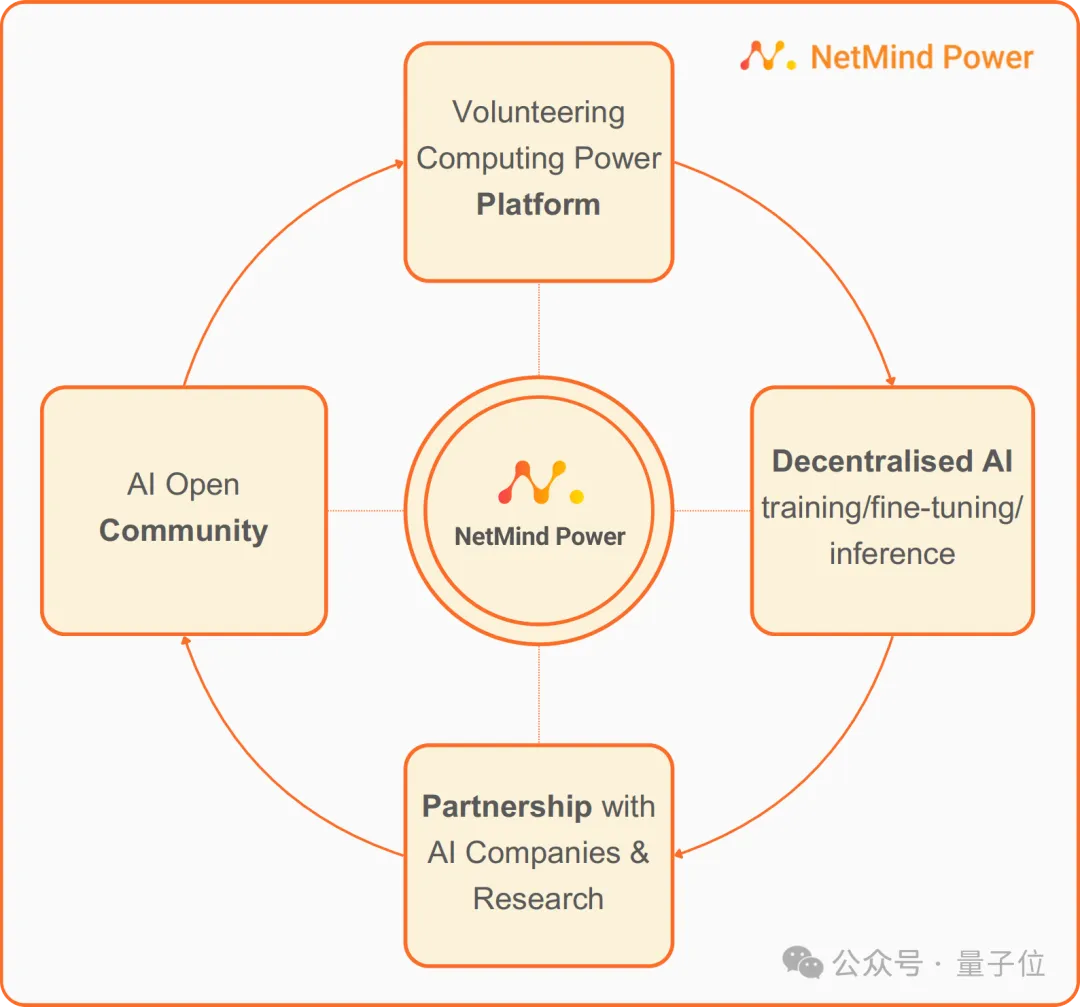

2. 完整的AI生态:降低算力使用门槛,扩大去中心化网络应用场景

借助NetMind多年在AI领域的积累,Power网络在基础算力服务之外,还将囊括开源模型库、AI数据集、数据与模型加密等AI生态基座,以及模型训练、推理、部署等全方位服务,打造MaaS (Model as a Service) 平台,为算力供给方与AI应用端的双方赋能。

针对科研人员、AI领域的中小企业和传统企业的AI+项目,Power的MaaS平台将大幅度降低算力的使用门槛,特别是对于没有专业AI开发能力的中小企业和传统企业来说,这一点尤为重要。

对于传统算力供给者,借助Power网络可以触达更多用户。更进一步,他们借助Power的MaaS平台,可以扩大应用场景,获得更高收益。这样一来,Power网络可以将传统的中小型中心化算力也纳入去中心化算力网络,进而大幅度扩大网络规模。

3. 异步训练算法——解决网络瓶颈,挖掘闲置算力潜力

在当下的机器学习领域,特别是在大型语言模型训练中,通常需要通过GPU专用连接线或高带宽的内部网络来实现GPU间的同步分布式训练,这不可避免地增加了训练的门槛和成本。

NetMind Power通过自研的模型切分和数据异步的技术,打破了分布式训练中网速和带宽的壁垒,即使是分布在地球不同角落的训练节点,也能够同步参与到庞大的模型训练工作中。

4. 模型加密与数据隔离——解决去中心化网络中的安全困扰

Power提供独特的模型加密技术,保障了在去中心化的志愿计算场景中,用户的AI模型和数据安全。所有网络通信都经过加密处理,保障了数据传输的安全;通过数据隔离与模型拆分确保去中心化网络中任何单一节点无法获得完整数据和模型,大幅度提高安全性。

NetMind.AI的核心团队来自清华,已在AI领域打磨超过10年的时间。

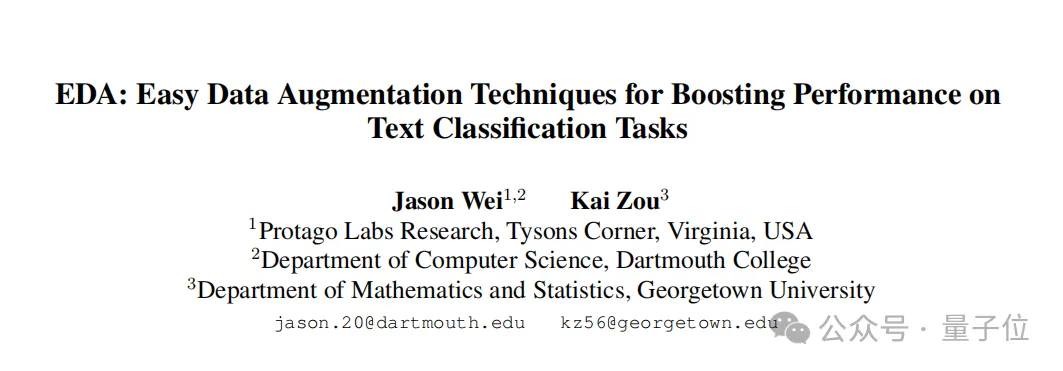

公司创始人兼CEO, Kai Zou 于2010年毕业于清华大学数学物理基础科学班,并于2013年获得乔治城大学数学和统计学硕士学位。

他是一名连续创业者,曾同时领导ProtagoLabs和非营利组织AGI Odyssey。同时,他还是一位天使投资人,曾投资包括Haiper.ai、Auto Edge、Qdot和Orbit在内的多家AI初创企业。

值得关注的是,目前,Kai Zou 和OpenAI研究员Jason Wei发表的论文《EDA: Easy Data Augmentation Techniques for Boosting Performance on Text Classification Tasks》累计引用次数已经超过2000次。CEO和他的团队坚信他们搭建的平台应该为真正做学术研究的学者以及推动AI发展的企业工程师们提供资源。

公司CTO则于2016年在乔治华盛顿大学获得计算机科学硕士学位;在加入NetMind.AI之前,曾在微软担任高级团队负责人;其在Web3、区块链技术、分布式系统、Kubernetes、云计算以及Azure和AWS等方面积累颇深;并具备边缘计算、全栈开发和机器学习等专业技能。

NetMind去中心化AI的愿景背后,实则深埋着技术普惠的理想。

回看IT技术发展史,去中心化的思潮往往在计算资源集中化陡增的时刻涌现,作为一股自下而上的力量,对抗试图将一切资源垄断的巨头,从而拉开新一轮的技术普惠浪潮,让新技术真正普及到世界各个角落。

如今的大模型市场,或许正处在这样的时刻。

放眼大模型市场,轰轰烈烈发展了一整年后,真正能站稳脚跟的创业公司并不多。除了极少数几家明星独角兽外,大模型的未来似乎正在收敛到微软、谷歌、英伟达等科技巨头手中。长此以往,少数企业可能会对计算资源的定价、可用性和访问权限形成垄断控制。

这时候,正需要类似NetMind Power这样的民主化叙事,为AGI的故事撰写新的蓝图。

目前,NetMind已经在学术和商业领域展开合作——

学术方面,NetMind Power目前已经与诸多国内外顶级名校开展合作,包括计算机科学领域顶尖的剑桥大学、牛津大学、卡耐基梅隆大学,美国西北大学、清华大学、华中科技大学、莱斯大学、复旦大学、上海交通大学等。

商业方面,NetMind Power作为企业提供基于去中心化网络的AI算力解决方案,让企业可以专注于模型研发与产品创新。越来越多的企业在Netmind Power的帮助下,加速推出AI创新产品。例如最近在北美势头正盛的文生视频团队Haiper.ai已经将其模型的训练和推理与NetMind Power平台深度结合。

未来,NetMind Power将逐渐生长为一个去中心化的AI社区,加速全球AI创新。

机器学习从业者,学术研究人员及AI应用侧的企业都可以在NetMind Power平台找到自己所需的算力和模型,也可以把自己训练的模型托管在平台上,甚至提供给平台上的其他用户,并从中收取一定费用。

用户不仅能够在平台上调用相应算力解决自己的训练需求,还能将自己训练的模型通过平台提供给更多有需要的人或企业,层层传递。

将时间轴拉长,要真正实现AGI,AI的普惠化和民主化是必然前提。如今,率先出发的NetMind.AI,正在做出自己的贡献,寻找更多的伙伴,通向民主的AGI时代,迈出坚实的一小步。

本文来自微信公众号“QbitAI",作者 量子位