微软的开发者生态,从下面这样:

变成了这样:

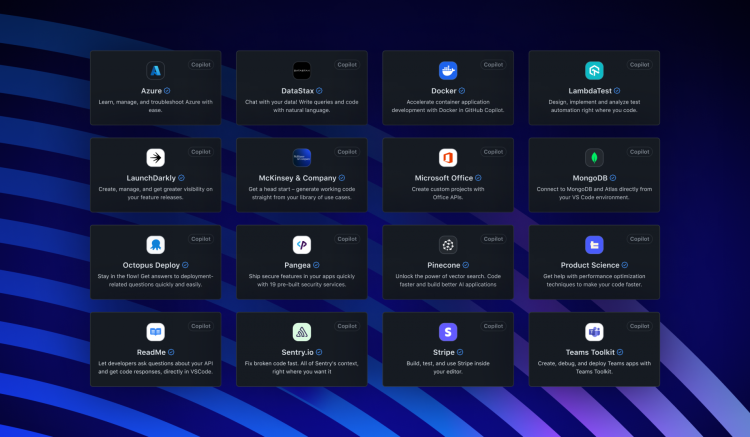

这样:

这家公司从错过移动互联网的机会,到成为生成式AI时代目前最大的赢家和定调者,真是走过了很长的路。

当微软CEO萨蒂亚-纳德拉站在2024年Build 大会的现场时,他首先致敬了创始人比尔-盖茨:

开场动画中,年轻的比尔盖茨出现在一台老电脑中,描述微软的愿景——“我希望信息对所有人触手可及”,然后视频直接跳转至今天。纳德拉的微软,已经“让这个愿景变为让智能对所有人触手

可及”。

“我记得Win32,.NET,Azure被第一次讨论的那些时刻。”纳德拉说。“这些我参加的PDC和Build被我用来标记我的人生。” 而现在,显然纳德拉拥有了属于他自己的时刻。

从更多Copilot强大功能、重新定义的AI PC,到使用新AI能力的工具堆栈——一切都是关于Copilot。

GitHub Copilot Extention:帮开发者解放生产力

“公司成立近50年后,我们重新定义软件开发。”

纳德拉把GitHub Copilot描述为“这个AI时代的第一款热门产品。”作为最广泛采用的AI开发工具之一,GitHub Copilot已经拥有来自5万家组织的180万订阅用户。而今,微软又进一步与100多家

合作伙伴推出GitHub Copilot Extensions,打造了一间属于开发者的“生产力应用商店”。

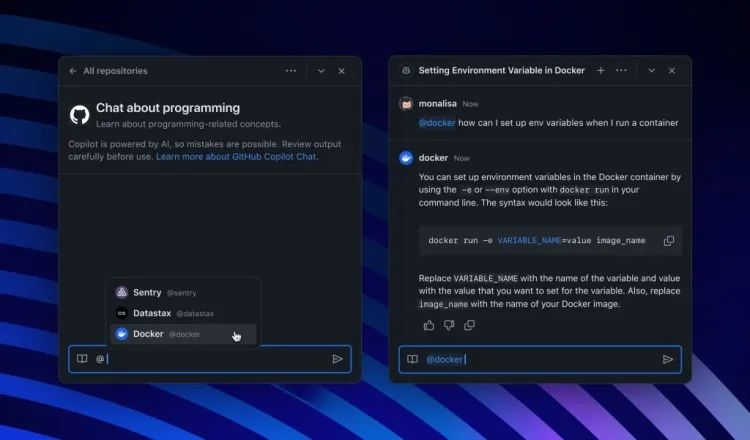

开发者可以使用Copilot Studio或Teams Toolkit,通过新引入的Copilot 连接器快速自定义扩展。选择自己喜欢的工具和服务,直接在workspace用自然语言调用并一站式构建和部署到云端,无

需离开 IDE 或 GitHub.com,从而更长时间地保持稳定通畅的工作流。

例如在以前,当开发者收到数据库错误警报时,需要查看GitHub issue、审计日志、错误监控等多处来获取上下文信息,找出解决方案、撰写代码并部署。整个过程涉及很多不同工具,需要不

断切换上下文,效率较低。

而现在,Copilot Extention将整个过程整合在一起。只需在 GitHub Copilot Chat里下达指令,就能轻松调用所有这些工具来执行操作、生成文件和拉取请求,极大加速了工作流。

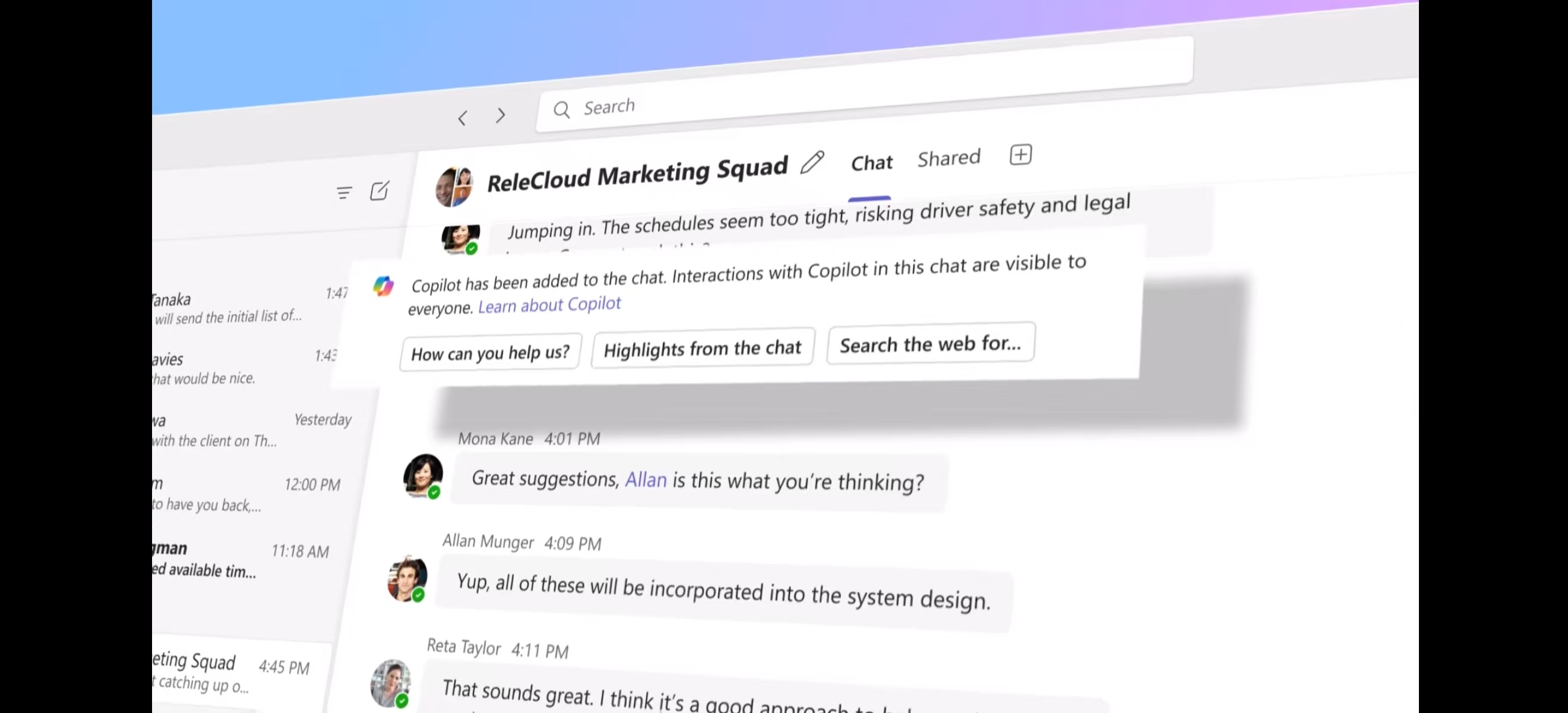

Team Copilot:专业高效的团队助手

微软还重磅推出Team Copilot功能,将Copilot从个人助理扩展到了团队环境中,服务于整个部门和组织,提高团队协作和项目管理效率。

演示视频中,Team Copilot能够充当各种团队角色:

会议主持人:管理议程、记录会议笔记,任何与会者都可以共同编辑,让讨论更加高效。

团队协作者:帮助大家更好地利用聊天功能,提取最重要信息,跟踪行动项目,解决遗留问题,并在团队达成解决方案后自动更新笔记面板,详细记录决策过程。

项目经理:创建和分配任务、跟踪截止日期,并在需要团队成员输入时通知他们,确保每个项目顺利进行。

作为一款面向团队的强大工具,Team Copilot 承了各种复杂细致的繁琐工作,并将任务瞬间清晰规划,大大节省了团队成员之间的沟通成本。Team Copilot 可以在 Teams、Loop、Planner 等

平台上使用,将于今年晚些时候开放预览。

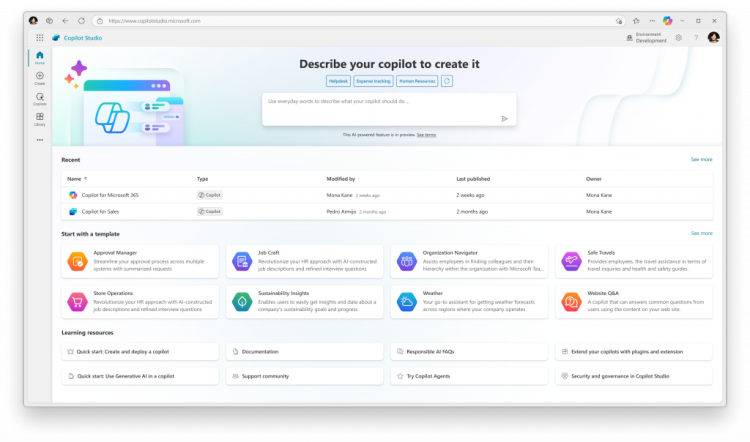

Copilot Studios定制AI代理,主动替你干活的虚拟员工

另外,此次微软也紧跟AI Agent趋势,推出了具有代理功能的Copilot。与OpenAI的“her”语音助手实时对话、Google的Project Astra识别物体与地理位置不同,微软的AI代理更注重帮用户异步执

行工作流程。

“我们很快意识到,仅限于对话的Copilot在当今所能做的事情上是非常有限的,”微软业务应用和平台的公司副总裁Charles Lamanna在接受The Verge采访时解释道。“与其让Copilot等待有人与

其聊天,不如让Copilot更主动,能够在后台执行自动化任务。”

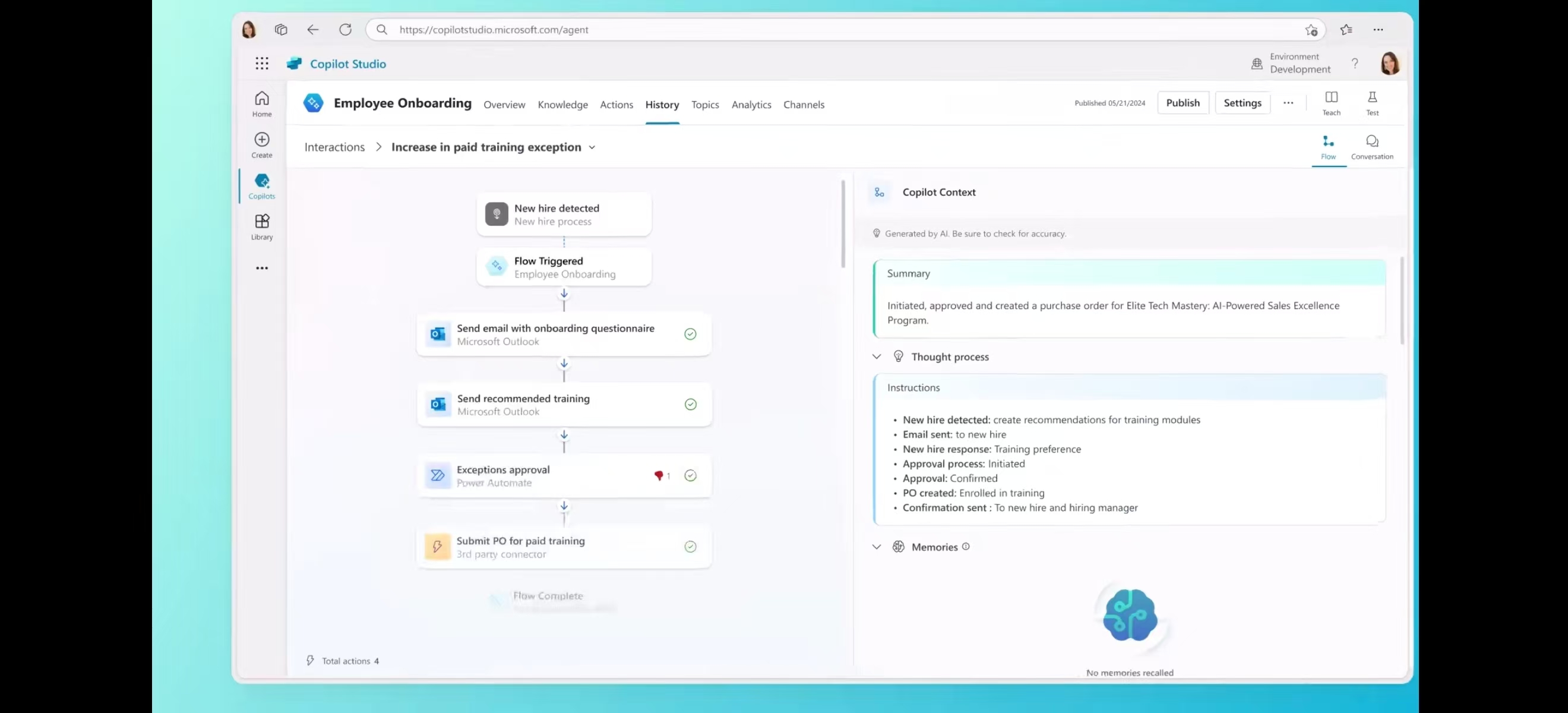

通过Copilot Studio,任何人都可以构建像虚拟员工一样的Copilot。只需提供一个工作描述和必要的知识和操作,Copilot就能在后台代替你工作,并以异步方式执行任务。“这种拥有异步行为能

力的Copilot和代理,是明年将发生的重大变化之一。”纳德拉在演讲中表示。

它将不再闲置一旁等待你来查询,而是能够监控email收件箱,自动化员工通常手动完成的一系列任务或数据输入。你还可以授权Copilot自动化长时间运行的业务流程,当它遇到不了解或无法

处理的情况时甚至会请求帮助。

01:05

想象一下这个场景,在你作为新员工入职的第一天,一个Copilot会来主动迎接你,利用HR数据回答你的问题,为你介绍同事、提供培训,帮助你填写表格并安排你的第一周会议。再比如,一

个“订单处理” Copilot 可以处理端到端的订单履行流程——从接收订单、处理订单、对缺货商品进行智能推荐和替代、到将商品运送给客户。对于它可能给人力带来的威胁,微软也强调,

Copilot代理不是要“取代”你,而是要“为你所用”。

此外微软还简化了基于 SharePoint 和 OneDrive 数据创建Copilots 的过程。这些功能目前在早期访问计划中向客户开放,并在2024年晚些时候更广泛发布。

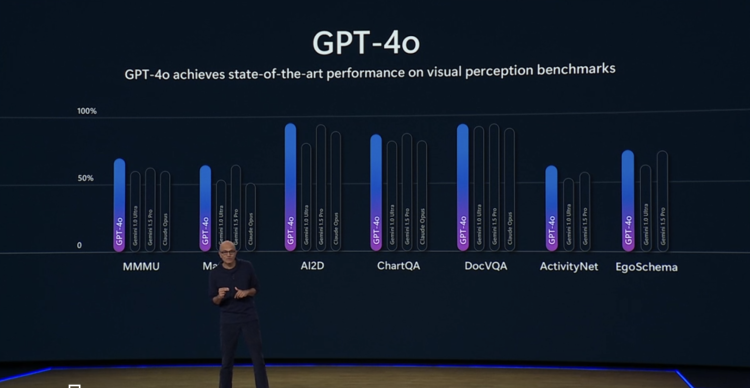

GPT-4o全面接入,Phi-3小模型家族上新

整场演讲中,GPT-4o仍然是微软大力推崇的对象之一。纳德拉兴奋表示,今天有超过5万个组织在使用Azure AI,而这一切都始于微软与OpenAI的重要合作伙伴关系。

“最新的多模态模型GPT-4o正是在Azure上训练的,这是一个绝对的突破,上周OpenAI展示的东西真的如同魔法一般!现在GPT-4o已经可以在Azure AI上使用。"

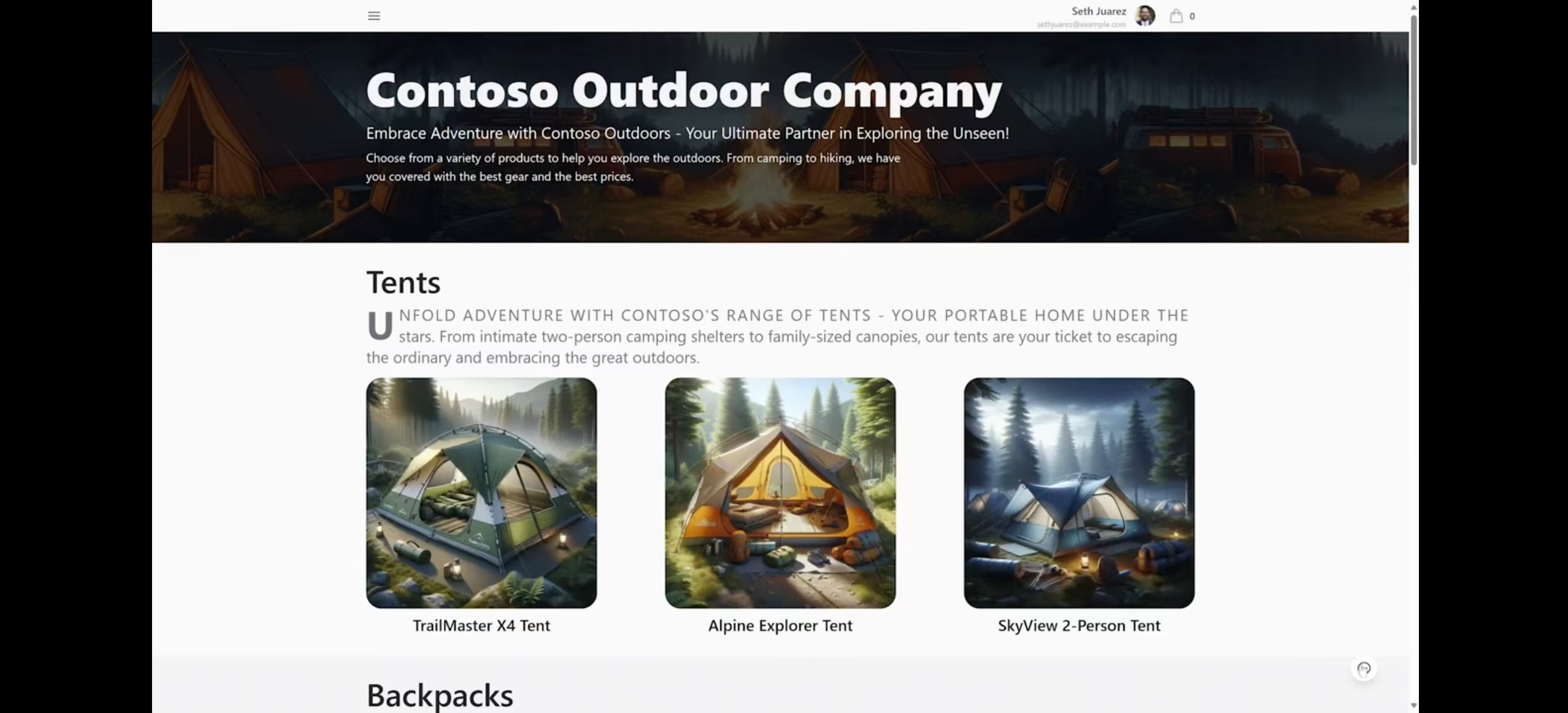

在现场,微软播放了一段使用新推出的 Copilots+PC 将 GPT-4o所有本领集大成的演示视频:

用户把一双鞋举到电脑摄像头前问GPT-4o:”我今晚要去露营,会很冷。我应该穿这些鞋吗?”

GPT-4o看了看,回答说那是徒步凉鞋,并不是寒冷天气的最佳选择。用户打断了GPT-4o,请求帮他选最合适的产品并加到购物车。GPT-4o接着像个老伙计一样一边解释边完成了操作,还无缝

切换了西班牙语对话。

整个过程一气呵成,效果惊艳,再次引来现场一片掌声。

01:11

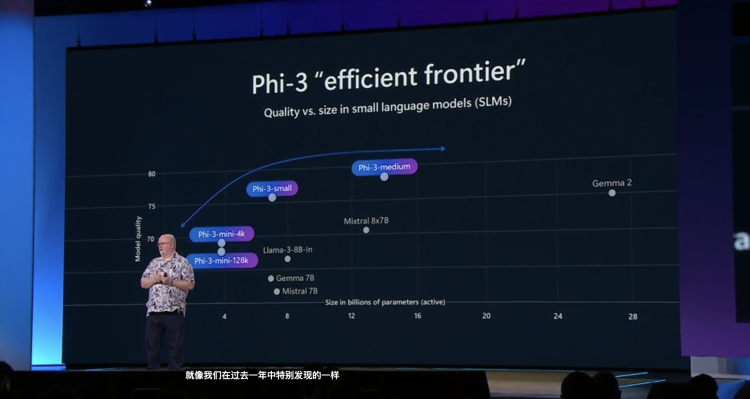

除了GPT-4o,微软开发的AI小语言模型(SLMs)Phi-3 系列也发布了一款新的多模态模型——Phi-3-vision,与之前已的 Phi-3-mini 和 Phi-3-medium一起,通过 Azure AI 的模型即服务产品提

供给用户。

至此,整个Phi-3家族已经有了四名成员:

Phi-3-vision :具有语言和视觉能力的42亿参数的多模态模型。

Phi-3-mini :38亿参数语言模型,有两种上下文长度(128K 和 4K)。

Phi-3-small :70亿参数语言模型,有两种上下文长度(128K 和 8K)。

Phi-3-medium :140亿参数语言模型,有两种上下文长度(128K 和 4K)。

值得一提的是,作为演讲最受期待彩蛋,被CTO Kevin Scott形容为”全地球头号大忙人“的Sam Altman也现身大会现场,为微软站了会儿台。

奥特曼表示,未来GPT-4o 将变得更快,但更便宜。他也透露了关于GPT-5的一点小提示,表示很高兴下一个大模型即将到来,微软为此建造了一台更大的超级计算机。

新模式和整体智能将是OpenAI下一个模型的关键。“最重要的事情听起来可能是我能说的最无聊的事情……模型总体上只会变得更聪明,”奥特曼说。

从基础设施、数据到Windows平台,构建最完整技术栈

纳德拉把微软定义为一家平台公司,“我们的目标是构建最完整的端到端技术栈,从基础设施到数据、工具,再到应用程序的可扩展性,使你能够利用这项技术的力量构建自己的应用程序。”

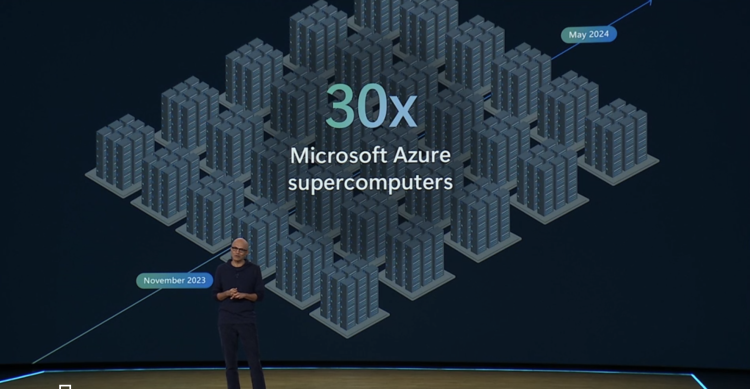

因此除了Copilot和模型,在硬件生态层,微软也表示具备最完整、可扩展的AI基础设施,满足AI时代的所有需求。坐拥全球超过60个数据中心区域,比其他任何云提供商都多。过去六个月里增

加30倍超级计算能力,并将Azure AI服务提供的国家数量增加了四倍。

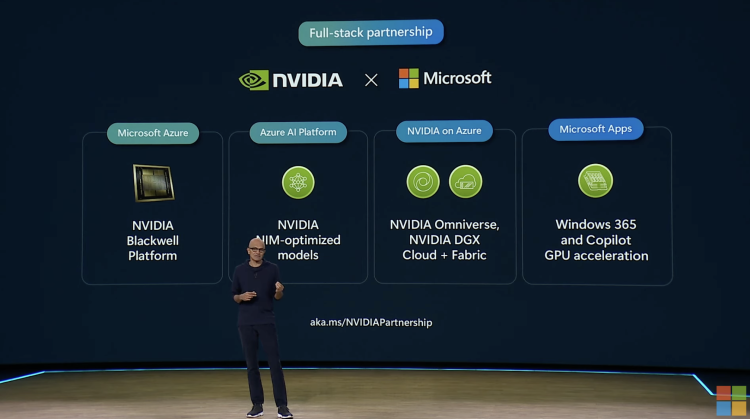

微软采用的AI加速器来自Nvidia和AMD及自己的Azure Maya。今年晚些时候,微软将引入Nvidia最新的H200 GPU,成为首批提供Nvidia Blackwell GPU的云服务商之一,并将Nvidia的

Omniverse Cloud和DGX Cloud与Microsoft Cloud深度集成。

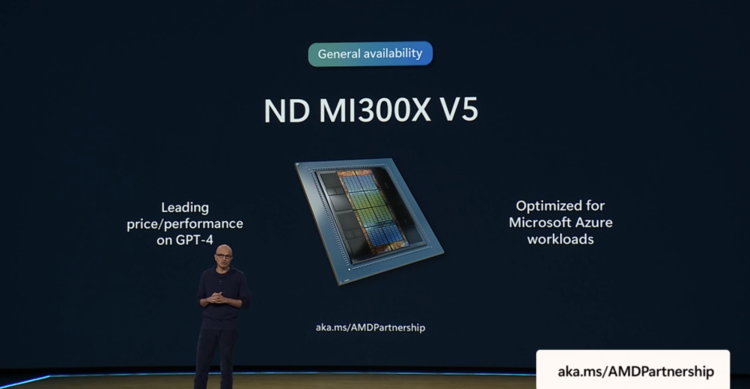

它也是首家将AMD MI300X AI加速器芯片用于客户AI训练和AI推理的云服务提供商。Azure ND MI300X v5虚拟机系列已正式发布,针对高需求AI,以及诸如Azure OpenAI Service的高性能计算

(HPC)工作负载进行了优化。

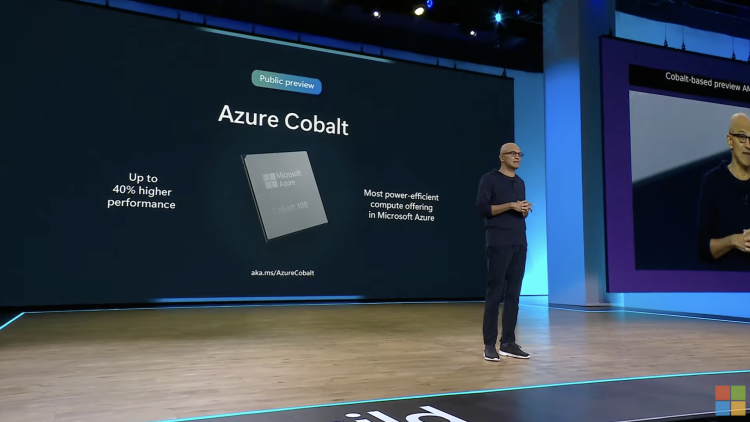

同时,微软自研的Azure Maya第一个集群也已经上线,将支持部分Copilot和Azure OpenAI 服务。并宣布基于去年11月发布的定制硅芯片开放全新的Cobalt 100 Arm-based虚拟机(VMs)公

开预览。与同类型Azure 虚拟机相比,Cobalt 100 Arm-based 虚拟机的性能提升达40%。

数据层面,微软的智能数据平台Microsoft Fabric推出了全新的实时智能(Real-Time Intelligence)。提供端到端的软件即服务解决方案,不仅帮助数据分析人员获得简单的低代码或无代码体

验,也能通过代码丰富的用户界面让专业开发者受益。让客户能够对海量的、时间敏感的高颗粒度数据采取行动,更快制定业务决策。

为了让独立软件供应商和开发者能够在 Fabric 中扩展应用程序, Microsoft Fabric 也推出工作负载开发套件(Workload Development Kit),保证构建程序的灵活性、定制化和效率。

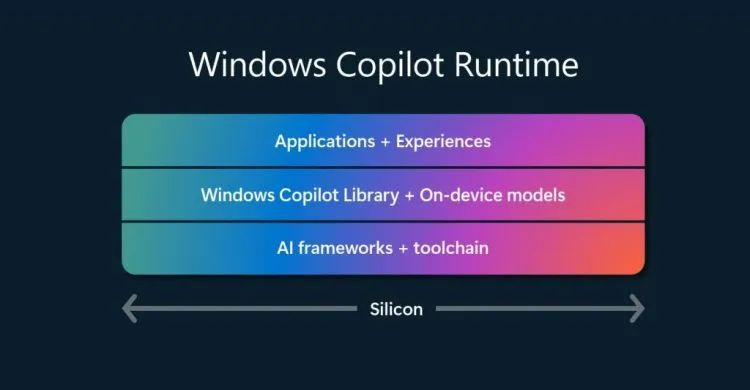

来到Windows平台,针对此前发布的一系列集成最新AI功能的Copilot Plus PC。纳德拉表示,得益于新的Windows Copilot Runtime,公司现在在Windows 11上运行了超过40个即插即用的AI

模型。

它包括一个API库,包含Studio Effects、实时字幕翻译、OCR、用户活动回忆和Phi Silica等现成的AI API。开发者可以利用这些API为自己的应用服务,并配有专门设计的AI框架和工具链,使

他们能够在Windows上发布自己的设备端模型。微软正用一切努力证明“Windows是AI的最佳开放平台”。

拥抱各大合作伙伴

除了与Nvidia、AMD深度合作,本届Build大会上,微软还宣布了与Hugging Face扩大合作关系,将更多Hugging Face模型引入 Azure AI Studio。

并将与打造出“首个AI程序员”的Cognition携手 ,把 Cognition 的自主AI软件代理 Devin 带给客户,帮助他们完成代码迁移和现代化项目等复杂任务。作为双方协议的一部分,Devin 将由微软智

能云Azure 提供支持。

微软也宣布和可汗学院(Khan Academy)达成多元合作伙伴关系,为美国所有K-12教育者免费提供AI教育助手Khanmigo for Teachers,捐赠Azure AI优化的基础架构权限。可汗学院则会借助

微软开发的小型语言模型(SLM)系列Phi-3最新版,探索以经济实惠、可扩展、适应性强的方式改进数学辅导。这项合作具有巨大的社区意义,宣布时线上评论区一片沸腾。

在演讲中,纳德拉称微软一直有两个梦。“如何让机器理解人,而不是让人理解机器;以及在信息爆炸时代,电脑如何帮我们整理,规划和更高效处理信息。”而现在生成式AI让微软有机会实现

这些梦。

显然,纳德拉的这种叙事,是在把这波浪潮描述为微软早就预料和期待的技术革命,也把微软定义为生成式AI的预见者和领导者。

而从今天微软的位置来看,他的这个叙事的确正在成为现实。

文章来自“硅星GenAI” ,作者:张潇雪

【开源免费】OWL是一个完全开源免费的通用智能体项目。它可以远程开Ubuntu容器、自动挂载数据、做规划、执行任务,堪称「云端超级打工人」而且做到了开源界GAIA性能天花板,达到了57.7%,超越Huggingface 提出的Open Deep Research 55.15%的表现。

项目地址:GitHub:https://github.com/camel-ai/owl

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/