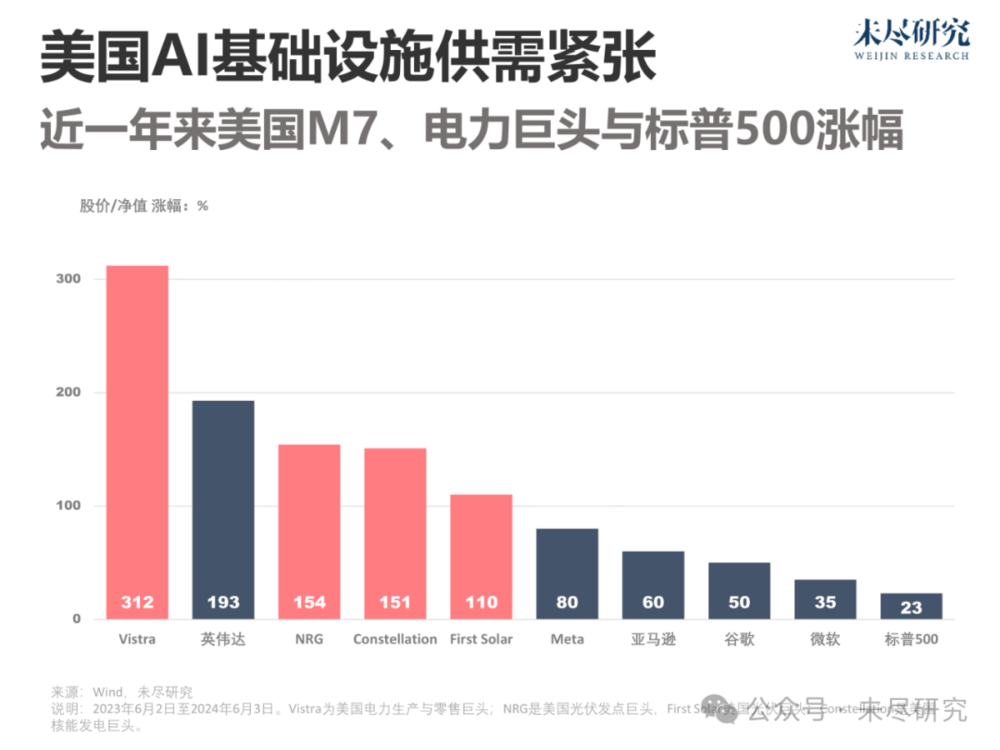

美国电力巨头们的股价正在因为AI而疯狂,近一年来涨幅普遍翻番,甚至超过了英伟达。正在建设AI基础设施的七大科技巨头(M7)们,不仅抢着向英伟达要货,还在抓紧和这些电力巨头们签订合同。也难怪黄仁勋前两天在COMPUTEX的演讲中频繁强调芯片能耗。中国人工智能要追赶美国,会遭遇类似的“电力危机”吗?

AI的智能是算力问题,也是电力问题。今年以来,多家机构预测数据中心用电量将在AI的推动下大幅增长。这进一步推高了市场对“电力危机”的关注度。

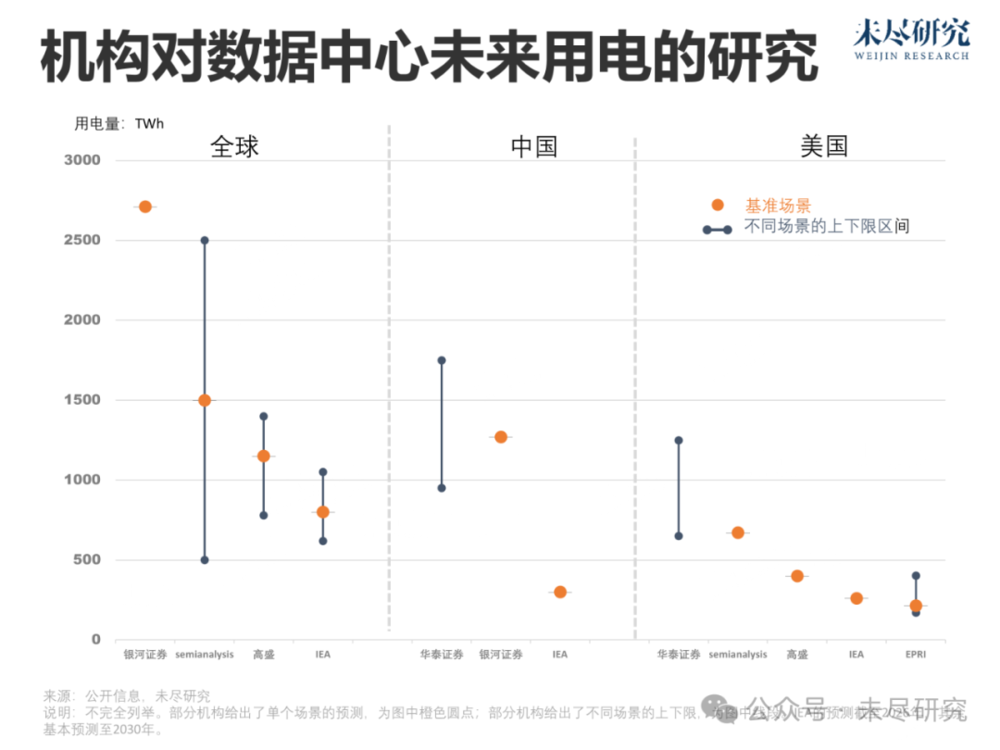

这些报告研究对象(数字中心、智能数据中心、加密货币等)、研究市场(全球、中国与美国等)、研究周期(多数截至2030年)各不相同,但基本逻辑大同小异:先根据芯片等硬件的算力与功率,计算出数据中心的用电量,再根据算力增长的预期、芯片能效提升的预期,以及数据中心能效(PUE)提升的预期,来推测未来一段时间内智能数据中心的用电量增长情况。

由于涉及因素繁多,不确定性较强,部分报告还假定了多种增长场景,不同场景下用电增长差距颇大。

今年5月,高盛预估到2030年,全球数据中心用电占比将从2023年的1%-2%升至3%-4%,美国则将从3%升至8%;美国电力研究协会(EPRI)则认为最严峻的情况下,美国数据中心用电占比将超过9%。但这都显著低于semianalysis的判断,这家深耕半导体行业的分析机构认为,届时全球数据中心用电占全社会用电将超过4.5%,美国更将是超过14%。

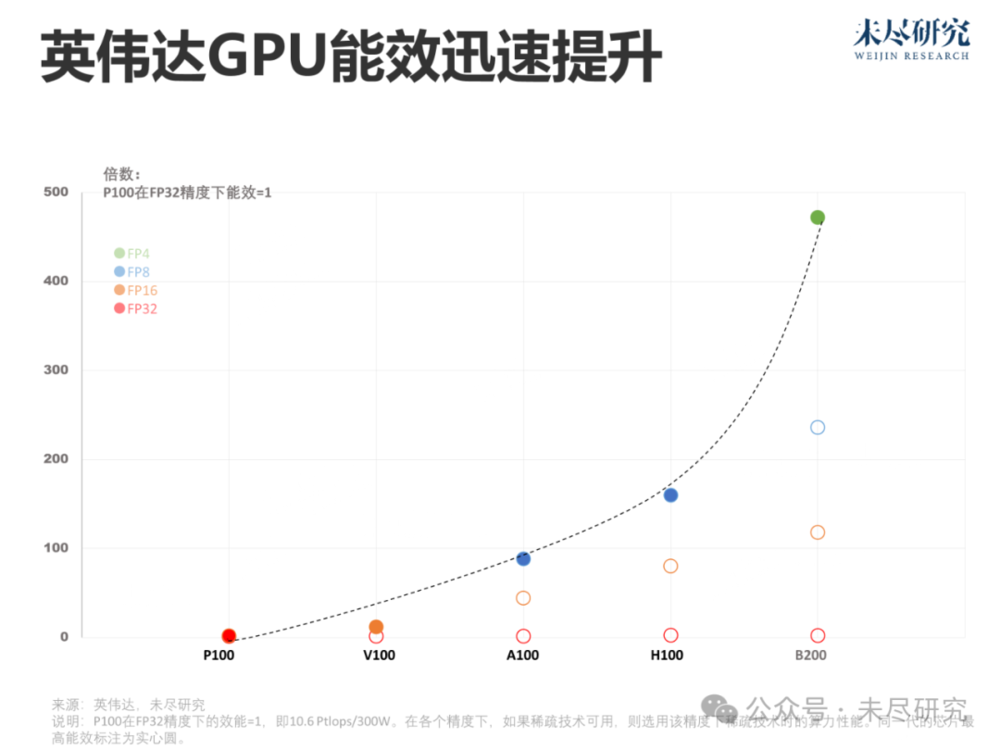

这些机构的最大分歧在于,AI会不会主导未来数据中心用电量的增长,尤其是AI主导的用电量增长,是否主要来自算力增长。各方相信,影响用电量增长的其他两大关键预期——AI数据中心与AI芯片的能效,都会继续有规律地提升。高盛认为届时AI用电占比约20%,semianalysis则认为可能超过60%。

算力增长,既取决于算力需求的增长,也取决于算力供给的增长,还取决于客户预算的增长赶不赶得上前两者的增长,以及电力电网建设的增长赶不赶得上前三者的增长。短期来看,英伟达的先进芯片仍然“供不应求”,长期来看,客户的需求才是更核心的驱动因素。

其中,算力需求的增长,既包括训练需求的增长,也包括推理需求的增长,都存在很高的不确定性。SOTA模型的训练仍在向更大参数规模扩展,但能够参与下一场竞争的玩家数量开始减少;推理市场的规模变现也尚未到来,去年500亿美元投入只换来30亿美元收入。

如果推理市场打开,那么AI芯片的格局也可能重构,更多更高功效的AI专用芯片有了用武之地。问题的关键又变成了回答“杰文斯悖论”,即更省电的芯片的应用,会不会带来更大用电总量的提升。此

外,微软与Meta也在持续优化算法效率,尝试在更低精度下训练模型,而从FP16到FP8再到FP4,正是英伟达芯片迭代的方向。

中国也有金融机构“炒作”中国版本的电力危机。3月,银河证券称,到2030年,中国的数据中心用电将达到1270 TWh,华泰证券则认为可能高达1700 TWh。这甚至超出了前述其他机构对全球数据中心总用电量的预测。

真的会这样吗?中国与美国面临的情况,有点不一样。尽管同样存在数据中心PUE提升以及应用规模落地等问题,但到2030年,影响中国AI算力与电力最主要的因素,还是在于国产芯片迭代速度与产能瓶颈。中国最起码发电问题没有美国那么严重,一年的“风光”装机量足以供电。

要确定当前中国主流AI芯片,包括GPU、FPGA与ASIC等,它总体上相当于等效英伟达的哪一代芯片?美国降下“硅幕”,试图将中国先进算力限制遏制在A100水平以下。尽管部分英伟达的先进芯片仍能通过“走线”的方式流入国内,但目前国内能合规获取的英伟达芯片主要是H20,它在推理层面相对国产芯片已经没有明显的优势。

也要确定国产芯片能否尽快迭代,能以多快的速度提升能效。接下来的问题,就是先进制程良率提升速度、产能爬坡速度。而一旦取得突破,美国也可能在保持代差优势的情况下,稍微放宽门槛,以冲击国产芯片市场,这也会提高国内算力硬件的供给。而要向更先进制程迈进,将取决于产业链各个环节解决卡脖子的问题。

如果中国的AI算力长期由低能效芯片提供,那么相同算力规模的用电量需求就会大增。中国就要以电力换算力,保证在AI领域的竞争力。如果能够突破,那么以“过剩”的能力,决定用电量的将是算力需求而不是供给。中国三大城市群已出台的智能算力基建规划,总规模早已超过全国。中国的企业家们相信,大模型最大的应用市场就在中国。

到2030年,中国的AI算力与电力,值得重估。

文章来源于“未尽研究”,作者“未尽研究”