终于,AI大神李沐回来了!带着他的大模型创业最新成果——

一个专门为复杂场景角色扮演设计的大模型,名为Higgs-Llama-3-70B。

得知消息的不少网友已激动在评论区催更,李沐老师也回应,视频坑还是会填的:

想你的365天。

终于回来了,视频都盘包浆了。

那沐神到底干啥去了?这就透过Higgs-Llama-3-70B瞧一瞧。

定睛一看,Higgs-Llama-3-70B是沐神去年联合创立的公司Boson AI,推出的Higgs开源系列大模型中的第一个,基于Llama 3打造,做了完整的SFT、RLHF。

它不仅能在角色扮演任务上表现优异,在通用领域上的指令遵循和推理方面也很有竞争力。

另外还有市场消息称,Boson AI已获张一鸣个人投资。

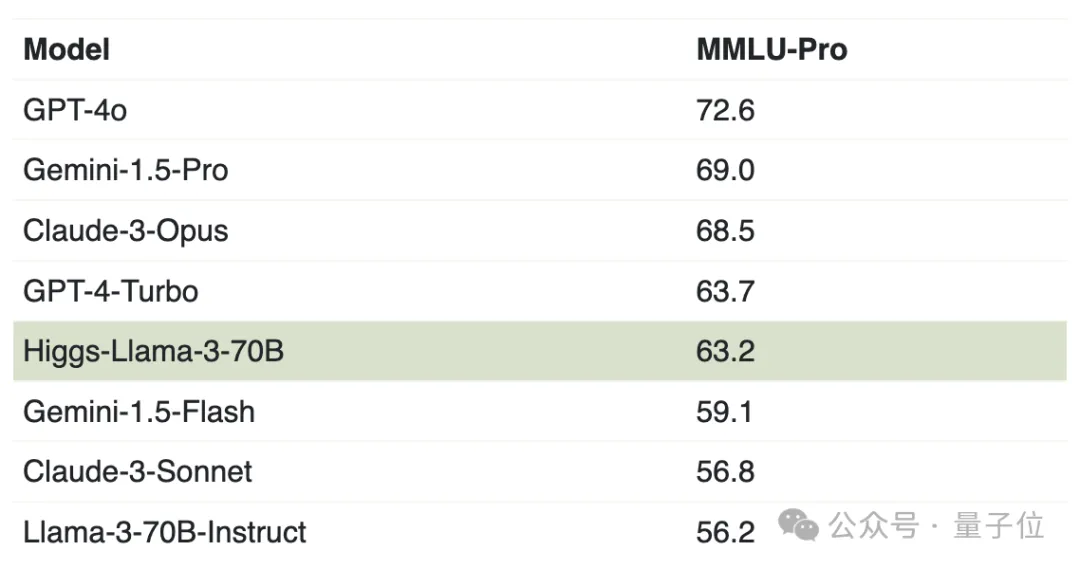

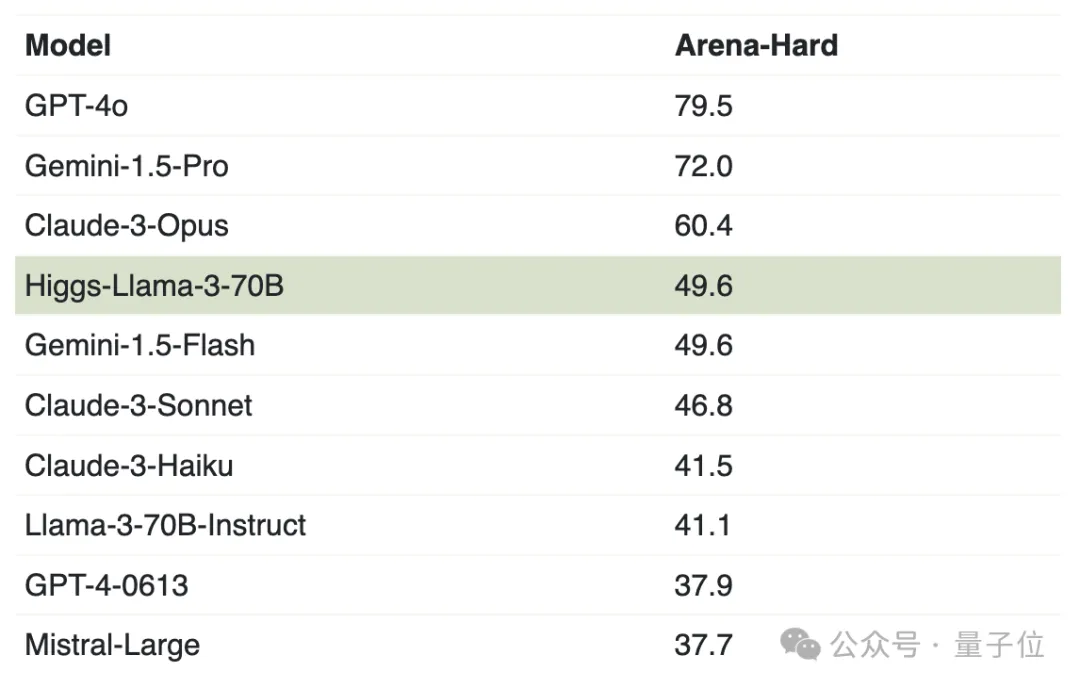

团队在两个新基准测试MMLU-Pro和Arena-hard上展示了Higgs-Llama-3-70B的能力。

他们还特地强调所有基准测试终将导致过拟合,已尽量从微调数据中排除了基准测试数据及其训练示例。

具体来说,MMLU-Pro是MMLU的扩展,团队认为MMLU-Pro是在模型完成训练之后发布,较少受到其他已发布模型的过拟合影响。

拿来做比较的模型也都一水的很强。

而Higgs-Llama-3-70B的表现优于谷歌在5月I/O大会上最新推出的模型Gemini-1.5-Flash、Claude3家族“中杯”Claude-3-Sonnet以及Llama3-70B-instruct。

再来看Arena-hard,该基准包含了来自Chatbot竞技场的500个具有挑战性的真实用户查询。

Higgs-Llama-3-70B的表现排名第四:

除此之外,使用相同的base model,Higgs-Llama-3-70B在6个基准测试中均优于LLama-3-70B-Instruct。

虽然距离GPT-4o还有不小的差距,但值得注意的是沐神团队放出的只是通用能力的基准测试,并且强调并未针对性刷榜。

而且Higgs-Llama-3-70B毕竟是为角色扮演专门设计的,相关效果展示团队未具体给出。

团队表示Higgs-Llama-3-70B只是个开胃菜,将进一步探讨角色扮演性能、训练后的处理流程、零基础建立数据中心、在云端使用GPU以及未来整合多个服务提供商的策略。

之后也会发布更多Higgs系列模型。

这次李沐大模型创业方向终于浮出水面,倒是一定程度印证了之前关于沐神创业方向的猜想。

此前有消息爆料,从亚马逊首席科学家的职务上离职后,李沐联手其导师、另一位亚马逊出身AI大牛Alex Smola创办了创业公司Boson AI。而公司方向是利用大模型能力,做和游戏娱乐有关的项目。

这回官方终于给出了个准信儿,确实跟游戏沾边:

自2023年成立Boson AI以来,我们一直致力于利用AI技术为企业赋能,旨在革新故事讲述、知识学习和信息洞察的方式。我们协助客户开发Agent,使其能够扮演多种角色,如游戏角色、语言教师、保险代理和金融顾问。

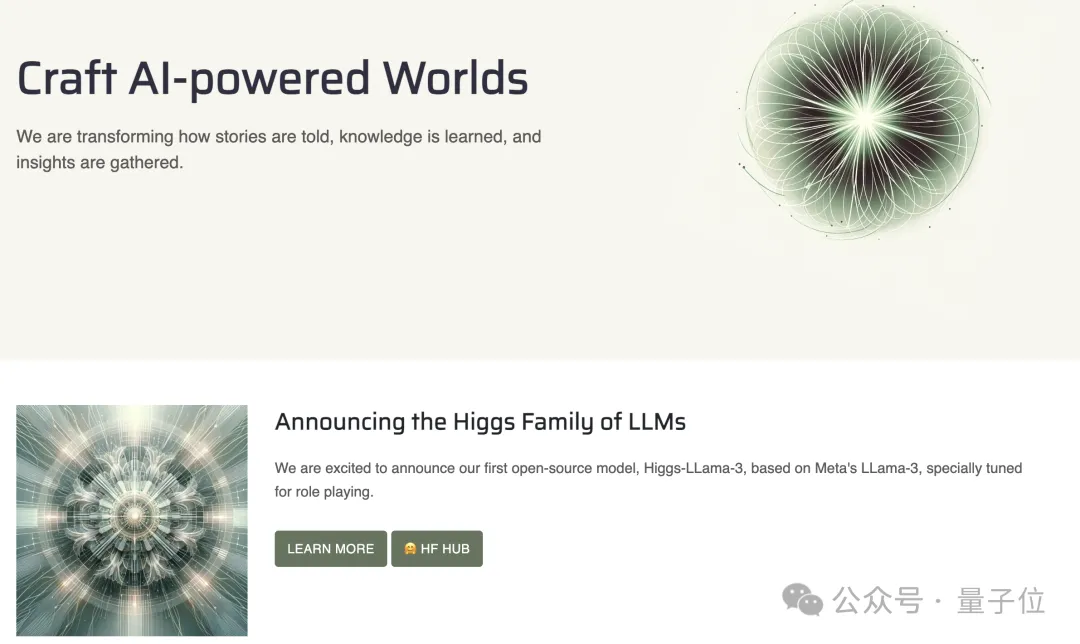

目前官网主页也已更新Higgs-Llama-3-70B模型。

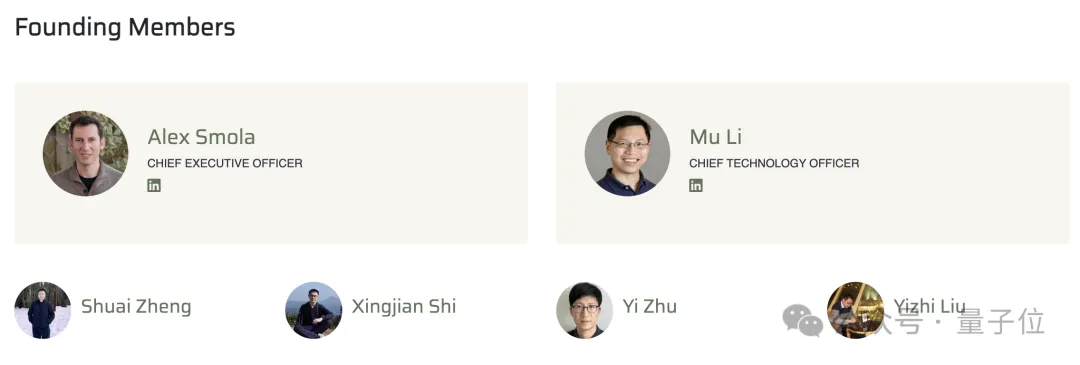

还晒出了团队创始成员,除李沐和Alex Smola外,还有四位成员。

李沐和Alex Smola,量子位此前也有介绍过。

李沐,是二者之间大家比较熟悉的那一位。自己有很厉害的经历,加上在小破站传道授业,打下了响当当的知名度。

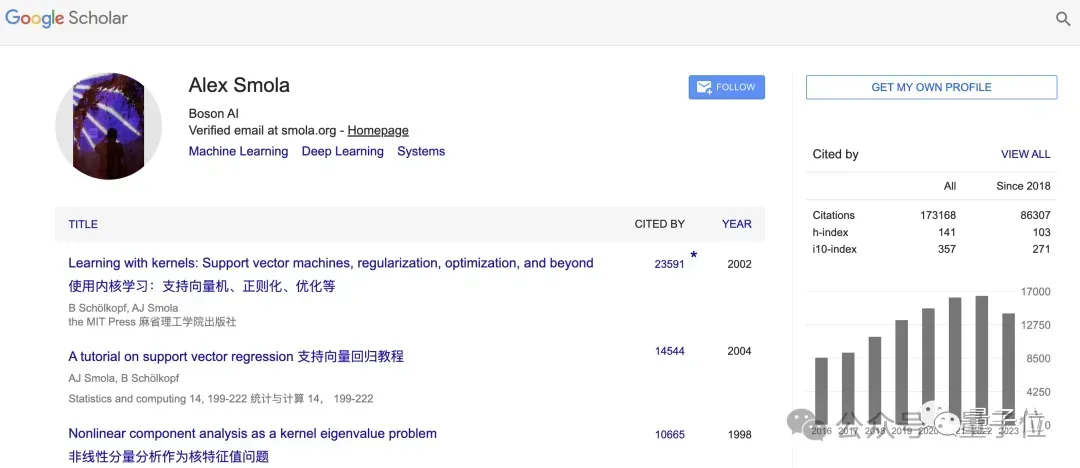

而Alex Smola,更是一个AI届的神级大牛。

直接上数据:Smola在Google Scholar上的被引用次数,超过17万次。其中,被引次数前三的所著论文,被引数统统破万。

除了是ML著作《动手学深度学习》的主要作者外,Smola这些年的履历也很值得好好了解一番——

1996年,Smola在慕尼黑工业大学完成硕士学业,而后又在柏林工业大学拿下计算机科学博士学位。博士毕业后,他先后去往柏林GMD软件工程和计算机体系结构研究所、NICTA(澳大利亚信息与通信技术研究中心)工作。

2004年起,Smola在NICTA的统计机器学习项目中,担任高级首席研究员和项目负责人;到了2008年,Smola选择入职雅虎研究院。

2012年春天到2014年年底,2年多的时间里,Smola的工作地点是谷歌研究院。

期间,他开始担任CMU的教授。也是这个时候,他成为了李沐的博士导师,二人结缘。

2016年7月,Smola成为了亚马逊的一员,致力于构建AI和机器学习工具。首要任务之一,是让AWS和开发者社区建立和保持联系,让更多的开发者共同建设亚马逊深度学习库MXNet。

离职创业前,Smola在亚马逊担任的职位是杰出科学家和副总裁。

值得一提的是,由于Smola在分布式深度学习框架领域曾提出并行LDA(Latent Dirichlet Allocation)的框架——这是参数服务器概念的最早来源,因此,Smola也被业界称为参数服务器之父。

其他四位成员如下。

Shuai Zheng,2019年从香港科技大学获得计算机科学博士学位。

之后就职亚马逊,领导亚马逊的分布式系统和LLM训练工作,包括开发可扩展的分布式训练和推理架构、具有数千亿参数的更智能模型,以及更快的分布式优化算法。

施行健,2014年本科毕业于上海交通大学,2018年获香港科技大学博士学位。

曾担任亚马逊担任高级应用科学家,领导过两个项目:AutoGluon Multimodal和DeepEarth。

其中AutoGluon Multimodal通过应用基础模型,突破了传统自动机器学习工具的限制。DeepEarth致力于为地球科学领域构建基础模型。之前他还参与了如Apache/MXNet等开源项目。

Yi Zhu,加州大学默塞德分校博士学位。

同样曾在亚马逊AI团队,担任高级应用科学家。研究主要关注大语言模型、多模态学习、自监督学习和视频理解,曾参与AutoGluon、GluonCV等开源项目。

Yizhi Liu,2012年毕业于浙江大学计算机系。

曾先后在百度实习,担任聚胜万合首席软件工程师、奇虎360技术部经理,之后成为亚马逊高级软件开发工程师。

最后,量子位认识的一位团队成员推荐大家用不同的人设、persona来测试Higgs-Llama-3-70B,“可能有惊喜哦”。

以及One more thing …

大神李沐创业,肯定是不缺投资的,量子位听闻,张一鸣已经打钱支持了。

不过一切以官方信息为准吧。祝福李沐老师一切顺利~

参考链接:

[1]https://boson.ai/about/

[2]https://szhengac.github.io/

[3]https://sxjscience.github.io/

[4]https://bryanyzhu.github.io/

[5]https://www.linkedin.com/in/yizhi-liu-20810558?original_referer=https%3A%2F%2Fwww.google.com%2F

文章来自于微信公众号量子位,作者西风

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner