GTP-4o挑战悬赏八百万的超难数据集,实现SOTA!

数据集当中包含了各种类型的图形推理题目,被挑战发起者预言“大模型很难完成”。

结果短短一周之内,这一挑战就被一位博主Ryan Greenblatt完成了一半,准确率达50%;而此前的SOTA仅为34%。

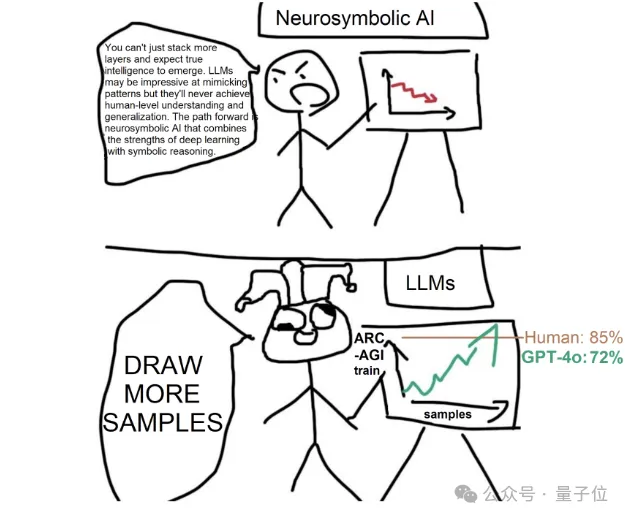

针对自己的成果,Ryan发了一个表情包表示:

只要有更多的样本,大模型的能力就能获得提升。

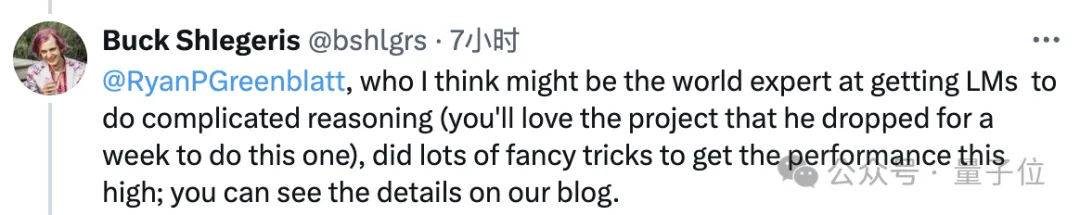

成果发布后,Ryan所在机构CEO Bucket Shlegeris称赞他是世界级的语言模型推理专家,用了很多精致技巧让模型的表现提高到了这样的程度。

要知道,挑战的发起方此前开出了最高50万美元(约360万人民币)、总计110万美元(约798万人民币)的巨额赏金。

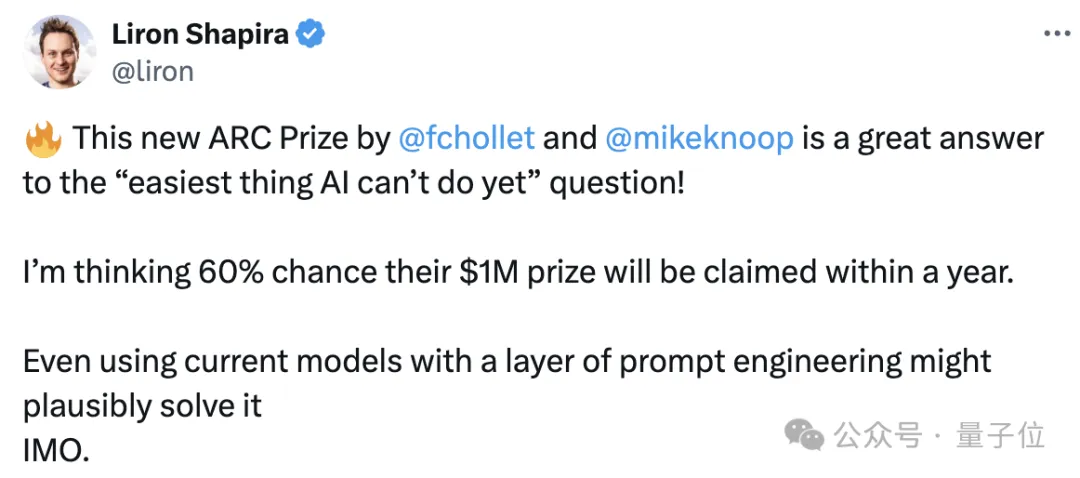

但有人预计,有60%的概率在未来一年内就会有人获得奖项,甚至现有的模型加上一些提示技巧就能实现。

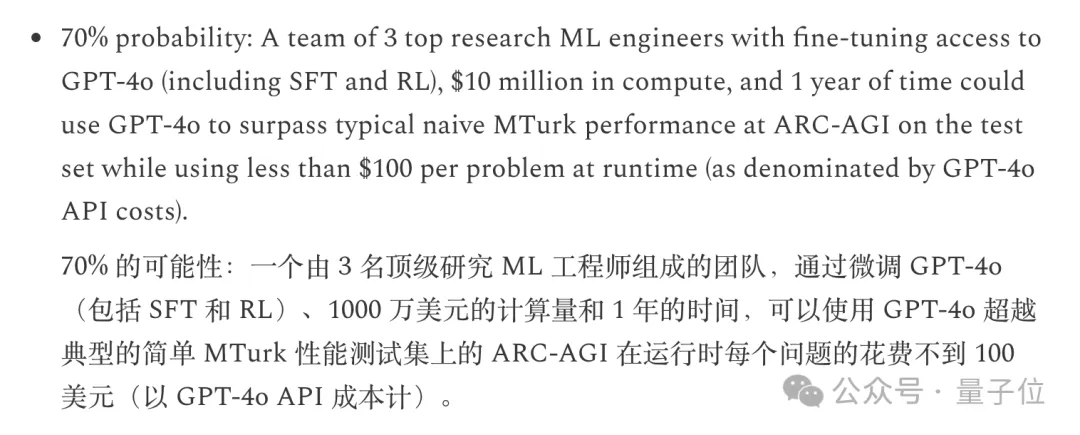

这也与Ryan的想法不谋而合,不过Ryan估计的概率更高些,是70%。

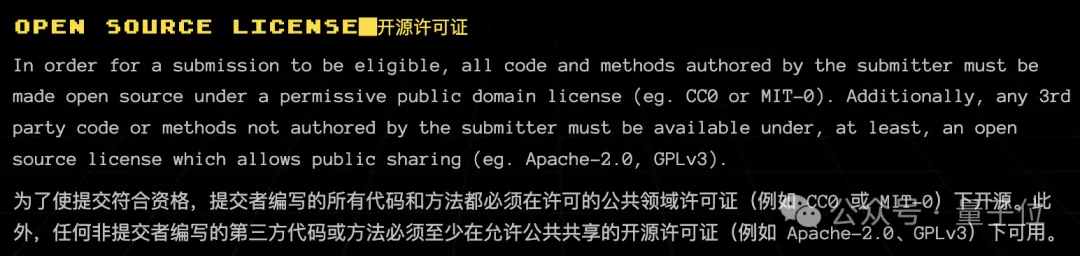

然而按照规则,想得奖的话,方法必须是开源的,而Ryan用的是GPT,所以可能与奖金无缘了。

不过,Ryan用到的的方法,还是值得我们了解一下的。

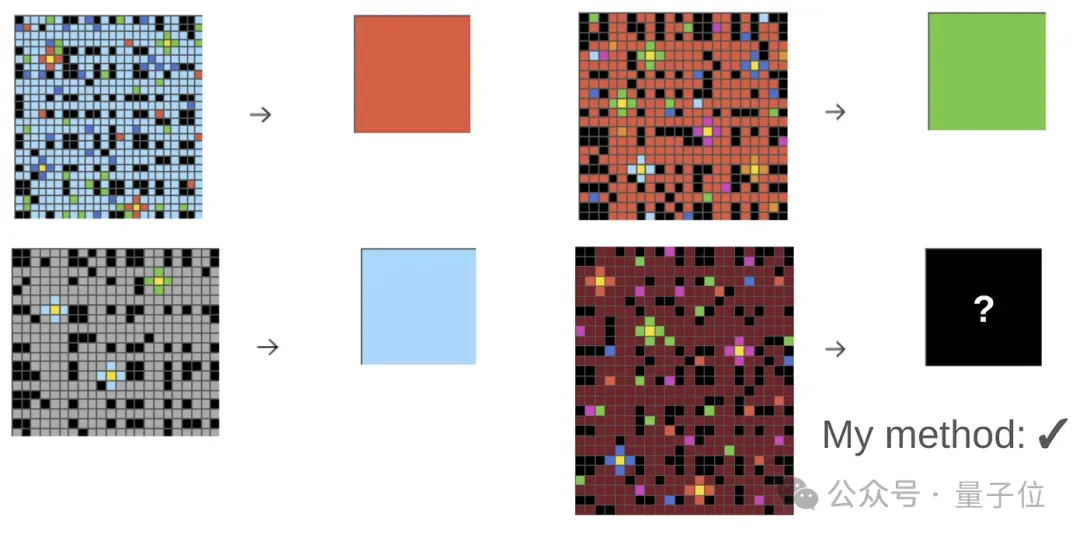

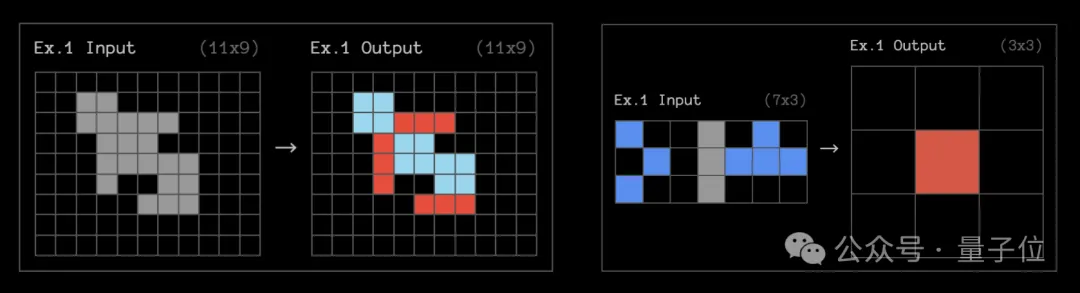

Ryan挑战的测试集名为ARC-AGI,题目带有色块的网格阵列,大模型需要观察每道题目中3个输入/输出示例,然后根据规律填充新的空白网格。

当然,实际测试中的问题,会比上面的例子复杂得多。

首先,Ryan根据网格大小是否发生变化,把测试集中的问题细分成了两类。

对于每个问题,Ryan都会把网格以图像和ASCII字符两种方式输入给GPT-4o。

其中,ASCII字符包括以下内容:

对于后面需要修正的程序,还会把实际输出与期望输出的的差异(ASCII字符形式)一并输入给模型。

根据前面不同的分类,Ryan会用不同的少样本提示词指示GPT-4o,提示词中包含这三项指令:

对每个问题,Ryan会从GPT-4o的回答中采样约5000个完成结果,对程序进行筛选与修正。

采样得到的完成结果首先会被转化为Python程序并在测试用例上运行,然后选出在所有例子上都正确的程序。

接着,在剩余的程序中,Ryan设计了一个汉明距离度量方式,并据此从中选出最有希望的12个。

对这12个程序,Ryan会让GPT-4o尝试修正其中的错误 ,首先用少样本提示词要求模型获取实际输出与期望输出差异,然后对每个待修正的程序再采样约3000个完成结果。

最后,Ryan会选择经过筛选和修正后能正确解决所有例子的3个程序,如果符合要求的程序少于3个,则会使用一些启发式规则选出剩余的程序。

实际操作中,Ryan使用了多个不同的少样本提示词分别进行了上述过程,获得了多组候选程序,并在所有组的正确程序中进行多数投票,选出出现频率最高的3个作为最终结果。

此外,Ryan还使用了一些额外的策略,比如在训练集和测试集的不相交子集上进行迭代优化,通过局部搜索等方法寻找更好的提示词等

同时,他还引入了一些额外的规则,比如拒绝输出与输入完全相同的解,从而更好地筛选出有用的程序。

最终,Ryan的方法在ARC-AGI公开测试集上达到了50%的准确率,成为了新的SOTA,此前的SOTA为34%,而在训练集(难度低于测试集)的一个子集上,该方法达到了72%的准确率。

不过Ryan同时指出,GPT-4o的视觉能力依然有待提高,同时还存在编程、长上下文和指令遵循能力不足,以及缓存空间不够等问题,如果这些问题能够被解决,将显著提高Ryan所用方法的效果。

那么,ARC Prize究竟是一项怎样的挑战?

这项ARC Prize,由零代码SaaS平台Zapier联创Mike Knoop和谷歌资深工程师François Chollet发起并出资。

项目顾问则包括GitHub前CEO Nat Friedman、前Y-Combinator合伙人Daniel Gross,以及瑞士企业家Pascal Kaufmann。

官方指出,现有的大多数AI基准测试都在衡量模型的“技能”,但“技能”并不等于“智力”,并表示“智力”指的是有效获取新技能的能力。他们认为,“智力”型的任务对人类很简单,但对于AI来说很难实现。

为此,活动方选择了一套测试数据集,也就是Ryan挑战的ARC-AGI,旨在评判大模型的“智力”,或者说“AGI能力”,并激发人们对于新算法和架构的探索,而不是单纯增加数据规模。

该数据集出现的时间是在2019年,去年有300个团队进行了尝试,今年的挑战则于6月11日开启。

按照规则,参赛者需要在这个数据集上取得更高的准确率,同时提交者必须将自己编写的代码完全开源,使用的第三方工具也至少要有允许共享的开源许可。

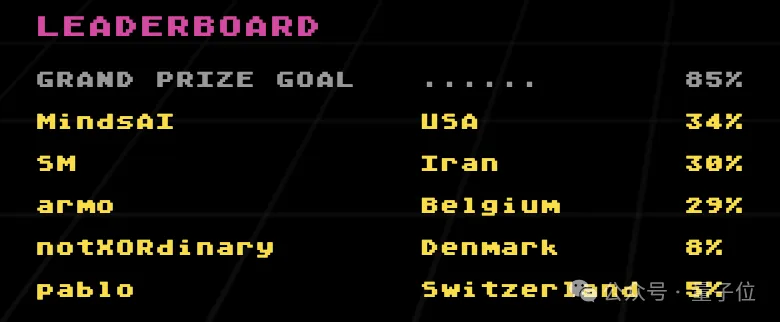

在Ryan之前,已经提交的方案中最高的准确率为34%,而官方设置的“成功”标准,也是他们预估的人类水平,为85%。

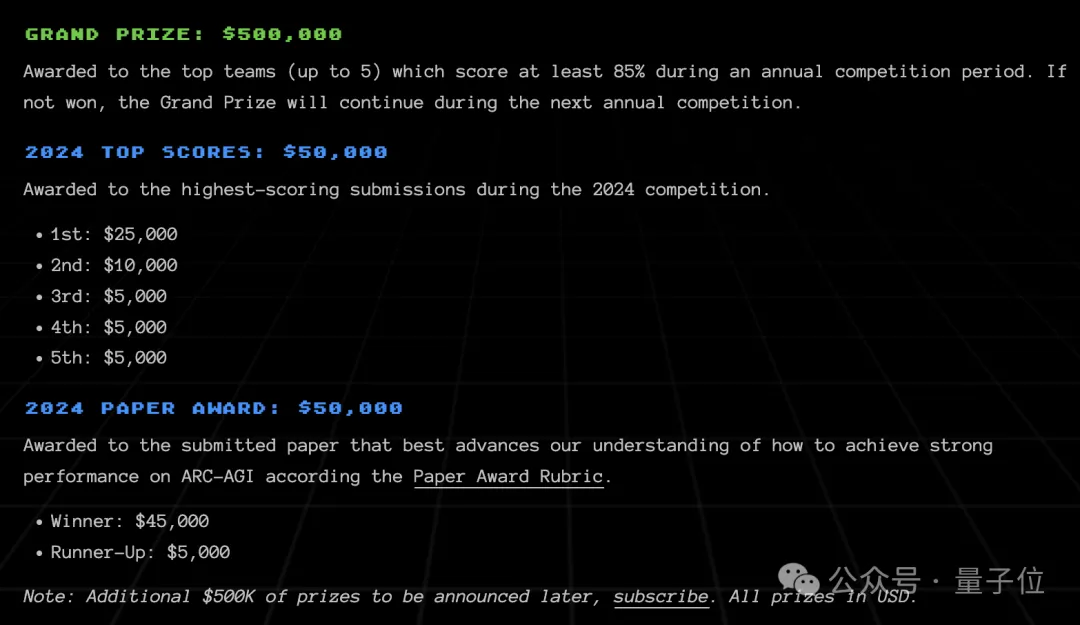

大赛一共设置了110万美元的奖金,目前已公布标准的奖项共计60万美元,还有50万美元的评奖方式等待官宣。

在已公布的60万美元中,有50万美元(约360万人民币)的大奖,获奖队伍不超过五个,奖给最先在ARC-AGI上达到85%准确率的团队。

还有高分奖五名,将获得5000-25000美元不等的奖励,共计5万美元。

此外还有一项论文奖,会颁发给能够帮助人们了解如何在ARC-AGI上实现更好表现的团队,冠亚军奖分别获得45000和5000美元。

按照官方赛程,提交的截止日期为11月10日,获奖名单则会在12月3日公布,对这项挑战感兴趣的话,不妨试一试。

参考链接:

[1]https://redwoodresearch.substack.com/p/getting-50-sota-on-arc-agi-with-gpt

[2]https://arcprize.org/

[3]https://x.com/liron/status/1800643034263990432

文章来自于微信公众号 “量子位”,作者 “克雷西”

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0