在当今的多模态大模型的发展中,模型的性能和训练数据的质量关系十分紧密,可以说是 “数据赋予了模型的绝大多数能力”。

在这其中,图像 - 文本数据集发挥着至关重要的作用,在图像理解、文本生成和图像检索等多个领域发挥着关键作用。

然而,现有的图像描述数据集主要来源于网络抓取和人工标注,存在着质量参差不齐、细节缺失、描述噪音多等问题。尽管人类可以为图像提供详细的描述,但高昂的标注成本限制了其规模和可行性。因此,迫切需要一种高效、可扩展的方法来生成准确且详细的图像描述。

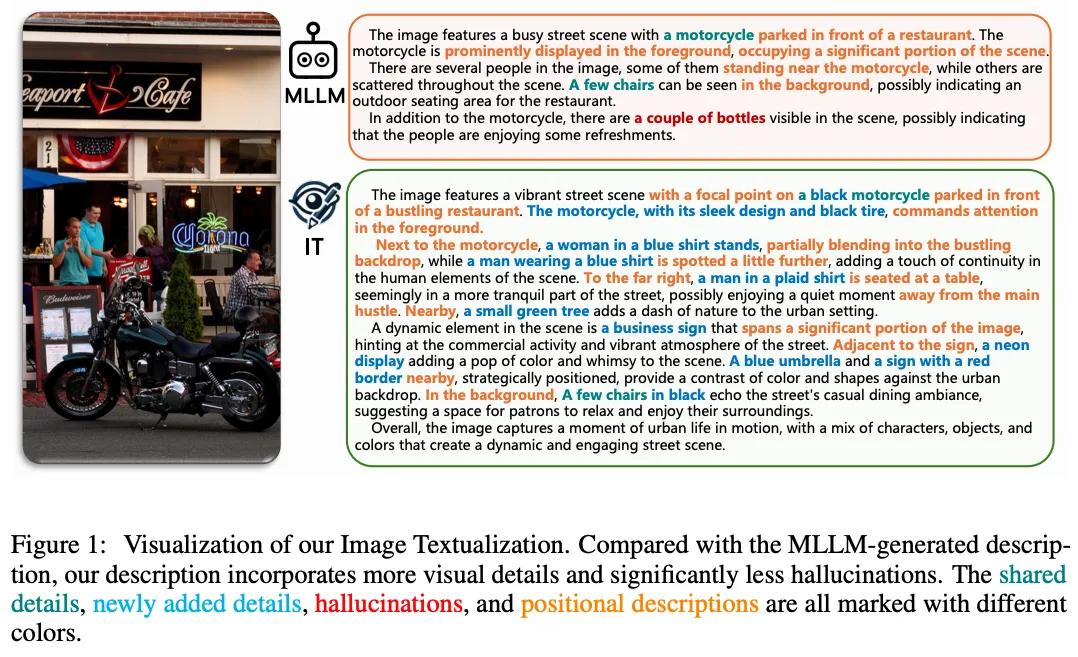

为了应对上述挑战,来自香港科技大学、武汉大学、浙江大学、UIUC的研究者联合提出了一种创新的自动化框架 ——Image-Textualization(IT),该框架通过整合多模态大语言模型(MLLMs)和多种视觉专家模型的协作,将图片信息进行文本化,最后利用拥有强大的推理能力的纯文本大语言模型将这些文本化的信息转化为高质量的图像描述。

利用多模态模型造的图片描述 vs 利用 IT 生成的图片描述

总的来说,本文贡献包括:

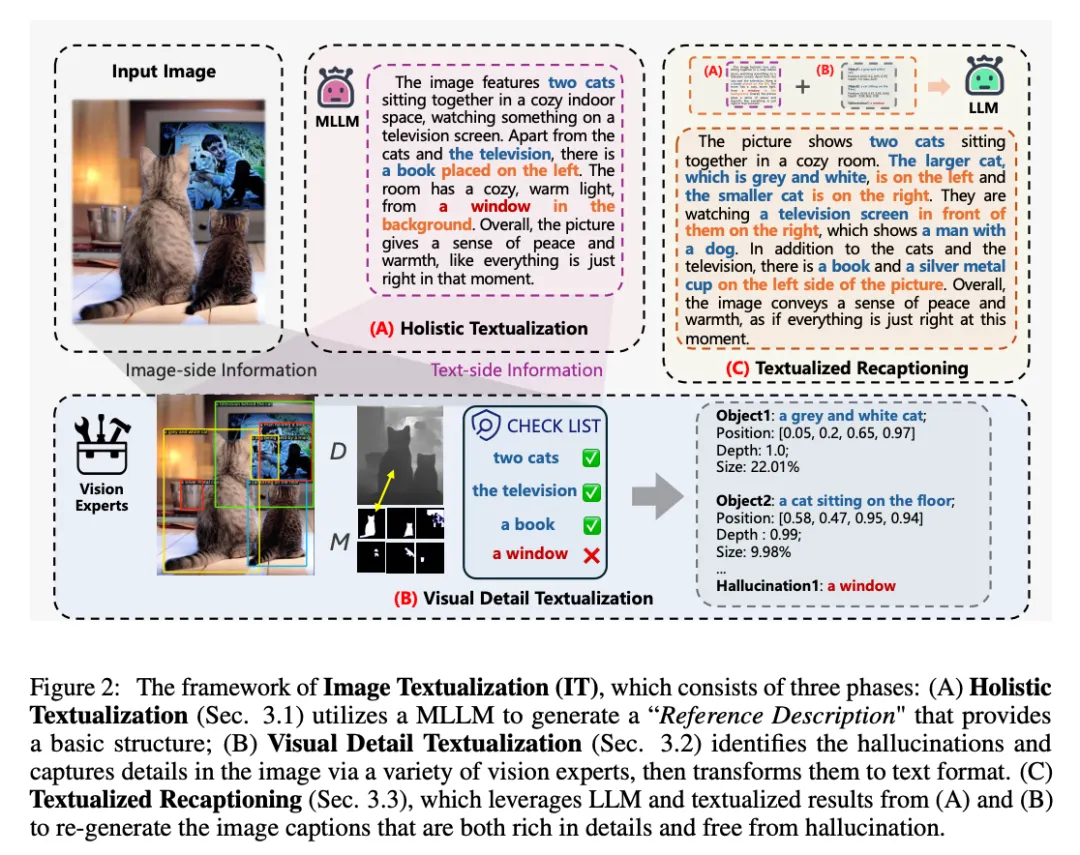

Image-Textualization(IT)框架包括以下三个阶段:

1. 粗粒度的图片文本化(Holistic Textualization):首先利用多模态大语言模型对图片生成参考描述,尽管这些描述可能存在细节缺失和幻觉,但它们为图像的视觉信息和语言表达提供了基本结构。这里视觉的结构主要体现在参考描述中往往会包含一些大的,核心的物体,这个可以为后续的细节提供类似 “锚点” 的作用,能够使得最后的文本化重述(Textualized Recaptioning)更好的添加细节。另外,语言表达上的结构主要体现在多模态大模型包含的纯文本大语言模型使得其拥有较强的语言能力,这使得这里生成的参考描述能够在语言上有良好的组织,比如会先说出这个图片大概描述了些什么,然后展开细节,最后总结,这种描述风格较为偏向人类的偏好。这也能够使得最后的文本化重述(Textualized Recaptioning)能够在一个语言能力较好的模板上进行加工。

2. 视觉细节文本化(Visual Detail Textualization):这个阶段我们同时从图片端和文本端进行细节的提取。

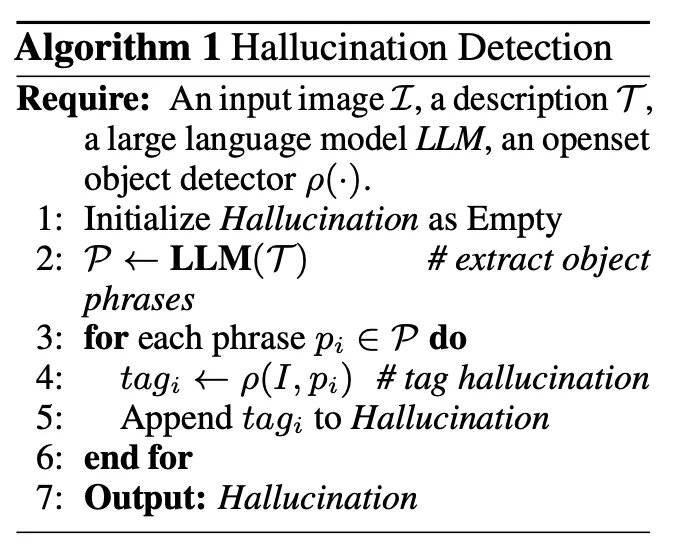

首先是文本端,由于在上一阶段中我们利用多模态大模型生成的参考描述可能含有幻觉,所以这里首先做的是 “幻觉检测”。我们首先利用 LLM 去抓取参考描述中含有的实体,再利用了一个开集检测器去图片里对这个实体进行匹配,如果没有被检测出来,则将这个实体判断为幻觉。这里我们把检测出来的幻觉也进行了文本化,在最后的文本化重述(Textualized Recaptioning)进行删除。

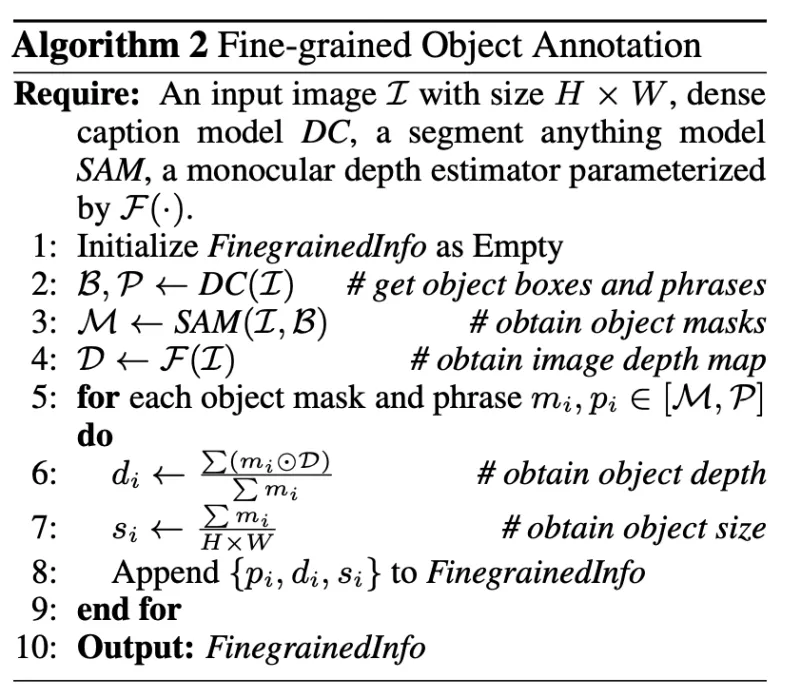

在视觉端,我们利用在高分辨率图片上训练出来的各个任务上的视觉专家模型提取图像中的细节信息。想要将一个图片上的物体的细节信息利用文本表达出来仅仅用物体的 caption 是不够的,我们首先利用提取这些物体的 bounding box 来把这些物体的左右关系给用文本的方式体现出来。但图片中的物体不仅仅有左右信息,还有前后信息。对此,我们首先利用分割模型将这些物体的 mask 给提取出来,再将原本的图片转化为深度图,通过计算深度图中特定物体 mask 对应的深度分数来将深度信息由文本体现出来。至此,我们能利用文本还原出图片中各个物体的大小,左右位置,前后关系等细节信息。

3. 文本化重述(Textualized Recaptioning):结合前两个阶段的图片信息文本化的结果,加上我们通过精心设计的改写 prompt,纯文本的大语言模型能够很好的通过纯文本还原出图片的信息,并通过强大理解和推理能力生成详细且准确的图像描述。

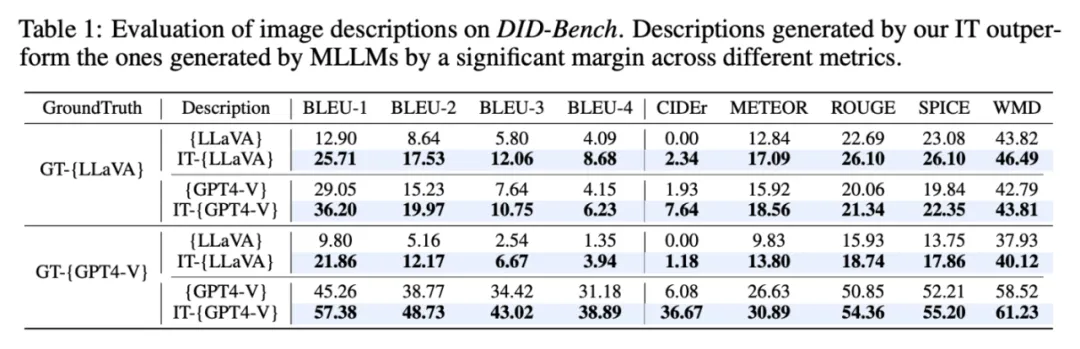

为了验证我们框架的有效性,我们构建了三个评估基准,分别是 DID-Bench(详细图像描述基准)、D2I-Bench(描述到图像基准)和 LIN-Bench(语言基准)。我们进行了广泛的实验,结果表明 IT 框架生成的图像描述在细节丰富度和准确性方面显著优于现有方法。尤其是,通过我们的 IT 框架生成的数据集训练的 MLLMs,如 LLaVA-7B,展现出了更强的图像描述能力,减少了幻觉现象。

DID-Bench(详细图像描述基准):用于评估图片描述和人类手动标的详细的图片描述的相似性。可以看到我们的修改后的 IT-{LLaVA} 和 IT-{GPT4-V} 图片描述都比修改前的要更详细和准确,更贴合人类标注出来的描述。

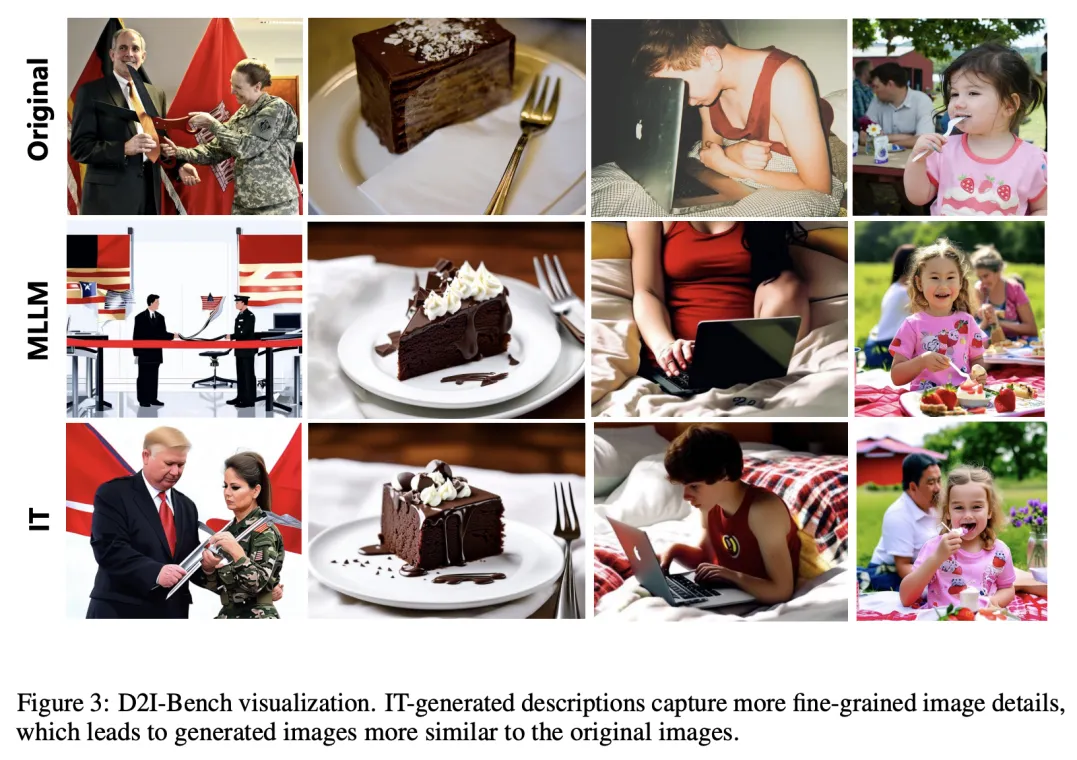

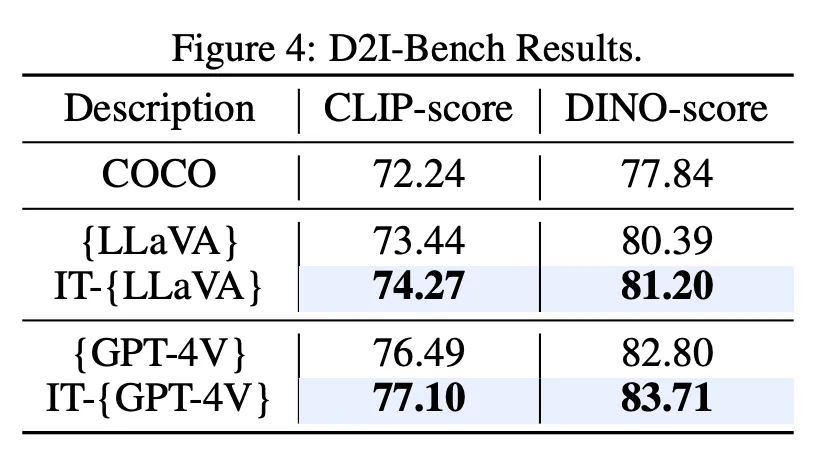

D2I-Bench(描述到图像基准):利用文生图模型将生成的描述转化为图片,和原图进行相似度的对比,这里我们选取了 CLIP-score 和 DINO-score 进行评估,都能达到更高的分数。

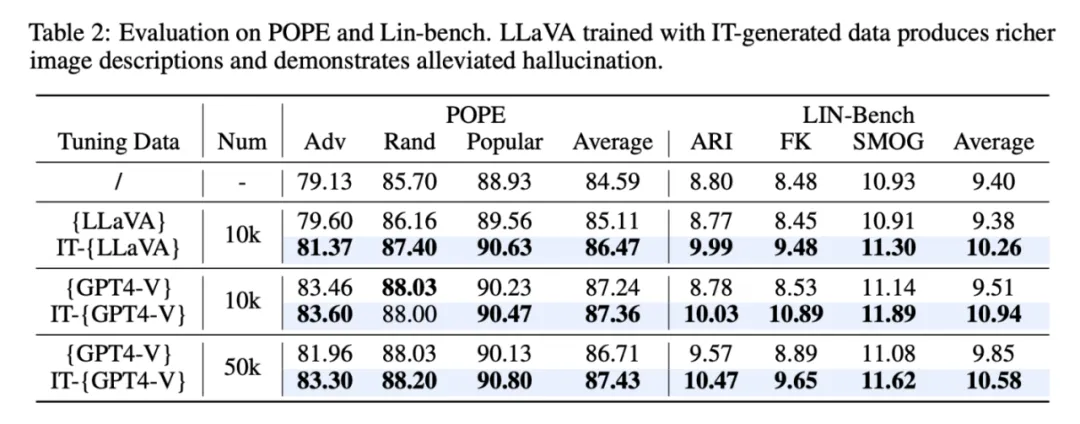

另外我们还在 POPE 和 LIN-Bench 上验证了利用我们框架生成数据进行训练的 LLaVA-7B 能够在生成描述更详细更复杂的情况下(表右侧 LIN-Bench),还能降低幻觉(表左侧 POPE 基准)。

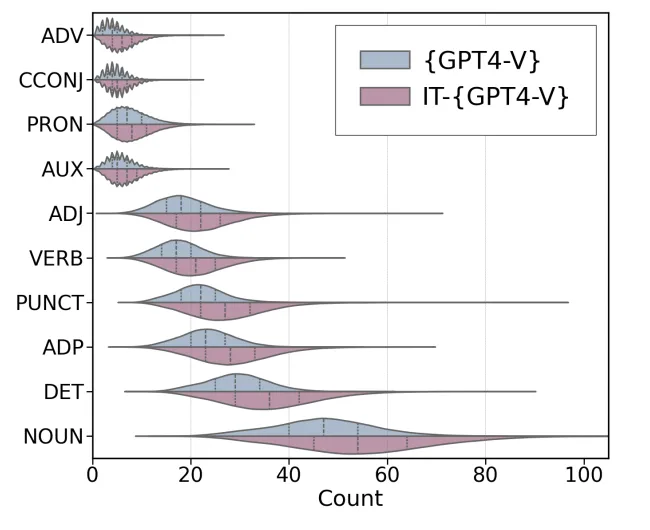

最后,我们对生成出的数据进行了统计上的对比,可以看到我们修改后的描述中各个词性的数量上都能有较大的提升。

我们的工作不仅解决了现有图像描述数据集的局限性,也为设计更高效、可扩展的方法提供了灵感。我们期待 IT 框架在更多应用领域中展示其潜力,推动图像理解和生成技术的进一步发展。

文章来自于微信公众号“机器之心”,作者 “机器之心”