一边造火箭,一边造新能源车,一边在推特评论区到处冒泡的马斯克继Grok 1.5发布后继续为自己的AI初创公司造势。

在回帖中,马斯克宣布xAI的大语言模型Grok 2将于8月推出。

并且马斯克为大家划重点:在数据训练方面将有大跨步。

Grok是马斯克正式进入生成式AI这条赛道推出的AI聊天机器人,来自一个与OpenAI、谷歌、Meta等巨头同时扳手腕的初创公司xAI,不仅开源还造超算中心,可谓野心勃勃。

自今年3月以来,xAI陆续推出了Grok 1.5大语言模型和首个多模态模型Grok1.5 Vision。

xAI曾表示,Grok 1.5V在多学科推理、文档理解、科学图表、表格处理等多领域「都能媲美现有的前沿多模态模型」。

今年5月,马斯克表示,xAI是一家新公司,因此Grok仍有大量准备工作要做,才能与谷歌Deepmind和OpenAI相抗衡。

后来者要居上,xAI一直在暗暗发力,直指模型性能,期望能给大公司上压力。

Grok 2:数据训练飞跃或有效解决「人体蜈蚣效应」

马斯克宣布Grok 2将在8月推出这条回帖的原帖也颇有意味。

原帖中,Cohere首席执行官Aidan Gomez表示,由于许多人工智能模型都是根据OpenAI的输出结果进行训练的,因此会产生「人体蜈蚣效应」,即模型会产生相同的输出结果。

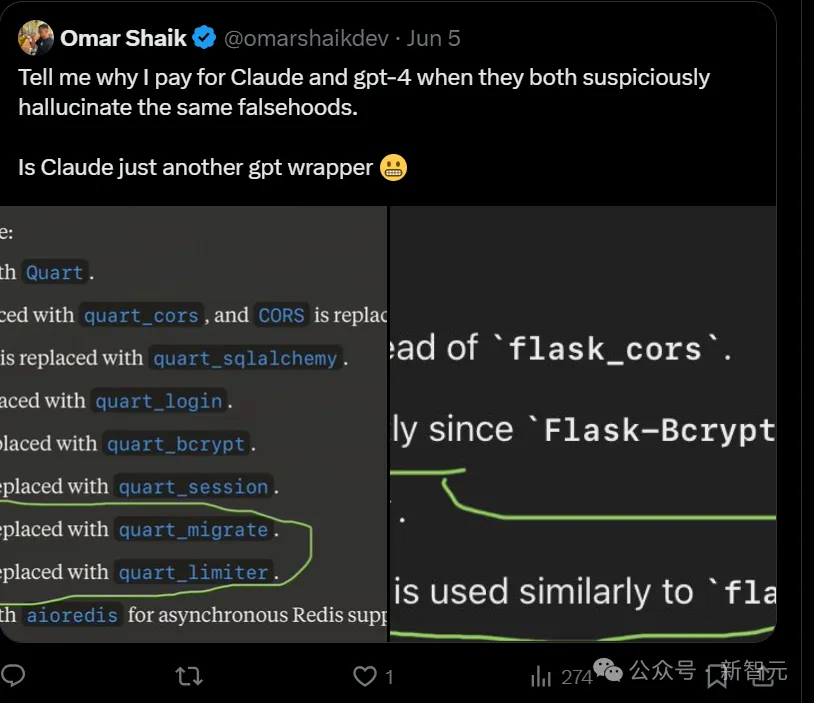

对于这一现象,使用大语言模型的用户应该深有体会。

有一位推特网友发现,他虽然付了GPT-4和Claude两份的钱,却得到了同一份相同的错误答案。

这个千载难逢的抹黑GPT的机会,马斯克自然不会错过。

他与OpenAI之间的战火早已弥漫了4个月,前段时间甚至向法院发起诉讼,指控OpenAI违反合同。

于是,借此天赐良机,马斯克狠狠地拉踩OpenAI,为即将推出的Grok造势。

他发帖表示,从互联网语料中清除掉LLM合成的错误数据,形成高质量数据集需要大量的工作,而8月份推出的Grok 2将是这方面的巨大进步。

消息一出,前脚才被OpenAI封锁API,后脚又被鸽GPT-4o语音功能的伤心用户们纷纷表示,要转投这个出身豪门的Grok的怀抱。

等不及了!我老早就用Grok比GPT用的多了!

等不及看到下一代Grok了!Grok 2公布之日,就是OpenAI退订之时。

奥特曼表示:

Grok 3:豪掷40亿美元买10万个H100训练模型

马斯克公布完Grok 2发行时间,继续回复表示Grok 3将在年底推出。

并且在经过10万个英伟达H100 GPU的训练后,将成为「特别的东西」。

的确特别,首要就是特别壕。

一笔订单十位数。那个无人在意的角落里,老黄又靠「卖铲子」赚翻了。

科技公司都在竞相打造更加智能的人工智能产品,H100自然成为这场AI军备竞赛的香饽饽。

H100 GPU作为AI的关键组件、硅谷的热门商品,据估计每块成本在3万到4万美元之间,马斯克的十位数订单可能有团购价。

这意味着,Grok 3正在价值30亿至40亿美元的人工智能芯片上接受训练。但目前还不清楚这些芯片是否是xAI直接购买的,从云服务提供商那里租用GPU计算也是可能的。

The Information在5月份报道称,马斯克的xAI初创公司正在与甲骨文公司洽谈,准备斥资100亿美元租用云服务器。

可以确定的是,马斯克的xAI近年来的确直接购买了大量的H100。

例如,据报道,特斯拉首席执行官将原定用于特斯拉的一批价值5亿美元的英伟达H100转用于xAI。

可以想到,基于10万个GPU训练的Grok 3将比Grok 2更上一层楼。

马斯克在今年4月接受挪威主权基金负责人Nicolai Tangen采访时说,Grok 2需要大约2万张H100来进行训练。

到目前为止,xAI已经发布了Grok 1和Grok 1.5,最新的Grok 1.5只提供给早期测试者和X(前身为Twitter)上的用户。

评论区也尤其关注了Grok 2和Grok 3的用户使用范围,可以看出,大家对10万张H100训练出来的模型颇有期待。

10万个GPU听起来确实很多,但是,像Meta这样的其他科技巨头正在购买更多的GPU。

Mark Zuckerber今年1月表示,到2024年底,Meta将购买约35万个英伟达H100 GPU。

并且,Meta将拥有包括其他GPU在内的约60万个芯片。也就是说,Meta将花费约180亿美元打造AI芯片。

H100芯片的囤积数量,也成为AI人才衡量公司实力的重要标准。

人工智能初创公司Perplexity的创始人兼首席执行官Aravind Srinivas谈到,他曾试图挖一名Meta的人工智能研究人员,但遭到拒绝,部分原因是Zuckerber保有了大量H100芯片。

Srinivas表示,我想从Meta聘请一位非常资深的研究员,你知道他们怎么说吗?

这位研究员无情拒绝,「等你有1万个H100 GPU的时候再来找我吧。」

由此可见,AI的核心是掌握算力,要想掌握数据,就得掌握运行数据芯片。

数据中心亲自监工

买买买之后,「工作狂」马斯克自然不会停下脚步。

分析师Adam Jonas在6月26日公开表示,如今AI数据中心在美国各地落地,导致美国周边电网用量激增。

而特斯拉迅速扩张的储能业务将帮助xAI在AI大战中占领一席之地。

这不,supermicro CEO和创始人Chales Liang发推公布和马斯克在数据中心的合照。

非常感谢马斯克引领液冷技术进入大型AI数据中心!新技术有可能帮助地球保护200亿棵树免于砍伐!

网友调侃道,马斯克要不就别睡了,要不数据中心打个地铺眯一会儿。

根据美国对数据中心的节能要求,全国范围内新建数据中心要求PUE<1.2,而传统的风冷制冷方式已经无法满足数据中心的散热需求,更加高效的液冷方案应运而生。

如何降低能耗也一直是各家公司关注的核心问题,而液冷技术具有冷却效率高、节能环保、稳定性强的优点。

因此,在人工智能领域,随着AI智算的需求爆发,液冷方案已经成为AI数据中心的首选。

文章来源于“新智元”,作者“新智元”

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/