英伟达又双叒迎来强劲挑战者了。

成立于2016年的初创公司Groq在最新一轮融资中筹集了 6.4 亿美元,由 BlackRock Inc. 基金领投,并得到了思科和三星投资部门的支持。

目前,Groq的估值已经达到28亿美元。

公司创始人Jonathan Ross曾在谷歌从事TPU芯片的开发,而Groq目前的顶梁柱LPU也是专门用于加速AI基础模型,尤其是LLM。

Ross表示,一旦人们看到在Groq的快速引擎上使用大语言模型有多么方便,LLM的使用量将会进一步增加。

以更低的价格和能耗,达到与英伟达芯片相同的速度,甚至更快,让Groq有底气叫板英伟达。

值得一提的是,Groq还宣布,图灵奖得主LeCun即将担任技术顾问。

LeCun的正式加入,成为Groq在竞争激烈的芯片领域一个强大的盟友。

每秒1256.54个token,快如闪电

天下武功,唯快不破。

而能打败每秒响应800个token的Groq只有下一代的Groq。

从500 token到800 token再到1256.54 token/s,Groq如此之快的速度可谓是让一众GPU望尘莫及。

随着7月初新功能的低调发布,Groq现在的结果要比之前演示的要快得多,也智能得多,不仅支持文本查询,还能输入语音命令进行查询。

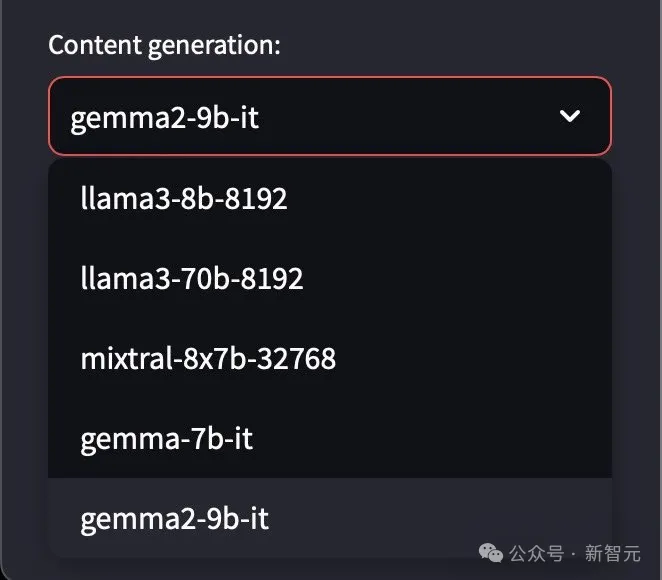

默认情况下,Groq 的网站引擎使用Meta的开源Llama3-8b-8192大语言模型。

用户还可以选择更大的Llama3-70b,以及来自Google的Gemma和Mistral模型,并且很快也将支持其他模型。

这种快速且灵活的体验对于开发者来说非常重要。在传统AGI处理数据时,等待是稀松平常的事情,要看着字符一个一个吐出来再进行下一步的操作。

而在最新版本的Groq中,以上任务几乎全部瞬间回答,快如闪电。

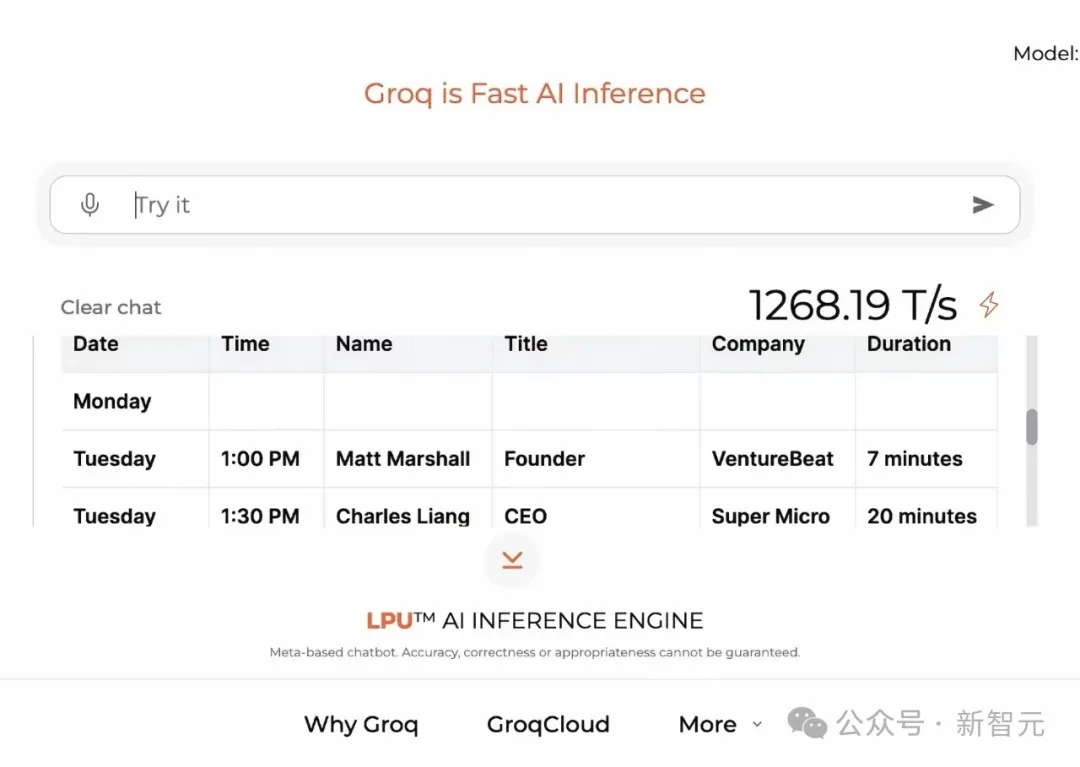

举个栗子。比如,在Groq上让它评论VB Transform活动议程有哪些地方可以加以改进。

1225.15token/s的速度——几乎就在一瞬间回答就弹了出来。

而且内容也十分详细清楚,包括建议更清晰的分类、更详细的会议描述和更好的演讲者简介等等,共十点修改意见。

当语音输入要求推荐一些优秀的演讲者以使阵容更加多样化时,它立即生成了一份名单,姓名、所属组织和可供选择的演讲主题给你安排的明明白白的,并且以清晰表格格式呈现。

要求它追加一列联系方式,也瞬间补充好邮箱地址和推特账号,不在话下。

再举个栗子。视频中巴拉巴拉说了一分多钟,要求Groq为下周的演讲课程创建一个日程表格。

Groq不仅耐心地听懂了,创建了要求的表格,还允许快速轻松地进行修改,包括拼写更正。

还可以改变主意,要求它为我忘记要求的内容创建额外的栏目,耐心高效细致,甲方眼里的完美乙方不过如此。

还可以翻译成不同的语言。有时会出现发出了几次请求才做出更正的情况,但这种错误一般是在LLM层面,而不是处理层面。

可以说,从500 token/s到800 token/s再到如今直接拉到每秒四位数的生成速度,把GPT-4和英伟达秒的更彻底了。

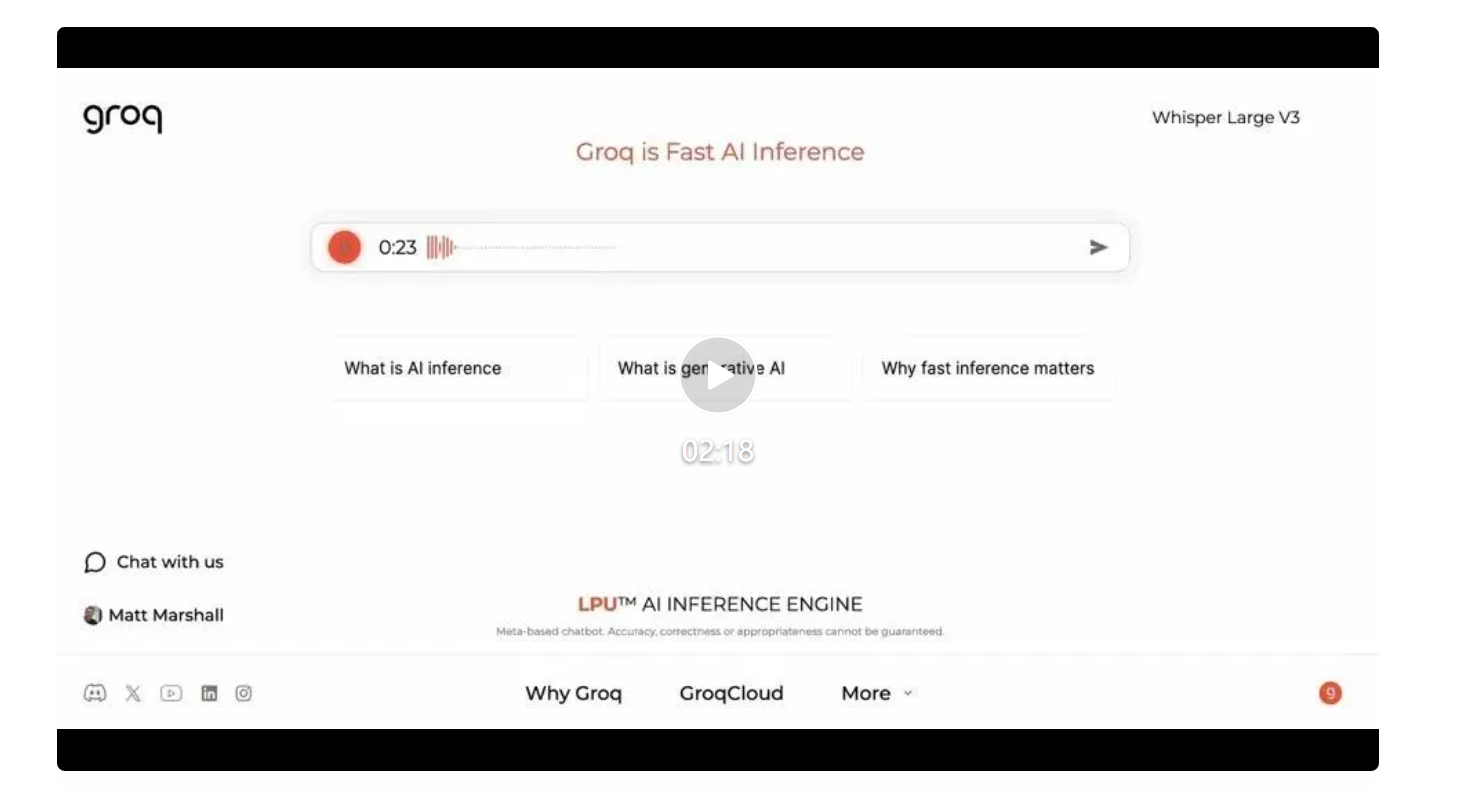

当然,除了「快」之外,此次更新的另一亮点是除了引擎内直接输入查询,还允许用户通过语音命令进行查询。

Groq使用了OpenAI的最新开源的自动语音识别和翻译模型Whisper Large v3,将语音转换为文本,然后作为LLM的提示。

提速增效再加多模态输入,不卡顿还能不打字,这种创新的使用方式为用户提供了极大的便利。

Groq + Llama 3强强联合

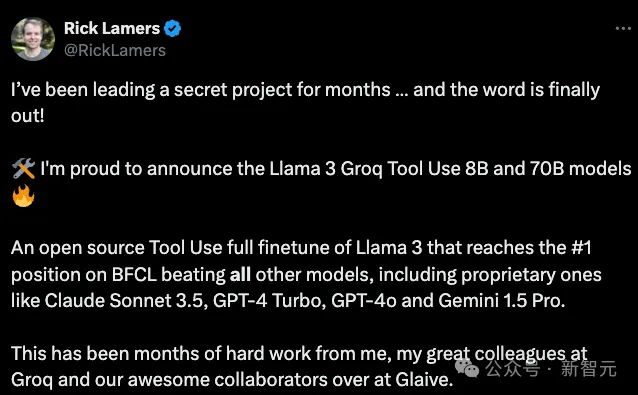

7月17日,Groq的研究科学家Rick Lamers又在推特上官宣了一个「秘密项目」——微调出的Llama3 Groq Synth Tool Use模型8B和70B型号 ,旨在提升AI的工具使用和函数调用能力。

团队结合了全量微调和直接偏好优化(DPO),并且完全使用符合道德规范的生成数据,没有涉及任何用户数据。

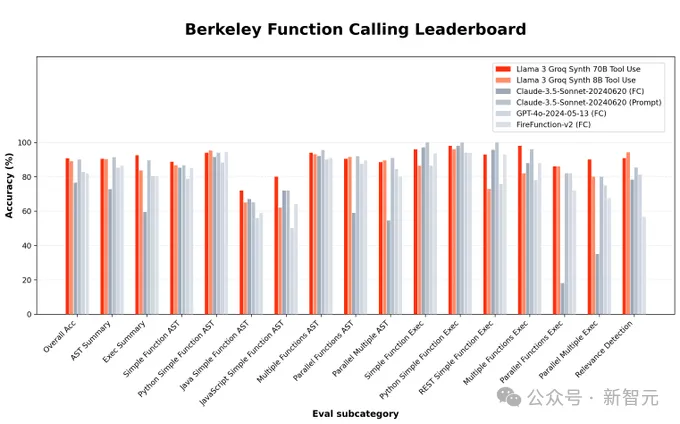

伯克利函数调用排行榜(Berkeley Function-Calling Leaderboard, BFCL)中的数据全部来源于真实世界,专门用于评估LLM调用工具或函数的的能力。

Groq本次发布的微调Llama3 8B和70B的版本都在BFCL上取得了相当惊艳的成绩,总体准确率分别为90.76%和89.06%。

其中,70B版本的分数超过了Claude Sonnet 3.5、GPT-4 Turbo、GPT-4o和Gemini 1.5 Pro等专有模型,达到了BFCL榜单第一的位置。

两个版本的模型都已开源,用户可从HuggingFace上下载权重或通过GroqCloud访问。

HugggingFace地址:https://huggingface.co/Groq

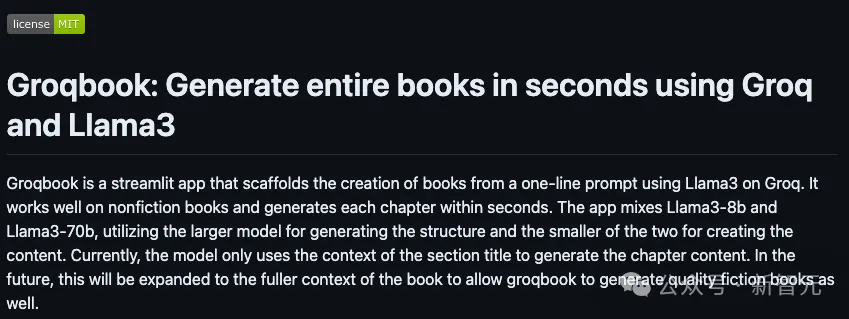

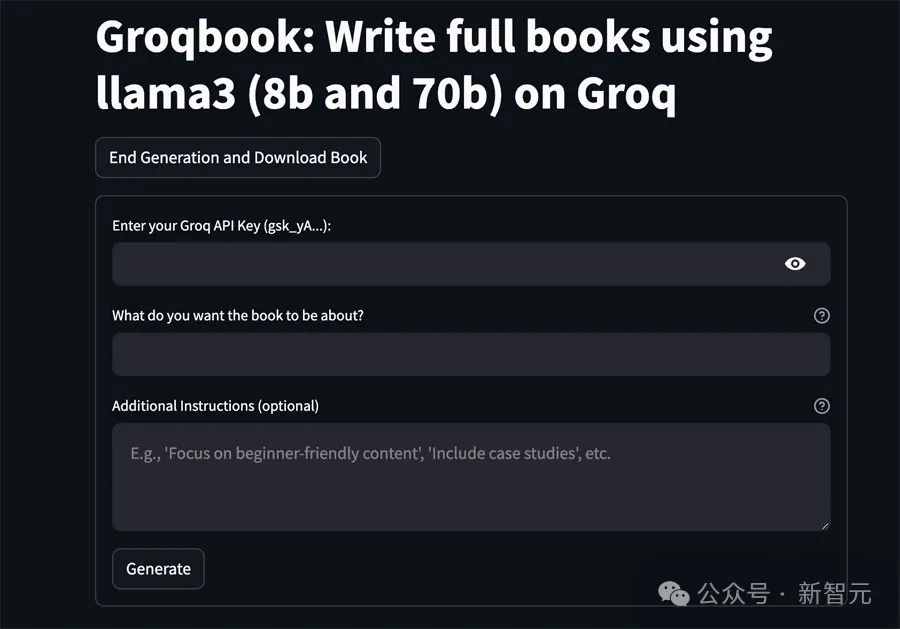

此外,Groq还在Llama 3的基础上进一步发挥自己「唯快不破」的秘籍,推出了一款名为Groqbook的应用程序,可以在1分钟内内生成出一整本书。

GitHub地址:https://github.com/Bklieger/groqbook

根据GitHub主页的介绍,Groqbook混合使用了Llama3-8B和70B两个模型,用较大模型生成结构,再让较小模型创作具体内容。

目前,这个程序只适用于非虚构类书籍,并需要用户输入每一章节的标题作为上下文。

Groq表示,未来将让Groqbook生成整本书内容,并扩展到虚构类书籍,创作出高质量的小说。

开发者4个月突破28万

解决了用户使用的核心痛点,Groq自然备受使用者欢迎。

上线4个月后,Groq已经开始免费提供服务来处理LLM工作负载,吸引了超过28.2万名开发者使用。

Groq提供了一个平台供开发者构建他们的应用程序,类似于其他推理服务提供商。

然而,Groq的特别之处在于,它允许在OpenAI上构建应用程序的开发者通过简单的步骤在几秒钟内将他们的应用程序迁移到Groq。

Ross表示他将很快专注于需求量极大的企业市场。大公司正在广泛推进AI应用的部署,因此需要更高效的处理能力来应对他们的工作负载。

Groq表示,其技术在最坏情况下使用的功率约为GPU的三分之一,而大多数工作负载仅使用十分之一的功率。

在LLM工作负载不断扩展、能源需求持续增长的背景下,Groq的高效性能对GPU主导的计算领域构成了挑战。

Nvidia虽然擅长AI训练但在推理方面存在局限,Groq的芯片在推理速度和成本上都有数倍优势,未来推理市场的份额将从现在的5%提升到90%-95%。

Ross自信声称,到明年底将部署150万个LPU,占据全球推理需求半壁江山。

LPU:快,真的快

目前来说,模型训练虽然首选GPU,但是部署AI应用程序时,更高的效率和更低的延迟也极为重要。

正如Groq第一次闯入大众视野是因为一个字,「快」,Groq此次提速继续在速度的赛道狂飙。

Groq承诺可以比竞争对手更快更经济地完成任务,在一定程度上得益于其语言处理单元(LPU)。

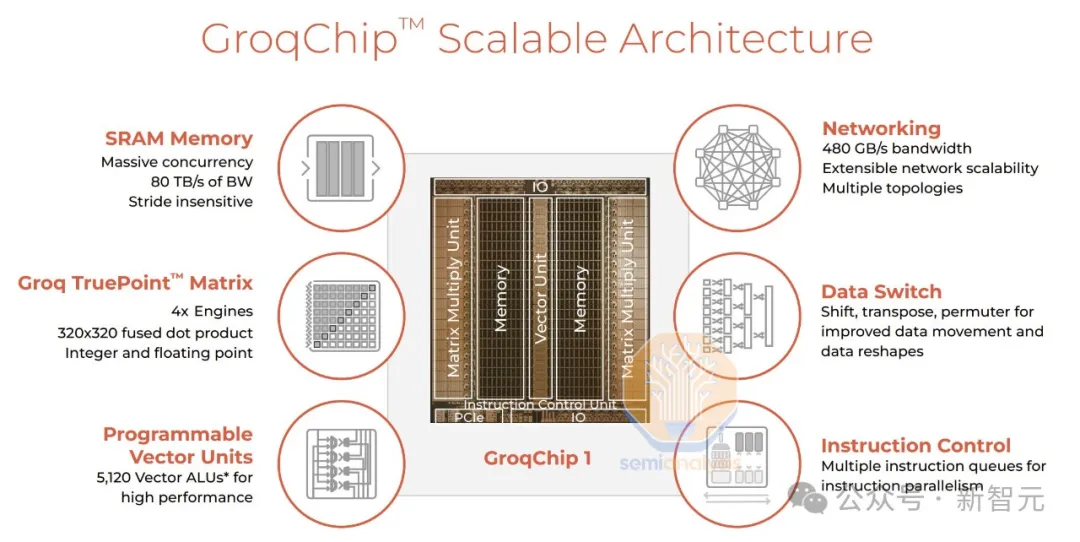

相比GPU,LPU减少了管理多个线程的开销,并避免了核心利用率不足。此外,Groq 的芯片设计还允许连接多个专用核心,而不会出现 GPU 集群中出现的传统瓶颈。

LPU的工作原理和 GPU存在显著差异,具体来说,LPU采用的是时序指令集计算机(Temporal Instruction Set Computer)架构,这一架构的特性就是无需像依赖高带宽存储器(HBM)的GPU那样,频繁地从内存中加载数据。

LPU不依赖外部内存,其权重、键值缓存(KV Cache)和激活函数等数据在处理期间全部存储在芯片内,不仅能够巧妙规避HBM短缺所带来的困扰,还能切实有效地削减成本。

与Nvidia GPU对高速数据传输的依赖有所不同,Groq的LPU在其系统架构中并未采用HBM,而是选用了SRAM。

由于每块芯片只配备了230MB的SRAM,没有任何复杂的模型能够仅通过单个芯片运行。值得一提的是,SRAM的速度相较GPU所使用的存储器约快20倍。

鉴于AI的推理计算所需的数据量相较于模型训练大幅减少,Groq的LPU展现出更为出色的节能优势。

在执行推理任务时,其从外部内存读取的数据量显著降低,所消耗的电量也明显低于GPU。

遗憾的是,英伟达的GPU可以同时用于训练和推理,但LPU仅为模型推理设计。

文章来源于“新智元”,作者“新智元”

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner