敲响警钟还是走向封闭?

「ACL 不是 AI 会议(ACL is not an Al conference)」,在泰国曼谷举办的 ACL 2024 上,今年的 ACL 主席 Emily M. Bender 抛出了一个极具争议的结论。

ACL 大会是计算语言学和自然语言处理领域的顶级国际会议,由国际计算语言学协会组织,每年举办一次。一直以来,ACL 大会在 NLP 领域的学术影响力都位列第一,它也是 CCF-A 类推荐会议。

近年来,随着深度学习等方法成为 NLP 研究的主流,越来越多的人将这一会议视为 AI 会议,大部分投稿都和 AI 相关。Emily M. Bender 似乎看到了这种倾向的一些弊端。

在演讲中,她强调了 ACL 作为计算语言学协会举办的年会(Annual Meeting of the Association for Computational Linguistics),其核心并非人工智能,而是更专注于语言技术和计算语言学。

Bender 明确指出,她不将 AI(人工智能)作为 ML(机器学习)的同义词。她认为机器学习(包括深度学习)为语言技术和计算语言学提供了许多有用的技术,但当焦点转移到 AI 时,就会出现问题。

计算语言学和自然语言处理(CL/NLP)关注的是语言的相似性 / 差异性、信息在语言中的表示方式、如何构建技术来帮助不同语言的转录、翻译、摘要、信息获取等,以及如何评价这些技术、哪些中间表示对这些技术有用、不同 ML 技术对不同任务的效果如何、语言技术如何与现有的权力体系相互作用。

AI 领域的问题包括如何构建能够进行类似人类推理的思考机器,如何使这些机器在认知工作上超越人类,如何自动化科学方法,以及如何自动化创造性工作等。

AI 领域还提出了一些观点,例如人类的命运是与机器融合成为超人类,奇点的到来是不可避免的,以及 AI(实际上是合成文本机器)可以替代我们彼此之间应提供的服务(教育、医疗、法律代表)。

AI 领域存在多种问题,包括来自风险资本和亿万富翁的强烈兴趣等。

Bender 还批评了 AI 领域的一些不良研究实践,如不当使用基准测试、要求与 SOTA 的封闭模型进行比较评估、数据集过大导致缺乏保留数据等。Bender 表示,如果你的研究问题集中在「如何证明我的机器具有智能」上,那么这种关注点可能会扭曲研究实践。

她还指出,AI 领域的焦点导致了糟糕的审稿实践,例如不使用大型语言模型(LLMs)或不提供 SOTA 大小的 LLM 结果的论文可能会被认为不感兴趣。

与 AI 领域的不良实践相对比,CL/NLP 领域的研究最佳实践包括对技术的适用性、对人类语言行为的理解、良好界定的评估、内在和外在的评估、坚实的基线、保留的测试数据和详细的错误分析。

Bender 表示,CL/NLP 研究建立在对数据的理解上,包括对语言如何工作的知识(即语言学)和数据集文档。

在可复制性和可重现性方面,Bender 强调了科学是关于在先前研究基础上构建,而不是仅仅为了达到 SOTA。

在社会影响方面,CL/NLP 研究关注其技术对社会的影响,包括伦理和 NLP 研究的历史,以及理解语言和技术将被谁使用、为谁使用、对谁使用,以及谁可能因被排除或包括而受到伤害。

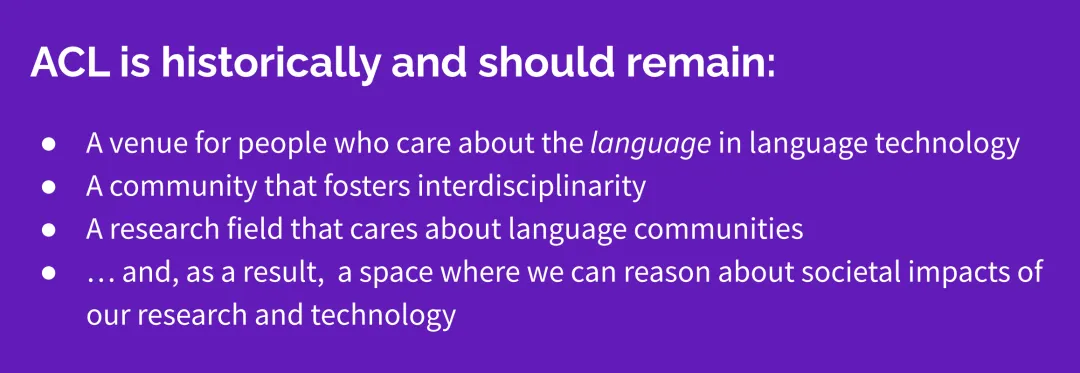

Bender 认为,ACL 应该是一个关注语言技术的场所,一个促进跨学科研究的社区,一个关心语言群体的研究领域,并且是一个我们可以理性讨论我们研究和技术对社会影响的空间。

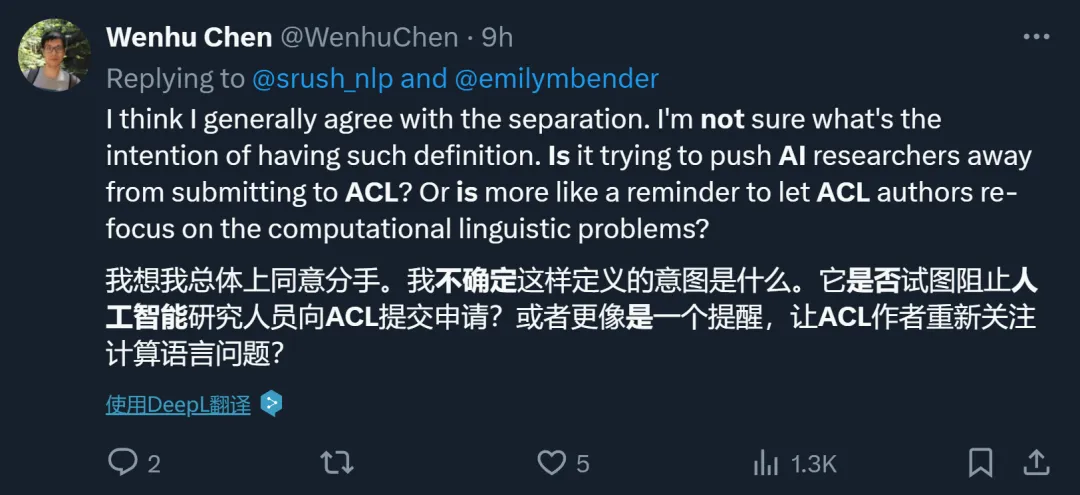

这一观点在社交平台上引起了很大争议。

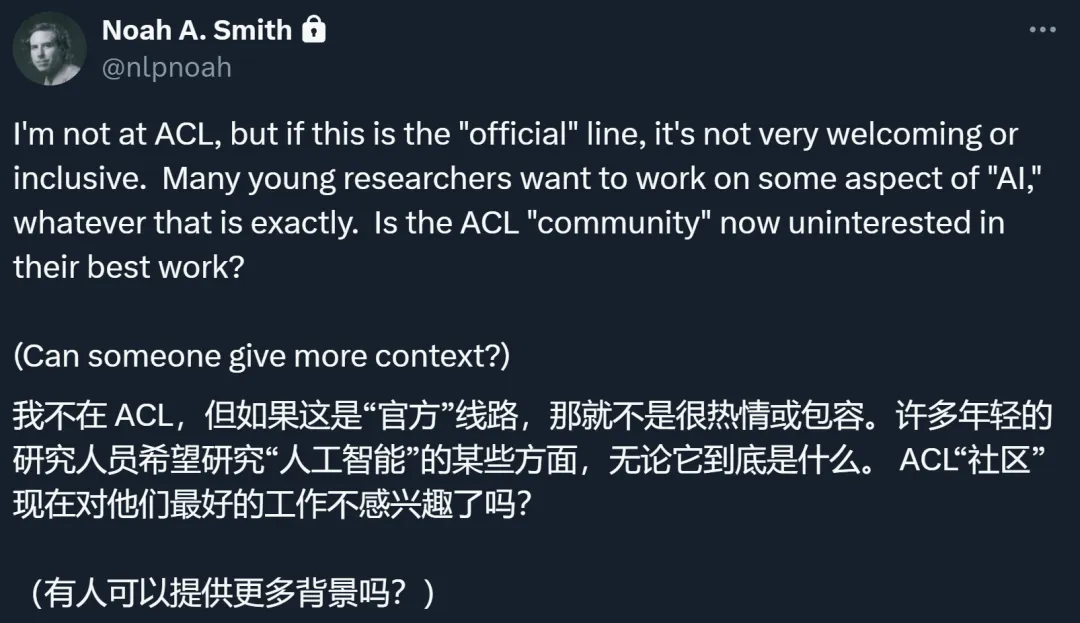

有人认为,这是一种不够包容的表现,「NLP 历史上最好的时刻发生在人们对其他学科的想法持开放态度的时候:从语言研究人员那里学习统计方法,从社会科学家那里学习如何看待世界。这些幻灯片让我觉得有些人想让我们走向封闭。」

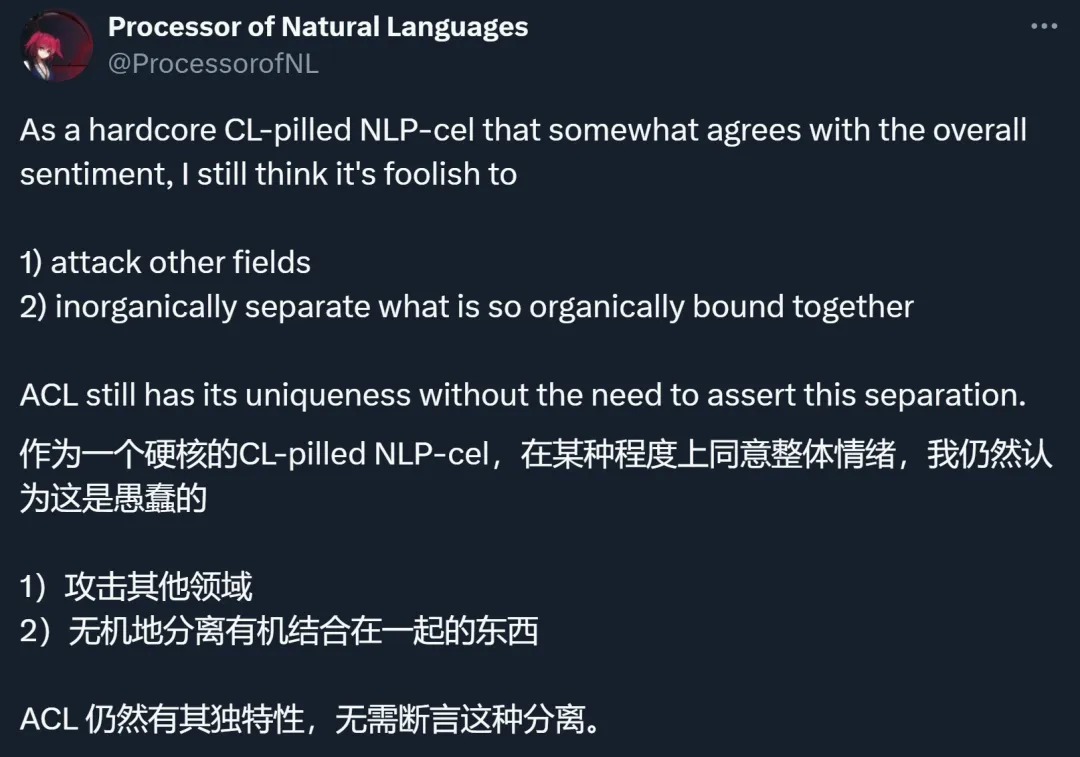

还有人认为,做这种分割完全没有必要,因为二者已经有机地融合在一起。

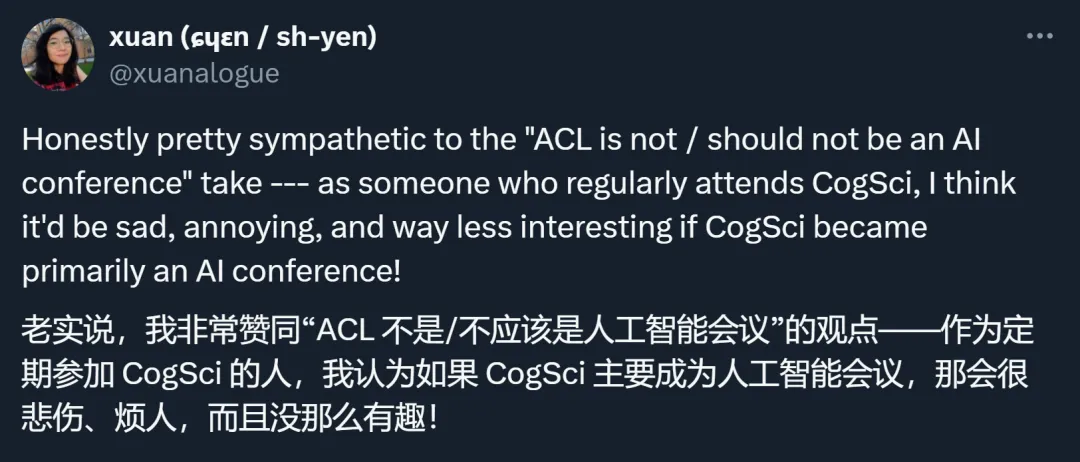

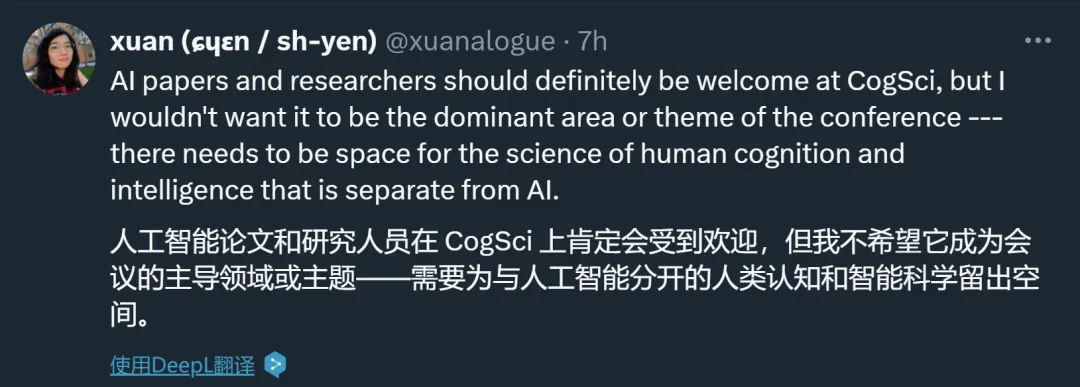

不过也有人表示理解,毕竟 AI 风头太盛,一旦某个会议被 AI 论文「承包」,其他领域的研究势必受到冷落,这将使该会议失去原本的趣味。

对于这个演讲传递的信号,大家也开始猜测:这是不是意味着 ACL 不欢迎 AI 论文了?

对此,你怎么看?

文章来源于“机器之心”