随着人工智能技术的广泛应用,人们认为AI可以避免人类常见的认知偏差。然而,AI本身可能会表现出类似于人类的偏差,例如锚定效应。本文通过回顾“系统1”和“系统2”两个思维模式,探讨AI在这两种模式中的运作方式,分析AI产生认知偏差的原因,并通过具体实验展示AI在面对锚定效应时的表现。本文进一步探讨如何在理解这些局限性的基础上,合理利用AI来改善人类决策质量,并强调AI透明性和可解释性的重要性。

关键词:认知偏差、锚定效应、系统1、系统2、决策辅助、透明性、可解释性。

“犯错是人之常情,但要真正搞砸一切,你需要一台电脑。” (To err is human, but to really foul things up you need a computer.)

—— 保罗· R·埃尔利希(Paul R. Ehrlich)

适合读者

易读性(7/10)、专业性(8/10)、知识性(8/10)

1. 对人工智能与心理学交叉领域感兴趣的研究人员

2. 从事AI开发与应用的技术工程师

3. 对认知偏差与决策科学有兴趣的学者与学生

本文目录

前言

一、快思考 vs. 慢思考

二、AI出现认知偏差的原因

三、如果AI有偏差,我们该如何利用它来改善人类的决策?

四、锚定效应和峰终定律

五、【实验28】锚定效应、主观判断与AI模型的决策

结语

参考文献与说明

前言

有人认为,人类是理性的动物。然而,在我们日常生活中,决策往往并非完全理性。无论是在购物、投资,还是选择保险产品时,我们的判断都可能受到某些无意识的心理倾向——即认知偏差的影响。认知偏差如锚定效应和峰终定律,常常在我们不知不觉中引导我们做出决定。这些偏差不仅存在于个人的思维中,也同样可能体现在人工智能的决策过程中。

随着AI技术的发展,许多人开始依赖AI来辅助决策,认为它可以避免人类的主观偏见,提供更客观的判断。然而,AI能够完全避免这些认知偏差吗?如果AI也会犯类似的错误,我们又该如何理解和利用AI,来提升人类的决策质量?这些问题值得我们深入探讨。

在本文中,我们探讨如何利用AI来优化决策、减少认知偏差。首先,回顾心理学家丹尼尔·卡尼曼提出的“系统1”和“系统2”这两个关于人类思维模式的概念,并探讨AI在这些模式中的表现。接着,我们会分析AI为什么会表现出认知偏差的倾向,并讨论如何识别和应对这些偏差。最后,通过具体的实验案例,我们将展示AI如何在面对锚定效应等偏差时表现出局限性,并探讨这种偏差在实际保险销售应用中的影响。

希望通过这篇文章,能够帮助读者快速理解AI的优势与不足,进而在实际应用中更加理性地利用这项技术来优化决策过程。

一、快思考 vs. 慢思考

诺贝尔奖得主、心理学家丹尼尔·卡尼曼(Daniel Kahneman)在其著作《思考,快与慢》(Thinking, Fast and Slow),提出了“系统1”与“系统2”两个概念(注1)。系统1代表快速、自动化、无意识的思维方式。它依赖直觉和经验,能够迅速做出反应,但有时可能不太准确。系统1在处理熟悉的、简单的、惯性的任务时非常有效。系统2代表较慢、深思熟虑、有意识的思维方式。它需要更多的认知资源,适合处理复杂、陌生的任务,或者需要逻辑推理的情境。系统2更为准确和理性,但它的运作速度较慢。

人类的认知偏差主要来源于系统1。为什么?系统1是我们大脑中的快速、自动化、无意识的思维系统。它依赖于直觉和经验,在面对复杂或不确定的环境时,系统1能够迅速做出反应,这在很多情况下是有用的。然而,正是由于系统1的这些特点,它也容易引发认知偏差。

相比之下,系统2是较慢、深思熟虑的思维系统。当我们意识到可能存在认知偏差,或者面对复杂的问题需要进行仔细分析时,系统2会介入。系统2可以帮助我们修正系统1所产生的偏差。然而,系统2的介入需要更多的认知资源和时间,因此人类往往依赖系统1的自动化反应,这也导致了认知偏差的频繁发生。

那么,由人类所创造的基于大量数据训练的语言模型GPT(Generative Pre-trained Transformer)呢?

GPT的运作机制更接近于系统1而不是系统2。它通过统计分析和模式识别来生成文本,与系统1的快速反应、依赖直觉与经验的特性相符。虽然GPT可以生成看起来合理的回答,但它并不具备真正的理解和深思熟虑的能力,这使得它在复杂推理和逻辑分析上更接近系统1,而不是系统2。

在《误解与偏见:探索保险规划中的认知挑战——保险交易存在的问题,用一句“销售误导”便可以说明一切吗?》一文中,我们探讨了保险规划过程中由于人类认知错觉与偏差所引发的挑战(注2)。文章指出,保险交易中经常出现的问题,如销售误导,并非完全由业务员素质问题造成,而是更深层次的源自于用户和业务员在理解需求和产品价值上的巨大落差。文中引用了卡尼曼的上述观点,介绍了各种常见的认知偏差及其对决策过程的影响,比如锚定效应、损失厌恶和计划谬误,并提出通过大模型技术来识别和纠正这些偏差的策略。不同于传统的“让你做对”的策略,该文提出“避免错误”的方法来优化保险规划过程。通过理解和利用已知的认知偏差,主动引导用户避开这些陷阱,从而确保规划结果更加准确并符合用户的需求。文章介绍了几种具体的方法,如情景模拟、逆向规划和情绪平衡法等,以及通过不同提示如何在实践中应用这些策略,帮助规划师在实际工作中更好地引导用户。

然而,你或许会有疑问:这篇文章似乎是基于AI本身不存在认知偏差为前提。但是,从上述对于系统1和系统2的说明,AI不是存在认知偏差吗?我们需要花点时间回头检视这个前提的可靠性。

二、AI出现认知偏差的原因

虽然AI被设计成一个理性和客观的工具,但在某些情况下它也可能表现出类似于人类认知偏差的行为。出现这些偏差的原因来自多个方面,使得AI的决策和判断并不像我们想象的那样完美。

举例来说,AI的判断能力主要依赖于它接受过的训练数据。因此,如果数据本身就存在偏差,比如不够多样性或含有某种刻板印象,那么AI便可能学习到这些偏差。例如,如果AI的训练数据主要来自某一特定群体,它在处理其他群体的类似情况时,便可能会表现出偏颇。

一个人在做决定时,可能会不自觉地更重视某些因素而忽略其他因素。AI的算法设计者通常会给某些特征赋予更多的权重,或者在处理复杂任务时进行简化。这种设计可能会导致AI在某些情况下出现系统性错误,从而影响它的公正性和准确性。

AI的偏差也可能来自开发者和用户的主观判断,而人类本身就有各种的偏见和主观倾向。就像一个老师在教学生时,可能会不自觉地将自己的观点传递给学生,开发者在选择训练数据、设定参数或定义任务目标时,也可能在无意中将自己的偏见融入到AI系统中。

所以,虽然AI被设计为理性工具,但它对各种形式的偏差并不能完全免疫。这提醒我们在使用AI系统做决策时,需要保持警惕,不能盲目依赖,同时需要不断优化这些系统,以减少它们的偏差,确保AI真正能帮助我们做出更好的决策,而不是引入新的问题。

利用AI来缓解人类认知偏差,并帮助我们做出更好的决策,这听起来是个非常有吸引力的目标。然而,如果AI本身也会犯错,那么我们又该如何理解“利用AI来改善人类的决策”这个目标呢?

图片由DALL-E生成

AI的优势与挑战

AI的许多优势让它在决策辅助中特别有用。举个例子,当我们面对大量数据时,人类的大脑会感到不知所措。想象一下,你要从成千上万的保险中挑选一个最适合自己的产品,这听起来是不是很让人头疼?AI可以在短短几秒钟内处理这些数据,并告诉你哪一个选项最适合你的需求。更重要的是,AI在这个过程中不会因为情绪、疲劳或其他外部因素的干扰而改变它的判断。AI的“冷静”和“一致性”让它能够在一定程度上减少人类在决策过程中常犯的情绪性错误,包括过于乐观或过于悲观。

然而,AI本身也有局限性。正如前面的介绍,AI的决策能力很大程度上依赖于所接受的训练数据和算法,如果这些数据本身就有偏差,AI便可能采用这些偏差,甚至放大它们。这种局限性就像是一个只看过一部电影的人试图评论整个电影行业,他的观点不可避免地会带有偏见。

AI与人类的协同工作

如何利用AI来帮助我们做出更好的决策?关键在于将AI的优势与人类的判断力相结合。我们可以通过模拟已知的偏差,对AI进行训练,使其能够通过分析大量数据来发现我们可能忽略的细节,并提供有针对性的提醒。例如,在保险规划中,AI可以模拟不同的风险情境,展示各个保险选项的潜在影响,帮助我们识别那些可能被情绪或直觉掩盖的事实。通过这种方式,AI能够引导我们做出更符合自身利益的选择。

尽管AI能够提供有力的建议,最终的决策权仍然在我们自己手中。这意味着我们不能完全依赖AI做出决定,而是应该将它的分析结果作为参考,同时结合我们的经验、直觉以及对具体情况的了解来做出最适合的决定。比如,当AI推荐一种保险方案时,我们可以问自己:为什么AI会给出这样的建议?这个建议是否真的符合我的需求?通过这样的思考过程,我们能够更好地理解AI的判断,做出更加理性的选择。

保持透明与可解释

为了使AI真正成为一个有效的决策辅助工具,它需要具备良好的透明性和可解释性。换句话说,我们应该能够清楚地理解AI是如何得出某个结论的,这样才能对它的建议充满信心。想象一下,如果一个AI告诉你某种保险方案最适合你,但它无法解释为什么,那你会相信它吗?很可能不会。举例来说,当AI向一位50岁的用户推荐10年缴费期的年金险时,如果用户反问为什么不推荐20年缴费期的选项,AI需要具备解释“为什么”的能力(因为用户将在60岁时退休)。

相关性并不等同于因果关系,而因果关系通常具有更强的可解释性。因此,AI系统不仅要具备搜索相关信息的能力,更需要具备因果推理的能力。 设计者与工程师需要确保AI系统能够清晰地展示其分析过程和依据,以便用户更容易理解并接受AI的建议。

接下来,我们将进一步说明锚定效应这一常见的认知偏差,并通过与GPT的互动实验,真实展示大模型在面对锚定效应时可能出现的偏差。

四、锚定效应和峰终定律

不少人对锚定效应(强调第一印象)和峰终定律(强调亮点和最终记忆)感到混淆,我们先对它们做简要说明。在上篇文章,我们详细介绍了峰终定律,请读者自行参考(注3)。锚定效应和峰终定律是心理学中的两个有趣现象,它们揭示了我们如何在做决策和记住经历时表现出的偏差。理解这两个效应的异同,有助于我们更清楚地认识到这些偏差如何影响我们的日常生活。

锚定效应是一种在决策时很常见的心理现象。简单来说,当我们面对一个问题时,最先收到的信息,往往会对我们后续的判断产生不成比例的影响。例如,在购物时,如果你先看到了一件商品的高价标签,即使后续有折扣,你的脑海中仍会认为这个商品“很贵”,相对的你会认为其他价格低的商品“很划算”。这个最初的价格成了你的判断标准,这个参照点(锚点)影响了你对后续价格的感知。

峰终定律则更多地与我们如何回忆过去的体验有关。根据这一定律,我们往往不会记住一件事情的所有细节,而是会特别记住最高潮的时刻和结束时的感觉。比如,看一场电影,你可能会忘记中间的剧情,但你会记住最激动人心的场面和电影的结尾。这些亮点和结束时的感觉,往往决定了你对整场电影的总体评价。

这两种现象都表明了我们在面对信息时并非完全理性。锚定效应会让我们在决策时过度依赖第一个信息,而峰终定律则让我们在回忆时,主要依赖最高潮和结束时的感觉。它们都显示了我们的大脑是如何选择性地处理信息,无法全面而客观地看待每一个细节。

然而,锚定效应和峰终定律的影响方式和应用场景并不相同。锚定效应影响我们决策时的思考过程,尤其是当我们处理数字、价格或时间等具体信息时。峰终定律则关注我们的记忆过程,它影响的是我们如何回忆和感受过去的经历。锚定效应发生在我们接触信息的最初阶段,它让我们从一开始就被某个信息“固定住”。峰终定律则关注体验的过程,尤其是高潮和结束时刻的影响。

因此,锚定效应提醒我们在做决定时要警惕第一个信息的影响,而峰终定律则告诉我们,在回忆过去时,要特别注意那些突出的瞬间。这些认识可以帮助我们在生活中做出更理性而全面的判断和选择。

五、【实验28】锚定效应、主观判断与AI模型的决策

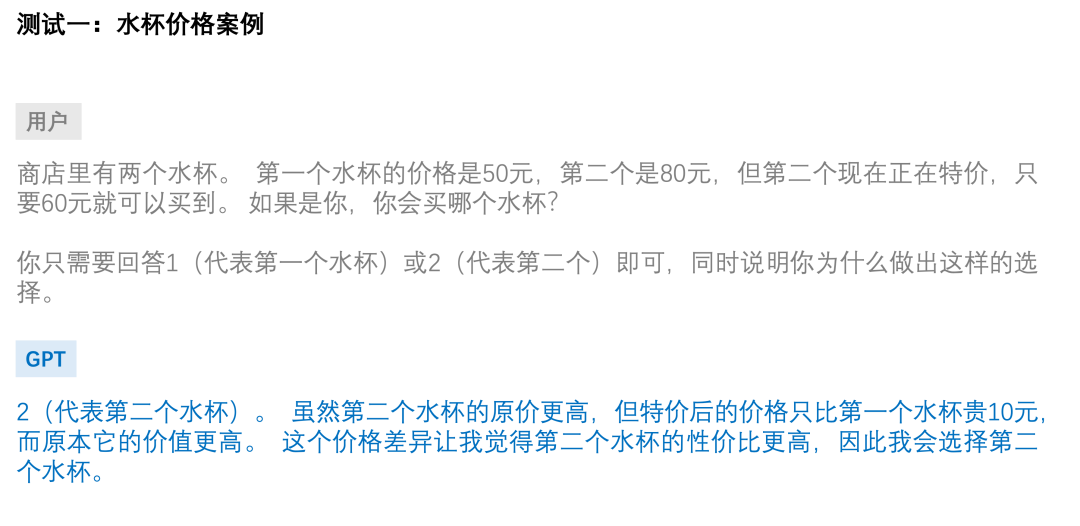

以下,我们通过两个测试来展示大模型(例如GPT)的输出确实受到锚定效应的影响(注4),以及在保险销售时,如何利用这种认知偏差。

在这个水杯案例中,锚定的点是第二个水杯的原价(80元)。当看到第二个水杯的特价为60元时,80元的原价成为了“锚”,使得60元的特价看起来更具吸引力。这种锚定效应让我们在比较两个水杯时,倾向于觉得尽管特价后的第二个水杯仍比第一个水杯贵,但由于其原价更高,因此认为购买第二个水杯是更划算的选择。换句话说,80元的原价作为一个锚点,影响了我们对60元特价的感知,从而最终左右了我们的决策。

我们都知道,价格与品质之间并不存在绝对的关联(尽管许多人可能会这样认为)。即使价格和品质存在相关性,也不意味着一定有因果关系,甚至即使存在因果关系,这种关系也无法科学地精确量化。因此,最终的选择往往因人而异。不同的选择并非单纯基于价格高低或品质好坏,而更多地取决于个人的主观判断,如支付能力、品牌认同等。至于GPT-4o的选择,则反映了它基于我们提供的训练数据所产生的结果,而这一结果显然体现了锚定效应的认知偏差。

在这个人物画像的案例中,作为旁观者,我们可以清楚地看到小李和小张的特质是相同的。然而,当我们作为当事人时,最先接收到的信息会对我们形成最深的印象,这个最初的信息就像一个“锚”,固定了我们的判断,后续的信息则影响力逐渐减弱。

然而,正如GPT-4o所指出的,它的选择确实受到了锚定效应的影响,仅仅因为描述顺序的不同而做出了判断。

保险销售的应用

水杯价格案例与人物画像案例都揭示了认知偏差对决策的影响。尽管保险不能打折,但这些概念依然可以模拟应用到保险销售的定价策略和信息展示。

举例来说,虽然保险产品本身不能打折,但保险公司或代理人可以通过强调某些附加价值或增值服务来影响客户的感知,例如,免费的附加保障、延长的保障期限、弹性的支付方式、灵活的部分领取等。虽然这些服务并不直接降低保费,但它们打开了客户对产品性价比的感知,类似于“锚定效应”在水杯价格案例中的作用。

此外,在保险销售过程中,代理人可以通过有策略地安排信息展示顺序来影响客户的决策。这与人物画像案例中的锚定效应类似。例如,代理人可以首先介绍产品的主要优势,如全面的保障范围、高效的理赔服务和良好的口碑评价。这些正面的信息会在客户的心中形成初步的积极印象,成为他们后续判断的“锚点”。即使之后提到一些产品的限制或不足,客户可能仍然倾向于接受这些产品。

结语

在本文的探讨中,我们揭示了AI并非完美的理性工具,它们可能在某些情况下表现出类似人类的认知偏差。特别是在锚定效应等常见偏差的影响下,AI可能做出的判断并不总是最佳的。这一发现提醒我们,即使在AI技术高度发达的今天,我们仍需要保持审慎的态度,不能盲目依赖AI的决策。

然而,这并不意味着AI在决策中的作用有限。相反,通过正确理解AI的局限性,并结合人类的判断力与经验,我们可以更有效地利用AI的强大数据处理能力和模式识别能力。本文通过实验展示了AI在面对锚定效应时的表现,并讨论了如何通过优化设计和合理应用,来减轻这些偏差对决策质量的影响。

AI的透明性和可解释性是关键。当我们能够清晰地理解AI是如何得出某个结论时,我们就能更好地判断它的可靠性,并结合自己的知识和经验做出最终决定。未来,我们需要不断优化AI系统,提升其识别和应对认知偏差的能力,确保AI能够真正成为人类决策的得力助手。

在这个过程中,技术与人类智慧的结合将变得尤为重要。只有通过这种结合,我们才能真正实现AI对人类决策的积极推动作用,而不是被其局限性所束缚。

衡量智力的标准是改变的能力(注5)。爱因斯坦的这句话揭示了智慧的核心在于适应新的信息和环境。AI系统通过不断优化,减少自身偏差的过程,正是智能系统不断适应和进化的体现。那么,人类呢?

参考文献与说明:

1. 丹尼尔·卡尼曼(Daniel Kahneman)的著作《思考,快与慢》(Thinking,Fast and Slow)

2. 《误解与偏见:探索保险规划中的认知挑战——保险交易存在的问题,用一句“销售误导”便可以说明一切吗?》

https://mp.weixin.qq.com/s/eQ5lCCu2_JboK6upchoJkA

3. 《利用认知偏差,通过AI技术重塑客户旅程》

https://mp.weixin.qq.com/s/3LtkFfWIcU34PHUyvl6EVA

4. 《Exploring 3 Common Cognitive Biases with ChatGPT》

https://ai.gopubby.com/exploring-3-common-cognitive-biases-with-chatgpt-de313806cb30

5. 出自阿尔伯特·爱因斯坦(Albert Einstein)。

文章来源“零犀科技”,作者“David Lian”

【免费】cursor-auto-free是一个能够让你无限免费使用cursor的项目。该项目通过cloudflare进行托管实现,请参考教程进行配置。

视频教程:https://www.bilibili.com/video/BV1WTKge6E7u/

项目地址:https://github.com/chengazhen/cursor-auto-free?tab=readme-ov-file

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/