从哈佛大学校长因抄袭指控在1月份辞职,到2月份曝光的同行评审报告中存在抄袭,今年学术界因抄袭事件而动荡不安。

但在学术写作中,一个更大的问题迫在眉睫——

生成式人工智能工具的迅速普及引发了关于何种行为构成抄袭,以及对AI工具什么程度的使用应该被允许的问题。

版权和剽窃问题顾问Jonathan Bailey认为,「人工智能的使用范围很广,从完全由人类撰写到完全由人工智能撰写,这中间存在着一个巨大的混乱地带」。

ChatGPT等生成式人工智能工具基于被称为大语言模型 (LLM) 的方法,可以节省时间、提高清晰度并减少语言障碍。

现在,许多研究人员认为,在某些情况下可以允许这些工具的使用,并且应当充分披露其使用情况。

但是,这些工具使本来就充满争议的关于不当使用他人作品的界定变得更加复杂。

LLM通过消化大量以前发表的文章来生成文本。因此,使用这些工具可能会类似于「剽窃」。

例如,研究人员将机器写的东西冒充为自己的作品,或者机器生成的文本与其他人的作品非常接近,却没有注明来源。

LLM还可以用来用来掩饰故意抄袭的文本,而且很难被检测出来。

英国普利茅斯大学生态学家Pete Cotton说,「界定学术不诚实或剽窃的真正含义,以及界限在哪里将是非常非常困难的。」

在2023年对1600名研究人员进行的一项调查中,68%的受访者表示,人工智能将使剽窃行为变得门槛更低,也更难被发现。

论文地址:https://www.nature.com/articles/d41586-023-02980-0

柏林应用科学大学的剽窃问题专家Debora Weber-Wulff说,「每个人都担心别人都在使用这些系统,也担心自己在应该使用的时候没有使用。大家都在为这件事焦头烂额。」

当抄袭遇上AI

剽窃,美国科研诚信办公室将其定义为「盗用他人的观点、过程、成果或文字而不给予适当的认可」。

这一问题其实并不罕见。2015年的一项研究估计,有1.7%的科学家承认自己有过剽窃行为,30%的科学家知道同事有剽窃行为。

LLM可能会让事情变得更糟。如果有人要求LLM对措辞进行转述,那么故意剽窃人类撰写的文本这一行为就很容易被伪装起来。

加拿大英属哥伦比亚大学(UBC)的计算机科学家兼语言学家Muhammad Abdul-Mageed说,这些工具可以被提示以复杂的方式进行转述,比如以学术期刊的风格。

一个核心问题是,使用完全由机器而非人类撰写的无署名内容是否算作剽窃。

许多研究人员认为不一定。例如,包括大学和个人在内的欧洲学术诚信网络将未声明使用人工智能工具的写作定义为「未经授权的内容生成」,而不是剽窃本身。

Weber-Wulff说,「对我来说,剽窃是指可归因于另一个可识别的人的东西。她补充说,虽然人工智能生成的文本与现有的人类撰写的内容看起来几乎一模一样,但这通常还不足以被视为剽窃。」

不过,也有人认为,生成式人工智能工具侵犯了版权。

剽窃和侵犯版权都是对他人作品的不当使用,剽窃是违反学术道德的行为,而未经授权使用受版权保护的作品则可能触犯法律。

密歇根大学安娜堡分校的计算机科学家Rada Mihalcea说,「这些人工智能系统是建立在数百万或数亿人的工作基础之上的。」

一些媒体公司和作家对他们认为人工智能侵犯版权的行为提出了抗议。

2023年12月,《纽约时报》对科技巨头微软和OpenAI提起版权诉讼。诉讼称,这两家公司复制并使用了该报的数百万篇文章来训练LLM,而这个训练出的模型现在正与该出版物的内容竞争。

诉讼内容包括,GPT-4在提示之下几乎一字不差地复制了报纸文章的几个段落。

今年2月,OpenAI向联邦法院提出动议,要求驳回诉讼的部分内容,认为 「ChatGPT 绝不是《纽约时报》订阅的替代品」。

微软的一位发言人说,「应该允许合法开发的人工智能工具以负责任的方式发展」,「它们也不能替代记者所扮演的重要角色」。

版权和剽窃问题顾问Jonathan Bailey说:「如果法院裁定,未经许可对文本进行人工智能训练确实侵犯了版权,这对人工智能公司来说将是一个巨大的冲击」。如果没有大量的训练集,ChatGPT这样的工具「就不可能存在」。

AI爆发

不管这是不是所谓的抄袭,自2022年11月ChatGPT发布以来,人工智能在学术写作中的应用呈爆炸式增长。

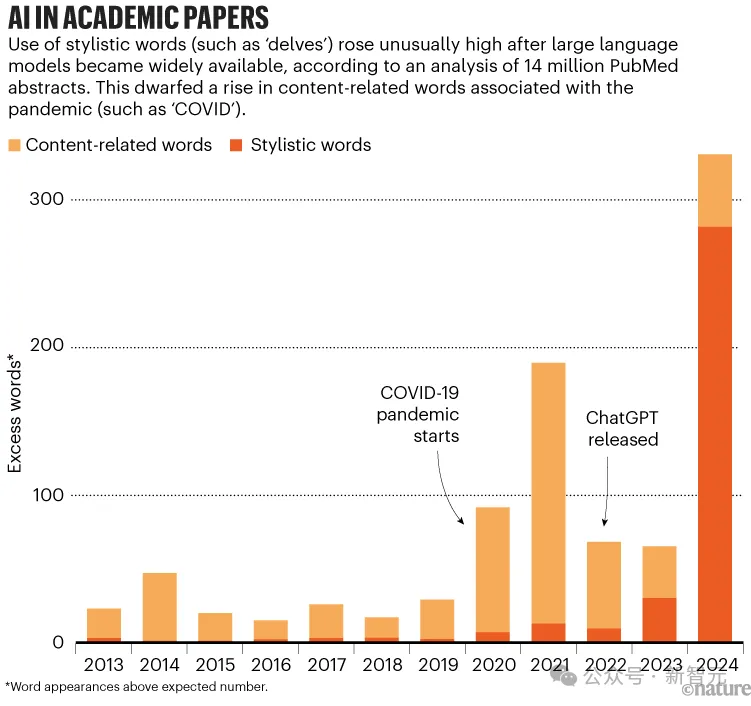

研究人员估计,在2024年前6个月的生物医学论文中,至少有10%的摘要使用了LLM进行写作——相当于每年15万篇论文。

由德国图宾根大学的数据科学家Dmitry Kobak领导的研究人员们,分析了学术平台PubMe上2010年至2024年6月期间发表的1400万篇摘要。

他们发现,「深入」(delves)、「展示」(showasing)和「强调」(underscores)这些词语的出现可能标志着LLM的使用。

通过寻找这些词语,他们估算出了使用人工智能处理过的摘要的比例。

研究团队发现,基于LLM的写作助手的出现对科学文献产生了前所未有的影响。

研究认为,与以英语为主要语言的国家相比,中国、韩国等国家的论文显示出更多使用LLM的迹象。

不过,Kobak说,英语国家的作者可能同样经常使用这些工具,只是使用的方式更难发现。他预测,LLM的使用「肯定会继续增加」,而且「可能会越来越难以发现」。

在学术写作中使用未公开的软件并非新鲜事。

自2015年以来,法国图卢兹大学计算机科学家Guillaume Cabanac和他的同事们一直在揭露由名为SCIgen的软件编写的「胡言乱语」的论文,以及那些包含「折磨人的短语」的论文,这些短语是由翻译或转述文本的软件自动生成的。

Cabanac说,「即使在生成式人工智能出现之前,人们也有一些工具可以瞒天过海。」

在学术写作中使用人工智能也有一定的价值。研究人员说,它可以使文字和概念更加清晰,减少语言障碍,并腾出时间进行实验和思考。

利雅得沙特国王大学的信息技术研究员Hend Al-Khalifa说,在人工智能生成工具问世之前,许多以英语为第二语言的同事在撰写论文时都会很吃力。

但现在,他们专注于研究,利用这些工具解决了写作的麻烦。

但是,对于使用人工智能何时构成剽窃或违反伦理道德,人们仍然感到困惑。

马里兰大学学院帕克分校的计算机科学家Soheil Feizi 说,使用LLM来转述现有论文的内容显然是抄袭。

但是,使用LLM来帮助表达想法,无论是根据详细提示生成文本,还是编辑草稿,如果做到透明,就不应该受到惩罚。

Feizi 认为,「我们应该允许人们利用LLM,毫不费力地、更清晰地表达自己的想法」。

现在,许多期刊的政策都允许在一定程度上使用LLM。

在最初禁止使用ChatGPT生成文本之后,Science于2023年11月更新了其政策,规定在撰写稿件时使用人工智能技术应完全公开,包括所使用的系统和提示。作者要对准确性负责,并「确保没有抄袭行为」。

Nature也表示,研究手稿的作者应在方法部分记录任何使用LLM的情况。

对100家大型学术出版商和100种排名靠前的期刊进行分析后发现,到2023年10月,24%的出版商和87%的期刊都制定了关于使用生成式人工智能的指南。

几乎所有提供指南的出版商都表示,人工智能工具不能作为作者收录,但在允许使用人工智能的类型和要求披露的程度方面,政策有所不同。

Weber-Wulff说,学术写作中迫切需要更明确的人工智能使用指南。

Abdul-Mageed说,就目前而言,使用LLM撰写科学论文的热潮因其局限性而受到抑制。用户需要创建详细的提示,描述受众、语言风格和研究子领域。「实际上,语言模型很难完全满足你的要求。」

但Abdul-Mageed表示,开发人员正在开发能让研究人员更容易生成专业科学内容的应用程序。用户今后无需撰写详细的提示,只需从下拉菜单中选择选项,然后按下按钮,就能从头开始撰写整篇论文。

「侦探」工作

在快速采用LLM编写文本的同时,也出现了大量旨在检测LLM的工具。

尽管许多工具吹嘘自己的准确率很高,有些甚至超过 90%,但研究表明,大多数工具并没有达到它们的要求。

在去年12月发表的一项研究中,Weber-Wulff 和她的同事对学术界广泛使用的14 种人工智能检测工具进行了评估。

只有5款工具能准确识别70%或以上的文本是人工智能还是人类撰写的,没有一款工具的识别率超过80%。

当人工智能生成的文本被人通过替换同义词和调整语序等方式进行了轻微编辑后,检测器的准确率平均下降到50%以下。

作者写道,这种文本「目前的工具几乎检测不出来」。其他研究也表明,要求人工智能对文本进行多次转述会大大降低检测器的准确性。

人工智能检测器还存在其他问题。

一项研究表明,如果英语不是母语的人撰写的英文文章,它们更有可能误判为人工智能生成的文章。

Feizi说,检测器无法可靠地区分完全由人工智能撰写的文本,和作者使用人工智能来帮助改善语法和句子清晰度来润色文本的情况。

他说,区分这些情况相当困难,也不可靠,可能会导致巨大的误报率。而且,被错误地指控使用人工智能会对这些学者或学生的声誉造成相当大的损害。

人工智能的合法使用与非法使用之间的界限可能会进一步模糊。

2023年3月,微软开始将人工智能生成工具纳入其应用程序,包括Word、PowerPoint和Outlook。其某些版本的人工智能助手名为Copilot,可以起草或编辑内容。

6 月,谷歌也开始将其生成式人工智能模型Gemini集成到Docs和Gmail等工具中。

英国普利茅斯马戎大学高等教育专家Debby Cotton说,「人工智能正深入到一切事物中,我们越来越难以分辨所做的事情是否受到了AI的影响,它的发展速度会比我们能跟上的速度更快」。

参考资料:

https://www.nature.com/articles/d41586-024-02371-z

文章来自于微信公众号“新智元” 作者庸庸 乔杨