新的最强开源多模态大模型来了!

阿里Qwen2大模型家族新添多模态模型Qwen2-VL,在图像和长视频理解任务上双双取得了SOTA。

在具体的子类任务中,Qwen2-VL在大部分的指标上都达到了最优,甚至超过 GPT-4o等闭源模型。

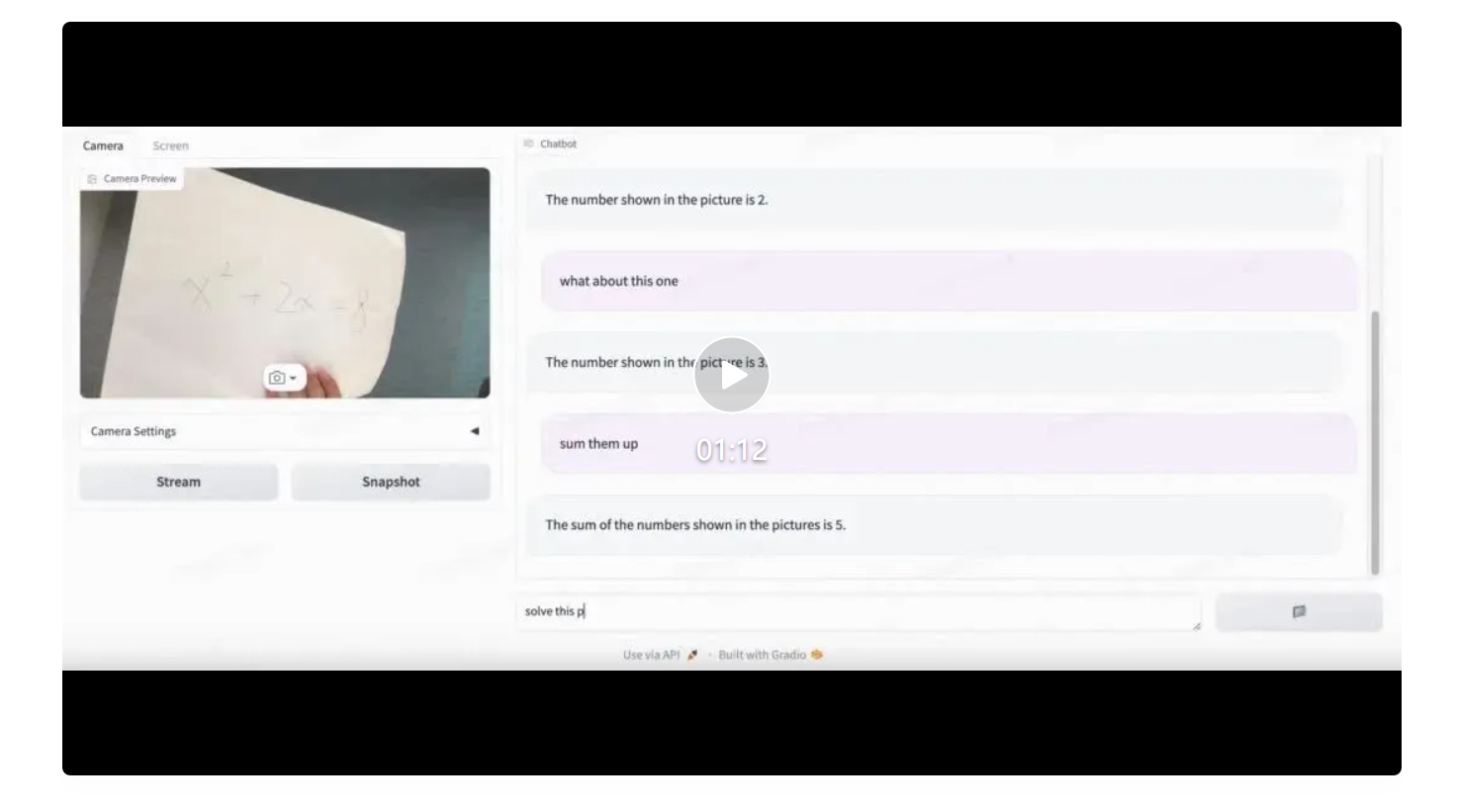

在多模态能力的加持下,Qwen2-VL可以实时读取摄像头或电脑屏幕,进行文字形式的视频对话。

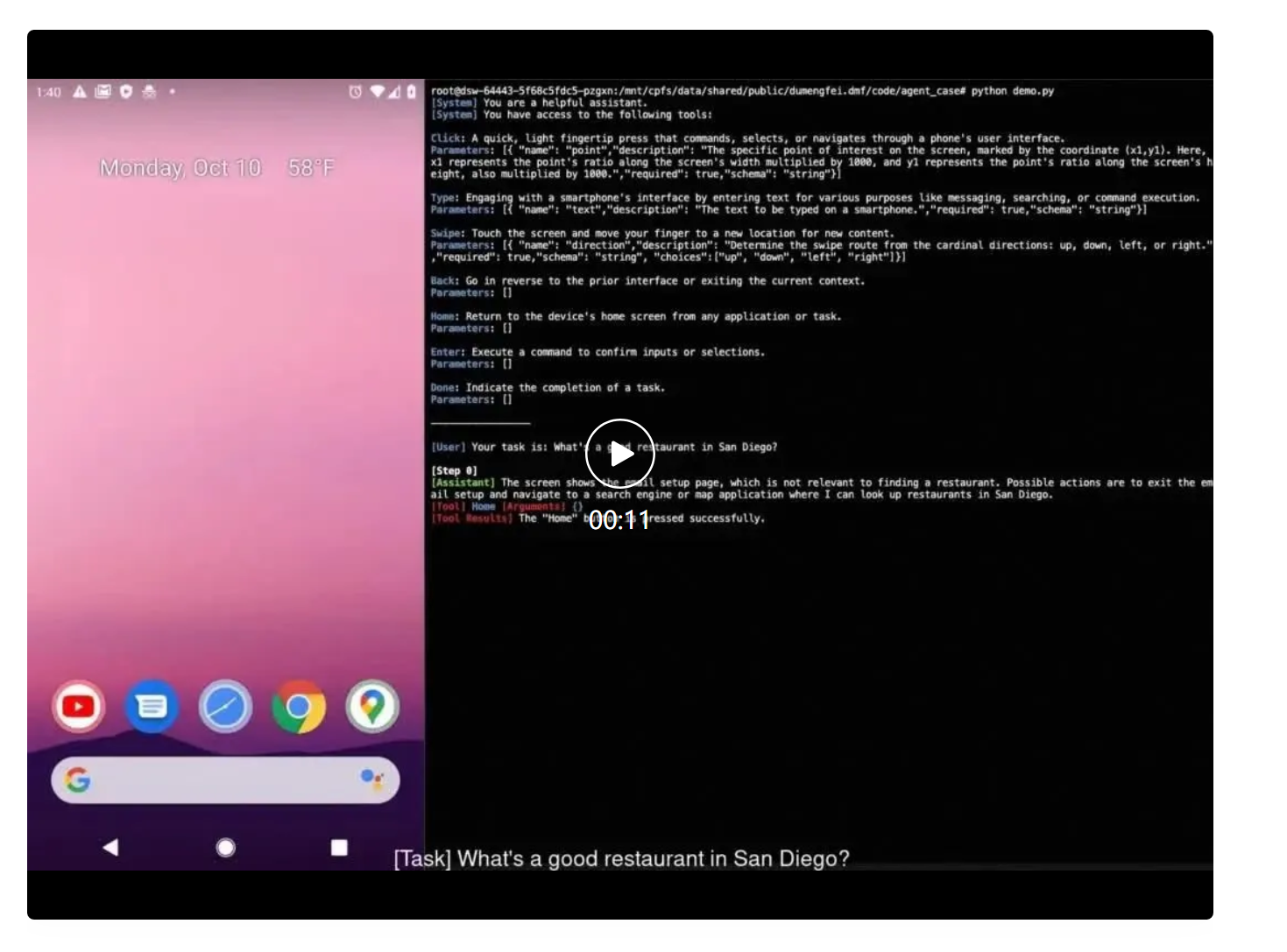

甚至还能作为Agent与环境进行交互,根据任务目标自主操控手机等设备。

此次发布的Qwen2共有2B、7B、72B三个版本,其中2B和7B版本已可下载并免费商用(Apache 2.0),72B则通过API提供。

目前开源代码已集成到Hugging Face Transformers、vLLM等第三方框架中。

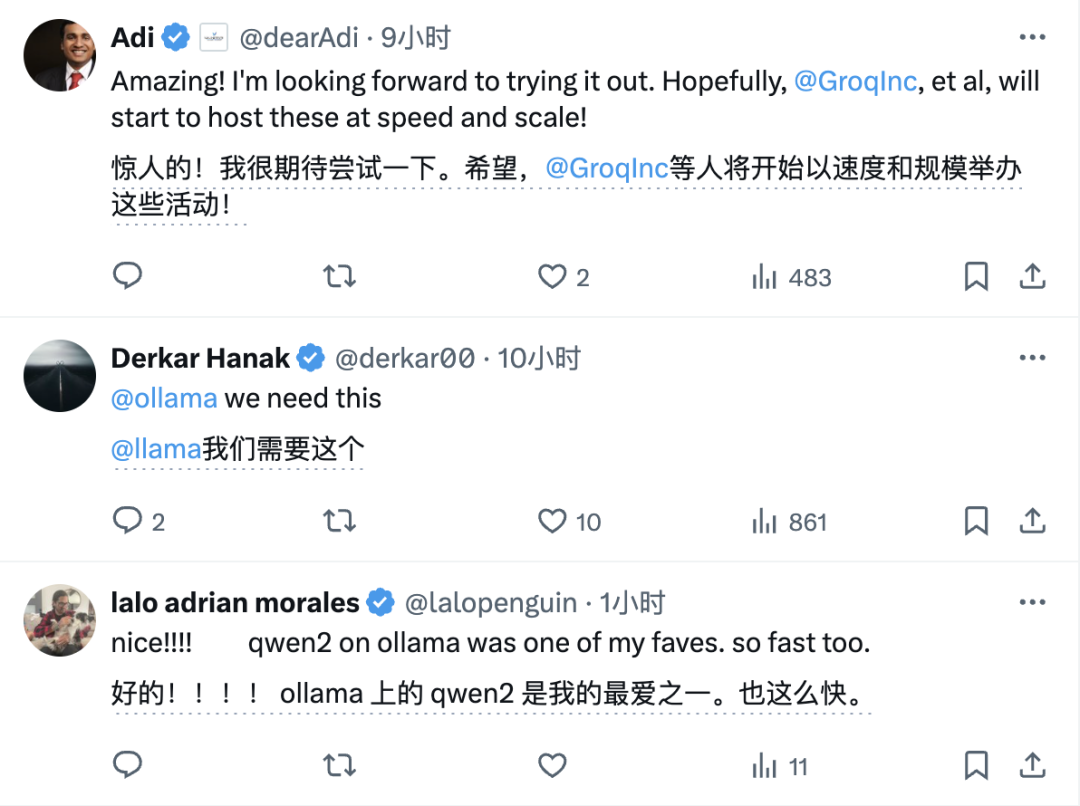

还有不少网友都在狂cue一些知名大模型推理平台,如Groq、Ollama,希望能够早日提供支持。

下面就来一睹Qwen2-VL的表现!

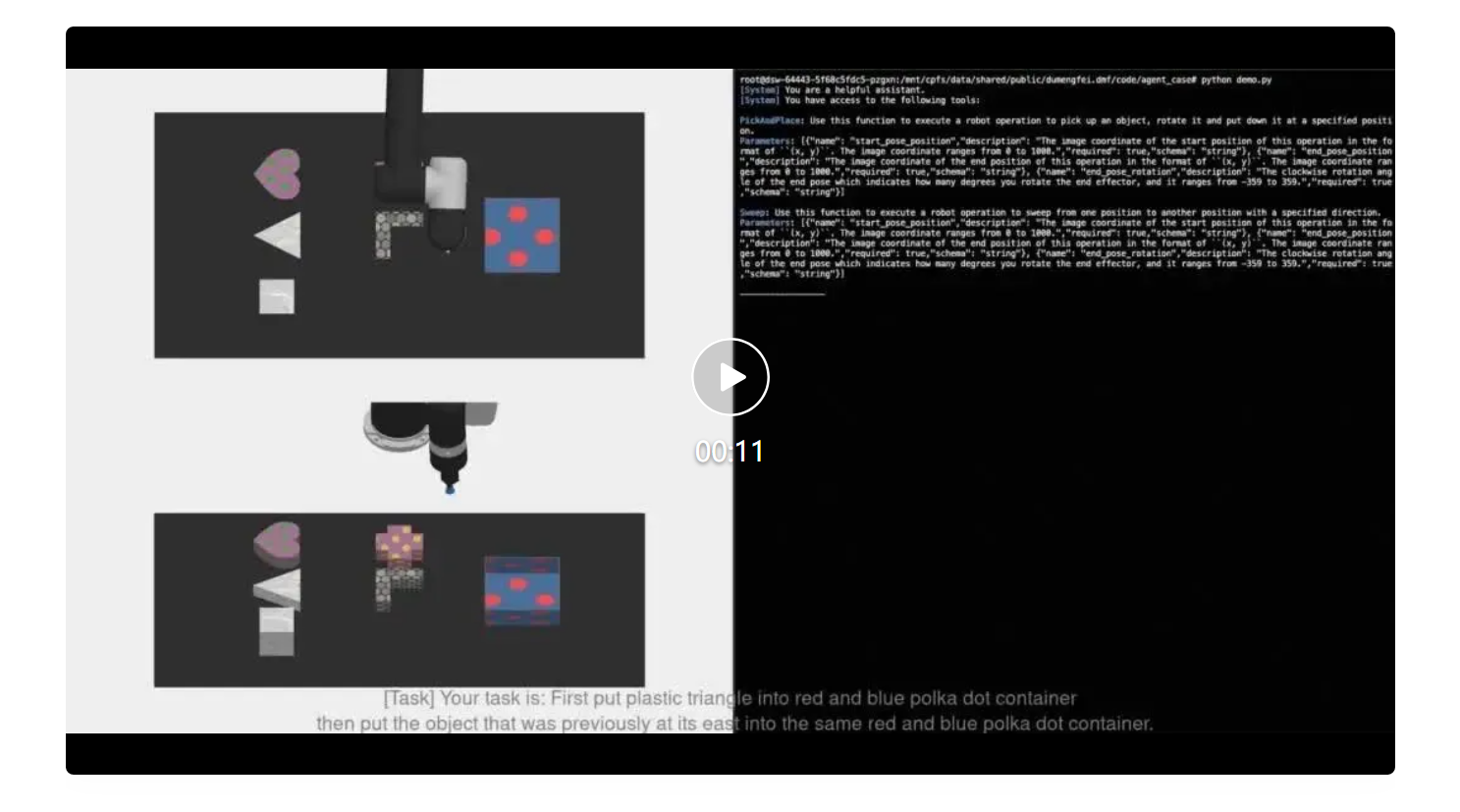

利用强大的多模态能力,Qwen2-VL能够操纵机械臂,进行物体的拿取、放置等操作。

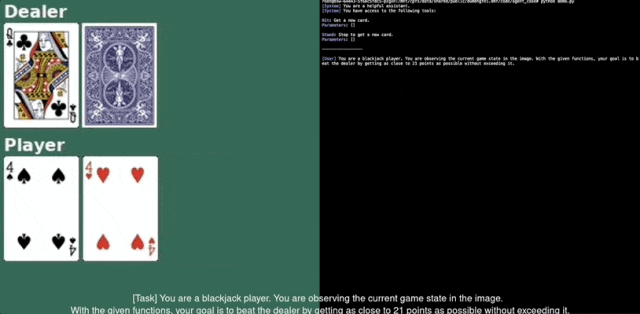

还可以化身扑克牌玩家,根据识别到的场上信息和提示词描述进行“24点”游戏的决策,并且取得了胜利。

还有开头所展示的,Qwen2-VL可以根据识别到的屏幕内容,结合用户需求自行操作手机在网络上进行信息检索。

当然在这些体现工具调用和Agent交互能力的复杂任务背后,基础能力也是不能落下。

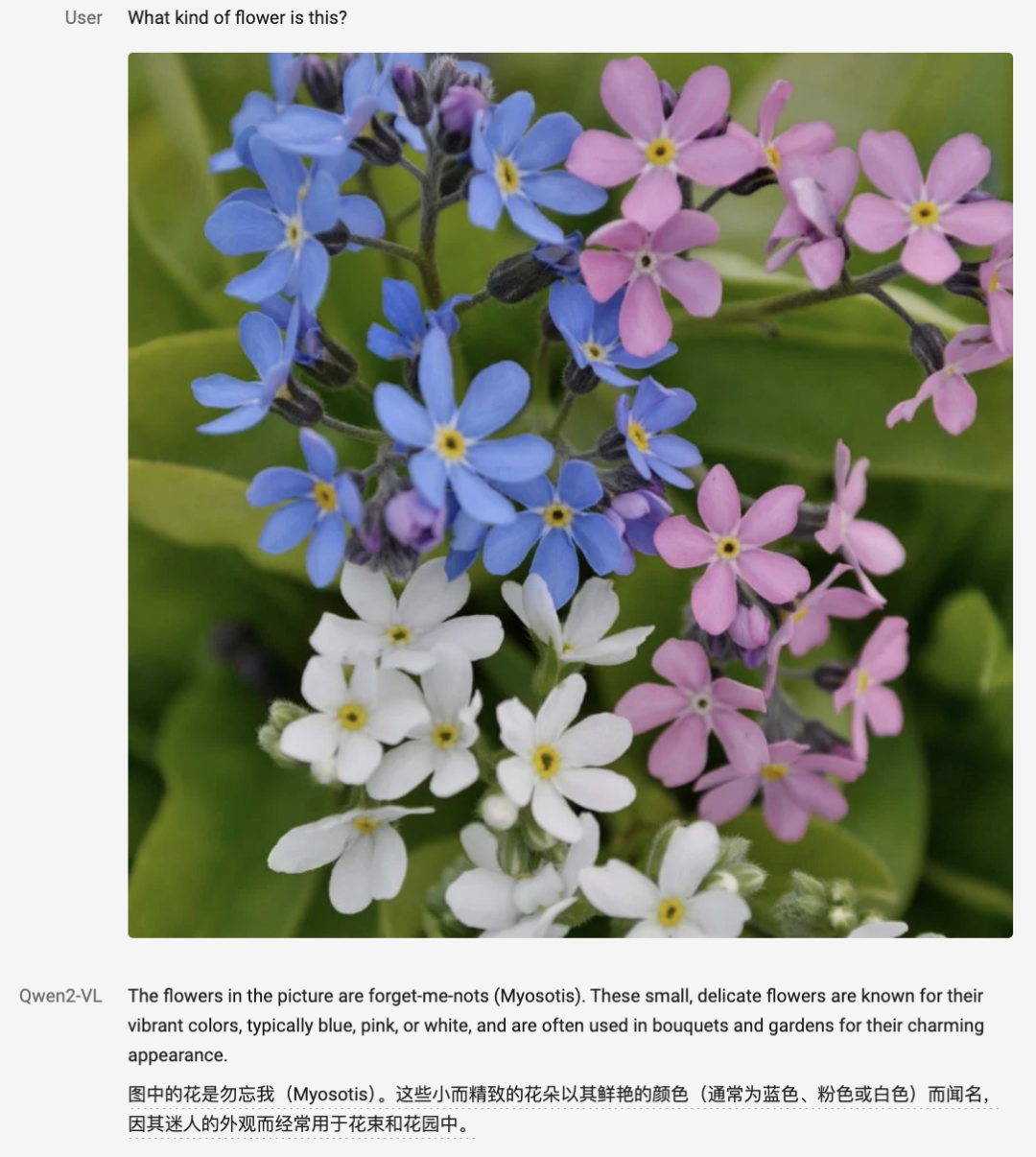

比如图像识别,在物体类的识别当中,Qwen2-VL可以准确地认出花的品种。

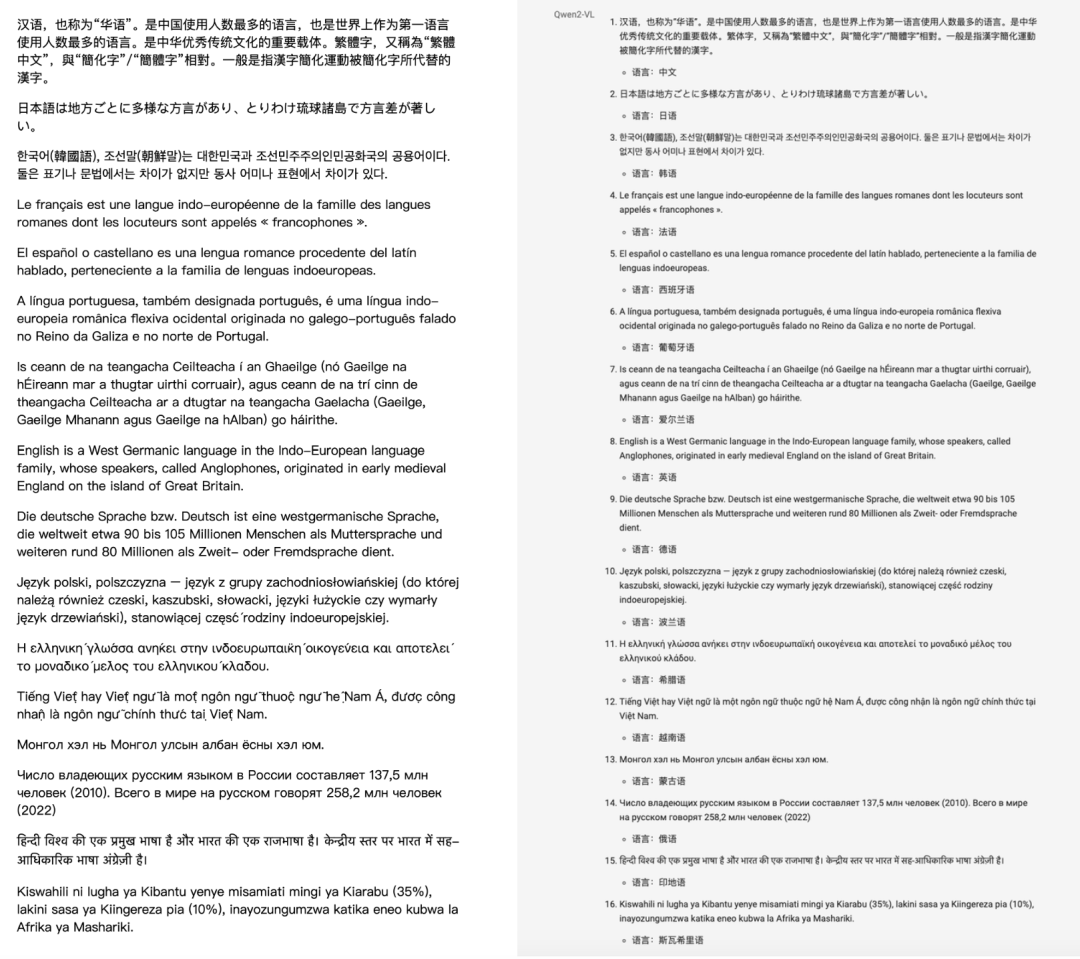

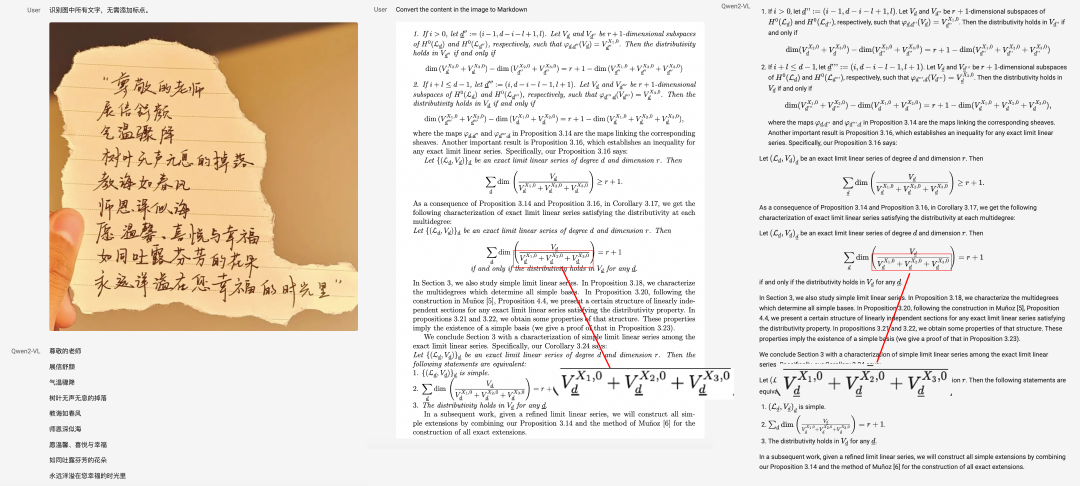

另一类识别场景是文字,Qwen2-VL支持多种语言的文本提取。

甚至把16种语言混合到一张图中,Qwen2-VL不仅能判断各自的语种,也能一口气提取出全部文本。

手写字体和复杂的数学公式也能识别,并且上下标这种微小细节处理得非常到位。

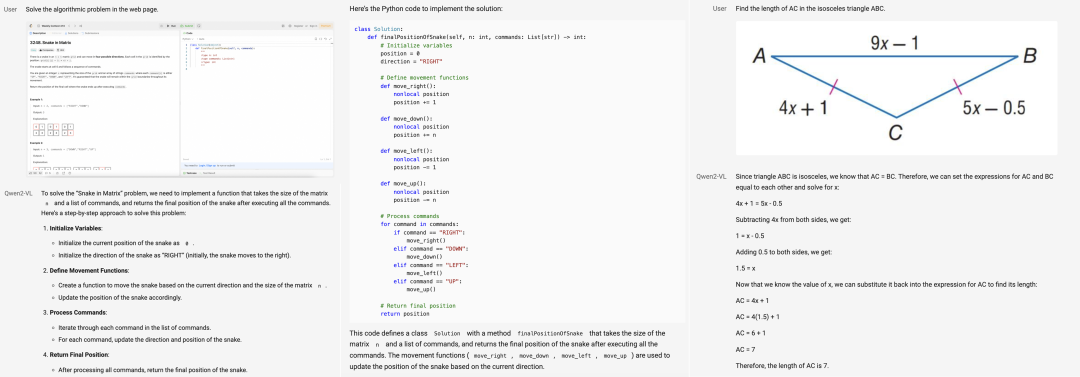

Qwen2-VL还支持多模态推理,代码和数学(包括几何)类问题,只需要传张图片就能解决。

视频方面,Qwen2-VL最长可以对20分钟以上的视频进行内容分析,既支持总结也能对细节进行提问。

不过目前还只能分析画面,暂不支持对声音的处理。

同时也支持实时视频文字对话,除了开头展示的基于摄像头的对话外,也可以读取电脑屏幕,作为对话的内容。

总之,在这些任务的背后,蕴含着Qwen2-VL不凡的综合实力。

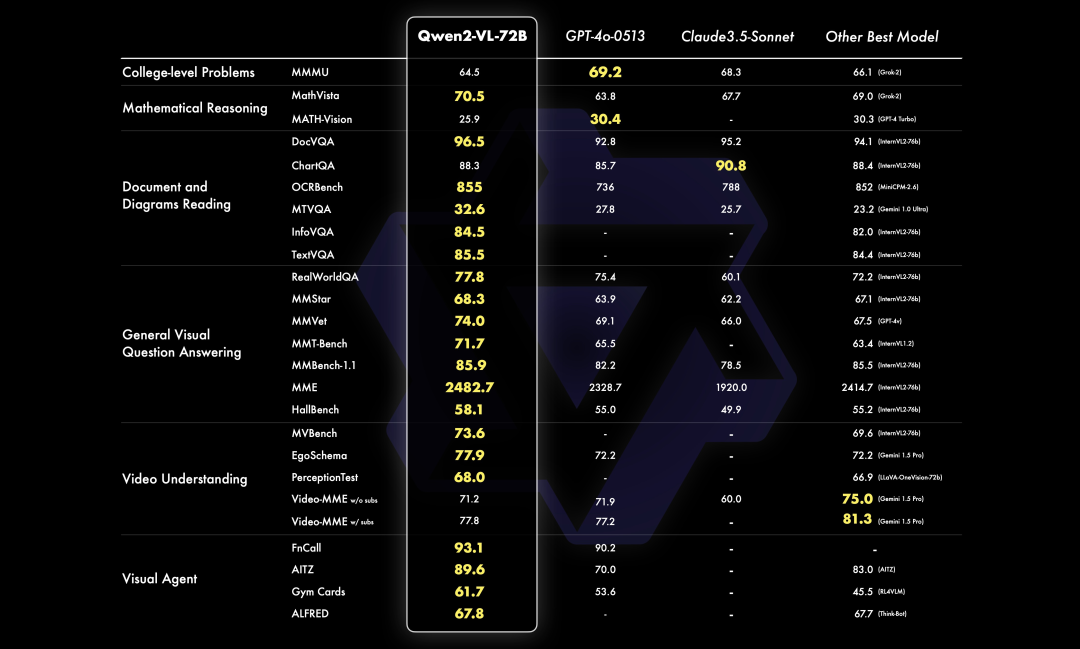

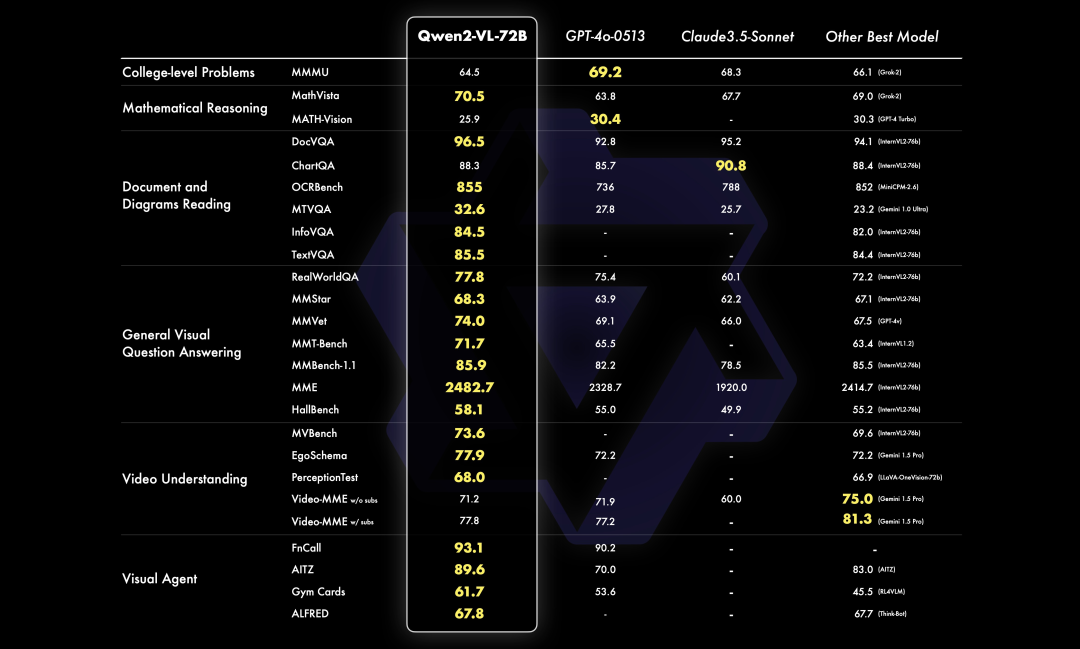

为了了解Qwen2-VL在各种任务上的综合表现,千问团队一共从从六个方面对其视觉能力进行了评估。

具体包括了综合类大学试题、数学试题、文档表格理解、通用场景下的问答、视频理解以及Agent能力这六种类型。

整体来看,Qwen2-72B的大部分的指标上都达到了最优,甚至超过了GPT-4o和Claude3.5-Sonnet,特别是在文档理解方面优势明显。

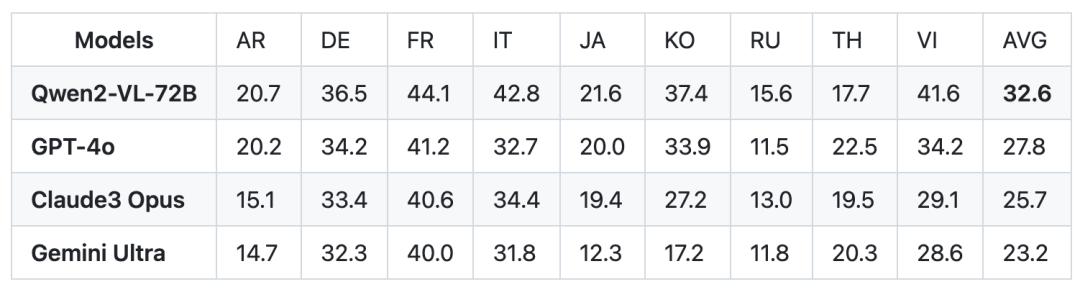

另外在多语言测试中,MTVQA也在9种语言中的8种全面超越了GPT-4o、Claude3-Opus和Gemini Ultra这些先进闭源模型,平均成绩也是最高分。

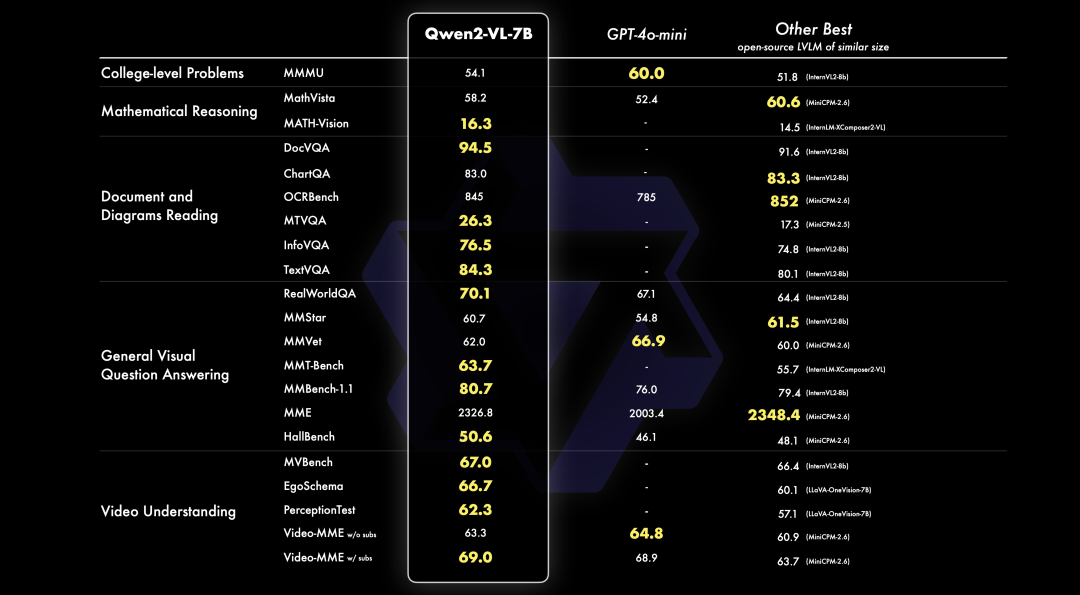

7B版本同样支持图像、多图、视频的输入,同时也达到了同等规模模型的SOTA水准。

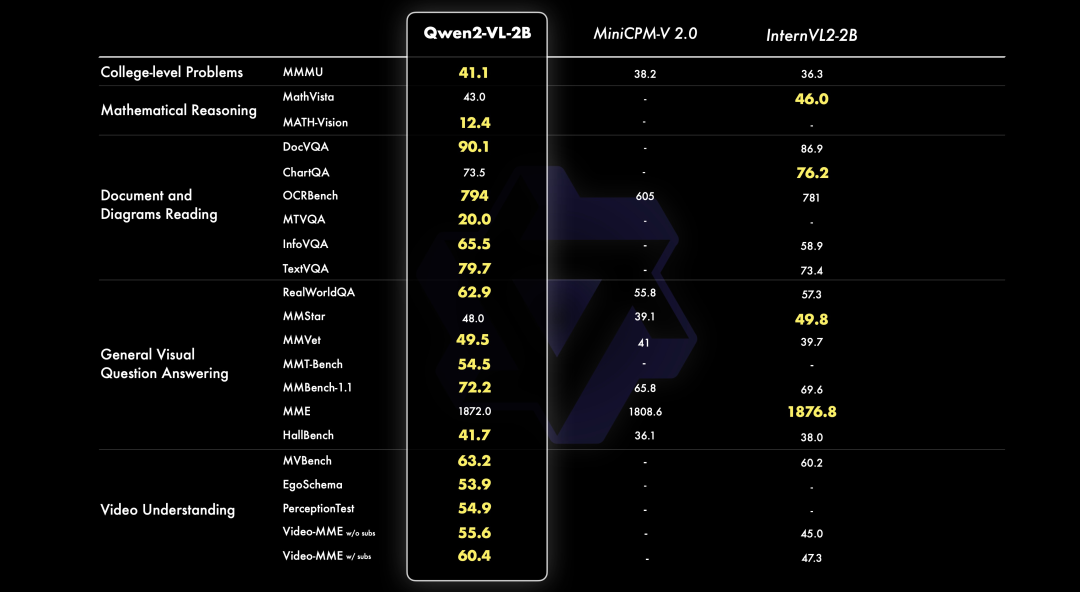

最小的2B版本则主要为移动端设计,但麻雀虽小,却具备完整图像视频多语言的理解能力,特别在视频文档和通用场景问答相较同规模模型优势明显。

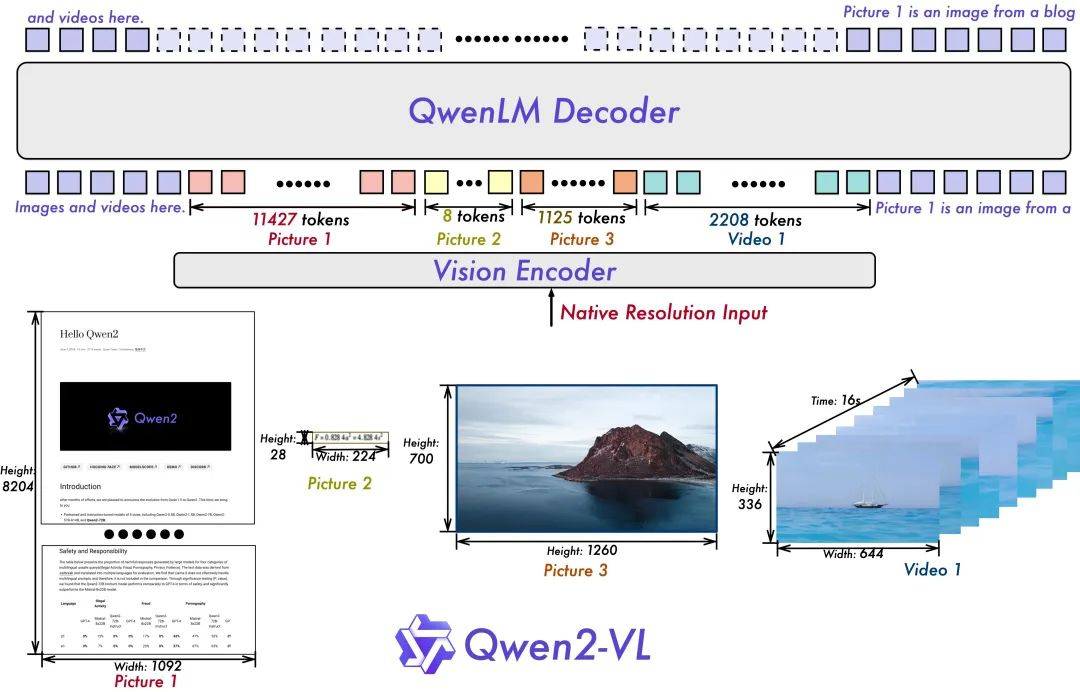

整体上,Qwen2-VL延续了其上一代Qwen-VL中ViT加Qwen(2)的串联结构,在三个不同规模的模型上,Qwen2-VL都采用了600M规模大小的ViT,并且支持图像和视频统一输入。

为了让模型更清楚地感知视觉信息和理解视频,Qwen2-VL新增了对原生动态分辨率的全面支持。

与上一代模型相比,Qwen2-VL能够处理任意分辨率的图像输入,不同大小图片被转换为动态数量的tokens,最少只需要4个。

这种设计不仅确保了模型输入与图像原始信息之间的一致性,也模拟了人类视觉感知的自然方式,让模型在图像处理任务上更加灵活高效。

Qwen2-VL在架构上的另一项创新,是多模态旋转位置嵌入(M-ROPE)。

传统的旋转位置嵌入只能捕捉一维序列的位置信息,而M-ROPE通过将原始旋转嵌入分解为代表时间、高度和宽度的三个部分。

这使得大规模语言模型能够同时捕捉和整合一维文本序列、二维视觉图像以及三维视频的位置信息。

这一创新有助于提升模型的多模态处理和推理能力,能够更好地理解和建模复杂的多模态数据。

DEMO:

https://huggingface.co/spaces/Qwen/Qwen2-VL

项目主页:

https://qwenlm.github.io/blog/qwen2-vl/

GitHub:

https://github.com/QwenLM/Qwen2-VL

文章来源于“量子位”,作者“克雷西”

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0