卷出第一个国产版GPT-4o的,是智谱AI。

智谱AI的2024年主题,一定是在多模态赛道上狂奔。先是2024年7月26日,智谱AI上线了类Sora的视频生成模型“智谱清影”。团队邀请大家使用和反馈的诚意也很足——比起发布半年多了还没开放的Sora,“清影”上来就是免费不限量。

一个月后的8月29日,在国际数据挖掘与知识发现大会(KDD)上,智谱AI带着国产版《Her》、类GPT-4o炸了一波场——在C端产品“智谱清言”中,智谱AI首次上线了“视频通话”功能。

这意味着,当“懂王”AI长了眼睛、有了情绪,人与AI的交互方式,离人与人更近了一步。

比如AI也跟上了潮流。最近刷屏游戏圈的《黑神话:悟空》,智谱清言看到后“秒懂”,还能和你唠两句。

同时,智谱AI还放出了最新版的“多模态模型全家桶”,比如能看懂视频和网页的视觉模型GLM-4V-Plus,支持图片编辑的文生图模型CogView-3-Plus。

语言基座模型GLM,也迭代到了GLM-4-Plus版本,更能玩转长文本,也更会做数学题。

曾经,GPT-4o的“三段感情迭代”,惊艳了一大批用户。但智谱清言像是个大直男,当要求它“更有感情一点”,它会理性地朝你“泼冷水”:作为一个人工智能,无法表达感情。

不过,智谱清言的视频通话功能,有更适合中国人“活到老学到老”体质的玩法。

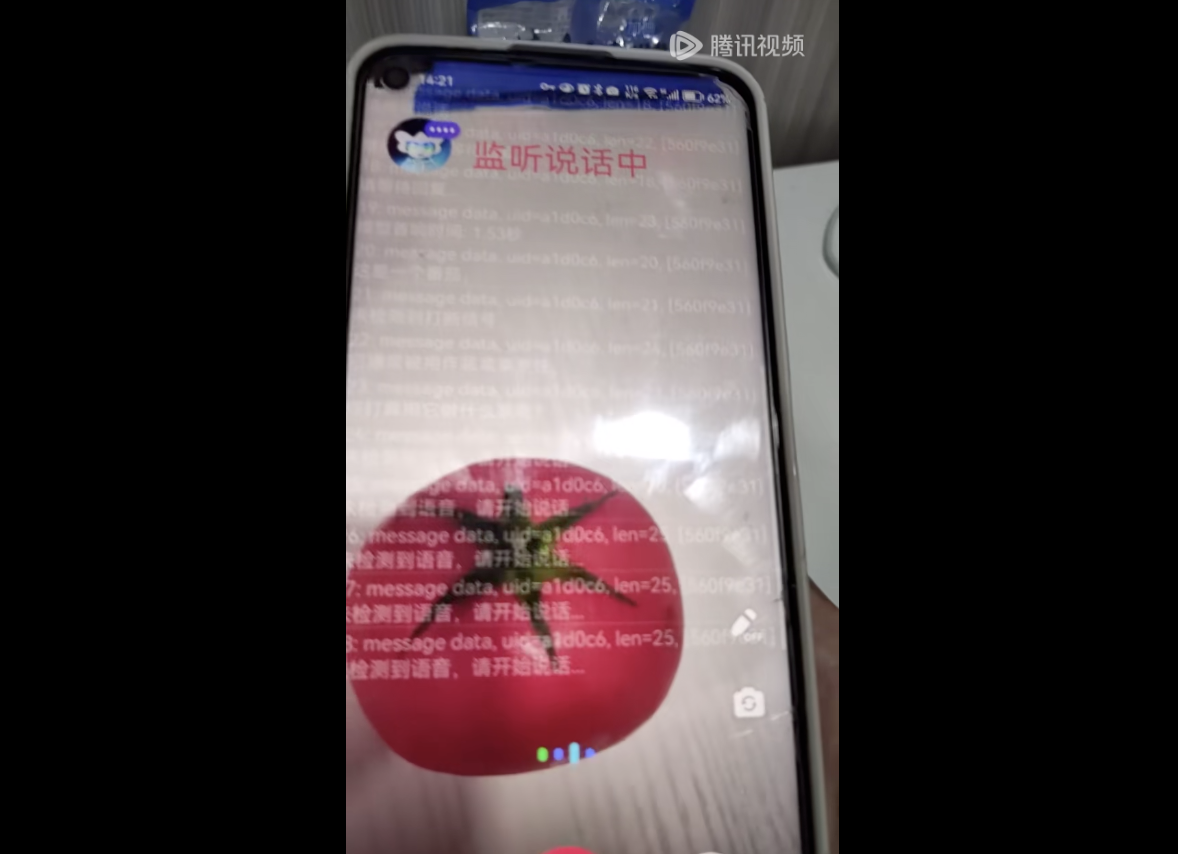

比如,它可以是你的随身英语教师。打开摄像头后,你也能体验一把“走到哪,问到哪,学到哪”的高浓度英语学习。

△询问番茄的英文。来源:智谱AI

当然,它也可以是“哪里不懂拍哪里”的数学老师。智谱清言的讲解,质量甚至和真人教师有的一拼,不仅循循善诱,还有问答互动。家长再也不用为辅导作业而烦恼!

△解答混合运算选择题。来源:智谱AI

平时在家,智谱清言也揽下了生活管家的活。

比如,它能一眼认出瑞幸的包装袋,立马给你来了一段瑞幸历史的科普。不过,智谱清言最后开了小差,将本意为咖啡该怎么储存的问题,理解成了包装袋该怎么储存……

△识别瑞幸包装袋。来源:智谱AI

目前,视频通话的过程还无法储存在历史记录中。不过,有了“长了眼”的智谱清言,就仿佛同时下载了作业帮、小红书和下厨房。

对于智谱AI而言,2024年绝对是在多模态上狂飙的一年。

在KDD上,智谱AI更新了“模型全家桶”,既发布了新一代的语言基座模型,也发布了升级后的多模态家族:图像/视频理解模型GLM-4V-Plus、文生图模型 CogView-3-Plus。

先来看语言基座模型GLM-4-Plus。

有意思的是,GLM-4-Plus的训练,大量采用了高质量模型合成数据。事实证明,AI合成数据已经可以有效运用于模型训练,降低训练数据的获取成本。

从结果来看,GLM-4-Plus的语言理解能力,与GPT-4o和Llama3.1-405B不相上下。

△综合能力benchmark。图源:智谱AI

而在长文本能力的表现上,GLM-4-Plus和GPT-4o、Claude 3.5 Sonnet两个顶尖模型也并驾齐驱。在清华大学刘知远团队做的长文本测试集InfiniteBench上,GLM-4-Plus甚至略优于两个国外天花板模型。

△长文本能力benchmark。图源:智谱AI

同时,通过采取近端策略优化(PPO,一种提升复杂任务决策能力的训练方法),GLM-4-Plus的数据、代码算法等推理能力有了明显提升,并且能够更好反映人类偏好。

目前,GLM-4-Plus百万Tokens的处理价格为50元,与百度最新的大模型ERNIE 4.0 Turbo差不多持平(百万Tokens输入30元、输出60元)。

△GLM-4-Plus定价。

多模态能力的更新,是最精彩的部分。

相较于上一代GLM-4V,视觉大模型GLM-4V-Plus增加了视频和网页理解能力。

△视觉能力benchmark。图源:智谱AI

比如,只要输入智谱AI官网的截图,GLM-4V-Plus立刻就能转化成html代码,帮助你快速复刻网站。

△GLM-4V-Plus能力测试。图源:作者测试

与一般视频理解模型不同,GLM-4V-Plus不仅看得懂复杂视频,还具备时间感知能力。这意味着你问模型视频第xx秒的内容,它也能给出答案。不过截至发稿前,智谱AI开放平台的模型体验区还不支持上传视频。

美中不足的是,相较于逆天的视觉多模态理解能力,GLM-4V-Plus的多轮对话和文本理解能力显得有些“拉垮”。看来,GLM-4V-Plus离成为GPT-4o,还有相当距离。

△GLM-4V-Plus视频理解能力。图源:智谱AI

在KDD上,智谱AI还发布了新一代的文生图模型CogView-3-Plus。与近期文生图界的“当红炸子鸡”FLUX相比,CogView-3-Plus 20s版本的各项能力基本能打平。

△文生图能力benchmark。图源:智谱AI

输入提示词:桌子上有一台笔记本电脑,电脑旁边放着一个透明玻璃杯,这是一个圆柱形的杯子,半杯水还冒着热气,杯身折射了些许阳光。

△CogView-3-Plus能力测试。图源:作者测试

同时,CogView-3-Plus也支持图片编辑功能,比如改变图中物体的颜色、替换物品等等。

△CogView-3-Plus图片编辑。图源:智谱AI

给2024年1月发布的几款模型,加上“Plus”的后缀,智谱AI花了超过7个月——这也是2023年以来,智谱AI发布模型的最长周期。

可见的是,GPT-4o,对于AI大模型企业而言,是一道能力的分水岭。随着多模态能力的融合,语言理解的“黑箱”刚被打开,又很快被GPT-4o合上了。

多数国内模型厂商的策略是:分而治之,先增强不同模态的单模态模型能力,再攻克融合的难题。

智谱AI的模型矩阵,目前仍然在各自迭代能力的“分治”阶段,而视频通话功能的上线,让用户已经看到了初步多模融合的影子。

文章来源于“周鑫雨”

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0