OpenAI最近发布的o1-preview可以说是再次震撼了整个大模型届,在各个主流高难度基准测试中都展现出了惊人的性能,甚至能在博士级别的科学问答环节上超越人类专家。

不过,o1模型的超强实力也带来了一个问题:现有的基准测试已经无法评估模型的能力了,需要新的、更难的基准。

最近,Scale AI与CAIS(人工智能安全中心,Center for AI Safety)计划合作推出Humanity's Last Exam (人类的最终测验),号称将要构建大型语言模型届最难的开源基准;此前CAIS发布的MMLU目前仍然是Huggingface社区中下载次数最多的基准数据集。

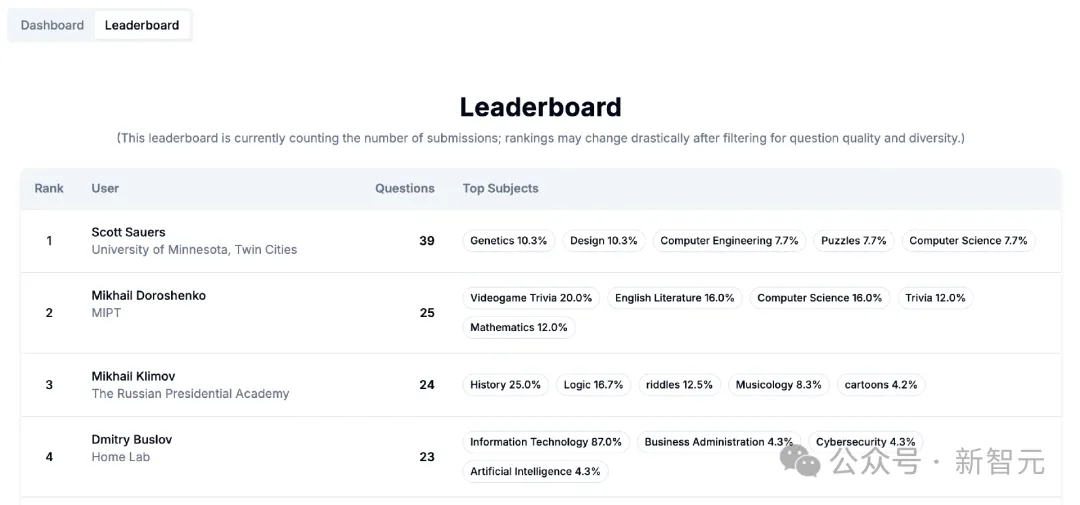

两个机构总共筹集了50万来收集「有史以来最难、最广泛的」问题,面向所有人类专家来收集那些尖锐的问题,以将人工智能模型推向极限:前50个被选中的问题,每题将获得5000美元;后面的500个问题,每题将获得500美元。

问题提交:https://agi.safe.ai/submit

不管是数学、天文、火箭工程还是分析哲学,不限领域,不限格式,只要够难,只要AI回答不上来,就能拿奖!

在数据集发布后,问题被选中的提交者也将成为论文的共同作者,被接受的问题数量越多,出现的位置也会越靠前,目前麻省理工学院、加州大学伯克利分校、斯坦福大学等研究人员都已参与到奖金争夺中!

问题提交的截止日期为2024年11月1日。

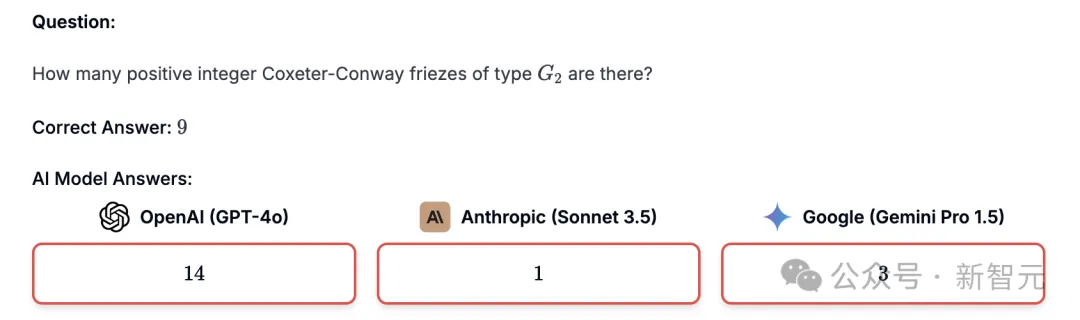

好问题1:存在多少个正整数G2类型的Coxeter-Conway格栅?

问题解读:该问题对于人工智能模型来说足够具有挑战性,并且重点关注研究概念。

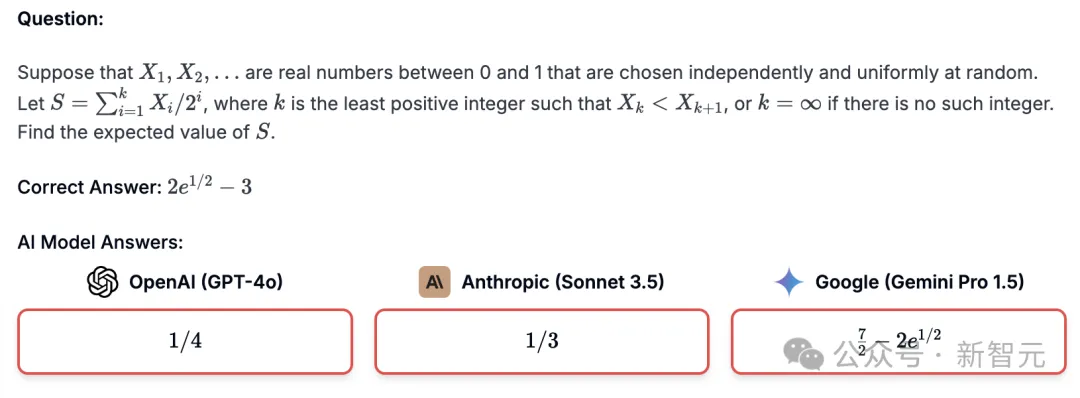

好问题2:假设X1,X2,...是在0和1之间独立且均匀随机选择的实数。设 ,其中k是最小的正整数,使得 Xk<Xk+1;或者如果没有这样的整数,则 k=∞;求S的期望值。

,其中k是最小的正整数,使得 Xk<Xk+1;或者如果没有这样的整数,则 k=∞;求S的期望值。

问题解读:尽管没有引用研究级别的概念,但这个问题对于人工智能模型来说已经足够具有挑战性了。对于精确匹配格式来说,答案也并不太复杂。

坏问题1:确定最小的正实数使得存在可微函数 和

和 满足下列五个限制。

满足下列五个限制。

问题解读:这个问题太简单了。三个模型中,有两个都能答对。

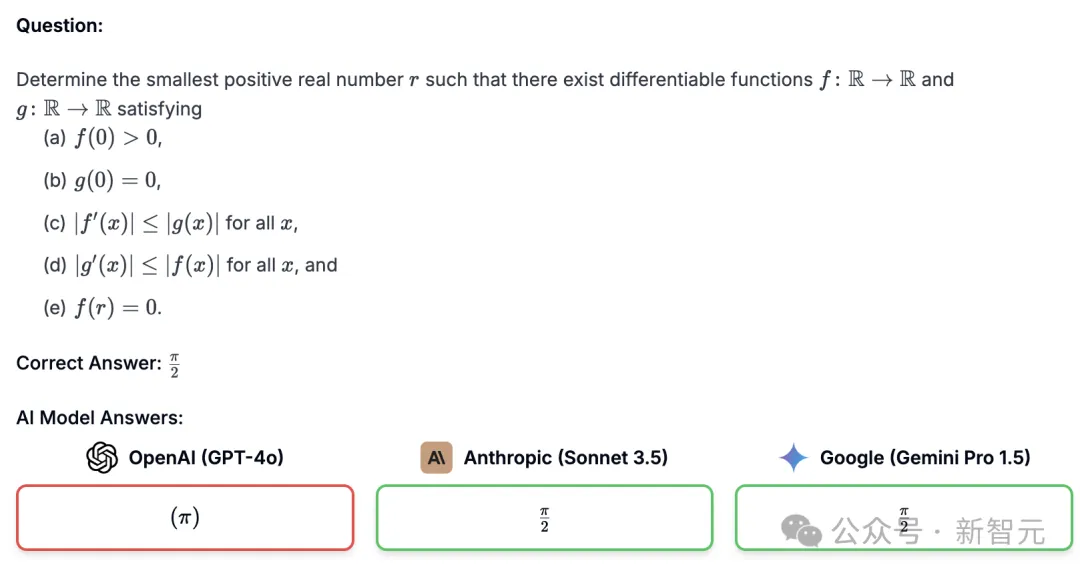

坏问题2:我正在研究病毒颗粒(尤其是冠状病毒)中基于系链蛋白的相互作用。我想进行实验来评估各种 ORF3 和 Spike 蛋白是否能与系链蛋白更好地相互作用,从而增强受感染细胞中的病毒释放。我直接使用改良的 SARS-CoV-2 毒株代替 HIVΔVpu 作为报告病毒,并使用 HeLa 细胞作为系链蛋白阳性毒株。感染一些测试 HeLa 细胞,孵育、固定并通过透射电子显微镜 (TEM) 进行分析后,拍摄了结果图像。下列哪个选项是正确的?

1. 固定甚至 TEM 技术过程可能会导致伪影,例如源自细胞质膜降解的小囊泡,如图 i 和 ii 所示。这些伪影可能是解释病毒活动的混杂因素。

2. 在图像 iii 中,白色箭头指向类似于尚未释放的病毒颗粒的结构,有时封闭在双膜囊泡内。

3. 图像 i、ii 和 iii 实际上显示了受感染细胞的不同细节:质膜外的病毒体 (i)、与质膜相关的病毒体及其附近充满病毒的隔室 (ii) 以及细胞器内的病毒体 (iii) )。

4. 图像 i、ii 和 iii 的分辨率不足以区分病毒颗粒和常见的细胞结构,使得很难确定这些尖头结构确实是病毒颗粒。

问题解读:我们不希望数据集中出现与病毒学相关的问题,尽管这是一个很好的问题。

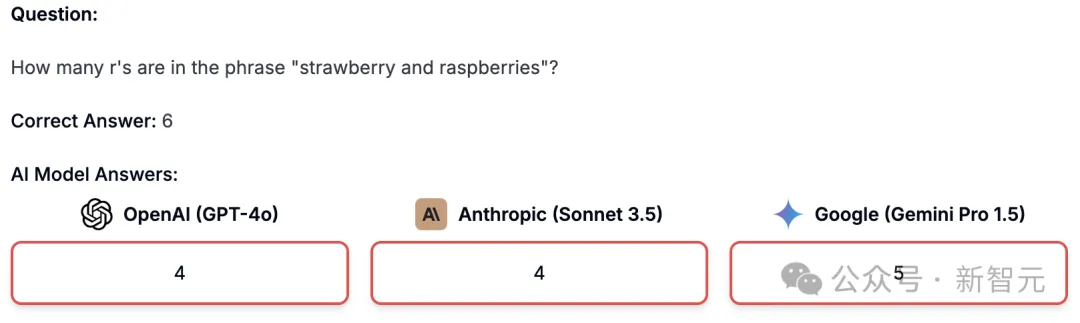

坏问题3:「strawberry and raspberries」这个短语中有多少个 r?

问题解读:无论是知识范围还是难度,该问题都没有超出本科生或硕士的水平,只是AI模型不擅长此类棘手问题,对于普通人来说并不具备挑战性。

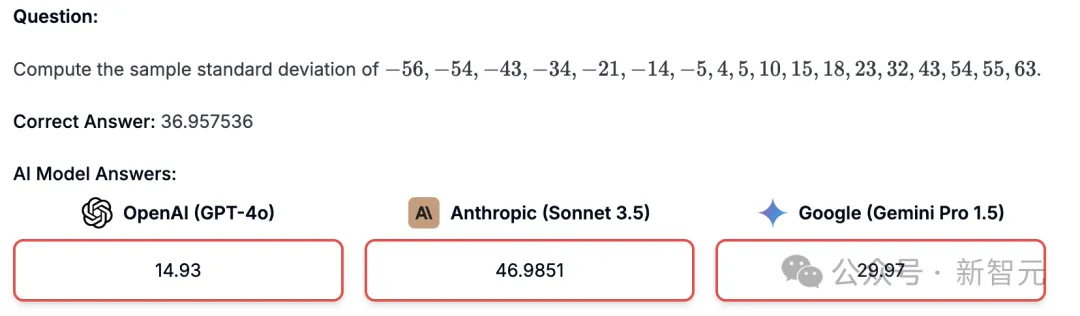

坏问题4:计算样本标准差。

问题解读:这是一个简单的计算问题,在难度上并不超出本科或硕士水平;没有对人类知识的最前沿进行测试,并且问题中还没有指定答案中预期的精度,一般来说答案形式应该是明确的、唯一的。

步骤1:写问题

提交者首先用「英语」写一个AI模型和普通人无法回答的、有效的、且非常困难的问题。研究人员的目标是只有非常杰出的人才能正确回答的问题,所以在提交之前,用户需要先在各个AI模型上进行测试,确定无法回答后再提交。

步骤2:AI评估问题难度

研究人员会使用最先进的AI模型来判断问题的难度,以过滤掉那些非常简单的问题。

步骤3:写下答案解释

如果该问题对于AI模型来说非常困难,研究人员就会要求提交者为该问题写出一个完善但简洁的解决方案。

步骤4:同行评审

提交完问题、答案和理由后,回答将会被保存下来,再进行另一轮手动审核以保证基准的质量。

答案理由可以帮助专家和AI模型来判断提供的答案是否正确;提交着可以随时在dashboard上进行更改或删除提交的问题。

步骤5:发布

如果提交的问题最终入选了数据集,在发布论文中,提交者也会获得合作者身份,并且热门问题作者也会在附录中进行强调。

其中一小部分问题将会作为测试集,以测试、防止AI模型作弊。

1. 挑战性

问题对于非专家来说应该是困难的,并且不能通过在线搜索来回答;避免刁钻的(trick)问题;前沿人工智能系统能够很好地回答大师级的问题。

研究人员鼓励具有 5 年以上技术行业工作经验(例如 SpaceX)或者是学术培训的博士生或以上来提出问题。

在筹备Humanity’s Last Exam时,研究人员发现本科生写的问题对于模型来说往往太简单了;根据经验来说,如果随便一个本科生都能够理解所问的内容,那么对于前沿LLMs来说,开发出能回答这类问题的模型可能会很轻松。

2. 客观性

答案应该被该领域的其他专家所接受,并且没有个人品味、模糊性或主观性。提供问题中所有必要的上下文和定义,使用标准、明确的术语和符号。

3. 原创性

问题必须是自己的作品,不能抄袭他人。

4. 保密性

问题和答案不能以任何公开渠道获得。

5. 武器化限制

请勿提交与化学、生物、放射性、核武器、网络武器或病毒学相关的问题。

文章来自于“新智元”,作者“LRS”。