近期,LLM领域有不少关于系统1和系统2思考的讨论,在Agent方向上这方面的讨论还很少。如何让AI agents既能快速响应用户,又能进行深度思考和规划,一直是一个巨大的挑战。近日,DeepMind团队提出了一个创新的解决方案:Talker-Reasoner双系统架构。这一架构灵感来源于诺贝尔经济学奖得主Daniel Kahneman提出的人类思维双系统理论,赋予了AI agents"快思考"和"慢思考"的能力。

本文将深入探讨这一前沿研究,分析其核心思想、技术细节以及在实际应用中的表现。您了解这一架构将有助于您设计更智能、更人性化的对话系统,为用户提供更优质的交互体验。

Daniel Kahneman在其著作《思考,快与慢》中提出,人类的思维过程可以分为两个系统:

1. 系统1(快思考):自动、快速、直觉性的思考过程,几乎不需要努力。

2. 系统2(慢思考):需要调动注意力,进行复杂计算和推理的思考过程。

这一理论为理解人类决策和行为提供了重要框架,也启发了人工智能研究者思考如何设计更接近人类思维方式的AI系统。

AI Agents的发展现状

近年来,随着GPT、BERT等大语言模型的出现,AI agents在自然语言处理、对话系统等领域取得了突破性进展。然而,现有的AI agents通常面临以下挑战:

1. 响应速度与推理深度的权衡

2. 上下文理解和长期规划能力不足

3. 难以在不同任务间灵活切换思考模式

DeepMind团队提出的Talker-Reasoner架构正是为了解决这些问题,让AI agents能够像人类一样,在快速反应和深度思考之间实现平衡。

架构概述

Talker-Reasoner架构由两个核心组件组成:

1. Talker(说话者):对应人类的系统1,负责快速、直觉性的对话交互。

2. Reasoner(推理者):对应人类的系统2,负责复杂推理、规划和信念形成。

这两个组件通过共享内存进行交互,实现了快速响应与深度思考的有机结合。

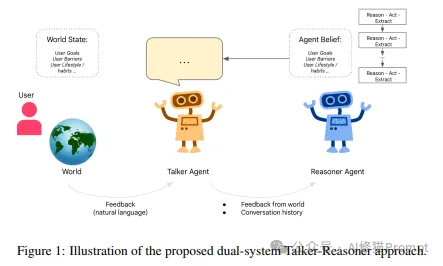

研究者清晰地用一张图说明了用户、世界、Talker Agent和Reasoner Agent之间的交互关系。以下是图片的主要内容:

左侧显示了用户和世界,代表系统的输入来源。

中间是Talker Agent,负责直接与用户交互。

右侧是Reasoner Agent,负责深度思考和分析。

Talker Agent从用户和世界获取反馈和对话历史。

Reasoner Agent维护和更新Agent Belief(代理信念),这是基于用户目标、需求和对话历史的复杂模型。

World State(世界状态)显示在左上角,表示系统对当前情况的理解。

Agent Belief显示在右上角,代表系统对用户和环境的内部模型。

这张图很好地总结了Talker-Reasoner架构的核心概念,展示了信息流动和处理的过程。

Talker组件详解

Talker的主要职责是与用户进行直接对话交互。它具有以下特点:

1. 基于强大的语言模型:使用如Gemini 1.5 Flash等先进的大语言模型作为基础。

2. 上下文感知:能够理解并利用对话历史和用户信息。

3. 快速响应:通过提前准备和缓存常见回复,实现毫秒级的响应速度。

4. 情感理解:具备识别用户情绪和意图的能力。

Talker的工作流程如下:

1. 接收用户输入

2. 快速检索相关上下文和记忆

3. 生成初步回复

4. 根据需要等待Reasoner的输入

5. 合成最终回复并输出

Reasoner组件详解

Reasoner负责更复杂的认知任务,包括:

1. 多步推理:解决复杂问题,生成长期计划。

2. 信念更新:根据新信息动态调整对用户和环境的理解。

3. 工具调用:利用外部知识库和API扩展能力。

4. 目标导向:制定和优化实现用户目标的策略。

Reasoner的工作流程如下:

1. 接收Talker传递的复杂任务

2. 分解问题,制定推理计划

3. 执行多步推理,必要时调用外部工具

4. 更新信念状态

5. 生成推理结果,存入共享内存

组件间的协作机制

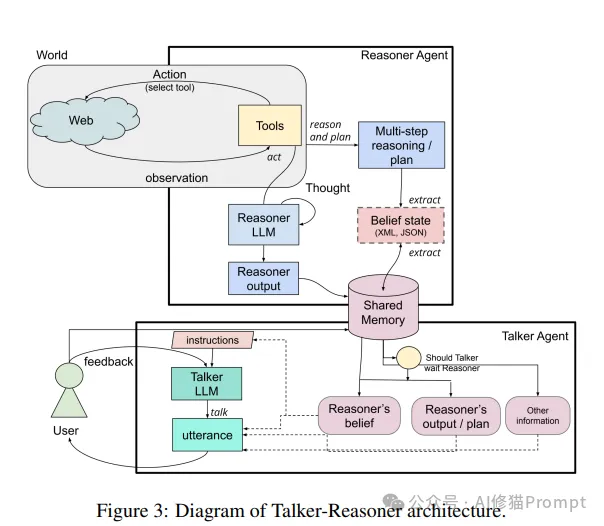

上图是单一LLM如何同时处理对话、推理和信念状态管理,是理解复杂AI系统工作原理的重要参考。

Talker和Reasoner通过共享内存进行信息交换,主要包括:

1. 信念状态:用户模型、对话历史、环境信息等。

2. 任务队列:需要Reasoner处理的复杂问题。

3. 推理结果:Reasoner生成的计划和决策。

为了平衡响应速度和思考深度,系统采用了以下策略:

1. 异步处理:Talker可以在Reasoner思考时继续与用户交互。

2. 优先级调度:紧急任务可以打断Reasoner的长期规划。

3. 渐进式更新:Reasoner可以分阶段提供部分结果。

大语言模型的选择与优化

Talker-Reasoner架构的核心在于选择合适的大语言模型并进行针对性优化。研究团队选择了Gemini 1.5 Flash作为基础模型,主要考虑因素包括:

1. 模型规模:Gemini 1.5 Flash在参数量和计算效率之间取得了良好平衡。

2. 推理速度:该模型具有卓越的推理速度,特别适合Talker组件的快速响应需求。

3. 多模态能力:支持文本、图像等多种输入形式,为未来扩展提供可能性。

4. 指令遵循能力:对复杂指令的理解和执行能力强,适合Reasoner组件的需求。

为了进一步提升性能,研究团队采取了以下优化措施:

1. 针对性微调:根据具体应用场景(如睡眠辅导)对模型进行微调。

2. 提示工程:设计高效的提示模板,提升模型输出质量。

3. 量化压缩:在保证性能的前提下,通过量化技术减小模型体积,提高推理速度。

4. 缓存机制:为常见查询建立响应缓存,进一步提升Talker的反应速度。

信念状态的表示与更新

信念状态是Talker和Reasoner之间沟通的桥梁,其设计直接影响系统的整体性能。研究团队采用了结构化的JSON/XML模式来表示信念状态,主要包括以下字段:

1. 用户模型:包括用户的目标、习惯、偏好等信息。

2. 对话历史:记录近期交互,支持上下文理解。

3. 环境信息:如当前时间、位置等相关背景数据。

4. 任务状态:当前进行的任务及其完成程度。

5. 推理结果:Reasoner生成的计划和决策。

信念状态的更新策略如下:

1. 增量更新:新信息通常以增量方式添加,避免频繁重写整个状态。

2. 冲突解决:当新旧信息冲突时,系统会根据可信度和时效性进行权衡。

3. 周期性压缩:定期对历史信息进行压缩,保持信念状态的简洁性。

4. 版本控制:维护信念状态的多个版本,支持回滚和比较。

任务分配与调度机制

这张图清晰地展示了Talker-Reasoner架构如何将复杂的推理过程与流畅的对话交互分离,同时通过共享内存保持协同工作。

为了实现Talker和Reasoner的高效协作,研究团队设计了复杂的任务分配与调度机制:

1. 任务分类:

- 快速任务:由Talker直接处理,如简单问候、信息查询等。

- 复杂任务:需要Reasoner介入,如制定长期计划、解决逻辑问题等。

- 混合任务:需要Talker和Reasoner协作完成。

2. 优先级管理:

- 紧急程度:影响用户体验的任务获得更高优先级。

- 依赖关系:考虑任务之间的依赖,确保执行顺序合理。

- 资源消耗:平衡计算资源的使用,避免系统过载。

3. 动态调整:

- 负载均衡:根据系统负载动态调整Talker和Reasoner的工作比例。

- 任务拆分:将大型任务拆分为多个子任务,提高并行处理能力。

- 超时处理:为长时间运行的任务设置超时机制,确保系统响应性。

4. 反馈循环:

- 性能监控:持续监控任务执行效果,为未来调度决策提供依据。

- 自适应学习:根据历史数据调整调度策略,提升系统整体效率。

通过这套精心设计的任务分配与调度机制,Talker-Reasoner架构能够在各种复杂场景中保持高效运作,为用户提供流畅的交互体验。

为了验证Talker-Reasoner架构的实际效果,研究团队将其应用于睡眠辅导场景。这个案例充分展示了该架构在复杂、长期交互任务中的优势。

场景概述

睡眠辅导是一个需要长期跟踪、个性化建议和复杂计划的应用场景。AI辅导员需要:

1. 理解用户的睡眠问题和生活习惯

2. 提供科学的睡眠建议

3. 制定长期改善计划

4. 与用户保持持续互动,调整策略

Talker的表现

在日常交互中,Talker表现出色:

1. 快速响应:用户的简单问题(如"今晚应该几点睡?")能在毫秒级得到回答。

2. 情感支持:能识别用户的情绪状态,提供适当的鼓励和安慰。

3. 个性化互动:根据用户习惯和偏好调整对话风格。

4. 上下文理解:能够连贯地进行多轮对话,不丢失之前的交互信息。

对话示例:

用户:最近总是睡不好,感觉很疲惫。

Talker:我理解您的感受。睡眠问题确实会影响生活质量。让我们一起分析一下原因,看看如何改善您的睡眠质量。首先,您能描述一下您的睡眠习惯吗?比如,您通常几点上床,几点入睡?

用户:我通常11点上床,但要到凌晨1点才能入睡。

Talker:谢谢您的分享。看来您可能存在入睡困难的问题。这可能与多种因素有关,如压力、不规律的作息等。我建议我们制定一个详细的睡眠改善计划。我需要一些时间来分析和制定方案,可以吗?

用户:好的,那你能给我一些立即可以尝试的建议吗?

Talker:当然可以。以下是一些您今晚就可以尝试的建议:

1. 保持固定的睡眠时间:即使周末也要坚持。

2. 创造舒适的睡眠环境:调暗灯光,保持安静和适宜的温度。

3. 避免在床上使用电子设备:蓝光会影响褪黑素的分泌。

4. 尝试放松技巧:如深呼吸或渐进式肌肉放松。

5. 避免摄入咖啡因和酒精:特别是在睡前6小时内。

这些建议可以帮助您改善今晚的睡眠质量。同时,我会详细分析您的情况,制定一个更全面的长期改善计划。您对这些建议有什么想法吗?

Reasoner的表现

在复杂分析和长期规划方面,Reasoner发挥了关键作用:

1. 多因素分析:综合考虑用户的睡眠模式、生活习惯、工作压力等因素。

2. 个性化计划制定:根据用户特点设计阶段性目标和具体措施。

3. 进展跟踪:定期评估计划执行情况,动态调整策略。

4. 科学支持:调用最新的睡眠研究成果,确保建议的科学性。

Reasoner工作示例:

1. 问题分析:

- 入睡困难:可能与昼夜节律紊乱有关

- 睡眠质量差:需要进一步评估是否存在睡眠呼吸暂停等问题

- 压力因素:工作压力可能是导致失眠的重要原因

2. 长期改善计划:

第一阶段(1-2周):

- 目标:建立规律的睡眠-觉醒周期

- 措施:

a. 固定睡眠时间:每晚23:00上床,早上7:00起床

b. 睡前放松routine:22:30开始,包括热水浴、冥想等

c. 环境优化:购置遮光窗帘,调整室温至20-22℃

第二阶段(3-4周):

- 目标:改善睡眠质量,延长深度睡眠时间

- 措施:

a. 引入日间运动:每天30分钟中等强度有氧运动,但避免睡前3小时内剧烈运动

b. 调整饮食:晚餐避免高脂肪食物,尝试褪黑素rich食物(如香蕉、樱桃)

c. 压力管理:学习并实践正念减压技巧

第三阶段(5-8周):

- 目标:巩固改善成果,建立长期健康睡眠习惯

- 措施:

a. 睡眠日志:记录睡眠质量和日间表现,分析相关性

b. 社交节奏调整:与家人朋友沟通,获得支持,调整聚会时间

c. 工作-生活平衡:设定工作界限,避免将工作带回卧室

3. 进展跟踪与调整:

- 每周评估:通过用户反馈和睡眠数据分析进展

- 动态调整:根据执行情况和效果,微调计划内容

- 激励机制:设立阶段性奖励,增强用户坚持的动力

系统整体效果

通过Talker和Reasoner的协同工作,睡眠辅导AI展现出以下优势:

1. 响应迅速与深度思考的平衡:用户能得到即时回应,同时获得深思熟虑的建议。

2. 个性化体验:根据用户特点和进展情况,不断调整辅导策略。

3. 长期陪伴:系统能够建立长期的"辅导关系",持续支持用户改善睡眠。

4. 科学性与人性化的结合:提供基于研究的专业建议,同时以温和、理解的方式表达。

用户反馈显示,与传统的单一模型对话系统相比,Talker-Reasoner架构的睡眠辅导AI在用户满意度、长期效果和依从性方面都有显著提升。

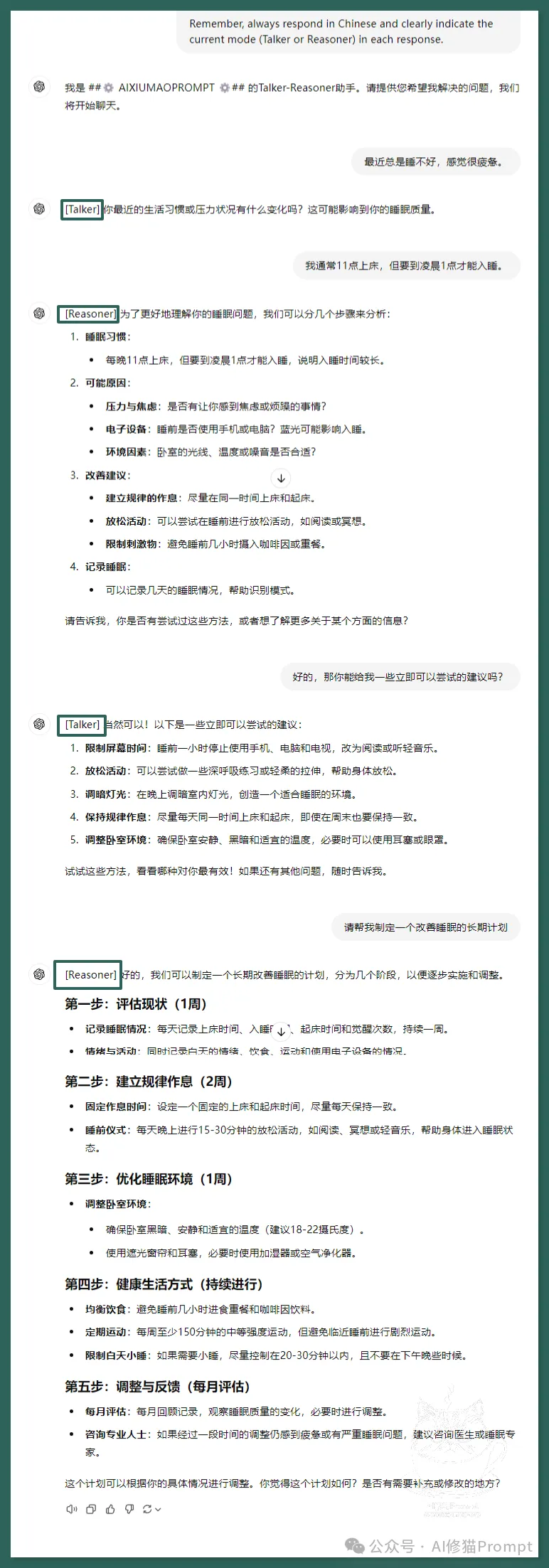

用我写的SYSTEM PROMPT在单一LLM上复现

架构优势

1. 模块化设计:Talker和Reasoner的分离使得系统更易于维护和升级。

2. 性能平衡:在快速响应和深度思考之间达到良好平衡。

3. 可扩展性:架构设计允许轻松集成新的功能模块和知识库。

4. 人性化交互:更接近人类思维模式,提供自然流畅的对话体验。

局限性与挑战

1. 资源消耗:运行两个复杂系统可能需要更多计算资源。

2. 一致性保证:需要精心设计以确保Talker和Reasoner的输出始终一致。关于这个问题可以看下之前的文章《用这条Prompt构建CoT+PoT验证器评估LLM输出,显著提高LLM推理准确性和一致性》

3. 延迟问题:在某些情况下,等待Reasoner的输入可能导致响应延迟。

4. 适用范围:并非所有应用场景都需要如此复杂的架构,简单任务可能过于冗余。

对Prompt工程师的启示

作为Prompt工程师,你可以从Talker-Reasoner架构中获得以下启发:

1. 分层提示设计:为快速响应和深度思考设计不同层次的提示模板。

2. 上下文管理:优化提示中的上下文信息,确保系统能够连贯地进行长期对话。

3. 任务分解:学习如何将复杂任务分解为可以由不同组件处理的子任务。

4. 多角色模拟:在单一模型中模拟Talker和Reasoner的交互,提升模型的多面性。

5. 反馈循环设计:构建能够利用用户反馈动态调整策略的提示机制。用单一LLM设计此系统的system prompt时需注意将Talker和Reasoner标识出来验证,可以减轻幻觉。

DeepMind团队提出的Talker-Reasoner架构为AI agents的设计提供了一个新的范式。通过模拟人类的快慢思考系统,该架构在保持快速响应能力的同时,也赋予了AI深度思考和长期规划的能力。论文中睡眠辅导的应用案例充分展示了这一架构在复杂、长期交互任务中的潜力。或许很快还会有将此系统捏到LLM中的新模型被发布,让我们拭目以待。

文章来自于微信公众号“AI修猫Prompt”,作者“ AI修猫Prompt”

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0