打造更强大文生图模型新思路有——

面对Flux、stable diffusion、Omost等爆火模型,有人开始主打“集各家所长”。

具体来说,清北、牛津、普林斯顿等机构的研究者提出了⼀个全新文生图框架IterComp。

它能提取不同模型在各自领域的优势,同时不引入额外的复杂指令或增加计算开销。

论文一经发布,即在????(前推特)获得AI论文领域大V转发,吸引大量关注。

那么,研究人员具体是如何实现的呢?

⾃2022年以来,基于diffusion的文生图模型取得了快速发展,尤其在复杂组合生成(complex/compositional generation)任务上取得了显著进展。

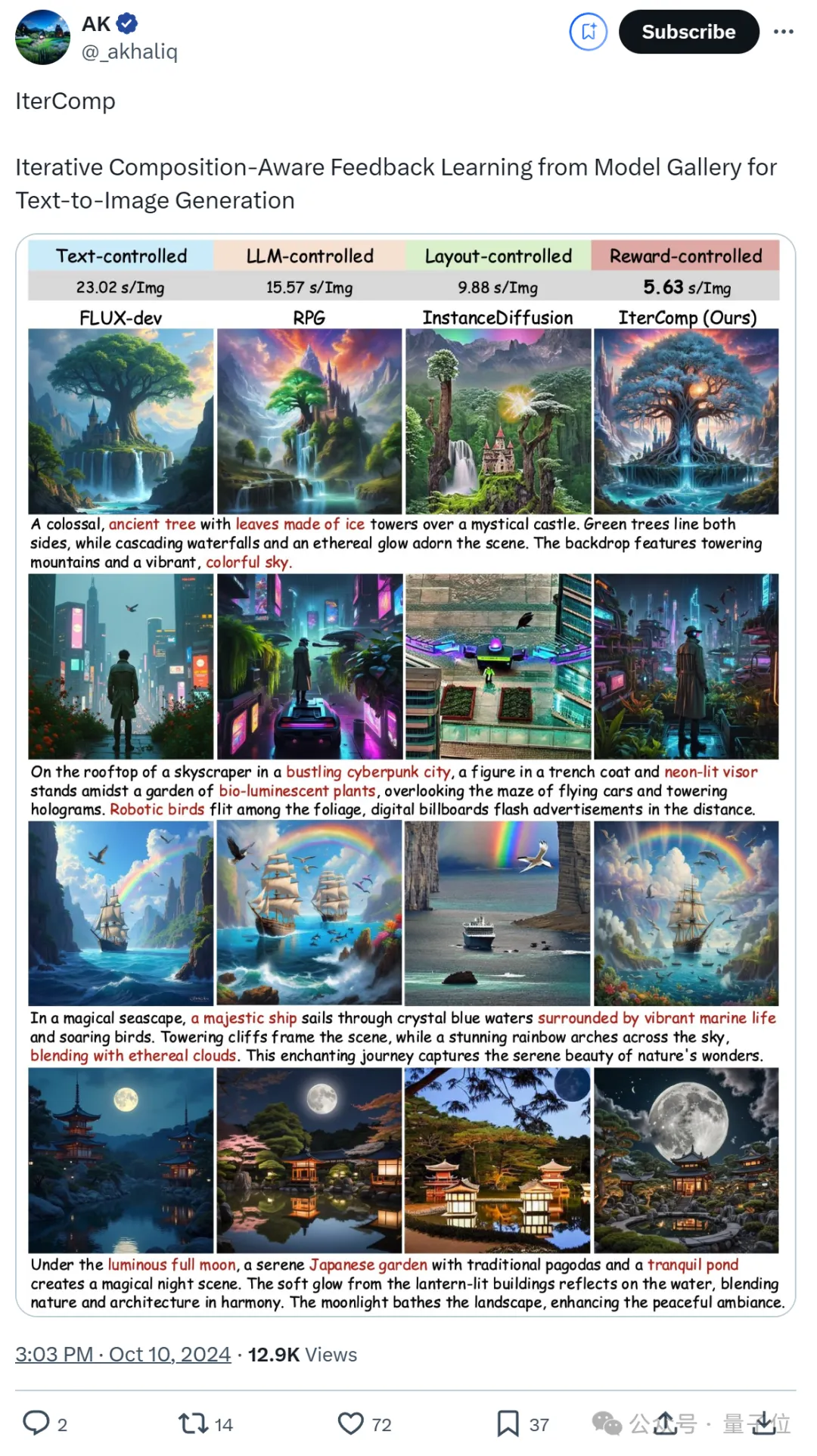

例如,今年8月发布的Flux展现出了十分震撼的复杂场景生成能力与美学质量;

RPG通过MLLM的辅助,将复杂的组合生成任务分解为简单子任务;

InstanceDiffusion通过布局控制(layoutbased),实现了与布局分布高度一致的精确图像生成。

然而,这些模型的优势仅限于某些特定的组合生成任务,且存在诸多局限。

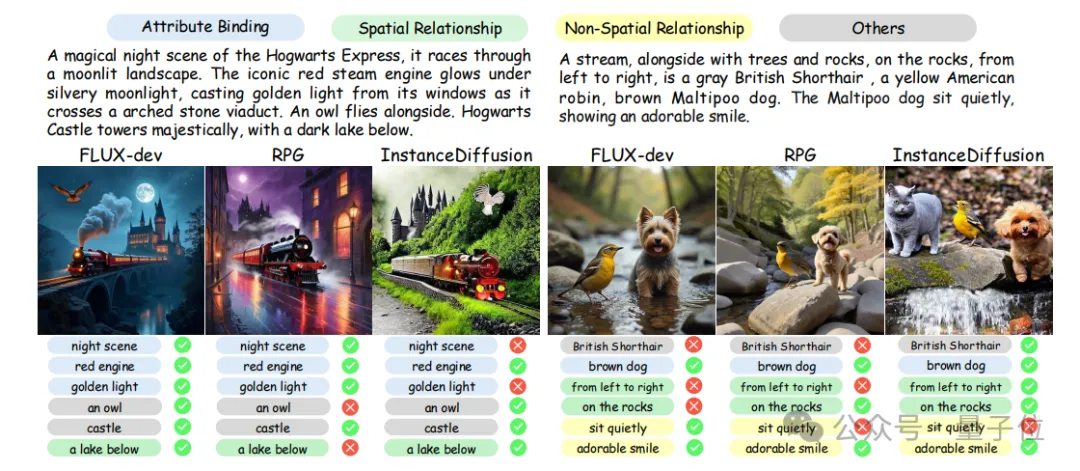

基于文本的生成方法(如SDXL、SD3、Flux等),由于其训练数据和框架的优势,在物体与场景的模拟上表现出色,特别在美学质量、属性绑定和非空间关系(non-spatial relationships)方面具有显著优势。

然而,当涉及多个物体,且存在复杂的空间关系时,这类模型往往表现出明显不足。

基于大语言模型(LLM-based)的生成方法,如RPG和Omost,通常需要对LLM进⾏额外训练或设计复杂的提示。

然而,对于LLM处理后的复杂指令,diffusion backbone并不具备精确生成的能力。

基于布局(layourbased)的生成方法,如Instancediffusion和LMD+,虽然提供了精确的控制,但在图像的美学质量和真实性上存在明显下降,并且需要人为设计布局。

因此,一个值得深⼊探讨的问题是:

能否设计出一个强大的模型,在上述多个方面都表现出⾊,同时不引入额外的复杂指令或增加计算开销?

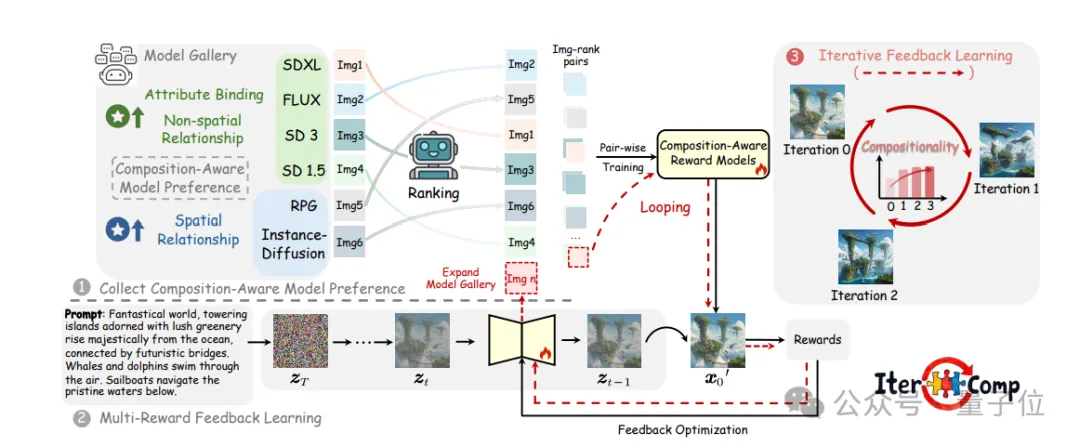

基于此,研究人员提出一个全新的文生图框架:IterComp。

要充分解决这⼀问题,研究面临两大难点:

1、如何提取不同模型在各自领域的优势,并引导模型进行有效学习?

针对该问题,研究人员首先构建了模型库(model gallery),其包含多种在不同方面表现出色的模型,每个模型都具备特定的组合生成偏好(composition-aware model preference)。

研究人员尝试通过扩散模型对齐方法,将base diffusion model与模型库中的组合生成偏好进行对齐。

团队聚焦于compositional generation的三个关键方面:

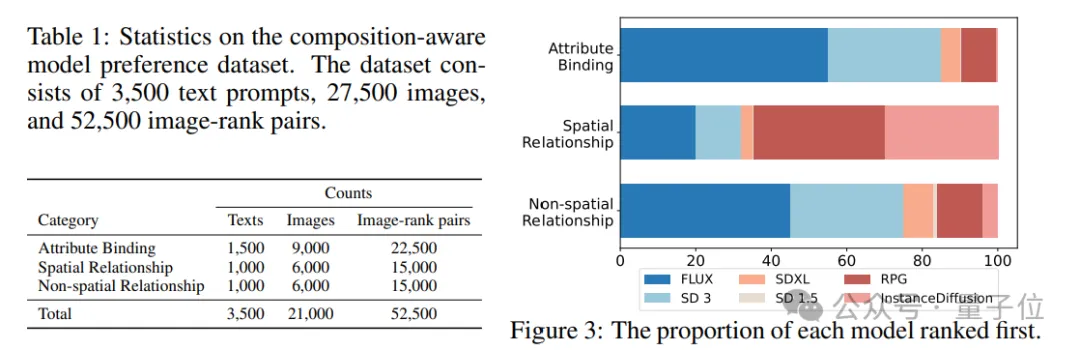

为此,研究人员收集了不同模型在这些方面的偏好数据,并通过人工排序,构建了⼀个面向组合生成的模型偏好数据集(composition-aware model preference dataset)。

针对这三个方面,团队分别训练三个composition-aware reward models,并对base模型进行多奖励反馈优化。

2、组合生成任务很难优化,如何更充分地学习到不同模型的组合偏好?

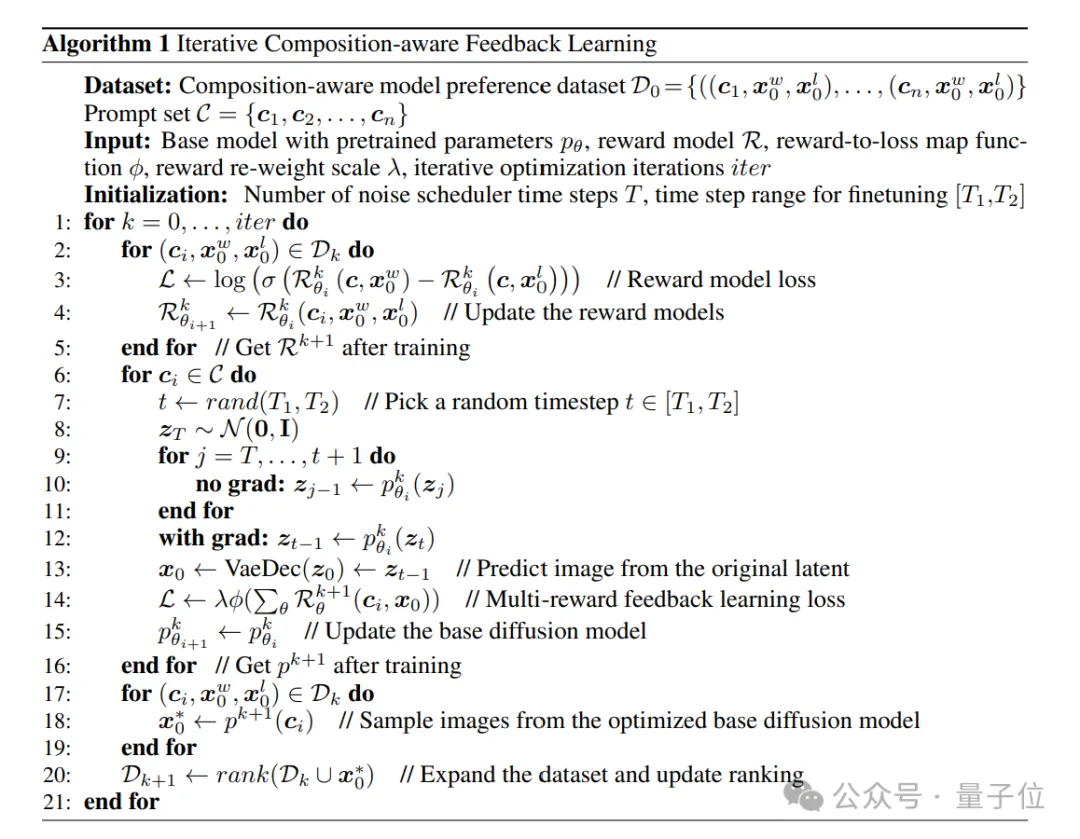

研究人员在diffusion领域创新地引入迭代式学习框架(iterative feedback learning),实现reward models与base diffusion model之间“左脚踩右脚登天”。

具体来说,在上述第一轮优化后,团队将optimized base diffusion model以及额外选择的其他模型(例如Omost等)添加进model gallery。

对新增模型进行偏好采样,与初始model gallery中的图像按照预训练的reward model构建图像对。

这些图像对被用于进⼀步优化奖励模型,随后继续用更新的奖励模型优化基础扩散模型。

具体的流程如下伪代码所示:

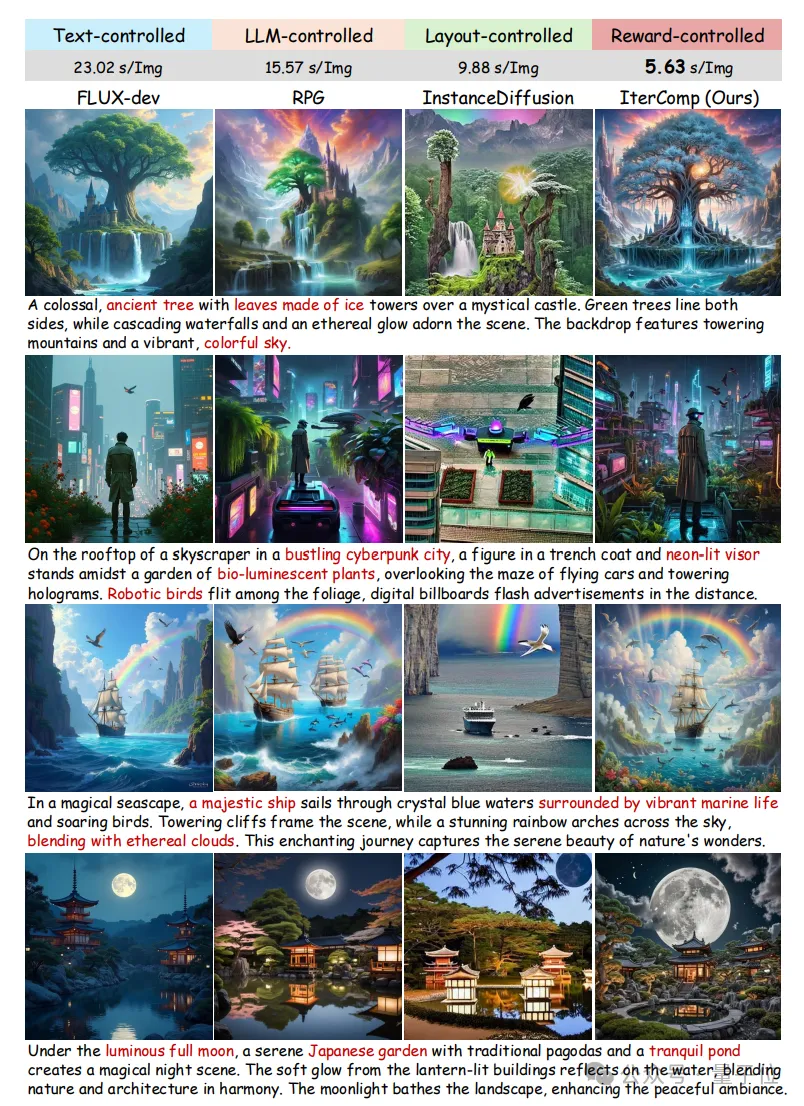

在定性实验中,与其他三类compositional generation方法相比,IterComp取得了显著的组合质量的提升,并且不会引入额外的计算量。

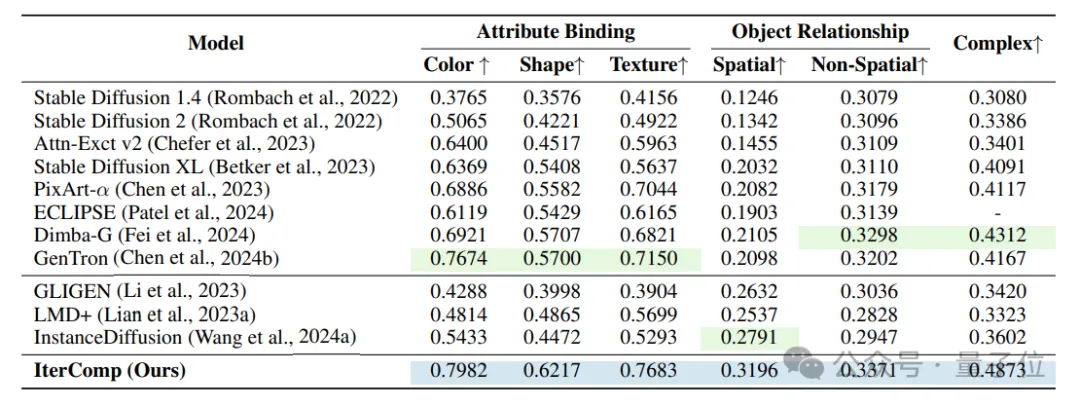

从定量结果中可以看出,IterComp在T2I-CompBench上取得了各方面的领先。

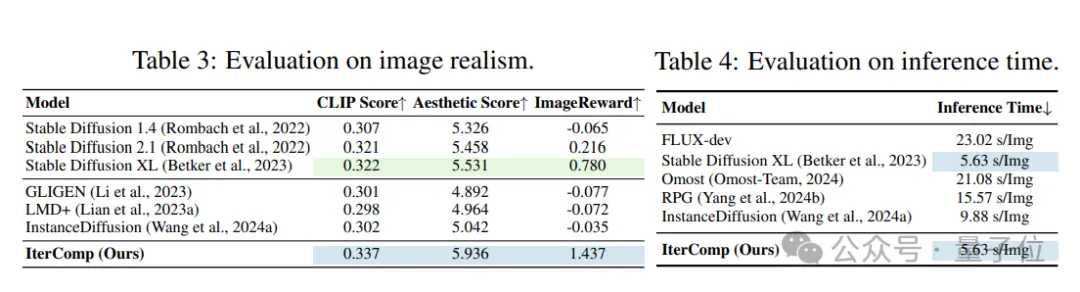

另外,针对图像真实性以及美学质量,IterComp也表现出色。

然而IterComp的应用潜力不限于此,其可以作为强大的backbone显著提升Omost, RPG等模型的生成能力。

论文地址:

https://arxiv.org/abs/2410.07171

代码地址:

https://github.com/YangLing0818/IterComp

模型地址:

https://huggingface.co/comin/IterComp

Civitai:

https://civitai.com/models/840857

文章来自于“量子位”,作者“IterComp团队”。