多年来,浙江大学周晟老师团队与阿里安全交互内容安全团队持续开展产学研合作。近日,双⽅针对标签噪声下图神经⽹络的联合研究成果《NoisyGL:标签噪声下图神经网络的综合基准》被 NeurIPS Datasets and Benchmarks Track 2024 收录。本次 NeurIPS D&B Track 共收到 1820 篇投稿,录⽤率为 25.3%。

图神经网络(GNNs)在节点分类任务中通过消息传递机制展现了强大的表示力。然而,它们的性能往往依赖于⾼质量的节点标签。在现实世界中,由于不可靠的来源或对抗性攻击,节点标签中通常存在噪声。不过,目前针对该领域缺乏⼀个综合的基准。

为填补这⼀空白,本文提出了 NoisyGL 方法,这是第⼀个针对标签噪声下图神经⽹络的综合基准。NoisyGL 使⽤统⼀的实验设置和接⼝,可以在具有不同性质的图数据上对不同⽅法的抗噪性能进⾏公平比较和多⻆度分析。此外,NoisyGL 也是⼀个可扩展且易于使⽤的 GLN 框架,便于后续的研究者跟进。

本⽂亮点包括如下:

许多现实世界中的复杂系统可以表示为图结构数据,包括引⽂网络、⽣物网络、交通网络和社交网络。图神经网络(GNNs)通过消息传递机制(Message passing mechanism)聚合邻域节点的信息,在建模图数据方⾯表现出了显著的优势。在 GNNs 的众多应⽤中,节点分类是研究最为深入的任务之⼀。通常在节点分类任务中,GNNs 以半监督的模式进⾏训练。

尽管图神经网络取得了成功,但它们在半监督图学习任务中的表现高度依赖于精确的节点标签,而在现实世界中,精确的标签很难获得。例如,对于在线社交⽹络,手动标记数百万⽤户的过程成本⾼昂,因此⽤户的标签通常依赖于⽤户⾃⼰的标注,这些标注通常是不可靠的。

此外,图数据容易受到对抗性标签翻转攻击的影响。因此,标签噪声在图数据中普遍存在。研究表明,标签噪声会显著降低机器学习模型在计算机视觉和自然语⾔处理场景中的泛化能力。在 GNNs 中,消息传递机制可能会通过传播错误的监督信息,从而进⼀步加剧这种负⾯影响。

为了在带标签噪声的图数据上实现稳健学习,⼀个直观的解决方案是借鉴以往标签噪声学习(LLN)策略的成功经验,并将其应⽤于图神经网络。然而,由于图数据并不具有独立同分布性质、节点标签的稀疏性以及 GNNs 的消息传递机制,这些 LLN 方法并不总是适⽤于图学习任务。在这个背景下,标签噪声下的图神经⽹络(GNNs under Label Noise, GLN)研究最近受到了关注。

然而,由于数据集选择、数据分割和预处理技术的差异,⽬前 GLN 领域缺乏⼀个综合的基准,这阻碍了对该领域的深⼊理解和进⼀步发展。

图神经网络(GNNs)通过消息传递机制在节点分类任务中表现出强大的潜力。然而,它们的性能往往依赖于⾼质量的节点标签。在现实任务中,由于不可靠的来源或对抗性攻击,准确的节点标签很难获得。因此,标签噪声在现实世界的图数据中很常见。噪声标签会在训练过程中传播错误信息,从而对 GNNs 产生负⾯影响。

为了解决这个问题,标签噪声下的图神经网络(GNNs under Label Noise, GLN)的研究最近受到了关注。然而,由于数据集选择、数据划分和预处理技术的差异,社区⽬前缺乏⼀个全面的基准,这阻碍了对 GLN 的深入理解和进⼀步发展。为填补这⼀空⽩,我们在本⽂中介绍了 NoisyGL,这是第⼀个针对标签噪声下图神经网络的全⾯基准。NoisyGL 在各种数据集上,通过统⼀的实验设置和接口,实现了对 GLN 方法的公平比较和详细分析。我们的基准揭示了之前研究中遗漏的几个重要⻅解,相信这些发现对未来的研究将非常有益。同时也希望我们的开源基准库 NoisyGL 能促进该领域的进⼀步发展。

1、问题定义

2、数据集选择

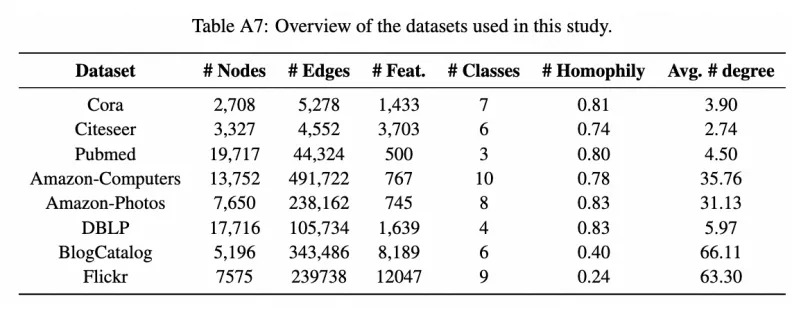

我们选择了 8 个节点分类数据集,这些数据集在不同的图标签噪声研究中被⼴泛使⽤。这些选定的数据集来⾃不同领域,具有不同的特征,使我们能够评估现有⽅法在各种场景中的泛化能力。

具体来说,我们使用了三个经典的引⽂⽹络数据集 Cora、Citeseer、Pubmed,以及⼀个作者合作网络数据集 DBLP,还有两个代表性的产品共购网络数据集 Amazon- Computers 和 Amazon-Photo。此外,为了验证各种方法在异质图上的性能,我们使用了两个代表性的社交网络数据集 BlogCatalog 和 Flickr。对于每⼀种数据集,我们为其适配最为常用的训练 - 测试 - 验证集划分方法,以确保对各种方法进行公平比较。

3、方法选择

我们选择了⼀系列最先进的 GLN 算法,包括 NRGNN、RTGNN、CP、D-GNN、 RCNGLN、CLNode、PIGNN、UnionNET、CGNN 和 CRGNN;以及⼀组设计良好的 LLN 方法,包括两种损失修正方法 Forward Correction 和 Backward Correction、两种稳健损失函数 APL 和 SCE、两种多网络学习方法 Coteaching 和 JoCoR,以及⼀种噪声适应层方法 S- model。并根据它们的论⽂和源代码严格地复现了所有⽅法。

4、期望研究的问题

在这项工作中,我们旨在回答以下问题:

RQ1:LLN ⽅法能否直接应⽤于图学习任务?

动机:尽管最近的研究表明,直接将传统的标签噪声下的学习(Learning with Label Noise, LLN)⽅法应用于图学习任务可能不会产⽣最佳结果,但⽬前对这⼀问题仍然缺乏全⾯的分析。因此,我们希望调查现有 LLN ⽅法对图学习的适⽤性并理解其背后的原因。通过研究这个问题,我们可以更清楚地了解图标签噪声带来的独特挑战,并确定哪些 LLN 技术在图学习环境中仍然有效。

实验设计:我们选择了在前文中提到的 7 种 LLN 方法,并以 GCN 作为骨干模型实现这些方法。然后,我们在八种具有不同性质的数据集上进行节点分类实验,评估它们在不同类型和水平的标签噪声下的有效性。对于每种方法和数据集,我们记录了 10 次运⾏的平均准确率指标和标准差。通过比较这些 LLN 方法的性能,我们可以确定额外的 LLN 方法是否增强了骨干 GCN 模型的稳健性。

RQ2: 现有的 GLN 方法取得了多大进展?

动机:尽管先前的研究提出了许多 GLN 方法,但它们使⽤了不同的数据集、数据划分和预处理技术,使得我们难以公平⽐较这些⽅法的性能。此外,我们注意到⼤多数现有⽅法是在同质图上进⾏评估的,这引发了它们在异质图上适⽤性的担忧,⽽异质图在实际中也很常⻅。通过研究这个问题,我们希望确定当前的 GLN ⽅法是否有效地解决了图标签噪声问题,并找出它们的不⾜之处。

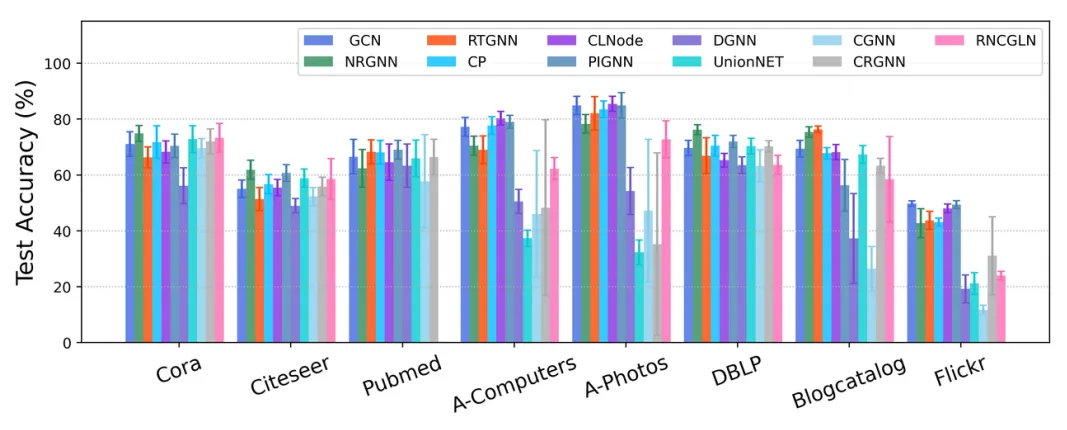

实验设计:我们实现了前⽂中描述的 10 种先进的 GLN ⽅法,然后使⽤ 8 个具有不同性质的数据集和统⼀的实验设置评估这些⽅法的性能。对于每种⽅法和数据集,记录了 10 次运⾏的平均测试准确率和标准差。由于这些 GLN ⽅法多数基于 GCN,我们在这些⽅法的代码实现中调⽤⼀个统⼀的 GCN ⻣⼲模型,以公平地评估它们对标签噪声的稳健性。

RQ3: 现有的 GLN ⽅法计算效率如何?

动机:GLN 的计算效率对于其在现实世界中的应⽤至关重要,⽽考虑标签噪声可能会导致更⾼的计算开销。尽管先前的研究深入探讨了 GLN 方法的准确性、泛化能⼒和稳健性,但却忽略了对这些方法计算效率的研究。

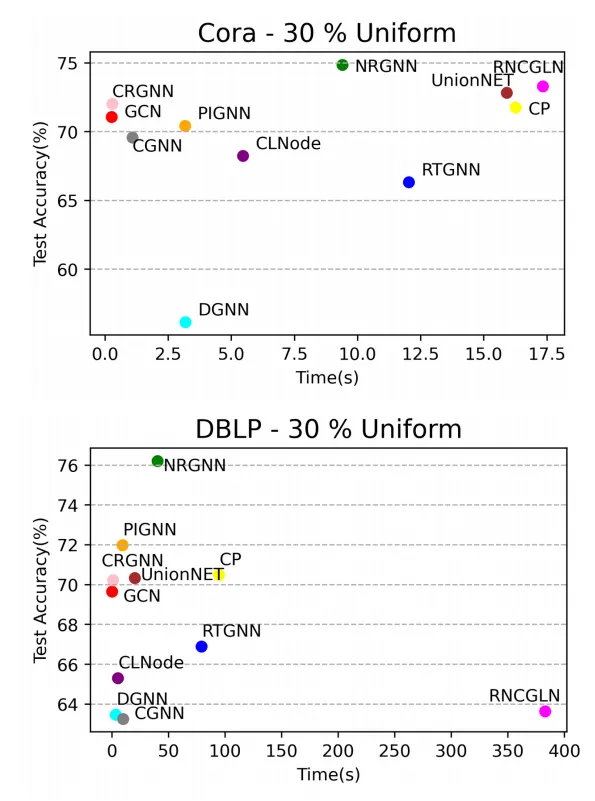

实验设计:我们记录了在 30% 均匀噪声下各种方法在不同数据集上的运⾏时间和测试准确率。具体来说,对于每种方法在每个数据集上进行了 10 次实验。在每次实验中测量模型在验证集上达到最佳准确率时的时间,并将其视为该⽅法的总运行时间。通过这些实验可以评估 GLN 方法在计算效率和测试准确率之间是否达到了平衡。

RQ4:现有的 GLN ⽅法对噪声率敏感吗?

动机:之前的研究使用了不同的标签噪声率,这使得我们难以横向比较各种方法的性能。因此,有必要使用⼀组⼀致的噪声率来验证现有的 GLN 方法是否在不同噪声水平下保持稳定的性能。

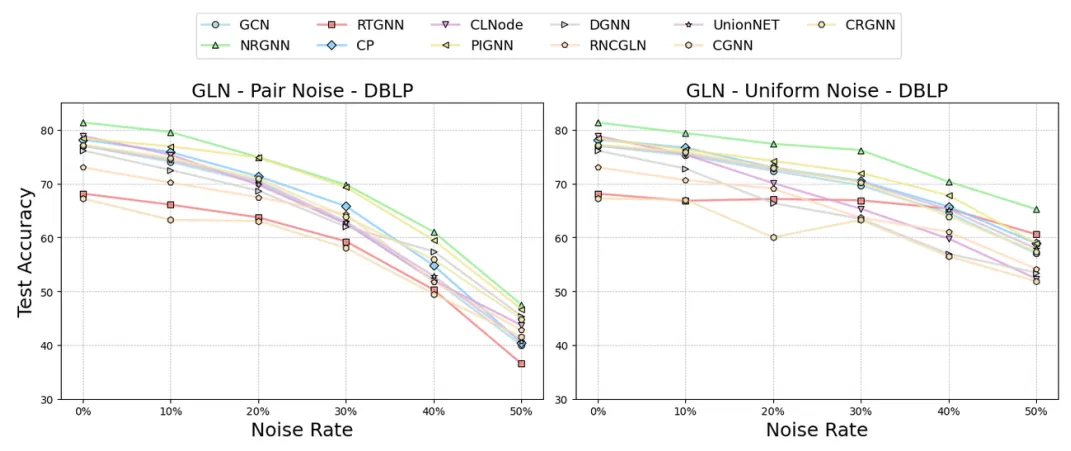

实验设计:我们在相同的数据集和噪声类型下评估几种 GLN 方法在不同噪声水平下的性能。具体来说,引入了 10%、20%、30%、40% 和 50% 的标签噪声,并使⽤干净标签作为基线。随后,按照 RQ2 中描述的实验设置在这些数据集上训练并评估 GLN 方法。

RQ5:现有的 GLN ⽅法对不同类型的标签噪声下表现如何?

动机:现有的 GLN 方法是基于各种技术和假设开发的,因此在处理不同类型的噪声时,它们具有独特的优势和劣势。此外,确定哪种类型的噪声对图学习最具破坏性并理解其背后的原因是至关重要的。解决这个问题将有助于我们更好地理解每种方法的具体适⽤场景以及不同类型标签噪声的独特特性。

实验设计:我们保持 30% 的噪声率不变,并对标签应⽤均匀噪声和对偶噪声。随后,按照 RQ2 中描述的实验设置在这些噪声数据集上训练并评估 GLN 方法。

RQ6:好还是坏?重新审视图结构在标签噪声中的作⽤。

动机:额外的图结构区分了图数据和其他类型的⾮ i.i.d. 数据。而图神经⽹络的成功在很大程度上依赖于消息传递机制,该机制从图结构上的邻域节点聚合信息。然而,在存在标签噪声的情况下,沿着边传播的消息可能有双重效果:⼀方面,标签噪声通过传播错误信息对图学习产生负⾯影响;另⼀⽅⾯,它也可能通过与邻居中的多数标签对⻬来缓解这种影响。因此,至关重要的是研究额外的图结构是否会放⼤标签噪声的影响,以及现有的⽅法是否能有效解决这⼀挑战。

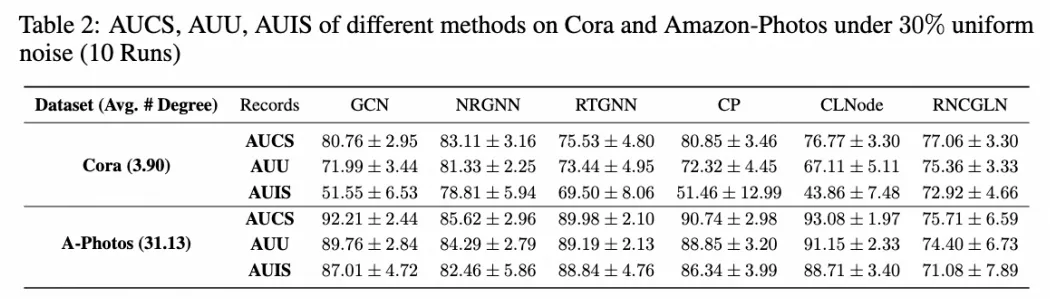

实验设计:我们对全部十八种方法进⾏了全面的实验,包括⼀个 GCN 基线、七种 LLN 方法和十种 GLN 方法,旨在明确图结构在标签噪声存在的情况下如何影响图学习。具体来说,我们记录了以下几个指标,包括在 30% 均匀噪声下的正确标记的训练节点的预测准确率(ACLT)、错误标记的训练节点的预测准确率(AILT)、正确监督的未标记节点的预测准确率(AUCS)、未监督的未标记节点的预测准确率(AUU)和错误监督的未标记节点的预测准确率(AUIS)。这⾥,「正确监督」、「错误监督」和「未监督」分别指的是在未标注节点的邻域中有正确标记的训练节点、错误标记的训练节点以及没有标记节点的未标记节点。

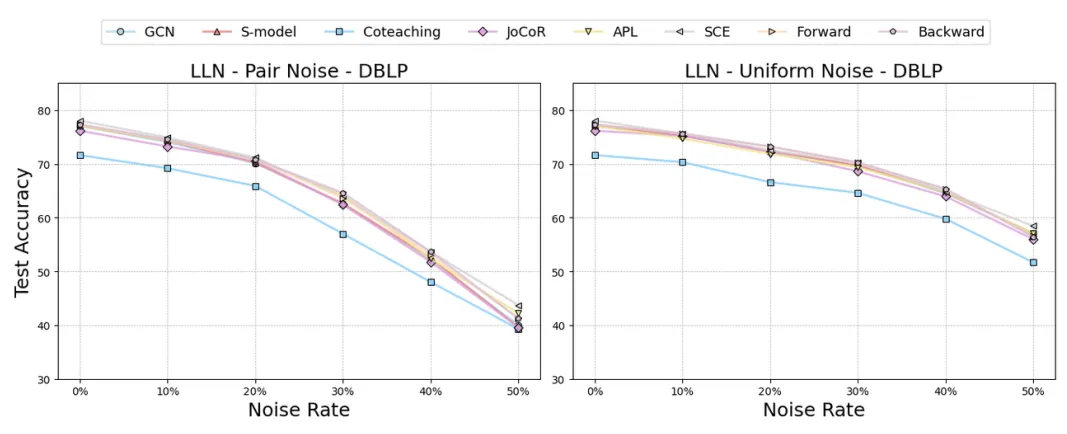

结论 1:大多数 LLN 方法并未显著提高 GNN 对标签噪声的稳健性(RQ1)。

实验结果显示,存在标签噪声的情况下,大多数选定的 LLN 方法并未显著提⾼ GNN 骨干的性能。大多数情况下,这些 LLN 方法的性能在统计上与基线相似。在某些情况下,应⽤额外的 LLN ⽅法甚至可能会导致更差的结果。

三种包含噪声转移矩阵的 LLN 方法 S-model、Forward Correction 和 Backward Correction,在大多数情况下表现与基线相似。通常,这些基于转移矩阵的方法学习到的是对⻆转移矩阵,这表明由于标签的稀缺,它们未能学习正确的标签转移模式。多网络学习方法 Coteaching 和 JoCoR 在稀疏图上表现与基线相似,但在密集图上表现不佳。值得注意的是,我们发现两种稳健损失函数,主动被动损失(APL)和对称交叉熵(SCE),在⼀些数据集上略微增强了基线模型的稳健性。这种改进可能是由于它们能够减少对错误标记样本的过拟合,而它们的独⽴同分布假设则限制了这种改进的幅度。因此得出结论,仅仅将 LLN 方法应用于 GNN 并不能实现对标签噪声稳健的图学习解决⽅案。

结论 2:现有的 GLN ⽅法在⼤多数情况下可以缓解标签噪声,但这种改进仅限于特定的适⽤场景(RQ2)

对于每个数据集,总有⾄少⼀种 GLN 方法的抗噪能力优于基线 GCN,这表明这些 GLN 方法在缓解图标签噪声问题上是有效的。然⽽,没有⼀种方法能在所有数据集中始终表现良好。例如,NRGNN 在 Cora、Citeseer 和 DBLP 数据集中显著优于基线 GCN,但在其他数据集中则不然。这⼀结果表明,现有的 GLN 方法缺乏在不同类型数据中泛化的能力。此外,我们观察到在 Flickr 数据集中,所有 GLN 方法的表现都不如基线,这突显了它们在处理⾼度异质图⽅⾯的不⾜。

结论 3:⼀些 GLN 方法的计算效率不高(RQ3)

尽管多种 GLN 方法在减少标签噪声方面有效,但通常需要大量计算资源。实验结果表明,⼀些 GLN 方法在性能与计算效率之间难以平衡。例如,在 Cora 数据集上,RNCGLN 是最慢的,比 GCN 慢 66.8 倍,而在 DBLP 数据集上更是慢了惊人的 2945.8 倍。而在另⼀⽅⾯,虽然 NRGNN 方法也比 GCN 消耗更多时间,但它在两个数据集上实现了性能与计算效率之间的合理平衡。

结论 4:大多数 GLN 方法在严重噪声下无法保证高性能(RQ4)

在通常情况下,随着噪声水平的增加,每种方法的测试准确率都会下降。这种下降在对偶噪声中最为显著,在 50% 对偶噪声下,所有方法的测试准确率⼏乎减半。此外,我们注意到在所有数据集上 RTGNN 在均匀噪声下表现相对稳定,并且 NRGNN 和 PIGNN 两种方法在不同噪声水平和类型下,在 DBLP 数据集上的表现优于基线 GCN。

结论 5:对图学习来说,对偶噪声更具危害性(RQ5)

在实验中,我们观察到对偶噪声对模型的泛化能力构成了最显著的威胁。我们对此发现有⼀个解释:回顾在前文中提供的定义。对于均匀噪声,真实标签有可能翻转到任何其他类别,这可能由于被错误标注的节点导致的不正确参数更新可以被其他错误标注的节点部分抵消。然⽽,对偶噪声将翻转类别限制为特定的对偶类别。对于分类器来说,这种类型的对偶翻转可能更具误导性。在完全训练后,分类器更有可能过拟合这些对偶标签,从而作出对偶类别的预测。当节点特征通过消息传递机制传播时,这种情况尤其有害,这可能导致局部邻域内的嵌⼊更加相似,从⽽使得它们更有可能被错误分类到相应的对偶类别。

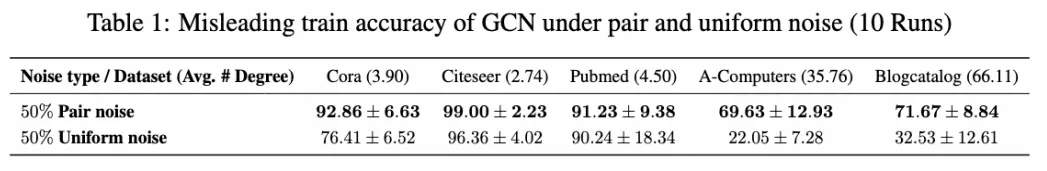

为了验证该假设,我们进行了实证研究。具体来说,我们记录了在 50% 对偶和均匀噪声下 GCN 在五个数据集上的误导性训练准确率。这⾥的误导性训练准确率(AILMT)代表模型在对错误分类的类别做出错误预测时的准确率,可以体现模型的过拟合程度。实验结果清楚地表明,对偶噪声的对模型泛化能力的影响最大,更可能导致模型模型过拟合到错误的标签上。同样的情况也发⽣在其他 LLN 和 GLN 方法中。

结论 6:图结构可以放大标签噪声的负面影响(RQ6)

从实验结果来看,我们观察到在稀疏图(Cora)中,AUIS 和 AUU 相较于 AUCS 显著下降。以 GCN 在 Cora 数据集上的表现为例,这种下降分别为 36.17% 和 10.85%。这些结果突显了邻居节点通过正确的标签对未标注节点进行正确监督对 GNN 的学习过程⾄关重要。被正确标注的邻域节点提供的正确监督显著提⾼了未标记节点的分类准确率,而标签噪声造成的错误监督则严重降低了这些节点的分类准确率,甚至比不进⾏邻域监督时更糟。

此外,我们的研究还揭示了图结构增强方法在减轻标签噪声传播效应⽅⾯的有效性。具体来说,基于图结构增强的三种方法,即 NRGNN、RTGNN 和 RNCGLN,在所有方法中的 AUIS 相较于 AUCS 和 AUU 表现出了最小的下降。这表明它们可以有效减轻标签噪声的传播效应。这种现象在像 Cora 这样的稀疏图中更加明显。⼀个可能的解释是它们采用的额外图结构学习技术可以在采样过程中形成⽤于预测的更密集的图结构。因此,分类器可以获得更多来⾃邻域节点的参考,从⽽减少对邻域错误标记样本的依赖。

结论 7:稀疏图更容易受到标签噪声传播效应的影响(RQ6)

从 Table 2 中可以看出,标签噪声的传播效应在平均度较低的稀疏图(如 Cora、 Citeseer、Pubmed 和 DBLP)上非常严重,但在密集图(如 Amazon-Computers、 Amazon-Photos、Blogcatalog 和 Flickr)上则不明显。对此现象的解释是:稀疏图上的未标记节点在其邻域中通常只有有限数量的标注节点可用于监督,所以这些未标注节点的预测结果在很大程度上依赖于其邻域中有限的标注节点,如果这些节点被错误标注,则很容易导致未标注节点表示的错误学习。相比之下,对于密集图,未标注节点的邻域包含许多可以作为参考的标注节点。

因此,分类器模型更有可能从这些标注节点中找到正确的监督。这⼀假设得到了 Table 1 中实验结果的进⼀步⽀持,我们观察到,与稀疏图(如 Cora、Citeseer 和 Pubmed)相⽐,GCN 在具有⾼平均节点度的密集图(如 Blogcatalog 和 Amazon-Computers)上更不容易产⽣过拟合。

本文提出的针对标签噪声下图神经⽹络的综合基准,可帮助阿里相关团队更精准地评估图相关技术在落地时的整体风险数据,并⾼效推进后续相关的算法落地和应用。最后,我们也为该领域未来的研究提供了⼀些思路:

文章来自于微信公众号“机器之心”