论文:

https://arxiv.org/abs/2410.18967v1

Ferret-UI 2 是苹果研究团队最新发表的一款先进的多模态大型语言模型(MLLM),旨在实现跨多个平台的通用用户界面(UI)理解。

与前身 Ferret-UI 相比,Ferret-UI 2 通过引入对多平台类型的支持、通过自适应缩放实现的高分辨率感知能力,以及利用GPT4o和视觉提示生成的高级任务训练数据,显著提升了UI的感知和交互能力。这些创新使得Ferret-UI 2能够更准确地识别和理解不同设备和操作系统上的UI元素,从而执行复杂的用户中心交互。

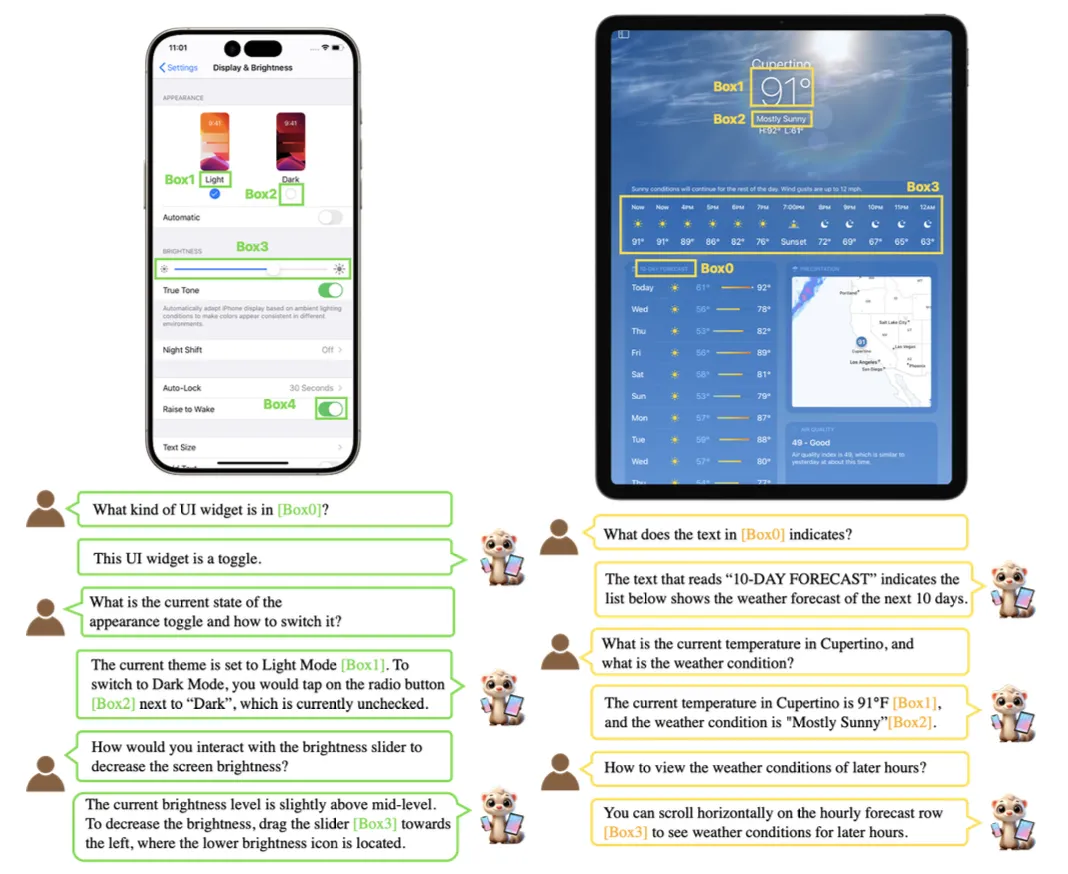

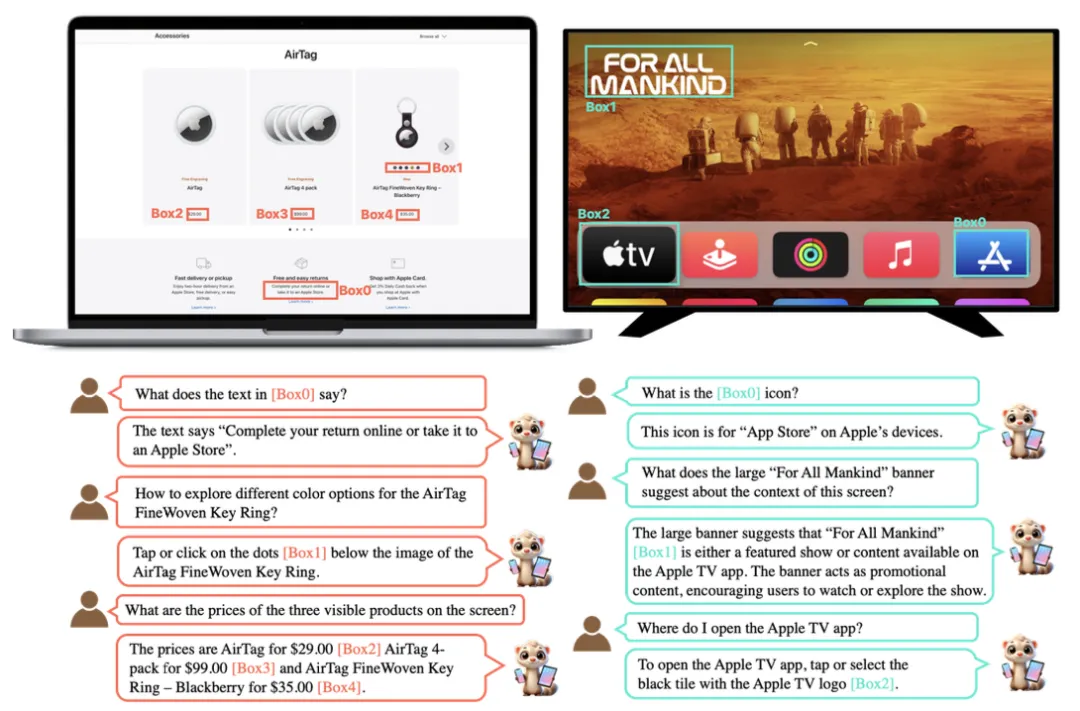

Ferret-UI 2 在多个基准测试中展现了卓越的性能,不仅在各种UI理解任务上超越了前代模型,还证明了其强大的跨平台迁移能力。实验结果表明,无论是在iPhone、Android、iPad、Webpage还是AppleTV上,Ferret-UI 2都能有效地理解和响应用户意图,处理高分辨率的UI截图,并在多样化的设备生态系统中无缝扩展。

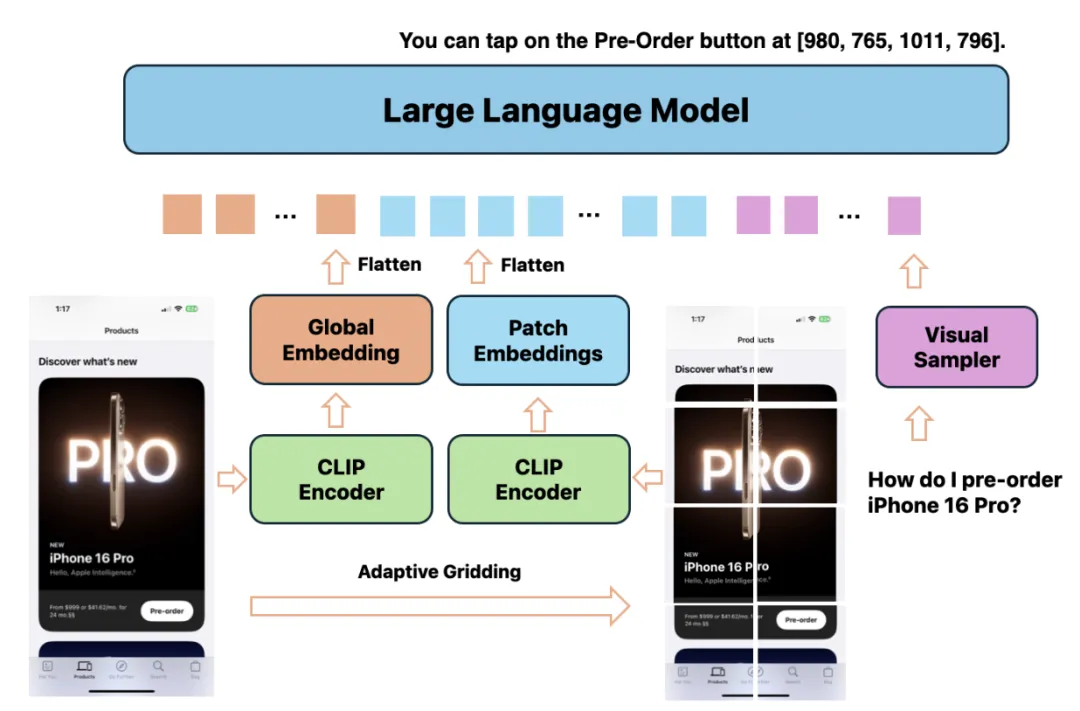

Ferret-UI 2 是一种多模态大型语言模型(MLLM),它通过结合先进的图像处理技术和自然语言理解能力,实现了对多种设备平台用户界面的广泛理解。该模型通过自适应缩放和视觉提示技术,能够精确地识别和操作不同分辨率和复杂度的UI元素,从而支持跨平台的用户交互。

Ferret-UI 2 的处理过程涉及从原始数据注释中构建训练数据集,并通过CLIP图像编码器提取UI截图的特征。其技术特点包括对多平台类型的支持,这意味着它可以处理来自iPhone、Android、iPad、Webpage和AppleTV等不同来源的UI界面。此外,模型采用自适应N网格方法来动态调整图像的分辨率,以保持在不同设备上的感知能力。

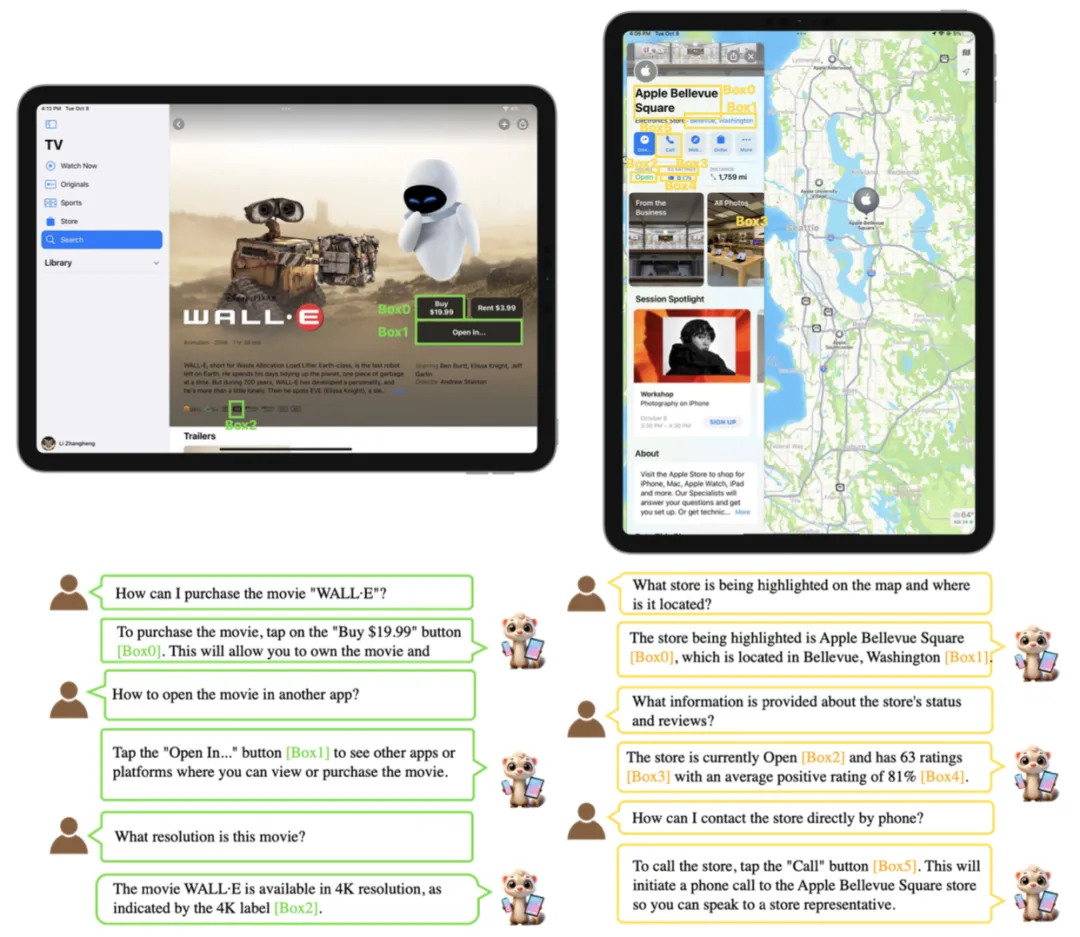

Ferret-UI 2 还利用GPT4o和视觉提示生成高级任务训练数据,这种方法通过在UI元素周围添加标记框和唯一编号,增强了模型对空间关系的理解,从而提高了训练数据的质量。在模型架构上,Ferret-UI 2 继承了Ferret-UI的基础,并通过引入自适应N网格机制进行了优化,以实现在给定推理成本限制下的最优网格配置。

总的来说,Ferret-UI 2 能够为广泛的设备生态系统提供统一的UI理解和交互能力。它不仅在多个基准测试中显示出卓越的性能,还证明了其在不同平台间的强迁移能力,这表明Ferret-UI 2是朝着创建一个能够适应多样化设备环境的通用UI代理迈出的重要一步。

这篇论文介绍了Ferret-UI 2,一个用于跨平台用户界面(UI)理解的多模态大型语言模型(MLLM)。

以下是论文内容要点:

摘要:

1. 引言:

2. 相关工作:

3. Ferret-UI 2:

4. 实验:

4.2 实验结果:

4.3 消融研究:

5. 结论:

文章来自于“ADFeed”,作者“ADFeed”。