大模型热两年后,将大模型融入业务场景、组织流程,提高产品和服务质量,已经成为越来越多企业的共识。

不仅如此,员工们也希望能用AI提升工作效率,甚至打破职业发展的天花板。

然而,许多企业在落地的具体过程中,却面临着众多痛点,困难重重。

AI正以意想不到的规模融入工作场所:帮助节省时间(90%),专注于最重要的工作(85%),变得更有创造力(84%),并且更享受工作(83%)

首先,成本就是一大难关。

现实问题是,该给大模型买多少算力?投多少人做数据治理、训练模型?需要多少人做运维?

第二,数据隐私与安全,也是让不少企业望而却步的重要原因。

B端企业往往对数据隐私要求较高,但大模型通常是由第三方提供,这个过程中就存在数据泄露的风险。

比如,一家医疗公司计划将大模型用于患者诊断,但担心数据传输到第三方模型提供商的服务器,会泄露患者隐私。虽然可以进行数据脱敏,但脱敏后的数据精度降低,也会降低模型效果。

第三,模型的集成与部署复杂,需要专业技术团队的支持。

B端用户的技术栈各不相同,现有的大模型可能需要大量调整,才能与企业现有系统集成。

比如某零售公司想要将大模型嵌入到内部CRM系统中,但由于API接口与现有系统不兼容,他们就需要开发大量中间接口,在内部数据安全防护上花费额外资源。结果就是项目推进极慢,还需要大量技术支持。

还有一种情况是,通用模型虽然有全领域能力,但是很多具有独特专业知识的行业和场景却无法直接应用。

比如在大模型落地工业场景上,施耐德电器数字化就提出了这样的「两难问题」——制造业企业的数据、知识、经验无法分享,导致数据流动差,难以出现垂直行业大模型;单个企业出面做私有化垂直的微调大模型,则会成本过高、维护难度过大。

此时,就需要结合客户领域和场景对通用大模型进行定向调优和增强。

然而,这个过程更是存在诸多痛点:缺少全链路增强的训练工具和框架;缺少与原模型匹配的通用训练预料;缺少模型训练的超参数、数据标注、数据清洗、配比等训练经验……

显然,今天的AI仍处于钻木取火的阶段,谁能攻破以上难题,让企业可靠、经济、易用地使用大模型,谁就能率先拿下一城。

这时,我们需要的是一套完整的工业级解决方案。

而就在昨天,百川智能正式面向企业用户,发布了「1+3」一站式大模型商业化解决方案,包括全链路优质通用训练数据、Baichuan4-Turbo、Baichuan4-Air两款模型,以及全链路领域增强工具链。

「1+3」的组合,覆盖了从数据构建、模型训练到强化调优、部署运营的全流程。

通过这个产品矩阵,企业既能保障自身数据和隐私安全,还能以较低成本高效实现效果最佳的大模型私有化部署,用大模型赋能多种业务场景。

一言以蔽之,工具多、部署快、效果好、成本低。

当前,AI社区已经有很多高质量的LLM可以免费获取,诸如Llama、Gemma等等。

它们具备了强大的通用泛化能力,然而,由于每个企业都拥有自身独特的专业知识和应用场景,直接应用通用模型难以达到理想效果,因此必须对模型进行定制化优化从而适应特定领域和场景的需求。而优化后模型在多场景下的可用率是评估其价值的关键标准。

目前,行业主流的定制化优化方式有两种:用场景数据微调;场景数据混合开源通用数据微调。

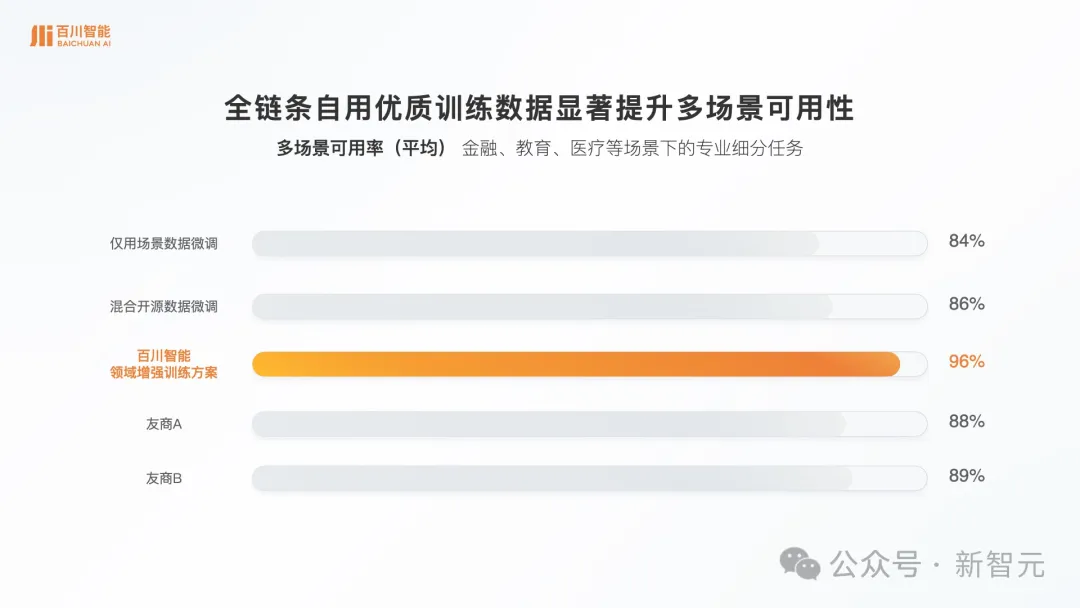

数据显示,仅用专业数据微调模型,多场景可用率是84%。

若是利用行业公开的通用数据,或者自建通用数据集,外加专有数据进行领域增强训练,可用率会有所提升,但也只能提升2%。

以上这些还不是最优解,因为对于很多企业来说,多场景可用率低于90%基本上就是不可用的状态。

导致这种情况的主要原因是,受限于诸多因素,企业在混合微调时只能自建或者使用开源的通用数据,很难获得与原模型高度匹配的通用训练数据,因此即便经过调优,模型也有很大概率会失去通用性,变成无法应对多个场景的专用模型。

这次,百川智能直接给出了其自用的预训练通用数据、SFT微调通用数据以及强化学习过程中的通用数据。

同时,自研的超参自动化搜索和调优技术、数据动态自适应配比技术等训练经验和技术,也都一并封装成工具,给到企业使用。

用白话说就是,Baichuan4-Turbo、Baichuan4-Air用到的高质量通用训练数据和训练技巧,都在里面!

评测结果显示,在使用百川智能优质通用训练数据与企业专有数据混合微调后,模型在金融、教育、医疗等场景下的专业细分任务的平均可用率高达96%。

相比不混合通用数据提升12%,混合开源通用数据提升10%。

相较于其他行业解决方案,百川智能取得了最新的SOTA,这也从侧面证明了模型想要在企业场景下取得优秀表现,需要的是专有数据与和原模型高度匹配的通用数据的「混合增强」。

接下来,如何将Baichuan4-Turbo、Baichuan4-Air应用在实际场景中?

从名字中不难看出,它们都是Baichuan 4系列基础模型的升级。

对于企业来说,在不同场景阶段,对模型性能和成本要求各不相同。

在复杂场景探索阶段,他们更加关注模型性能、部署成本。

而在已验证过的大规模落地阶段,他们更侧重模型推理成本、响应速度。

这次新发布的两款模型,分别应对不同阶段的客户落地场景,效果更好,成本更低。

其中,Baichuan4-Turbo属于旗舰模型升级版。

它适合复杂场景的初期探索阶段,尤其适用于对于初始部署成本(比如显存)较为敏感的场景。

对于B端企业用户,大模型时常会遇到极为复杂的场景,这时就对模型能力提出了很高的要求。

比如在一个金融机构中,需要实时分析海量交易和市场数据,还要检测异常交易、反欺诈,预测信用风险等等。

此时就需要大模型能够整合动态数据与多模态处理、具有强大的模型识别与实时预测能力。

这样它才能快速集成结构化(交易记录)和非结构化数据(文本),并进行跨模态的信息分析。并且,它还能对数据中的微小变化做出快速响应,识别风险信号。

针对以上场景,Baichuan4-Turbo就是一个极具性价比的选择。

相比Baichuan 4,Baichuan4-Turbo在B端客户高频应用场景上,效果均有显著提升。具体来说,分聚类提升了9.09%、多语言提升了31.43%、信息摘要提升了50%、生成提升了12.77%。

而在成本上,通过w4kv4等infra量化,Baichuan4-Turbo仅需2张4090,即可达到GPT-4o效果。

可以说达到了旗舰模型的行业最低,仅为Baichuan 4的15%。

在响应速度上也更快,其中首token速度提升了51%、token流速提升了73%。

Baichuan4-Air则是Baichuan 4系列中的低成本极速版,同时也是百川智能发布的首款MoE模型。

它适合中等复杂及简单场景的广泛应用阶段,尤其是请求量大、推理成本敏感型的场景。

比如电商搜索和推荐、智能客服与对话机器人,都属于这一类。

电商平台的用户访问量大,产品浏览和搜索请求频繁发生,此时模型无需深层理解用户的全部行为,只需提供较高相关性的推荐即可。

而在智能客服场景,银行、零售、物流等企业的在线客服系统往往有高并发的用户咨询,用户问题相对简单、重复性高,不涉及复杂情感理解和多轮对话。

此时,相比复杂大模型,轻量化的模型就能实时响应海量请求,在不牺牲速度的情况下回答大量简单的用户咨询,企业也不必承受复杂模型带来的高计算成本。

Baichuan4-Air,正是为这类用户量身打造。

它的效果和Baichuan 4基本持平,但价格只有后者的1%——0.98厘/千tokens,目前行业最低。

同时,它的响应也更快,首token速度提升了77%、token流速提升了93%。

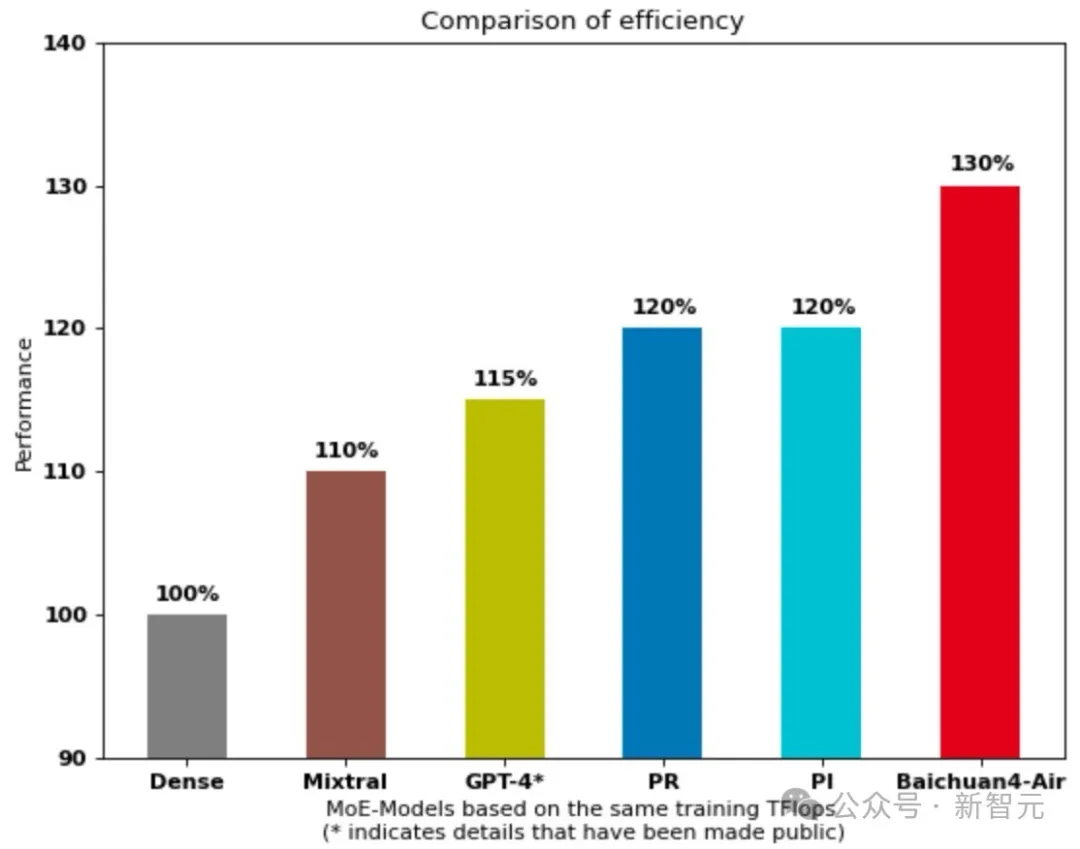

值得一提的是,作为百川智能的首个MoE模型,Baichuan4-Air 行业首创了PRI架构,巧妙融合了Pyramid(金字塔架构)、Residual(残差结构)、Interval(区间结构)三种配置方式。

与标准的MoE架构相比,Baichuan4-Air的MoE架构保持了MLP(多层感知机)和Attention(注意力机制)的内部结构不变,仅对混合专家MLP层的配置方式进行优化,通过合理配置专家数量和激活策略,能够更好地平衡计算负载,减少计算量,提高推理速度。

正是由于这种MoE架构上的创新,Baichuan4-Air在时效率和模型性能上均表现优异。

在相同训练数据下,Baichuan4-Air不仅时效率更高,性能也大幅领先于GPT4-style、Mixtral-style结构的MoE模型。

至此,所谓停止预训练模型的谣言,也就不攻自破了。

作为「1+3」产品矩阵中的「1」,从数据处理、增量预训练、模型微调、强化学习、提示词优化,到评测、量化、部署,「全链路领域增强工具链」全面覆盖了私有化部署的所有关键环节。

值得一提的是,百川团队基于数万亿token的训练实战经验,全部开放。

这其中,微调数据自动化增强、标注工具、数据配比搜索策略等,全部被封装到全生命周期工具包中,企业直接可用。

在整套工具链中,还包含了百川开放的高效训练框架。

相较于开源方案,基于百川成熟的训练框架,能在相同收敛结果下,将训练速度提升数倍。

与此同时,它还支持RAG、Agent能力定制化,以及超长窗口训练等高级功能。

这些能力,能够帮助企业在更短时间内,完成复杂模型训练任务。

得到微调模型后,在部署前还需进行全面的模型评测。

「全链路领域增强工具链」中提供了一站式模型评测方案,不仅包含了行业标准的基准测试,还包含了全面自动评测功能。

一方面,能够帮企业了解模型相对表现;另一方面,还能为其模型优化提供精确指导。

不仅如此,通过大量的适配工作,百川智能还实现了多平台适配的私有化部署方案,和英伟达、华为、寒武纪、高通、MTK、天数等主流芯片都能适配。

那些拿到内测资格的客户,纷纷对百川智能两款新模型、全链路领域增强工具链,给出了好评。

新致软件称,百川的工具包为LLM开发带来了革命性的提升。

这套工具不仅能够有效处理私有数据资产,还可以与百川优质通用数据融合训练,从而显著提升了最终模型的表现效果。

另一个案例来自信雅达。

他们的实践表明,Baichuan4-Turbo在硬件需求方面实现了重大突破——仅需2张4090显卡即可流畅运行,大幅降低了基础设施投入成本。

更令人瞩目的是,自部署该模型以来,他们在业务层面取得了显著成效:客户满意度提升15%,运营效率更是实现了近30%的增长。

以上,这些数据充分证明了百川智能的一站式解决方案,在实际应用场景中的卓越表现。

截至目前,百川智能已经服务了数千家客户,不仅有北电数智、完美世界游戏等行业领军企业,还与多家行业生态伙伴,以及运营商达成合作,携手构建百川大模型生态。

随着生态朋友圈不断壮大,百川的实践证明,LLM的落地不是遥不可及的未来,而是触手可及的现实。

最终实现,让更多企业以更低门槛、更高效率拥抱AI时代,推动各行各业的升级。

点击「阅读原文」即可访问官网,查看更多信息。

参考资料:

https://platform.baichuan-ai.com/homePage

文章来自于微信公众号“新智元”

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0