现在,一个大模型就能直接拿来当游戏,还是开放世界的那种!

可以直接根据玩家操作预测下一帧,连游戏引擎都省了。

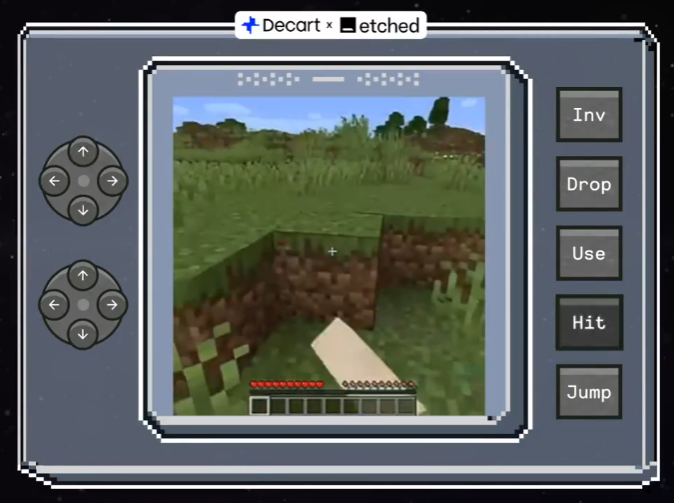

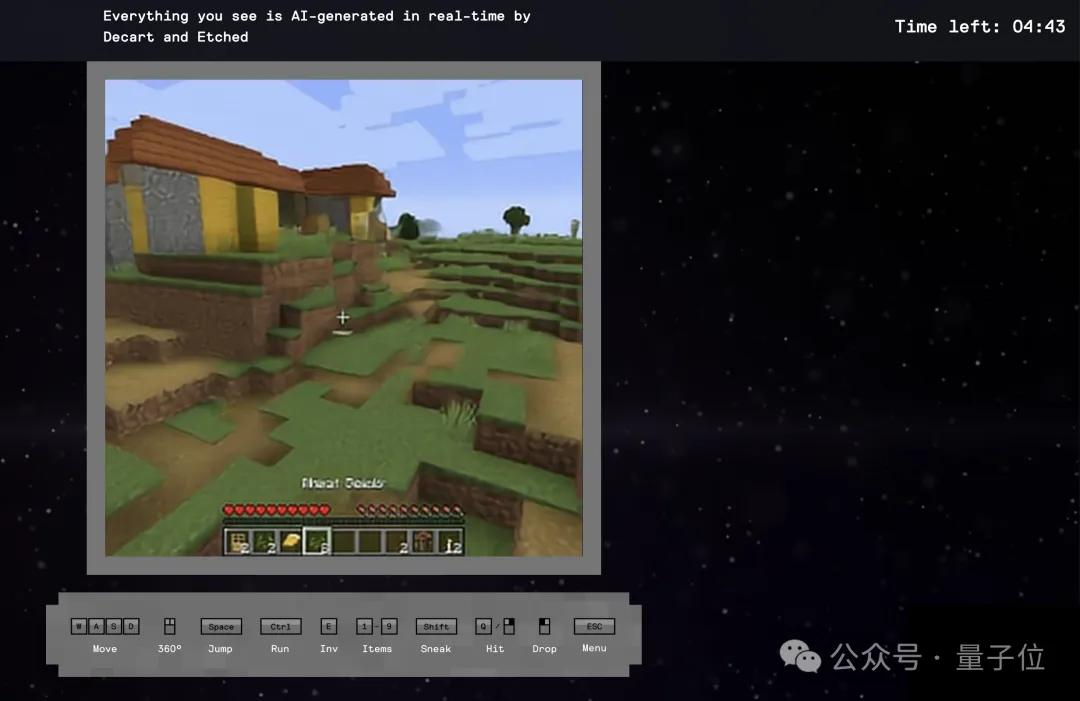

这个怎么看都像是《我的世界》的界面,就是这款游戏Oasis本尊了。

虽然看着像,但两者驱动方式完全不同,Oasis的图像不是来自渲染,而是AI实时绘制。

Oasis会根据你的键盘输入生成新的帧,每次游戏都能探索不同的地图。

像这样的可交互世界模型,一个模型就是一个游戏,每秒20帧零延迟的生成效率,也让不少人都投来了惊讶的目光。

FlashAttention作者Tri Dao也感叹说,很快模型推理成本就会降低,很多娱乐内容将会变成AI生成。

目前Oasis的代码和500M参数的模型权重已经开源,作者同时也放出了在线体验版本。

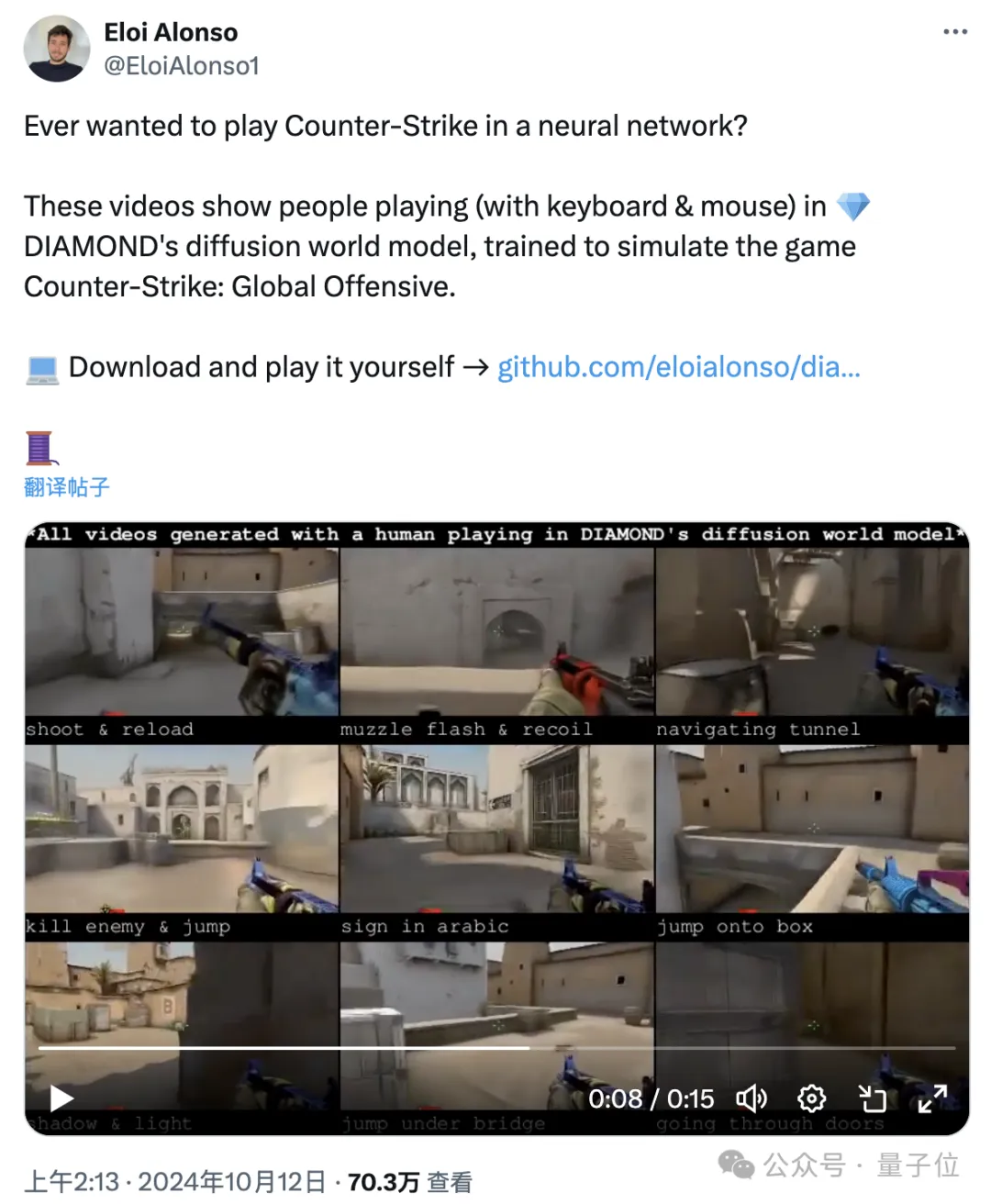

在Oasis之前,已经有人用类似的技术,开发出了基于大模型的fps射击游戏。

现在,Oasis直接把科技树点到了开放世界游戏当中。

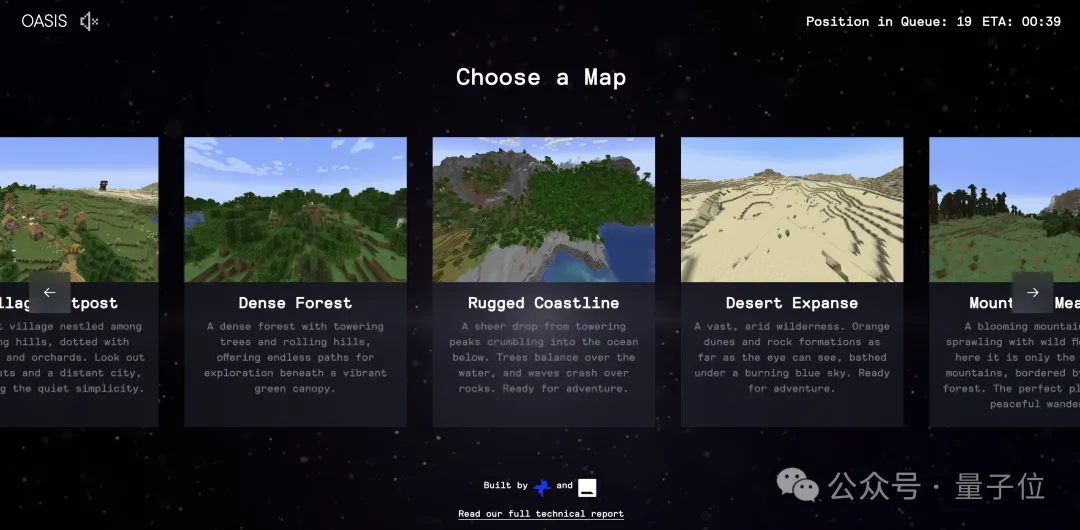

Oasis在线版本提供了多种地图风格可供选择,需要排队体验,不过时间不长,排到一次可以玩五分钟。

进入之后会显示游戏画面、操作说明和剩余的体验时间。

根据前面选择的地图风格,游戏中的AI引擎可以实时生成各种各样的画面。

而且模型也包含了一些对现实世界的理解,比如在绘制时能够理解并遵循光照等物理规律。

生命值、饥饿度这样一般游戏中具有的复杂机制也都有,可以通过食物来获得体力。

而且游戏世界也并不空洞,角色的设定方面,Oasis中安排了大量的动物和NPC。

但是……为什么都挤成一团啊?

当然这些动物也不只是贴图,你可以像《我的世界》种一样和动物进行交互。

时间用完或者手动结束后,还会有游戏全过程的视频记录,可以选择下载保存。

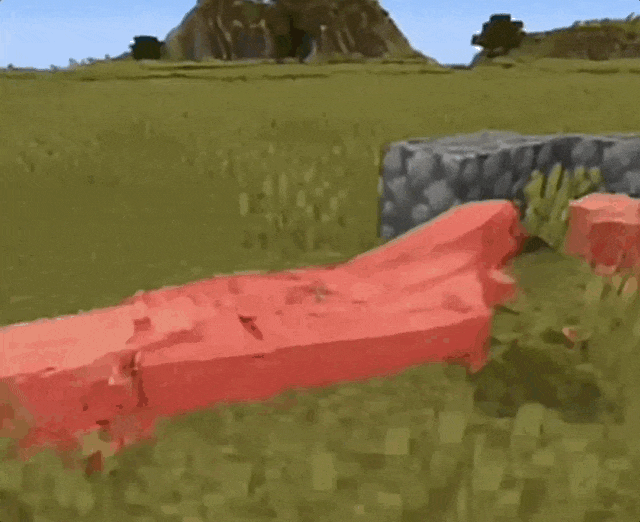

不过,Oasis的画面质量也确实还有很大的进步空间,还有人吐槽一致性问题,只要转一个圈看到的东西就全变了。

但至少胜在响应速度快,也算是为以后的实时AI画面生成打了个样。

那么,Oasis的研发团队都运用了些什么技术呢?

Oasis由位于美国加州的初创公司Decart打造,该公司成立于2023年。

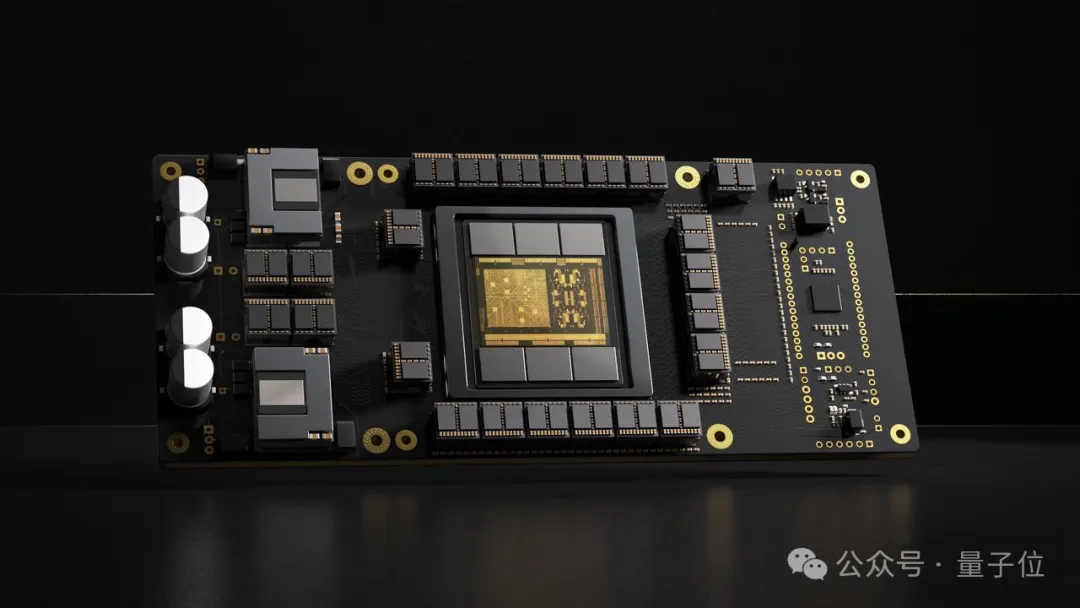

为了让研发的模型能够高效工作,Decart选择了和一家叫做Etched的芯片初创公司合作研发。

Etched由哈佛辍学生Gavin Uberti在2022年创建,并于今年获得了1.2亿美元的A轮融资。

今年六月,Etched研发出了专用于Transformer的4nm AI芯片Sohu,号称一张能顶20张A100。

按照宣传,Sohu运行700亿参数的Llama 3,每秒吞吐量可达50万tokens,相当于1秒就能生成21个人一天说的所有话。

当然,Sohu拥有高速度的代价之一就是只能用来跑Transformer,其他的CNN、RNN等神经网络通通运行不了。

所以,为了能够利用Sohu的速度优势,Decart团队为Oasis选定了Transformer作为基础架构。

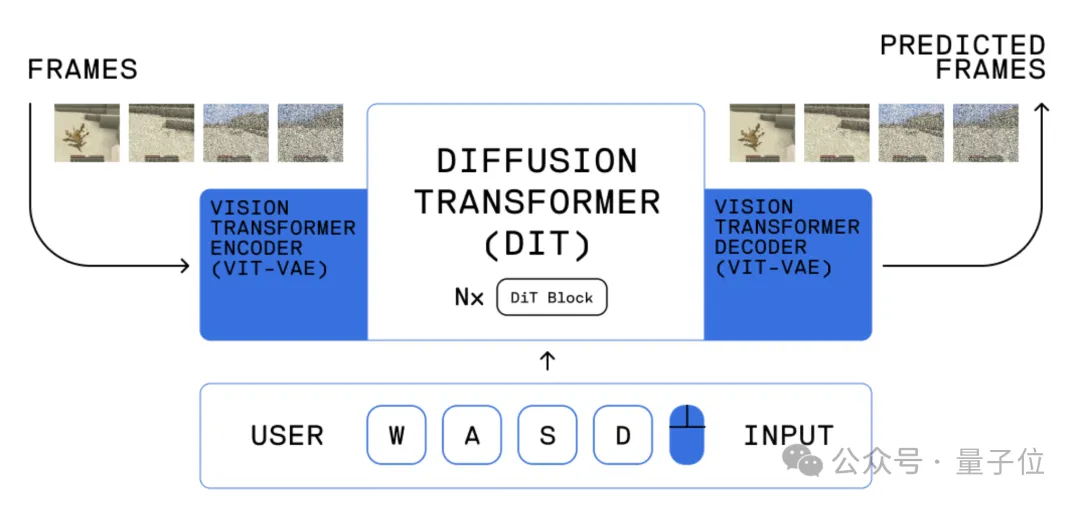

具体来说,Oasis所用的模型由空间自动编码器和潜在扩散主干两部分组成。

两者都基于Transformer构建,其中自动编码器为ViT(Vision Transformer)架构 ,主干网则运用了很多视频生成模型(包括Sora)都在用的DiT(Diffusion Transformer)。

Decart还对Transformer架构进行了修改,在空间注意层之间穿插了额外的时间注意层,以便提供来自先前帧的上下文。

另外不同于Sora等双向模型的是,Oasis生成帧的过程是自回归的,因此能够根据游戏输入对后续帧进行调节,使得用户能够与世界实时交互。

Decart介绍,如果用H100来跑Oasis,在360P的画质下能够达到每秒20帧,而用Sohu的话相同帧率下的画质可以达到4K。

实际运行下来团队发现,Oasis生成一帧画面只需47毫秒。

当然除了速度之外,对于Oasis这样的游戏场景来说,保持时间稳定性也是一项重要工作。

但是在自回归模型中,错误会发生叠加,即使很小的缺陷也有可能形成雪球效应。

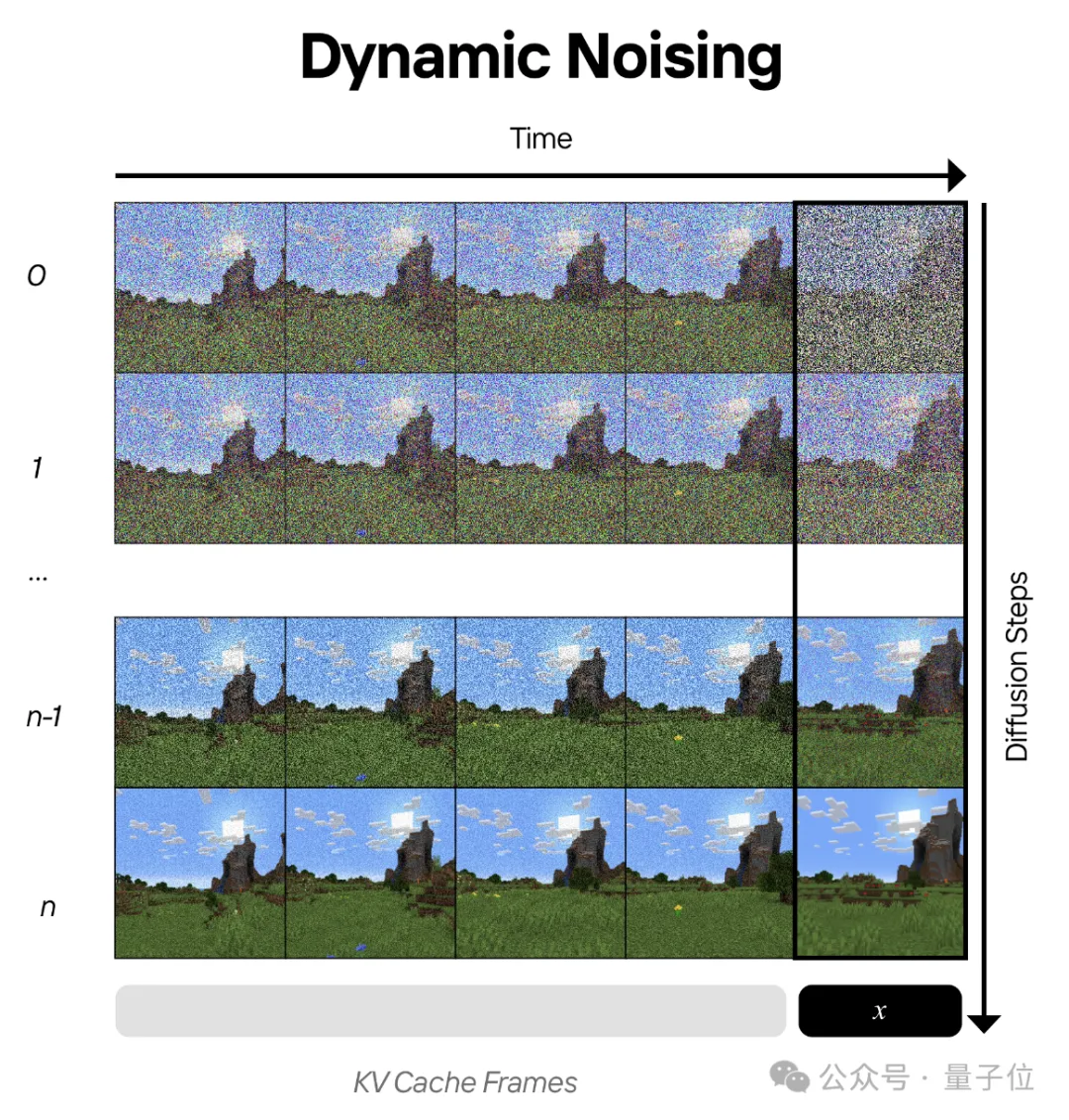

为了解决这个问题,Decart团队引入了动态噪声。

动态噪声机制会在第一个扩散前向传递中注入噪声以减少误差累积,并在后面的传递中逐渐消除,这样模型就可以找到并保留高频细节。

未来,Decart团队将针对部分远处物体出现模糊、不确定对象的时间一致性等问题进行研究,逐步提升Oasis的游戏体验。

官方介绍:

https://oasis-model.github.io/

DEMO:

https://oasis.decart.ai/welcome

代码:

https://github.com/etched-ai/open-oasis

模型权重:

https://huggingface.co/Etched/oasis-500m

文章来自于微信公众号“量子位”,作者“克雷西”