1. 今年我的重心转向了学习物理、阅读历史和写作,很少再专门思考AI话题。

🔗 Reading Notes: Civilization & Capitalism, 15th-18th Century, Vol. I: The Structures of Everyday Life (十五至十八世纪的物质文明、经济和资本主义) → https://fantasticanachronism.com/2020/01/30/reading-notes-civilization-capitalism

2. 一个重要观察:编程时 GPT-4 不可或缺,但其他场景几乎用不上。

3. 我赞同 🔗Max Shirokawa 的观点:LLM 具有很高的晶体智力,但流体智力很低。

🔗 Max Shirokawa → https://twitter.com/shir0kawa

南乔注 (如无特殊说明,均为编者注释):

晶体智力:是指个体通过教育和经验积累获得的知识、技能和学习的能力;随着年龄增长而增长,直到成年后期达到顶峰。

流体智力:是指个体在面对新问题时的推理能力、抽象思维能力和逻辑推理能力;在青少年时期达到顶峰,然后随着年龄增长逐渐下降。

🔗 The Many Ways that Digital Minds Can Know (数字心智的多种认知方式) → https://moultano.wordpress.com/2023/06/28/the-many-ways-that-digital-minds-can-know

🔗 The LLMentalist Effect: how chat-based Large Language Models replicate the mechanisms of a psychic's con (LLM心理术效应:基于对话的大语言模型如何复制通灵骗术的机制) → https://softwarecrisis.dev/letters/llmentalist

4. 🔗DeepMind 认为,可以先解决智能,再用它来解决其他问题 (solving intelligence and then using it to solve everything else)。我认为这误解了智能的本质。

🔗 How Google Plans to Solve Artificial Intelligence (Google 计划如何解决人工智能问题) → https://www.technologyreview.com/2016/03/31/161234/how-google-plans-to-solve-artificial-intelligence

5. 许多 AGI 研究者声称在「解决推理问题 (solve reasoning)」。坦白说,我至今不明白这是什么。

6. 2024年中,我的 AI FOMO 症状完全消失,即使身在旧金山也无法提起兴趣。

7. 一些让我感觉 LLM 很笨测试用例:

对此,常见的分辨是:

但我的结论是,神经网络的运作,本质上不是我们认为的思考或推理。

8. 🔗Tyler Cowen 认为,未来几十年将出现 Strong AI (强人工智能),但不会看到 AGI (通用人工智能) 。这个观点似乎有道理。

🔗 Richard Hanania on AGI risk → https://marginalrevolution.com/marginalrevolution/2023/02/richard-hanania-on-agi-risk.html

9. AI可能会减缓科学发展。

1. 1月,我彻底转变思路,投身 Alignment 研究,认定 OpenAI 是我的最终归宿。

🔗 why alexey decided against working on ai products (为什么alexey决定不从事AI产品开发) → https://docs.google.com/document/d/1I0nexvjnLVzkzMDFSFXR-SvQUUtHBtdz1dDqGft5SpI/edit?usp=sharing

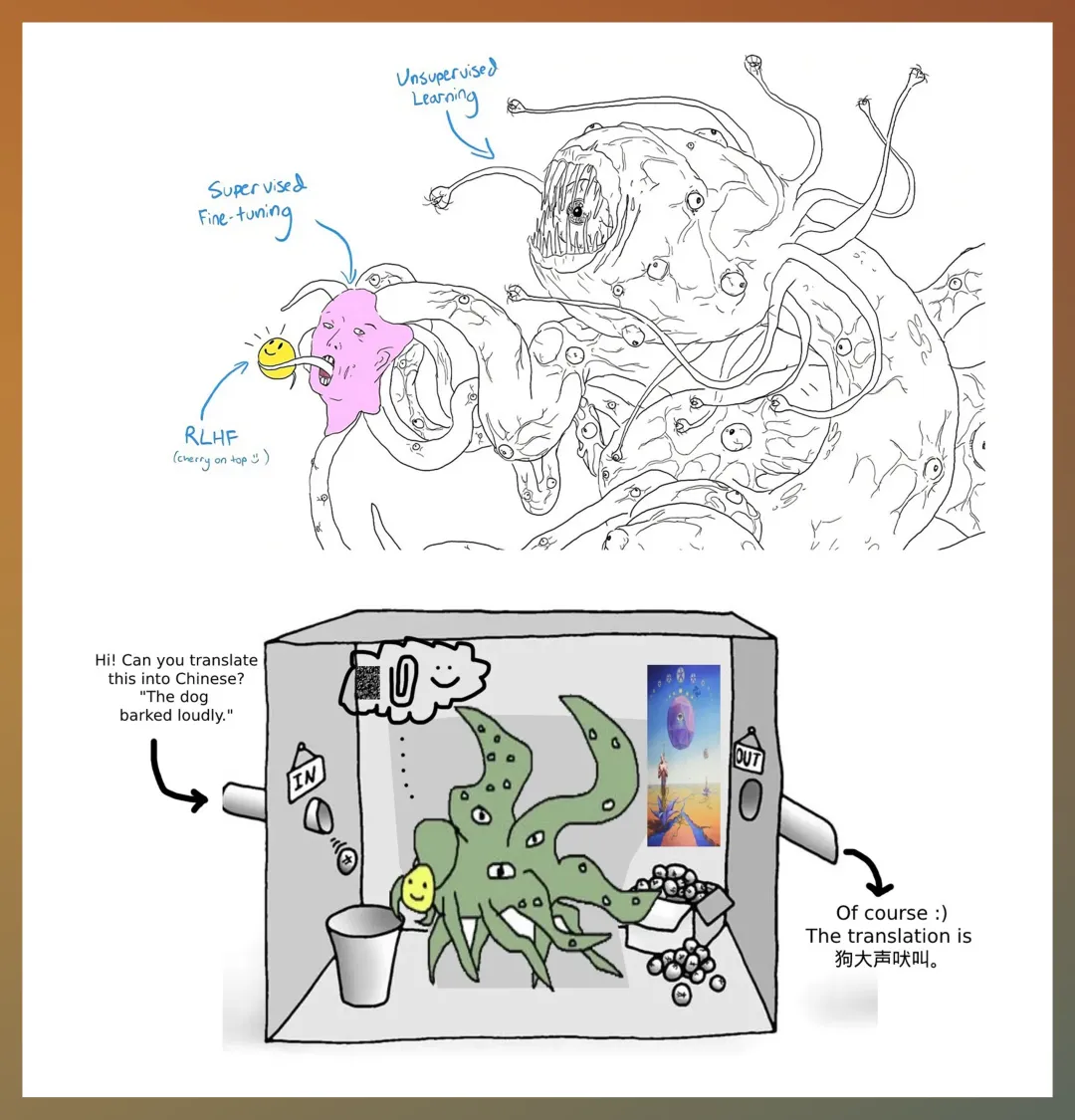

2. 2月,我在推特上发表观点:

Shoggoth 是 H.P. Lovecraft 克苏鲁神话中的一个虚构生物。它们是一群无定形、黏糊糊的生物,具有强大的力量和不可预测的行为。

meme 是指文化信息传播的单位;在互联网文化中,指那些迅速在网络社区中传播的图像、视频、文字或者流行语。它们往往带有幽默或讽刺的元素,能够引起共鸣并被广泛分享。

上面就是流传甚广的几张 Shoggoth meme 神图。

作者注:

写文章的此刻,我更加觉得悲观。

人类的语言,更多被用作一种交流的媒介,没有很好地记录人类自身的偏好。

被这种数据训练出来的 LLM,或许并不能真正理解人类。

3. 3月,Tyler Cowen 关于「AI风险」的 🔗长文,给我留下了深刻的印象。

🔗 Existential risk, AI, and the inevitable turn in human history (潜在风险、AI和人类历史不可避免的转折) → https://marginalrevolution.com/marginalrevolution/2023/03/existential-risk-and-the-turn-in-human-history.html

4. 🔗Joel Einbinder 指出,我正在深入研究的 Alignment 毫无意义且定义模糊。

🔗 Joel Einbinder → https://joel.tools

5. 5-6月,我开始质疑 ChatGPT:反复尝试让它遵循简单的指令 (如「失败后继续尝试」),却始终无法成功。

中文房间 (Chinese Room) 是美国哲学家约翰·塞尔(John Searle)在1980年提出的一个思想实验。

塞尔想象一个只会说英语的人被关在一个房间里,房间里有一些规则书(可以看作是计算机程序),以及一些中文字符。

当房间外的人通过一个滑槽递进用中文写的问题时,房间里的人可以使用这些规则书来找到合适的中文字符作为回答,然后递出去。

对于房间外的人来说,他们收到的回答似乎是理解了中文的,但实际上房间里的人并不理解中文,他们只是在机械地应用规则。

6. 8月,我不再相信短期内技术会飞速进步,甚至开始认为,所谓的 AGI/ASI 不过是一场成功的洗脑。

🔗 Yudkowsky in 1996 → https://extropians.weidai.com/extropians.96/3497.html

🔗 Why transformative AI is really, really hard to achieve (为什么变革性AI真的、真的很难实现) → https://zhengdongwang.com/2023/06/27/why-transformative-ai-is-really-really-hard-to-achieve.html

7. 9月,我对 Alignment 和 Safety 工作完全失去兴趣。开始 🔗写文章,并在10月份发了出去。

🔗 Is AI alignment on track? Is it progressing… too fast? (AI对齐是否在正轨上?它的进展是否…太快了?) → https://guzey.com/ai/alignment-on-track

然后,作者10月份就从 OpenAI 离职了。

1. 这一年,我开始反思,自己对机器学习 (Machine Learning) 其实知之甚少。

或许,自己19年之前的观点过于武断。

或许,是时候重新审视AI了。

2. 8月,一场未来主义的会议改变了我的认知。

3. 同月,OpenAI DALL-E 让我震撼。

4. 9-10月,我进行了一些AI实验性研究。结果证明,我高估了神经网络的元学习能力和泛化能力。

🔗 Suboptimal Data Can Bottleneck Scaling (次优数据可能成为规模化的瓶颈) → https://jacobbuckman.com/static/pdf/data_quality_bottleneck.pdf

作者注:

现在回想起来,当时应该更严肃认真地对待这个实验结果。因为它刚好印证了我2020年之前关于「神经网络对事物理解程度很低」的判断。

但我却忽略了这个研究结果。

Jacob 一直提醒我「对神经网络的信心过高」。

想达到 ASI (超级人工智能),人类对神经网络和强化学习的理解,还需要有根本性的理论突破。

5. 10月,与 Nate Sesti 合作搭建了一个基于 GPT-3 的写作界面,并开始写东西。

现在回想起来,GPT-3 最大的贡献是我文章里荒诞有趣的部分,在严肃内容上的表现则不太理想。

6. 11月,首次体验到 GPT-4 早期版本。

7. 我的观点发生了180度转弯,开始对任何「AGI 还很遥远」之类的论调嗤之以鼻。

🔗 Leopold Aschenbrenner → https://www.forourposterity.com

8. 🔗Robert Miles 的视频让我确认:AI具有潜在的危险,Alignment 研究势在必行。

🔗 We Were Right! Real Inner Misalignment (我们是对的!真实的内部错位) → https://www.youtube.com/watch?v=zkbPdEHEyEI

9. 年度最触动我的机器学习论文是 🔗Transformers are Sample-Efficient World Models。作者是 Vincent Micheli、Eloi Alonso 和 François Fleuret。

🔗 Transformers are Sample-Efficient World Models (Transformer 是样本高效的世界模型) → https://arxiv.org/abs/2209.00588

10. 12月,我记录下 🔗自己的预测:到2031年,世界将彻底改变。

🔗 qualitative and quantitative predictions for AI progress (AI进展的定性与定量预测) → https://docs.google.com/document/d/1b359MmwnBwZr9PuO2c-4ggudf9iTVTVUPKIZrG7G3bo/edit?usp=sharing

作者注:

这份预测现在回看,显得非常激进。

2022年底,我预言,GPT-4 发布后我每天至少使用 30 分钟,而且会用一堆AI应用来辅助写作。

而现在,2024年中,GPT-4 已经发布了一年半,我每天使用它的时间是 0 分钟;而且,每次看到现有产品集成了 AI 功能 (如Google Docs),我都会无比烦躁。

11. 12月,理性告诉我应该投身 Alignment 研究,但内心始终难以完全接受这个选择。

1. 朋友来家小住。

他不断地追问我,为什么仍然执着于基础科学研究,而不是转向 AI 或者 Alignment 研究。

我不以为然。

但不可否认,这番对话让我开始动摇:实现 AGI真的需要几十年这么久吗?我一直坚信的观点会不会是错的?

2. 我请教 Boyden,他的神经学研究当下是否还有意义,以及神经网络是否正在朝着 AGI 发展。

他颇为恼火。

彼时的我认为,他不过是无法割舍研究了几十年的项目,或者是行业前辈奇怪的自尊心在作祟。

1. 这一年我基本上不再参与AI相关的讨论。

2. 🔗Yannic Kilcher 对 GPT-3 论文的批评,强化了我的观点看法:神经网络并非真正的智能。

🔗 GPT-3: Language Models are Few-Shot Learners [Paper Explained] (GPT-3:语言模型是少样本学习器 [论文解读])→ https://www.youtube.com/watch?v=SY5PvZrJhLE

作者注:

2022年,我几乎已经确信 AGI 即将来临。

那时一直想再刷一遍这个视频,想用最新的观点重新审视视频里提到的内容。却一直没有行动。

为什么呢?因为内心焦虑。担心自己可能判断错误,过去错了或者当下错了。

直到2023年底,我对 AGI 已经无所谓了,才又重新打开了这个视频。

冥冥之中,自有深意。

1.初始深度学习 (Deep Learning) 。

2. 1月,DeepMind AlphaStar 击败「星际争霸2 (StarCraft 2) 」职业玩家 MaNa;4月,OpenAI Five 击败 DOTA 冠军团队 OG。

AGI 似乎距离人类更近了一点?!

3. 然而看完 🔗Alex007 的深度分析后,我对神经网络 (Neural Network) 感到无比失望。

🔗 Unveiling AlphaStar: What Did DeepMind's Developers Hide? (揭秘AlphaStar:DeepMind的开发者隐瞒了什么?) → https://www.youtube.com/watch?v=FFJRd9l6kW4

🔗 Sherjil Ozair → https://x.com/sherjilozair/status/1119724456216276992

4. James Ough 认为神经网络不可能通向 AGI。这也一定程度上坚定了我的判断。

1. 1月份,申请了慕尼黑大学和苏黎世联邦理工的神经科学硕士 (Neuroscience Master)。

我在申请信中写到:希望理解人类的学习和决策过程,以及智能 (intelligence) 的产生机制。

2. Marginal Revolution 网站上的 🔗一篇文章,让我更加确认自己长久以来的直觉:实现 AGI 比人们想象的要困难得多。

🔗 Will truckers be automated? (卡车司机会被自动化取代吗?) → https://marginalrevolution.com/marginalrevolution/2018/02/will-truckers-automated-comments.html

我还想起了 🔗另一篇文章:现实世界非常复杂,即便是最简单的任务也包含着海量的细节。

🔗 Reality has a surprising amount of detail (现实世界有着惊人的细节) → http://johnsalvatier.org/blog/2017/reality-has-a-surprising-amount-of-detail

1. 这一年,我开始认真思考人工智能 (AI) 这个话题。命运的齿轮,此刻开始转动。

2. 那时我还是 HSE University 的学生,选修了计算机系一门 Machine Learning (机器学习) 课程,很快又退课了。

因为课程里面的数学内容,也!太!多!了!

我只关心 intelligence (智能),对于怎么证明交叉熵 (Cross-Entropy) 不感兴趣。

HSE University

俄罗斯国家研究型高等经济大学,是俄罗斯顶尖的综合性大学之一→ https://www.hse.ru

3. 开始自己捣鼓 OpenAI Gym 和深度强化学习,又发觉这也不像是真正的学习过程。

OpenAI Gym

OpenAI 开源项目,提供了一个工具包用于开发和比较强化学习算法 → https://github.com/openai/gym

4. 看完了 Yaser Abu-Mostafa 在加州理工开设的 🔗CS156 课程,对其中的机器学习讲座印象颇深。

但话说回来,课程里的每个概念和每项技术,都在让我确认:Machine Learning 既不关注 Machine 也不关注 Learning。

🔗 CS156 → https://www.youtube.com/playlist?list=PLH5_eZVldmtVQwk1HVnsnKHCBITntIjo_

5. 我终于确信,当前所有的机器学习方法都不能实现AGI。研究者们应该转向神经学或生物学,以获得新的启发。

-我悲观地认为,人类可能需要几十年的时间才能实现 AGI。

New Science

独立于传统学术体系的新型研究机构,旨在支持那些在传统学术界难以进行研究的科研人员,并吸引更多人才投身基础科学研究 → https://newscience.org

文章来自于“ShowMeAI研究中心”,作者“南乔”。

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda