文本属性图Text-Attributed Graphs(TAGs)是一种在节点上有丰富文本信息的图结构, TAGs 广泛应用于社交网络(social network)、引用网络(citation network)和推荐系统(recommendation system)等实际场景中。由于其强大且通用的表达能力,该领域近年来得到了快速发展。

然而目前TAGs面临三大挑战:

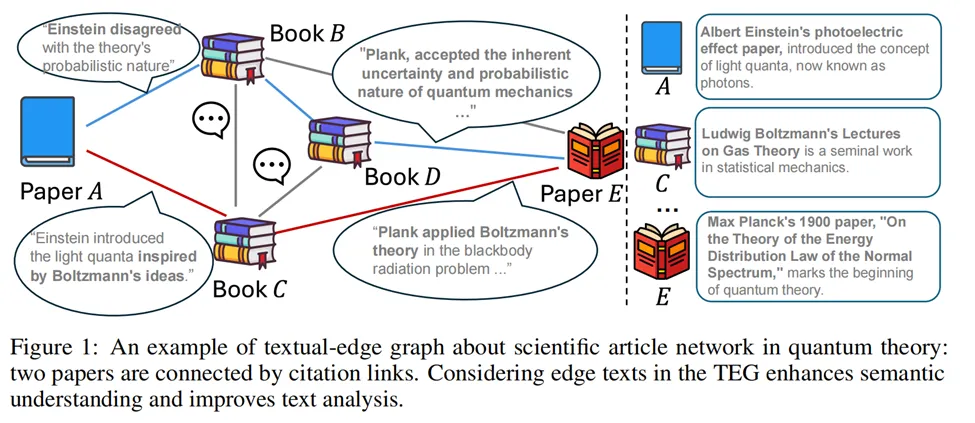

1. 现有的TAGs数据集一般仅在节点上包含文本信息,而边的信息往往被简化为二元或分类属性。边文本(edge text)的缺乏限制了对文本实体间复杂语义关系的表达和理解(比如一个实体局部的一些概念如何与另一实体的局部相关),阻碍了图数据挖掘技术的进一步发展;

2. 文本图数据格式和实验设置不统一,难以进行模型之间的比较;

3. 由于缺乏全面的基准测试和分析,对图模型处理边文本信息能力仍然了解的很欠缺。

论文地址:https://arxiv.org/abs/2406.10310

代码地址:https://github.com/Zhuofeng-Li/TEG-Benchmark

数据集地址:https://huggingface.co/datasets/ZhuofengLi/TEG-Datasets

为了解决这一问题,上海大学、山东大学、埃默里大学等学术机构的研究人员联合推出了TEG-DB,一个全面的基于文本边的图数据集和基准测试(A Comprehensive Dataset and Benchmark of Textual-Edge Graphs)。

目前,论文已被NeurIPS Datasets and Benchmark Track 2024接收。

其主要有三个特点:

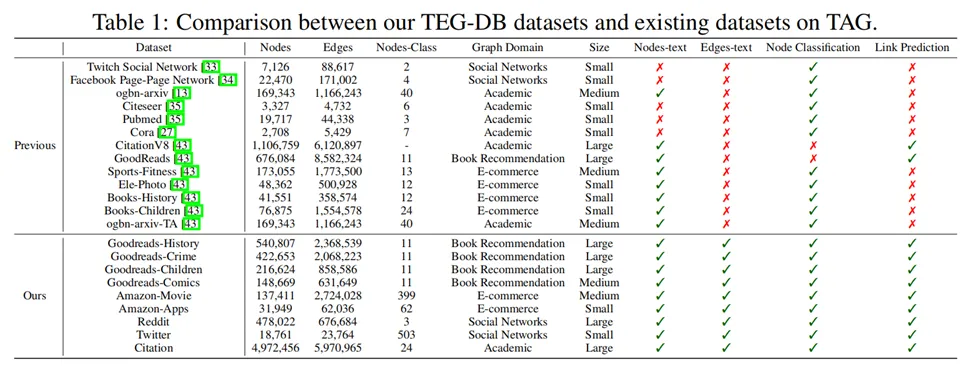

1. TEG-DB datasets提供了涵盖4个领域9个统一格式的TEG数据集,规模从小到大不等,均包含丰富的节点和边的原始文本数据,这些数据集填补了TEGs领域的空白,旨在为相关研究提供重要数据集资源。

2. 研究人员开发了TEGs研究的标准化流程,涵盖数据预处理、加载和模型评估等关键阶段。

3. 研究人员进行了广泛的基准实验,并对基于TEGs的方法进行了全面分析,深入探讨了不同模型及不同规模pre-trained language models(PLMs)生成的嵌入的效果、在GNNs中使用分离和交织嵌入方法(seperate and entangled embedding methods)的影响、边文本的作用以及不同领域数据集的影响。

为了构建同时满足节点和边具有丰富文本信息的数据集,研究人员选择了来自不同领域和规模的9个数据集。

具体包括4个来自Goodreads的图书推荐领域用户-书籍评论网络,2个来自Amazon的电商购物网络,1个来自Semantic Scholar的学术引用网络,以及 2个来自Reddit和Twitter的社交网络。数据集统计请见下表:

利用LLM强大的文本理解能力,LLM可以直接被用于解决图级别问题。具体而言,为每个数据集采用一个包含相应的节点和边文本的text prompt,从而让LLM回答特定问题,例如节点分类或链接预测。

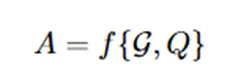

可以正式定义如下:

其中,f是提供图信息的prompt,G表示一个TEG,Q为问题。

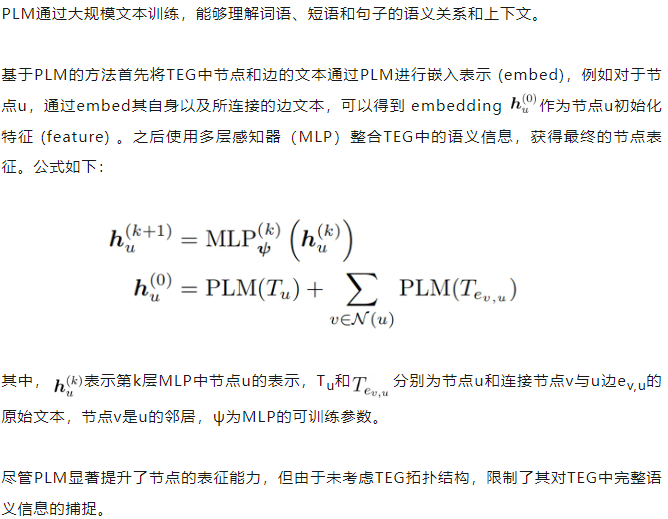

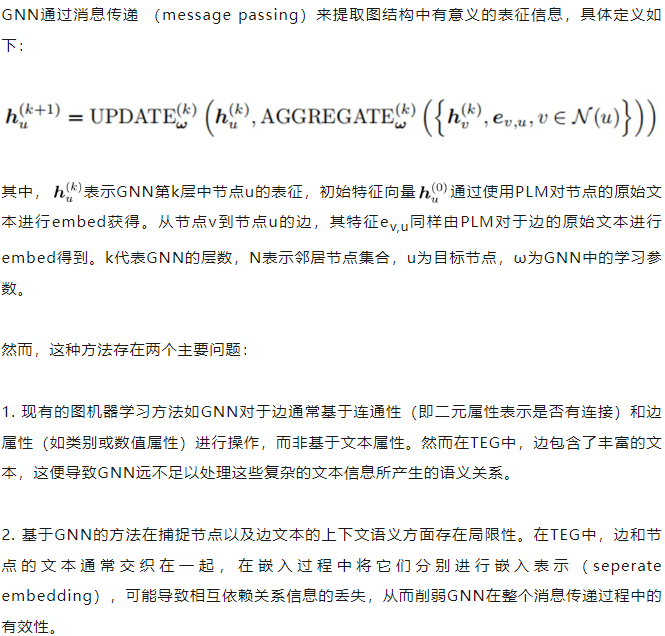

在基于PLM的范式中,使用三种不同规模的PLM对节点文本进行编码,以生成节点的初始嵌入。三种模型分别是:大模型GPT-3.5-TURBO,中型模型Bert-Large,以及小型模型Bert-Base。

在基于Edge-aware GNN的范式中,选择了五种流行的Edge-aware GNN模型:GraphSAGE、GeneralConv、GINE、EdgeConv和GraphTransformer。使用与PLM范式相同的三种规模的PLM对节点和边的文本进行编码,之后这些文本嵌入作为节点和边的初始特征。

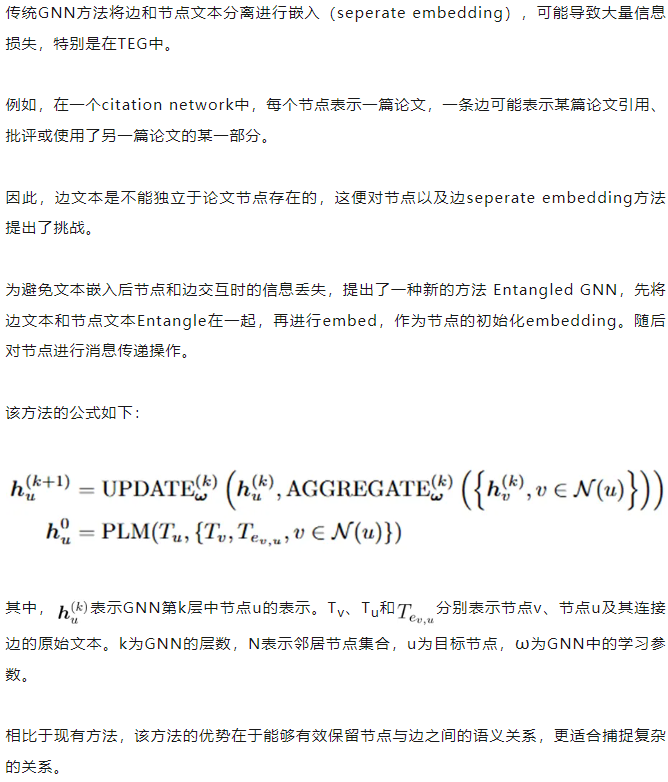

在基于Entangled GNN的范式中,实验设置与Edge-aware GNN相同除了使用Entangled方式通过GPT-3.5-TURBO对于节点和边的文本进行编码。

在LLM as Predictor的范式中,选择通过API访问GPT-3.5-TURBO和GPT-4,以平衡性能和成本。

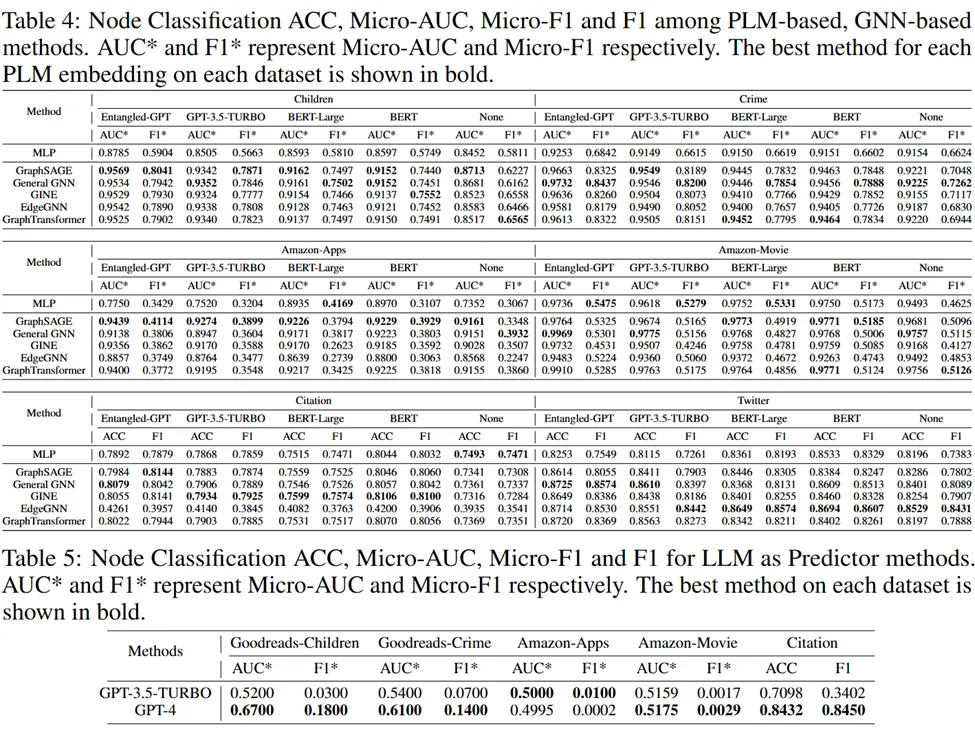

下表展示了不同数据集上节点分类在中的效果:

下表展示了不同数据集上链接预测的效果:

研究人员推出了首个Textual-Edge Graph基准,TEG-DB,旨在深入研究TEG上的图表示学习。

与传统的仅包含节点文本信息的TAG不同,TEG涵盖了节点和边的文本内容。

研究人员收集并提供了9个全面的TEG数据集,以促进NLP和GNN社区对于TEG的合作与探索,其Benchmark对各种学习方法进行了全面评估,确认了它们的有效性和局限性。

此外,研究人员计划继续挖掘和构建更多研究导向的TEG,以推动该领域的持续发展。

文章第一作者为上海大学的本科生李卓风,通讯作者为埃默里大学计算机系的赵亮教授。

共同作者包括埃默里大学的博士生胡云桐、张铮、凌辰,本科生 Sirui Li,中国石油大学本科生刘众源,约翰·霍普金斯大学硕士生 Xiangnan Zhang,山东大学本科生 Zixing Gou。

参考资料:

https://arxiv.org/abs/2406.10310

文章来自于微信公众号 “新智元”