大模型理解复杂表格,能力再次飞升了!

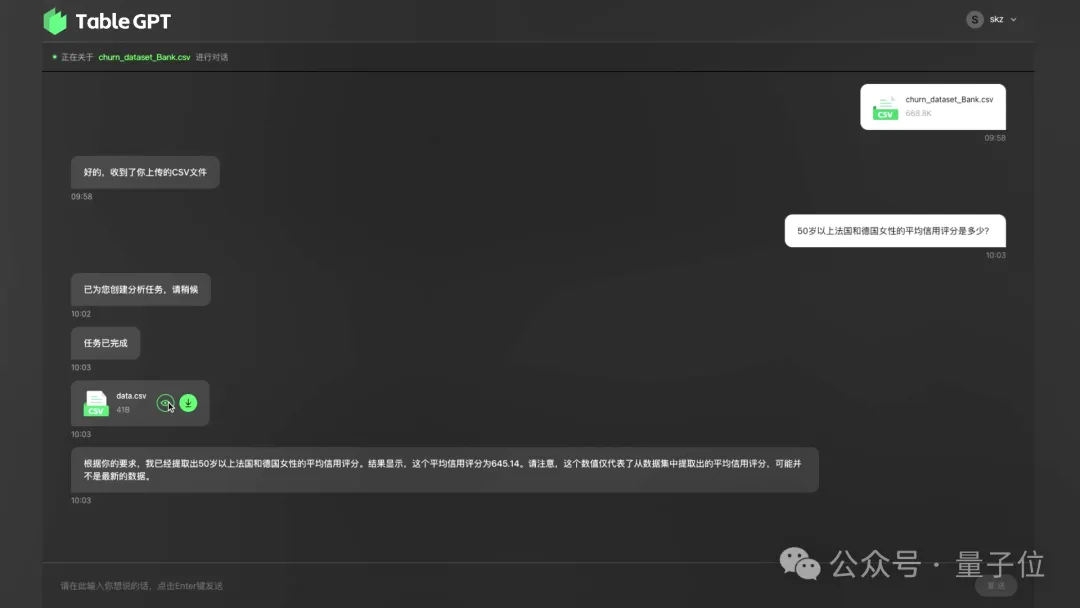

不仅能在不规则表格中精准找到相关信息,还能直接进行计算。

比如提问:

如果2022年出口总额的人民币计价比实际数值少了10%,请计算新的出口总额并与实际数据比较。

普通的大模型要么找不到正确的单元格信息,要么会计算错误。

而最新模型给出了正确回答:

实际出口总额为121324327.3663万元,减少10%后的出口总额为109191894.62967001万元。

这就是由LeCun高徒、浙江大学博导赵俊博领衔打造的TableGPT2。

它首次将结构化数据作为独立模态进行训练,这意味着大模型将不再依赖长上下文窗口,而是直接理解数据库、Excel、数仓中的数据,进而搞定SQL、分析、增删改查等相关任务。

要知道,结构化数据已是无处不在,从BI(商业智能)到当下爆火的具身智能,大模型想要被更充分精准应用于这些领域,就不能再单纯以“文科生”的形式去学习。

由此赵俊博等人耗时1年带来了更强大的TableGPT2。

在23个基准测试中,TableGPT2都表现优异,平均性能提高35.20%(7B模型)和49.32%(72B模型)。

目前团队已将两个版本的模型、一个Agent工作流以及RealTabBench中的一个子集开源。

在TableGPT2之前,业界几乎没有人尝试将结构化数据作为独立模态。这主要有两方面原因——

第一,数据库中表格的空间关系存在特殊性。比如在图像视频上任意交换像素或者词的token,都会改变数据的本质,这说明两种模态之间具备空间依赖关系。但是在数据库的表格中,随机交换2行或2列数据,表格本身并不会变化。目前我们缺乏工具和手段去应对结构化数据这种特点。

第二,结构化数据存在异质性。比如在CV领域,RGB是很客观的表达,红色就是红色,蓝色就是蓝色,自然语言也是一样。但是在结构化数据中,同样一个表格字段下面的标记,在不同数据库里的意义可能截然不同。比如都是“1,2,3”,不同图表中表示的内容可能完全不同。所以这种“异质性”要求大模型对整体的库、表和字段都有理解,才能给出实际意义。这部分的对齐和传统LLM对齐不太一样。

不过这些问题也不是完全不能解决。

赵俊博介绍,针对表格数据,如果掩码掉一个“子表”的一些单元格,加上字段、数据库的信息辅助,是可以才出来掩码信息的内容。这意味着尽管结构化数据的空间关系比较弱,但是本身还是有分布可以去学习的。

由此,研究团队提出了TableGPT2工作。

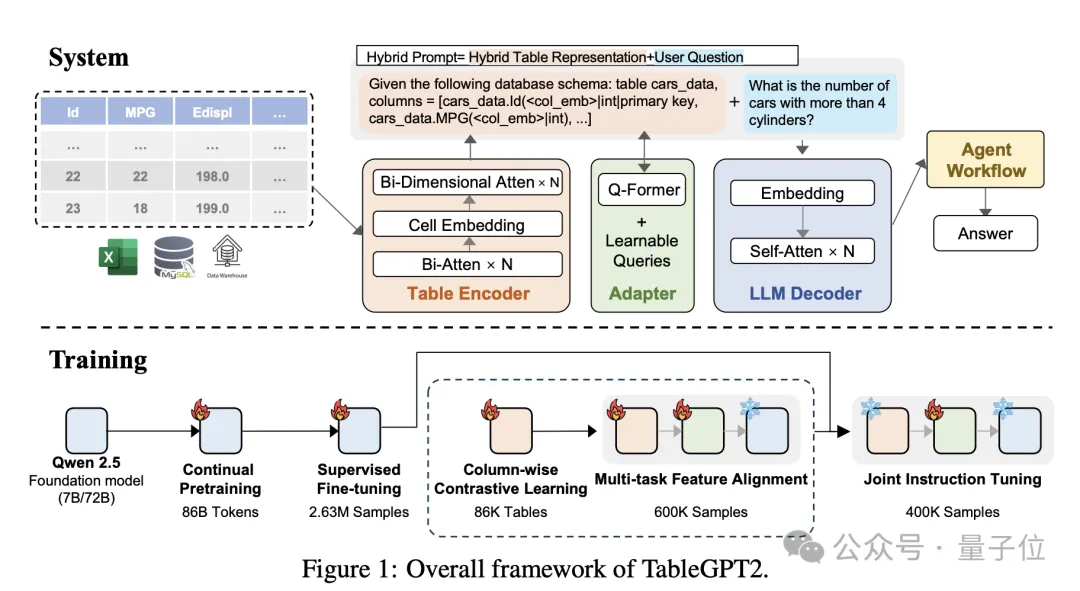

它基于Qwen2.5系列模型,使用超过860亿token进行预训练,给大模型喂入了超过59.38万张表和236万高质量的查询-表-输出样本,并创新性加入了一个表格编码器,专门用于读取和解释表格数据。

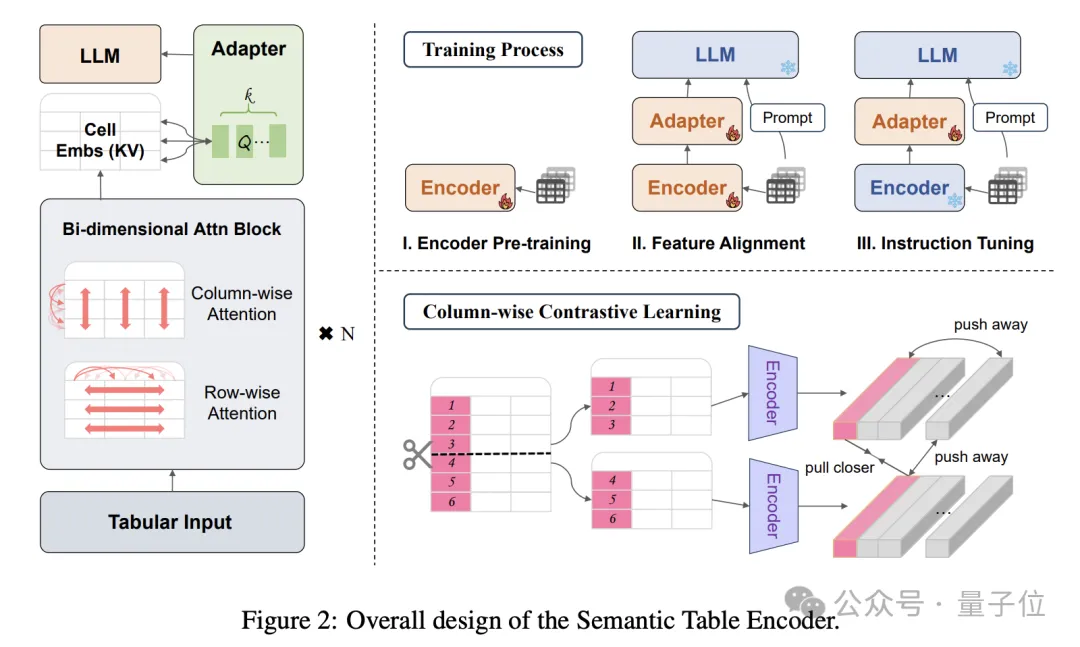

模型主要框架包括以下几个部分:

表格编码器支持输入整个表格,生成每列的紧凑嵌入。

采用双维注意力机制,无需位置嵌入,同时进行分层特征提取,确保行和列的关系被有效捕捉。

再使用列对比方法,鼓励模型学习有意义的、结构感知的语义表示。

具体实现上,通过Q-former样式适配器对齐嵌入和文本输入,引入可学习的查询。

使用特殊标记(如”“和”“)区分表格特征与文本,这样模型可以同时处理两种模态。

应用联合指令微调来增强文本信息、列嵌入和模式单元数据之间的对齐,提高模型对表格数据的理解和解释能力。

值得一提的是,这个表格编码器可以单独使用。作者团队透露,后续还将发表相关论文。

LLM解码器则基于Qwen-2.5模型,用于自然语言生成。

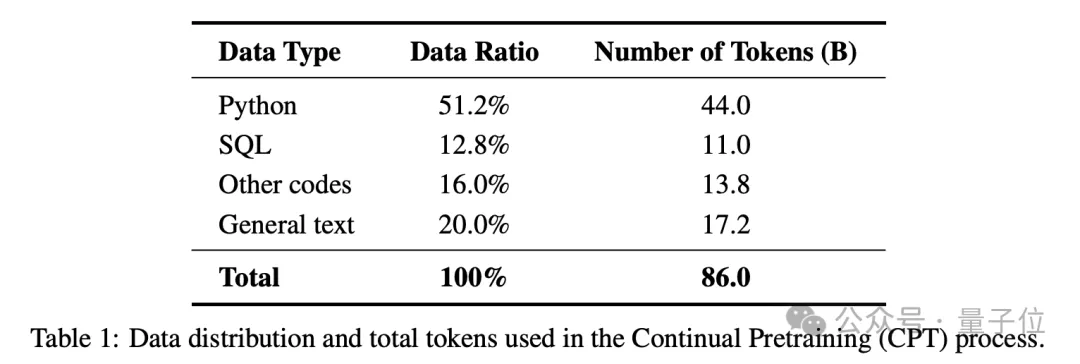

具体训练部分,预训练阶段首先针对模型的编码和推理能力进行加强。80%的预训练数据是有优质注释的代码,这和DeepSeek-v2的方法一致,以确保强大的编码能力。

同时还融入了大量推理数据和特定领域知识(比如金融、制造、生物等),以增强推理能力。

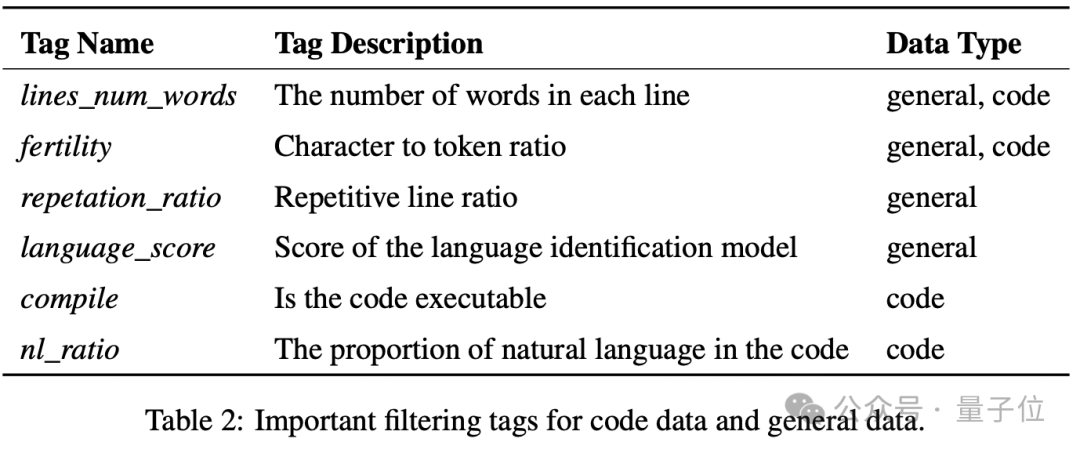

在数据处理层面,采用两级过滤策略。

文档层面将数据标记为54个不同类别,token层面利用RHO-1来微调高质量token。

预训练部分的数据由86B个token组成。

进行监督式微调主要是为了提高模型在BI特定任务中的表现。

作者构建了一个包含236万条样本的数据集,主要覆盖多轮对话、复杂推理、工具使用和高度特定的业务查询场景,包含代码生成、数据可视化、统计测试和预测建模等表格任务。

通过模糊化字段引用、匿名化字段名等方法增强模型在处理复杂任务时的鲁棒性。

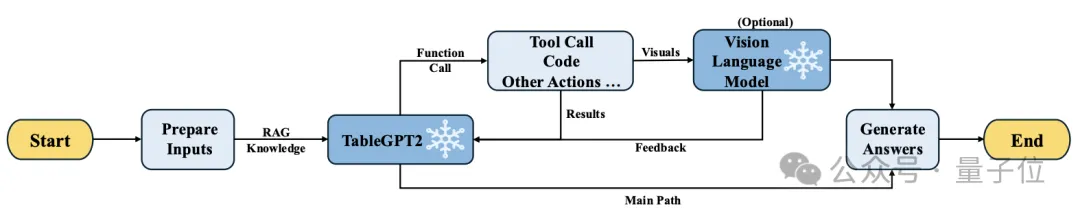

最后来看Agent框架。

该框架由运行时prompt、代码沙箱和agent评估模块共同增强agent的能力和可靠性。

具体工作流如下。首先通过prompt模块处理输入查询,经过检索增强处理后将查询输入到主模型中。然后TableGPT2与VLM协作,生成工具调用、代码或其他相关操作。利用智能体的反思能力,观察中间结果,判断是否需要迭代。最终得到输出。

实验阶段,作者将TableGPT2与其他大模型进行性能对比。

对比对象主要分为两类。

第一类为主流开源大模型,包括DeepSeek-Coder-V2-Lite-16B、YiCoder-9B-Chat、Qwen2.5-Coder-7B-Instruct和Qwen2.5-7B-Instruct。

第二类为针对表格相关任务进行微调或专门开发的模型。包括TableLLMs和CodeLlama-13B。

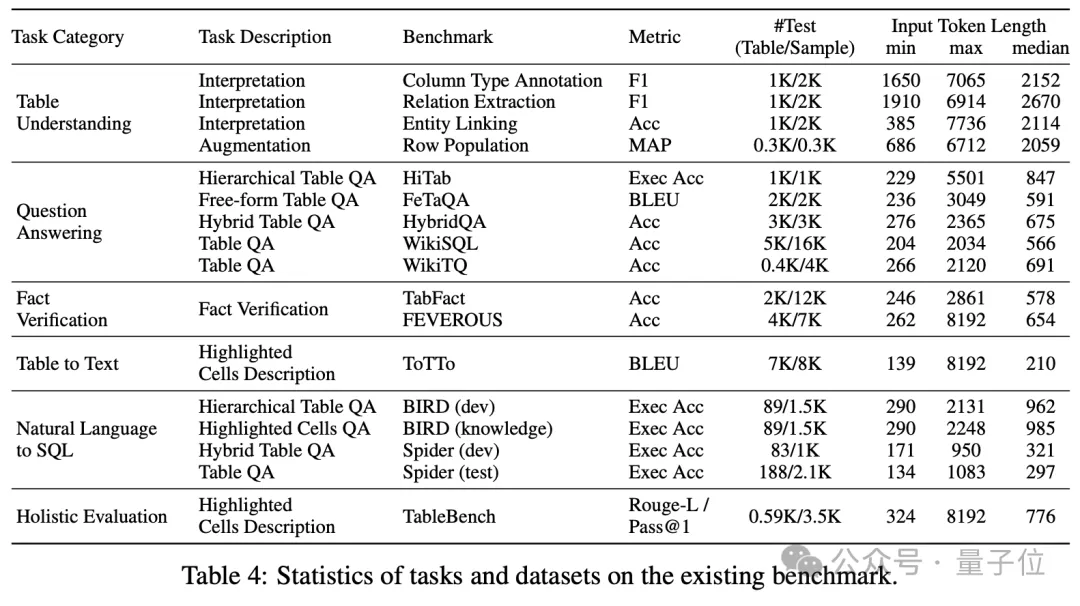

实验主要评估模型的6方面任务:表格理解、问答、事实论证、表格到文本、自然语言到SQL、整体评估。

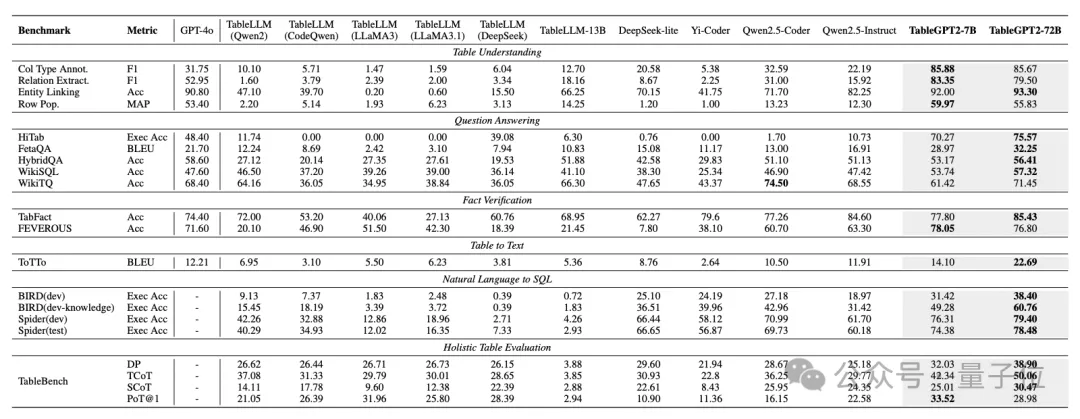

在不同benchmark上,各个模型表现如下。TableGPT2显著优于绝大部分其他模型,并在一些基准上超越GPT-4o。

结果显示,TableGPT2的7B模型和72B模型的平均准确率分别提高了35.20%和49.32%。

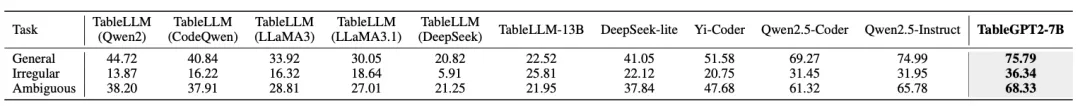

此外,考虑到当下benchmark中针对表格异形问题、匿名问题或者治理较差的情况兼顾不佳,而实际落地中90%以上case都会出现类似情况。

作者还构建了一个新的benchmark—— RealTabBench。它更加关注实际应用中真实出现的问题。

结果显示在RealTabBench上,TableGPT2表现也是最好。

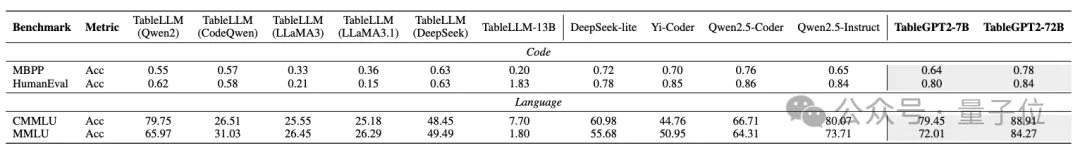

另外,TableGPT2不会导致基座模型通用能力下降。

该研究来自浙江大学计算机与科学技术学院计算创新研究所。

由助理教授、博士生导师赵俊博领衔。

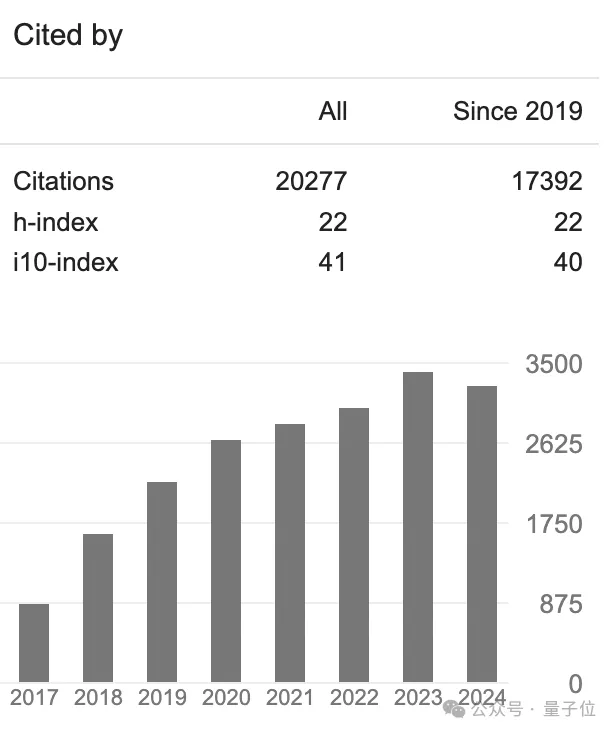

赵俊博于2019年获得纽约大学计算机专业博士学位,师从图灵奖得主、Meta首席AI科学家、纽约大学教授Yann LeCun。

他曾在Meta(原Facebook)人工智能实验室(Facebook AI Research)任研究员,期间深度参与了深度学习主流框架PyTorch和向量数据库Faiss的开发,并曾参与了内部通用对话机器人项目的前沿研究,该工作被视为大模型方向的早期产品化工作之一。

曾于2015年供职于英伟达半年时间,联合主持开发了全球首个端到端的自动驾驶解决方案,该工作由英伟达创始人Jensen Huang在次年的GTC 大会上做隆重介绍。

截至目前论文总被引数已超过20000次。

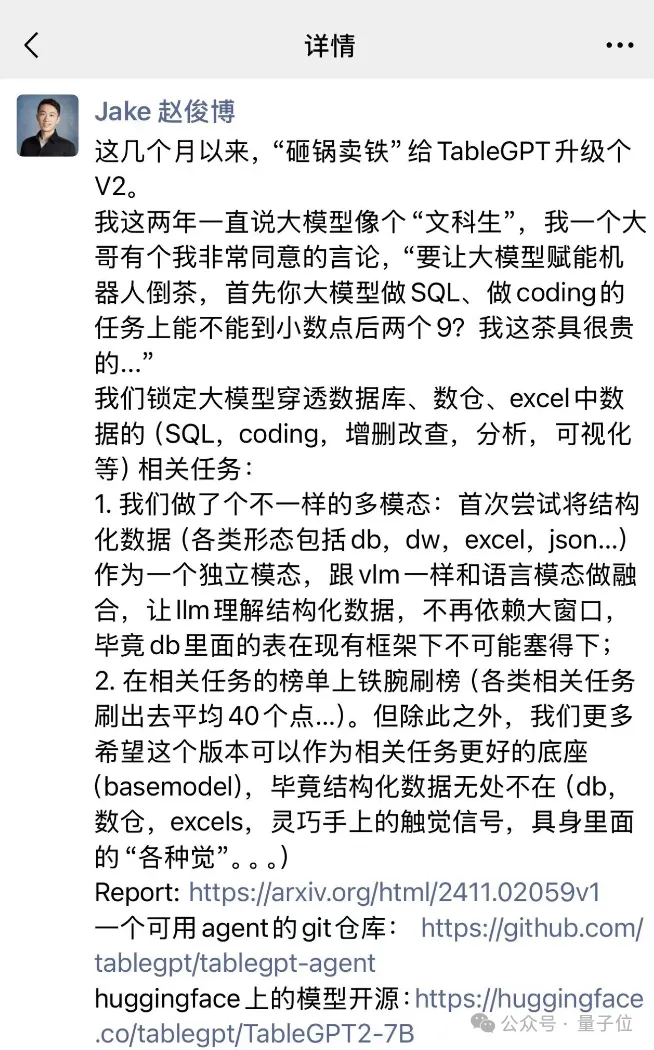

去年,赵俊博主持研发了TableGPT。

这是全球首款对接关系数据库和数据仓的大模型产品。

2024年,团队又继续“砸锅卖铁”,给TableGPT升级了V2版本。

作为高校团队,开发一个大模型意味着算力上要砸钱、数据收集工程优化上要出人,这中间有非常多的坑,需要消耗巨大人力财力。

而且TableGPT2的开发还有着诸多难点。

首先在技术上,构建一个在table上单独模态的编码器很难弄。它独有的复杂结构和空间特点,以及字段语义信息对齐等,都有考验。

其次在数据方面。结构化数据怎么收集、清洗?标签体系怎么定制?如何把合成数据和人工数据合并?怎么做到成本可控,都是问题。

以及监督微调部分,不光需要输入输出样本对,而且需要收集表,专业领域的数据表还需要专业人士进行标注……

不过为啥还是要做呢?

因为他们看到了大模型理解结构化数据背后更广阔的应用前景。

赵俊博向量子位介绍,作为高校团队,他们现在的工作更多是为了“趟路”。

做结构化这件事,我们不会停留在Excel或者数据库上面,下一步技术发展肯定是往硬件和具身智能领域上走。

灵巧手的触觉信息,还有具身智能领域的视觉、听觉等,广义来说都属于结构化数据,我们还想往这个方向再往前一步。

与此同时,TableGPT2也会在产业落地上试水,希望能给从业者提供更好用的底座模型。

目前,团队已经开源了这项工作的多个成果,后续也会发布表格编码器的相关研究,感兴趣的童鞋可以进一步了解~

[1]论文地址:https://arxiv.org/html/2411.02059v1

[2]一个可用agent的git仓库: https://github.com/tablegpt/tablegpt-agent

[3]模型开源:https://huggingface.co/tablegpt/TableGPT2-7B

文章来自于微信公众号“量子位”,作者“明敏”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0