昨天,The Information爆料,传统的大模型Scaling Law已经撞墙,OpenAI下一代旗舰Orion遭遇瓶颈。

就在刚刚,路透社也发文表示,由于当前方法受到限制,OpenAI和其他公司正在寻求通向更智能AI的新途径。

有趣的是,昨天拱火的The Information,今天又急忙发出一篇文章来灭火。

他们强调,昨天的文章只是在说改进大模型必须找到新方法,并不是说Scaling Law已经终结。

但一个不争的事实就是:硅谷几大主要AI实验室正在陷入困境。训练这些大规模的LLM动辄需要花费数千美元,但复杂系统还经常崩溃。往往需要数月时间,才知道模型能否按预期工作。

比起GPT-4o,Orion几乎没有任何改进;谷歌的Gemini 2.0,被曝也存在同样问题;Anthropic据传也已暂停Opus 3.5模型的工作。

据悉,谷歌正准备在12月推测出最新的Gemini 2.0,它可能无法实现DeepMind创始人Demis Hassabis团队预期的显著性能改进,但会有引入一些有趣的新功能

Anthropic首席执行官Dario Amodei 表示,「我们的目标是改变曲线,然后在某个时候成为Opus 3.5」

而离职创业的OpenAI元老则Ilya Sutskever则表示,现在重要的是「扩大正确的规模」。

「2010年代是scaling的时代,现在,我们再次回到了奇迹和发现的时代。每个人都在寻找下一个奇迹。」

对经营着自己的AI实验室SSI的Ilya来说,这是一个很大的改变。

曾经在推动OpenAI的GPT模型时,他的准则是「越大越好」。但在SSI的最近一轮融资中,Ilya开始希望尝试一种与OpenAI不同的Scaling方法。

Scaling Law大家都说得够多了。但有一个问题,却被每个人都忽略了——我们说scaling的时候,究竟在scaling什么?

如今,Ilya抛出了这个振聋发聩的疑问。

毕竟,超大规模语言模型的ROI实在太低了。

虽然在GPT-4发布后,各大AI实验室的研究人员都竞相追赶,发布了超过GPT-4的大模型,但他们更多的感觉是失望。

因为要同时运行数百个芯片,这种超大参数模型的训练可能要花费数千万美元,系统太复杂还可能会出现硬件故障。但只有经过数月,等到运行结束后,研究人员才能知道模型的最终性能。

另一个问题,就是LLM吞噬了大量数据,而世界上易于获取的数据,几乎已经被耗尽了!

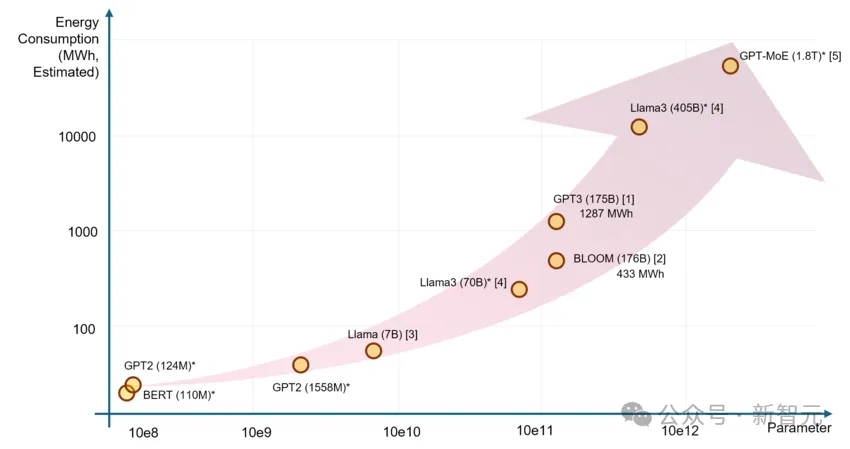

同时,由于过程中需要大量能源,电力短缺也成为训练AI的严重阻碍。

论文题目:「The Unseen AI Disruptions for Power Grids: LLM-Induced Transients」

面对这种种现状,Ilya最近在路透社的采访中表示,扩展训练的结果,已经趋于平稳。

也就是说,用大量未标记数据来理解语言模式和结构的训练阶段到头了。

以前,Ilya是暴力scaling的早期倡导者之一,那时有一种想法广泛认为,通过预训练中使用更多的数据和算力,能让AI模型的性能暴涨。

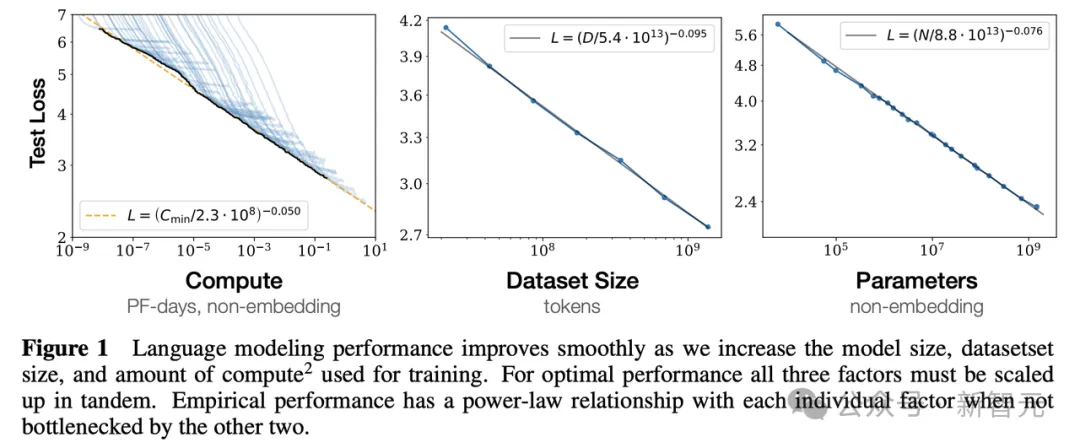

OpenAI团队2020年提交的arXiv论文中最先提出这一概念:LLM性能与计算量、参数量、数据量三者呈现幂律关系

的确,沿着这条路线,最终ChatGPT诞生了。

ChatGPT发布后,从AI热潮中受益颇多的科技公司都公开声称,这种通过增加数据和算力来「scale up」的方法,能显著改善模型性能。

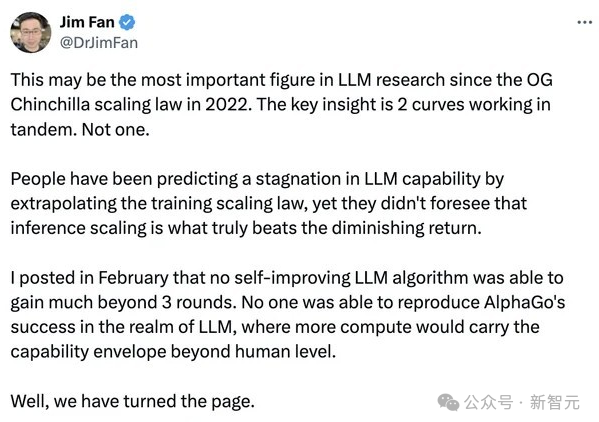

可是现在,Scaling Law已经碰壁了!越来越多的AI科学家,对于这种「越大越好」(bigger is better)的哲学产生了质疑。

2010年代属于Scaling,但大模型要继续发展下去,需要一个新的奇迹。

Ilya的SSI团队是否找到了呢?

对此,Ilya拒绝透露,只是表示,SSI正在研究一种全新的替代方法,来扩展预训练。

同时,OpenAI仿佛也找到了新方法——通过开发使用更类人思维的算法训练技术,或许就能克服在追求更大规模LLM过程中遇到的意外延迟和挑战。

已经有十几位AI科学家、研究人员和投资者告诉路透社,他们认为正是这些技术,推动了OpenAI最近发布的o1模型。

而它们,可能会重塑AI竞赛的格局,让AI公司们不再对能源和芯片资源产生无限制的需求。

有没有这么一种新方法,让AI模型既能摆脱对数据的依赖,又不再需要动辄吞噬整个国家乃至全球的电力?

为了克服这些挑战,研究人员正在探索一项「测试时计算」的技术。

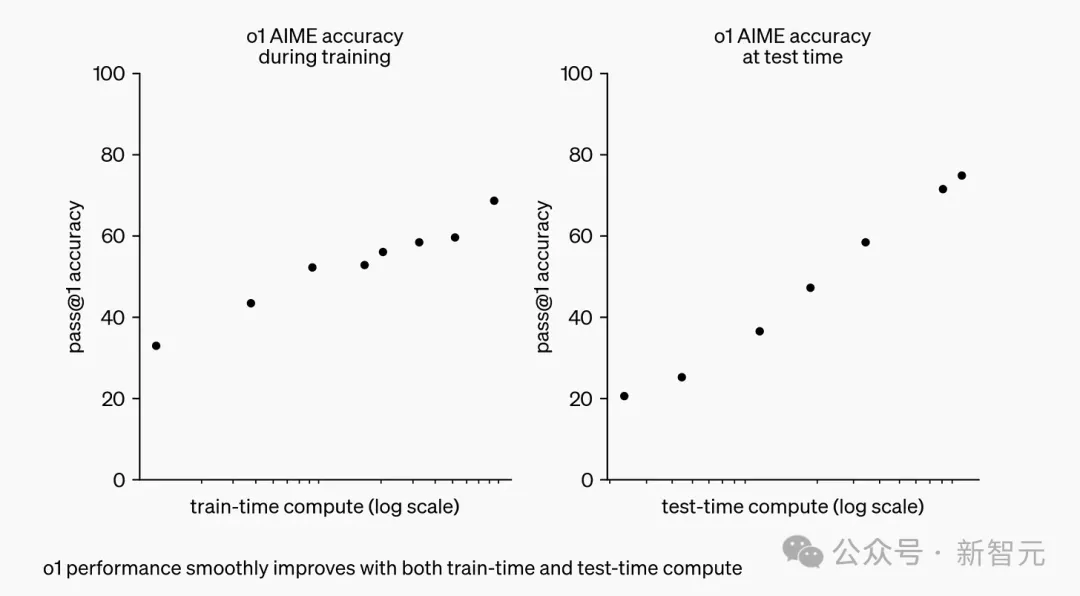

上图即是OpenAI解释o1的博文,x轴标记为「训练时计算」和「测试时计算」。

左图是OpenAI发现的Scaling Law,意味着在模型上投入更多训练时间(GPU周期)时,我们可以获得更好的结果。

右图则暗示了我们尚未触及的一套全新的Scaling Law。「测试时计算」意味着,给模型更多的「思考时间」(GPU周期)时,它会思考出更好的结果。

测试时计算技术,能在推理阶段(模型被使用时)就将模型增强,比如,模型可以实时生成和评估多种可能性,而不是理解选择单一答案。最终,模型就可以选择出最佳路径。

这种方法可以允许模型将更多的处理能力,用于数学、编码问题等具有挑战性的任务,或者需要类人推理和决策的复杂操作。

传统的Scaling Law,专注于用更长时间训练大模型,但如今o1系列模型scaling有了两个维度——训练时间和测试(推理)时间

早在上个月的旧金山TED AI会议上,曾参与o1开发的OpenAI研究员Noam Brown就提出——

事实证明,让一个机器人在一局扑克中思考仅20秒,其性能提升与将模型规模扩大10万倍并训练10万倍时间相同。

o1模型以前曾被称为「Q*」和「Strawberry」。现在,它能够以多步骤方法思考问题,类似于人类推理。

现在,模型不再受限于预训练阶段,还可以通过增加推理计算资源,来提升表现

而且,它还涉及了来自博士和行业专家策划的数据和反馈。

o1系列的秘密武器,是在GPT-4等基础模型上进行的另一套训练,OpenAI还计划,将这种技术应用于更多更大的基础模型。

OpenAI的首席产品官Kevin Well在十月的一次科技会议表示——

我们看到很多可以快速改进这些模型的机会,而且非常简单。到人们赶上来的时候,我们会尝试再领先三步。

通过思维链提示,o1模型可以经过训练生成长长的输出,并通过答案进行推理

OpenAI说要领先三步,其他顶尖AI实验室岂甘落后?

据知情人士透露,来自Anthropic、xAI和谷歌DeepMind的研究人员,也已经奋力开卷了!

比如Meta最近提出了「思维偏好优化」TPO,这种方法旨在教会LLM在回答一般任务(而不仅仅是数学或逻辑问题)之前「思考」,而不需要特殊的训练数据。

论文地址:https://arxiv.org/pdf/2410.10630

而谷歌也在开发一种新模型,同样使用CoT方法解决多步骤问题、生成多个答案,评估后选择最佳答案。

这个过程同样可以通过在推理中使用更多算力来增强,而非仅仅增加训练数据和算力,这就为扩展AI模型开辟了一条新道路。

论文地址:https://arxiv.org/pdf/2408.03314

这会导致什么后果?

很有可能,对英伟达GPU巨大需求主导的AI硬件竞争格局,将从此改变。

这是因为,通过增加训练时间和测试(推理)时间,可能会获得更好的结果,模型就不再需要那么大的参数。

而训练和运行较小模型会更便宜,因此,在给定固定计算量的情况下,我们可能会突然从小模型中获得更多收益。

突然之间,模型参数、训练时间和测试时间计算之间的关系变得复杂了,也就让我们看到了下一代GPU的可能。

比如Groq这样的公司,恰巧就在为这类任务制造专门的芯片。

今年2月登场的世界最快大模型Groq,每秒500 token直接破了纪录,自研的LPU在LLM任务上比英伟达GPU性能快了10倍。

红杉资本和A16z在内的著名风投机构,如今已经投入了数十亿美元,资助OpenAI、xAI等多家AI实验室的开发。

他们不可能不注意到最近圈内盛传的Scaling Law碰壁事件,而重新考虑自己的昂贵投资是否会打水漂。

红杉资本合伙人Sonya Huang表示,这种转变,将使我们从大规模预训练集群转向推理云,即分布式的、基于云的推理服务器。

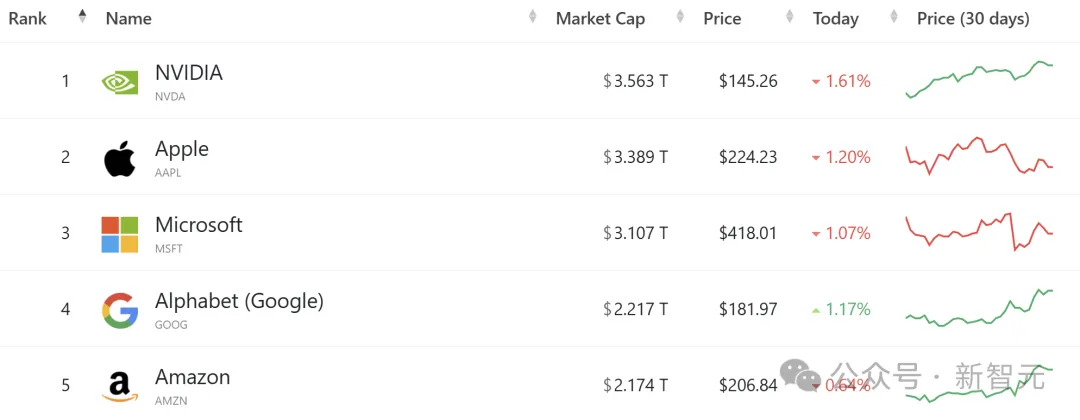

大模型热以来,对英伟达尖端AI芯片的需求,已经让它崛起为全球最有价值的公司,并且市值超越了苹果。

今年以来,英伟达股价了约186%,而苹果仅上涨了17%

虽然在训练芯片的市场,英伟达已经占据主导地位,但它在推理市场,可能还会面临更多竞争。

而o1模型背后技术,意味着对推理芯片的需求也会随着增加。

「我们现在发现了第二个Scaling Law,这是在推理阶段的Scaling Law……所有这些因素导致对Blackwell的需求非常高。」

在英伟达GTC大会上,黄仁勋也讲到,如果要训练一个1.8万亿参数量的GPT模型,需要8000张H100 GPU,消耗15兆瓦的电力,连续跑上90天

随着Scaling Law碰壁,各大公司纷纷开启新路线,英伟达是否还会继续坐火箭般的辉煌呢?

The Information今天的解释文章,标题意味深长:《再见,GPT。你好,推理「o」》。

文章内容是这样的。

月初,一位Reddit用户曾在QA种问道,OpenAI的下一代旗舰大语言模型何时发布。

对此,Altman回答说:「今年晚些时候,我们会发布一些非常不错的产品,但并不会叫做GPT-5。」随后他又补充道,有限的计算资源意味着很难同时推出过多的项目。

当时我们并未多想。

但如今,我们更能理解Altman的评论了——以及他为何专注于推出o系列推理模型而非另一版本的GPT 。

所谓GPT,即生成式预训练Transformer模型,是ChatGPT和大多数其他生成式人工智能产品的基石。

原因正如之前报道的那样,GPT的改进速度正在放缓。

2023年初登场的上一代旗舰级模型GPT-4,凭借着巨大的性能提升在科技行业引发了轰动。

Orion比GPT-4更好,但其质量提升与GPT-3和GPT-4之间的差距相比略显逊色。甚至,可能会让OpenAI放弃自2018年推出GPT-1起使用的「GPT」命名惯例。

因此,当Altman写道「o1及其后续版本」时,可能意味着Orion将与推理融合并被命名为「o2」。

让我们回到GPT发展放缓这个问题上。

传统的Scaling Law不仅仅意味着在大语言模型训练过程中需要更多的数据和计算能力才能获得更好的结果。OpenAI的研究人员还做了各种其他有趣的事情,才使得GPT-4比GPT-3有了大幅提

升。比如,引入被称为模型稀疏性的概念。

随着推理范式的出现,预训练改进的放缓变可以得到弥补——从本质上讲,它可能代表了一种新的Scaling Law。

OpenAI一再表示,推理模型的性能在回答问题前有更多时间思考时会变得更好,这被称为对数线性计算扩展。

那么,这些变化是否意味着OpenAI的1000亿美元超级计算集群的梦想正在消退呢?对于这个问题,可以肯定的是,所有主流的AI开发者都在全速推进极其昂贵的集群建设。

一方面是,大型集群上可以更好地在预训练后改进这些模型、在后训练阶段处理强化学习以及更新或微调模型。

另一方面是,即便预训练模型的改进速度放缓,但只要自己能训出比竞争对手略好的模型,就值得增加的数据中心投入。毕竟,LLM越好,将推理模型融入模型后获得的结果就越好。

最后,如果GPT的发展没有加速,是不是就意味着末日论者错了——AI不会进入所谓的递归自我改进循环,在这个循环中,AI会一次又一次地找出如何制造下一个更好版本的自己(然后也许会征服我们所有人)?

对此,Marc Andreessen认为,这种明显的平台期意味着这样的恐惧目前看来是没有根据的。

文章来自于微信公众号 “新智元”,作者:“ 新智元 ”

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner