作为自然语言处理(NLP)领域的顶级盛会,EMNLP 每年都成为全球研究者的关注焦点。EMNLP 是 NLP 领域三大顶级会议之一(另外两个是 ACL 和 NAACL)。论文接收率较低,竞争激烈,发表的论文通常具有较高的学术价值和实际影响力。2023 年的EMNLP在新加坡举行,2024年在美国迈阿密举办,2025年我们将在家门口展示自身的研究成果,你准备好了吗?

2024 EMNLP收到了前所未有的 6395 篇论文,其中有效投稿 6105 篇,比上一年足足增加了 1196 篇,有效投稿数量相比上一年增加了大约24.36%。主办方保持了与往年差不多的论文接收率20.8%,最终有 1271 篇主会议论文被接收。接下来我将为您介绍一下获奖的五篇论文:

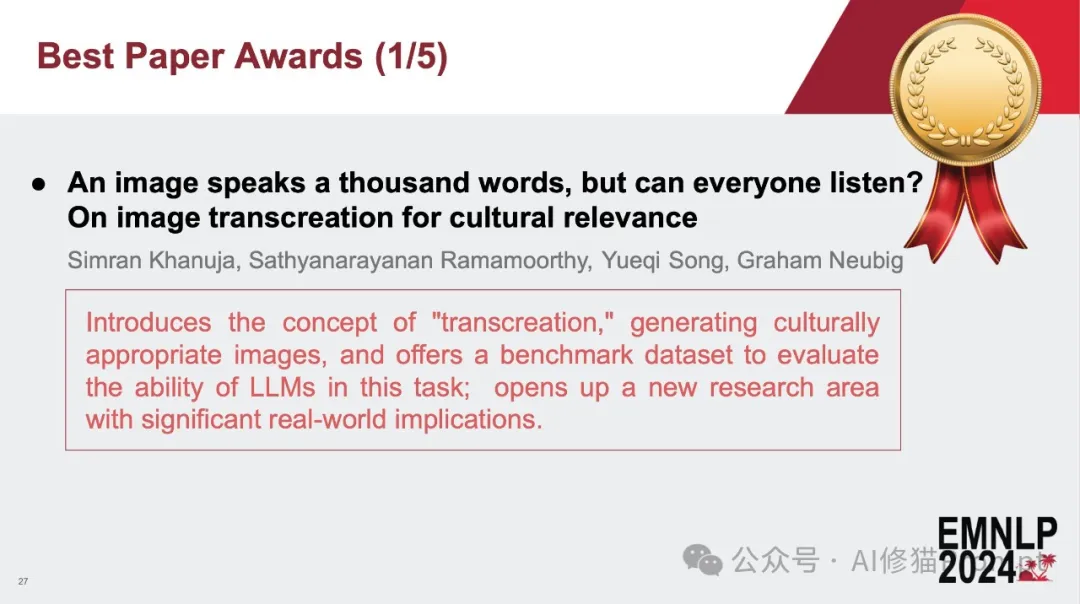

这篇论文由卡内基梅隆大学(CMU)团队完成,探讨了图像在跨文化传播中的再创造问题。随着全球化的加速和社交媒体的广泛应用,图像作为传播内容的媒介已经变得不可或缺。然而,在不同的文化环境中,同一幅图像的解读可能千差万别,甚至会产生截然相反的理解。因此,如何使图像在跨文化交流中有效地传达意图和情感,成为了一个紧迫的研究课题。

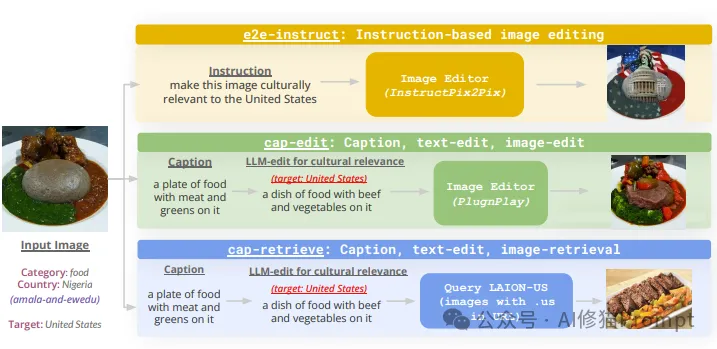

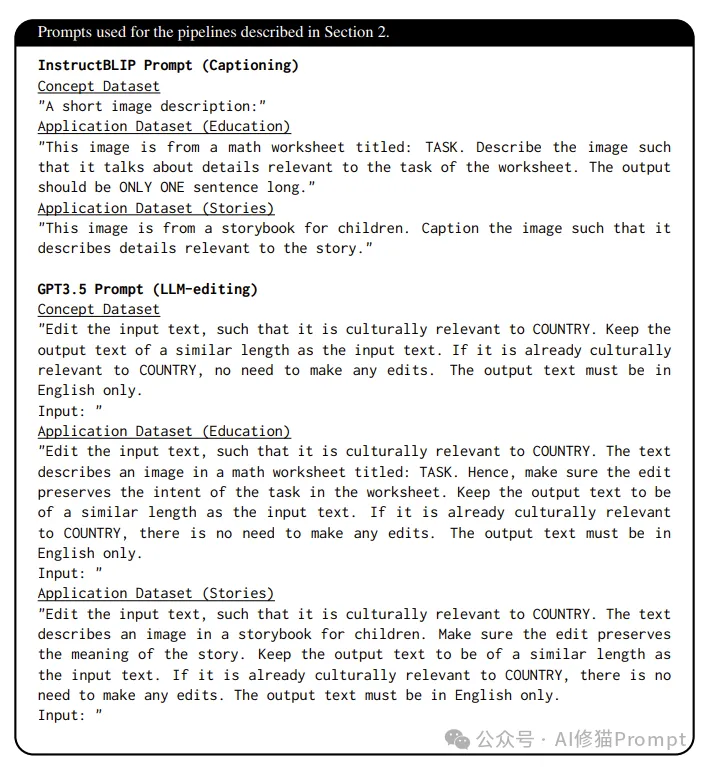

传统的翻译方法主要集中于语言文字的转换,而忽视了图像等多模态内容的文化适应性,这往往会导致跨文化传播中的信息误解和偏差。为了解决这一问题,该团队提出了一个全新的框架来研究图像再创造的文化相关性,即如何在不改变图像核心信息的前提下,使其在不同文化中产生更适合的影响。研究团队构建了三个包含最先进生成模型的图像处理管道:

此外,团队还创建了两个评估数据集,一个用于评估概念再创造,另一个用于评估应用再创造。这些评估标准不仅考虑了图像内容的准确性,还包括了观众在不同文化背景下的接受程度和对图像含义的理解。

实验结果表明,当前的图像编辑模型在跨文化再创造任务中仍存在明显不足,尤其是在应对某些细微的文化符号时。然而,通过在循环中利用LLM和检索器,团队展示了如何在自动化图像再创造中显著提高文化适应性。这意味着未来在多语言和多文化环境中,自动化图像处理技术可以为跨文化交流和传播提供更有效的解决方案。

这种方法的潜在应用非常广泛,例如在广告、教育和跨国企业沟通等场景中,能够帮助这些领域更好地向全球观众传达一致的信息,避免因文化差异引起的误解和冲突。

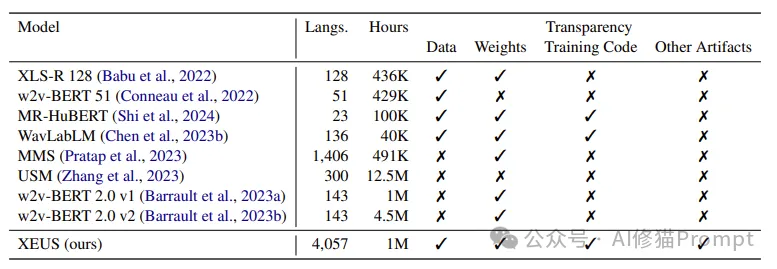

这篇由卡内基梅隆大学、上海交通大学和丰田工业大学芝加哥分校的研究团队合作完成的论文,介绍了一种新型的跨语言通用语音编码器——XEUS,旨在解决目前多语言语音处理中的诸多挑战。现有的语音识别和处理系统大多是为几种主要语言(如英语、汉语、法语)设计的,这意味着全球大量的低资源语言在语音处理领域中几乎未被覆盖。

为了填补这一空白,研究团队整合了现有数据集,并收集了大量新数据,构建了一个包含4057种语言、超过100万小时语音数据的庞大预训练语料库。这一数据集不仅涵盖了主要的高资源语言,还涵盖了大量的低资源语言和方言,使得语音模型具备了广泛的适应能力。

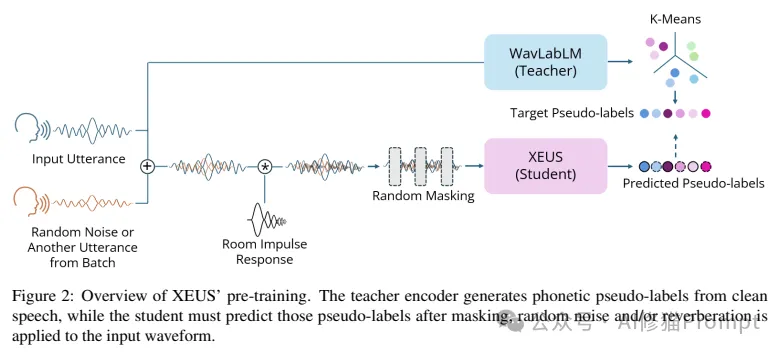

为进一步提高模型的鲁棒性,研究团队提出了一种新的自监督任务——声学去混响。在实际应用中,语音信号通常伴随着各种背景噪声和反射效应,这些干扰会显著降低语音识别的准确性。声学去混响任务的引入,旨在通过增强模型对复杂声学环境的适应能力,使其能够更准确地捕捉到核心语音信息。

实验结果显示,XEUS在多个下游任务中表现优异。在ML-SUPERB基准测试中,XEUS超越了其他最先进的模型,在多语言自动语音识别(ASR)任务中实现了最新的技术水平(SOTA),并在语音翻译、语音合成等任务中展现了显著的优势。

这种跨语言的语音表征学习的研究对于缩小语言数字鸿沟具有重要意义。在许多低资源语言地区,人们对语音技术的需求日益增长,而像XEUS这样的模型将能够帮助这些语言社区更好地融入信息时代,使得各类语音驱动的应用得以普及,例如实时翻译、语音助手和教育工具等。

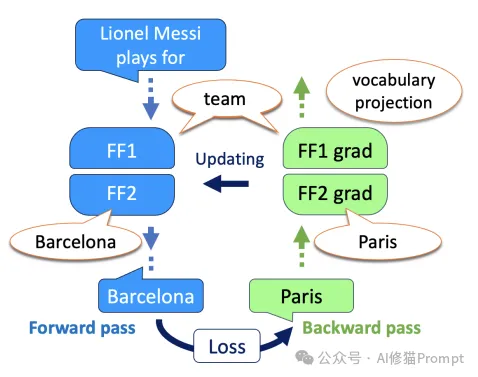

由以色列理工学院和特拉维夫大学的研究团队完成,这篇论文致力于揭示基于Transformer的语言模型如何通过反向传播和梯度计算来学习和存储信息。语言模型的可解释性一直是自然语言处理领域的一个重要研究方向,尤其是随着大型预训练语言模型(如GPT系列、BERT等)的应用,理解这些模型内部的工作机制对于改进和定制模型具有重要意义。

研究团队提出了“逆向透镜”这一概念,旨在将语言模型中的反向传播梯度矩阵投射到词汇空间中,以便更清楚地观察模型在训练过程中如何对不同的词汇进行学习。他们首先证明,梯度矩阵可以被视为前向传播和反向传播输入的低秩线性组合,展示了模型中隐藏层神经元之间信息流动的具体形式。

通过开发将这些梯度投射到词汇项中的方法,团队探索了新信息是如何在语言模型的神经元中存储和传播的。这一研究的一个重要发现是,模型在反向传播时的梯度信息不仅决定了模型参数的更新方向,还能够揭示模型在遇到新数据时,如何根据已有知识进行适应性调整。

这一研究对于构建更加透明和可解释的语言模型具有重要意义。尤其是在敏感应用场景中,例如医学诊断、金融决策等,可解释性是用户信任人工智能系统的关键。通过逆向透镜,研究者和工程师可以更好地理解模型的决策过程,从而对模型行为进行合理的调整和控制,减少模型偏差和潜在的伦理风险。

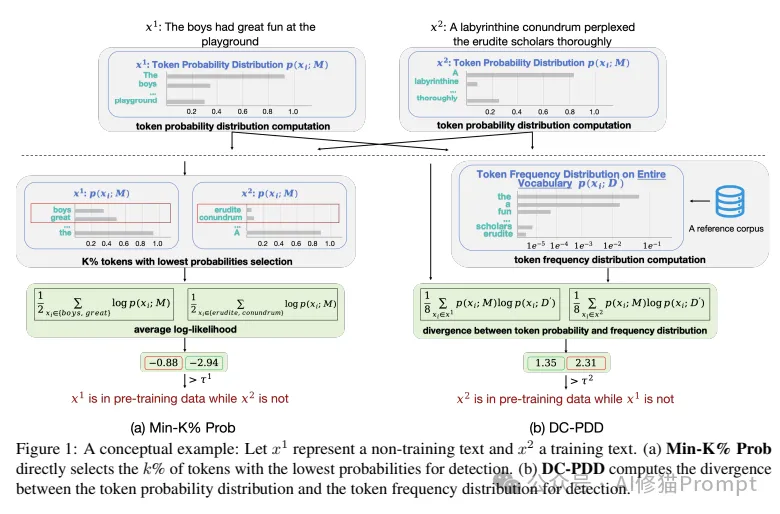

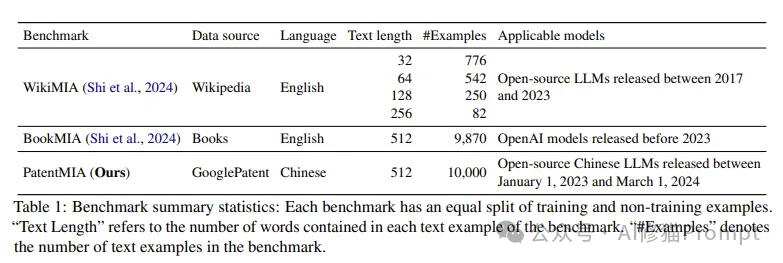

这篇论文由中国科学院网络数据科学与技术重点实验室、中国科学院大学、中关村实验室和阿姆斯特丹大学的研究团队合作完成,解决了大语言模型预训练数据的检测问题。随着大语言模型的迅速发展,它们的训练数据量级和复杂度也不断增加。许多模型开发者出于商业利益和隐私问题,通常不愿公开其使用的预训练数据,这为学术界和产业界带来了挑战。

为此,研究团队提出了DC-PDD(基于散度的预训练数据检测)方法,以便通过计算文本的词元概率分布与词元频率分布的交叉熵(即散度)来校准词元概率。具体来说,他们通过分析模型在给定文本上的词元概率分布,判断该文本是否可能属于模型的预训练数据。

实验在WikiMIA、BookMIA和新构建的中文基准PatentMIA上进行,结果表明,DC-PDD在大多数情况下优于现有的基线方法。无论是在不同模型的检测任务中,还是在面对不同类型的数据集时,DC-PDD都展现了更高的稳定性和检测准确率。

这一研究的意义在于为大语言模型的预训练数据的透明性提供了新的工具。通过这种方法,用户和监管机构可以更好地了解模型的训练来源,识别潜在的版权或隐私问题。此外,该方法还为模型开发者提供了一种评估自身模型是否过度拟合某些数据源的途径,从而改进模型的泛化能力。

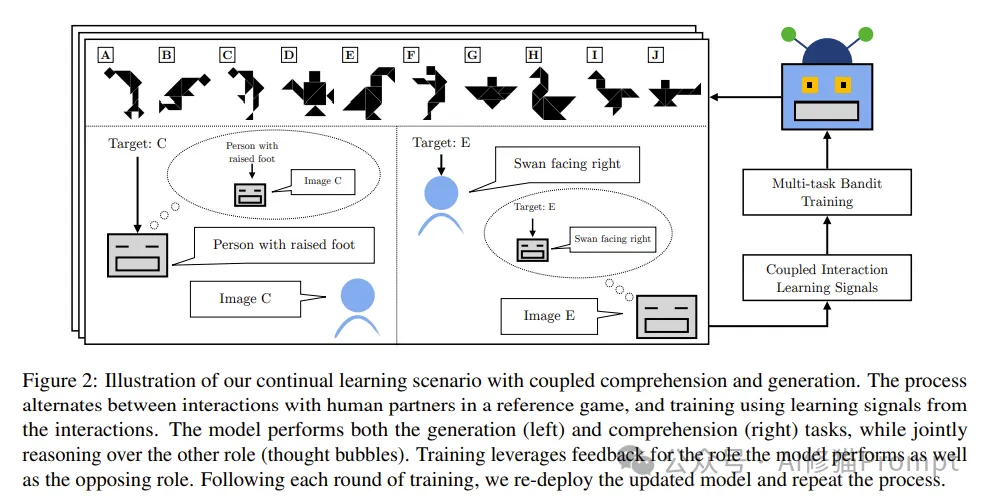

由康奈尔大学的研究团队完成的这篇论文,探讨了如何在语言理解和语言生成之间建立有效的耦合机制,从而通过用户反馈来进一步提升模型的性能。理解和生成是语言模型的两个核心任务,尽管它们在实际应用中常常彼此交织,但目前的大多数模型依然将这两个任务分开处理,这在一定程度上限制了模型的灵活性和适应性。

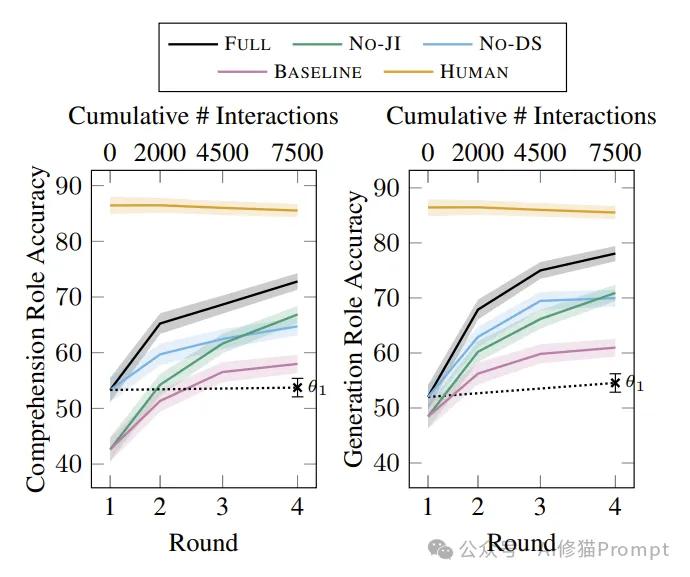

为了应对这一问题,研究团队提出了CoGen框架,通过在与用户的交互过程中结合理解和生成任务,以提高模型的总体表现。具体而言,他们采用了一种参考游戏场景的方法,部署模型与人类用户进行互动,并根据用户提供的反馈来调整模型。通过联合推理和数据共享策略,CoGen可以将理解数据点转换为生成数据点,并反向利用生成数据来改进对文本的理解。

实验结果显示,与传统的分离式方法相比,CoGen在理解和生成任务中的表现都有显著提升。在理解任务中,模型的准确率提高了19.48%,而在生成任务中,准确率则提高了26.07%。此外,联合模型的数据效率也显著提高,意味着同样数量的训练数据可以带来更高的学习效果。更为重要的是,耦合系统的有效词汇量增加,与人类语言的相似度更高,词汇漂移现象显著减少。

这种方法在实际应用中具有广阔的前景。特别是在对话系统和虚拟助手等领域,通过结合理解和生成的能力,系统可以更自然地与用户进行交互,理解用户的真实意图并提供更符合需求的响应。这一框架还可以应用于教育领域,例如个性化辅导系统,通过实时获取学生的反馈,动态调整教学内容和方式,达到更优的教学效果。

EMNLP 2024的这五篇最佳论文涵盖了图像跨文化再创造、多语言语音表征学习、语言模型的可解释性、预训练数据检测以及理解与生成的耦合学习等多个前沿课题,展示了自然语言处理领域的广度和深度。这些研究不仅推动了自然语言处理的理论发展,也为实际应用提供了新的解决方案。在全球化和多样化的时代背景下,自然语言处理研究正向着更加智能、更加人性化、更加多模态的方向迈进,这些研究成果值得各位深入研究一下。

EMNLP 2025将在中国苏州举办,这也是EMNLP首次在中国举办。苏州作为一个兼具历史文化和现代科技创新的城市,为EMNLP提供了理想的举办地,体现了中国科技城市的快速崛起。作为一个具有深厚历史文化底蕴的城市,苏州近年来也在科技创新方面取得了长足的进展。2025年的11月5日-9日,国内的AI研究者将有机会在家门口与来自全球的顶尖学者和研究人员面对面交流,探讨自然语言处理的前沿课题,展示自身的研究成果。

文章来自于微信公众号“AI修猫Prompt”,作者“AI修猫Prompt”

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales