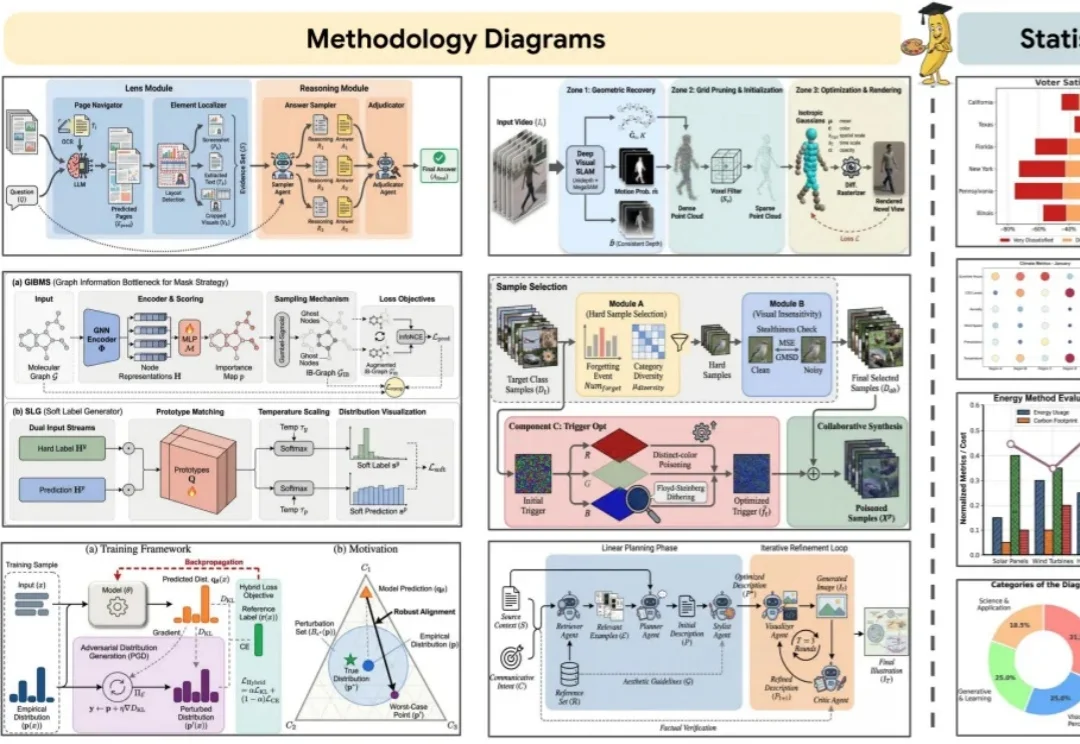

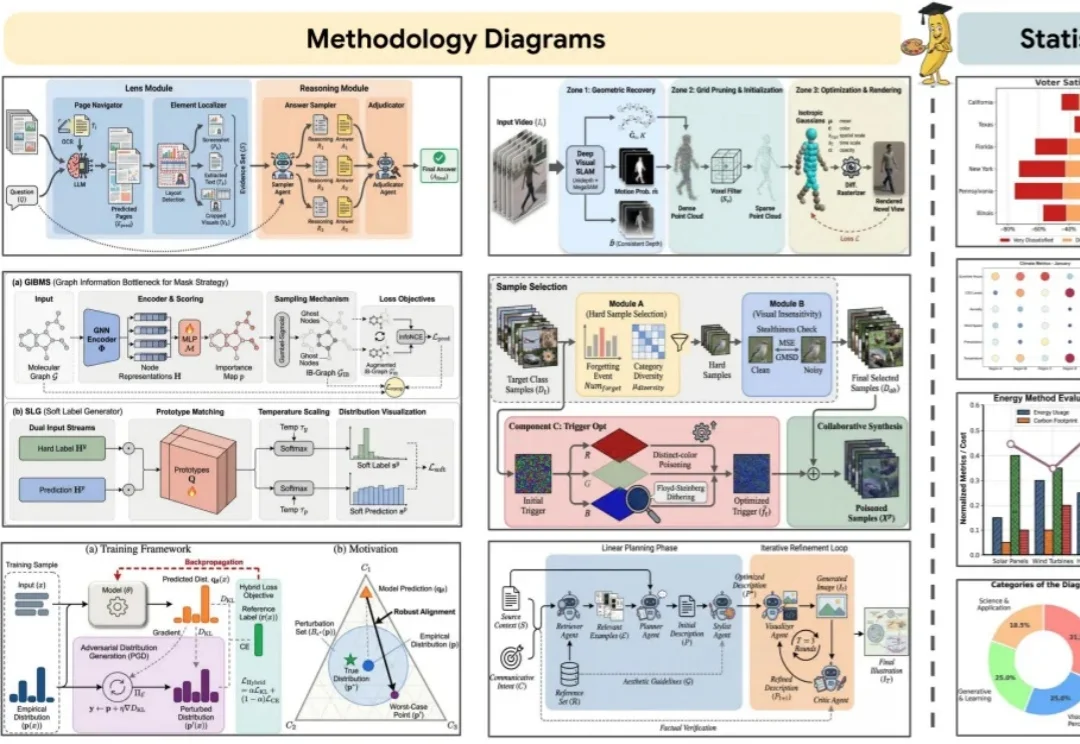

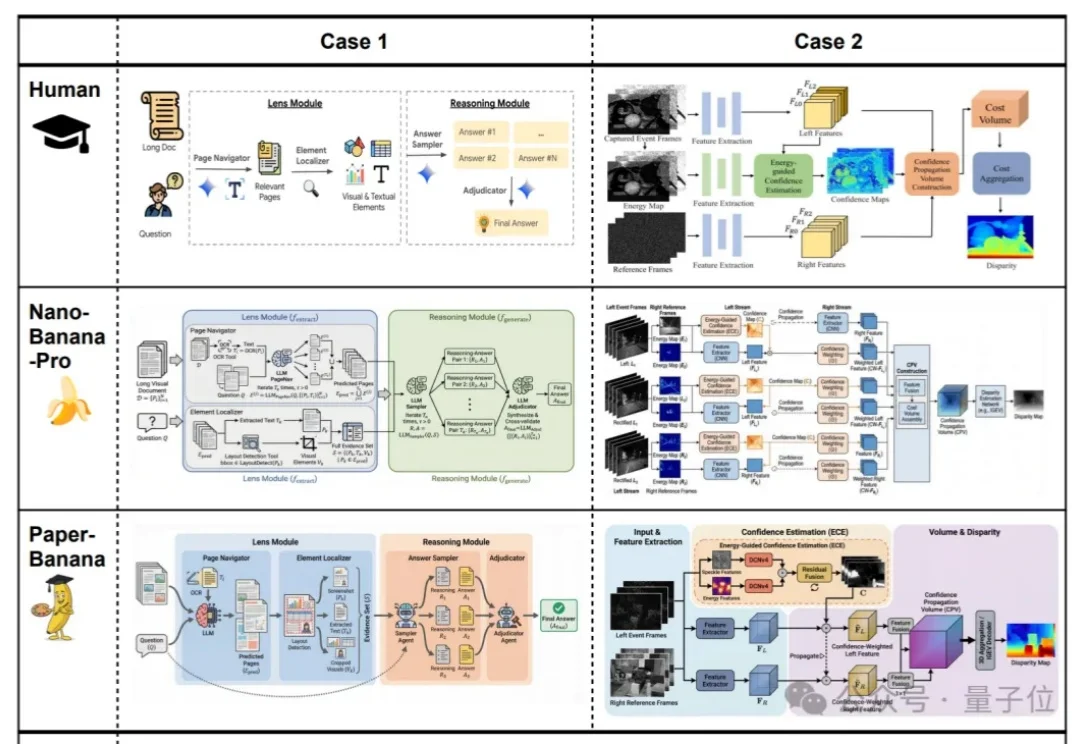

谷歌做了个论文专用版nano banana!顶会级Figure直出

谷歌做了个论文专用版nano banana!顶会级Figure直出你负责写方法,AI负责画 Figure。 科研打工人,终于等来「画图解放日」。

你负责写方法,AI负责画 Figure。 科研打工人,终于等来「画图解放日」。

效果好到刷屏的Nano Banana,学术特供版热乎出炉!

较真还得是程序员。

如果论文是AI写给AI看的,那人类还剩下什么?

AAAI 2026「七龙珠」,华人团队强势霸榜!从视觉重建到因果发现,再到知识嵌入传承,新一代AI基石正在新加坡闪耀。

华东师范大学Planing Lab提出APEX框架,通过自然语言指令实现学术海报的局部可控编辑,并引入「审查—调整」机制提升编辑可靠性。

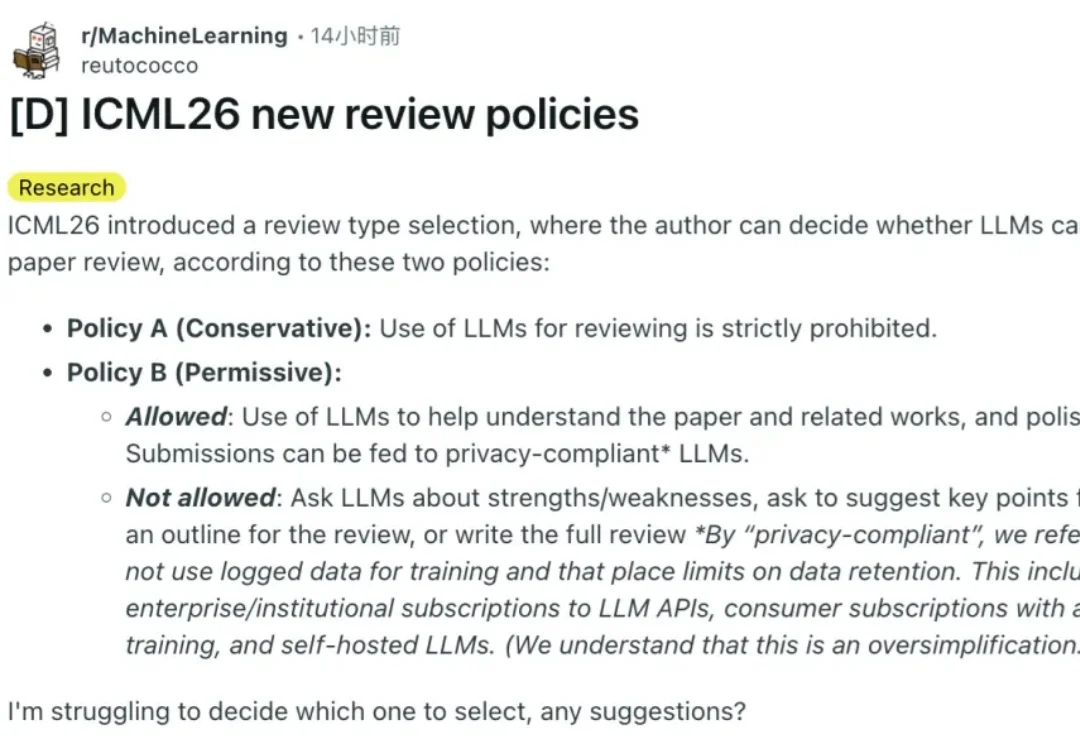

两个月前,ICML 2026发布了征稿新规,我们也详细做了报道。

2026 年 1 月过半,我们依然没有等来 DeepSeek V4,但它的模样已经愈发清晰。

论文将汇总人类从出生到死亡每个神经元的活动情况。利用更完善的“分子记录带”(molecular ticker tape)技术,神经元每发出一个电脉冲,都会在其蛋白链上加上一段荧光分子。通过对这些蛋白链进行测序,可以获得神经元整个生命周期内神经活动的完整历史记录。同时对每个神经元的mRNA进行测序,可以确定它属于10.4万个神经元类型中的哪一种。

24条AI幽灵文献,坑惨港大某副院长。