好消息,搞生成式AI应用的门槛,被狠狠地打下去了!

就在刚刚,亚马逊云科技在年度盛会re:Invent中正式宣布:

在我这搞生成式AI应用,主流、最新大模型随便用~

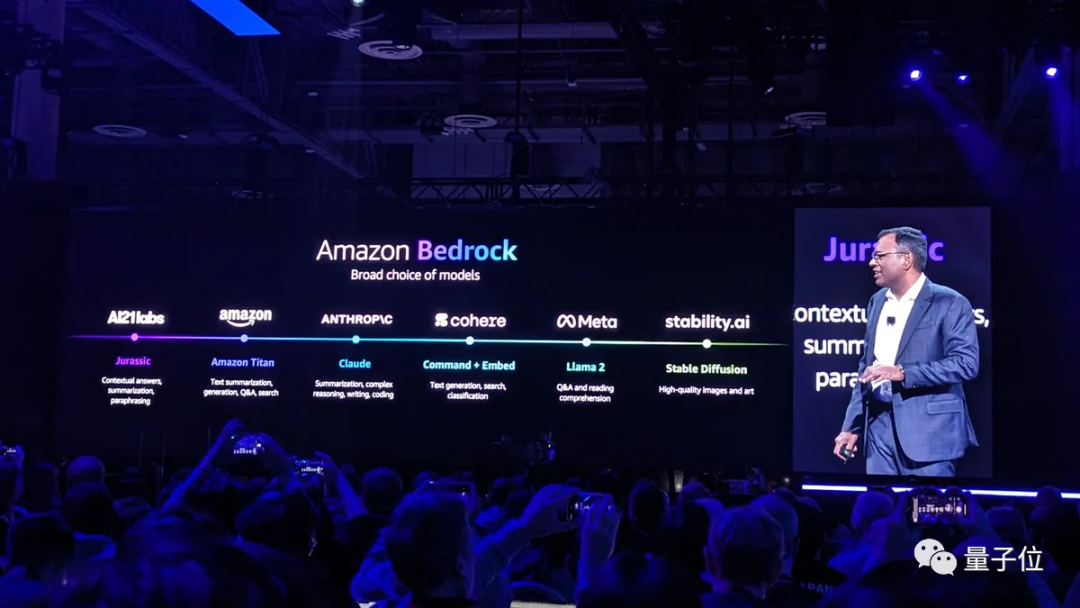

例如Meta家的Llama 2 70B、Antropic家的Claude 2.1等等:

能够将如此众多大模型“打包”起来的集大成者,便是亚马逊云科技的AI大模型服务Amazon Bedrock。

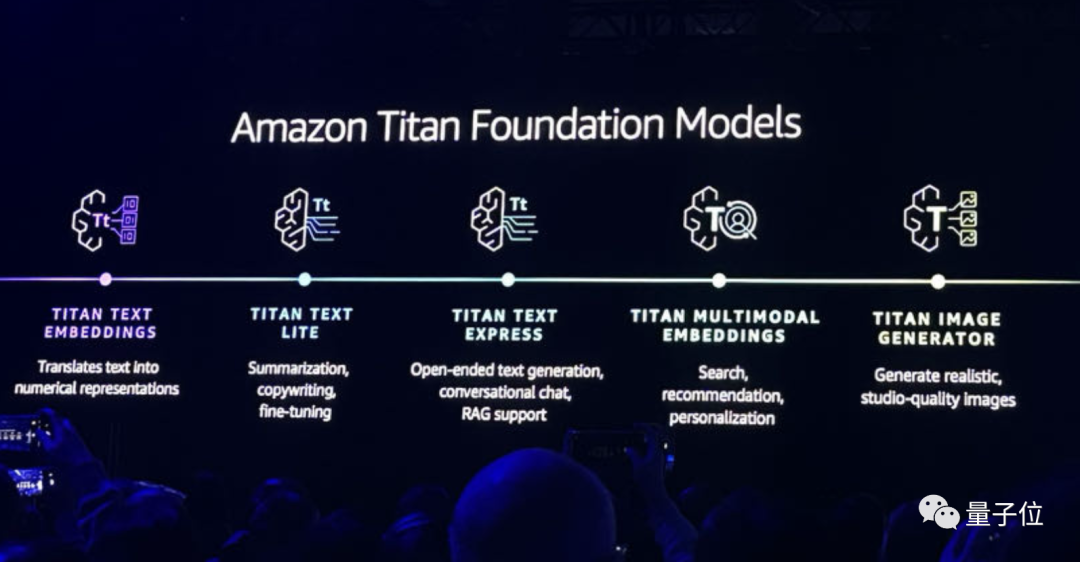

当然,其中也包含了自家最新升级的大模型Titan:

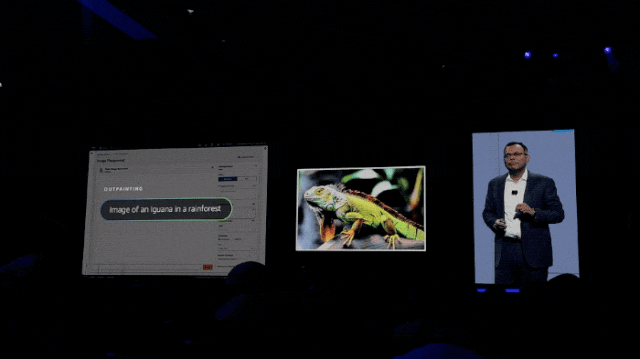

亚马逊云科技AI副总裁Swami Sivasubramanian,还在现场演示了Titan Iamge Generator的能力。

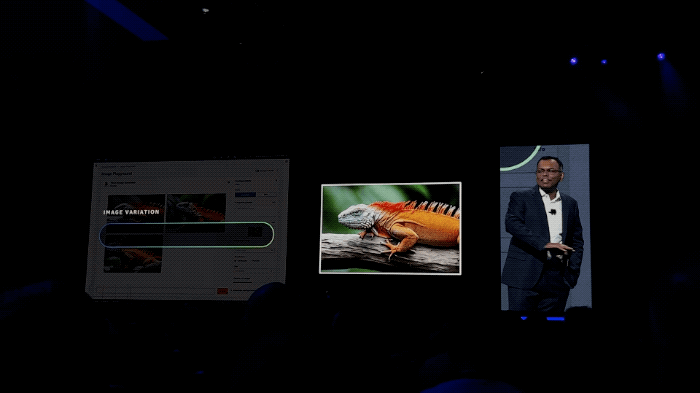

例如只需一句话就可以将一只绿色蜥蜴,毫无PS痕迹地变成橘色:

再如把图片掉转个方向,也是只是一句话的事儿了:

方便,着实是方便。

不过纵观整场发布会,这些个功能和升级也还仅是亚马逊云科技把门槛打下去的动作一隅。

还有更多新功能的发布,让搞生成式AI应用变得简单了不少。

SageMaker是亚马逊云科技长期押注的一个项目,它的主要作用便是构建、训练和部署机器学习模型。

Swami在今天的大会中宣布了它的诸多新功能,让客户可以更轻松地去构建、训练和部署生成式AI模型。

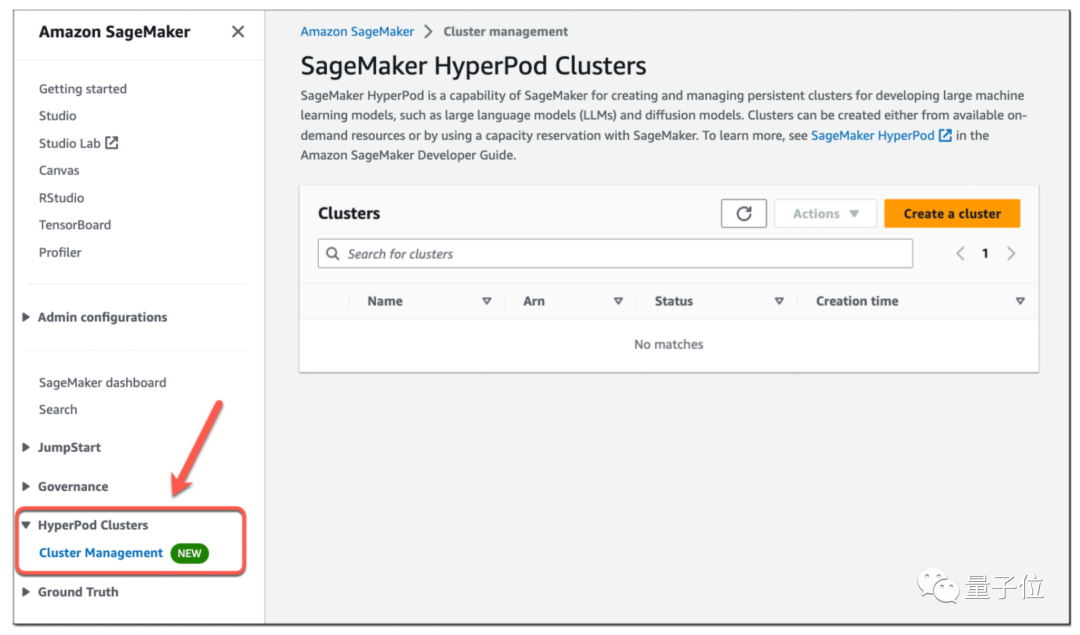

首先,便是SageMaker HyperPod功能。

我们都知道,以往基础模型通常过于复杂,无法使用单个 AI 芯片进行训练;因此,它们必须拆分到多个处理器上,这是一项技术上复杂的工作。

而SageMaker HyperPod可以提供对按需AI训练集群的访问,开发人员可以通过点击式命令和相对简单的脚本组合来配置集群,这比手动配置基础架构要快得多。

Swami在现场表示:

SageMaker HyperPod将训练基础模型所需的时间减少了40%。

SageMaker HyperPod不仅可以自动执行设置AI训练集群的过程,它还可以自动执行其维护。

当客户集群中的某个实例脱机时,内置的自动化软件会自动尝试修复它;如果故障排除尝试不成功,SageMaker HyperPod 会将出现故障的节点换成新节点。

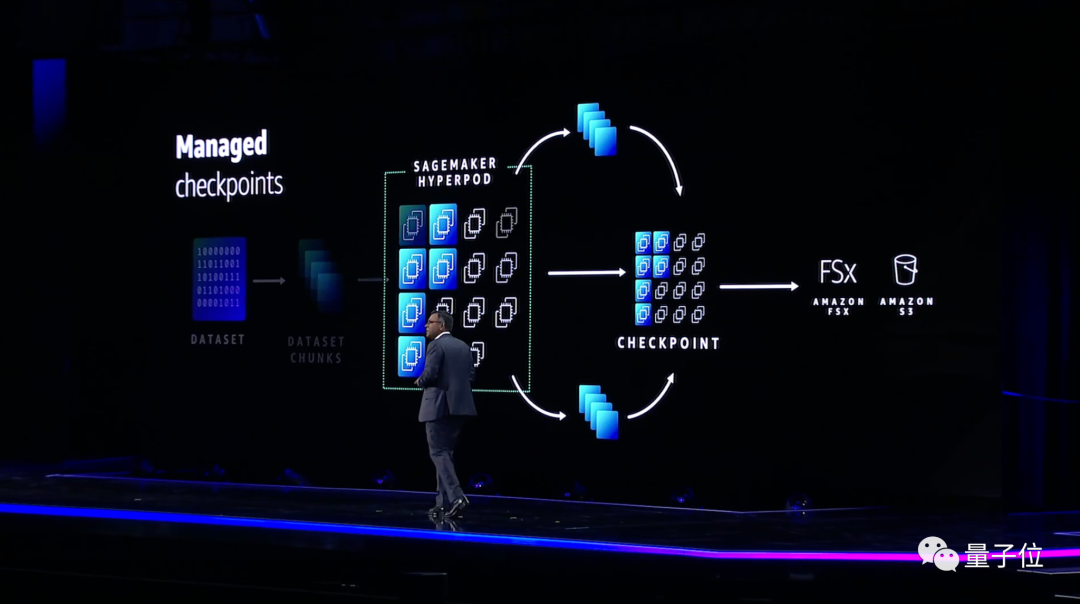

在某些情况下,基础模型需要数周或数月的时间来训练。如果中断使底层 AI 基础设施脱机,开发人员必须从头开始重新开始训练,这可能会导致严重的项目延迟。

为避免此类情况,SageMaker HyperPod 会在训练期间定期保存AI模型,并提供从最新快照恢复训练的功能。

不仅如此,每个SageMaker HyperPod集群都预配置了一组亚马逊云科技开发的分布式训练库。

这些库会自动将开发人员的模型分散到集群中的芯片上,而且还可以将训练该模型的数据拆分为更小,更易于管理的部分。

其次,在推理方面,亚马逊云科技推出了SageMaker Inference功能。

它的出现将有助于降低模型的部署成本和延迟;新的推理功能可以让客户单个端点上部署一个或多个基础模型,并控制分配给它们的内存和加速器数量。

具体降本增效的成果,亚马逊云科技在现场也有介绍:

这项新功能可以帮助将部署成本降低50%,并将延迟减少20%。

在构建机器学习模型的无代码界面上的SageMaker Canvas也有所更新。

我们现在可以直接用自然语言去处理了!

在聊天界面中,SageMaker Canvas提供了许多与您正在使用的数据库相关的引导提示,或者你可以提出自己的提示。

例如,你可以通过说“准备数据质量报告”、“根据特定条件删除行”等等,让它来执行你的需求。

……

总而言之,SageMaker今天的众多能力更新,着实是让模型的构建、训练和部署简单了不少。

拥有强大的数据基础,对于充分利用生成式AI可以说是至关重要。

Swami在现场表示,强大的数据基础需要满足三点:全面(comprehensive)、集成(integrated)和治理(governed)。

围绕这些特性,亚马逊云科技在今天的大会中也做了相应新功能的发布。

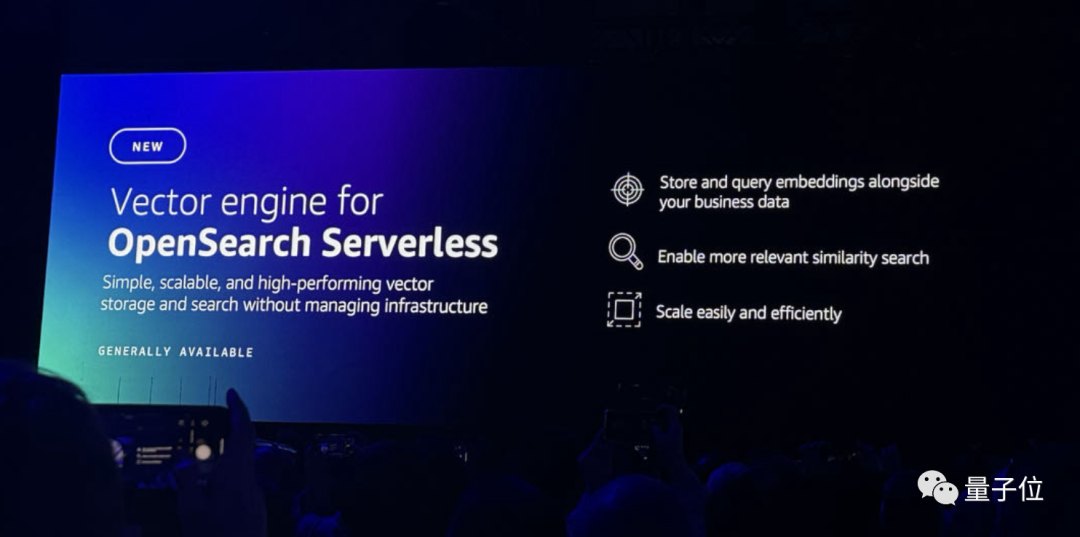

首先便是针对向量引擎的OpenSearch Serverless,它能够带来更高效的搜索和流程。。

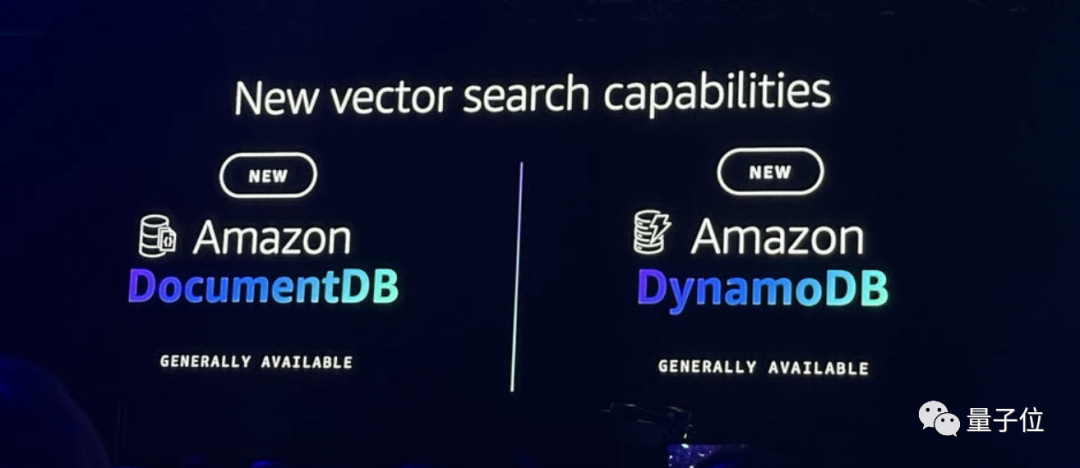

其次,DocumentDB和DynamoDB也加入到了向量功能,可以允许用户将多种数据存储在一起。

除此之外,MemoryDB for Redis也有了相应更新,它也可以支持向量搜索,响应时间变得更快,每秒可以处理数万个查询。

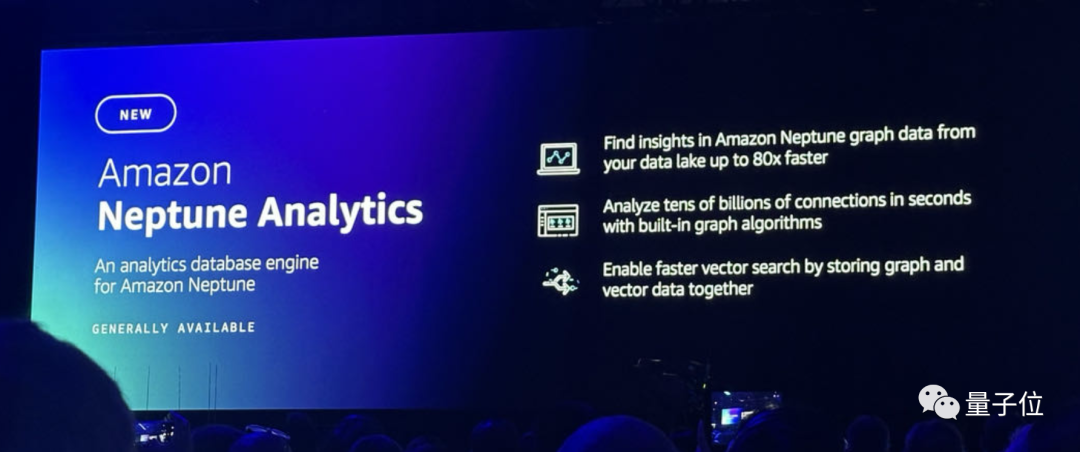

在分析数据库方面,亚马逊云科技则是推出了Amazon Neptune Analytics,可以让开发人员在几秒钟内检查海量的图形数据,也支持更快的向量搜索。

在数据的“集成”特性方面,亚马逊云科技依旧坚持的是“zero-ETL”之道——Amazon S3加持下的OpenSearch Service zero-ETL integration,仅使用一个工具,便可以分析S3中的所有操作数据。

最后,在“治理”方面,亚马逊云科技上新的功能便是Clean Rooms ML。

它可以允许用户在不共享底层数据的情况下与客户应用机器学习模型。

在推动大模型发展的这件事上,亚马逊云科技可以说是有着自己独到的“玩法”——

不仅发展自家的大模型,更是给其它大模型提供AI基础设施和AI工具,让它们也能更好地发展。

那么二者之间是否会存在冲突和竞争呢?

在量子位与亚马逊云科技数据库和迁移服务副总裁Jeff Carter的交流过程中,他发表了如下看法:

我希望我们生活在一个合作的世界里,每个LLM都擅长于不同的方面,我认为这种情况会持续下去,这种专业化水平也会持续一段时间。

我喜欢Bedrock的一个原因是它可以无缝地从一个LLM转换到另一个LLM。很明显,亚马逊将持续在LLM方面推进最先进的技术。

但对于每个LLM,或许下个月所呈现出来的能力会截然不同,这也就是为什么我们认为给客户提供选择的能力和同时使用多个功能的能力是如此重要的原因之一。

参考链接:

[1]https://press.aboutamazon.com/2023/11/aws-announces-more-model-choice-and-powerful-new-capabilities-in-amazon-bedrock-to-securely-build-and-scale-generative-ai-applications

[2]https://www.techradar.com/news/live/aws-reinvent-2023-all-the-news-updates-and-more

文章来自于微信公众号“量子位”(ID: QbitAI) ,作者 “金磊”

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner