「无界动力」完成数亿元天使+轮融资,线性红杉高瓴等持续加注 | Linear Portfolio

「无界动力」完成数亿元天使+轮融资,线性红杉高瓴等持续加注 | Linear Portfolio通用具身智能机器人公司「无界动力」宣布完成超2亿元天使+轮融资,老股东红杉中国、线性资本、高瓴创投、华业天成、中金资本旗下基金、BV百度风投持续追投,新增深创投、创新工场、普华资本、钧山资本、雅瑞资本等加入。

通用具身智能机器人公司「无界动力」宣布完成超2亿元天使+轮融资,老股东红杉中国、线性资本、高瓴创投、华业天成、中金资本旗下基金、BV百度风投持续追投,新增深创投、创新工场、普华资本、钧山资本、雅瑞资本等加入。

千问前脚刚把Qwen-Image-2.0甩出来,后脚就又放大招,冲着牛马党学生党的「痛处」下手了——就在这两天,重磅发布了AI PPT生成工具:Qwen AI Slides(幻灯片),据说从内容结构到视觉配图,一套全包……

其依据是Micro1的25亿美元(约合人民币173亿元)最新估值。福布斯报道称,成立于2022年的Micro1被曝正在以25亿美元估值洽谈新融资,如果Micro1锁定或超过这一估值,安萨里在该公司持有的约42%股份价值将超过10亿美元(约合人民币69亿元)。

1 月下旬,一个没有铺天盖地公关、甚至连官方介绍都极简的产品 Moltbook 悄然发布,瞬间在 AI 圈掀起了一场不小的地震。

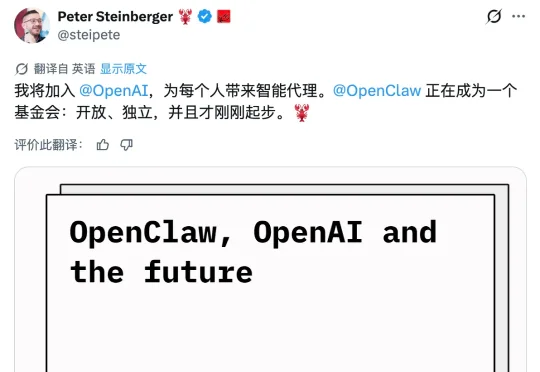

就在刚刚,OpenClaw 开发者 Peter Steinberger 在 X 平台官宣加入 OpenAI。用他自己的话说:「我将加入 OpenAI,致力于把智能体带给每一个人。OpenClaw 将转为基金会形式运作,并保持开源和独立。」

创意这东西保质期很短,那股兴奋劲儿一过,大多数想法就不了了之。直到最近我在看一批新的 AI 产品时,碰到了 Leewow。

开源模型新王 MiniMax M2.5 震撼降临:M2.5 编码性能逼平 Claude Opus 4.6,价格却只有 1/20;1 美金 / 小时,这种尺寸和性能的模型,才能在算力短缺的时代不降智不卡顿,持续提供最好体验,成为最终王者!

这两周,字节新发布的 AI 视频模型 Seedance2.0 特别火,真正的全民热议。 我给我爹看了几个模型生成的视频,他的反应特别有代表性。看完以后他跟我说了一句话:「你别胡说八道,这就是真人啊。」

我想洗车,我家距离洗车店只有 50 米,请问你推荐我走路去还是开车去呢?就是这么一道题,却让 AI 集体上演了一出大型降智现场。只能说,看完 AI 们的回答,我悬着的心终于放下了。

2026 年刚开年,PC 玩家的心态就崩了。 本来大家都在搓手期待英伟达的 RTX 60 系显卡,结果最近有消息传出,老黄反手给了游戏佬一记耳光:今年不打算发新卡,产能全给 AI 了。 更离谱的是,前