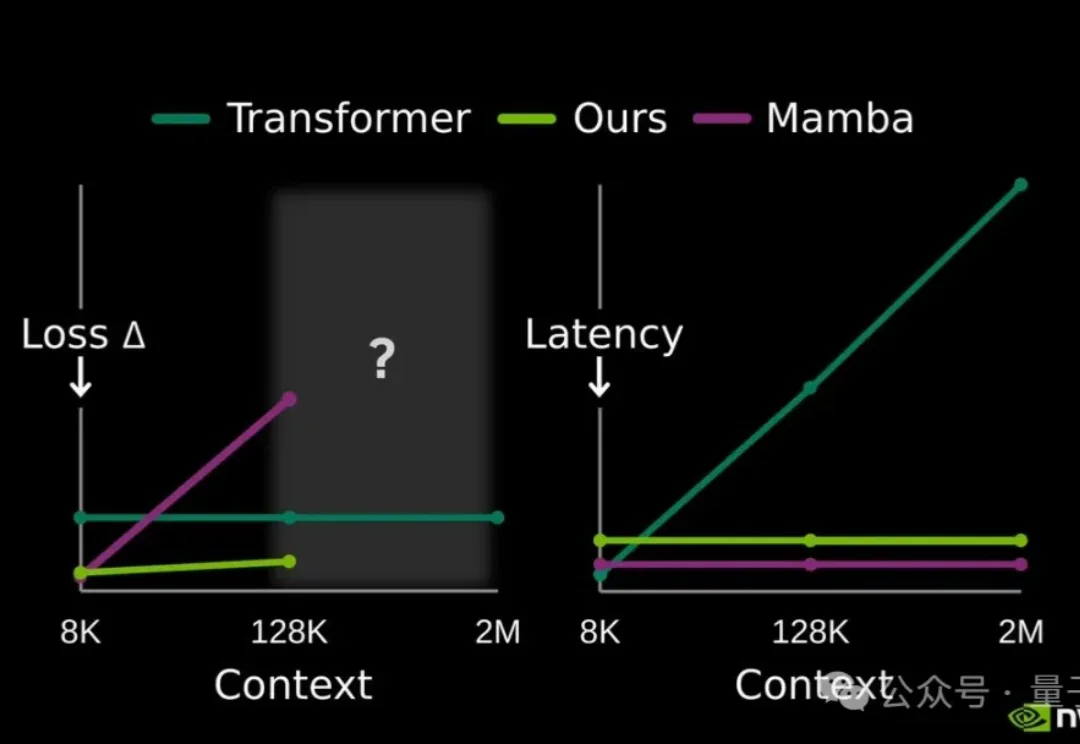

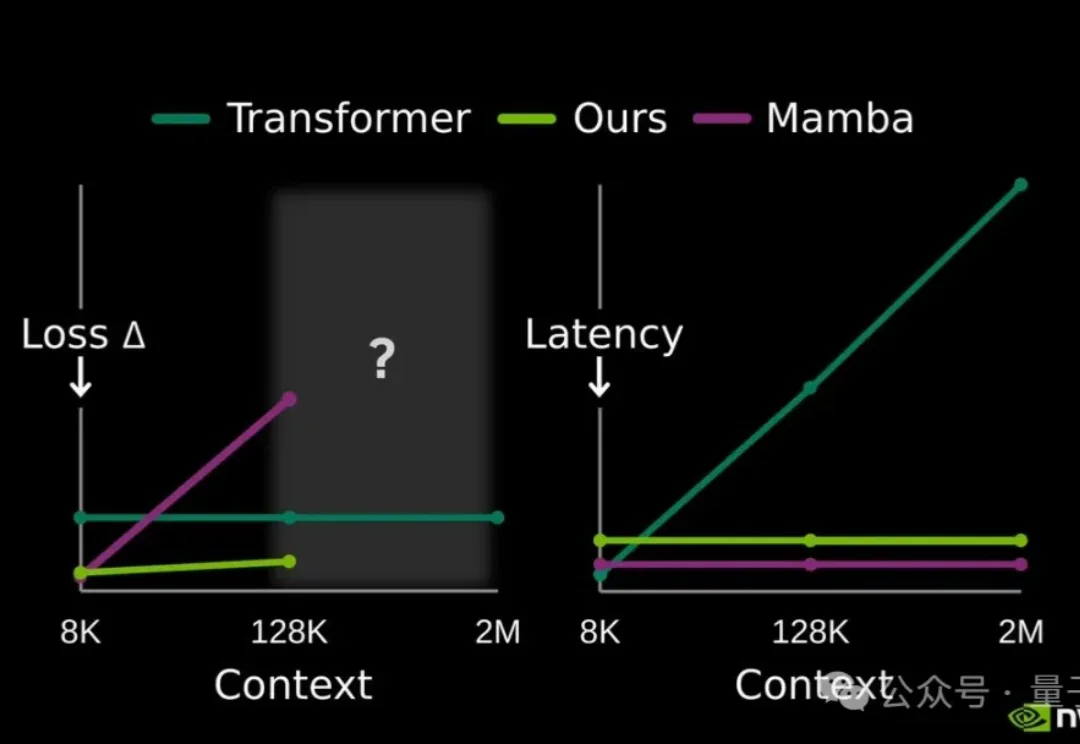

不用额外缓存!英伟达开源大模型记忆压缩方案,128K上下文提速2.7倍

不用额外缓存!英伟达开源大模型记忆压缩方案,128K上下文提速2.7倍提高大模型记忆这块儿,美国大模型开源王者——英伟达也出招了。

提高大模型记忆这块儿,美国大模型开源王者——英伟达也出招了。

为什么大模型厂商给了 128K 的上下文窗口,却在计费上让长文本显著更贵?

原生工具调用、128K上下文,图文创作仍有短板。

9 月 22 日下午,联发科推出的新一代旗舰 5G 智能体 AI 芯片 —— 天玑 9500,并展示了一系列新形态端侧的 AI 应用,在公众层面首次推动端侧 AI 从尝鲜到好用。现在,让手机端大语言模型(LLM)处理一段超长的文本,最长支持 128K 字元,它只需要两秒就能总结出会议纪要,AI 还能自动修改你的错别字。

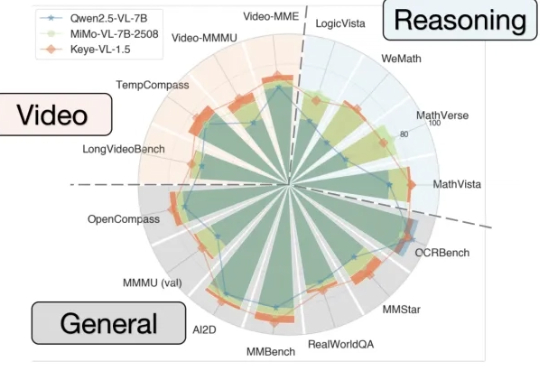

能看懂视频并进行跨模态推理的大模型Keye-VL 1.5,快手开源了。

Grok-2正式开源,登上Hugging Face,9050亿参数+128k上下文有多猛?近万亿参数「巨兽」性能首曝。马斯克再现「超人」速度,AI帝国正在崛起。

DeepSeek V3.1和V3相比,到底有什么不同?官方说的模模糊糊,就提到了上下文长度拓展至128K和支持多种张量格式,但别急,我们已经上手实测,为你奉上更多新鲜信息。

DeepSeek V3.1新版正式上线,上下文128k,编程实力碾压Claude 4 Opus,成本低至1美元。在昨晚,DeepSeek官方悄然上线了全新的V3.1版本,上下文长度拓展到128k。本次开源的V3.1模型拥有685B参数,支持多种精度格式,从BF16到FP8。

没等到Deepseek R2,DeepSeek悄悄更新了V 3.1。官方群放出的消息就提了一点,上下文长度拓展至128K。128K也是GPT-4o这一代模型的处理Token的长度。因此一开始,鲸哥以为从V3升级到V 3.1,以为是不大的升级,鲸哥体验下来还有惊喜。

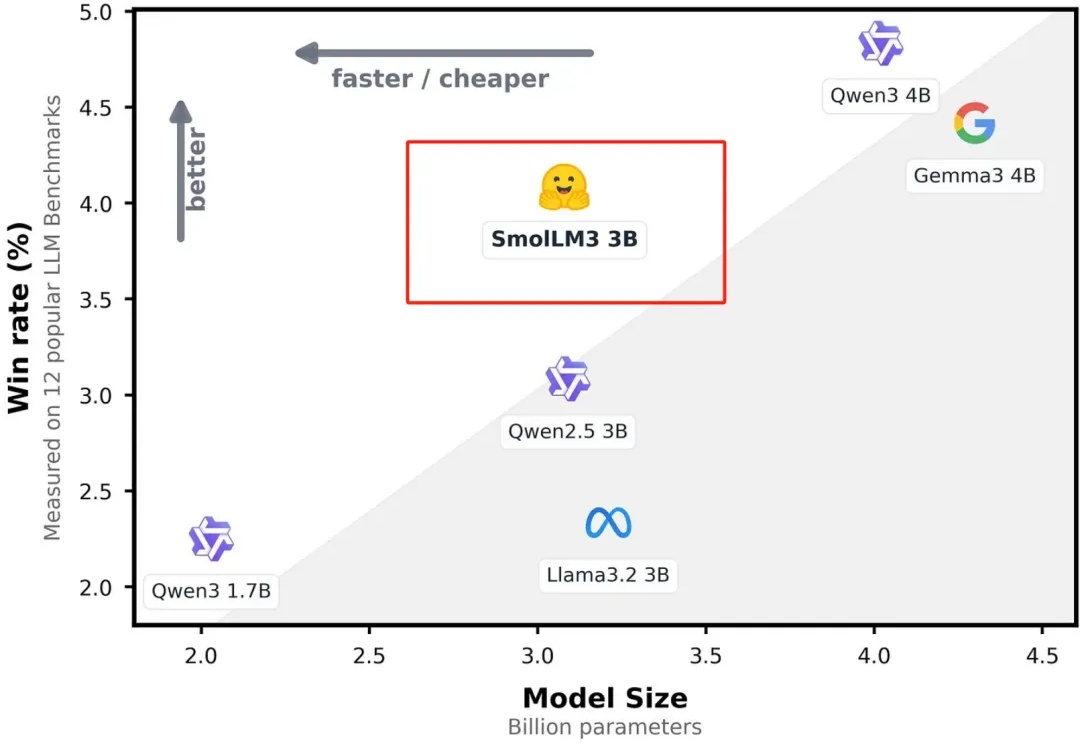

今天凌晨,全球著名大模型开放平台Hugging Face开源了,顶级小参数模型SmolLM3。