苹果下个爆款可能不是 iPhone,居然「复活」全网群嘲的 Ai Pin,首批 2000 万台

苹果下个爆款可能不是 iPhone,居然「复活」全网群嘲的 Ai Pin,首批 2000 万台最有看点的苹果产品要来了,但可能不是 iPhone。

最有看点的苹果产品要来了,但可能不是 iPhone。

2026年,AI的第一个规模商业化赛道—AI漫剧,正在爆发。

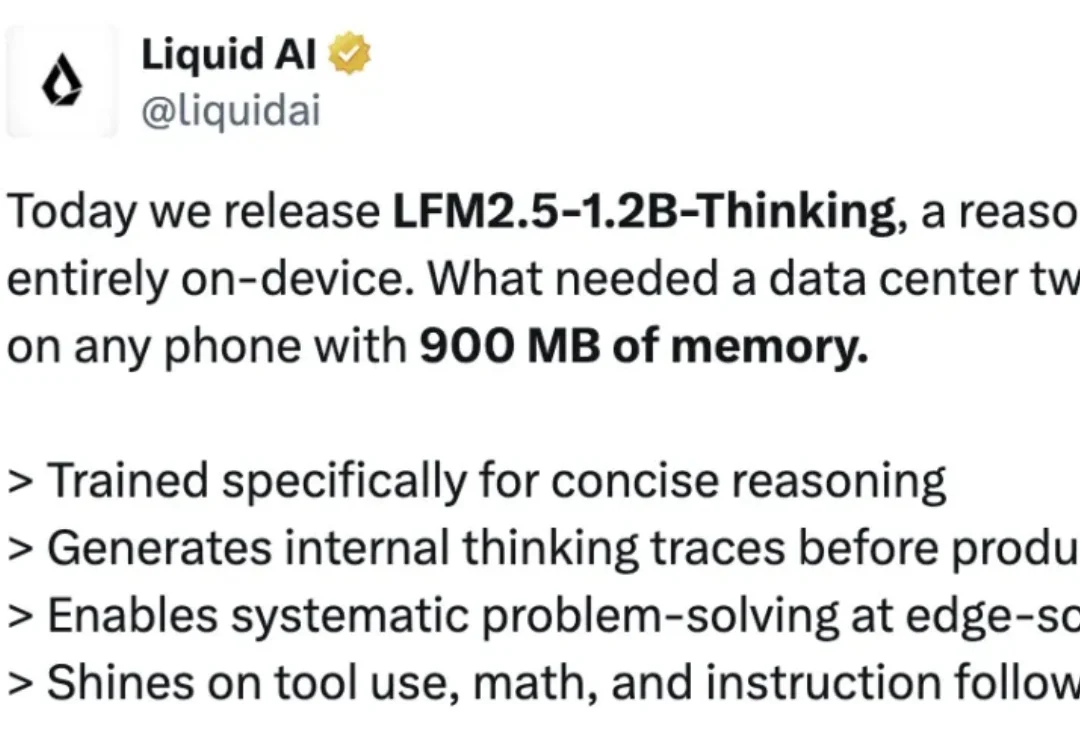

就在刚刚,Liquid AI 又一次在 LFM 模型上放大招。他们正式发布并开源了 LFM2.5-1.2B-Thinking,一款可完全在端侧运行的推理模型。Liquid AI 声称,该模型专门为简洁推理而训练;在生成最终答案前,会先生成内部思考轨迹;在端侧级别的低延迟条件下,实现系统化的问题求解;在工具使用、数学推理和指令遵循方面表现尤为出色。

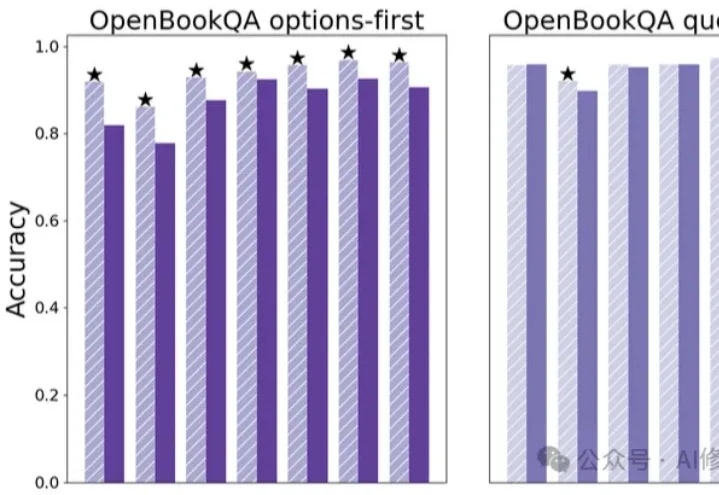

竟然只需要一次Ctrl+V?这可能是深度学习领域为数不多的“免费午餐”。

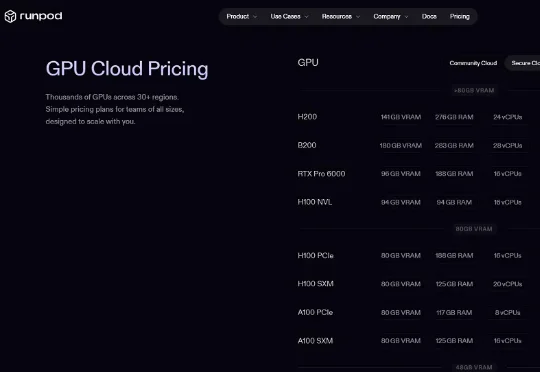

又一家ARR突破1亿美元的AI创企诞生了!近日,由华人CEO领衔的美国AI云创企RunPod对外披露,其年化收入已达到1.2亿美元(约合人民币8.35亿元),平台累计开发者用户数超过50万。

近日,中国科学技术大学(USTC)联合新疆师范大学、中关村人工智能研究院、香港理工大学,在数据驱动的多功能双连通多尺度结构逆向设计领域取得重要突破。

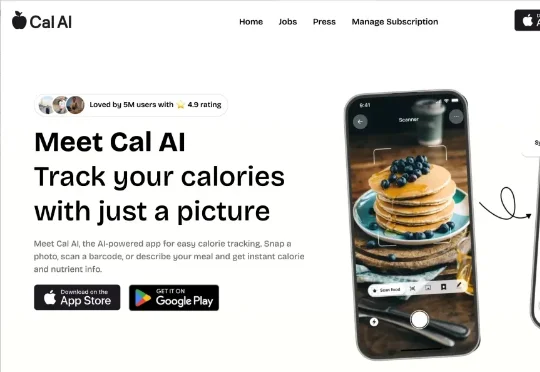

随着政府对于健康领域的重视和人们健康意识的普及,热量追踪应用的用户画像逐渐从以健身爱好者、减重者为主的专业细分群体,逐步转向以普通大众为主的非专业用户,与专业细分群体相比,他们更倾向于追求“简单、易上手”的体验。

大模型卷到第三年,谁在偷偷赚钱?刚刚,一家中国团队,不声不响地拿到了全球第一。它不拼参数、不造模型,却用2.5年跑赢Midjourney,为什么?答案就在它的产品里。

OpenAI最新播客释出—— 首席财务官Sarah Friar&著名投资人Vinod Khosla聚在一起,聊了聊2026年的AI趋势。

这两天都在研究 ralph,一个你睡觉时,都能不眠不休替你干需求、榨干任何 Coding Agent 的工具。