具身智能开年最大融资,自变量机器人宣布完成十亿元A++轮融资,字节、阿里、美团首次在具身智能“同框”

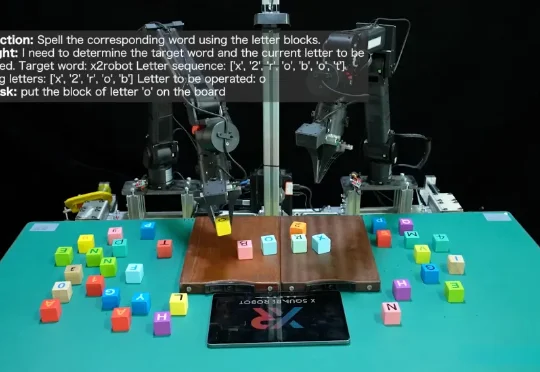

具身智能开年最大融资,自变量机器人宣布完成十亿元A++轮融资,字节、阿里、美团首次在具身智能“同框”2026年开年之际,具身智能赛道迎来了首个重磅融资事件,自变量机器人宣布完成十亿元A++轮融资。本轮融资由字节跳动、红杉中国、深创投、北京信息产业发展基金、锡创投、南山战新投等顶级投资机构及多元地方平台联合投资。据悉,这也是深创投AI基金成立以来的第一笔投资。

2026年开年之际,具身智能赛道迎来了首个重磅融资事件,自变量机器人宣布完成十亿元A++轮融资。本轮融资由字节跳动、红杉中国、深创投、北京信息产业发展基金、锡创投、南山战新投等顶级投资机构及多元地方平台联合投资。据悉,这也是深创投AI基金成立以来的第一笔投资。

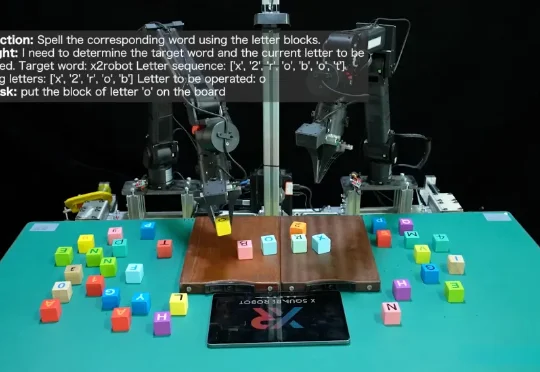

2024 年底,硅谷和北京的茶水间里都在讨论同一个令人不安的话题:Scaling Law 似乎正在撞墙。

昔日霸主CMU跌落神坛,清华上交联手登顶世界第一,中国高校以「屠榜」之势宣告CS新时代的到来!

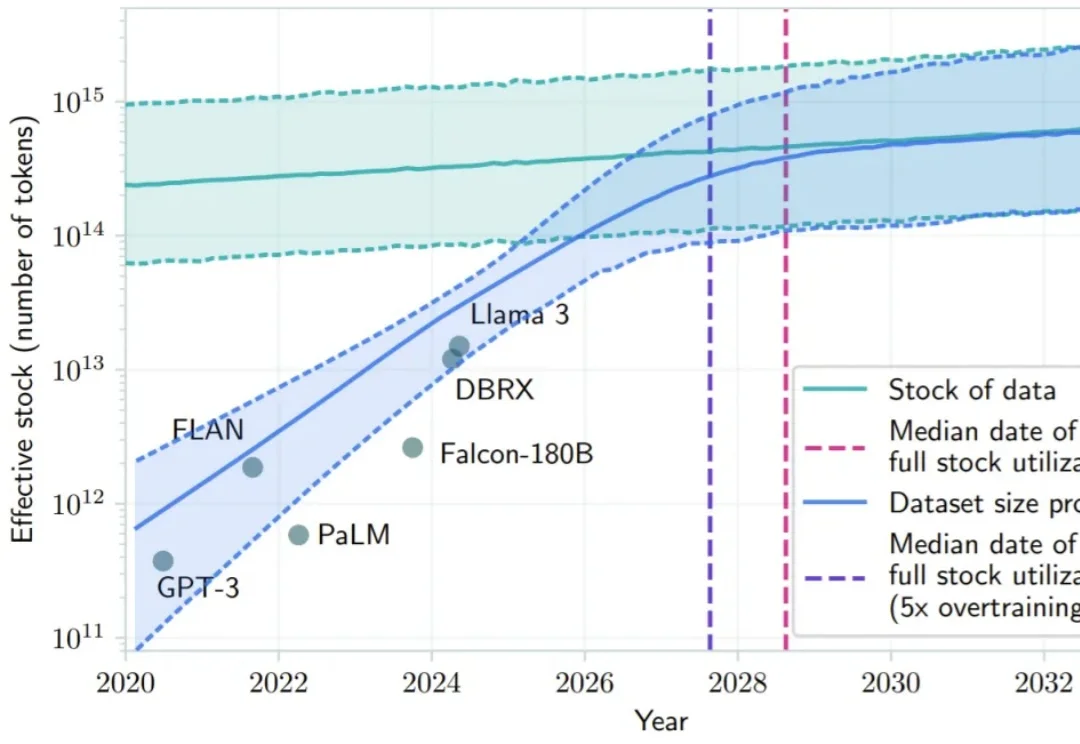

短视频搜索业务是向量检索在工业界最核心的应用场景之一。然而,当前业界普遍采用的「自强化」训练范式过度依赖历史点击数据,导致系统陷入信息茧房,难以召回潜在相关的新鲜内容。

西湖心辰还在近两年连续推出了多款AI社交应用,如Fantasia、Joyland以及刚刚上线4个月的My Loverse,其中专注于二次元群体的Fantasia也在欧美市场备受关注,2025年总下载量接近290万,总收入达到约323万美元。

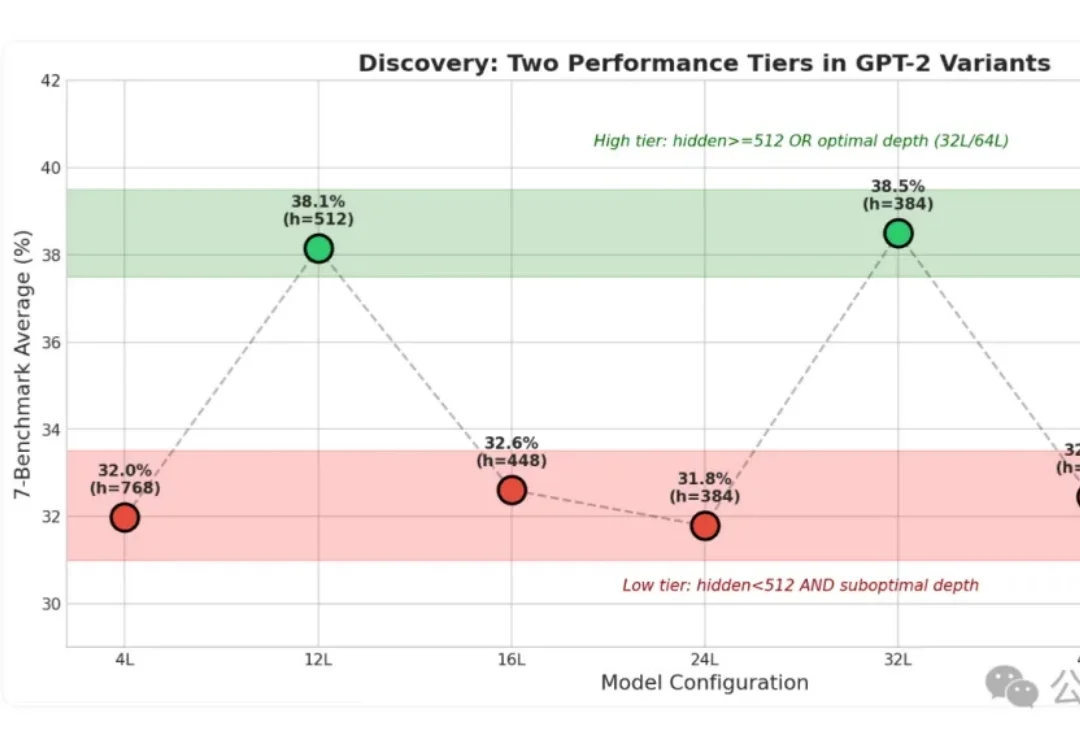

小模型身上的“秘密”这下算是被扒光了!

2026硅谷「爽文剧本」已备好:Ilya将卖掉SSI、OpenAI可能吞下Pinterest、特斯拉将接盘xAI、苹果AI有望翻身……这些惊人预言到底哪些会在2026年成真?

Deepmind推出的SIMA 2,让智能体能在虚拟环境(商业游戏)中,边聊天边进行复杂的多模态推理。作为具身通用智能的原型,SIMA 2已从静态数据集迈向无限程序化生成的训练场。

当全市场都在用Agent炒股,人类的唯一胜算在哪?

2022年,Google Cloud 将π计算到100万亿位,在2025年,高性能计算界的知名评测机构 StorageReview只用了4个月的时间,花了不到一千美元电费就将π算到314万亿位,这可不是为了炫技,而是说明高性能计算也可以很节能。