1元=1700000tokens!清华系发布国产Mistral仅2B,老手机都带得动,GitHub一天斩获300+星

1元=1700000tokens!清华系发布国产Mistral仅2B,老手机都带得动,GitHub一天斩获300+星一个体量仅为2B的大模型,能有什么用?答案可能超出你的想象。

一个体量仅为2B的大模型,能有什么用?答案可能超出你的想象。

在 AI 赛道中,与动辄上千亿参数的模型相比,最近,小模型开始受到大家的青睐。比如法国 AI 初创公司发布的 Mistral-7B 模型,其在每个基准测试中,都优于 Llama 2 13B,并且在代码、数学和推理方面也优于 LLaMA 1 34B。

2B性能小钢炮来了!刚刚,面壁智能重磅开源了旗舰级端侧多模态模型MiniCPM,2B就能赶超Mistral-7B,还能越级比肩Llama2-13B。成本更是低到炸裂,170万tokens成本仅为1元!

对于大型视觉语言模型(LVLM)而言,扩展模型可以有效提高模型性能。然而,扩大参数规模会显著增加训练和推理成本,因为计算中每个 token 都会激活所有模型参数。

羊驼家族的“最强开源代码模型”,迎来了它的“超大杯”——就在今天凌晨,Meta宣布推出Code Llama的70B版本。

马里兰大学联合北卡教堂山发布首个专为多模态大语言模型(MLLM)设计的图像序列的基准测试Mementos,涵盖了真实世界图像序列、机器人图像序列,以及动漫图像序列,用4761个多样化图像序列的集合,全面测试MLLM对碎散图像序列的推理能力!

删除权重矩阵的一些行和列,让 LLAMA-2 70B 的参数量减少 25%,模型还能保持 99% 的零样本任务性能,同时计算效率大大提升。这就是微软 SliceGPT 的威力。

Meta 正式发布 Code Llama 70B,这是 Code Llama 系列有史以来最大、性能最好的型号。

Quora联合创始人兼首席执行官Adam D'Angelo发文宣布,已从硅谷风投巨擘Andreessen Horowitz 处筹集7500万美元。这笔资金将用于加速公司AI 聊天平台Poe的发展,其中大部分会投入支持AI开发者的创作货币化。

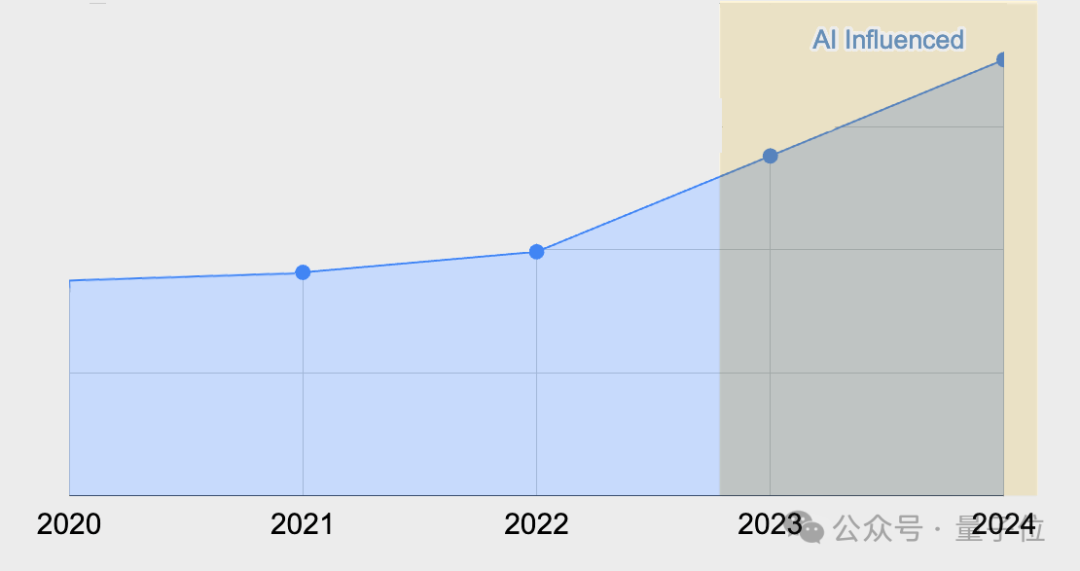

一家名为GitClear的公司分析了近四年超过1.5亿行代码后发现,随着GitHub Copilot工具的加入,代码流失率(即代码写入后不久又被返工修改、删除的情况)出现了显著上升: 2023年为7.1%,而2020年时仅为3.3%,翻了一番。